2022年,我国肉鸡产量1.43×107 t,约占全球总产量14.15%,鸡蛋产量2.937 6×107 t,出口金额约3.02亿美元[1-2]。肉蛋鸡产业蓬勃发展不仅满足了国内持续增长的消费需求,同时为我国对外贸易发展做出重要贡献。随着经济水平提高,预计2025—2027年,全球对禽肉需求会增加18%[3]。由于表型特征最直观、最易于观察及描述,受到众多育种研究者关注,特别是鸡冠肉垂大小这种明显表型特征[4-5]。目前研究[6-9]发现,鸡冠是可遗传性状,其特征(如面积、长度、颜色等)与产蛋量、生育能力等有着密切相关性,对于鸡冠肉垂等表型特征与育种之间关系有深入研究必要。

目前,利用卡尺等工具手工测量长和高,通过计算获得大致面积,是获取肉、蛋鸡鸡冠大小主要方式。这种方法耗时耗力而且需要与鸡体直接接触,易造成应激反应,有悖于福利养殖要求,同时还会带来人畜共患疾病风险。随着图像处理和机器学习技术发展,张珍等[6]利用Photoshop软件,郭蓓佳等[7]利用L*、a*、b*颜色空间及Otsu方法获取鸡冠面积,孙一平等[10]使用L*、a*、b*颜色空间与K-means聚类算法提取鸡冠和肉髯特征。这些方法虽在一定程度上解决了人力耗费问题,但图像处理精度受限于图像采集环境且与研究者经验有关,机器学习方法需要特定采集背景以及人工固定鸡只,也会产生应激与疾病传播问题。

随着深度学习技术发展,U-Net系列[11-12]、Deeplab系列[13-14]、FCN[15]等语义分割模型,YOLACT[16-17]、Mask R-CNN[18]、Solo[19-20]等实例分割模型,被引入并应用到农业生产领域。尽管深度学习模型在农业领域已有诸多应用[21-28],但在鸡冠肉垂面积计算细分领域,尚未见有关研究文献。

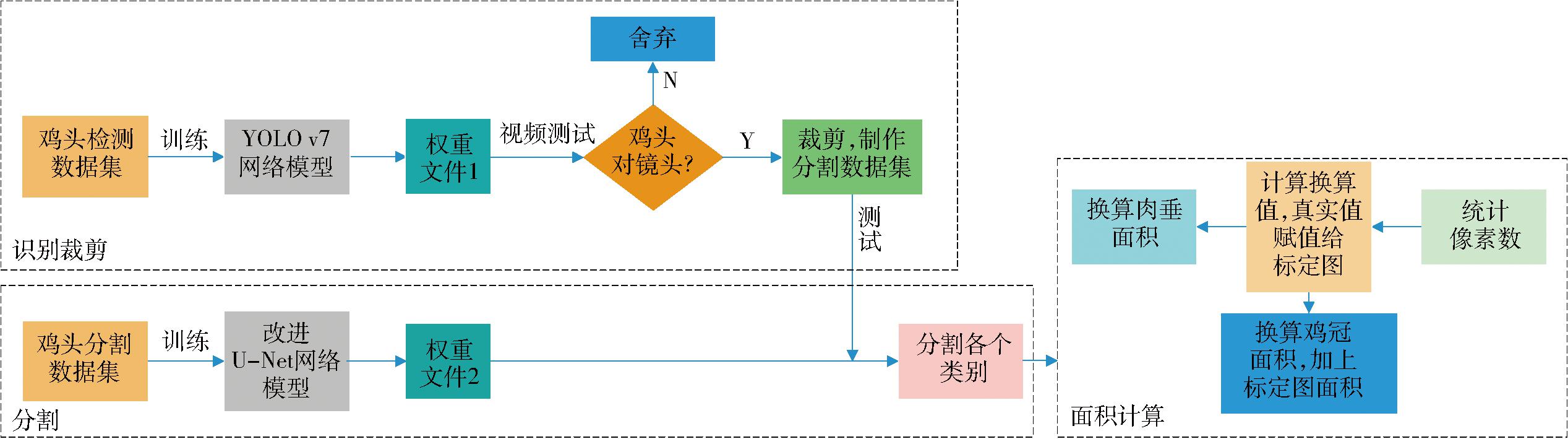

针对上述问题,本文采用YOLO v7模型[29]进行侧面正对摄像头鸡头裁剪,结合改进U-Net分割模型,实现鸡冠肉垂自动、精准分割,利用标定物标定系数,实现鸡冠和肉垂面积高精度计算。

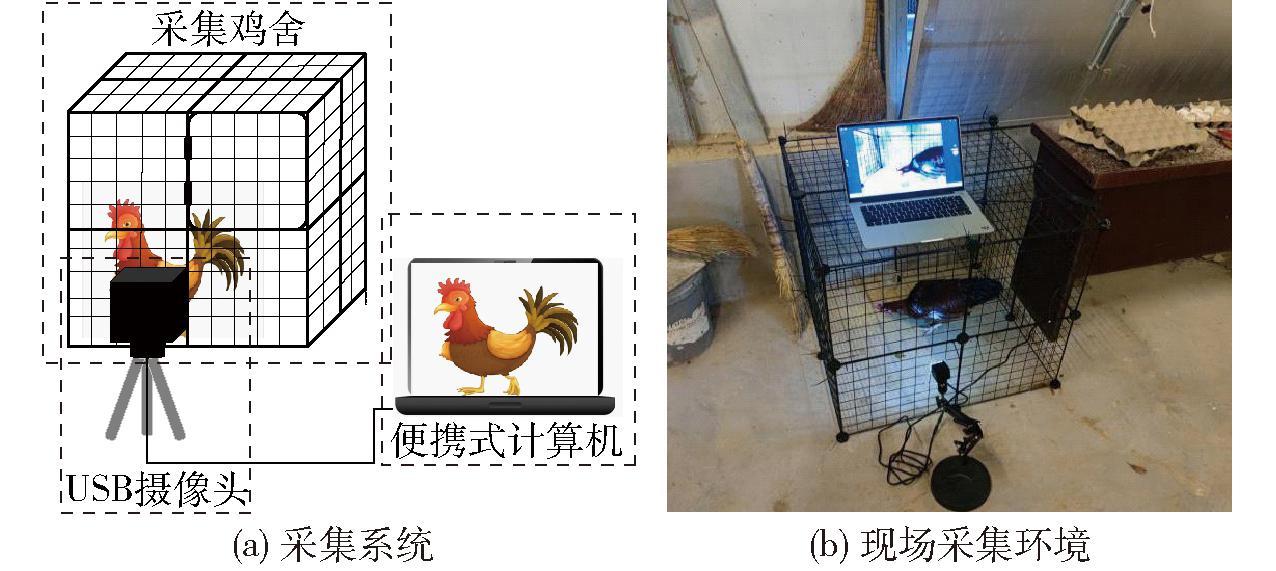

数据采集自河北桃木疙瘩农业科技股份有限公司中庄养殖基地,于2023年8月1—12日、9月4—5日,选择21只鸡冠肉垂形态存在一定差异的太行公鸡作为研究对象。在实验阶段,对算法计算结果与真实值间的差异进行对比,使用无毒无害黑色标记笔,在鸡冠处涂抹直径15 mm(面积为1.77 cm2)圆形,作为真实面积标定依据。使用长×宽×高为76 cm×76 cm×76 cm的长方体拼接鸡舍采集鸡只视频数据,采集系统示意图如图1a所示,便携式计算机通过USB接口连接索尼IMX298 USB型相机,进行分辨率为4 656像素×3 496像素和帧率为10 f/s的视频录制。现场采集环境示意图如图1b所示。视频采集前,将鸡只放在拼接鸡舍内1 h适应环境,然后对其进行2 h视频录制,每隔30 min调整摄像头位置,使其分别处于距离地面26、30、39 cm的3个高度,获得仰拍、平拍和俯拍3个不同视角,每天视频采集6 h。

图1 采集示意图

Fig.1 Acquisition schematics

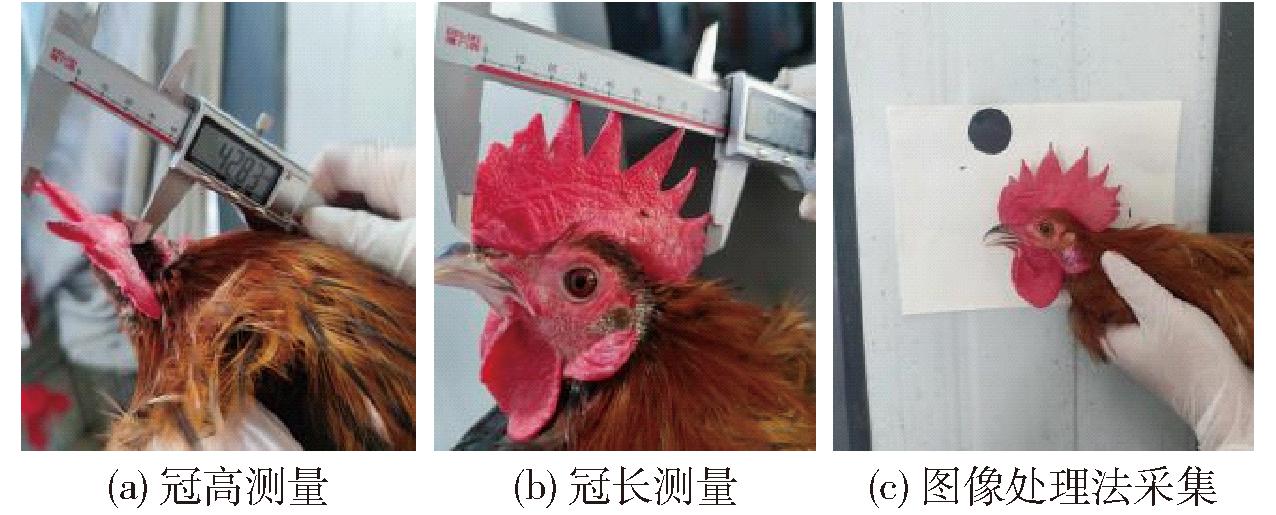

视频数据采集完成后,使用德力西电子数显卡尺,测量鸡冠长和高(测量过程如图2a和图2b所示),由于目前仅有手工测量计算鸡冠面积的相关研究[6],为了进行效果对比,本实验手工测量了鸡冠长和宽,不涉及肉垂尺寸的测量。为减少测量误差,每个实验对象测量3次,取3次测量数据平均值作为最终值。测量完成后,将实验对象靠在画有直径30 mm黑色圆形图案标定纸墙上(标定图案用来换算真实面积),待鸡只稳定后进行图像拍摄,作为计算鸡冠肉垂面积图像数据(拍摄过程如图2c所示)。

图2 手工测量法与图像处理法采集示意图

Fig.2 Manual measurement and image processing methods schematic

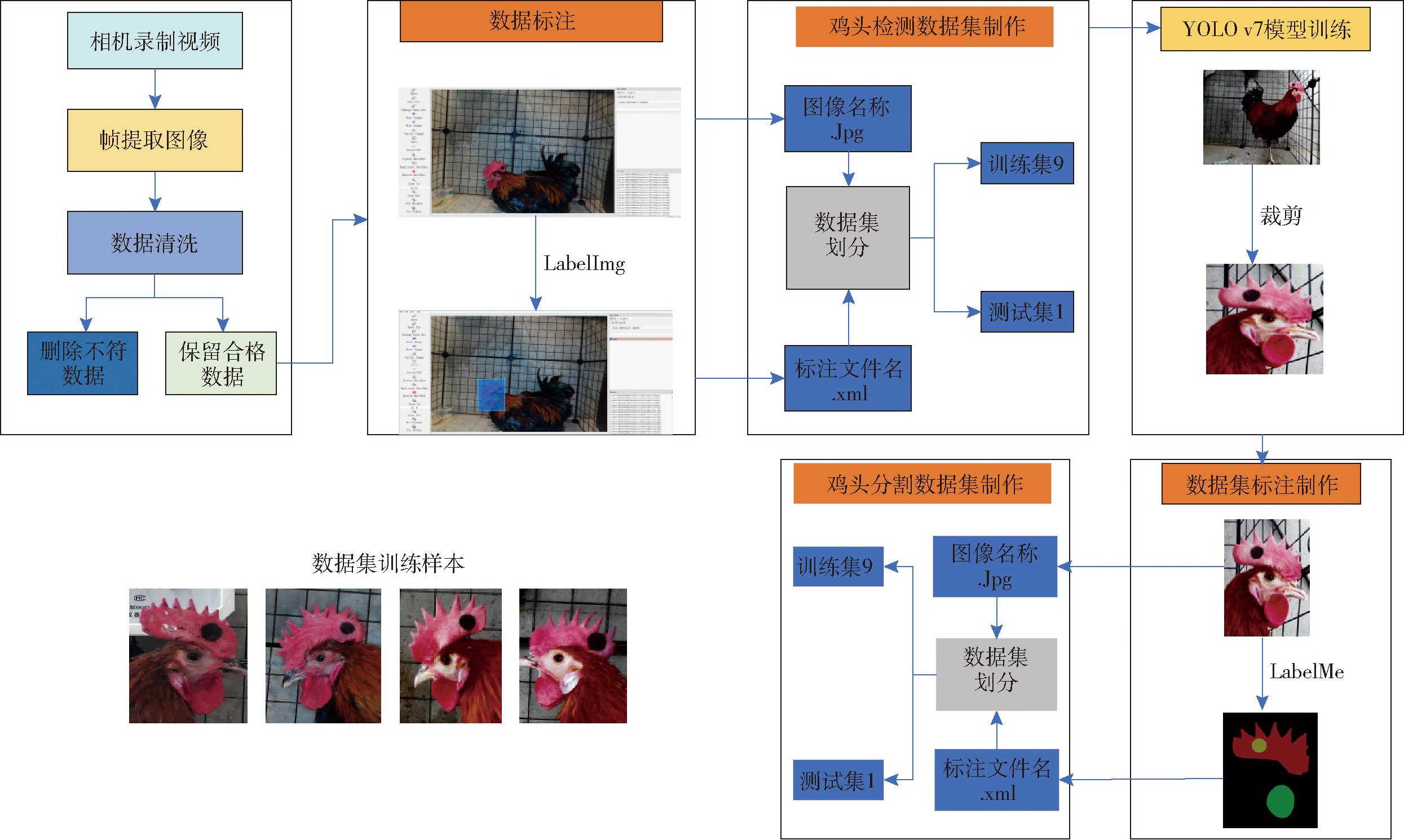

为避免非鸡冠和肉垂部分对面积计算结果的干扰,突出鸡冠和肉垂特征,采用YOLO v7模型对视频中的鸡头部分进行分割、裁剪,构建鸡头识别数据集,数据集构建过程如图3所示。

图3 数据集构建过程图

Fig.3 Dataset construction diagram

2023年9月4—5日采集的视频数据被用来训练YOLO v7模型,以精准裁剪侧面正对摄像头的鸡头图像;利用训练好的YOLO v7模型,对8月1—12日采集的视频数据中鸡头图像进行裁剪,制作分割模型训练数据集,用来训练U-Net模型。将9月4—5日采集的视频片段,每隔25帧提取1幅图像,获取不同位置不同行为姿态鸡只图像。去除模糊图像,对帧提取后图像进行数据清洗[30],最终获得共2 000幅侧面正对摄像头鸡头图像数据。使用开源软件LabelImg对图像进行标注[31],制作Pascal VOC格式鸡头侧面检测数据集。将数据集以比例9∶1划分为训练集和验证集,最终得到由1 800幅图像组成的训练集,由200幅图像组成的验证集。对YOLO v7模型进行180次训练后,平均精度均值达到97.03%,在图像集或视频中可实现正对摄像头的侧向鸡头自动裁剪功能,避免后期人工筛选。对8月1—12日采集的视频数据进行分帧处理,每隔60帧提取1幅图像,利用YOLO v7模型对分帧处理后图像进行预测和裁剪,共获得约1 100幅鸡头图像数据。

利用LabelMe工具标注鸡冠、肉垂和标定图案,使用LabelMe2voc将JSON格式标注文件转换为Pascal VOC格式,以比例9∶1将鸡冠肉垂分割数据集划分为训练集和验证集,作为后续处理数据基础。

U-Net模型[11]采用端到端语义分割网络结构,由编码器和解码器组成。编码器捕获输入图像特征信息,减小特征图尺寸,提取图像低级和高级特征。编码器由4个子模块组成,每个子模块包含两个卷积核,子模块之间通过Maxpool池化层连接。解码器是将编码器提取的特征信息,还原为与输入图像大小相同的分割掩码。解码器也由4个子模块组成,子模块间通过上采样层连接。U-Net模型通过跳跃连接,将编码器获得的高分辨率特征与解码器获得的特征图进行融合,获取更详细特征信息,提高分割精度。解码器通过跳跃连接可以访问不同尺寸特征图信息,从而获得不同层次特征信息,提升模型对局部和全局特征信息捕捉能力。跳跃连接虽然增加了模型复杂性,但也增强了U-Net模型分割性能。

2.2.1 编码器部分改进

U-Net模型可使用实际拍摄的图像,不需要限定采集环境,因此,相较于需要特定背景采集图像的图像处理方法,更具有实用价值。为进一步避免背景信息干扰,提高图像分割精度,本文通过在特征提取部分引入CoTNet50模型对U-Net模型进行优化,CoTNet50模型的CoT (Contextual Transformer)模块[32]可以通过对静态和动态上下文信息的融合学习,进一步丰富特征表现,提高U-Net图像信息捕捉能力,因此可在特征提取过程中,更好地保留鸡冠肉垂特征,有效避免背景信息干扰。

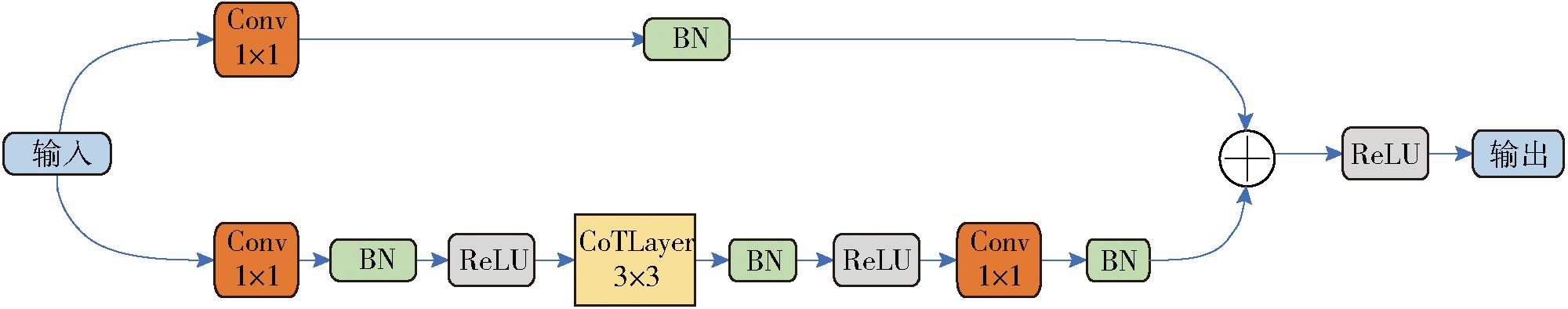

CoTNet50模型具有强大图像分类、对象检测、语义分割和姿势估计等计算机视觉任务能力。CoTNet50模型采用类似残差网络的结构框架,通过在Bottleneck结构中引入CoT块,实现静态和动态上下文信息融合,增强网络性能,提高分割任务准确率,Bottleneck结构如图4所示。

图4 CoTNet50模型Bottleneck结构图

Fig.4 CoTNet50 network model Bottleneck structure diagram

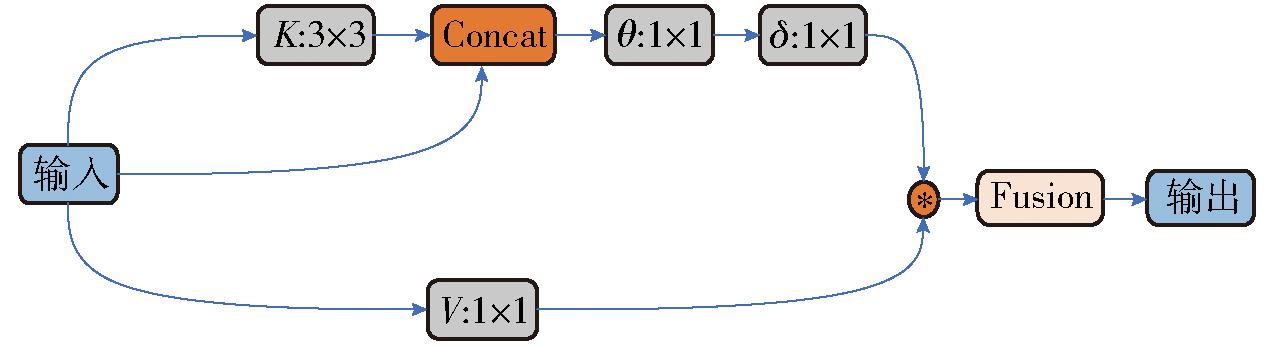

CoT块结构图如图5所示。CoT块采用Transformer风格,输入特征经过3×3卷积处理,获取静态上下文信息,并将提取后的信息与输入信息进行拼接;通过两个1×1的卷积核,学习调整动态多头注意力矩阵,将静态和动态上下文信息融合输出,增强模型特征表达能力,更好地处理不规则鸡冠肉垂特征。

图5 Contextual Transformer (CoT)结构图

Fig.5 Contextual Transformer (CoT) structure diagram

2.2.2 解码器部分改进

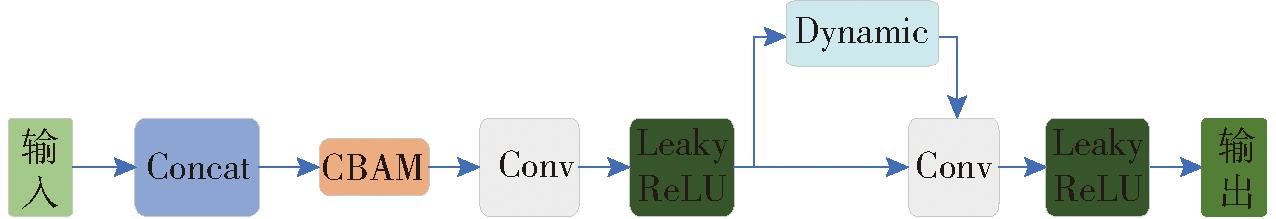

鸡冠肉垂凸出和凹陷等不规则部分是分割的难点,实现精准分割需要更高精确性和更详细特征信息。为丰富上采样特征信息,本文构建了可以动态捕捉输入信息局部特征和语义信息的DyC-UP上采样层,上采样层结构如图6所示。上采样层结构由标准卷积、CBAM注意力机制、Leaky ReLU函数以及动态卷积组成。标准3×3卷积从融合的低分辨和高分辨特征图中提取特征;CBAM注意力机制细化特征表示[33];DynamicConv通过注意力动态聚合多个并行卷积核[34],进一步提取和细化特征,更好地获取局部和全局信息;上采样层通过添加Leaky ReLU函数增加模型非线性表示,缓解神经元输出为0不再更新问题。总体而言,DyC-UP上采样层通过特征学习动态调整卷积核,获得更丰富特征表示,保留更多特征信息,提高对细节分割精度,可增强鸡冠不规则突起细节的分割能力。

图6 DyC-UP上采样结构图

Fig.6 Structural diagram of DyC-UP upsampling module

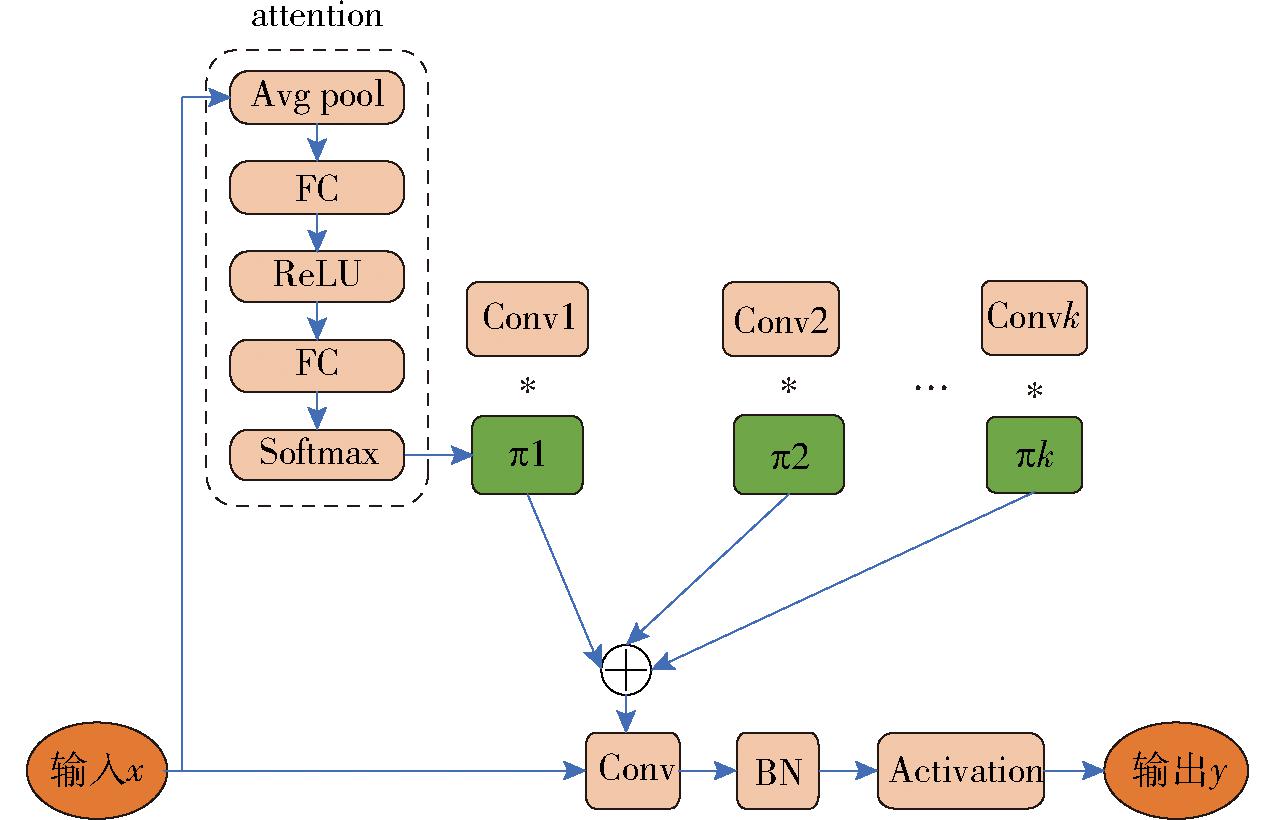

DynamicConv是传统卷积的改进卷积,每层根据注意力机制,以非线性方式动态聚合多个并行卷积核。DynamicConv根据输入信息特征,学习生成特征图权重,将特征图权重与输入特征图相乘,得到不同尺寸特征图,拼接这些特征图,获得更丰富特征信息,因此具有强大特征学习能力,DynamicConv具体结构如图7所示。

图7 DynamicConv结构图

Fig.7 DynamicConv structure diagram

2.2.3 U-Net网络结构改进

改进U-Net模型结构如图8所示。改进U-Net模型通过特征提取部分融入CoT块的CoTNet50模型,构建基于DynamicConv、CBAM机制及Leaky ReLU函数的上采样层,分析周围像素及像素序列位置,降低背景干扰,保留更多细节特征,获取局部细节和全局上下文信息,捕捉边缘、纹理等特征,动态调整卷积核参数,扩大模型感受野,增强鸡冠肉垂分割能力。由于U-Net模型不具有像素统计和面积换算功能,因此在predict.py脚本中添加相应的转换算法,实现鸡冠肉垂真实面积计算功能。

图8 改进U-Net模型结构图

Fig.8 Improved U-Net network structure diagram

结合深度学习和像素统计方法,确定鸡冠肉垂面积计算过程。①鸡头裁剪:使用权重文件1的YOLO v7模型对原始数据预测,舍弃鸡头侧面未正对镜头图像,并剪裁出鸡头侧面正对镜头图像。②鸡冠肉垂分割:利用权重文件2的优化U-Net模型,对裁剪出的鸡头图像进行分割训练,获得鸡冠、肉垂和标定物分割效果图。③像素统计:使用像素统计方法,计算分割效果图中鸡冠、肉垂和标定图案像素数量。④面积计算:根据标定图案像素数与真实面积关系,求得图像标定系数,标定系数计算式为

(1)

式中 Δy——标定系数

Sb——标定图案像素数

Zb——标定图案真实面积

鸡冠像素数Sc除以标定系数,加上标定图案真实面积,得到鸡冠真实面积Zc,即

(2)

肉垂像素数Sw除以标定系数,即可获得肉垂真实面积Zw,即

(3)

通过标定图案真实面积1.77,可以计算出鸡冠肉垂实际面积。结合深度学习和像素统计方法计算鸡冠肉垂面积,流程如图9所示。

图9 鸡冠肉垂面积计算流程图

Fig.9 Calculation diagram of the area of comb and wattle

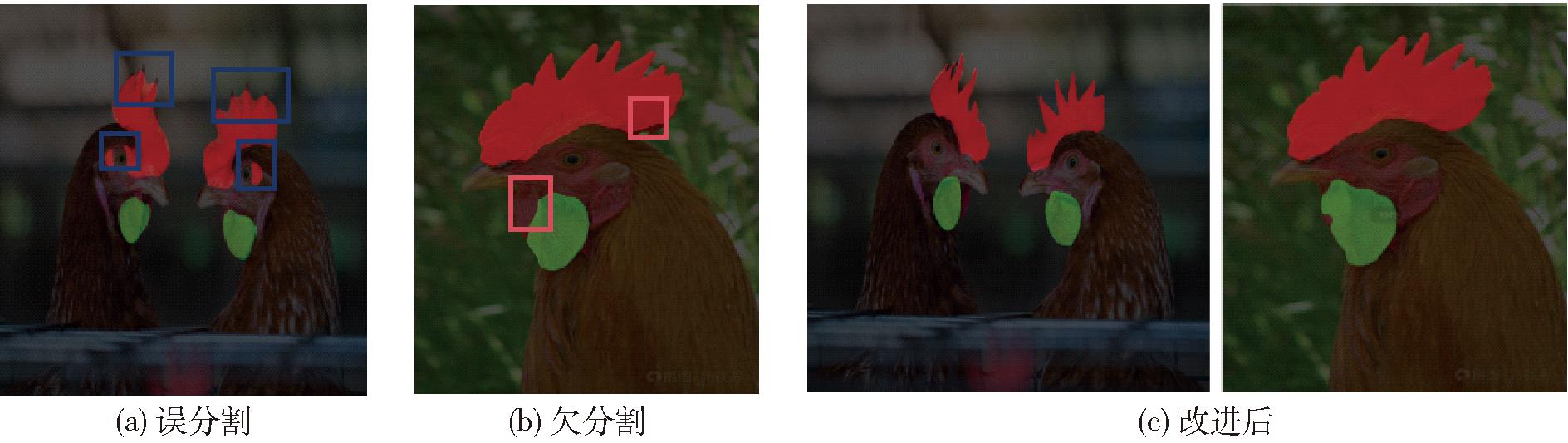

精准分割是实现鸡冠肉垂面积准确计算的前提,分割过程中的误分割和欠分割会影响计算精度。误分割是将非鸡冠肉垂部分错误分割为鸡冠肉垂,误分割会导致面积计算结果偏大,如图10a用蓝框圈出的部分,将鸡头眼睛、肉垂间隔区域以及鸡冠棱刺间的间隔都错误地识别为鸡冠,导致鸡冠面积计算偏大。欠分割是少分割了一部分,如图10b红框所示部分,未能识别肉垂和鸡冠的部分特征,没有准确分割,导致后续面积计算值偏小。因此,在分割过程中,需要消除误分割和欠分割现象,通过对U-Net提高分割精度,减小面积计算误差。本文通过优化U-Net模型的特征提取部分和上采样部分,缓解了模型对鸡冠和肉垂的过分割和欠分割现象,效果如图10c所示。

图10 分割效果

Fig.10 Segmentation effect maps

在数据预处理阶段使用小米便携式计算机Pro 14(2021版),搭载AMD R5 5600H CPU。模型训练在服务器上进行,服务器配备Nvidia GeForce RTX 2080 Ti GPU,具体配置如表1所示。输入图像尺寸设置为512像素×512像素,迭代次数(Epoch)设定为200,训练批量大小(Batch size)设定为6,线程数(Num workers)设定为4。在模型训练过程中,使用VOC数据集训练的权重作为预训练权重。实验中超参数设置:初始学习率设定为0.001,采用余弦退火算法进行学习率衰减,优化器选择Adam,动量(Momentum)设定为0.9。

表1 硬件配置和实验环境

Tab.1 Hardware configuration and experimental environment

硬件配置环境版本操作系统Ubuntu18.04Python3.7CPU Intel(R) Xeon(R) Platinum 8255CPyTorch1.8.1GPUNVIDIA GeForce RTX 2080TiCuda10.0

采用交并比(Intersection over union,IoU)、召回率(Recall,R)、精确率(Precision,P)为模型评价指标。IoU用于评价每个类别预测分割区域与实际分割区域重叠程度;召回率衡量每个类别中正确预测像素数与真实像素数比率;精确率表示真实类别像素数量占所有预测为该类别像素数量比例。使用参数量、浮点运算量和检测速度对模型复杂度、计算效率和实时性进行评估。

为验证本文提出的预处理方案是否有助于提升模型训练精度,对未经YOLO v7模型处理原始视频数据进行了一系列操作,包括分帧、图像筛选和数据清洗等。使用LabelMe工具对获得的图像进行标注,制作数据集,作为预处理方案1(以下简称为预案1)。本文提出预处理方法制作的数据集作为预处理方案2(以下简称为预案2)。在相同迭代次数和超参数设置下,分别使用U-Net模型和DeepLabV3+模型对两个不同数据处理方法进行训练,以IoU、R和P作为评价指标进行评价,评价结果如表2所示。

表2 不同数据处理方法结果对比

Tab.2 Comparison of different data processing methods %

模型IoURP鸡冠肉垂标定图案鸡冠肉垂标定图案鸡冠肉垂标定图案预案1+UNet73.6464.0580.1392.7187.6391.3978.1668.5986.67预案1+DeepLabV3+84.5475.5683.4392.3692.1485.7684.7778.7889.32预案2+UNet86.0482.6589.9396.0388.6094.4188.4390.4093.98预案2+DeepLabV3+85.0276.7883.4496.3694.1786.4386.6880.6193.01

由表2可知,预案2训练的U-Net模型比预案1训练的U-Net模型,IoU分别高出12.4、18.60、9.8个百分点;在R上分别高出3.32、0.97、3.02个百分点;P分别高出10.27、21.81、7.31个百分点。综上所述,使用预案2各项指标均优于预案1。

预案2训练的DeepLabV3+模型比预案1训练的DeepLabV3+模型,在IoU上,鸡冠、肉垂和标定图案分别高出0.48、1.22、0.01个百分点;R分别高出4.00、2.03、0.67个百分点;P分别高出1.91、1.83、3.69个百分点。综合而言,使用预案2训练的DeepLabV3+模型在各项指标上均优于使用预案1训练的DeepLabV3+模型。

上述结果表明,经过YOLO v7模型处理后数据集质量明显提高,U-Net和DeepLabV3+模型分割效果明显优于直接标注制作的数据集,而且YOLO v7模型可直接对原始视频数据进行预处理,省去了视频分帧、筛选和数据清洗等操作,节省人力和时间,同时提高了分割模型准确性。

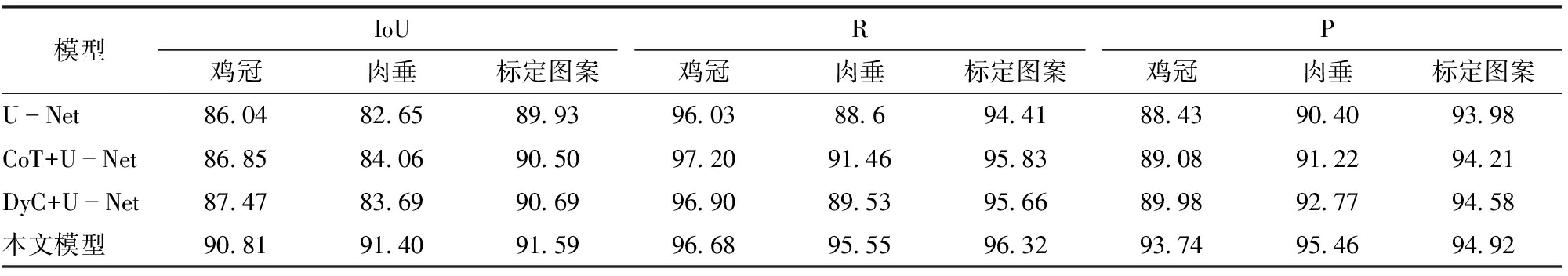

为了验证本文改进方案是否可以提高模型精度,对原模型及各改进部分的模型以及最终改进模型进行对比。其中CoT + U-Net为添加CoT 块的U-Net模型,DyC+ U-Net为使用DyC-UP上采样层的U-Net模型。不同模型采用相同测试集进行性能评价,评价对比结果如表3所示。

表3 改进模型性能对比

Tab.3 Model improvement comparison %

模型IoURP鸡冠肉垂标定图案鸡冠肉垂标定图案鸡冠肉垂标定图案UNet86.0482.6589.9396.0388.694.4188.4390.4093.98CoT+UNet86.8584.0690.5097.2091.4695.8389.0891.2294.21DyC+UNet87.4783.6990.6996.9089.5395.6689.9892.7794.58本文模型90.8191.4091.5996.6895.5596.3293.7495.4694.92

由表3可知,CoT+U-Net模型在鸡冠、肉垂和标定图案上的IoU均高于U-Net模型,分别提高了0.81、1.41、0.5个百分点;DyC+U-Net模型在这3个类别上的效果优于U-Net模型,分别提高1.43、1.04、0.76个百分点;本文模型在这3个类别上均高于U-Net模型,分别提高4.77、8.75、1.66个百分点;本文模型相较于CoT+U-Net模型和DyC+U-Net模型均有提高,分别提高3.96、7.34、1.09个百分点和3.34、7.71、0.9个百分点。

CoT+U-Net模型在鸡冠、肉垂和标定图案上R均高于U-Net模型,分别提高1.17、2.86、1.42个百分点;DyC+U-Net模型在这3个类别上效果优于U-Net模型,R分别提高0.87、0.93、1.25个百分点;本文模型在这3个类别上R均高于U-Net模型,分别提高0.65、6.95、1.91个百分点;本文模型相较于CoT+U-Net模型和DyC+U-Net模型在鸡冠类别上R稍低,但在其余两个类别上分别提高4.09、0.49个百分点和6.02、0.66个百分点。

CoT+U-Net模型在鸡冠、肉垂和标定图案上P均高于U-Net模型,分别提高0.65、0.82、0.23个百分点;DyC+U-Net模型在这3个类别上的效果优于U-Net模型,P分别提高1.55、2.37、0.60个百分点;本文模型在这3个类别上P均高于U-Net模型,分别提高5.31、5.06、0.94个百分点;本文模型相较于CoT+U-Net模型和DyC+U-Net模型P均有提高,分别提高4.66、4.24、0.71个百分点和3.76、2.69、0.34个百分点。

总体而言,本文模型各评价指标表现出色,优于U-Net模型、CoT+U-Net模型以及DyC+U-Net模型,能够更精确地对鸡冠、肉垂和标定图案进行分割,为后续的面积计算提供更精确的数据。

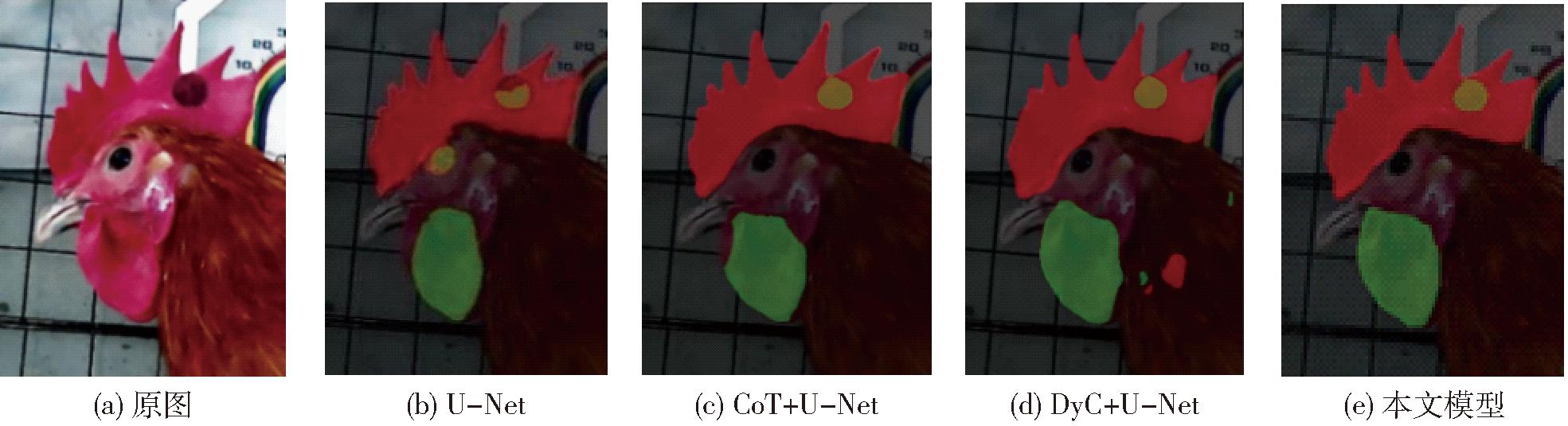

为了验证本文模型对鸡冠、肉垂以及标定图案分割效果的影响,使用U-Net模型、CoT+U-Net模型、DyC+U-Net模型与本文模型对同一幅图像进行预测并对比效果,效果如图11所示。

图11 分割效果对比

Fig.11 Segmentation effect comparison maps

由图11b可知,U-Net分割图存在严重的过分割和欠分割情况,如鸡冠类别将标定图案的一部分识别为鸡冠分割出来,导致鸡冠类别的面积相较正常鸡冠面积偏大,这是由于鸡头部位主要是红色,鸡冠与眼睛周围的红色难区分;肉垂类别则存在欠分割情况,这是由于图中肉垂有褶皱,以褶皱线为分界线,将区域面积大的部分分割出来,区域面积小的部分则被遗漏;标定图案类别既存在欠分割情况,也存在将鸡眼误识别为标定图案的过分割情况,这是由于鸡眼也是黑色的,导致模型识别错误。CoT+U-Net模型的分割如图11c所示,它在主干网络中引入了CoT块,通过融合静态和动态上下文信息来增强特征提取部分的能力,有效地缓解了各类别的过分割现象,但肉垂类别仍存在欠分割现象;DyC+U-Net模型的分割如图11d所示,通过构建DyC-UP上采样层和动态调整卷积核,在上采样过程中获得更丰富的特征表示,更好地捕获各类别的边缘轮廓,以缓解欠分割现象,但由于鸡羽毛的颜色与鸡冠和肉垂的颜色相近,仍存在过分割现象;图11e为本文模型的分割图,其融合了CoT块和DyC-UP上采样层,有效缓解了过分割现象和欠分割现象,为后续面积计算提供精确的数据来源。

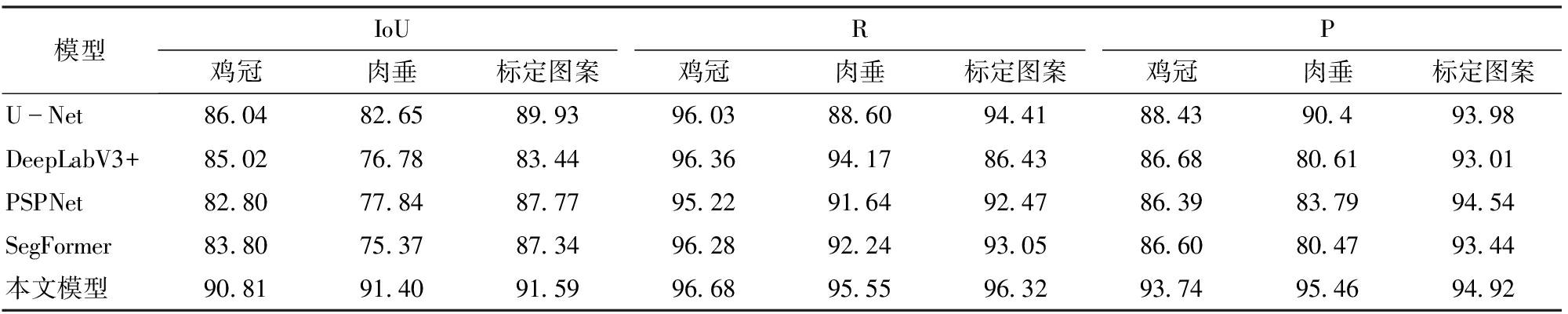

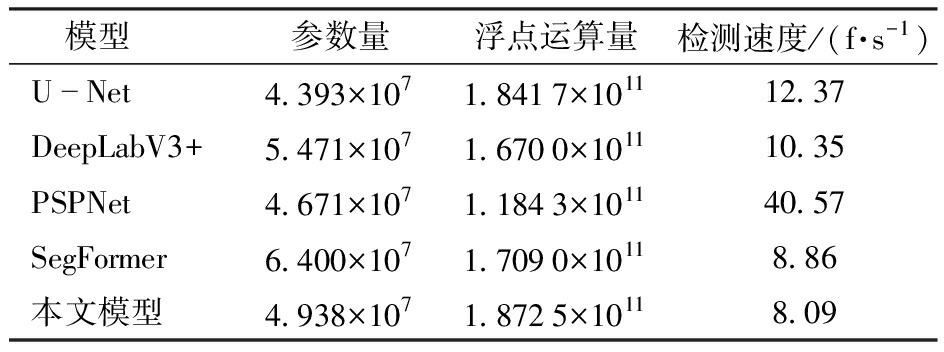

为检验改进U-Net模型分割效果,使用YOLO v7模型预处理后数据集,对U-Net模型、DeepLabV3+模型、PSPNet模型、SegFormer模型以及本文模型进行训练,采用相同测试集进行性能评价,评价对比结果如表4所示。各模型参数对比如表5所示。

表4 不同模型训练数据对比

Tab.4 Comparison of different models’ training data %

模型IoURP鸡冠肉垂标定图案鸡冠肉垂标定图案鸡冠肉垂标定图案UNet86.0482.6589.9396.0388.6094.4188.4390.493.98DeepLabV3+85.0276.7883.4496.3694.1786.4386.6880.6193.01PSPNet82.8077.8487.7795.2291.6492.4786.3983.7994.54SegFormer83.8075.3787.3496.2892.2493.0586.6080.4793.44本文模型90.8191.4091.5996.6895.5596.3293.7495.4694.92

表5 不同模型参数对比

Tab.5 Comparison of different models parameters

模型参数量浮点运算量检测速度/(f·s-1)UNet4.393×1071.8417×101112.37DeepLabV3+5.471×1071.6700×101110.35PSPNet4.671×1071.1843×101140.57SegFormer6.400×1071.7090×10118.86本文模型4.938×1071.8725×10118.09

由表4可知,相较于其他模型,本文模型各项评价指标均具有显著优势。从IoU评价指标看,本文模型在所有类别鸡冠、肉垂以及标定图案上均超过了90%,表明本文模型能够生成与实际标记高度相符分割结果。在鸡冠类别上,本文模型相较于标准U-Net模型、DeepLabV3+模型、PSPNet模型和SegFormer模型,分别高出4.77、5.79、8.01、7.01个百分点;在肉垂类别上,分别高出8.75、14.62、13.56、16.03个百分点;在标定图案类上,分别高出1.66、8.15、3.82、4.25个百分点。数据表明,改进U-Net模型在鸡冠、肉垂和标定图案精确分割方面明显优于其他模型。

在鸡冠、肉垂以及标定图案上本文模型R均超过90%,表明本文模型能够生成与实际标记高度相符分割结果。在鸡冠类别上,本文模型相较于标准U-Net模型、DeepLabV3+模型、PSPNet模型和SegFormer模型,R分别高出0.65、0.32、1.46、0.4个百分点;在肉垂类别上,R分别高出6.95、1.38、3.91、3.91个百分点;在标定图案类别上,R分别高出1.91、9.89、3.85、3.27个百分点。数据表明,改进U-Net模型在鸡冠、肉垂和标定图案精确分割方面明显优于其他模型。

本文模型在鸡冠、肉垂和标定图案P分别为93.74%、95.46%和94.92%。在鸡冠类别上,本文模型比标准U-Net模型、DeepLabV3+模型、PSPNet模型和SegFormer模型,P分别高出5.31、7.06、7.35、7.14个百分点;在肉垂类别上,本文模型相较于上述模型,P分别高出5.06、14.85、11.67、14.99个百分点;在标定图案类别上,P分别高出0.94、1.91、0.38、1.48个百分点。本文模型P均高于其他对比模型,综合比较,本文模型对鸡冠和肉垂的分割精度更优。

由表5可知,本文模型参数量和浮点运算量比U-Net模型大,分别增加5.450×106、3.080×109;检测速度降低4.28 f/s。综合表3数据,本文改进模型相对于U-Net模型在鸡冠、肉垂以及标定图案的IoU分别提升4.77、8.75、1.66个百分点。在参数量、浮点运算量以及检测速度降低的情况下,分割精度有较大提升。虽然PSPNet模型的帧速达到40.57 f/s,但本文模型在IoU上相较于PSPNet模型,提高8.01、13.56、3.82个百分点。此外,本文模型R和P均优于对比模型。

总体来看,尽管本文模型参数量和浮点运算量有所增加,处理速度稍有下降,但所有评价指标都表现出色,取得了显著提升。因此,在需要对不规则鸡冠和肉垂图形进行高精度分割时,改进模型具有明显精度优势,可为后续面积计算提供精确数据。

随机选取6只公鸡,利用绝对误差和相对误差指标,对比分析本文方法和常用鸡冠肉垂面积计算方法准确度,结果如表6所示(其中,对比1为本文方法与图像处理法对比,对比2为图像处理法与手工测量法对比。由于手工测量法没有肉垂面积计算,所以对比2仅与手工测量法的鸡冠面积进行对比)。常用鸡冠肉垂面积计算方法有手工测量法和图像处理法。手工测量法通过手工测量冠长和冠高,利用三角形面积近似计算得到鸡冠面积,手工测量肉垂面积方法目前暂未见到。图像处理法通过将形状各异鸡冠肉垂平铺在平面上拍照,利用图像处理技术计算像素面积得到鸡冠肉垂面积。由于图像处理法可以较好地计算得到鸡冠肉垂轮廓面积,因此以图像处理法计算结果作为对比标准值。

表6 不同面积测量方法对比

Tab.6 Comparison of different area measurement methods

实验对象序号类别对比1对比2标准面积/cm2本文方法测量面积/cm2绝对误差/cm2相对误差/%标准面积/cm2手工测量面积/cm2绝对误差/cm2相对误差/%1鸡冠26.9725.351.626.0126.9723.393.5815.31肉垂9.4910.060.576.019.492鸡冠26.6727.090.421.5726.6719.407.2737.47肉垂7.709.321.6221.047.703鸡冠21.7922.410.622.8521.7915.805.9937.91肉垂6.968.851.8927.166.964鸡冠25.6927.151.465.6825.6918.996.7035.28肉垂10.0310.500.474.6910.035鸡冠27.4128.561.154.2027.4120.696.7232.48肉垂10.488.392.0919.9410.486鸡冠16.2316.300.070.4316.2310.595.6453.26肉垂5.396.090.7012.995.39

由表6可知,图像处理法与手工测量法绝对误差为3.58~7.27 cm2,相对误差为15.31%~53.26%。这是因为手工测量法通过三角形近似计算鸡冠面积,但是鸡冠形状不全类似三角形形状,导致计算结果出现较大误差。本文方法与图像处理法所得鸡冠面积绝对误差为0.07~1.62 cm2,相对误差为0.43%~6.01%。6个实验对象中,所得面积相差最小的是实验对象6,其测量面积与标准面积相差仅为0.07 cm2,面积相差最大的是实验对象1,其测量面积与标准面积相差1.62 cm2,但与手工测量值最小误差3.58 cm2相比,仍有较好的精度。实验结果表明,本文方法相较手工测量法在准确率上有较大提升。

由表6可知,6个实验对象肉垂面积与标准值相比,绝对误差为0.47~2.09 cm2,相对误差为4.69%~27.16%。其中,肉垂面积误差相对较大,这是因为肉垂易发生形变,随着鸡只运动,肉垂会产生较大形变,在视频中很难采集到肉垂的标准形状,所以肉垂的测量值浮动较大。

分析结果表明,本文方法计算鸡冠面积准确率较高,虽在肉垂面积计算方面尚有提升空间,但相较于图像处理法,本文方法省时省力,更易实现自动化,且能克服人工拍照采集数据带来的应激及疾病传播问题,在智能化农业发展过程中更有优势。

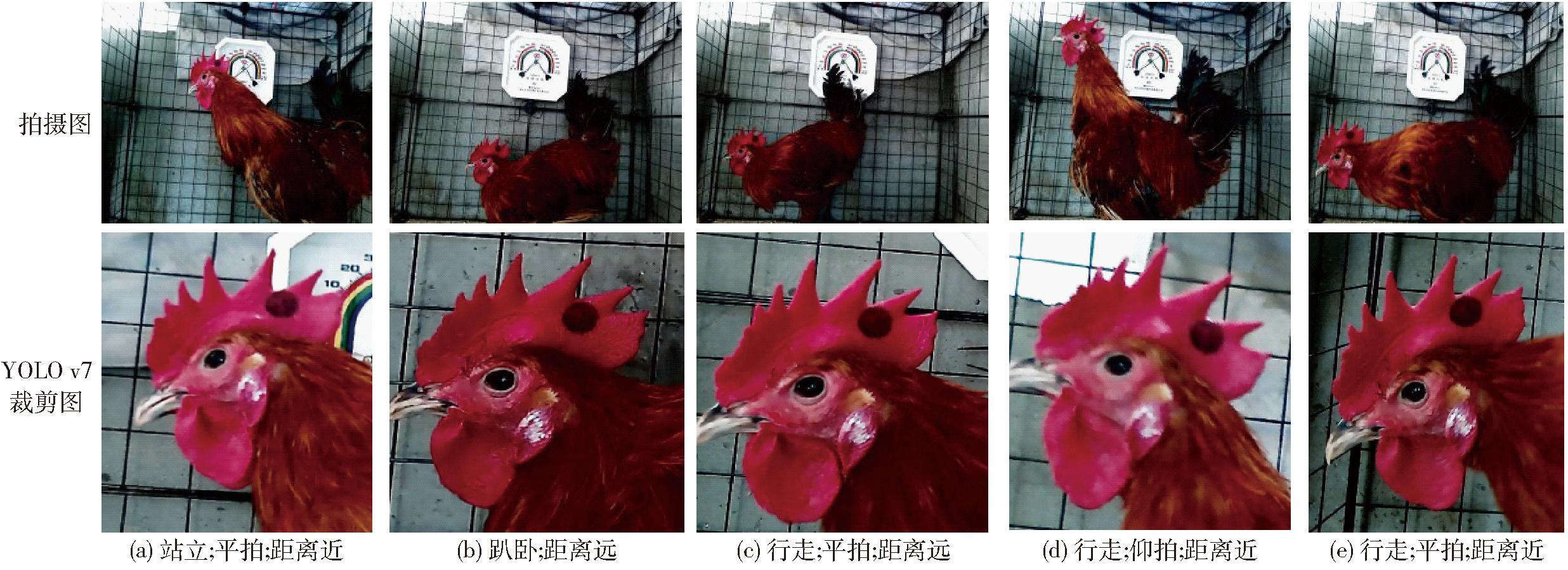

为进一步检验本文方法在不同姿态、不同拍摄角度和不同拍摄距离情况下的计算效果,选择3种姿态(站立、趴卧、行走)、2种角度(平拍、仰拍)和2种距离(距摄像头远、近)鸡只图像进行效果验证,如图12所示。利用本文方法计算图像中鸡冠肉垂面积,并与标准值进行对比,使用绝对误差和相对误差进行评价,评价结果如表7所示(实验对象序号对应图12分图序号)。

表7 不同状态面积测量结果对比

Tab.7 Comparison results of area measurements in different states

实验对象序号类别标准面积/cm2本文方法测量面积/cm2绝对误差/cm2相对误差/%1鸡冠25.6926.901.214.71肉垂10.0311.631.6015.952鸡冠25.6927.952.268.80肉垂10.0310.560.535.283鸡冠25.6926.310.622.41肉垂10.039.930.101.004鸡冠25.6929.193.5013.62肉垂10.0312.962.9329.215鸡冠25.6927.551.867.24肉垂10.0310.340.313.09

图12 不同状态鸡只示意图

Fig.12 Different states of chickens schematics

从表7可知,本文方法对不同姿态、不同拍摄角度和不同拍摄距离鸡冠面积计算结果绝对误差为0.62~3.50 cm2,相对误差为2.41%~13.62%。相对误差最大的是图12d,主要与仰拍视角有关。仰拍图像中标定图案变小,导致像素面积统计值与真实面积换算值也相应减小,因此与其他图像相比,鸡冠真实面积与标准面积差异变大。相反,通过平拍视角获取的面积相对误差均在9%以内,尤其是图12c的形态,其与标准面积相对误差仅为2.41%。由表7可知,本文方法对不同拍摄距离和不同姿态公鸡肉垂面积计算结果绝对误差为0.10~2.93 cm2,相对误差为1.00%~29.21%。从绝对误差角度来看,肉垂面积误差与鸡冠面积误差相差甚微,但由于肉垂本身较小,导致相对误差较大。肉垂面积产生误差的主要因素是,肉垂形状易受鸡只运动影响,产生褶皱或遮挡,从而影响面积计算准确性。

上述结果表明,本文方法对于不同姿态、不同拍摄角度和不同拍摄距离鸡均具有良好的计算效果,尤其是在鸡冠面积计算方面,在利用摄像头水平拍摄采集数据的情况下,相对误差可以控制在9%以内,具有较高测量精度。这一结论不仅验证了本文方法的有效性,同时为图像采集过程中的采集摄像头安装位置及距离提供了理论依据,为减少肉垂面积计算的误差,后续可单独采集肉垂完全舒展的状态,进行单类别的面积计算。改进模型虽在分割效果上得到了较大提升,但参数量和浮点运算量有所上升,检测速度有所下降,后续可在保证分割效果的前提下,对模型进行轻量化处理,以更好地满足实际应用的需要。

(1)提出了一种基于YOLO v7和改进U-Net模型自动提取鸡冠和肉垂真实面积的方法。通过YOLO v7模型对采集的原始数据进行训练,筛选和裁剪鸡头部位的图像,突出鸡冠和肉垂特征,降低背景对分割效果的影响;改进U-Net模型,在特征提取部分,融入具有CoT块的CoTNet50模型,融合了静态和动态上下文信息,使模型能够更好理解每个像素在上下文中的意义,扩大模型感受野,提高模型对前景和背景的分割能力;构建了一种基于DynamicConv、CBAM机制及Leaky ReLU函数的上采样层,提高模型对复杂数据的处理能力,捕捉到更丰富的上下文信息,以及对关键信息的敏感度和准确性,提升模型对鸡冠和肉垂细节的分割能力。

(2)改进U-Net模型对鸡冠、肉垂以及标定物平均交并比为91.27%,相较于标准U-Net模型提升5.06个百分点;平均召回率提升3.17个百分点;平均精度提升3.77个百分点;改进U-Net模型分割精度有较好提升,可更好适用于鸡冠和肉垂的分割任务。

(3)实现了鸡只活动状态下鸡冠和肉垂真实面积的计算。通过YOLO v7模型和改进U-Net模型实现了对鸡活动状态下鸡冠和肉垂的面积采集,鸡冠面积相较于固定背景和位置的图像处理法的相对误差在9%以内,肉垂相对误差不大于29.21%,这是因为肉垂的形状容易受到公鸡运动的影响,产生褶皱或遮挡,且肉垂标准采集状态与鸡冠标准采集状态存在差异,很难同时采集到肉垂标准采集状态和鸡冠标准采集状态,因此可能影响面积计算的准确性。为减少肉垂面积计算误差,后续可单独采集肉垂完全舒展的状态,进行单类别面积计算。

[1] 张怡,毕思恺,许少成,等.2022年全球肉鸡生产、贸易及产业经济发展研究[J].中国畜牧杂志,2023,59(3):280-287.

[2] 朱宁.2022年蛋鸡产业发展形势及2023年展望[J].中国畜禽种业,2023,19(4):37-41.

[3] JOHANSEN S V, BENDTSEN J D, MARTIN R, et al. Broiler weight forecasting using dynamic neural network models with input variable selection[J]. Computers and Electronics in Agriculture, 2019, 159: 97-109.

[4] MCGARY S, ESTEVEZ I, BAKST M R, et al. Phenotypic traits as reliable indicators of fertility in male broiler breeders[J]. Poultry Science, 2002, 81(1): 102-111.

[5] SZTANDARSKI P, MARCHEWKA J, WOJCIECHOWSKI F, et al. Associations between neck plumage and beak darkness, as well as comb size measurements and scores with ranging frequency of Sasso and Green-legged Partridge chickens[J]. Poultry Science, 2021, 100(9): 101340.

[6] 张珍,廖千蕙,李淑霞,等.鸡冠面积大小的评估方法及其与体重、体尺性状的相关性分析[J].黑龙江畜牧兽医,2023(5):61-64.

ZHANG Zhen, LIAO Qianhui, LI Shuxia, et al. Evaluation method of comb area size and analysis of its correlation with body weight and body size[J]. Heilongjiang Animal Science and Veterinary Medicine, 2023(5):61-64. (in Chinese)

[7] 郭蓓佳,张晓雨,籍颖,等.基于鸡冠图像特征的蛋鸡产蛋早期产蛋量预测研究[J].中国家禽,2023,45(5):31-38.

GUO Beijia, ZHANG Xiaoyu, JI Ying, et al. Study on egg production prediction of laying hens based on comb image features[J]. China Poultry, 2023,45(5):31-38. (in Chinese)

[8] NAVARA K J, ANDERSON E M, EDWARDS M L. Comb size and color relate to sperm quality: a test of the phenotype-linked fertility hypothesis[J]. Behavioral Ecology, 2012, 23(5): 1036-1041.

[9] MUKHTAR N, KHAN S H. Comb: an important reliable visual ornamental trait for selection in chickens[J]. World’s Poultry Science Journal, 2012, 68(3): 425-434.

[10] 孙一平,李丹,蔺旭鸿,等.计算机视觉技术在家禽养殖与公鸡选种中应用综述[J].农业机械学报,2021,52(增刊):219-228,283.

SUN Yiping, LI Dan, LIN Xuhong, et al. Computer vision in poultry breeding and rooster selection[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021,52(Supp.):219-228,283. (in Chinese)

[11] RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[C]∥Medical Image Computing and Computer-assisted Intervention-MICCAI 2015: 18th International Conference, 2015: 234-241.

[12] XIAO X, LIAN S, LUO Z, et al. Weighted res-U-Net for high-quality retina vessel segmentation[C]∥2018 9th International Conference on Information Technology in Medicine and Education (ITME). IEEE, 2018: 327-331.

[13] CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Deeplab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 40(4): 834-848.

[14] CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv Preprint, arXiv:1706.05587, 2017.

[15] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

[16] BOLYA D, ZHOU C, XIAO F, et al. Yolact: real-time instance segmentation[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 9157-9166.

[17] BOLYA D, ZHOU C, XIAO F, et al. YOLACT++: better real-time instance segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020,42(7):1971-1980.

[18] HE K, GKIOXARI G, DOLL R P, et al. Mask R-CNN[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

R P, et al. Mask R-CNN[C]∥Proceedings of the IEEE International Conference on Computer Vision, 2017: 2961-2969.

[19] WANG X, KONG T, SHEN C, et al. SOLO: segmenting objects by locations[C]∥Computer Vision-ECCV 2020: 16th European Conference, 2020: 649-665.

[20] WANG X, ZHANG R, KONG T, et al. SOLOv2: dynamic and fast instance segmentation[J]. Advances in Neural Information Processing Systems, 2020, 33: 17721-17732.

[21] MAW S Z, ZIN T T, TIN P. Dairy cattle detection in loose housing calving pen by using semantic segmentation networks[J]. ICIC Express Letters PartB: Applications, 2022, 13(3): 279-286.

[22] ZHANG J, ZHUANG Y, JI H, et al. Pig weight and body size estimation using a multiple output regression convolutional neural network: a fast and fully automatic method[J]. Sensors, 2021, 21(9): 3218.

[23] 陈佳,刘龙申,沈明霞,等.基于实例分割的白羽肉鸡体质量估测方法[J].农业机械学报,2021,52(4):266-275.

CHEN Jia, LIU Longshen, SHEN Mingxia, et al. Breeding white feather broiler weight estimation method based on instance segmentation[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021,52(4):266-275. (in Chinese)

[24] 段恩泽,方鹏,王红英,等.基于深层卷积神经网络的肉兔图像分割与体质量估测[J].农业机械学报,2021,52(6):259-267.

DUAN Enze, FANG Peng, WANG Hongying, et al. Meat rabbit image segmentation and weight estimation model based on deep convolution neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021,52(6):259-267. (in Chinese)

[25] 王禹莎,王家迎,辛瑞,等.基于计算机视觉的大黄鱼体尺、体重性状表型测量装置开发和应用[J].水产学报,2023,47(1):207-216.

WANG Yusha, WANG Jiaying, XIN Rui, et al. Application of computer vision for morphological and body weight measurement in large yellow croaker (Larimichthys crocea)[J]. Journal of Fisheries of China, 2023,47(1):207-216. (in Chinese)

[26] 杨断利,王永胜,陈辉,等.基于SEEC-YOLO v5s的散养蛋鸡日常行为识别与统计系统[J].农业机械学报,2023,54(9):316-328.

YANG Duanli, WANG Yongsheng, CHEN Hui, et al. Daily behavior recognition and statistics system for free-range laying hens based on SEEC-YOLO v5s[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(9): 316-328. (in Chinese)

[27] 杨断利,齐俊林,陈辉,等.基于改进YOLO v8n模型的散养蛋鸡个体行为识别方法与差异分析[J].农业机械学报,2024,55(11):112-123.

YANG Duanli, QI Junlin, CHEN Hui, et al. Individual behavior recognition method and difference analysis for free-range laying hens based on improved YOLO v8n model[J]. Transactions of the Chinese Society for Agricultural Machinery, 2024, 55(11): 112-123.(in Chinese)

[28] 柏宗春,吕胤春,朱一星,等.基于改进Mask R-CNN的笼养死鸭识别方法[J].农业机械学报,2024,55(7):305-314.

BAI Zongchun, LÜ Yinchun, ZHU Yixing, et al. Cage-reared dead duck recognition method based on improved Mask R-CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2024, 55(7): 305-314.(in Chinese)

[29] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLO v7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023: 7464-7475.

[30] 杨断利,王永胜,陈辉,等.基于改进YOLO v6-tiny的蛋鸡啄羽行为识别与个体分类[J].农业机械学报,2023,54(5):268-277.

YANG Duanli, WANG Yongsheng, CHEN Hui, et al. Feather pecking abnormal behavior identification and individual classification method of laying hens based on improved YOLO v6-tiny[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(5):268-277. (in Chinese)

[31] 杨断利,王永胜,陈辉,等.复杂环境下蛋鸡个体识别与自动计数系统研究[J].农业机械学报,2023,54(6):297-306.

YANG Duanli, WANG Yongsheng, CHEN Hui, et al. Individual identification and automatic counting system of laying hens under complex environment[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(6):297-306. (in Chinese)

[32] LI Y, YAO T, PAN Y, et al. Contextual transformer networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 45(2): 1489-1500.

[33] WOO S, PARK J, LEE J Y, et al. Cbam: convolutional block attention module[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 3-19.

[34] CHEN Y, DAI X, LIU M, et al. Dynamic convolution: attention over convolution kernels[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 11030-11039.