在农业种植中,精准定位株心位置对精准施肥[1-4]、农机视觉导航[5-11]等意义重大。然而由于自然环境的复杂性和叶冠外观多样性,实现准确高效的玉米株心定位一直是一个难题。

近年来,国内外很多研究团队通过分析作物形态、颜色等图像特征进行株心定位[12-13]。但传统图像处理算法在识别过程中过于依赖作物形态、颜色及纹理特征,识别效果不稳定,田间适用性差[14]。随着深度学习技术的不断发展,很多学者开始通过构建复杂神经网络的方式,自动学习和提取图像中的关键特征,解决传统图像处理方法在田间适用性差的问题[15-17]。但现有研究所用方法可靠性低,无法有效解决因玉米叶冠长宽比例大、叶片交叉重叠、杂草密集伴生等而导致的株心定位困难问题[18-19]。旋转目标检测在水平目标检测的基础上增加了旋转角度预测,最早应用于文字识别[20-22]和遥感领域[23-24]。相较于水平目标检测,旋转目标检测算法在处理具有特定角度或非水平方向的物体时具有明显优势[25-27],近年来也开始应用于农业领域[28-30]。旋转目标检测算法在复杂背景下密集遮挡的小目标检测中优于水平目标检测算法[29],能更精准地捕获目标位置而不受其他干扰,能为具有长宽比例大特点的密集目标提供更为准确的定位信息[30]。

目前应用旋转目标检测算法对玉米株心定位开展的相关研究较少,上述研究证明了将旋转目标检测应用在农业领域的可行性,为玉米株心定位研究提供了技术支持。但在自然环境下玉米叶冠交叉重叠,颜色、形态及纹理特征与伴生杂草相似,增加了模型提取叶冠特征和识别叶冠边缘的难度。针对上述问题,本文提出一种高贴合的旋转目标检测网络LCA-YOLO v7OBB及一种能有效减少边缘精度缺失的标注策略。该方法结合玉米叶冠长宽比例大、叶片交叉重叠、杂草密集伴生特点对基线模型和标注策略进行改进,以期实现对玉米株心精准定位。

实验数据采集自吉林农业大学实验田,实验品种为吉农玉2300,采集时间为2023年5月至6月。实验数据的获取设备为红米K40智能手机,采用距地面50~60 cm高度垂直拍摄。图像原始分辨率为3 000像素×3 000像素,保存为jpg格式。为了保证数据集多样性和普遍性,分别在早上、中午、傍晚、晴天以及阴天等不同场景下对大田玉米进行拍摄得到2 019幅数据。经过处理和筛选,剔除模糊及不包含目标的无关图像,得到1 800幅玉米叶冠原始图像。

标注方式越准确,提供给网络训练时的冗余信息就越少。由于玉米叶冠长宽比例大且不同株叶冠倾斜交叉,使用水平边界框易产生大量无关干扰,导致模型学习到干扰信息。为解决该问题,使用旋转边界框。旋转边界框在水平边界框的基础上增加旋转角度,能更好适应玉米叶冠形态特征,为训练提供更准确的目标信息。

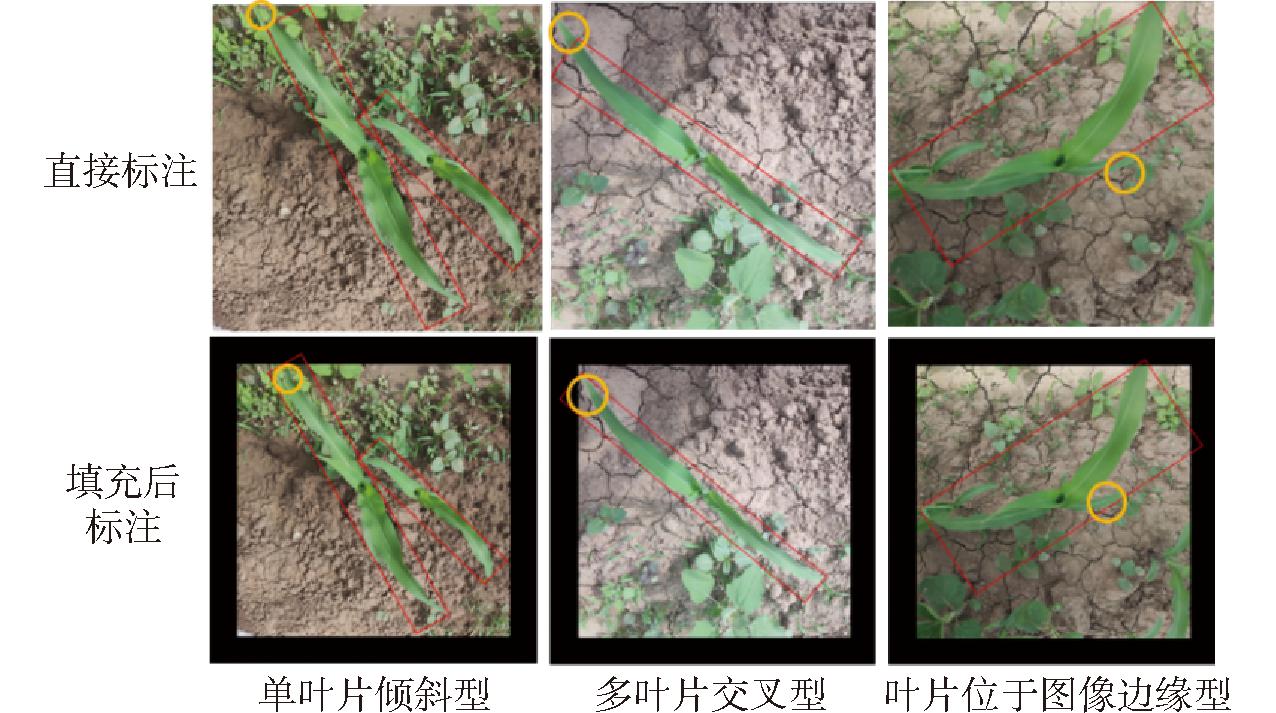

旋转边界框由中心点坐标(x,y)、宽度w、高度h及旋转角θ组成,在已有研究中目标对象多集中于图像中心,研究人员采用直接标注方式。但旋转边界框旋转角度受图像边缘限制,对于玉米叶冠这类长宽比例大、角度多变的目标,直接标注法会导致边缘精度缺失。针对上述问题,提出一种能有效减少边缘精度缺失的标注策略,即标注前对图像进行黑色边缘填充操作。通过扩展图像的边缘区域,确保对图像边缘进行准确标注,避免信息损失,图1为直接标注和填充后标注对比。与直接标注法相比,无论是在单叶片倾斜、多叶片交叉还是叶片位于图像边缘场景下,填充后标注策略都能更准确地捕捉黄色圆圈内的细节信息,克服直接标注法在图像标注上的局限性。将标注好的数据按照比例8∶1∶1划分,得到训练集1 440幅、验证集180幅和测试集180幅,本实验中所需叶冠数据均使用该数据集。

图1 直接标注和填充后标注对比

Fig.1 Different annotation methods comparison

YOLO v7网络由输入端、主干特征提取网络、加强特征提取网络和检测头组成。输入端通过马赛克数据增强方法,对4幅图像进行随机裁剪和拼接,提供多样性输入。主干特征提取网络对输入图像进行特征提取,得到3个不同尺寸的特征层。加强特征网络结合3个有效特征层的特征信息进行特征融合,得到3个加强过的有效特征层。检测头将特征图看作特征点的集合,对每个特征点上的3个先验框进行判断,得到预测结果。

YOLO v7OBB在YOLO v7的基础上,引入旋转边界框。在检测头中增加旋转角θ这一维度,每一特征检测层第3维度前5个参数用于判断每一个特征点回归参数(x,y,w,h,θ),回归参数调整后可以获得预测框,用于实现物体的旋转边界框检测。YOLO v7OBB通过引入旋转框中心坐标、宽度、高度和旋转角,有效解决水平目标检测网络对旋转物体检测的局限性。采用旋转边界框坐标回归损失函数和旋转角误差损失函数,优化目标真实值和预测值之间误差,提高检测准确性和稳定性。

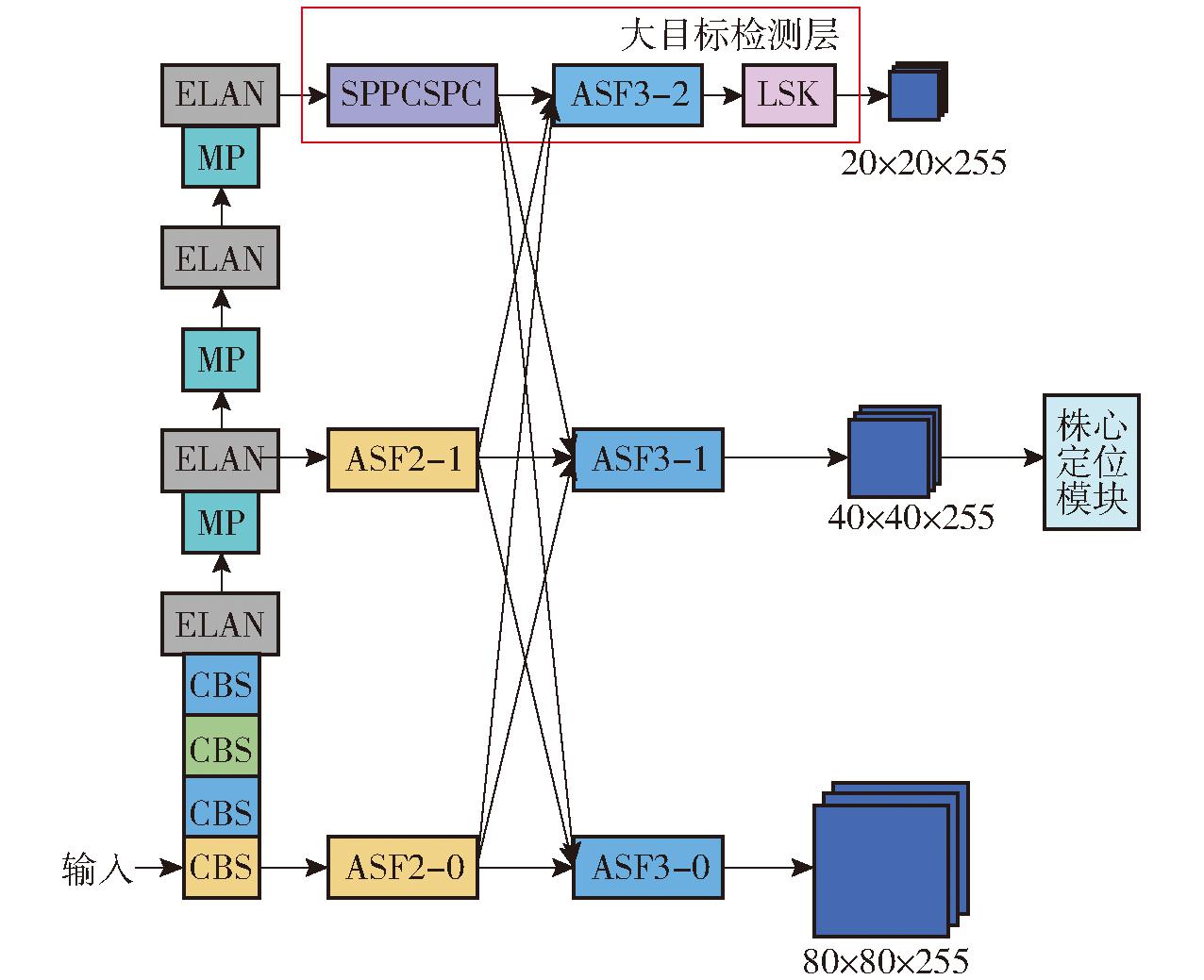

田间环境复杂,叶片交叉和相似杂草增加了玉米叶冠检测任务的难度。YOLO v7OBB网络在特征融合和信息传递时侧重于相邻层之间的信息交互,非相邻层之间信息融合程度低,导致一些跨层次的信息无法充分传递,影响其在玉米冠层检测上的表现。本研究基于YOLO v7OBB网络结构,提出自适性轻量化渐进特征金字塔网络LC-AFPN,提高特征融合能力,构建了LCA-YOLO v7OBB网络模型,实现复杂背景下玉米叶冠检测,图2为LCA-YOLO v7OBB模型结构。

图2 LCA-YOLO v7OBB网络结构

Fig.2 LCA-YOLO v7OBB model structure

首先,模型输入层将分辨率为640像素×640像素的玉米叶冠图像转换为R、G、B 3通道的像素矩阵。其次,主干特征提取模块Backbone提取图像特征,得到3个有效特征层。这些特征层随后被送入LC-AFPN,通过多尺度特征融合,增强模型对不同尺度特征的学习能力。3个融合后的特征层分别输入至头部网络,进行分类和回归任务,并通过得分筛选和非极大抑制步骤实现玉米叶冠检测。最后将玉米叶冠检测结果输入株心定位模块,进行区域凸显操作后根据图像的矩计算得到株心坐标。

2.2.1 自适性渐进特征金字塔网络构建

在目标检测中,多尺度特征可以适应不同尺寸的检测对象,常见的多尺度特征提取策略是采用自顶而下和自底向上的特征融合网络。渐进特征金字塔网络AFPN通过非相邻层直接交互的思想增强特征融合效果,以减少非相邻层之间的语义差距,避免原始YOLO v7OBB模型使用路径聚合网络易导致的玉米叶冠特征信息丢失或退化问题。

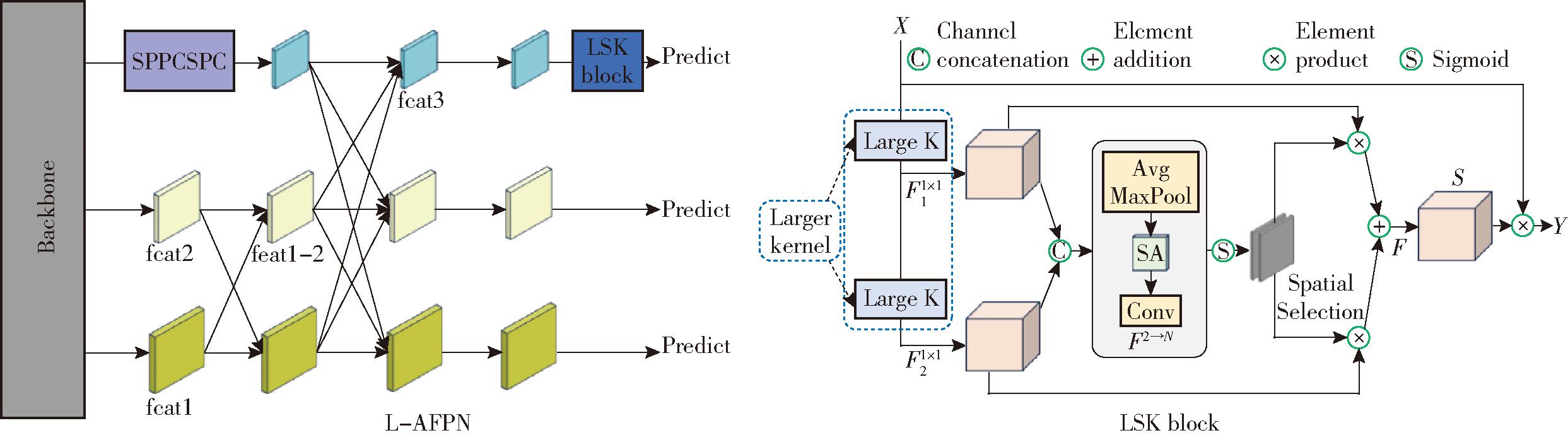

由于叶片交叉且存在大量杂草伴生现象,使用基于固定大小卷积核的AFPN难以动态地调整感受野,影响网络对玉米叶冠的精准识别。为解决上述问题,本研究引入一种选择性注意力机制LSK。通过将LSK分别嵌入到3个不同尺度的特征图分支中,设计AFPN-S、AFPN-M、AFPN-L和AFPN-ALL 4种策略。实验结果表明,AFPN-L性能最佳。因此最终在大尺寸目标检测分支输出前加入LSK,构建自适性渐进特征金字塔网络L-AFPN,实现对特征提取模块感受野的动态调整,图3为L-AFPN结构。

图3 L-AFPN结构

Fig.3 L-AFPN structure

选择性注意力机制由2个主要部分构成:大卷积核模块和空间核选择模块。大卷积核模块通过解耦策略,将大卷积核(卷积核大小为23,扩张率为1)重新组织为2个较小卷积核分支(卷积核大小为5,扩张率为1,卷积核大小为7,扩张率为7)。两分支通过串联操作替代大卷积核,在保持相同感受野的同时有效减少了模型参数量。空间核选择模块负责处理并融合来自不同感受野的特征图,对不同感受野的特征进行拼接操作,并使用平均池化和最大池化提取空间关系。空间特征经过Sigmoid激活函数生成注意力权重,将其与2个卷积核分支的输出特征进行加权融合,得到最终增强特征图,增强模型在不同环境下对玉米叶冠特征提取及处理不同目标背景信息差异性的能力。

2.2.2 轻量化上采样

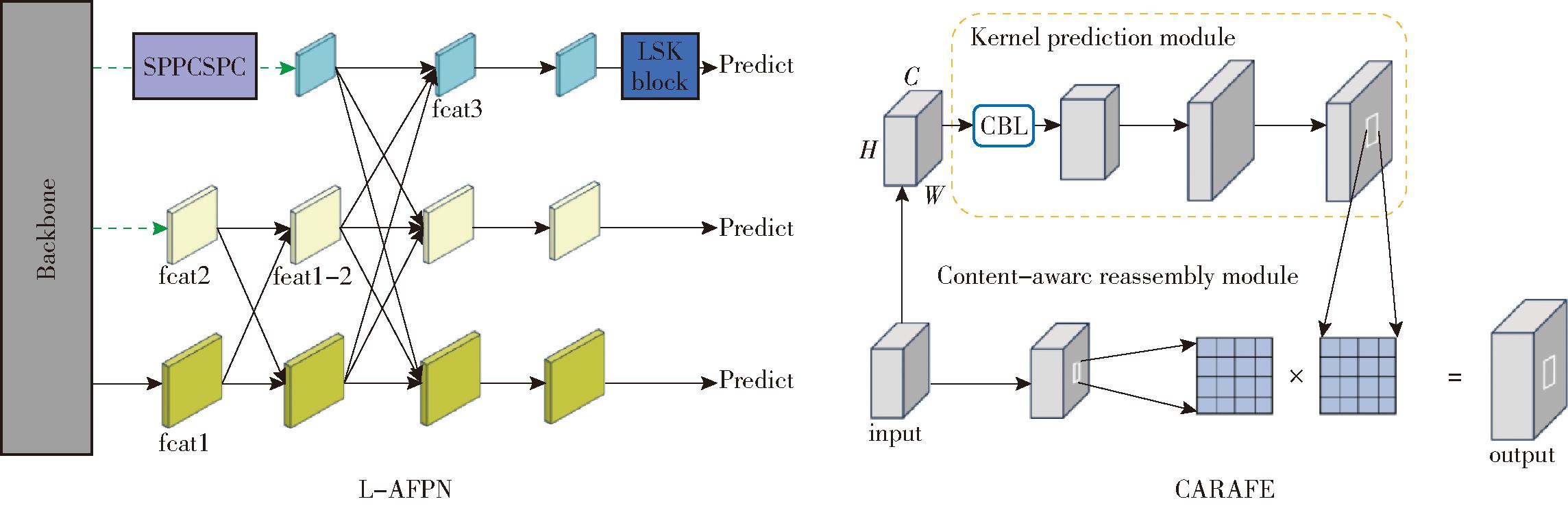

通过分析玉米叶冠数据可知,苗期玉米叶冠属于大尺寸目标检测范围。为克服非相邻层直接交互带来的计算负担,通过弱化小、中尺寸目标检测分支及使用轻量级的上采样算子CARAFE代替L-AFPN中的标准上采样2种策略,构成LC-AFPN。图4为LC-AFPN结构,绿色虚线为取消的卷积操作,橙色线为替换的CARAFE算子。

图4 LC-AFPN结构

Fig.4 LC-AFPN structure

LC-AFPN网络的核心在于多级特征融合,该网络从主干网络的中间层、中下层、底层获取feat1、feat2、feat3这3个特征层。其中,feat3在融合前经过空间金字塔池化模块SPPCSPC进行特征增强,以扩大模型感受野。LC-AFPN特征融合模块首先结合底层特征feat1与中间层特征feat2,随后融合顶层特征feat3。这种渐进式网络架构使得不同层特征图的语义信息在融合时更加接近,例如对feat3来说,将融合了feat1和feat2的特征图feat1-2与feat3相融,有效缩小了非相邻层feat3和feat1之间的语义差距,加强了特征融合效果。

与1×1卷积和双线性插值的特征上采样相比,引入的CARAFE模块能够根据输入特征预测每个像素在上采样过程中的权重,实现高效的特征重组并降低模型复杂度。在给定H×W×C形状的输入特征图情况下,CARAFE首先通过通道压缩和编码生成权重特征图,其中,H、W、C表示特征图的高度、宽度、通道数。权重特征图对与目标像素具有相似特征的像素赋予更高的插值权重,而降低与目标像素差异较大像素的权重。其次采用像素洗牌技术进行局部上采样,并将上采样后的特征图与权重特征图进行加权融合,为模型提供更精确的上采样结果,提升LC-AFPN网络特征提取能力。

2.2.3 迁移学习策略

通过实验发现由于YOLO v7原始权重是基于水平框标注数据得到,没有针对旋转边界框进行优化,在旋转目标上适用性较低。直接将YOLO v7原始权重作为预训练权重,模型召回率低且漏检率高。为解决上述问题,采用迁移学习的思想,将在一个任务上学习到的知识和特征迁移到另一个相关任务上,从而加快学习速度,提高模型性能和泛化能力。DOTA数据集是一个与玉米叶冠有相似旋转特征的船舶数据集实例,通过基于DOTA数据集的迁移学习策略可以帮助模型学习旋转角度特征,提升模型召回率。

本研究使用DOTA数据集作为辅助域,训练YOLO v7OBB模型,使模型学习旋转角度的通用特征。再将玉米叶冠数据集作为目标域,训练LCA-YOLO v7OBB模型,使模型具有玉米叶冠识别的能力。

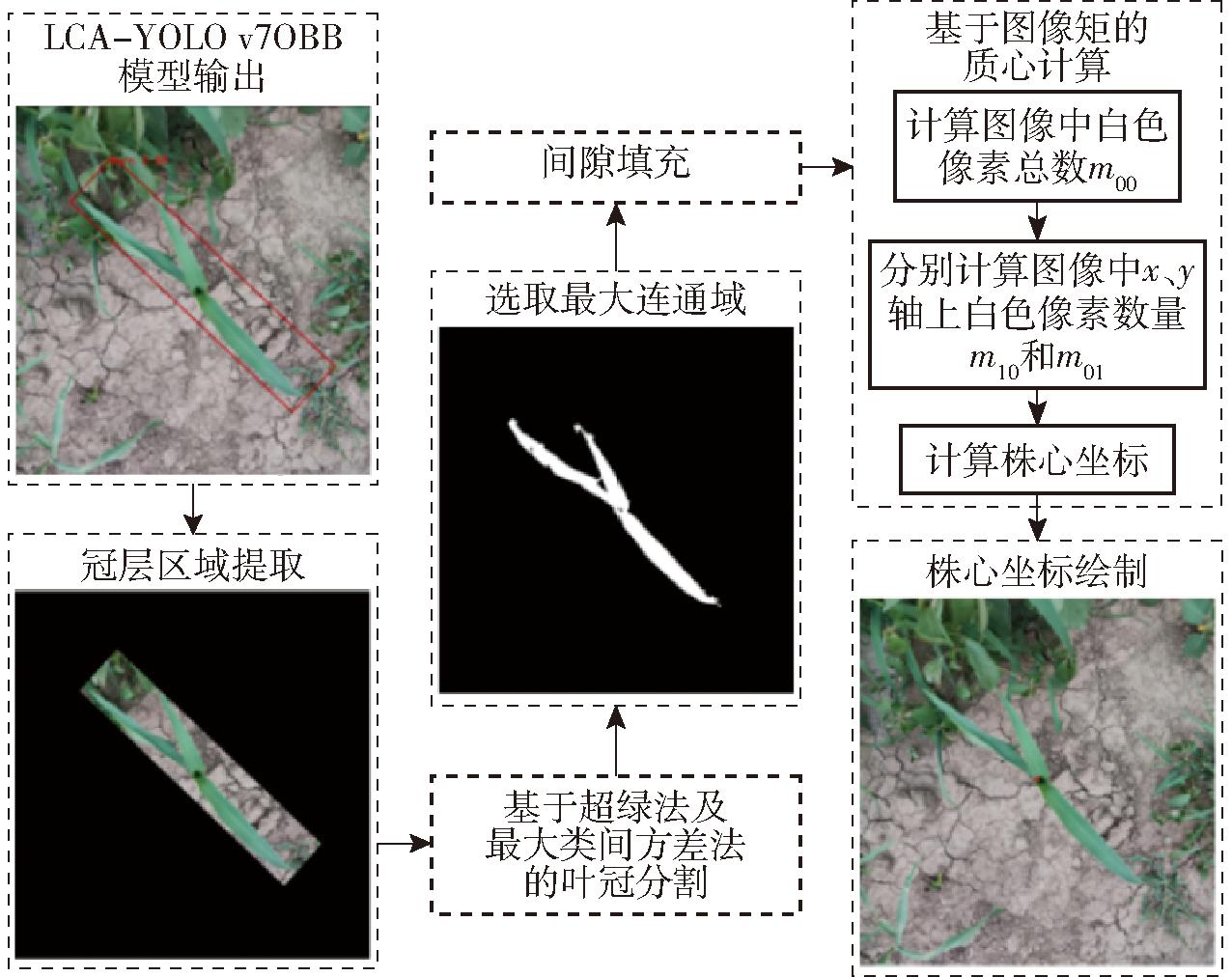

2.2.4 株心定位模块设计

株心定位算法由区域凸显和计算株心坐标2部分组成,图5为整体流程图。在区域凸显阶段,首先利用LCA-YOLO v7OBB模型对输入的玉米叶冠图像进行处理,实现对叶冠区域的准确识别。为了降低复杂背景对后续处理的影响,本研究通过与操作,将检测框之外的区域用黑色遮盖,实现对复杂背景的抑制。为进一步简化图像并突出叶冠区域,采用基于超绿法的图像灰度化技术,降低图像的维数,简化后续处理流程。利用最大类间方差法自动计算最佳阈值,实现对背景和叶冠区域的精确区分。由于光线和伴生杂草等因素的影响,分割后的叶冠图像存在一些无关连通域,因此选取面积最大的连通域作为实际的玉米叶冠区域,并对存在噪声干扰的连通域进行间隙填充,以提高分割的准确性。

图5 区域凸显与株心定位流程图

Fig.5 Regional salience and centrality localization

在计算株心坐标部分使用基于图像矩的方法,该方法通过计算图像区域的一阶矩来找到质心。对于二值图像,零阶距m00表示图像中白色像素的总数,一阶距m10和m01分别表示白色像素在x轴和y轴上的总和。质心坐标(Cx,Cy)计算式为

Cx=m10/m00

(1)

Cy=m01/m00

(2)

训练网络时设定学习率为0.01,权重衰减率为0.000 05,动量因子为0.935。网络训练轮次为300次,图像尺寸为640像素×640像素。本研究采用平均精度(Average precision,AP)、精确率(Precision,P)、召回率(Recall,R)、参数量(Params)、浮点计算量(Floating point operations,FLOPs)、F1值(F1-score)、模型大小(Model size,Size)、单幅图像平均推理时间(Inference time,IT)、置信度指标进行模型评价,此处模型大小为模型权重大小。

实验所用操作系统为Windows 10,软件环境配置为Python 3.8+Pytorch 1.9.0。硬件设备采用的CPU型号为Intel i7-7820X,主频3.60 GHz。GPU为2张Titan Xp显卡,显存12.0 GB,CUDA版本11.0,所有实验均在此环境下运行。为验证本研究提出的改进策略的效果,设计了消融实验、LSK应用不同位置对比实验、多模型对比实验;为评估高贴合旋转框在株心定位上的优势,设计了定位效果对比实验;为验证LCA-YOLO v7OBB模型泛化性,设计了黄瓜、茄子果实检测实验。

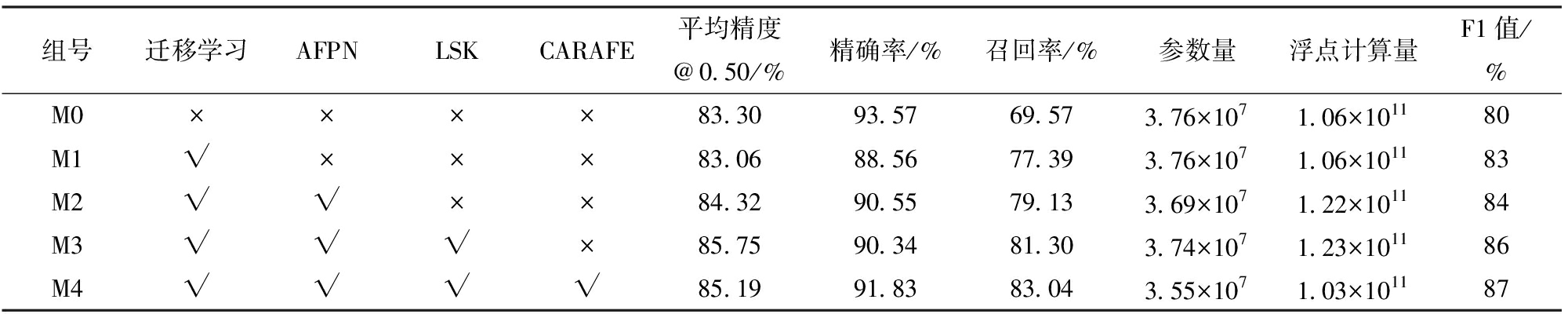

为验证本研究所提改进策略的有效性,选取4个模型进行对比分析。这些模型分别集成以下4个模块:迁移学习、AFPN、LSK、CARAFE。在测试集上消融实验结果如表1所示,表中“√”表示模型采用该模块,“×”表示模型不采用该模块,M0~M4为对应组号。

表1 消融实验性能指标

Tab.1 Ablation study performance metrics

组号迁移学习AFPNLSKCARAFE平均精度@0.50/%精确率/%召回率/%参数量浮点计算量F1值/%M0××××83.3093.5769.573.76×1071.06×101180M1√×××83.0688.5677.393.76×1071.06×101183M2√√××84.3290.5579.133.69×1071.22×101184M3√√√×85.7590.3481.303.74×1071.23×101186M4√√√√85.1991.8383.043.55×1071.03×101187

由表1可以看出,与M0组相比,M1组召回率提升7.82个百分点,F1值提升3个百分点。这说明相较于使用原始权重,使用迁移学习策略能有效提升模型召回率,降低漏检风险。与M1组相比,M2组召回率提升1.74个百分点,F1值提升1个百分点。表明引入的渐进特征金字塔能加强非相邻层之间的信息交互,改善玉米叶冠数据不同层特征的融合效果,提高模型整体性能。与M2组相比,M3组平均精度提升1.43个百分点,召回率提升2.17个百分点。这说明引入的选择性注意力机制可以自适应调整卷积核权重,增强特征提取能力,提升模型在不同环境下的表现。与M3组相比,使用轻量化上采样算子的M4组浮点计算量降低15.98%,参数量降低5.08%,同时精确率、召回率和F1值分别提升1.49、1.74、1个百分点。对比M0组与M4组可以看出使用改进策略后,模型平均精度提升1.89个百分点,召回率提升13.47个百分点,参数量下降5.74%,浮点计算量下降3.09%,F1值提升7个百分点。

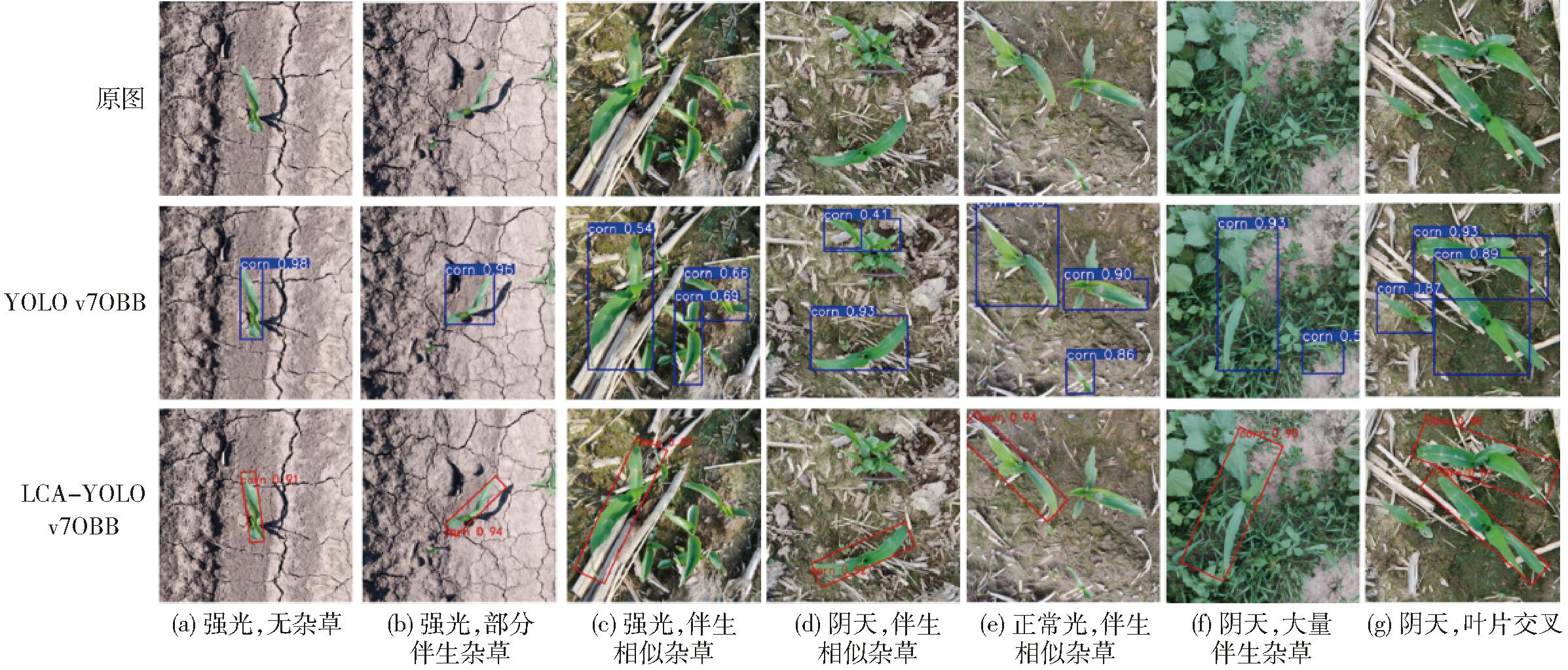

图6是不同环境下YOLO v7OBB模型和LCA-YOLO v7OBB模型检测效果,图中红色数字为置信度。

图6 不同环境下玉米叶冠检测结果

Fig.6 Results under different environments

由图6可知,在强光无杂草和强光部分伴生杂草情况下,YOLO v7OBB和LCA-YOLO v7OBB模型均可准确识别。但在强光伴生相似杂草和阴天伴生相似杂草情况下,YOLO v7OBB的检测框贴合度低,如图6c、6d中YOLO v7OBB输出的检测框不贴合,而LCA-YOLO v7OBB模型检测框则包含整个玉米叶冠。在正常光伴生相似杂草情况下,YOLO v7OBB模型不能准确分辨玉米叶冠和相似伴生杂草,如图6e中YOLO v7OBB将一株形态相似杂草错误判断为玉米叶冠,而LCA-YOLOv7OBB可以准确分辨玉米和相似杂草。在阴天大量伴生杂草和阴天叶片交叉情况下,YOLO v7OBB也存在边界框不够准确的问题。此外,相较YOLO v7OBB模型,LCA-YOLO v7OBB模型在不同环境下玉米叶冠检测结果置信度明显提升,如图6f中置信度由YOLO v7OBB的0.56提升至LCA-YOLO v7OBB的0.90。

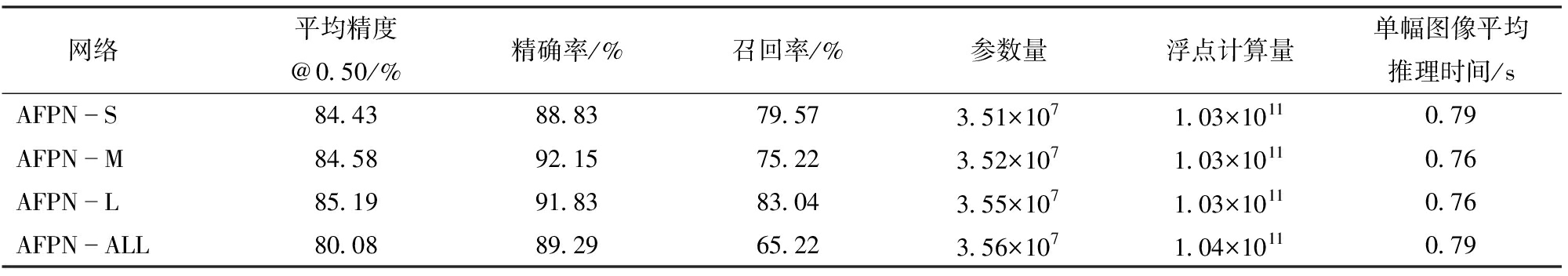

为分析LSK模块在AFPN网络中不同位置对性能的影响,进行AFPN-S、AFPN-M、AFPN-L和AFPN-ALL 4种策略的对比实验,表2为在测试集上4种策略性能指标。

表2 LSK应用不同位置性能指标

Tab.2 Performance metrics for LSK applied at different positions

网络平均精度@0.50/%精确率/%召回率/%参数量浮点计算量单幅图像平均推理时间/sAFPNS84.4388.8379.573.51×1071.03×10110.79AFPNM84.5892.1575.223.52×1071.03×10110.76AFPNL85.1991.8383.043.55×1071.03×10110.76AFPNALL80.0889.2965.223.56×1071.04×10110.79

当LSK模块被添加到小尺寸、中尺寸目标检测层时,相比于添加到大尺寸目标检测层,模型检测性能出现下降,平均精度分别降低0.76个百分点和0.61个百分点,召回率分别下降3.47个百分点和7.82个百分点,这表明将LSK模块应用于大尺度目标检测层能有效提升模型检测性能。当LSK模块同时被添加到小、中、大3个检测层时,模型平均精度、精确率、召回率相较于其他3种策略都有所下降。这是因为引入过多的注意力模块增加了模型的复杂度,导致模型在训练数据时捕获了更多的统计噪声,出现了过拟合现象。而将LSK模块添加在大尺寸目标检测分支,能够更有效地调整特征提取的主干感受野范围,避免过大感受野导致的局部信息提取不足,解决大尺寸检测层主要提取网络深层特征,缺乏局部细节感知能力的问题。LSK模块的加入促使模型能够更好地处理不同范围内的上下文信息。

为验证LCA-YOLO v7OBB网络在玉米叶冠检测中的性能,将本模型与12种在旋转检测任务上表现优秀的网络进行对比分析。在相同条件下,使用Rotated-FasterRCNN、Oriented R-CNN、S2A-Net、Redet、R3det、Roi-Trans、Rotated-Reppoints、Rotated-Retinanet、Sasm-Reppoints、Kld、GWD、YOLOx-OBB这12个旋转目标检测算法对同一叶冠数据集进行训练,并在验证集上进行分析,表3为本文模型与上述12种网络模型性能指标对比。鉴于不同模型具有不同的性能指标,本研究采用平均精度、召回率和模型大小3项通用指标来验证本研究提出模型的有效性。

表3 13种旋转目标检测网络模型性能

Tab.3 Performance metrics of 13 rotated object detection networks

网络模型主干网络平均精度@0.50/%召回率/%模型大小/MBRotatedFasterRCNNResNet50FPN58.2465.70314Oriented RCNNResNet50FPN67.7977.10314S2ANetResNet50FPN61.4169.50295RedetResNet50REFPN64.2070.50245R3detResNet50FPN77.1980.00318RoiTransResNet50FPN69.1478.10421RotatedReppointsResNet50FPN55.7984.80280RotatedRetinanetResNet50FPN63.2572.41276SasmReppointsResNet50FPN74.9086.70280KldResNet50FPN67.7176.21318GWDResNet50FPN63.9576.20276YOLOxOBBCSPDarknet5385.3781.11194LCAYOLO v7OBBCSPDarknet5387.1081.04136

分析所有模型召回率表现可知,Rotated-FasterRCNN、Oriented R-CNN、S2A-Net、Redet、Roi-Trans、Rotated-Retinanet、Kld、GWD 8个模型召回率低于80%。这表明模型在识别过程中未有效捕捉到玉米叶冠数据的关键特征信息,导致对玉米叶冠和背景的区分能力较弱,漏检率高。在模型大小方面,与标准ResNet-50网络相比,本研究使用的CSPDarknet53主干网络通过将梯度变化集成到特征图中的方式实现了模型的轻量化,将其作为主干网络能够在增强卷积神经网络学习能力的同时有效减小模型大小。从表3可以看出,LCA-YOLO v7OBB网络检测平均精度最高,为87.10%,同时模型大小最小,为136 MB。实验结果表明,对于长宽比例大、叶片交叉重叠的玉米叶冠,LCA-YOLO v7OBB网络综合性能最佳,能够满足玉米株心检测的精度要求,且算法召回率高,能有效降低模型漏检率。

为评估高贴合旋转框在株心定位上的优势,对1 800幅玉米叶冠图像进行水平框标注,并送入YOLO v7网络进行训练,图7为YOLO v7和LCA-YOLO v7OBB的检测效果。在图7a、7b检测框无杂草干扰情况下,YOLO v7和LCA-YOLO v7OBB均可实现准确识别。然而,在更为复杂的环境下,YOLO v7网络性能明显下降。在图7c~7f伴生相似杂草情况下,YOLO v7无法准确区分玉米叶冠和伴生杂草,将相似杂草错误地识别为玉米叶冠。在图7g阴天、叶片交叉情况下,检测框交叉重叠准确率低,仅包含部分玉米叶冠区域。结果表明YOLO v7网络辨别相似杂草能力弱,而LCA-YOLO v7OBB网络则可以准确分辨玉米叶冠和相似杂草。

图7 YOLO v7和LCA-YOLO v7OBB检测效果对比

Fig.7 Comparison of effects between YOLO v7 and LCA-YOLO v7OBB

图8为经过株心定位模块得到的定位效果,其中红色圆点是计算的株心位置。在图8a、8c检测框无杂草干扰情况下,YOLO v7和LCA-YOLO v7OBB均可实现精准定位。然而,在杂草伴生情况下,水平边界框定位效果差。在图8b、8e中,YOLO v7输出的检测框与叶冠贴合度低,检测框内有杂草干扰,无法精确获得株心区域,定位严重偏离。而LCA-YOLO v7OBB输出的高贴合检测框抗干扰能力强,定位精准。在图8d、8f中,YOLO v7模型无法准确分辨玉米和相似杂草,导致对杂草株心的错误定位,而LCA-YOLO v7OBB能准确识别并计算玉米株心坐标。分析可知,对于呈现细长特征且叶片交叉重叠的玉米叶冠,采用旋转目标检测能够获得更精准的叶冠分割图像,减少重叠和无关信息干扰,实现对玉米株心的准确定位。而水平目标检测容易受背景叶片交叉重叠干扰严重,不利于进一步玉米株心定位。

图8 定位效果对比

Fig.8 Localization effect comparison

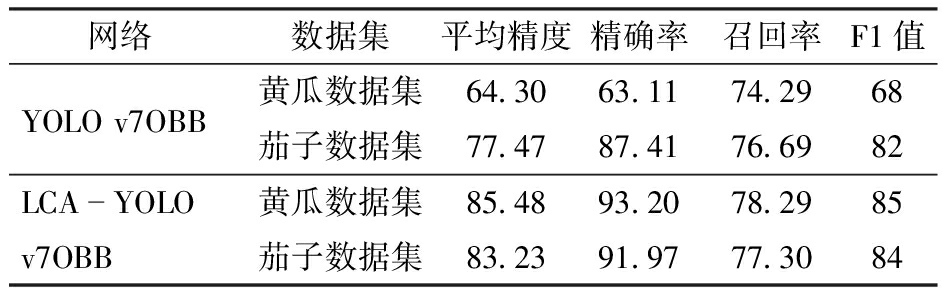

通过分析发现黄瓜和茄子具有长宽比例大和目标角度多变的特点,与旋转目标检测算法应用场景契合,能够很好地检验模型在具有此类形状特征的目标检测任务上的泛化能力。因此分别收集500幅黄瓜图像和500幅茄子图像,构建黄瓜和茄子数据集。将数据集按照比例8∶1∶1划分为训练集、验证集、测试集,以进行模型训练和测试。在测试集上使用平均精度、精确率、召回率、F1值4个评价指标来分析模型泛化性,表4为YOLO v7OBB和LCA-YOLO v7OBB模型在黄瓜和茄子检测任务上的性能。

表4 黄瓜和茄子检测性能

Tab.4 Performance metrics for cucumber and eggplant detection %

网络数据集平均精度精确率召回率F1值YOLO v7OBB黄瓜数据集64.3063.1174.2968茄子数据集77.4787.4176.6982LCAYOLO 黄瓜数据集85.4893.2078.2985v7OBB茄子数据集83.2391.9777.3084

由表4可知,LCA-YOLO v7OBB模型在黄瓜数据集上的平均精度、精确率、召回率、F1值相较于原模型分别提高21.18、30.09、4、17个百分点,在茄子数据集上的平均精度、精确率、召回率、F1值相较于原模型分别提高5.76、4.56、0.61、2个百分点,图9为模型应用在两种检测任务上的效果。从图中可以看出在背景复杂及少量训练数据情况下,LAC-YOLO v7OBB模型能较好识别黄瓜与茄子。在图9a背景颜色相似和图9b果实部分遮挡情况下,模型能准确捕捉黄瓜边缘及整体特征,有效定位小目标。对于形态多样、密集分布的茄子,模型在图9c多角度拍摄及图9d果实距离较远情况下,实现了有效识别。结果表明LCA-YOLO v7OBB模型泛化性强,无论是在黄瓜检测还是茄子检测任务中都有良好表现。

图9 不同任务上的检测效果

Fig.9 Detection effects on different tasks

(1)以YOLO v7OBB为基础,构建了LCA-YOLO v7OBB玉米株心检测模型,该模型通过集成自适性轻量化渐进特征金字塔网络,大幅提高了漏检率,有效抑制了背景干扰。在测试集上,LCA-YOLO v7OBB平均精度、召回率可达85.19%、83.04%,较改进前分别提升1.89、13.47个百分点,模型参数量减少5.74%,浮点计算量减少3.09%,F1值提升7个百分点,实现了性能提升和模型轻量化。通过与12种旋转目标检测算法对比,本研究提出的LCA-YOLO v7OBB综合模型性能最佳,在验证集上平均精度为87.10%,召回率为81.04%。

(2)使用高贴合旋转框实现株心定位,解决了水平边界框定位严重偏离的问题。相较于YOLO v7输出的水平边界框,LCA-YOLO v7OBB输出的检测框贴合度高,抗干扰能力强。在不同程度杂草伴生情况下,都能有效区分玉米叶冠和相似伴生杂草,实现对玉米株心的准确定位。实验结果充分证明了LCA-YOLO v7OBB算法在玉米株心定位任务中的适用性和优越性。

(3)通过网络爬取和筛选公开数据集,构建了黄瓜、茄子2个不同类型的数据集。在黄瓜检测任务上,LCA-YOLO v7OBB平均精度、精确率可达85.48%、93.20%,较改进前分别提升21.18、30.09个百分点,召回率提升4个百分点,F1值提升17个百分点。在茄子检测任务上,LCA-YOLO v7OBB平均精度、精确率可达83.23%、91.97%,较改进前分别提升5.76、4.56个百分点,召回率提升0.61个百分点,F1值提升2个百分点。实验结果证明模型泛化能力强,在处理复杂场景和多样化目标时具有较高的稳定性和准确性。提出的高贴合旋转目标检测网络LCA-YOLO v7OBB以及能有效减少边缘精度缺失的标注策略,能够满足田间作业中玉米株心定位的精度及性能要求。

[1] 韩长杰,刘钊,毛罕平,等.棉田变量施肥整地联合作业机设计与试验[J].农业机械学报,2024,55(11):250-261,284.

HAN Changjie, LIU Zhao, MAO Hanping, et al. Design and experiment of variable rate fertilization combined soil preparation machine[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(11):250-261,284. (in Chinese)

[2] 李文伟,江世界,徐平凡,等.丘陵果园自走式小型靶标跟随喷雾机设计与试验[J].农业机械学报,2023,54(9):188-197.

LI Wenwei, JIANG Shijie, XU Pingfan, et al. Design and experiment of self-propelled small target following sprayer for hilly orchard[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(9):188-197. (in Chinese)

[3] 窦汉杰,陈震宇,翟长远,等.果园智能化作业装备自主导航技术研究进展[J].农业机械学报,2024,55(4):1-22.

DOU Hanjie, CHEN Zhenyu, ZHAI Changyuan, et al. Research progress on autonomous navigation technology for orchard intelligent equipment[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(4):1-22. (in Chinese)

[4] ZHOU W, AN T, WANG J, et al. Design and experiment of a targeted variable fertilization control system for deep application of liquid fertilizer[J]. Agronomy, 2023, 13(7): 1687.

[5] DIAO Z, GUO P, ZHAO C, et al. Navigation line extraction algorithm for corn spraying robot based on Light-YOLOv8s network[J]. Computers and Electronics in Agriculture, 2023, 212: 108049.

[6] DE SILVA R, CIELNIAK G, WANG G, et al. Deep learning-based crop row detection for infield navigation of agri-robots[J]. Journal of Field Robotics, 2023,41(7):2299-2321.

[7] GONG J, WANG X, ZHANG Y, et al. Navigation line extraction based on root and stalk composite locating points[J]. Computers and Electrical Engineering, 2021, 92: 107115.

[8] 张伟荣,陈学庚,齐江涛,等.基于深度学习和高斯过程回归的玉米冠下视觉导航路径提取方法[J].农业机械学报,2024,55(7):15-26.

ZHANG Weirong, CHEN Xuegeng, QI Jiangtao, et al. Deep learning and Gaussian process regression based path extraction for visual navigation under canopy[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(7):15-26. (in Chinese)

[9] 宫金良,孙科,张彦斐,等.基于梯度下降和角点检测的玉米根茎定位导航线提取方法[J].农业工程学报,2022,38(13):177-183.

GONG Jinliang, SUN Ke, ZHANG Yanfei, et al. Extracting navigation line for rhizome location using gradient descent and corner detection[J]. Transactions of the CSAE, 2022, 38(13): 177-183. (in Chinese)

[10] 肖珂,夏伟光,梁聪哲.复杂背景下果园视觉导航路径提取算法[J].农业机械学报,2023,54(6):197-204,252.

XIAO Ke, XIA Weiguang, LIANG Congzhe.Visual navigation path extraction algorithm in orchard under complex background[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(6):197-204,252. (in Chinese)

[11] WANG S, SU D, JIANG Y, et al. Fusing vegetation index and ridge segmentation for robust vision based autonomous navigation of agricultural robots in vegetable farms[J]. Computers and Electronics in Agriculture, 2023, 213: 108235.

[12] JIN J, TANG L. Corn plant sensing using real-time stereo vision[J]. Journal of Field Robotics, 2009, 26(6-7): 591-608.

[13] 魏帅均,张彦娥, 梅树立.基于俯视图像的玉米株心快速识别方法研究[J].农业机械学报,2017,48(增刊):136-141.

WEI Shuaijun, ZHANG Yan’e, MEI Shuli. Fast recognition method of maize core based on top view image[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(Supp.): 136-141. (in Chinese)

[14] 马志艳,朱熠,张徐康,等.基于视觉的玉米苗期作物识别与定位方法研究[J].中国农机化学报,2020,41(9):131-137.

MA Zhiyan, ZHU Yi, ZHANG Xukang, et al. Research on the method of crop recognition and location in maize seedlings stage based on vision[J]. Journal of Chinese Agricultural Mechanization, 2020, 41(9): 131-137. (in Chinese)

[15] 孟庆宽,张漫,杨晓霞,等.基于轻量卷积结合特征信息融合的玉米幼苗与杂草识别[J].农业机械学报,2020,51(12):238-245,303.

MENG Qingkuan, ZHANG Man, YANG Xiaoxia, et al. Recognition of maize seedling and weed based on light weight convolution and feature fusion[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(12): 238-245, 303. (in Chinese)

[16] 宗泽,赵硕,刘刚.苗期玉米冠层识别与质心定位方法研究[J].农业机械学报,2019,50(增刊):27-33.

ZONG Ze, ZHAO Shuo, LIU Gang. Coronal identification and centroid location of maize seedling stage[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(Supp.): 27-33. (in Chinese)

[17] 张伟荣,温浩军,谯超凡,等.基于Mask R-CNN的玉米苗与株芯检测方法[J].新疆农业科学,2021,58(10):1918-1928.

ZHANG Weirong, WEN Haojun, QIAO Chaofan, et al. Maize seedling and core detection method based on Mask R-CNN[J]. Xinjiang Agricultural Sciences, 2021, 58(10): 1918-1928. (in Chinese)

[18] CAI E, BAIREDDY S, YANG C, et al. Deep transfer learning for plant center localization[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops,2020: 62-63.

[19] 孙红,乔金博,李松,等.基于深度学习的玉米拔节期冠层识别[J].农业工程学报,2021,37(21):53-61.

SUN Hong, QIAO Jinbo, LI Song, et al. Recognition of the maize canopy at the jointing stage based on deep learning[J]. Transactions of the CSAE, 2021, 37(21): 53-61. (in Chinese)

[20] LIAO M, ZHU Z, SHI B, et al. Rotation-sensitive regression for oriented scene text detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 5909-5918.

[21] MA J, SHAO W, YE H, et al. Arbitrary-oriented scene text detection via rotation proposals[J]. IEEE Transactions on Multimedia, 2018, 20(11): 3111-3122.

[22] 张尹人,邓春华.基于旋转目标检测的指针仪表读数识别方法[J].计算机工程与设计,2023,44(6):1804-1811.

ZHANG Yiren, DENG Chunhua. Reading recognition method of pointer instrument based on rotating target detection [J]. Computer Engineering and Design, 2023,44(6):1804-1811. (in Chinese)

[23] HAN J, DING J, XUE N, et al. Redet: a rotation-equivariant detector for aerial object detection[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 2786-2795.

[24] WEN L, CHENG Y, FANG Y, et al. A comprehensive survey of oriented object detection in remote sensing images[J]. Expert Systems with Applications, 2023, 224: 119960.

[25] 王旭,吴艳霞,张雪,等.计算机视觉下的旋转目标检测研究综述[J].计算机科学,2023,50(8):79-92.

WANG Xu, WU Yanxia, ZHANG Xue, et al. Survey of rotating object detection research in computer vision[J]. Computer Science, 2023, 50(8): 79-92. (in Chinese)

[26] 王新良,纪昂志,李自强.基于旋转框定位的绝缘子污秽检测算法[J].计算机工程与应用,2023,59(21):319-326.

WANG Xinliang, JI Angzhi, LI Ziqiang. Insulator contamination detection algorithm based on rotating frame location[J]. Computer Engineering and Applications, 2023,59(21): 319-326. (in Chinese)

[27] 尤泳,李芳旭,纪中良,等.基于旋转目标检测的青贮机精准抛送系统设计与试验[J].农业工程学报,2024,40(21):36-45.

YOU Yong, LI Fangxu, JI Zhongliang, et al. Design and experiment of the precise throwing system for silage machines based on rotating target detection[J]. Transactions of the CSAE, 2024, 40(21): 36-45. (in Chinese)

[28] 耿艳利,林彦伯,付艳芳,等.基于双扩张层和旋转框定位的群猪目标检测算法研究[J].农业机械学报,2023,54(4):323-330.

GENG Yanli, LIN Yanbo, FU Yanfang, et al.Object detection algorithm for pigs based on dual dilated layer and rotary box location[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(4):323-330. (in Chinese)

[29] ZHANG W, XIA X, ZHOU G, et al. Research on the identification and detection of field pests in the complex background based on the rotation detection algorithm[J]. Frontiers in Plant Science, 2022, 13: 1011499.

[30] 宋怀波,焦义涛,华志新,等.基于YOLO v5-OBB与CT的浸种玉米胚乳裂纹检测[J].农业机械学报,2023,54(3):394-401,439.

SONG Huaibo, JIAO Yitao, HUA Zhixin, et al. Endosperm crack detection method for seed dipping maize based on YOLO v5-OBB and CT technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(3): 394-401,439. (in Chinese)