在深海养殖系统中,饲料支出占总成本的50%以上[1],过度投喂不仅会造成饲料浪费,还会引发水体污染[2]。而鱼类的摄食强度评估可用于指导智能投喂、优化饲养策略,有助于提高生产效益和减少饲养成本[3-4]。因此,分析鱼类摄食强度完善投喂策略对于提高大规模深海养殖的效益至关重要。目前,传统的鱼类食欲分析方法主要依赖养殖工人的经验,导致准确性和实时性难以保证,无法满足大规模深海养殖的需求。鱼类摄食强度通常与进食时产生的水花大小密切相关。通过计算机视觉技术对水花进行语义分割和计算,可以推断鱼类的摄食强度,从而实现精量投喂,突破个人养殖经验的限制。分析鱼类摄食行为方法有助于及时调整投喂策略,提高水产养殖效率[5-6]。

关于鱼类摄食强度的研究已涉及高频声纳、声学标签[7-8]及计算机视觉技术等多个领域。其中,计算机视觉技术为一种非入侵式且稳定性较好的观察技术,已被广泛应用于摄食强度的分析[9-11]。例如,张铮等[12]提出了一种轻量级的2D卷积运动特征提取网络模型,能够有效识别鱼类摄食行为,其识别准确率提高至93.97%。此外,赵建[13]结合流光法和统计学方法,提出一种改进动能模型的摄食活动强度评估方法,但该方法容易受外界环境干扰。以上方案难以在复杂的深海环境中应用。

金鲳鱼是我国南海深海网箱养殖的主要对象,因此,本文将围绕金鲳鱼的摄食行为展开研究。在投喂作业过程中,金鲳鱼摄食活动激烈,当投入一定量饲料后,金鲳鱼摄食时通常会冲出水面,造成水面波动形成水花。鱼类的食欲与形成的水花面积相关,识别水花面积可作为自投投料机投料启动信号,且依据每次投入饲料后水花面积分析鱼类食欲,决定下一次投喂量,是避免饲料浪费的有效措施,当水花面积大幅度长期下降时,说明长期食欲低下,则可能存在健康隐患,系统也将基于此向饲养人员发出健康预警。然而,由于使用的算法复杂,飞溅特性可能会造成过多的计算负担,无法在边缘设备上有效部署[14]。因此,许多研究者开始关注轻量化网络设计,以减轻计算负担[15]。轻量化网络通过调整网络内部结构,设计较少的模型参数和更快速的卷积网络,如MobileNet[16]、shuffleNet[17]、GhostNet[18]等。此外,以YOLO系列为主,HU等[19]对YOLO v4架构进行改进。在骨干网络特征提取模块中实现密集连接和去冗余操作,同时改进颈部连接方法。这一改进将模型平均精度提高27.12%,同时减少计算量约30%,从而有效检测水下饲料残留颗粒以分析鱼类食欲。

此外,目前在水花分析鱼类食欲的研究中,为了检测水花大小,需要在每个养殖池或网箱中安装固定摄像头,检测特定区域的水花[20],这在拥有上百个网箱的大型深海养殖场中会显著增加成本。双目相机作为一种解决方案,可在不同位置通过左右摄像头的视差识别出目标的位置及大小。双目相机在各个领域均有较好的应用效果[21-23]。

因此,针对深远海大型高密度聚乙烯(High density polyethylene,HDPE)金鲳鱼网箱养殖中的鱼类摄食强度分析问题,本文提出一种基于双目视觉的水花面积估算方法,并引入轻量化网络模型YOLO v8n-seg-SBS-DI。该改进模型用于对投饵后鱼类进食区域水花进行语义分割,同时结合双目相机获取的深度信息计算水花面积,为鱼类摄食强度分析提供基础数据。此外,使用PVC(Polyvinyl chloride)板模拟水花目标,进行测量性能评估试验,并分析探测位置等因素对系统测量性能的影响。

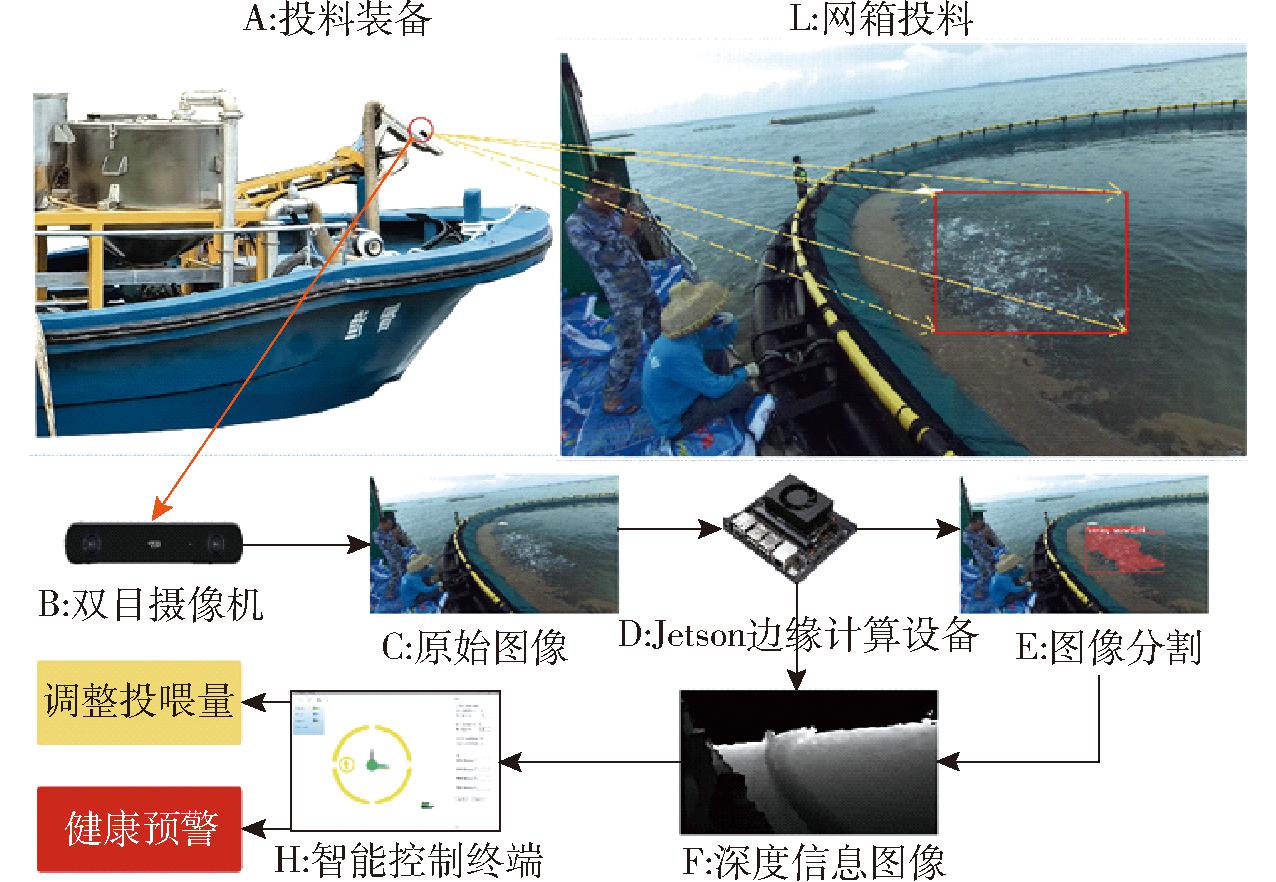

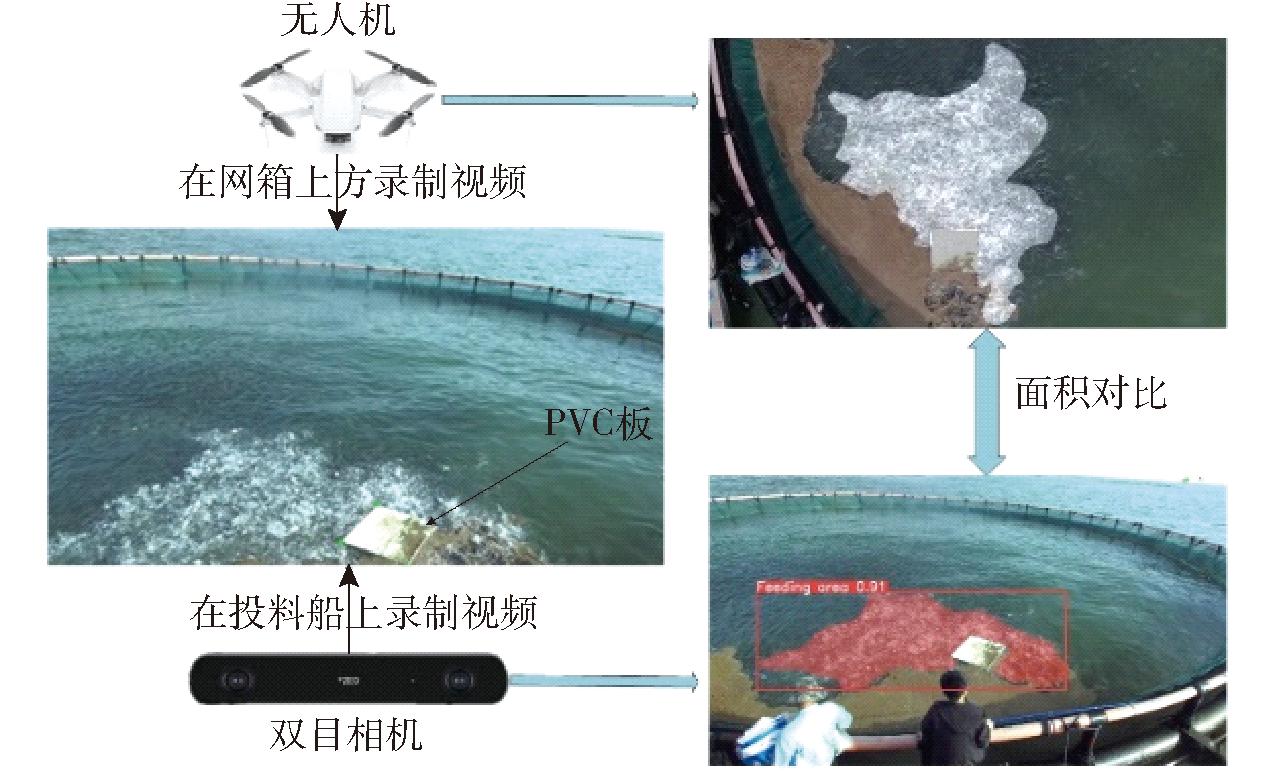

试验系统如图1所示,主要由双目相机、投料装备及搭载算法的边缘计算设备(NVIDIA Jetson Orin Nano开发板)组成。投料设备安装在无人船上,边缘计算设备置于电箱内。所使用的ZED-2i型双目视觉传感器安装在投料机械臂上方,该相机利用双目测距原理,提供相应的SDK和API,通过计算2幅具有视差的图像,实时获取像素深度数据。该相机能在0.7~20 m范围内感知环境,并具有110°的视野,偏光版本的设计使其在户外环境中表现优异。

图1 鱼类健康监测系统整体架构图

Fig.1 Overall framework of fish health monitoring

当投料船靠近网箱边缘进行投料时,双目相机捕获原始图像,随后通过边缘设备计算深度信息。Jetson边缘设备使用轻量级YOLO算法对水花区域进行分割,并根据分割区域的深度信息计算水花实际面积。PC智能管理系统则分析每次投喂后水花面积的变化,以评估鱼类的食欲并调整下一次饲料投喂量。此外,若网箱内鱼类食欲长期偏低,系统会将该结果反馈给养殖管理员,以警示可能存在的健康问题。

1.2.1 水花图像采集

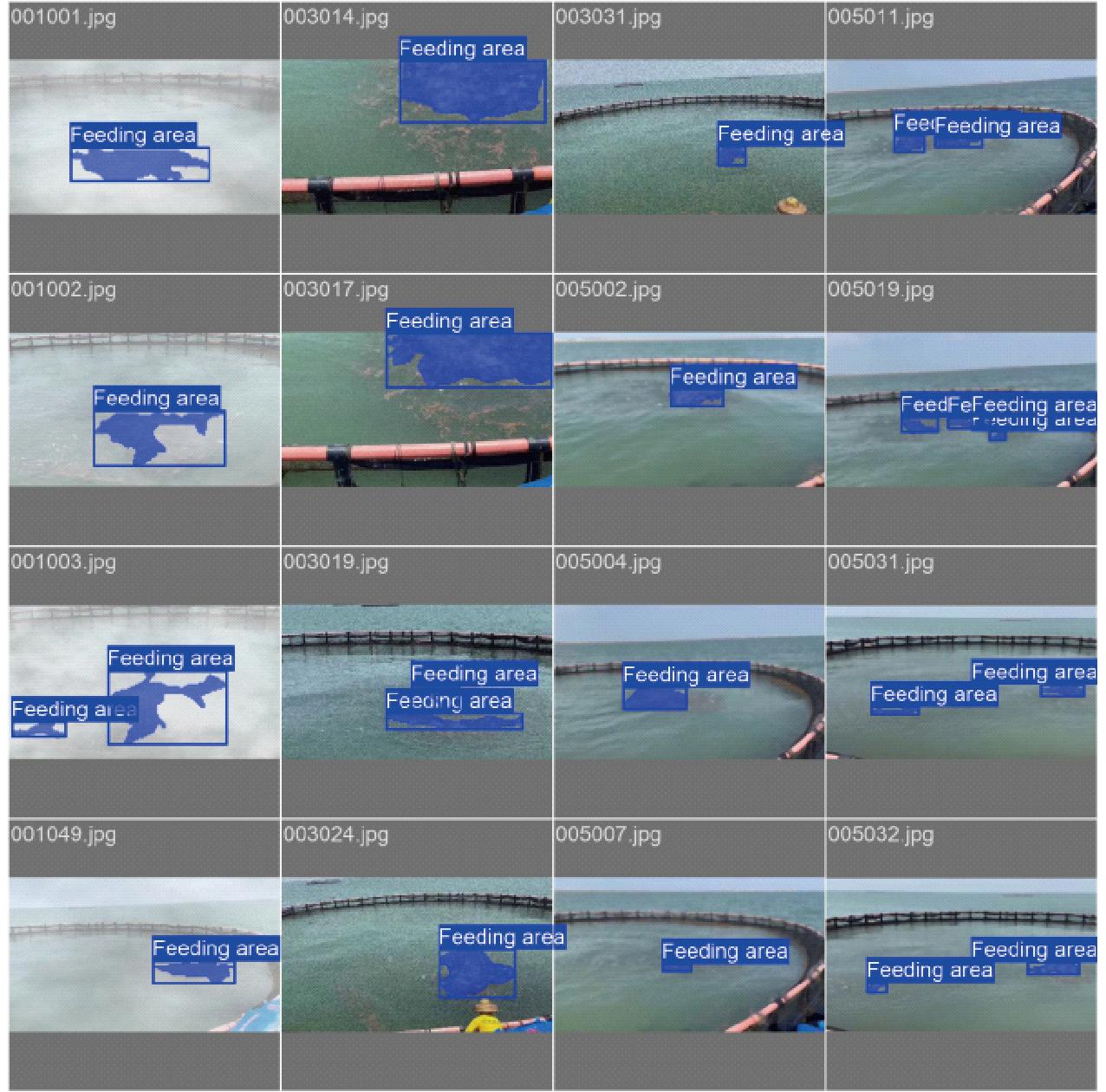

水花数据集于广东省湛江市渔宝有限公司水产养殖海上基地拍摄获得,研究对象为金鲳鱼在进食期间因跳跃和争食而溅起的水花区域。考虑到工作环境复杂性,图像采集采用索尼手持相机进行视频录制、拍摄。为应对投料时的不同情况,数据采集涵盖不同距离、光线强度和视角的多样化样本。每幅图像分辨率为1 024像素×768像素,共收集1 750幅图像,部分样本图像如图2所示。

图2 采集图像数据集示例

Fig.2 Example of captured image datasets

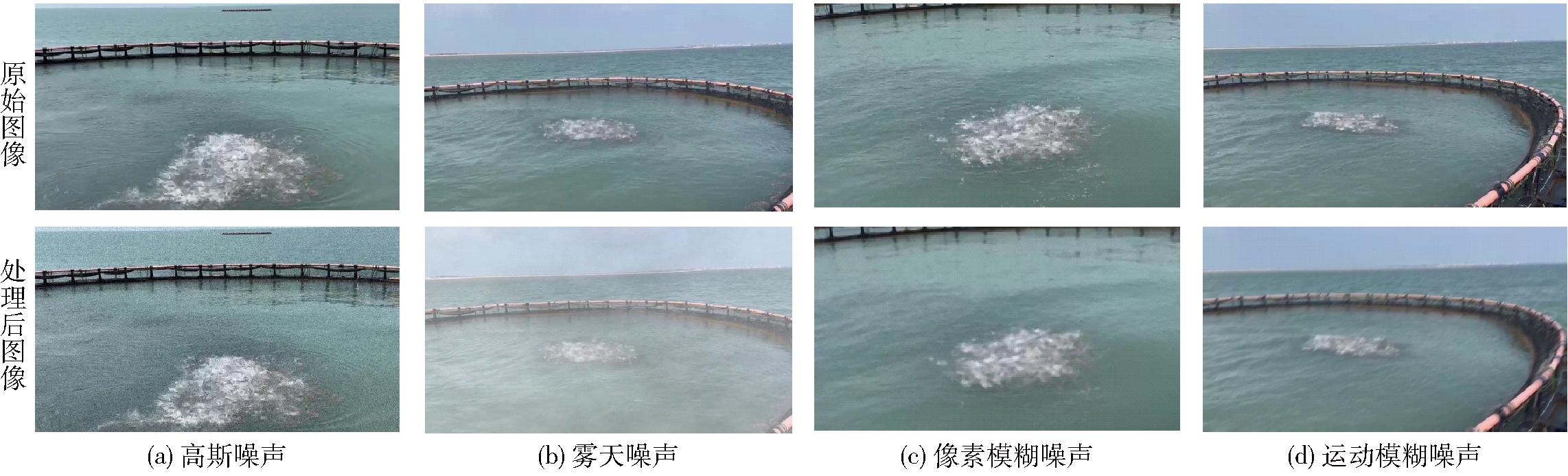

1.2.2 数据增强

相较于简单旋转、剪切等数据增强方法,本文依据实际环境进行数据增强。由于海面环境的复杂性主要受天气、污渍和船体运动等因素影响,为提高模型识别鲁棒性,采用4种数据增强算法:高斯噪声、像素模糊噪声、雾天噪声和运动模糊噪声。高斯噪声通过在原始图像中均匀插入无关像素来实现(图3a);雾天噪声处理方法基于文献[24]提出的暗通道去雾技术,本文反向推导此方法,通过人工添加噪声来模拟雾化效果(图3b);像素模糊和运动模糊噪声原理类似,通过α混合模式将周围像素点自然重叠和混合,以实现模糊效果(图3c、3d)。这些数据增强方法使模型能够在雾天、镜头污渍、对焦失败和船体晃动导致的运动模糊情况下有效运行,从而减小对分割结果的影响。最终选取200幅(每组50幅)图像进行数据增强处理,形成包含增强图像的1 750幅水花图像数据集,其中,1 190幅用于训练、255幅用于验证、255幅用于测试。

图3 处理后图像数据集

Fig.3 Processed image datasets

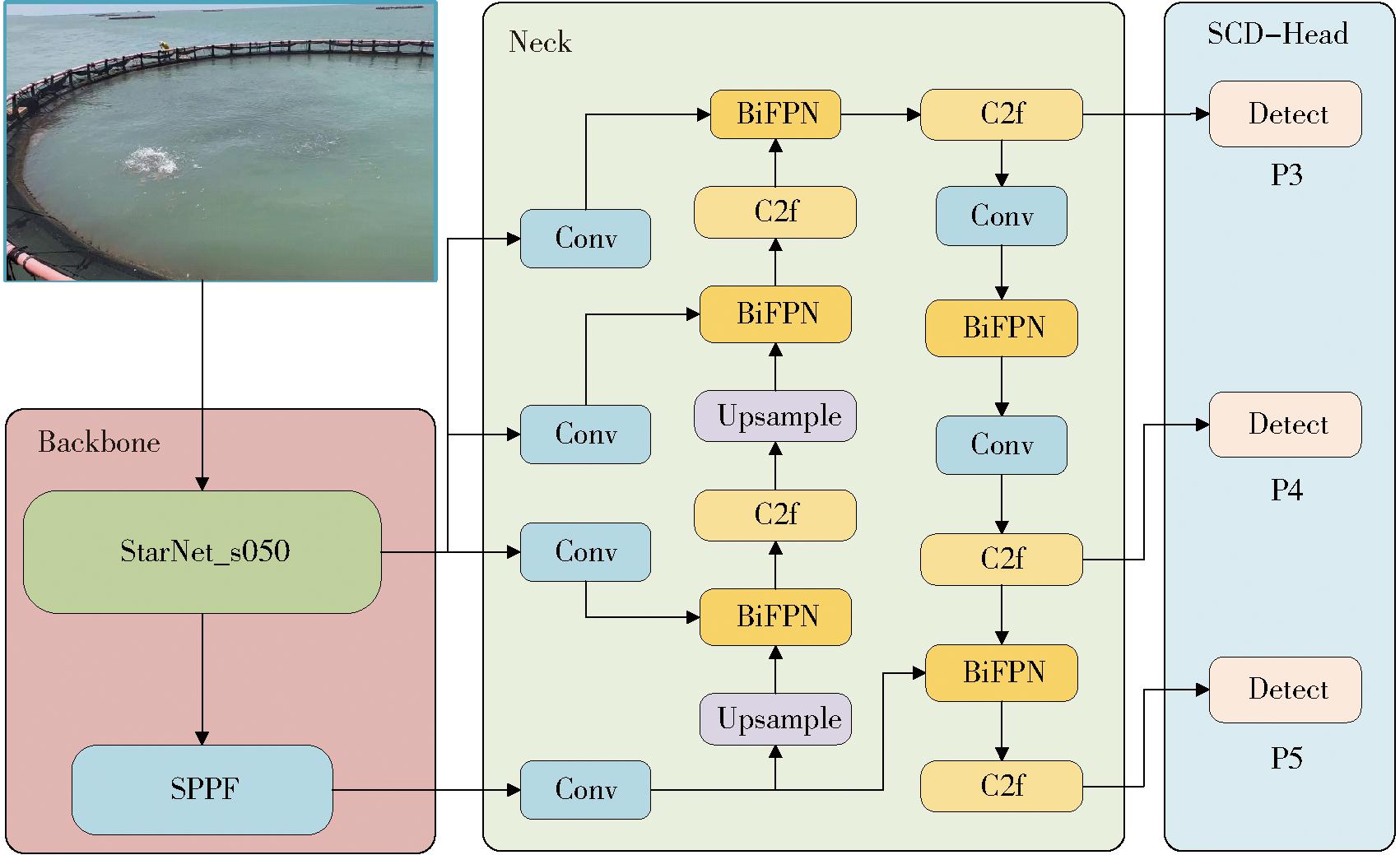

2.1.1 网络总体结构

目前,YOLO系列网络已广泛应用于各个领域检测和分割任务。YOLO v8将物体分类、检测和分割等任务整合到一个统一的框架中,其采用CSP-Darknet53[25]作为主干,使用路径聚合网络PANet[26]作为颈部,并通过解耦头部进行检测和分割。

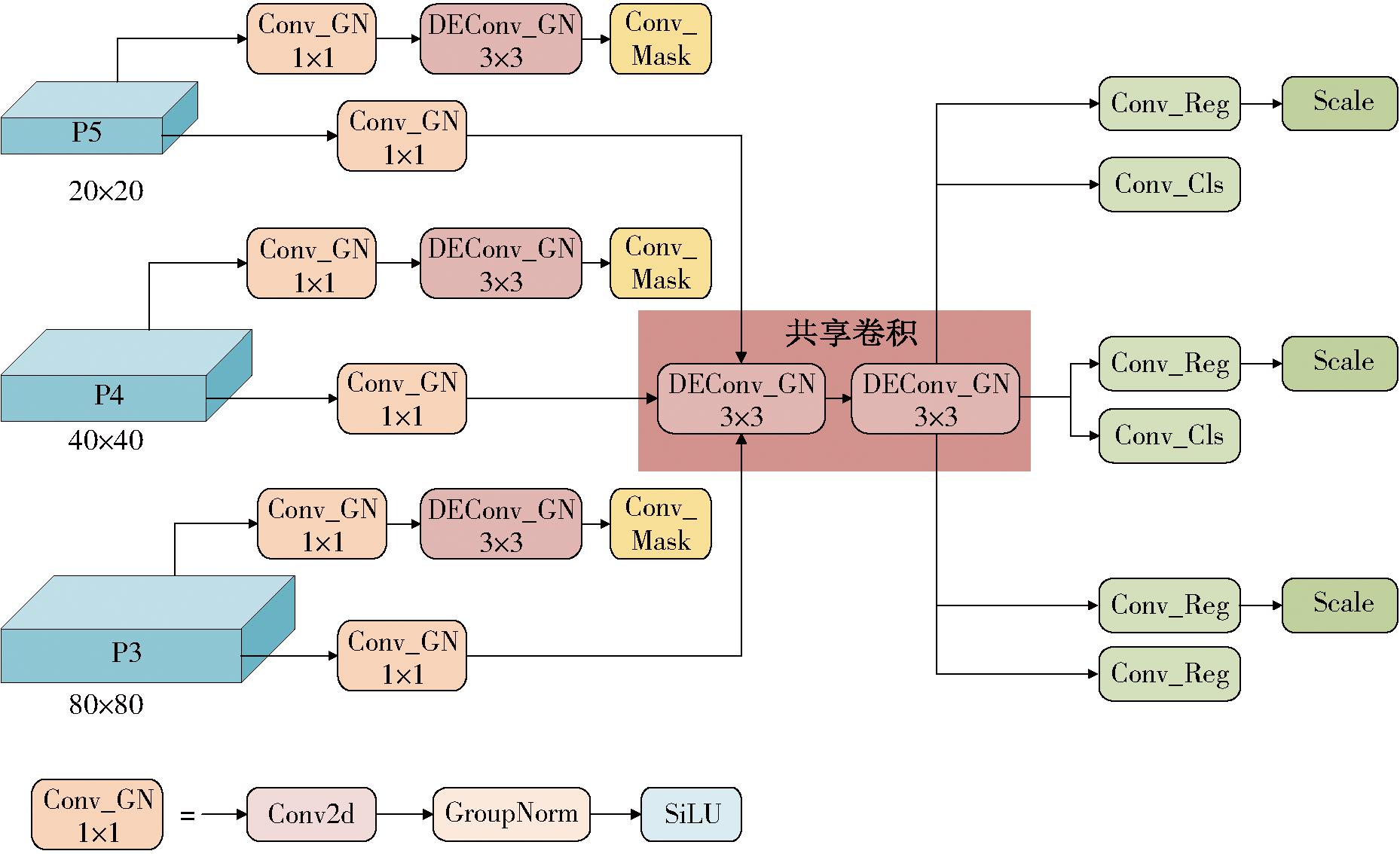

YOLO v8n-SBS网络在YOLO v8n网络基础上进行多项改进,改进YOLO v8n-SBS网络以轻量化为目标,其结构如图4所示。首先将骨干网络替换成StarNet[27]网络结构,提高网络特征提取能力与多尺度信息融合效果,同时减少模型参数量与计算量。其次将颈部中的PANet替换为BiFPN[28]模块,以降低模型参数量并增强多尺度特征融合能力,从而提升检测性能。最后,基于GroupNorm和DEConv设计一种共享卷积检测头(SCD-Head),旨在利用共享卷积的思想在减少检测头参数量的同时,尽量减少精度损失。综合考虑StarNet、BiFPN和SCD-Head等改进,改进YOLO v8n网络命名为YOLO v8n-SBS。

图4 YOLO v8n-SBS 网络结构图

Fig.4 YOLO v8n-SBS network structure

2.1.2 StarNet

StarNet提出了一种新的学习范式——星操作(Star operation),通过元素级乘法将不同子空间的特征进行融合,在多个领域中展现出了卓越的性能和效率。

StarNet采用4级分层架构,通过卷积层进行下采样,并利用修改后的demo block进行特征提取。为提高计算效率,该模型将Layer Normalization替换为Batch Normalization,并引入多个star block以增强特征提取能力。在未使用复杂结构和精心调整超参数的情况下,StarNet仍能够提供较好的性能。因此,使用StarNet网络替换骨干网络。该算法通过高效的星运算显著扩大特征维度,而不会在单个层内增加额外的计算开销。采用这一方案,计算参数得以减少,同时特征提取能力得以保持。

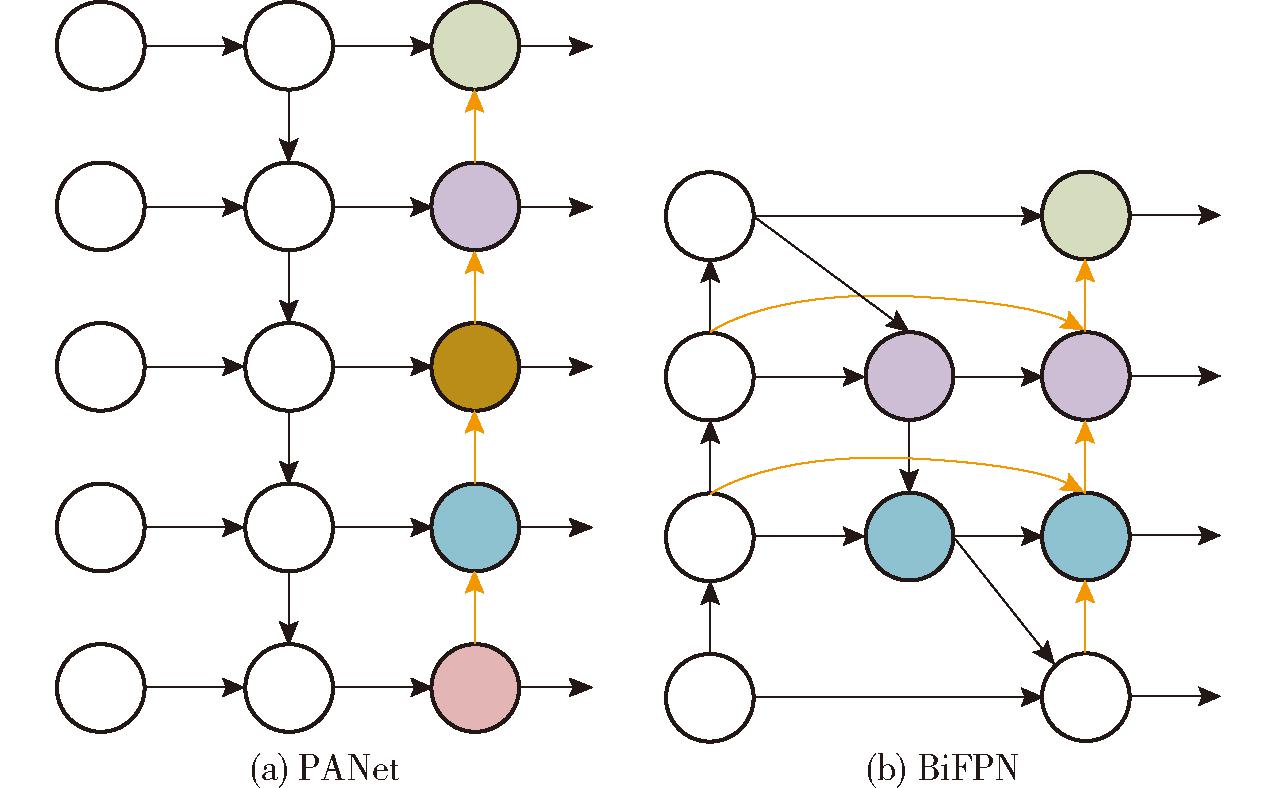

2.1.3 BiFPN

采用更灵活高效的加权双向特征金字塔(BiFPN)来改进颈部网络。通过在不同尺度的特征图之间建立双向连接,BiFPN充分利用细节和语义信息,使模型能够更有效地学习目标特征,从而实现更精准的定位和分类,提升模型的准确性和鲁棒性。

水花图像中,水花大小存在显著差异,涵盖多种不同尺度,因此,如何有效捕获多尺度特征对水花目标分割与检测至关重要。PANet通过融合浅层和深层特征,充分提取网络各层次特征。基于PANet,BiFPN进一步通过添加额外的边来引入上下文信息和可学习的权重信息,从而获取更多的语义信息,并增大感受野。BiFPN中的双向连接机制有助于更好地在不同尺度上捕获特征,增强网络在处理不同尺度和复杂度任务中的能力,因此选择BiFPN对颈部网络进行改进。PANet和BiFPN结构如图5所示。

图5 不同Neck网络结构对比

Fig.5 Comparison of structures of different Neck networks

2.1.4 SCD-Head

YOLO v8原始检测头参数量较大,占据整个算法总计算量的1/5。对于不同尺寸的特征图(P3、P4、P5),具有不同感受野的检测头每个都需执行两次3×3卷积和一次1×1卷积来提取图像信息,这显著增加了参数量。此外,原始算法使用的单尺度预测结构无法有效处理多尺度目标,因为它仅依赖于特征映射的单一尺度进行预测,忽略其他尺度贡献。

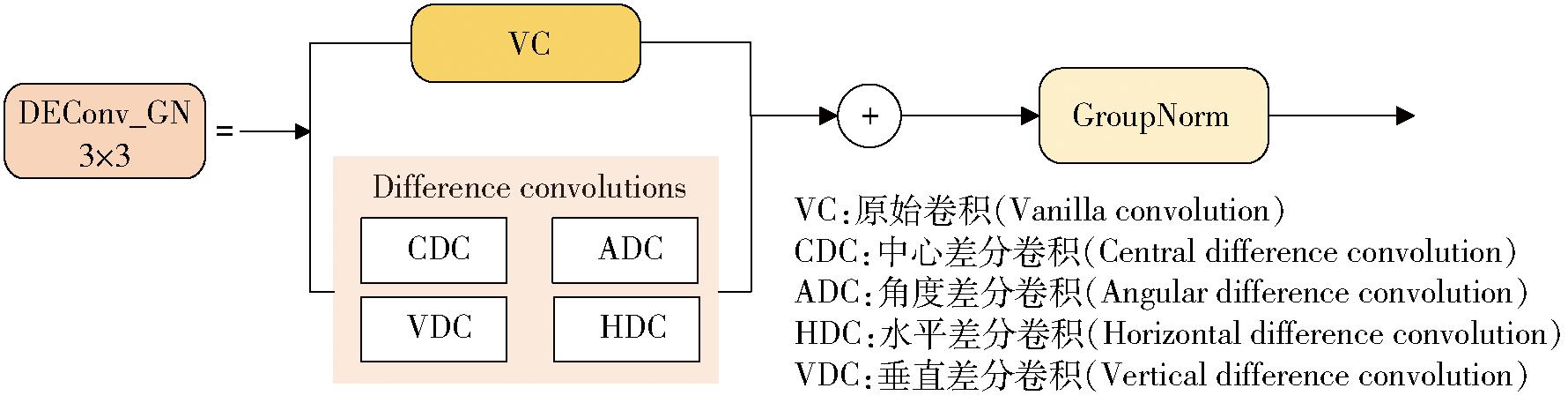

为了解决这些问题,提出一种新的头部结构,称为共享卷积检测头(SCD-Head),如图6所示。该新结构结合GroupNorm卷积,在TIAN等[29]研究中已证明能够显著提高定位和分类性能。此外,由于采用共享卷积,难免会导致提取特征能力下降。因此,本文基于DEA-Net[30]中的详细增强卷积(DEConv)设计了卷积DEConv_GN,提高检测头的细节捕获能力,进一步改善检测精度。DEConv将先验信息集成到标准卷积层中,以增强表示能力和泛化能力。通过重新参数化技术,DEConv可等效地转换为标准卷积,无需增加额外的参数或计算成本。因此,本文将GroupNorm和DEConv相结合,设计DEConv_GN卷积(图7)。

图6 SCD-Head 模块

Fig.6 SCD-Head structure

图7 DEConv_GN模块

Fig.7 DEConv_GN structure

通过引入Scale层对特征进行缩放,以解决每个检测头所检测的目标尺度上不一致的问题。由于分割任务对精度要求较高,故仅引入Conv_GN和DEConv_GN卷积。通过这种设计,模型不仅有效减少参数量,还为检测头提供更多的尺度感知能力。

本文旨在将深度学习模型与立体视觉相结合,精确分割并计算鱼类进食时所造成的水花面积,用于推断鱼类摄食强度。所采用的YOLO模型能够实时分割目标,并输出目标在图像中的坐标掩膜。检测到目标后,根据分割后的坐标掩膜,在ZED相机的深度图像中计算水花面积。ZED深度相机通过其参数(如焦距、像素大小)将像素尺寸转换为实际尺寸。转换过程如下:

计算每个像素实际大小,即

(1)

(2)

计算实际面积,即

(3)

式中 A——水花面积,m2 f——焦距,m

SW、SH——传感器宽度、高度,m

IW、IH——图像宽度、高度,像素

Wpixel、Hpixel——像素宽度、高度,m

Di——第i个像素点深度,m

N——目标总像素点数量

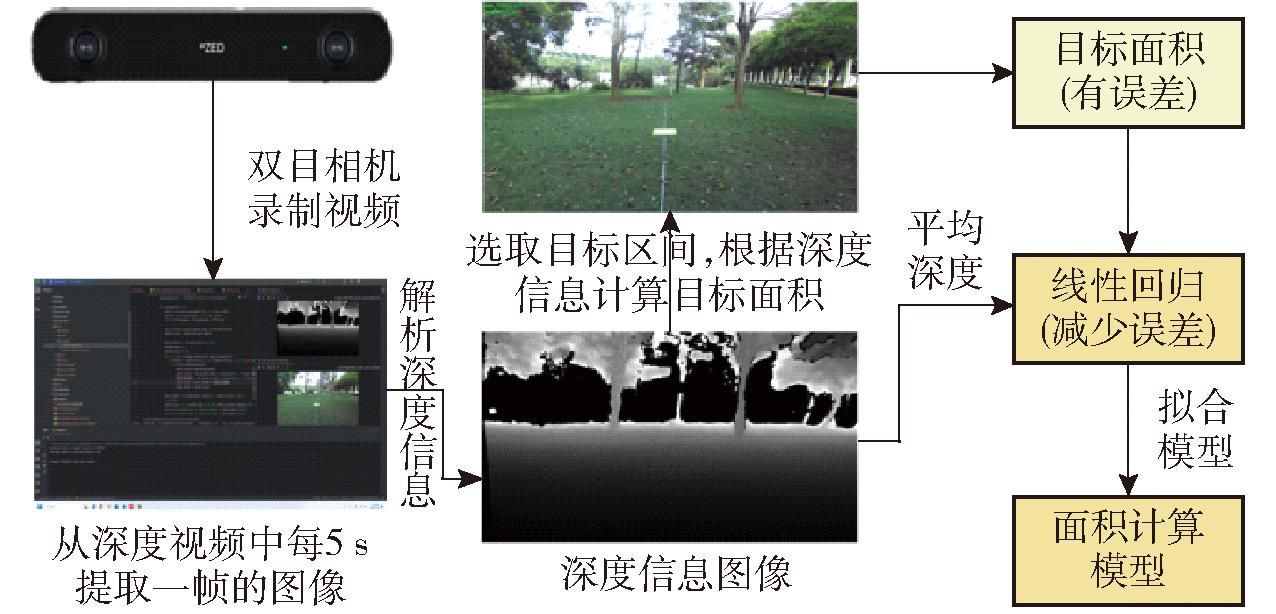

该方法利用每个目标像素点的深度信息来计算目标实际面积。然而,在计算过程中可能存在系统误差,因此需进一步通过线性回归建立数学模型以提高精确度减小误差。

为构建面积计算模型,试验分为2个阶段,分别在广东海洋大学和广东省湛江市渔宝水产养殖公司进行。为方便控制目标位置和距离,本文首先在广东海洋大学使用PVC板模拟水花,进行数据采集并构建计算面积的模型,随后在养殖公司的深海养殖牧场对模型进行验证。

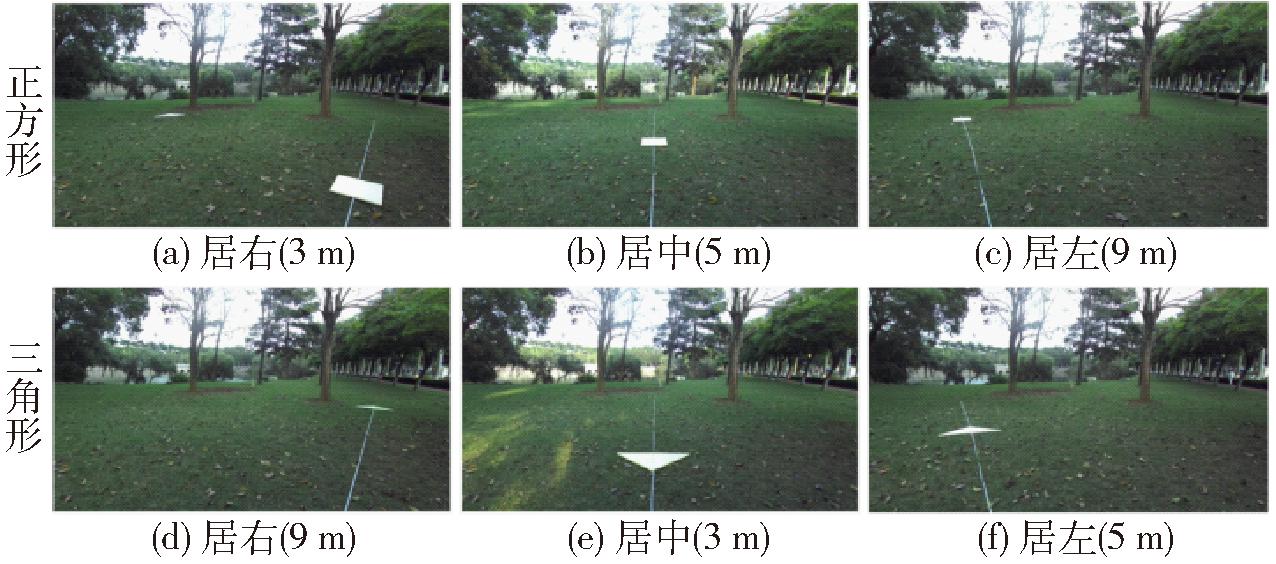

2.3.1 面积计算模型构建

通过线性回归构建计算水花面积的数学模型。首先,在便于控制的陆地环境下进行模拟试验,选择2种形状和3种不同尺寸的PVC板作为面积计算的目标。所选的3个面积规格分别为0.72、0.36、0.18 m2。为了分析目标在不同位置的深度信息对计算结果的影响,分别将PVC板置于视野的中央、左侧和右侧3个位置,并在距离相机3 m外等间距采集数据。相机视角是基于船体高度,平行于地面的。相机正视被测面,对于双目相机计算深度信息效果最佳。因而该视角为工作环境中检测效果最差的视角,所以所构建的模型不会影响实际工作中性能。每隔1 m拍摄10幅图像作为试验数据(图8),每个规格共采集480条数据,最终获得1 440条数据。

图8 PVC板摆放示意图

Fig.8 PVC board layout diagram

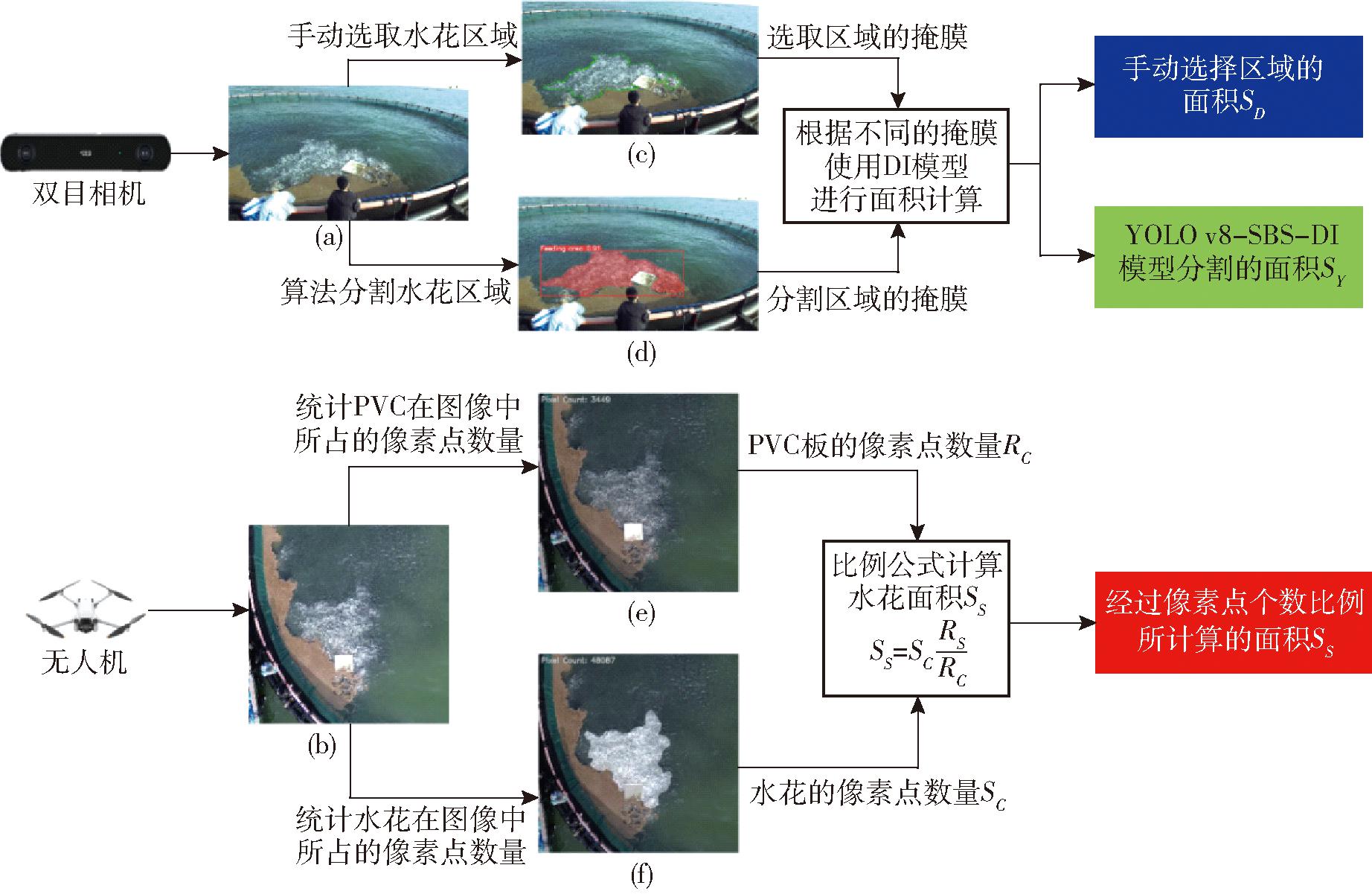

采集的深度图像经过手动选取目标区域,并根据深度信息计算出对应PVC板实际面积。试验流程如图9所示。最后,将计算得到的面积A与PVC板的实际面积进行对比,基于这些数据,利用平均深度信息构建线性回归数学模型DI (Depth information)。

图9 PVC板试验流程图

Fig.9 PVC board test flowchart

2.3.2 模型验证方法

为验证YOLO v8n-SBS-DI模型性能并评估水花面积计算模型DI的精度,在现场试验中采用图像处理方法。如图10所示,双目相机使用模型计算水花面积的同时,利用无人机在网箱上空采集图像,分别统计网箱中PVC板与水花占据的像素点数量,计算水花的实际面积,即

(4)

图10 模型验证流程图

Fig.10 Model validation flowchart

式中 SS——通过像素比例方法计算的水花面积

SC——水花所占的像素点数量

RS——PVC板面积

RC——PVC板所占的像素点数量

利用参照物比例法估算水花的真实面积,并将其与双目相机测得的面积进行比较,从而评估模型的性能。

本研究模型训练以及数据集测试均在同一环境下运行,试验硬件平台为英特尔i5-13400 CPU,24 GB内存,英伟达RTX4070 SUPER 12G显卡。试验操作系统为Windows 11系统,使用Python 3.8解释器和Pytorch 1.13.1深度学习框架。

YOLO v8n-SBS-DI模型验证均采用边缘计算设备(NVIDIA Jetson Orin Na(8 GB)开发板)和ZEDZ-2i型双目相机以及大疆mini 3型无人机采集相关数据进行评估。

采用精确率(Precision,P)、召回率(Recall,R)、平均精度均值(Mean average precision,mAP)、模型参数量、浮点运算量、内存占用量对模型的效果进行综合评估。同时,使用帧率(FPS)来衡量模型在边缘设备上的运行效率。

对于模型在计算面积任务中的性能,选用决定系数(R2)、均方根误差(Root mean square error,RMSE)和平均绝对误差(Mean absolute error,MAE)作为验证指标,以全面评估模型的预测精度和稳定性。

经过500轮次训练,YOLO v8n-seg-SBS模型在测试集中精确率为93.2%,召回率为75.9%,mAP为88.2%,参数量为9.60×105,浮点运算量为7.70×109,表现出良好的性能。使用的测试集包含255幅图像,这些图像中存在由鱼类进食引起的不同程度的水花。该模型对不同情况下的水花进行分割和定位,检测结果如图11所示。

图11 YOLO v8n-seg-SBS 检测效果

Fig.11 YOLO v8n-seg-SBS detection effect

由图11可知,模型不仅能够准确分割出大面积水花,还能够识别局部小区域水花。结果表明,所提出的模型在水花检测和分割方面具有较高的准确性。

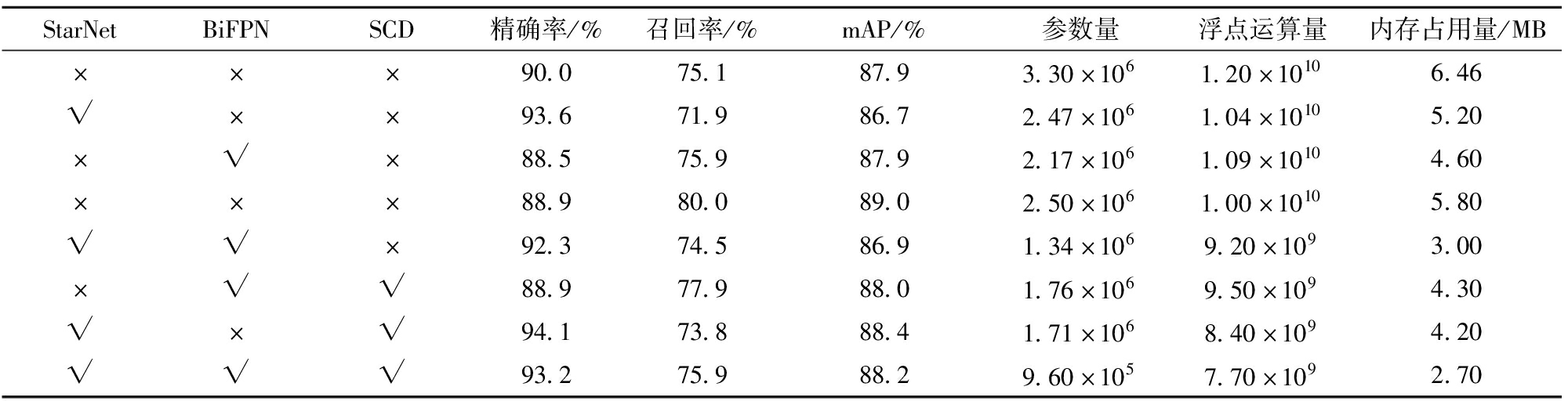

利用StarNet、BiFPN、SCD-Head对YOLO v8进行轻量化改进。为了进一步讨论每种改进方式对最终算法的优化效果,分别将其添加进模型中进行消融试验,在255幅图像的测试集上进行试验。如表1所示,相较于基础模型YOLO v8n-seg的精确率、召回率和mAP分别增加3.2、0.8、0.3个百分点。优化的重点参数量和浮点运算量分别减少到 9.60×105和7.70×109。通过引入StarNet、BiFPN和SCD-Head等模块,模型在显著减少参数量的同时,各项性能指标均有所提升。消融试验结果表明,改进后的网络保持较高的精度,参数量降低71%、浮点运算量降低36%,有效降低在移动设备上部署模型的难度和成本,同时满足实时性的需求。

表1 各改进模块消融试验对比结果

Tab.1 Ablation experiment on each improved module

StarNetBiFPNSCD精确率/%召回率/%mAP/%参数量浮点运算量内存占用量/MB×××90.075.187.93.30×1061.20×10106.46√××93.671.986.72.47×1061.04×10105.20×√×88.575.987.92.17×1061.09×10104.60×××88.980.089.02.50×1061.00×10105.80√√×92.374.586.91.34×1069.20×1093.00×√√88.977.988.01.76×1069.50×1094.30√×√94.173.888.41.71×1068.40×1094.20√√√93.275.988.29.60×1057.70×1092.70

注:√表示采用此模块,×表示不采用此模块。

StarNet模块通过替代传统的骨干网络,使得模型精确率提升3.6个百分点,在减少参数量和浮点运算量方面做到均衡的优化,显著简化模型的复杂性,有效降低模型参数量,但在召回率上有一定的损失。BiFPN模块在网络中也表现良好,虽在精确率方面指标降低,但在其他方面均保持不变或略有提升,特别在参数量方面为3个模块中优化效果最佳。最后,SCD-Head利用共享卷积思想来组合以前独立的卷积,减少参数量并提高基于来自3个不同感受野的信息的检测精度。在所有增强中,SCD-Head在召回率和mAP上分别提升4.9、1.1个百分点,验证了共享卷积在网络中的关键作用,并弥补StarNet在改进中所造成召回率和mAP的损失。虽然每个模块均有部分性能损失,但在最后都能互相弥补,做到整体指标上升。

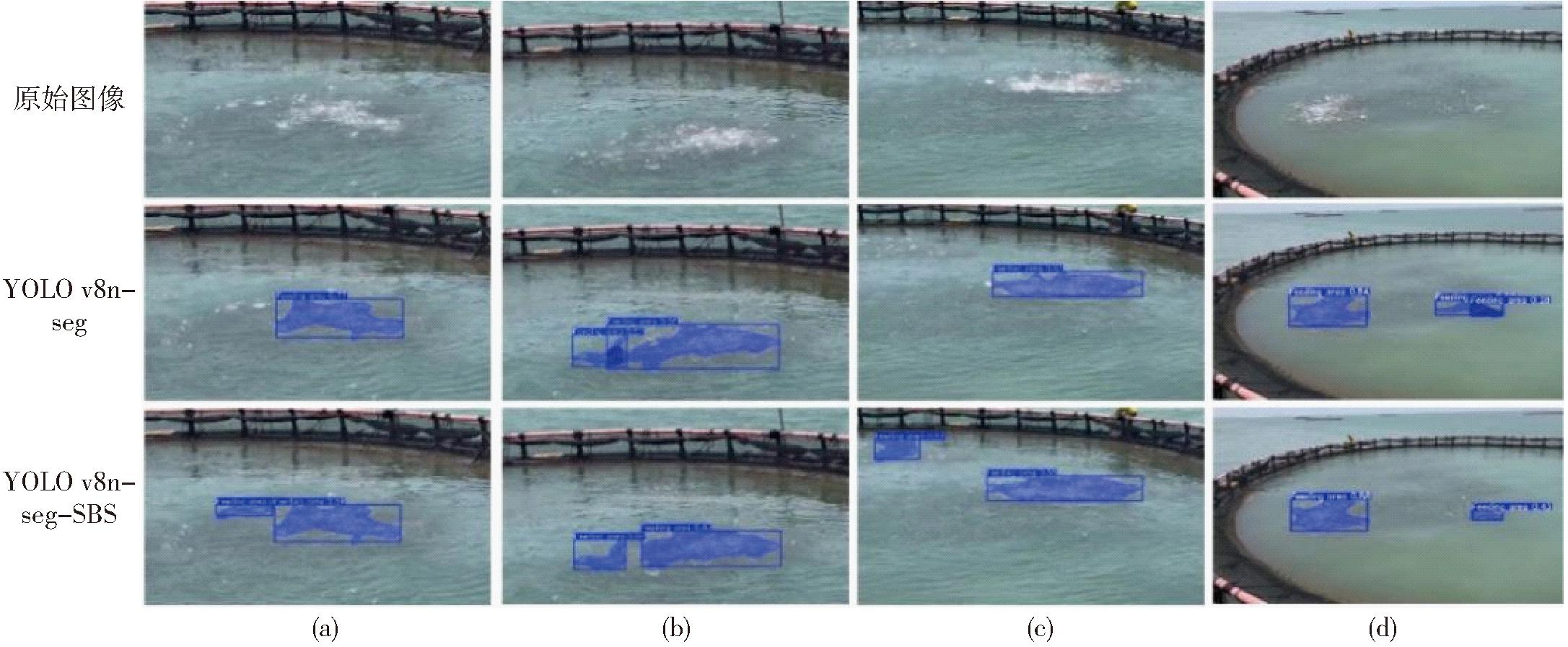

在255幅测试图像上对基础模型YOLO v8n-seg和改进模型YOLO v8n-seg-SBS进行对比。部分测试结果如图12所示。由图12a可知,基础模型在图像左侧区域漏检了一些水花,表现出检测能力不足。图12b中,基础模型不仅检测精度较低,还存在分割重叠现象,虽两种算法均有重叠,但基础模型重叠率为0.17,而改进模型重叠率为0.08。图12c中,基础模型对远处的小水花漏检,反映出其在小目标检测方面的不足,而在YOLO v8n-seg-SBS模型中,BiFPN模块的引入改善了小目标检测效果,SCD-Head共享卷积头通过多感受野的结合也提升小目标检测性能。图12d中,基础模型将非水花区域错误地划分为水花区域,而改进后模型则能够准确区分这些区域,展现了更强的特征识别能力。总体而言,改进后模型在检测精度和鲁棒性方面均优于基础模型。

图12 分割效果对比

Fig.12 Segmentation effect comparison diagrams

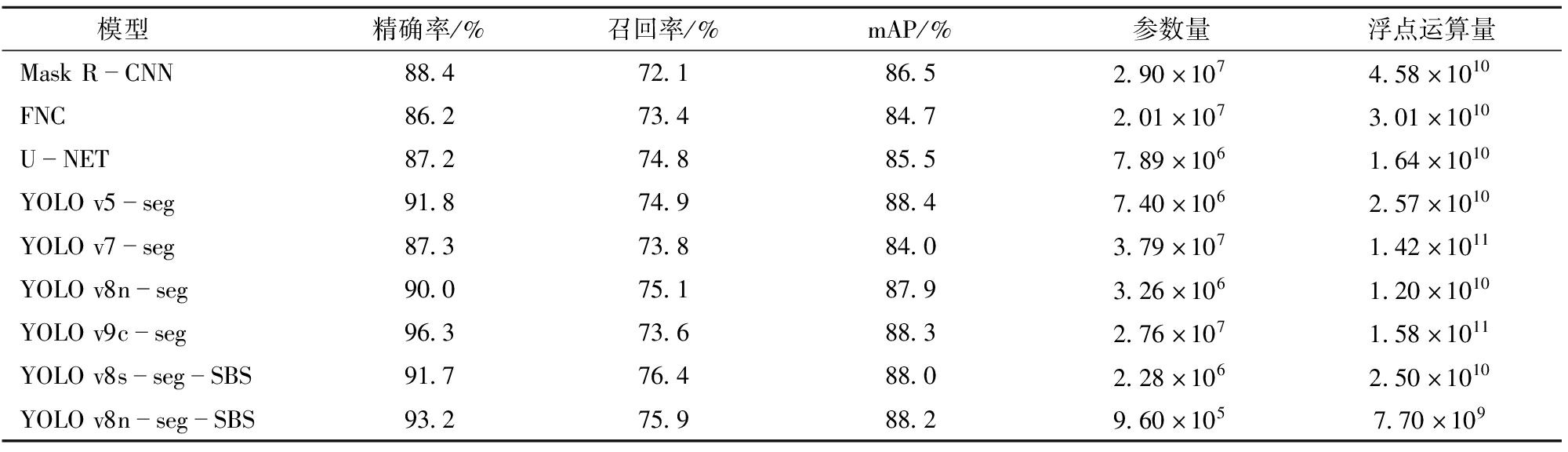

为进一步评估改进网络对水花目标的检测和分割效果,将提出的YOLO v8n-seg-SBS模型与传统模型(如Mask R-CNN、FNC和U-NET)和先进YOLO系列模型(YOLO v5-seg、YOLO v7-seg、YOLO v8-seg、YOLO v9c-seg)对比。在相同环境下对模型进行训练和测试,测试结果如表2所示。与其他模型相比,YOLO v8n-seg-SBS在精确率、召回率、mAP和参数量等指标上均表现出显著优势,在目标检测任务中表现优异。

表2 模型分析对比试验结果

Tab.2 Comparative experiment results of modelling analysis

模型精确率/%召回率/%mAP/%参数量浮点运算量MaskRCNN88.472.186.52.90×1074.58×1010FNC86.273.484.72.01×1073.01×1010UNET87.274.885.57.89×1061.64×1010YOLOv5seg91.874.988.47.40×1062.57×1010YOLOv7seg87.373.884.03.79×1071.42×1011YOLOv8nseg90.075.187.93.26×1061.20×1010YOLOv9cseg96.373.688.32.76×1071.58×1011YOLOv8ssegSBS91.776.488.02.28×1062.50×1010YOLOv8nsegSBS93.275.988.29.60×1057.70×109

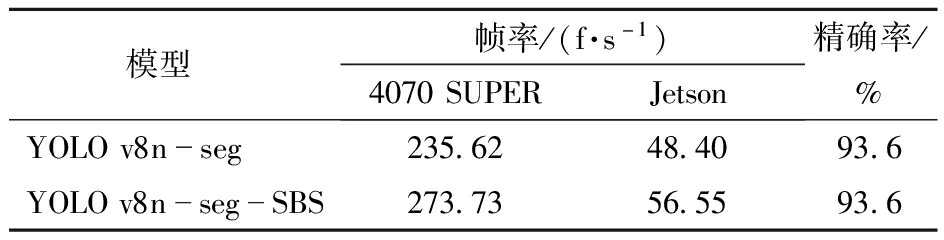

在资源消耗方面,YOLO v8n-seg-SBS模型参数量仅为9.60×105,显著低于其他模型。例如,YOLO v7-seg参数量为3.79×107,YOLO v9c-seg参数量为2.76×107,这突显YOLO v8n-seg-SBS在硬件资源利用率和模型训练时间上的优势。此外,YOLO v8n-seg-SBS浮点运算量为7.70×109,远低于YOLO v9c-seg的1.58×1011和YOLO v7-seg的1.42×1011,将算法分别部署在台式计算机(4070 SUPER)与边缘计算设备(Jetson)上计算帧率,试验结果如表3所示,可以看出帧率均有提升。这表明其推理过程中计算成本更低,更适合部署在资源受限的设备上。

表3 部署在不同设备上帧率对比

Tab.3 Comparison of FPS deployed on different devices

模型帧率/(f·s-1)4070SUPERJetson精确率/%YOLOv8nseg235.6248.4093.6YOLOv8nsegSBS273.7356.5593.6

综上所述,YOLO v8n-seg-SBS模型在保持高精度的同时,有效减少参数量和计算量,显示出广泛应用的潜力。未来研究可以进一步优化该模型,以在不同的数据集和任务上获得更优异性能。

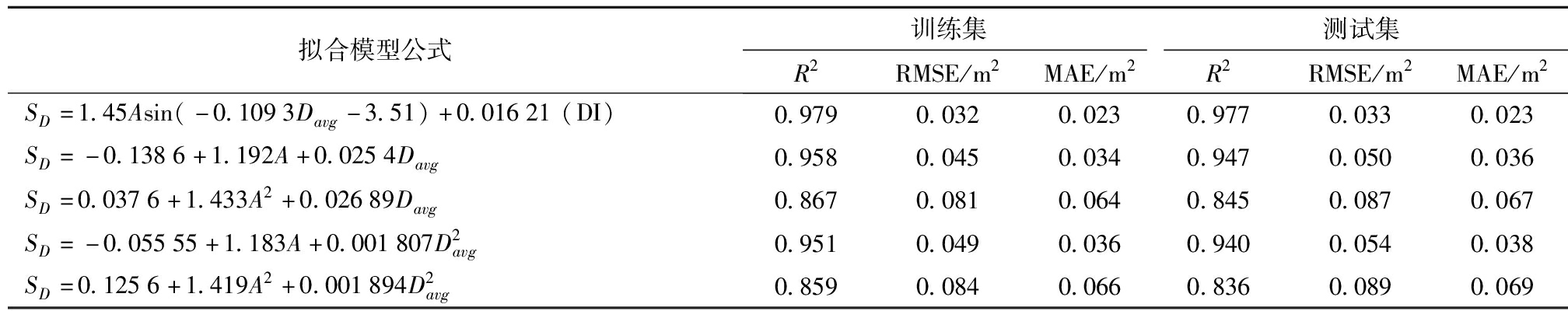

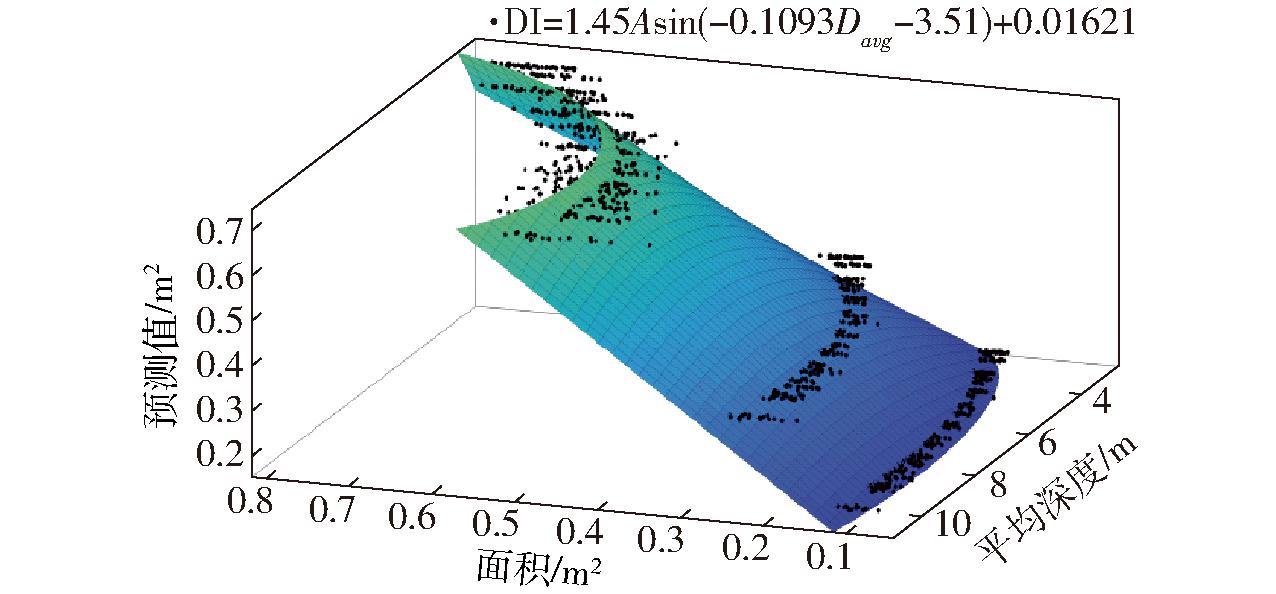

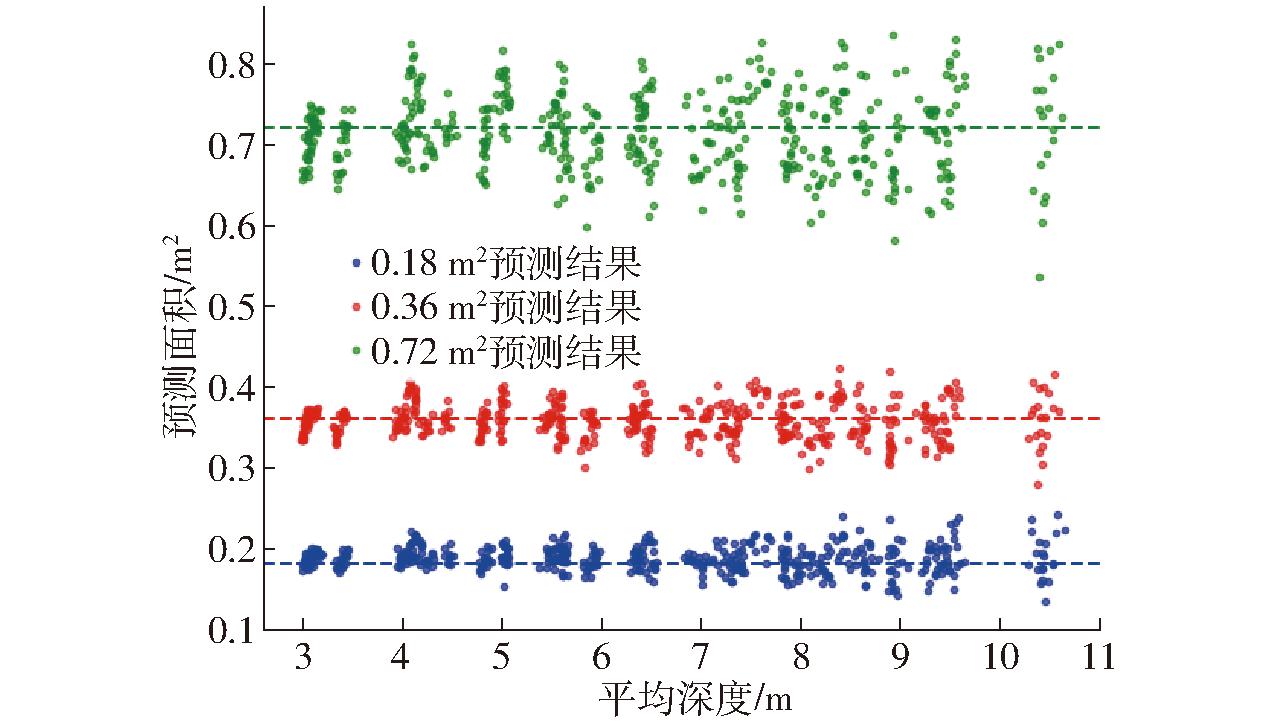

在PVC板试验中,根据数据分布情况,将数据分为1 296条训练集和144条测试集。基于像素点平均深度(Davg)和双目相机所测面积(A),采用线性回归构建几种数学模型,结果如表4所示,拟合效果最佳的模型被命名为DI,即通过深度信息计算面积模型。在测试集上模型决定系数(R2)为0.977,拟合结果如图13所示。

表4 模型对比结果

Tab.4 Model comparison result

拟合模型公式训练集测试集R2RMSE/m2MAE/m2R2RMSE/m2MAE/m2SD=1.45Asin(-0.1093Davg-3.51)+0.01621(DI)0.9790.0320.0230.9770.0330.023SD=-0.1386+1.192A+0.0254Davg0.9580.0450.0340.9470.0500.036SD=0.0376+1.433A2+0.02689Davg0.8670.0810.0640.8450.0870.067SD=-0.05555+1.183A+0.001807D2avg0.9510.0490.0360.9400.0540.038SD=0.1256+1.419A2+0.001894D2avg0.8590.0840.0660.8360.0890.069

图13 DI模型拟合效果

Fig.13 DI model fitting effect

如图14所示,x轴表示双目相机计算的目标所有像素点的平均深度,y轴则表示通过DI模型估算的PVC板面积结果。可以看出,预测结果受到目标实际面积和目标与双目相机距离的影响。目标面积越大,误差越大;目标距离越大,误差也越大。

图14 PVC板面积估算结果

Fig.14 PVC board area estimation results

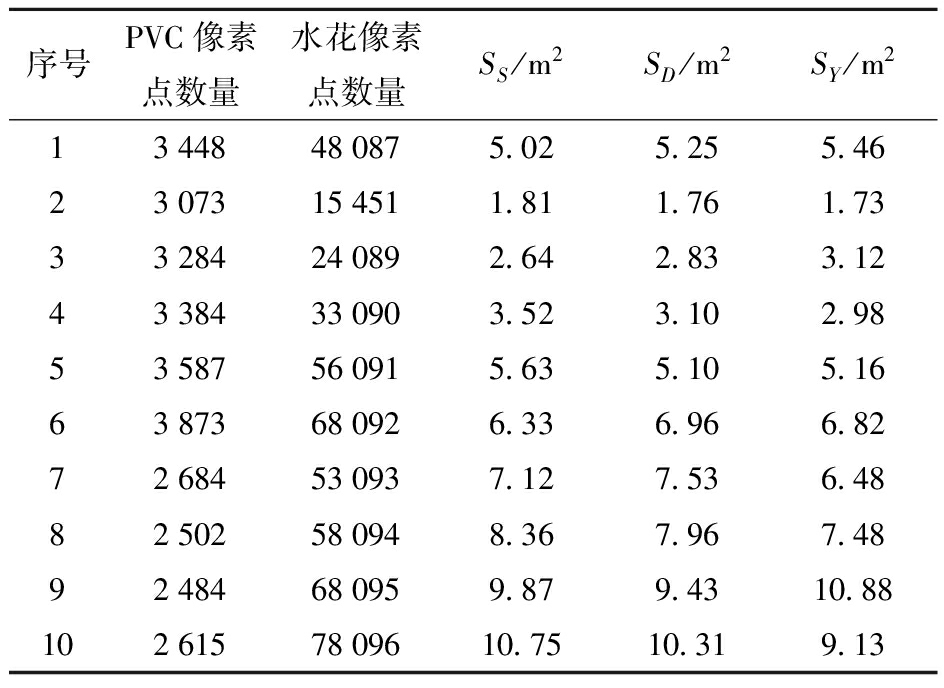

将DI模型与YOLO v8n-SBS组合为YOLO v8n-SBS-DI模型,为了分析在实际应用中该模型性能,在网箱内对模型进行性能评估。图15a为投料船上使用双目相机录制的视频帧,图15b为同一时刻无人机在网箱上方采集的图像。通过手动选择图15a中的水花区域,即为图15c,并利用深度信息计算手动选择区域面积SD。同时,在图15b中手动选取PVC板(图15e)和水花区域(图15f),并分别计算像素点数量。由于矩形面积RS已知,可以通过比例计算水花实际面积SS。图15d展示了改进后网络对图15a中水花区域识别结果,并根据深度信息用YOLO v8n-SBS-DI模型计算出识别区域面积SY,部分测量结果见表5。

表5 各试验数据部分统计结果

Tab.5 Statistical results of each test data section

序号PVC像素点数量水花像素点数量SS/m2SD/m2SY/m213448480875.025.255.4623073154511.811.761.7333284240892.642.833.1243384330903.523.102.9853587560915.635.105.1663873680926.336.966.8272684530937.127.536.4882502580948.367.967.4892484680959.879.4310.881026157809610.7510.319.13

图15 试验流程示意图

Fig.15 Test flow diagram

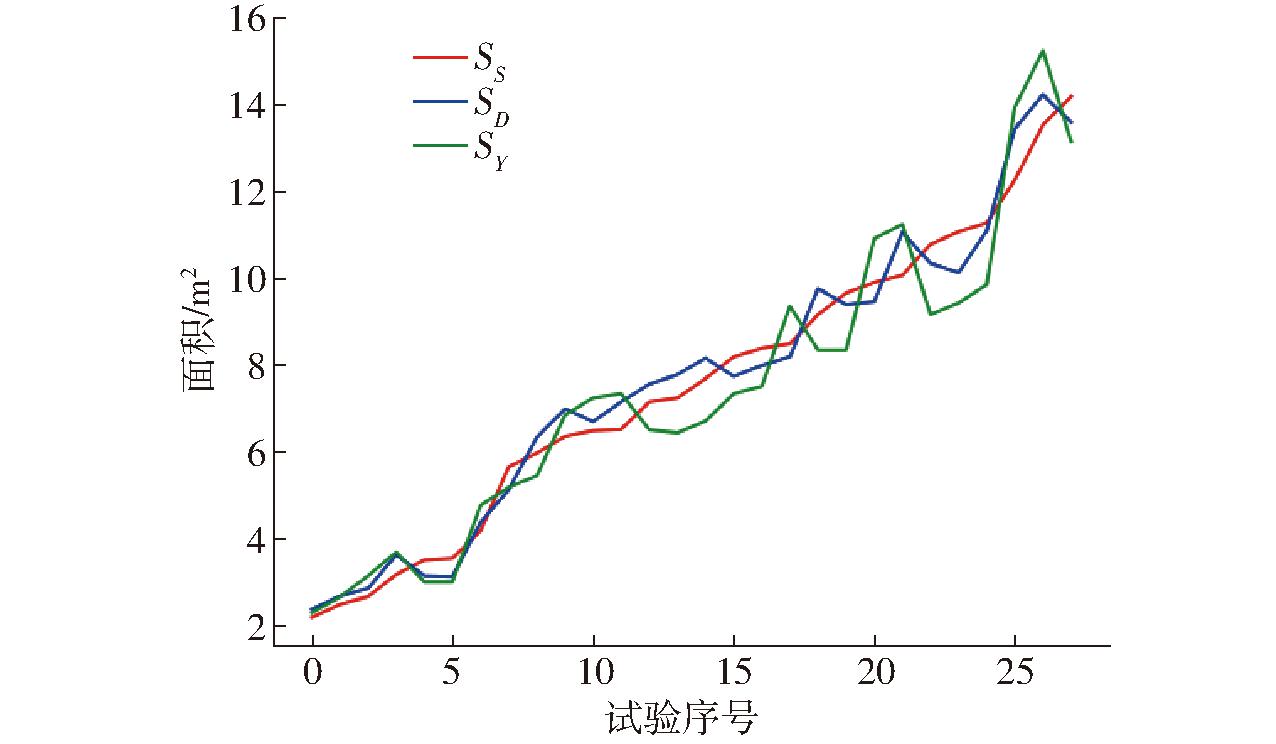

基于上述步骤,进行了30组试验,涵盖大小不一、距离不同的水花区域。试验结果如图16所示。红色线段表示通过像素点比例计算的水花面积测量值SS。由于真实的水花面积难以直接测量,将通过像素比例计算的SS作为水花真实面积。蓝色线段表示手动选取的深度图像中计算的水花面积SD,绿色线段则表示基于YOLO v8n-SBS-DI模型计算的水花面积SY。SD作为分割模型性能对比基准,SY越接近SD,分割模型性能越好;而SS则作为真实水花面积参考,用于评估整个系统性能。SD越接近SS,说明面积计算模型DI性能越好;SY越接近SS,则表示YOLO v8n-SBS-DI对水花面积自动计算性能越好。

图16 面积计算试验结果

Fig.16 Area calculation test results

由图16可知,3条线段趋势基本一致,表明DI模型能够较好地计算水花面积。其中,YOLO v8n-SBS-DI模型计算的目标面积SY,与手动选取的面积SD相比,精度略有下降,尤其是对于较大的目标区域。这种误差主要来源于深度学习算法在分割过程中引入的误差。然而,模型仍能够相对精确地计算出目标面积的变化趋势,满足工业应用。

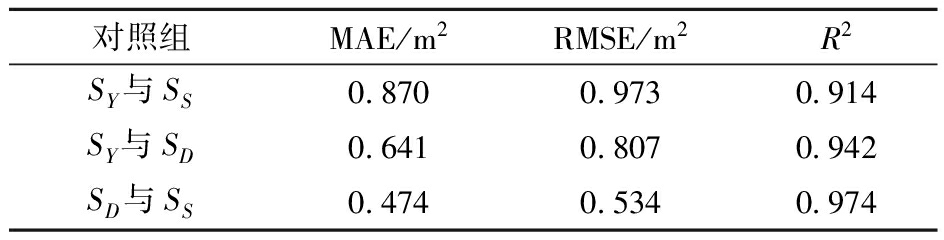

表6为SY与SS、SY与SD、SD与SS 3组数据MAE、RMSE和R2的计算结果。由表6可知,手动选择的水花面积SD与通过像素比例计算的SS之间误差较小。这种误差部分来源于手动选择区域时的精确度不足,另一部分则源自DI模型计算过程中的误差。SY与SD误差不大,证明分割效果达到较高水平。对于SY与SS的对比,MAE仅为0.87 m2,RMSE为0.973 m2,R2高达0.914,表明深度学习方法结合双目相机的深度信息可以实时准确地计算目标面积。

表6 试验统计结果

Tab.6 Experimental statistics

对照组MAE/m2RMSE/m2R2SY与SS0.8700.9730.914SY与SD0.6410.8070.942SD与SS0.4740.5340.974

(1)通过分割和计算鱼类进食时产生的水花面积,为投料设备提供评估摄食强度的依据,可以优化养殖过程,防止过量投喂导致饲料浪费和水质污染。或当鱼类长期表现出食欲不佳时,该方法还可提供健康预警,提醒养殖人员密切关注。

(2)提出YOLO v8-SBS网络结构,利用StarNet网络替代Backbone网络,增加网络特征提取能力,通过BiFPN加权融合方式实现多尺度特征融合,并设计SCD-Head在保留精度的同时减少检测头的冗余参数。相比原模型,改进模型精确率提高3.2个百分点,达到93.2%,参数量和计算量显著降低,参数量和浮点运算量分别减少71%和36%。有效降低边缘设备部署难度和成本。

(3)基于双目相机的深度信息,提出了基于线性回归的面积计算模型DI。对PVC板进行试验,结果表明,随着目标面积增大,测量误差也随之增加;目标距离越远,误差也相应增大。

(4)基于组合数学模型YOLO v8n-SBS-DI,在自然海上环境中进行了水花面积估算试验。试验结果显示,MAE、RMSE和R2分别为0.870、0.973 m2和0.914。试验结果表明,双目相机与深度学习算法相结合,能够有效计算鱼类进食时产生的水花面积。

[1] 胡学龙,朱文韬,杨信廷,等.基于水质-声音-视觉融合的循环水养殖鱼类摄食强度识别[J].农业工程学报,2023,39(10):141-150.HU Xuelong,ZHU Wentao,YANG Xinting,et al.Identification of feeding intensity in recirculating aquaculture fish using water quality-sound-vision fusion[J].Transactions of the CSAE,2023,39(10):141-150.(in Chinese)

[2] F∅RE M,ALVER M,ALFREDSEN J A,et al.Modelling growth performance and feeding behaviour of Atlantic salmon (Salmo salar L.) in commercial-size aquaculture net pens:model details and validation through full-scale experiments[J].Aquaculture,2016,464:268-278.

[3] ZHAO S,DING W,ZHAO S,et al.Adaptive neural fuzzy inference system for feeding decision-making of grass carp (Ctenopharyngodon idellus) in outdoor intensive culturing ponds[J].Aquaculture,2019,498:28-36.

[4] ZHOU C,XU D,LIN K,et al.Intelligent feeding control methods in aquaculture with an emphasis on fish:a review[J].Reviews in Aquaculture,2018,10(4):975-993.

[5] DU Y,SUN G,ZHENG B,et al.Design and implementation of intelligent gateway system for monitoring livestock and poultry feeding environment based on bluetooth low energy[J].Information,2021,12(6):218.

[6] BANERJEE S,ALVEY L,BROWN P,et al.An assistive computer vision tool to automatically detect changes in fish behavior in response to ambient odor[J].Scientific Reports,2021,11(1):1002.

[7] KOLAREVIC J,AAS-HANSEN ∅,ESPMARK Å,et al.The use of acoustic acceleration transmitter tags for monitoring of Atlantic salmon swimming activity in recirculating aquaculture systems (RAS)[J].Aquacultural Engineering,2016,72:30-39.

[8] RAKOWITZ G,TU ER M,

ER M,

HA M,et al.Use of high-frequency imaging sonar (DIDSON) to observe fish behaviour towards a surface trawl[J].Fisheries Research,2012,123:37-48.

HA M,et al.Use of high-frequency imaging sonar (DIDSON) to observe fish behaviour towards a surface trawl[J].Fisheries Research,2012,123:37-48.

[9] 陈彩文,杜永贵,周超,等.基于图像纹理特征的养殖鱼群摄食活动强度评估[J].农业工程学报,2017,33(5):232-237.CHEN Caiwen,DU Yonggui,ZHOU Chao,et al.Evaluation of feeding activity of shoal based on image texture[J].Transactions of the CSAE,2017,33(5):232-237.(in Chinese)

[10] 张重阳,陈明,冯国富,等.基于多特征融合与机器学习的鱼类摄食行为的检测[J].湖南农业大学学报(自然科学版),2019,45(1):97-102.ZHANG Chongyang,CHEN Ming,FENG Guofu,et al.Detection method of fish feeding behavior based on the multi-feature fusion and the machine learning[J].Journal of Hunan Agricultural University (Natural Science Edition),2019,45(1):97-102.(in Chinese)

[11] ZHOU C,ZHANG B,LIN K,et al.Near-infrared imaging to quantify the feeding behavior of fish in aquaculture[J].Computers and Electronics in Agriculture,2017,135:233-241.

[12] 张铮,沈彦兵,张泽扬.基于运动特征提取和2D卷积的鱼类摄食行为识别研究[J].农业机械学报,2024,55(6):246-253.ZHANG Zheng,SHEN Yanbing,ZHANG Zeyang.Recognition of feeding behavior of fish based on motion feature extraction and 2D convolution[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(6):246-253.(in Chinese)

[13] 赵建.循环水养殖游泳型鱼类精准投喂研究[D].杭州:浙江大学,2018.ZHAO Jian.Precise feeding for the swimming fish in recirculating aquaculture system[D].Hangzhou:Zhejiang University,2018.(in Chinese)

[14] WU Y,WANG X,SHI Y,et al.Fish feeding intensity assessment method using deep learning-based analysis of feeding splashes[J].Computers and Electronics in Agriculture,2024,221:108995.

[15] 张震,周俊,江自真,等.基于改进YOLO v7轻量化模型的自然果园环境下苹果识别方法[J].农业机械学报,2024,55(3):231-242,262.ZHANG Zhen,ZHOU Jun,JIANG Zizhen,et al.Lightweight apple recognition method in natural orchard environment based on improved YOLO v7 model[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):231-242,262.(in Chinese)

[16] HOWARD A,SANDLER M,CHU G,et al.Searching for Mobilenetv3[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision,2019:1314-1324.

[17] MA N,ZHANG X,ZHENG H T,et al.Shufflenet v2:practical guidelines for efficient CNN architecture design[C]∥Proceedings of the European Conference on Computer Vision (ECCV),2018:116-131.

[18] TANG Y,HAN K,GUO J,et al.GhostNetv2:enhance cheap operation with long-range attention[J].Advances in Neural Information Processing Systems,2022,35:9969-9982.

[19] HU X,LIU Y,ZHAO Z,et al.Real-time detection of uneaten feed pellets in underwater images for aquaculture using an improved YOLO-V4 network[J].Computers and Electronics in Agriculture,2021,185:106135.

[20] HU W C,CHEN L B,HUANG B K,et al.A computer vision-based intelligent fish feeding system using deep learning techniques for aquaculture[J].IEEE Sensors Journal,2022,22(7):7185-7194.

[21] 李丽,梁继元,张云峰,等.基于改进YOLO v5的复杂环境下柑橘目标精准检测与定位方法[J].农业机械学报,2024,55(8):280-290.LI Li,LIANG Jiyuan,ZHANG Yunfeng,et al.Accurate detection and location method of citrus target in complex environment based on improved YOLO v5[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(8):280-290.(in Chinese)

[22] ZHANG R,LIAN S,LI L,et al.Design and experiment of a binocular vision-based canopy volume extraction system for precision pesticide application by UAVs[J].Computers and Electronics in Agriculture,2023,213:108197.

[23] WANG A,QIAN W,LI A,et al.NVW-YOLO v8s:an improved YOLO v8s network for real-time detection and segmentation of tomato fruits at different ripeness stages[J].Computers and Electronics in Agriculture,2024,219:108833.

[24] HE K,SUN J,TANG X.Single image haze removal using dark channel prior[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,33(12):2341-2353.

[25] BOCHKOVSKIY A,WANG C Y,LIAO H Y M.YOLO v4:optimal speed and accuracy of object detection[J].arXiv Preprint,arXiv:2004.10934,2020.

[26] LIU S,QI L,QIN H,et al.Path aggregation network for instance segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:8759-8768.

[27] MA X,DAI X,BAI Y,et al.Rewrite the stars[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2024:5694-5703.

[28] TAN M,PANG R,LE Q V.Efficientdet:scalable and efficient object detection[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2020:10781-10790.

[29] TIAN Z,CHU X,WANG X,et al.Fully convolutional one-stage 3D object detection on LiDAR range images[J].Advances in Neural Information Processing Systems,2022,35:34899-34911.

[30] CHEN Z,HE Z,LU Z M.DEA-Net:single image dehazing based on detail-enhanced convolution and content-guided attention[J].IEEE Transactions on Image Processing,2024,33:1002-1015.