高通量棉花产量估算对于棉花种质资源筛选与农业资源调配具有重要意义,传统的产量估算方式主要基于田间人工调查,估产效率低,准确度差[1],因此,大面积棉花产量快速准确估算对于棉花品种选育和精细化田间管理至关重要[2]。近年来,随着无人机技术的发展和传感器技术的进步,使用无人机搭载高分辨率传感器,在获取田间尺度的遥感信息方面具有巨大优势和潜力[3]。从无人机(Unmanned aerial vehicle,UAV)遥感数据中提取的光谱特征、冠层结构、纹理特征等信息已用于估算各种作物产量[4-5],并且有研究指出,基于多源传感器的融合数据可以有效提高作物产量的估算精度[6-7]。目前的遥感估产模型主要分为经验模型、半经验模型和机理模型[8-10] 3类,其中半经验模型和机理模型虽然能够较为准确地描述作物的生长机制,但是面临着复杂的数据同化和校准问题[11-12];而经验模型忽略了作物产量形成的复杂过程,所需的参数量较小,并且更加适用于田块尺度的作物产量估算[13-14]。

现有棉花产量估算大多基于单生育期或2到3期遥感数据[15-16],难以确定棉花产量估算最佳时期。RGB(Red green blue)和多光谱(Multispectral,MS)传感器在UAV高通量表型分析领域中是最常用的传感器[3],已经有相关研究对比了不同传感器数据在作物性状估算中的效果[17-19]。然而,在使用不同类型的光谱特征和不同的应用场景下,两者的表现也不尽相同,对此相关的研究较为缺乏。虽然已有将多种传感器数据进行融合并用于作物产量估算的研究[20],但很少有关于光谱、冠层结构、纹理特征等信息对于作物产量估算的贡献程度进行系统分析的研究。由于机器学习模型主要通过数据驱动,模型的决策是基于大量数据的统计规律而非现实逻辑,且模型本身较为复杂,因此其内部机制通常难以被开发人员和用户理解[21]。夏普利加性解释(Shapley additive explanations,SHAP)算法是最近提出的一种机器学习模型可解释性分析工具,通过计算特征对模型结果的边际影响,可以较为直观地描述每个特征在模型中的贡献度[22],有助于增强模型的可解释性。

本文基于新疆维吾尔自治区昌吉回族自治州玛纳斯县棉花地块的2023年和2024年UAV遥感数据(RGB相机、MS相机和激光雷达)和产量数据,将UAV数据预处理后提取光谱特征、冠层结构和纹理特征3类特征指标;通过比较各时期植被指数(Vegetation index,VI)与产量的皮尔逊相关系数来确定产量预测的最佳生育时期,并利用偏最小二乘法回归(Partial least squares regression,PLSR)、随机森林回归(Random forest regression,RFR)、极致梯度提升(Extreme gradient boost,XGBoost)3种机器学习算法,建立最佳生育时期的产量估算模型;通过评估模型精度来比较RGB和MS数据在产量预测中的效果;引入SHAP方法计算输入特征对于模型结果的贡献度、增强机器学习模型的可解释性以及分析各类数据和特征在产量估算中的贡献程度,以期为棉花智慧化管理中高通量棉花产量估算提供理论和技术支持。

本研究对UAV影像数据进行预处理,包括植被指数阈值掩膜剔除RGB和MS图像的土壤背景以便提取冠层的光谱和纹理信息,以及将结构信息分为通过RGB图像计算的植被覆盖度和通过LiDAR点云提取的冠层高度两部分;随后,利用相关性分析确定棉花产量估算的最佳生育时期;进而使用最佳生育时期的特征建立机器学习模型,将产量实测值按比例7∶3随机划分为训练集和测试集,用来训练和评估模型;最后,使用SHAP算法分析各特征贡献度。具体技术路线如图1所示。

图1 技术路线图

Fig.1 Technology roadmap

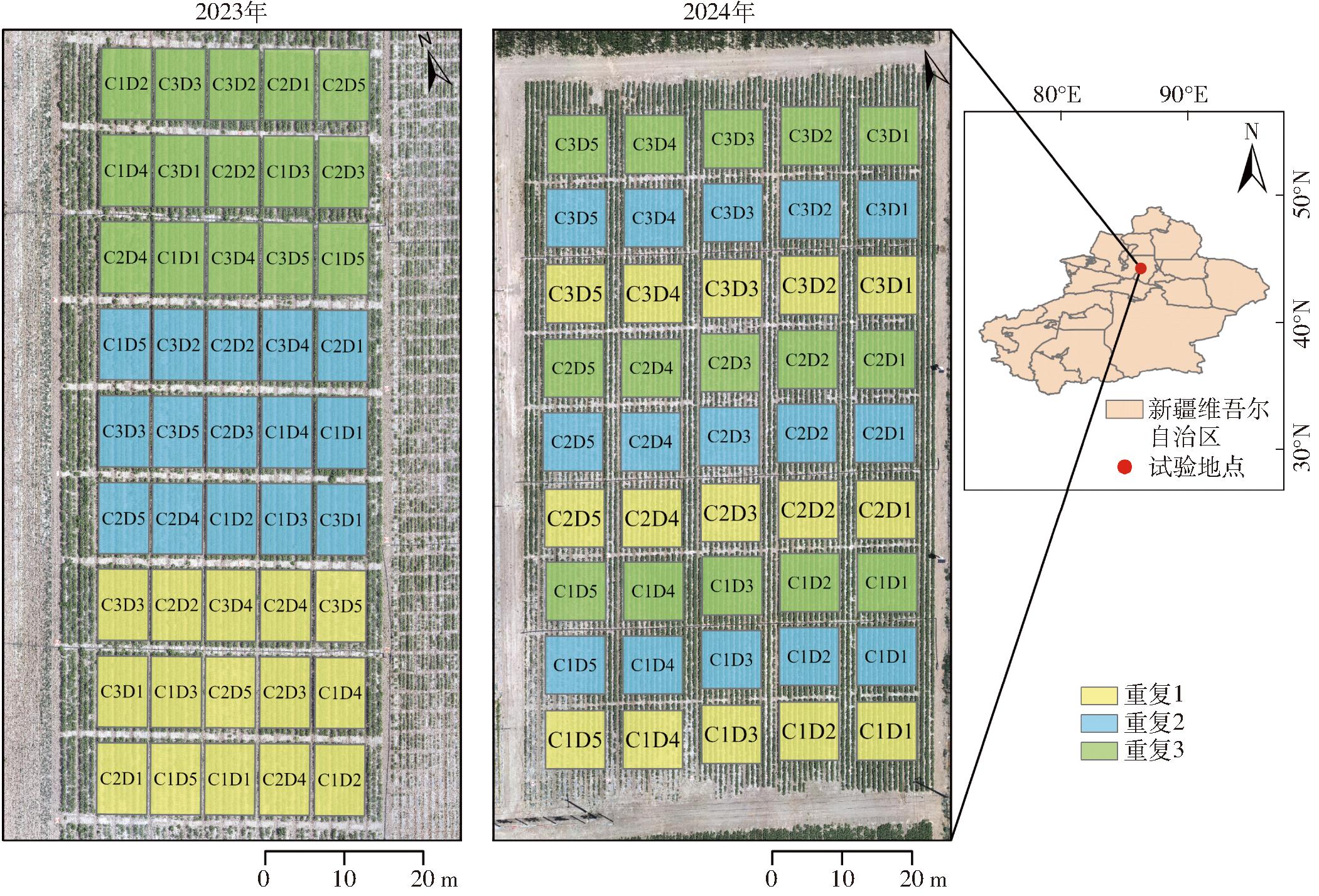

试验于2023年和2024年的4—10月在新疆维吾尔自治区昌吉回族自治州玛纳斯县新疆农科院玛纳斯试验站(44°18′13.91″N,86°13′11.03″E)开展,两年的试验地块距离约为200 m。试验采用1膜6行的宽窄行(行距10 cm+66 cm)种植模式,膜宽2.05 m,设置3个品种(C1:新农大1号,C2:新陆早73,C3:欣试518)、5个密度梯度(D1:270 000株/hm2,株距9.50 cm;D2:225 000株/hm2,株距11.50 cm;D3:180 000株/hm2,株距14.60 cm;D4:135 000株/hm2,株距19.50 cm;D5:90 000株/hm2,株距29.00 cm),每个处理设置3个重复。试验区各小区的施氮量和灌水量与当地农户基本一致。具体研究区概况如图2所示。

图2 研究区概况及试验设计

Fig.2 Overview of study area and experimental design

2023年和2024年分别获取了当年45个小区的理论产量,共计90个产量数据。在每个小区各取6.67 m2作为测产区域,统计该区域中的棉铃数。每个小区在收获期收取100个棉铃晒干后计算平均单铃质量。最终产量计算公式为

Y=1 500NW

(1)

式中 Y——籽棉产量,kg/hm2

N——棉铃数量

W——平均单铃质量,kg

本试验使用大疆M300 RTK型无人机,搭载大疆禅思P1型相机、Micasense Rededge MX型相机和大疆禅思L1型激光雷达分别获取试验区域的RGB、MS图像和点云数据。其中RGB图像包含红、绿、蓝3个波段,MS图像包含蓝、绿、红、红边以及近红外5个波段。遥感数据采集生育时期分别为现蕾期(S1)、初花期(S2)、盛花期(S3)、花铃期(S4)和吐絮期(S5)。数据采集时,UAV飞行的旁向和航向重叠率分别为75%和80%,飞行高度为30 m,飞行速度为2.2 m/s。在每次飞行前拍摄反射率校准板,用于MS图像辐射校准。在试验区内放置多个标记作为地面控制点,用于地理配准。RGB和MS图像数据的正射影像使用软件Agisoft PhotoScan(版本1.4.5,Agisoft LLC,俄罗斯)生成。点云数据使用软件DJI Terra(DJI科技有限公司)处理。使用软件ArcGIS(版本10.8,ESRI公司,美国)对在不同时间获得的正射图像进行地理配准,以便消除位置位移,对准图像。

1.4.1 冠层纹理信息

多种纹理特征计算方法被用于图像分类、森林生物量估算、作物产量估算等研究[23],本研究选用较为常用的灰度共生矩阵(Gray level co-occurrence matrix,GLCM)[24]来评估纹理特征在作物产量估算方面的潜力。使用软件ENVI(版本5.6,ESRI公司,美国)提取了RGB和MS图像所有8个波段,每个波段各8种纹理特征,即均值(Mean)、角二阶矩(Second_momen)、熵(Entropy)、对比度(Contrast)、相关性(Correlation)、均匀性(Homogeneity)、方差(Variance)和异质性(Dissimilarity),作为模型输入特征。

1.4.2 冠层光谱信息

为了消除土壤背景对于植被反射率的影响,使用植被指数阈值去除土壤背景,根据前人研究,将MS图像中NDVI值小于0.4的像素以及RGB图像CIVE值大于18.10的像素识别为土壤[17]。选取30个常用于作物产量估算的光谱植被指数,分别为15个MS植被指数,包括花青素反射指数_2(ARI_2)[25]、大气阻抗植被指数(ARVI)[26]、绿色叶绿素指数(CI_G)[27]、绿色归一化差异植被指数(GNDVI)[23]、增强植被指数(EVI)[28]、修正归一化差异植被指数(mNDVI)[29]、修正土壤调整植被指数(MSAVI)[30]、归一化差异植被指数(NDVI)[23]、红边归一化差异植被指数(NDVI_RE)[23]、优化土壤调节植被指数(OSAVI)[23]、红绿比率指数(RGRI)[31]、结构不敏感色素指数(SIPI)[32]、简单比值反射率指数(SR)[33]、简单比率植被指数(SRVI)[34]和土壤调整植被指数指数(SAVI)[17],以及15个RGB植被指数,包括归一化红色、绿色、蓝色波段(RN、GN、BN)[35]、植被颜色指数(CIVE)[17]、过量红色植被指数(ExR)[35]、过量绿色植被指数(ExG)[35]、过量蓝色植被指数(ExB)[35]、过量绿色减过量红色指数(ExGR)[35]、绿色与蓝色比率指数(GBRI)[17]、绿色与红色比率指数(GRRI)[17]、绿度指数(GLI)[17]、绿度比值植被指数(GRVI)[17]、归一化差异指数(NDI)[17]、红蓝比率指数(RBRI)[17]和可见光大气阻抗指数(VARI)[17]。

1.4.3 冠层结构信息

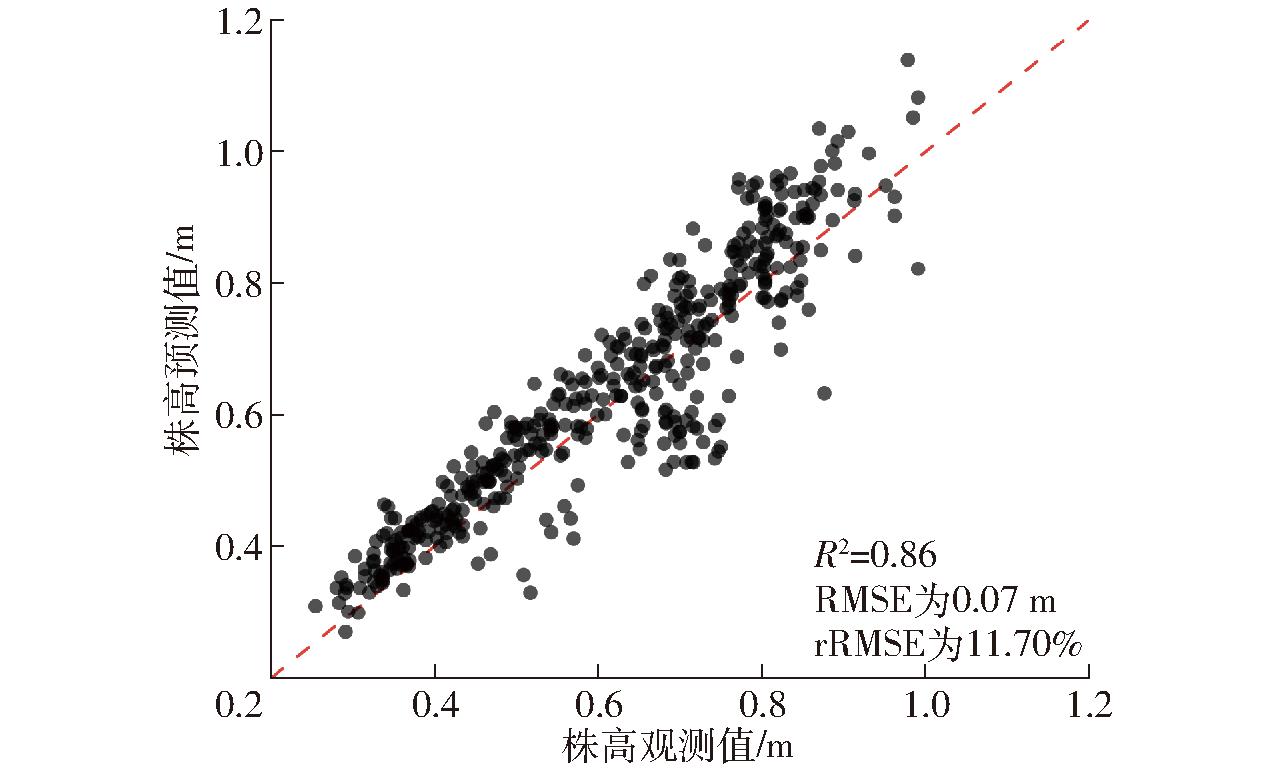

棉花作物冠层较为茂密,LiDAR采集到的地面点较少,为保证精度,使用播种前采集的LiDAR点云数据生成了裸地的数字高程模型(Digital elevation model,DEM)[36]。使用各生育期采集的LiDAR点云数据生成了地面和冠层数字表面模型(Digital surface model,DSM)。由DSM与DEM逐像素相减得到冠层高度模型(Canopy height model,CHM),其中像素的值表示像素对应的冠层高度。在每次LiDAR数据获取的当天测量每个处理小区3个冠层高度,取平均值后作为小区冠层高度观测值。共450个观测值用于评估CHM估算棉花株高(Plant height,PH)的准确性。根据文献[37],使用小区内CHM值的第91~100分位数分别与株高观测值进行拟合,最终确定第95分位值精度最高(图3)。

图3 基于CHM的棉花株高估算精度

Fig.3 Estimation accuracy of cotton plant height based on CHM

植被覆盖度(VF),即单位地面面积上的植被面积百分比,作为反映作物生长状况的重要指标,常用于作物性状估计[38]。通过1.4.2节中建立的CIVE植被指数阈值掩膜提取RGB图像中的植被像素,然后将每个小区植被像素数除以该小区总像素数得出VF。VF计算公式为

(2)

式中 DVF——植被覆盖度

Ncp——小区图像植被像素数

N——小区图像像素总数

1.5.1 相关性分析

在建立模型前,对各生育时期提取的光谱植被指数与产量的相关性进行研究,使用SPSS 26.0进行相关性分析,以确定产量估算最佳生育时期。采用皮尔逊相关系数(r)及其绝对值(|r|)作为光谱植被指数与产量之间相关性的评价指标。

1.5.2 模型构建

将数据集分为训练集和测试集,对应的训练集和测试集按照7∶3进行划分,并利用五折交叉验证来减少因数据集划分造成的模型精度误差。使用Scikit-Learn 1.3.2以及XGBoost 2.0.3包中的机器学习函数在Python 3.8.17环境中构建模型。利用网格搜索调参方法微调模型的超参数,以达到最佳训练效果。使用Python标准库中的time模块记录模型训练时间以反映机器学习模型的复杂程度。训练模型使用的工作站配置如下:CPU为英特尔酷睿i9-13900K,GPU为Nvidia GeForce RTX 4090,内存为128 GB。

PLSR是一种基于线性回归模型的改进方法,可以有效处理自变量之间的共线性问题,同时对于非线性关系也有一定的适用性[39]。本研究中使用Scikit-Learn 1.3.2中的PLSRegression函数,设置n_components为9,其余参数为默认值,在Python 3.8.17环境中进行棉花估产模型的构建。

RFR为一种基于集成学习的回归方法,其特点是构建多个独立的决策树,并将每个决策树的结果进行集成。这些决策树会选择不同的特征子集和数据子集,因此可以减少过拟合风险并提升鲁棒性[40]。使用Scikit-Learn 1.3.2中的RandomForestRegressor函数,利用GridSearchCV函数进行网格寻参,得到了最佳超参数组合:n_estimators为13,max_depth为5,min_samples_split为6,其余参数为默认值,在Python 3.8.17环境中进行棉花估产模型的构建。

XGBoost是经过优化的分布式梯度提升方法,对损失函数做了二阶泰勒展开,并在目标函数中加入了正则项,具有拟合精度高、泛化性好等特点[41]。使用XGBoost 2.0.3中的XGBRegressor函数,利用GridSearchCV函数进行网格寻参,得到了最佳的超参数组合:n_estimators为100,max_depth为2,learning_rate为0.05,subsample为0.8,其余参数为默认值。在Python 3.8.17环境中进行棉花估产模型的构建。

1.5.3 评价指标

由于机器学习属于黑盒模型,在实际应用中,其复杂度一般与训练时间呈正相关[42]。因此,本研究使用模型训练时间(ms)量化模型复杂度。

使用决定系数(R2)、均方根误差(RMSE)和相对均方根误差(rRMSE)评价产量估算模型性能。

1.5.4 特征重要性分析

由于机器学习模型本身属于黑盒模型,用户难以理解其内部决策过程,因此模型的可解释性通常较差。SHAP是一种模型可解释性分析工具,可以计算每个特征对模型估算结果的贡献,增强模型可解释性[22]。

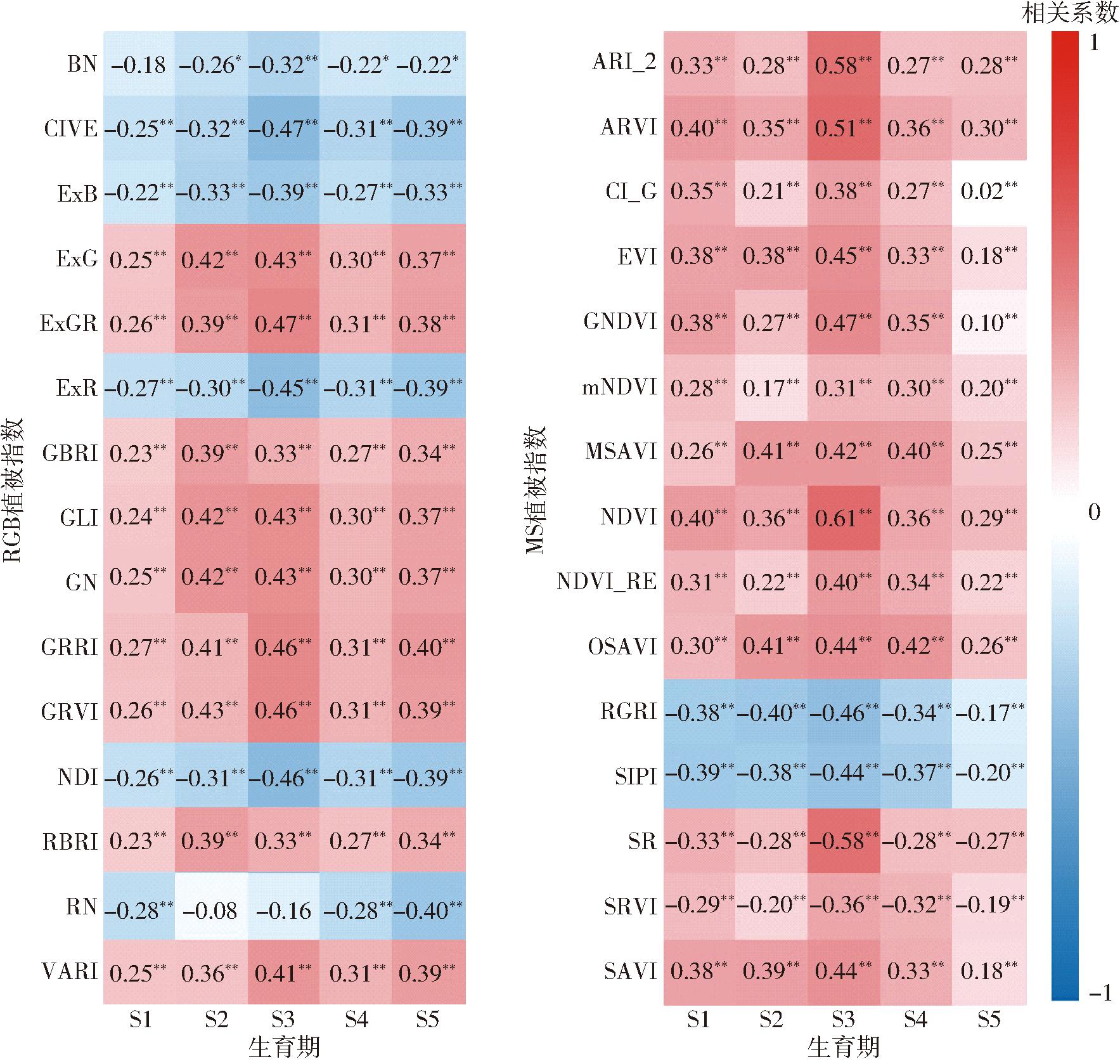

将基于RGB和MS传感器的5 个采样时期的光谱植被指数与产量做相关性分析,结果如图4(图中,*表示相关系数在0.05水平下显著,**表示相关系数在0.01水平下显著)所示。与产量相关性最高的RGB植被指数为ExGR,5个生育时期相关系数最高为0.47。RGB指数相关系数在S3时期最高,除RBRI和RN外,S3时期所有RGB植被指数与产量的相关系数均高于其他4个时期。与产量相关系数最高的MS植被指数为NDVI,5个生育时期相关系数最高为0.61。从图4可以看出,S3时期获取的MS植被指数与产量的相关性均优于其他时期,整体上呈随生育时期先上升后下降的趋势。

图4 不同时期光谱植被指数与产量的相关性

Fig.4 Correlation between spectral vegetation index and yield at different periods

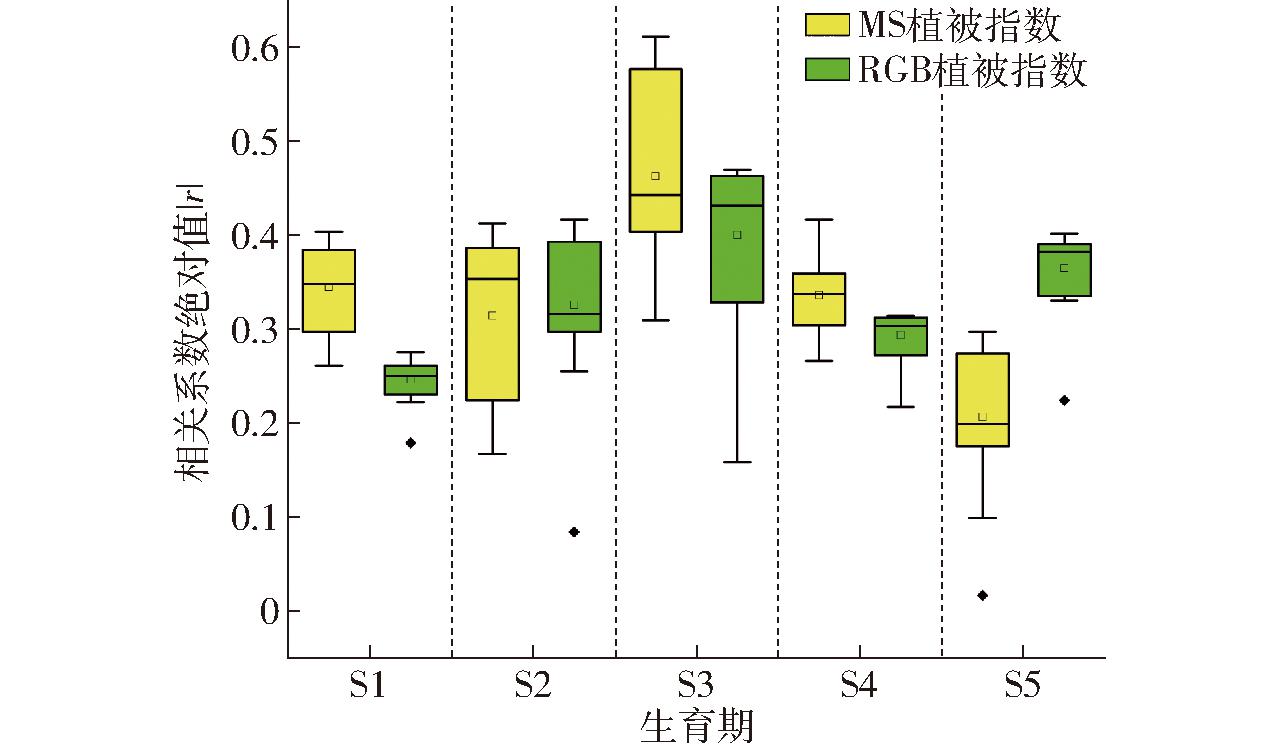

图5展示了每个采样时期植被指数与产量相关性绝对值的箱线图,从图5可以看出,2类光谱植被指数在S3时期相关系数的绝对值高于其他时期,MS植被指数尤为明显。在S3时期,大多数光谱植被指数与产量间呈现出显著的相关性(在0.01水平上显著)。因此,将基于S3时期UAV影像提取的指标作为模型的输入特征。

图5 各个时期植被指数与产量相关系数的绝对值

Fig.5 Absolute correlation coefficients between vegetation index and yield at different periods

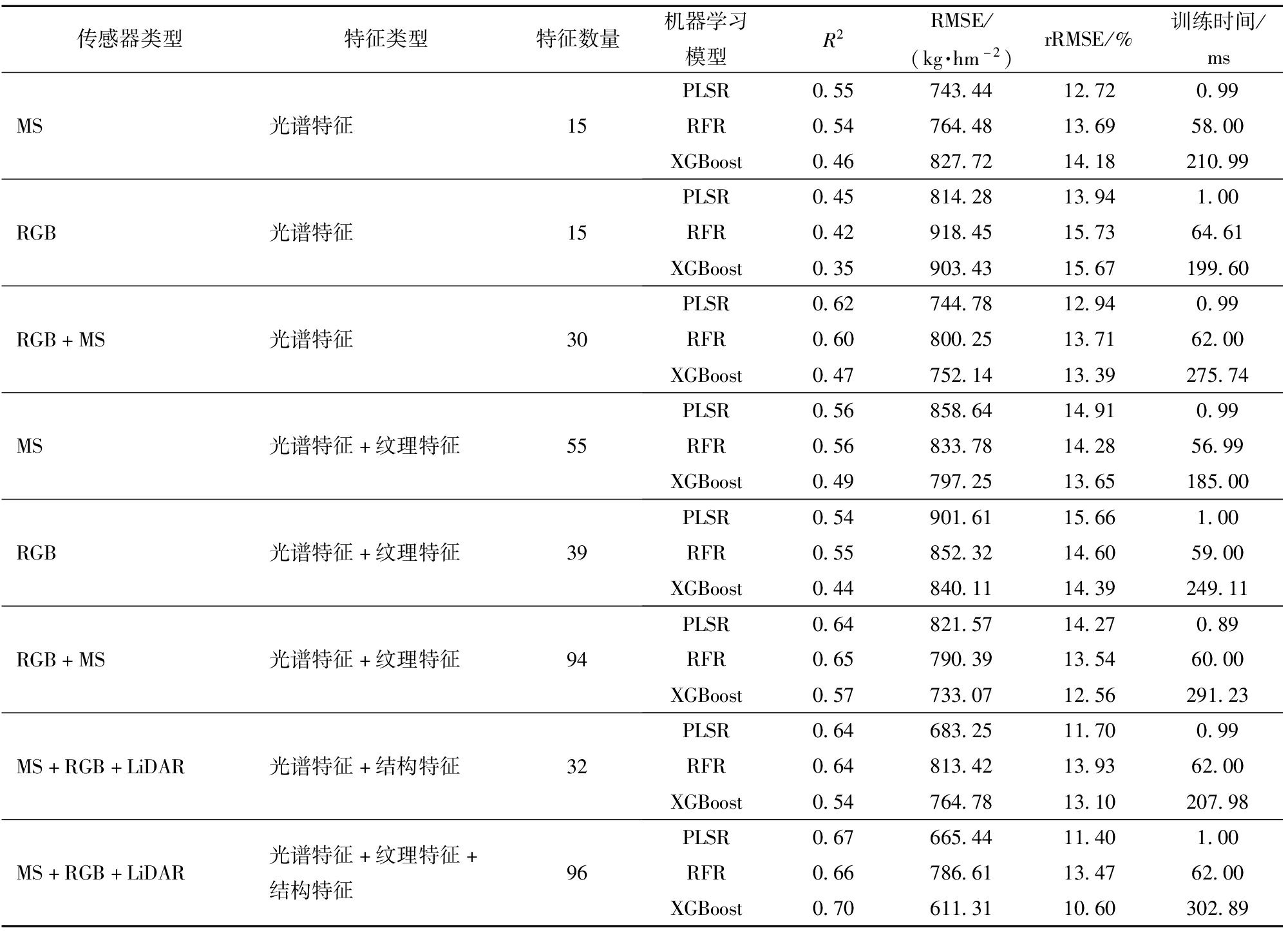

将2.1节得出的棉花产量估算最佳生育期,即S3时期提取的特征作为输入,使用PLSR、RF和XGBoost 3种机器学习方法估算棉花产量。为了对比和探索单一的RGB或MS传感器在产量估算中的性能,先分别将2类光谱植被指数单独作为输入特征进行训练,然后将基于单一传感器提取的植被指数和纹理特征作为输入特征进行训练,最后将基于多个传感器的植被指数、纹理特征、冠层结构进行组合,探究各类特征对于产量估算的效果,并对模型进行评估。模型R2、RMSE、rRMSE以及训练时间如表1所示。在3种机器学习模型中,MS植被指数表现均优于RGB植被指数;而使用2类光谱植被指数共同作为特征输入时,模型的精度高于单独使用单一光谱植被指数。此外,在光谱指数的基础上加入纹理特征与冠层结构信息可以有效提升3种模型的估算精度。在使用光谱指数与纹理特征共同建立模型时,基于MS传感器提取的特征相较于基于RGB传感器提取的特征表现更好。当使用基于多种传感器提取的特征共同作为输入特征时,模型精度优于单一传感器。例如,使用基于RGB和MS相机2种传感器的光谱指数与纹理特征共同建模,模型精度优于单一传感器;使用基于RGB、MS相机和LiDAR 3种传感器提取的光谱指数、纹理特征与冠层结构共同建立模型时,模型精度达到最佳。不同机器学习模型训练时间有明显差异,PLSR模型各组输入特征训练时间在1 ms左右,RFR模型训练时间大约为60 ms,XGBoost模型训练时间相对较长,为185~302.89 ms不等。不同输入特征对RFR和XGBoost模型训练时间具有一定影响,总体而言,输入特征数量越多,模型训练时间越长。

表1 不同产量估算模型性能统计

Tab.1 Performance statistics of different yield estimation models

传感器类型特征类型特征数量机器学习模型R2RMSE/(kg·hm-2)rRMSE/%训练时间/msMS光谱特征15PLSR0.55743.4412.720.99RFR0.54764.4813.6958.00XGBoost0.46827.7214.18210.99RGB光谱特征15PLSR0.45814.2813.941.00RFR0.42918.4515.7364.61XGBoost0.35903.4315.67199.60RGB+MS光谱特征30PLSR0.62744.7812.940.99RFR0.60800.2513.7162.00XGBoost0.47752.1413.39275.74MS光谱特征+纹理特征55PLSR0.56858.6414.910.99RFR0.56833.7814.2856.99XGBoost0.49797.2513.65185.00RGB光谱特征+纹理特征39PLSR0.54901.6115.661.00RFR0.55852.3214.6059.00XGBoost0.44840.1114.39249.11RGB+MS光谱特征+纹理特征94PLSR0.64821.5714.270.89RFR0.65790.3913.5460.00XGBoost0.57733.0712.56291.23MS+RGB+LiDAR光谱特征+结构特征32PLSR0.64683.2511.700.99RFR0.64813.4213.9362.00XGBoost0.54764.7813.10207.98MS+RGB+LiDAR光谱特征+纹理特征+结构特征96PLSR0.67665.4411.401.00RFR0.66786.6113.4762.00XGBoost0.70611.3110.60302.89

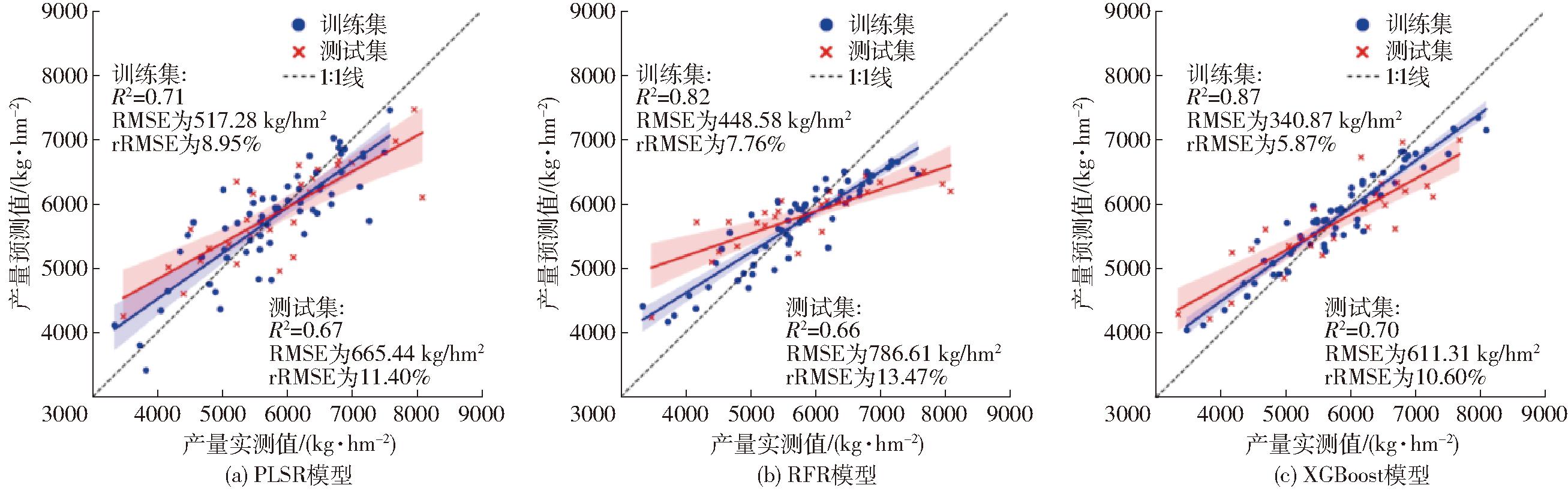

使用散点图将每种机器学习方法得出的最佳预测值与相对应的观测值进行比较(图6)。XGBoost模型效果最好,其R2为0.70,并且RMSE和rRMSE在3种模型中最低,分别为611.31 kg/hm2和10.60%。PLSR模型和RFR模型精度略低于XGBoost模型,R2分别为0.67和0.66,RMSE分别为665.44 kg/hm2和786.61 kg/hm2,rRMSE分别为11.40%和13.47%。

图6 模型预测值与实测值的散点图

Fig.6 Scatter plot of model predicted and measured values

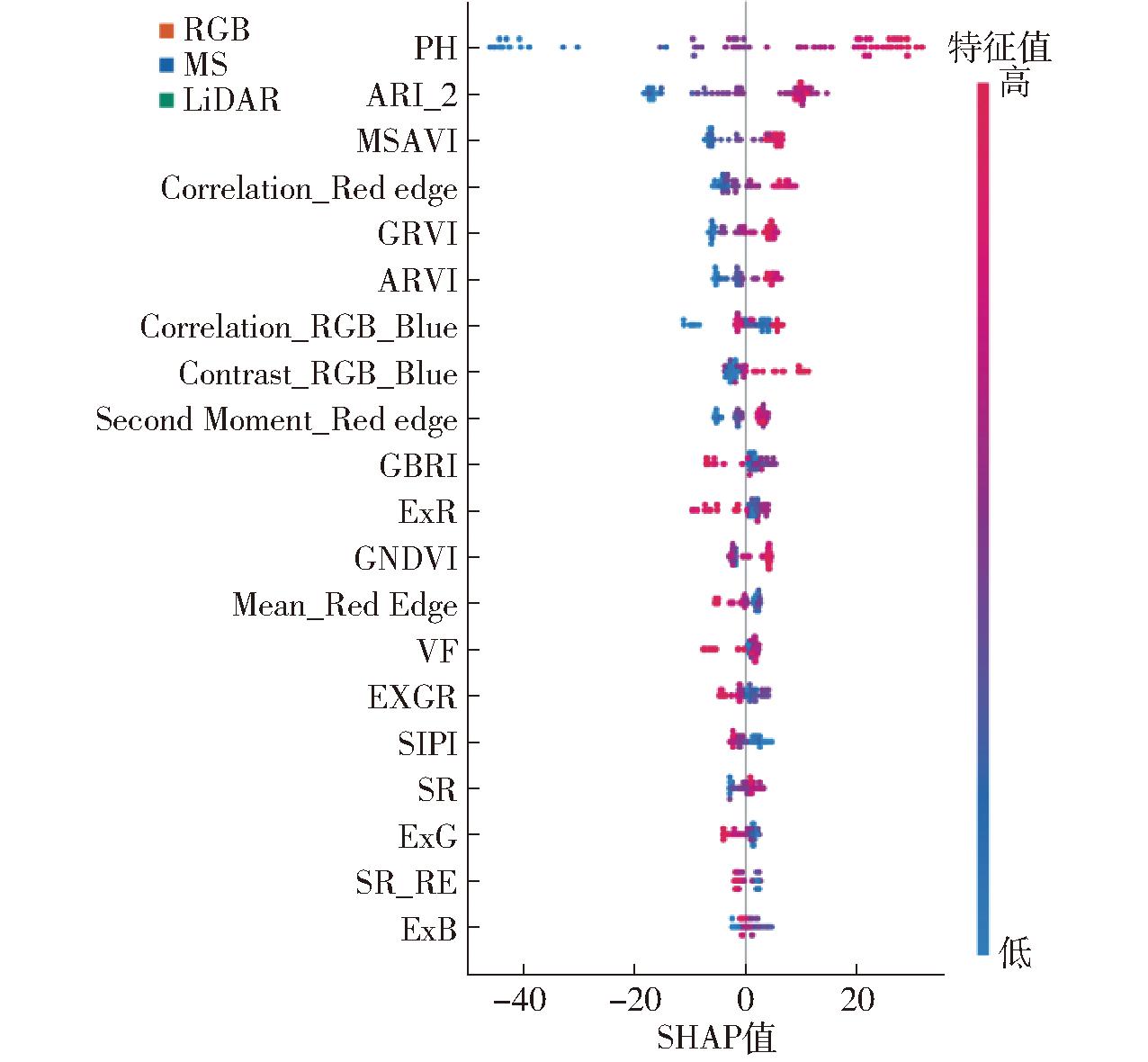

使用SHAP工具中的摘要图,基于2.2节得出的最佳产量估算模型,即XGBoost,得出了前20位特征贡献度排序(图7)。图中SHAP值表示特征对于模型结果的影响力,正值为正向影响,负值为负向影响;特征值表示特征数值大小。图中每个点都表示一个样本所对应特征数值,点的颜色反映数值大小,红色表示高值,蓝色表示低值;点的位置反映了此样本特征的SHAP值,离中轴越远,SHAP值绝对值越大,则表明其对模型结果的影响力越大。其中,贡献度最高的20个特征中,有9个来自RGB数据,10个来自MS数据,1个来自LiDAR数据,其中包括13个光谱特征、5个纹理特征和2个冠层结构特征。2种冠层结构特征(PH和VF)贡献度在全部96个特征中分别排名第1和第14。PH特征值与其对模结果的影响力呈现明显的正向相关,VF则随着特征值的增高,先对模型结果产生更高的正向影响,在达到某一阈值后,反而对模型结果产生负向影响。此外,基于RGB蓝(Blue)波段的2种纹理特征和基于MS红边(Red edge)波段的3种纹理特征在图中排名较高。

图7 SHAP分析摘要图

Fig.7 SHAP analysis summary plot

通过皮尔逊相关性分析发现,盛花期植被指数与产量的相关性高于其他时期。刘焕军等[43]建立了基于时间序列Landsat影像的棉花估产模型,研究发现花铃期的植被指数与产量相关性最高。本研究在此基础上将花铃期进一步细分为初花期、盛花期和铃期,确定了盛花期是棉花产量估算的最佳生育时期。在其他作物的产量估算研究中,盛花期也是较为重要的生育时期,例如张斌斌等[44]在马铃薯产量估算研究中发现,基于盛花期无人机数据的产量估算效果优于其他生育时期和全生育期;REN等[45]利用3个关键生育期的无人机数据建立了大豆产量估算模型,发现盛花期是最佳的产量预测时期。由于盛花期是大多数作物生长发育最为旺盛的时期,在这个阶段,植物的营养生长和生殖生长并进,吸收养分的能力达到高峰,据此推断,盛花期是棉花以及大多数开花作物产量估算的关键生育时期。

通过比较基于RGB和MS传感器数据的建模结果发现,3种模型中,基于MS传感器数据的模型性能均略好于基于RGB传感器数据的模型性能,并且将2种传感器提取的特征同时作为输入特征对于模型性能也有一定程度的提升,这一结果与MAIMAITIJIANG等[23]的研究结果一致。产量估算精度最高的模型是XGBoost。但输入特征量较少时,XGBoost的精度较差。这可能是由于XGBoost更适用于回归模型较为复杂的情况和数据量较大的场景,在特征数量较少时无法发挥模型潜力[41]。由于PLSR属于线性回归模型,模型复杂度远低于其他2种模型,因此训练时间最短[46]。RFR和XGBoost模型同属于基于树的集成学习模型,其模型复杂度与模型中树的数量息息相关[47],而RFR模型中树的数量较少,因此复杂度低于XGBoost模型。虽然3种机器学习模型的训练时间有明显的差异,但在田块尺度作物产量估算的应用环境下,毫秒级的训练时间足以满足实际应用需求。并且可以预见,即使样本和特征数量增加数倍,或使用计算资源有限的平台,也可以在短时间内完成模型的训练。因此,本研究建议在大田尺度下应当尽可能选择精度最高的XGBoost模型来估算作物的产量。

将纹理特征与光谱植被指数相结合,可以有效提升机器学习模型对棉花产量估算的精度。这可能是因为在使用来自光谱信息的植被指数估计作物性状时,传感器往往会受到光谱渐进饱和问题的影响[48],无法准确测量光谱信息,这在冠层密度高的作物中较为常见[39]。纹理特征可以反映作物冠层结构和几何特征[49],并且其依赖于图像中像素灰度的空间变化,不易受到光谱渐进饱和问题影响[15]。冠层结构信息对于产量估算模型贡献度较高。虽然棉花打顶后植株基本不再长高,但其冠层高度仍然可以反映植株在生长发育前期尤其是营养生长阶段的生长状况。特征重要性排名前5位分别为PH、ARI_2、MSAVI、Correlation_Red edge和GRVI,其中包含本研究所涉及3类特征。这说明在作物产量估算中,光谱特征、冠层结构、纹理特征都具有较大潜力。基于多个传感器提取的光谱、冠层结构和纹理特征等信息的组合,具有提升作物性状指标估计精度的潜力,多源传感器的融合数据能提供比单一数据源更高的估算精度,这与前人研究结果[20,23]一致。不同波段和类型的纹理特征对模型结果的贡献度是不同的,本研究发现,RGB蓝色和MS红边波段提取的纹理特征对模型贡献度较高,但是对于其他波段纹理的特征贡献度未进行比较和分析,不同波段和空间分辨率对于纹理特征贡献度的影响尚不明确。在今后研究中,可以将不同分空间辨率和波段的纹理特征进行对比,以深入发掘纹理特征在棉花产量估算中的潜力。此外,进一步加强模型多生态站点优化和验证工作。

使用基于RGB、MS和LiDAR 3种传感器获取的光谱特征、冠层结构、纹理特征3类共96个特征指标,使用PLSR、RFR和XGBoost 3种机器学习方法估算棉花产量,通过相关性分析发现,盛花期为棉花产量估算最佳生育时期;在对比基于RGB和MS数据提取的特征时,基于MS数据提取的特征建模结果更好。同时将2种传感器数据提取的特征作为输入时,模型结果高于单一传感器。在光谱特征的基础上加入纹理特征和冠层结构特征可以提高产量估算精度。棉花产量估算最佳模型为XGBoost(R2为0.70,RMSE为611.31 kg/hm2,rRMSE为10.60%),其精度高于PLSR与RFR模型。在特征重要性方面,基于3种传感器的3类特征信息在产量估算方面都具有重要意义,纹理特征与冠层结构展现出了较大的潜力。

[1] 徐伟诚.基于无人机遥感影像的棉花单铃重、产量及纤维品质预测模型构建[D].广州:华南农业大学,2021.

[2] 刘文静,范永胜,董彦琪,等.我国棉花生产现状分析及建议[J].中国种业,2022(1):21-25.LIU Wenjing,FAN Yongsheng,DONG Yanqi,et al.Analysis and suggestions on the current situation of cotton production in China[J].China Seed Industry,2022(1):21-25.(in Chinese)

[3] TAO H Y,XU S,TIAN Y C,et al.Proximal and remote sensing in plant phenomics:20 years of progress,challenges,and perspectives[J].Plant Communications,2022,3(6):39.

[4] 向友珍,安嘉琪,赵笑,等.基于无人机多光谱遥感的大豆生长参数和产量估算[J].农业机械学报,2023,54(8):230-239.XIANG Youzhen,AN Jiaqi,ZHAO Xiao,et al.Soybean growth parameters and yield estimation based on UAV multispectral remote sensing[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(8):230-239.(in Chinese)

[5] 朱志畅,葛焱,臧晶荣,等.基于无人机图像和SHAP特征筛选的小麦田间产量预测方法研究[J].麦类作物学报,2024,45(2):264-274.ZHU Zhichang,GE Yan,ZANG Jingrong,et al.Research on wheat yield prediction based on UAV imagery and SHAP feature selection[J].Journal of Triticeae Crops,2024,45(2):264-274.(in Chinese)

[6] 郭燕,井宇航,贺佳,等.基于无人机影像多源信息的冬小麦生物量与产量估算[J].河南农业科学,2023,52(12):149-161.GUO Yan,JING Yuhang,HE Jia,et al.Winter wheat aboveground biomass and yield estimation based on multi-source information from UAV imagery[J].Journal of Henan Agricultural Sciences,2023,52(12):149-161.(in Chinese)

[7] 张少华,段剑钊,贺利,等.基于无人机平台多模态数据融合的小麦产量估算研究[J].作物学报,2022,48(7):1746-1760.ZHANG Shaohua,DUAN Jianzhao,HE Li,et al.Wheat yield estimation from UAV platform based on multi-modal remote sensing data fusion[J].Acta Agronomica Sinica,2022,48(7):1746-1760.(in Chinese)

[8] 刘照,李华朋,陈慧,等.基于时序影像及不同模型的玉米早期估产研究[J].光谱学与光谱分析,2023,43(8):2627-2637.LIU Zhao,LI Huapeng,CHEN Hui,et al.Maize yield forecasting and associated optimum lead time research based on temporal remote sensing data and different model[J].Spectroscopy And Spectral Analysis,2023,43(8):2627-2637.(in Chinese)

[9] LI Z,TAYLOR J,YANG H,et al.A hierarchical interannual wheat yield and grain protein prediction model using spectral vegetative indices and meteorological data[J].Field Crops Research,2020,248:107711.

[10] JIN X,LI Z,YANG G,et al.Winter wheat yield estimation based on multi-source medium resolution optical and radar imaging data and the AquaCrop model using the particle swarm optimization algorithm[J].ISPRS Journal of Photogrammetry &Remote Sensing,2017,126:24-37.

[11] 程志强,蒙继华.作物单产估算模型研究进展与展望[J].中国生态农业学报,2015,23(4):402-415.CHENG Zhiqiang,MENG Jihua.Research advances and perspectives on crop yield estimation models[J].Chinese Journal of Eco-Agriculture,2015,23(4):402-415.(in Chinese)

[12] 朱艳,汤亮,刘蕾蕾,等.作物生长模型(CropGrow)研究进展[J].中国农业科学,2020,53(16):3235-3256.ZHU Yan,TANG Liang,LIU Leilei,et al.Research progress on the crop growth model CropGrow[J].Scientia Agricultura Sinica,2020,53(16):3235-3256.(in Chinese)

[13] PERROS N,KALIVAS D,GIOVOS R.Spatial analysis of agronomic data and UAV imagery for rice yield estimation[J].Agriculture,2021,11(9):809.

[14] 郑恒彪,吉文翰,郭彩丽,等.无人机遥感作物估产研究进展[J].南京农业大学学报,2025,48(1):1-13.ZHENG Hengbiao,JI Wenhan,GUO Caili,et al.Research progress in crop yield estimation using unmanned aerial vehicle-based remote sensing[J].Journal of Nanjing Agricultural University,2025,48(1):1-13.(in Chinese)

[15] MA Y,MA L,ZHANG Q,et al.Cotton yield estimation based on vegetation indices and texture features derived from RGB image[J].Frontiers in Plant Science,2022,13:925986.

[16] FENG A J,ZHOU J F,VORIES E D,et al.Yield estimation in cotton using UAV-based multi-sensor imagery[J].Biosystems Engineering,2020,193:101-114.

[17] MENG L,YIN D M,CHENG M H,et al.Improved crop biomass algorithm with piecewise function (iCBA-PF) for maize using multi-source UAV data[J].Drones,2023,7(4):24.

[18] LIU Z H,JI Y S,YA X X,et al.Ensemble learning for pea yield estimation using unmanned aerial vehicles,red green blue,and multispectral imagery[J].Drones,2024,8(6):227.

[19] PRANGA J,BORRA-SERRANO I,APER J,et al.Improving accuracy of herbage yield predictions in perennial ryegrass with UAV-based structural and spectral data fusion and machine learning[J].Remote Sensing,2021,13(17):3459.

[20] MA J C,LIU B H,JI L,et al.Field-scale yield prediction of winter wheat under different irrigation regimes based on dynamic fusion of multimodal UAV imagery[J].International Journal of Applied Earth Observation and Geoinformation,2023,118:103292.

[21] LUNDBERG S M,ERION G,CHEN H,et al.From local explanations to global understanding with explainable AI for trees[J].Nature Machine Intelligence,2020,2(1):56-67.

[22] LUNDBERG S M,LEE S I.A unified approach to interpreting model predictions[C]∥31st Annual Conference on Neural Information Processing Systems (NIPS),2017.

[23] MAIMAITIJIANG M,SAGAN V,SIDIKE P,et al.Soybean yield prediction from UAV using multimodal data fusion and deep learning[J].Remote Sensing of Environment,2020,237:111599.

[24] HARALICK R M,SHANMUGAM K,DINSTEIN I.Textural features for image classification[J].Studies in Media and Communication,1973,SMC-3(6):610-621.

[25] GITELSON A A,KEYDAN G P,MERZLYAK M N.Three-band model for noninvasive estimation of chlorophyll,carotenoids,and anthocyanin contents in higher plant leaves[J].Geophysical Research Letters,2006,33(11):5.

[26] 丁永军,李民赞,安登奎,等.基于光谱特征参数的温室番茄叶片叶绿素含量预测[J].农业工程学报,2011,27(5):244-247.DING Yongjun,LI Minzan,AN Dengkui,et al.Prediction of chlorophyll content using spectral response characteristics of greenhouse tomato[J].Transactions of the CSAE,2011,27(5):244-247.(in Chinese)

[27] GITELSON A A,GRITZ Y,MERZLYAK M N.Relationships between leaf chlorophyll content and spectral reflectance and algorithms for non-destructive chlorophyll assessment in higher plant leaves[J].Journal of Plant Physiology,2003,160(3):271-282.

[28] 刘珺,庞鑫,李彦荣,等.夏玉米叶面积指数遥感反演研究[J].农业机械学报,2016,47(9):309-317.LIU Jun,PANG Xin,LI Yanrong,et al.Inversion study on leaf area index of summer maize using remote sensing[J].Transactions of the Chinese Society for Agricultural Machinery,2016,47(9):309-317.(in Chinese)

[29] 贺佳,刘冰锋,李军.不同生育时期冬小麦叶面积指数高光谱遥感监测模型[J].农业工程学报,2014,30(24):141-150.HE Jia,LIU Bingfeng,LI Jun.Monitoring model of leaf area index of winter wheat based on hyperspectral reflectance at different growth stages[J].Transactions of the CSAE,2014,30(24):141-150.(in Chinese)

[30] 牛亚晓,张立元,韩文霆,等.基于无人机遥感与植被指数的冬小麦覆盖度提取方法[J].农业机械学报,2018,49(4):212-221.NIU Yaxiao,ZHANG Liyuan,HAN Wenting,et al.Fractional vegetation cover extraction method of winter wheat based on UAV remote sensing and vegetation index[J].Transactions of the Chinese Society for Agricultural Machinery,2018,49(4):212-221.(in Chinese)

[31] 张智韬,许崇豪,谭丞轩,等.覆盖度对无人机热红外遥感反演玉米土壤含水率的影响[J].农业机械学报,2019,50(8):213-225.ZHANG Zhitao,XU Chonghao,TAN Chengxuan,et al.Influence of coverage on soil moisture content of field corn inversed from thermal infrared remote sensing of UAV[J].Transactions of the Chinese Society for Agricultural Machinery,2019,50(8):213-225.(in Chinese)

[32] NIKROOZ B.Application of aerial remote sensing technology for detection of fire blight infected pear trees[J].Computers and Electronics in Agriculture,2020,168:7.

[33] 陶惠林,徐良骥,冯海宽,等.基于无人机高光谱长势指标的冬小麦长势监测[J].农业机械学报,2020,51(2):180-191.TAO Huilin,XU Liangji,FENG Haikuan,et al.Monitoring of winter wheat growth based on UAV hyperspectral growth index[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(2):180-191.(in Chinese)

[34] AL-FANSHURI B,PRAYOGO C,SOEMARNO,et al.The reliability of unmanned aerial vehicles (UAVs) equipped with multispectral cameras for estimating chlorophyll content,plant height,canopy area,and fruit total number of lemons (Citrus Limon)[J].Sains Tanah,2023,20(2):221-230.

[35] KAWASHIMA S,NAKATANI M.An algorithm for estimating chlorophyll content in leaves using a video camera[J].Annals of Botany,1998,81(1):49-54.

[36] DUAN T,ZHENG B Y,GUO W,et al.Comparison of ground cover estimates from experiment plots in cotton,sorghum and sugarcane based on images and ortho-mosaics captured by UAV[J].Functional Plant Biology,2017,44(1):169-183.

[37] 王庆,车荧璞,柴宏红,等.基于无人机可见光与激光雷达的甜菜株高定量评估[J].农业机械学报,2021,52(3):178-184.WANG Qing,CHE Yingpu,CHAI Honghong,et al.Quantitative evaluation of sugar beet plant height based on UAV-RGB and UAV-LiDAR[J].Transactions of the Chinese Society for Agricultural Machinery,2021,52(3):178-184.(in Chinese)

[38] OGAWA D,SAKAMOTO T,TSUNEMATSU H,et al.Haplotype analysis from unmanned aerial vehicle imagery of rice MAGIC population for the trait dissection of biomass and plant architecture[J].Journal of Experimental Botany,2021,72(7):2371-2382.

[39] RISCHBECK P,ELSAYED S,MISTELE B,et al.Data fusion of spectral,thermal and canopy height parameters for improved yield prediction of drought stressed spring barley[J].European Journal of Agronomy,2016,78:44-59.

[40] SHU M,WANG Z,GUO W,et al.Effects of variety and growth stage on UAV multispectral estimation of plant nitrogen content of winter wheat[J].Agriculture,2024,14(10):1775.

[41] CHEN T Q,GUESTRIN C,ASSOC C M.XGBoost:a scalable tree boosting system[C]∥22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining (KDD),2016:785-794.

[42] HE K M,SUN J.Convolutional neural networks at constrained time cost[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2015:5353-5360.

[43] 刘焕军,孟令华,张新乐,等.基于时间序列Landsat影像的棉花估产模型[J].农业工程学报,2015,31(17):215-220.LIU Huanjun,MENG Linghua,ZHANG Xinle,et al.Estimation model of cotton yield with time series Landsat images[J].Transactions of the CSAE,2015,31(17):215-220.(in Chinese)

[44] 张斌斌,魏峭嵘,尹燕斌,等.基于无人机遥感影像的马铃薯产量估算[J].中国马铃薯,2023,37(6):498-513,535.ZHANG Binbin,WEI Qiaorong,YIN Yanbin,et al.Potato yield estimation based on UAV remote sensing images[J].Chinese Potato,2023,37(6):498-513,535.(in Chinese)

[45] REN P T,LI H L,HAN S Y,et al.Estimation of soybean yield by combining maturity group information and unmanned aerial vehicle multi-sensor data using machine learning[J].Remote Sensing,2023,15(17):4286.

[46] GELADI P,KOWALSKI B R.Partial least-squares regression:a tutorial[J].Analytica Chimica Acta,1986,185(1):1-17.

[47] CHRISTOPHER M B.Pattern recognition and machine learning[M].New York:Springer,2006.

[48] LU B,DAO P D,LIU J G,et al.Recent advances of hyperspectral imaging technology and applications in agriculture[J].Remote Sensing,2020,12(16):44.

[49] 周元琦,王敦亮,陈晨,等.基于无人机RGB图像颜色及纹理特征指数的小麦产量预测[J].扬州大学学报(农业与生命科学版),2021,42(3):110-116.ZHOU Yuanqi,WANG Dunliang,CHEN Chen,et al.Prediction of wheat yield based on color index and texture feature index of unmanned aerial vehicle RGB image[J].Journal of Yangzhou University (Agricultural and Life Sciences Edition),2021,42(3):110-116.(in Chinese)