植物表型是指植物对其基因型和生长环境所表现出的独特生理生化形态参数或性状[1]。在现代农业中,植物表型是分析单株生长发育的基础。实时监测和分析植物叶片形状、颜色和大小等表型参数,有助于检测病虫害、预测作物产量,选择优质作物品种[3]。传统表型参数获取方法依赖人工手动测量,耗费大量劳动和时间成本,且易受主观影响。一些性状衍生方法甚至对植物具有破坏性[4]。此前,基于二维图像的深度学习技术一直是植物器官分割问题的主要解决方案[5-6]。然而,基于二维图像的植物器官分割方法存在缺乏深度信息导致空间结构难以区分的缺陷。

近年来基于三维点云的植物器官分割逐步成为现代农业信息技术研究的热点问题[7]。基于三维点云的植物器官分割方法为自动、准确、无损、高通量测量植物形态表型参数提供了关键技术手段。文献[8-12]所述点云分割算法常需凭借经验手动设置参数和调整算法,自动化程度低,难以大规模应用;并且在处理复杂的植物形态时,很难保持稳定的性能。使用深度学习进行三维点云分割的优点显著,尤其在处理复杂三维结构和实现高精度分割任务方面具有独特优势[13]。因此随着深度学习技术的不断发展和硬件计算能力的提升,基于深度学习的植物点云器官分割成为当前的研究热点。目前分割方法主要分为基于多视图投影的方法[14-15]、基于体素化的方法[16]和基于点的直接处理方法[17-19]。

目前影响植物点云分割网络性能的因素包括3个方面:①大部分网络只是在特征空间对邻域信息进行聚合,而未考虑到坐标空间信息,未融合坐标空间信息会导致网络对植物局部几何结构理解不充分,进而引发分割精度和鲁棒性降低的问题。②在当前植物分割网络解码阶段,仅根据几何距离选择最近的一个点进行赋值,可能导致细节丢失或插值不准确。③过分聚焦局部特征,缺乏对全局信息的利用,可能导致网络对整体结构理解不足,无法识别植物器官边界和位置关系,导致分割不准确。

针对上述问题,本文提出一种基于注意力机制的植物三维点云语义分割网络,首先针对现有植物分割网络邻域特征提取不充分的缺陷,构建一个注意力局部(邻域)特征提取模块(Attention local feature extraction module,ALEFM)。为了使网络能够更好地理解和处理点云细节部分,在解码阶段提出一个双近邻插值上采样模块(Double nearest neighbor interpolation module,DNNIM)。提出多头空间自注意力模块(Multi-head spatial self-attention module,MHSSAM)和通道注意力模块(Channel attention module,CAM),以增强网络在空间和通道维度上提取全局信息的能力,以期实现植株语义分割。

为了评估所提出网络的分割性能,选择公开数据集Pheno4D[20]和Planest3D[21]进行训练和测试。Pheno4D数据集共有224个点云,在7株玉米和7株番茄植株第1次发芽后每天捕获得到这些点云。Planest3D数据集包含10株辣椒点云、10株玫瑰点云和14株红醋栗点云。

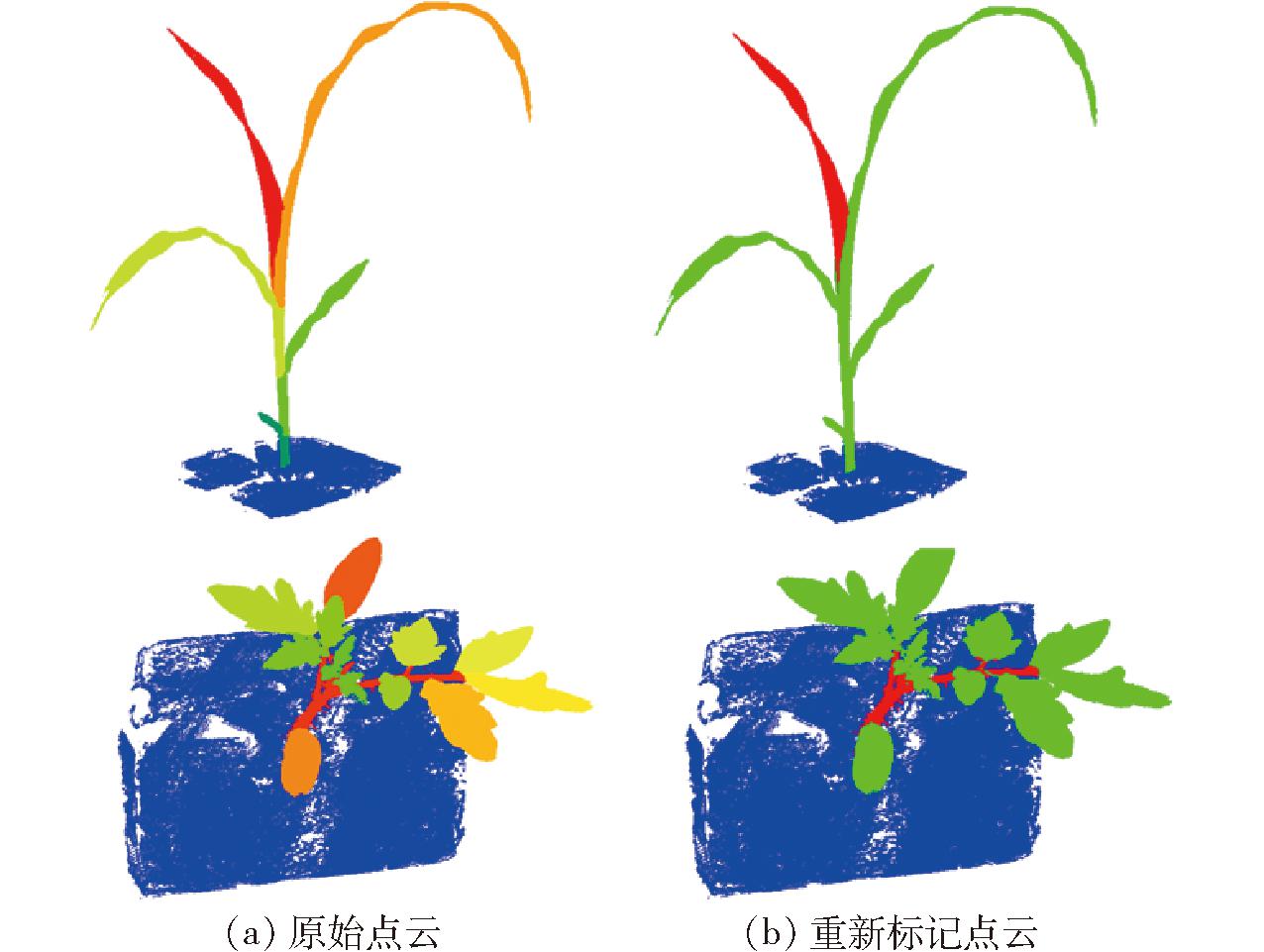

Pheno4D数据集将点云标记为“土壤”、“茎”和“叶”点,其中每片叶子在整个测量期间被分配一个唯一的标签,如图1a所示。为了便于进行植物语义分割,使用CloudCompare工具手动将所有叶子点重新标记为相同的“叶”标签。图1b为重新标记后的植物点云。Pheno4D数据集收集12 d玉米点云和20 d番茄点云,间隔注释7 d玉米点云和11 d番茄点云。为了对特定阶段的植物点云进行语义分割,使用与Pheno4D相同的叶尖法,将玉米叶片之间的叶柄标记为具有枝状结构的“茎”,标记玉米未注释的点云和番茄未注释的点云。玉米1~5号后7 d点云作为训练集,6、7号后7 d点云作为测试集,使用番茄1~5号前11 d点云作为训练集,6、7号前11 d点云作为测试集。

图1 点云重新标记示意图

Fig.1 Illustration of point cloud relabeling

原始Pheno4D和Planest3D数据集采用TXT文件格式存储数据,读取效率较低,特别是对于大规模数据,I/O操作时间较长。为此,将点云数据转换为HDF格式以提高数据读取效率。由于原始点云通常包含大量的点,这会导致消耗巨大的计算资源。为了提高处理效率、降低计算复杂度,使用与DGCNN[22]相同的数据策略来处理输入玉米和番茄点云。将植物点云划分为固定大小的长方体块,然后由网络独立处理每个长方体块。并且以固定的2 048个数对块中的点进行最远点采样操作,以确保采样点均匀分布,保留点云的全局几何结构。对于块中不足2 048个点的点云块,进行重复随机采样,凑够2 048个点。Pheno4D和Planest3D数据集分配情况如表1、2所示。最后将同一植物点云预测块进行组合,得到完整分割。

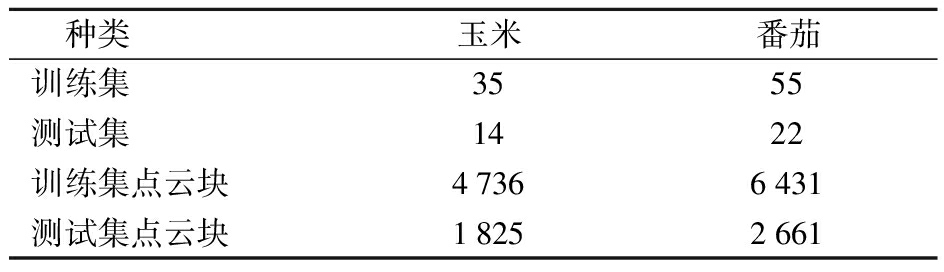

表1 Pheno4D数据集分配

Tab.1 Pheno4D data set allocation

种类玉米番茄训练集3555测试集1422训练集点云块47366431测试集点云块18252661

表2 Planest3D数据集分配

Tab.2 Planest3D data set allocation

种类辣椒玫瑰红醋栗训练集7710测试集334训练集点云块9198061495测试集点云块386344940

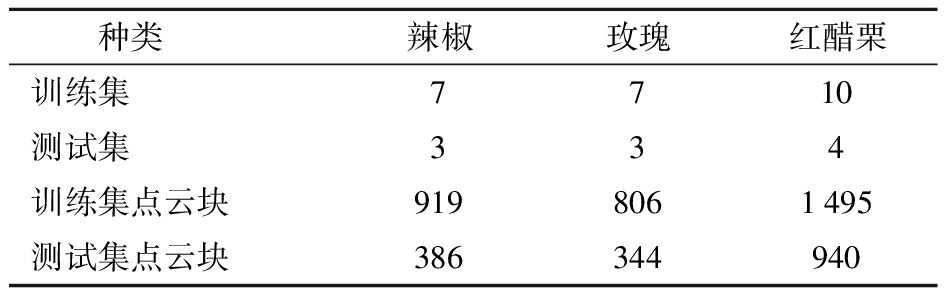

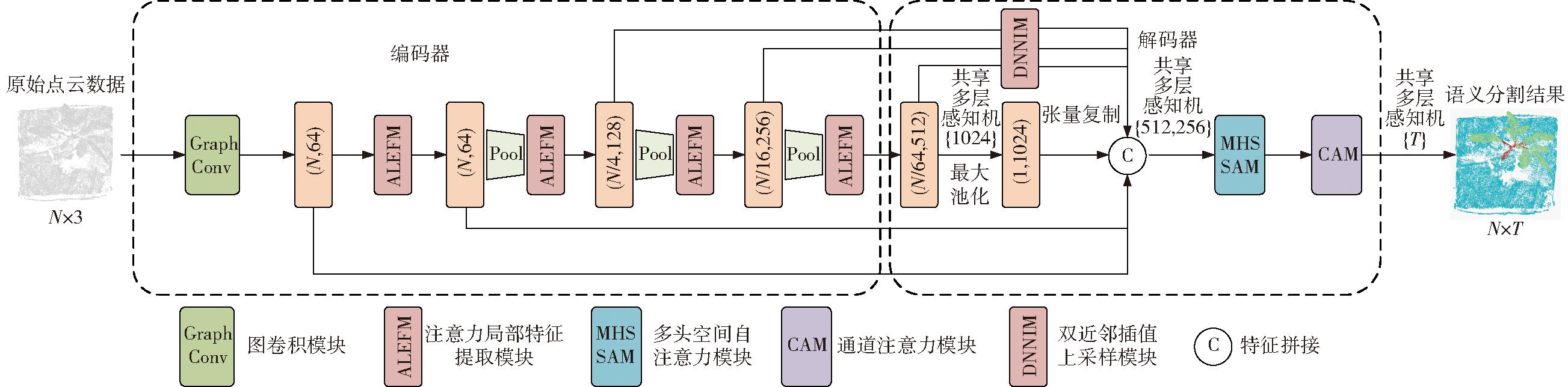

所提出的网络整体结构如图2所示,主要由注意力局部特征提取模块、双近邻插值上采样模块、空间和通道注意力模块构成。该网络输入是尺寸为N×3的点云块,点云块中每个点由1个三维向量表示,即xyz坐标。输入的点云首先经过1个图卷积模块[22]和1个注意力局部特征提取模块来获取每个点的高级特征。其中图卷积模块的作用是构建邻域图并聚合邻域特征,并提升每个点的特征维数。

图2 网络结构图

Fig.2 Network structure diagram

然后,经过3个连续的注意力局部特征提取模块,充分提取局部邻域信息。在每个注意力局部特征提取模块之前,对特征点采用最远点采样(Farthest point sampling,FPS)算法进行下采样,确保采样到的点能够均匀覆盖整个点云表面,从而减少点的数量,并在压缩点云的同时保留其几何结构的重要信息。点云以4倍采样速率进行下采样处理,即每经过一层,仅保留原始点数的1/4。同时每个点的特征维度逐渐增加,以弥补因点数减少带来的信息损失。随后,通过共享多层感知器进行进一步处理,以提取深层次特征,并通过最大池化操作聚合点云信息,提取全局特征。对每层经过注意力局部特征提取模块后的特征点经过双近邻插值上采样模块,恢复原始点数N。然后,每一层提取到的局部特征都会被融合并进行拼接,以保留各层提取到的不同尺度的特征信息。最后使用两个共享多层感知器进行另一轮特征学习。此外,在这两个共享多层感知器之间使用多头空间自注意力模块和通道注意力模块,最后网络生成尺寸为N×T的矩阵作为输出,其中T为类别数。

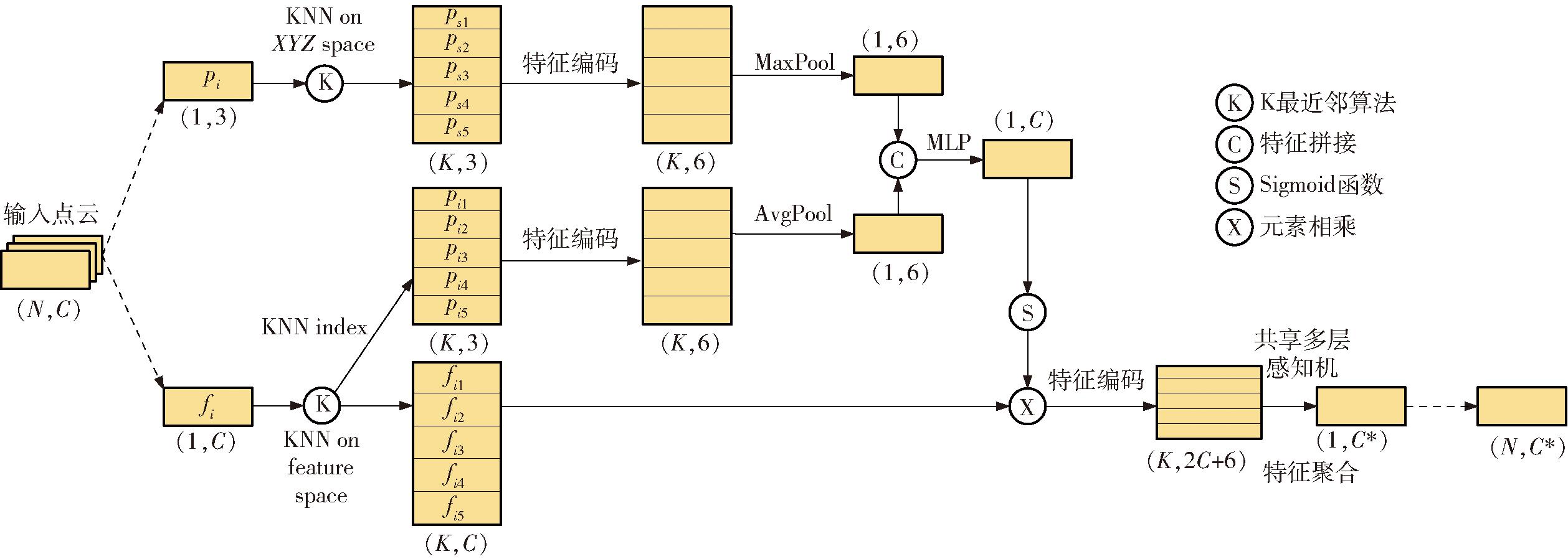

由于简单的将特征空间的高级特征进行聚合很难充分提取点云邻域信息,而坐标空间的低级特征具有基本的几何信息,如点的坐标位置(笛卡尔坐标)、相对位置(极坐标)等,将高级和低级特征结合可使网络更准确地理解和处理点云中的复杂几何结构。因此本文引入注意力局部特征提取模块,模块结构如图3所示。它通过池化、多层感知机和Sigmoid操作将邻域点的低级特征融合成一个注意力分数,作为权重与每个邻域点的当前特征相乘得到加权特征。然后在编码阶段添加邻域点相对于中心点的局部笛卡尔积坐标信息和局部极坐标信息,以帮助网络更好地捕捉局部几何形状和拓扑结构,最后通过共享多层感知机得到最终输出。

图3 注意力局部特征提取模块结构图

Fig.3 Attention local feature extraction module

以点i为例,pi为其三维坐标向量,fi为其特征向量,C为特征维数。首先以点i为中心点,在坐标空间(XYZ space)通过K最近邻算法计算中心点与剩余点之间的几何距离。选择最近的k个点作为最近邻点,记作{ps1,ps2,…,psk}。在特征空间(Feature space)通过K最近邻算法计算中心点与剩余点之间的特征距离。选择最近的k个点作为最近邻点,记作{fi1,fi2,…,fik}。然后将特征空间邻域点的索引(index)信息传入坐标空间,记作{pi1,pi2,…,pik}。由于极坐标含有距离和方位信息,是笛卡尔积坐标不具备的,因此将坐标空间的邻域点的笛卡尔积坐标转换为极坐标再与原坐标进行拼接。计算式为

(1)

其中![]() 和

和![]() 表示以点i为中心点,不同index信息,k个近邻点的笛卡尔积坐标和极坐标的拼接向量,σ为Sigmoid函数,⊕表示特征拼接操作,⊗表示逐元素相乘,MLP表示多层感知机,MaxPool表示最大池化,AvgPool表示平均池化。将

表示以点i为中心点,不同index信息,k个近邻点的笛卡尔积坐标和极坐标的拼接向量,σ为Sigmoid函数,⊕表示特征拼接操作,⊗表示逐元素相乘,MLP表示多层感知机,MaxPool表示最大池化,AvgPool表示平均池化。将![]() 最大池化,将

最大池化,将![]() 平均池化后拼接在一起。再将拼接得到的特征经过多层感知机后再经过一层Sigmoid函数,与当前特征空间邻域特征信息

平均池化后拼接在一起。再将拼接得到的特征经过多层感知机后再经过一层Sigmoid函数,与当前特征空间邻域特征信息![]() 相乘得到模块前半部分的输出。

相乘得到模块前半部分的输出。

将得到的结果![]() 进行特征编码操作,再与邻域点的局部笛卡尔积坐标和局部极坐标拼接,得到高级邻域特征集合,最后经过共享多层感知机和池化得到最终输出,即

进行特征编码操作,再与邻域点的局部笛卡尔积坐标和局部极坐标拼接,得到高级邻域特征集合,最后经过共享多层感知机和池化得到最终输出,即

(2)

其中![]()

(3)

式中 fi——中心点i特征向量

![]() 经过特征编码操作后近邻点特征向量

经过特征编码操作后近邻点特征向量

![]() k个邻域点局部笛卡尔积坐标和局部极坐标

k个邻域点局部笛卡尔积坐标和局部极坐标

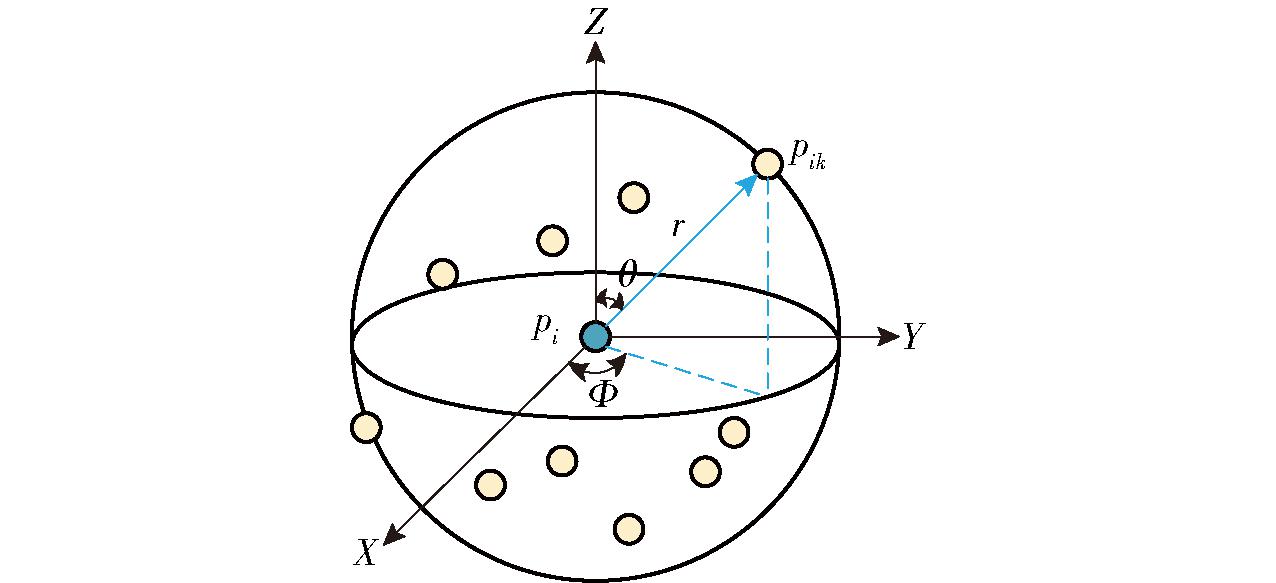

对于邻域点位置表示,图4为组内点pik相对于中心点pi的位置关系。如图4所示,pi为中心点,pik为它的第k个邻域点,r表示极径长度,θ表示直角坐标系中向量(x,y,z)与Z轴夹角,Φ表示向量(x,y,z)在XY平面上投影向量与X轴正向夹角。

图4 近邻点相对位置

Fig.4 Relative position of the nearest neighbors

pik相对于pi的局部笛卡尔积坐标表示为 ik=(

ik=( ik,

ik, ik,

ik, ik),计算式为

ik),计算式为

ik=xik-xi

ik=xik-xi

(4)

ik=yik-yi

ik=yik-yi

(5)

ik=zik-zi

ik=zik-zi

(6)

式中 (xi,yi,zi)——pi全局笛卡尔积坐标

(xik,yik,zik)——pik全局笛卡尔积坐标

pik局部极坐标表示为![]() 计算式为

计算式为

(7)

(8)

(9)

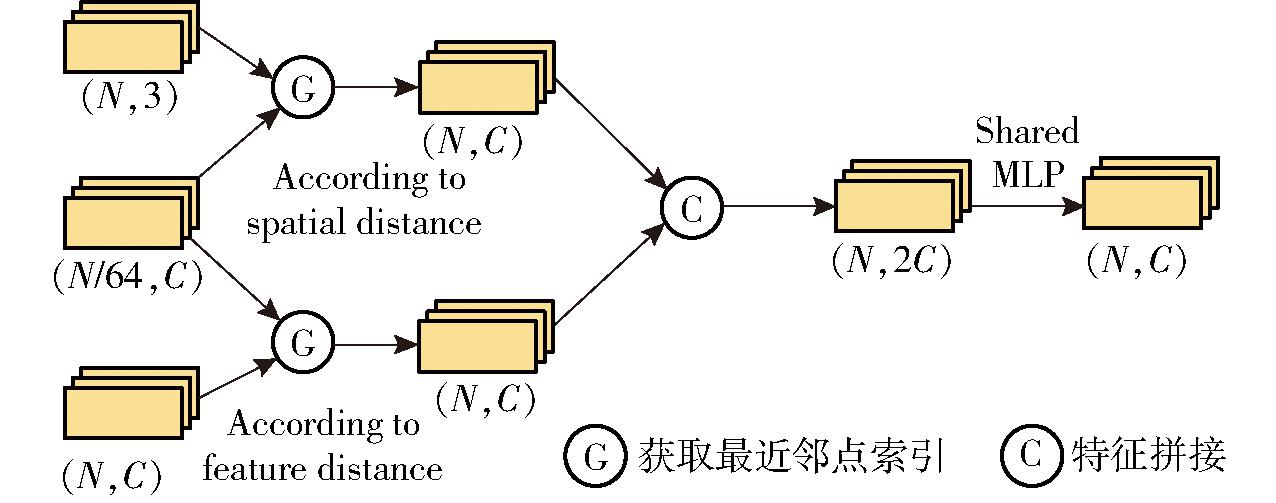

通过下采样操作后,可用更少的点概括原始点信息,使网络更好地捕捉全局特征。在解码部分,要将这些融合了大量点特征的采样点恢复到原始点中。现有的上采样方法大多是基于几何距离的,很少利用到特征距离,例如选择最近采样点的特征值作为原始点特征值的最近邻插值,虽简单快速,但可能导致特征不连续,丢失点云细节。为了在恢复原始空间分辨率的过程中,尽可能保留和恢复更多的细节信息,设计双近邻插值上采样模块。

该模块结构如图5所示,以经过池化的点云(N/64,C)为例,在坐标空间根据几何距离获得最近索引,而后将特征值映射到原始点上。同理,在特征空间根据特征距离获得最近索引,将特征值映射到原始点上。最后,将两者拼接再经过一个共享多层感知机得到最终输出。

图5 双近邻插值上采样模块结构图

Fig.5 Double nearest neighbor interpolation upsampling module

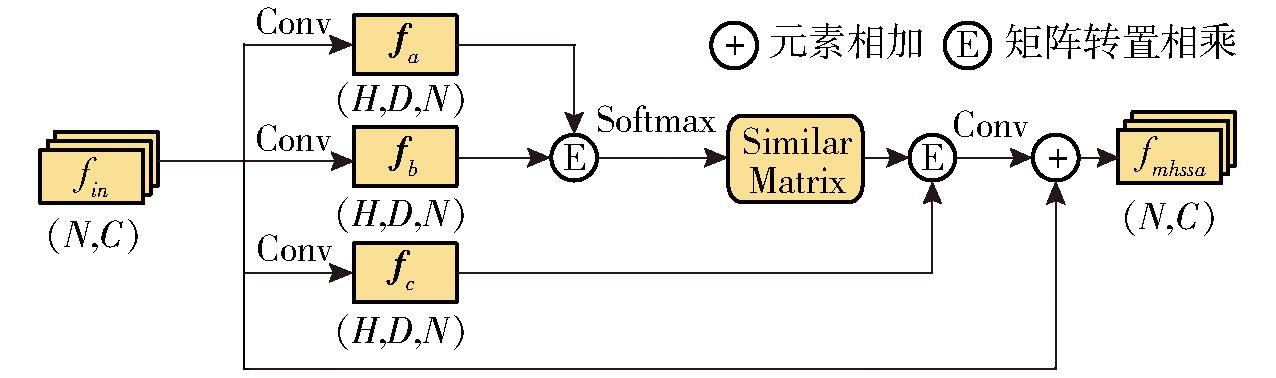

多头空间自注意力模块如图6所示,通过将输入特征划分为多个子空间,每个子空间对应一个独立的注意力头,增强了特征的表达能力。每个注意力头在其特征子空间专注不同点之间的依赖关系,使得网络能够在全局范围内捕获点云中的长距离依赖关系,同时也能够在局部范围内捕捉点与点之间的细粒度关系。

图6 多头空间自注意力模块

Fig.6 Multi-head spatial self-attention module

输入特征向量形状为(N,C),使用3个一维卷积操作生成查询fa、键fb和值fc特征向量,即

fa=Conv1D(fin)

(10)

fb=Conv1D(fin)

(11)

fc=Conv1D(fin)

(12)

将结果向量调整为形状(H,D,N),其中H为注意力头数量,D=C/H表示每个头维度。在每个注意力头中,使用查询特征和键特征计算每个头的点对相似性矩阵S,其形状为(H,N,N)。通过Softmax函数对相似性矩阵的最后一个维度进行归一化,得到注意力权重A,即

(13)

A=σ(S)

(14)

利用注意力权重A对值特征fc进行加权求和得到加权特征,然后将各个头的结果拼接并恢复到原始通道维度。拼接后的特征通过一个1D卷积层映射回输入特征维度,并通过残差连接与输入特征fin相加得到最终输出,即

(15)

通道注意力机制可用于提高模型对输入特征中关键信息的学习能力。通道注意力模块如图7所示,通过分配较高的权重给特征向量中重要的维度(通道),强化这些维度特征,通过分配较低的权重给不重要的特征维度(通道),抑制不重要特征。

图7 通道注意力模块

Fig.7 Channel attention module

首先通过平均池化和最大池化操作对输入点云特征fmhssa进行聚合,生成两个1×C特征向量favg和fmax,分别表示输入点云在通道维度上的平均水平和最大水平,再将这两个向量分别输入到多层感知机,将两个输出特征向量通过向量相加求和,最后通过Sigmoid操作获取一个长度1×C的通道权重向量w,计算式为

w=σ(MLP(Avg(fmhssa))⊕MLP(Max(fmhssa)))

(16)

将该权重向量与经空间注意力机制强化后特征对位相乘,得到通道注意力筛选后增强特征fout,即

fout=fmhssa⊗w

(17)

使用平均交并比(Mean intersection over union,mIoU)和每个类交并比(Intersection over union,IoU)来评价点云语义分割效果。

所有实验均在Intel(R) Xeon(R) Platinum 8255C CPU、主频2.50 GHz,NVIDIA GeForce RTX 3090 GPU的64位服务器上进行,服务器系统为Linux Ubuntu 18.04,运算平台为CUDA-Toolkit 11.0,GPU加速库为Cudnn 8.0.5,深度学习框架为 Pytorch 1.7.1。网络训练时批量大小(Batch size)设置为32,测试时Batch size设置为16,初始学习率设置为0.001,训练迭代次数设为200。训练过程使用随机梯度下降(SGD)进行训练,设置动量为0.9,权重衰减系数为0.000 1。

番茄语义分割结果如表3所示,土壤类IoU均可达到99%以上,PiontCNN[23]和ShellNet[24]的叶类IoU略大于本文方法。本文方法茎类IoU达到最高(70.84%),高于另外3种网络,分割效果提升明显。与DGCNN、PiontCNN和ShellNet相比,mIoU分别提高6.73、2.14、1.06个百分点。

表3 不同网络在番茄数据集上结果对比

Tab.3 Comparison of results of different networks on tomato dataset %

网络mIoUIoU土壤茎叶DGCNN80.5999.3551.9290.49PointCNN85.1899.1363.8992.53ShellNet86.2699.2565.6493.90本文方法87.3299.3670.8491.77

为了直观感受本文方法分割效果,将4种网络分割结果进行可视化,结果如图8所示。由图8可知,DGCNN几乎只能识别主要的茎,对于分茎不能很好地识别。PiontCNN、ShellNet和本文方法可以正确识别大部分茎叶,但是对于茎叶连接处还是不能很好地识别。由表3可知,茎的交并比远低于其他两种,有2个原因:①茎空间结构细长且形态不规则,因此预测区域与真实区域之间差异较大。②茎的点所占比例远低于叶子,这种数据不均衡问题会导致模型在训练过程中更加关注占比大的器官,而错误分割占比小的茎。

图8 番茄数据集语义分割结果可视化

Fig.8 Visualization of semantic segmentation results for tomato dataset

玉米语义分割结果如表4所示,DGCNN的土壤类IoU略大于本文方法。除了土壤类IoU不是最优值,其余类别和mIoU均是最优值。与DGCNN、PiontCNN和ShellNet相比,本文方法mIoU分别提高7.55、5.01、2.23个百分点。

表4 不同网络在玉米数据集上结果对比

Tab.4 Comparison of results of different networks on corn dataset %

网络mIoUIoU土壤茎叶DGCNN[22]72.1399.8127.6388.95PointCNN[23]74.6799.5235.1689.31ShellNet[24]77.4599.1340.2792.96本文方法79.6899.6145.8493.58

玉米分割可视化结果如图9所示,DGCNN、PiontCNN、ShellNet和本文方法对于玉米茎叶均不能进行很好的分割。由表4可知,在玉米数据集上茎的交并比也远低于其他2种,有以下原因:①玉米茎通常位于植株中心位置,容易被周围的叶片遮挡,且存在断续不完整的现象。这种不完整性会使得模型难以准确预测茎的区域,导致交并比降低。②玉米的茎在点云中所占的点数较少,数据量显著小于叶片。③茎与叶在空间结构上极为相似,这种相似性使得模型在区分茎与叶时容易混淆,导致预测不准确。

图9 玉米数据集语义分割结果可视化

Fig.9 Visualization of semantic segmentation results for corn dataset

基于Planest3D数据集在语义分割任务中评估本文方法的分割性能,并与其他主流的深度学习点云分割网络进行对比。由表5可知,本文方法3种植物mIoU分别达到94.73%、91.43%、95.02%,玫瑰叶类IoU和红醋栗茎类IoU低于ShellNet,多数情况下实现了最佳语义分割性能。

表5 不同网络语义分割性能对比

Tab.5 Comparison of semantic segmentation performance of different networks %

网络辣椒玫瑰红醋栗茎IoU叶IoUmIoU茎IoU叶IoUmIoU茎IoU叶IoUmIoUDGCNN83.4893.4588.4781.2393.4687.3587.4894.7591.16PointCNN89.4994.1291.883.2595.1989.2289.6895.7492.71ShellNet89.7596.6193.1885.3796.2990.8392.4695.2793.87本文方法91.8497.6294.7387.3695.4991.4391.8598.1995.02

3种植物分割可视化结果如图10所示。在辣椒点云中,分割错误主要集中在叶片和茎的连接处。而在玫瑰和红醋栗点云中,除茎叶连接处外,叶片中叶存在少量分割错误的情况。原因为:①在植物的茎叶连接部位,往往存在复杂的几何形态和结构过渡,这些部位的点云数据可能具有相似的局部特征,导致模型难以准确识别它们边界。②有些叶片的表面结构可能与茎的表面相似,尤其是当植物的茎较为光滑,或者叶片与茎形态相似时,并且点云数据几何特征可能无明显差异,造成模型识别错误。

图10 Planest3D数据集语义分割结果可视化

Fig.10 Planest3D data set semantic segmentation results visualization

为了评估网络泛化能力,对Pheno4D中两个植物数据集进行了交叉验证实验。首先,评估在番茄数据集上训练网络,在玉米数据集上测试网络结果。然后,评估在玉米数据集上训练网络,在番茄数据集上测试网络结果。为了保证实验公平,采用与上述实验相同的参数设置和相同评价指标。

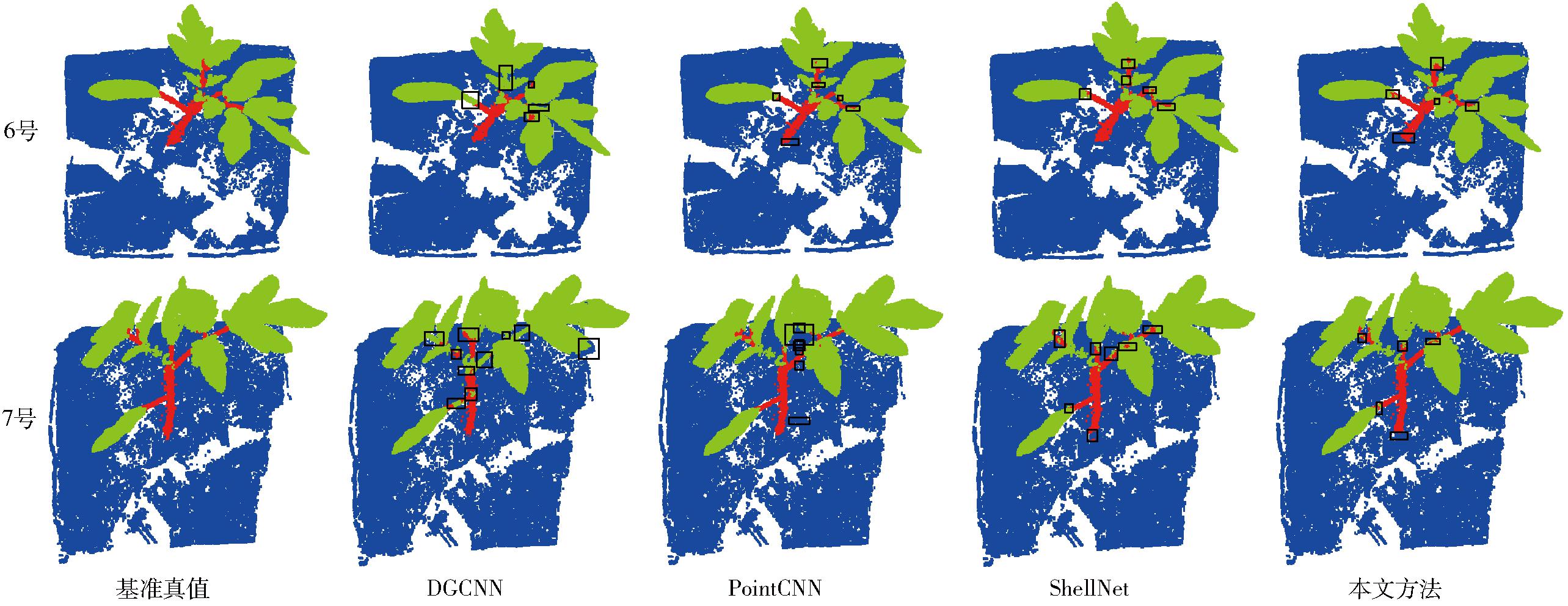

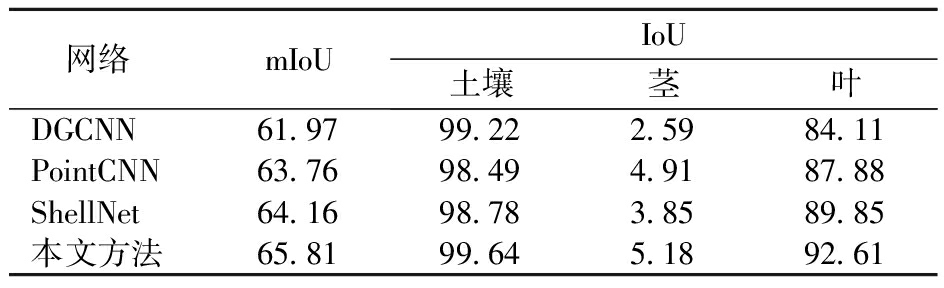

3.6.1 番茄数据集交叉验证

在玉米数据集上训练网络并在番茄数据集上测试网络结果如表6所示。所有网络土壤类IoU都达到98%以上,只有本文方法叶类IoU达到90%以上。然而与在番茄数据集上训练的网络相比,所有网络茎类IoU均下降到将近0。图11为4种网络在番茄数据集上的交叉验证可视化结果,其中A行表示模型在番茄数据集上进行训练和测试结果,B行表示模型在玉米数据集上进行训练,在番茄数据集上进行测试的结果。当从玉米数据集推广到番茄数据集时,所有网络几乎都正确地分类了土壤和叶子,然而所有网络都无法准备识别茎点。

表6 玉米数据集训练和番茄数据集测试结果

Tab.6 Training on corn dataset and testing results on tomato dataset %

网络mIoUIoU土壤茎叶DGCNN61.9799.222.5984.11PointCNN63.7698.494.9187.88ShellNet64.1698.783.8589.85本文方法65.8199.645.1892.61

图11 玉米数据集训练番茄数据集测试分割结果可视化

Fig.11 Corn dataset training tomato dataset test segmentation results visualization

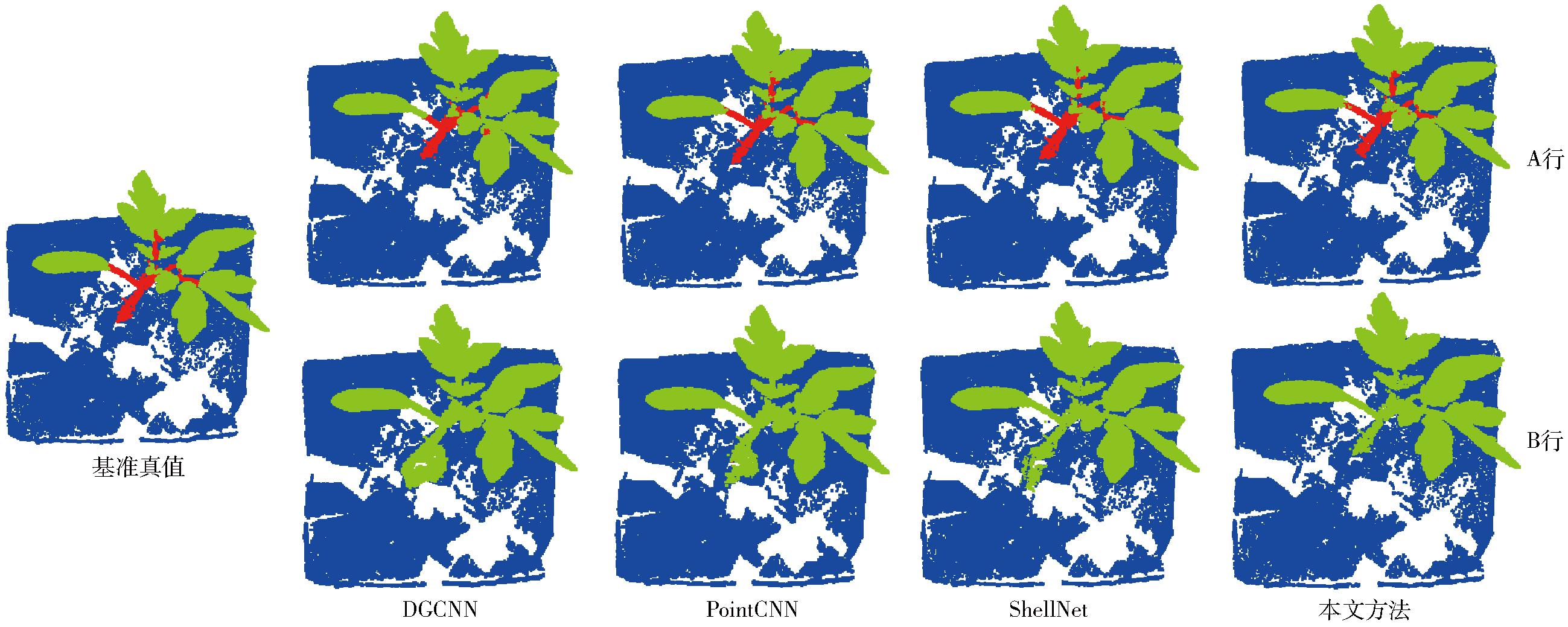

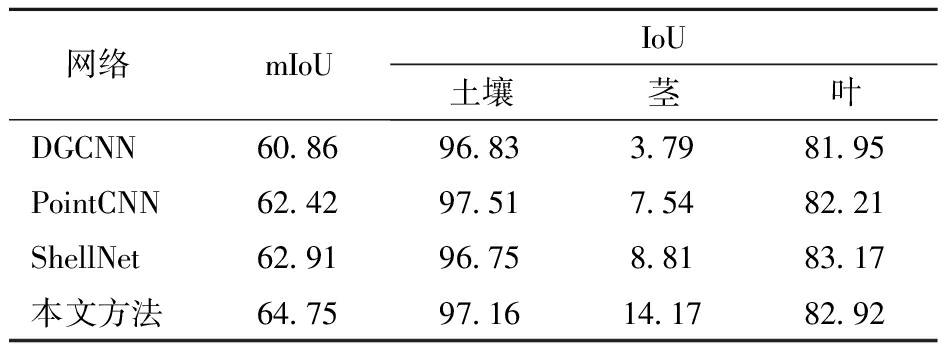

3.6.2 玉米数据集交叉验证

表7为在番茄数据集上训练和在玉米数据集上测试的结果。由于两个数据集中的地面具有相似的特征,所有模型土壤类均保持较高IoU(>96%)。本文方法叶类IoU低于ShellNet,茎类IoU最高(>14%),优于其他3类网络模型。图12为4种网络在玉米数据集上的交叉验证可视化结果,其中C行表示网络在玉米数据集上进行训练和测试的结果,D行表示网络在番茄数据集上进行训练,在玉米数据集上进行测试的结果。当从番茄数据集推广到玉米数据集时,所有网络将大部分茎识别为叶,只有少部分茎识别正确。

表7 番茄数据集训练和玉米数据集测试结果

Tab.7 Training on tomato dataset and testing results on corn dataset %

网络mIoUIoU土壤茎叶DGCNN60.8696.833.7981.95PointCNN62.4297.517.5482.21ShellNet62.9196.758.8183.17本文方法64.7597.1614.1782.92

图12 番茄数据集训练玉米数据集测试分割结果可视化

Fig.12 Tomato dataset training corn dataset evaluation segmentation results visualization

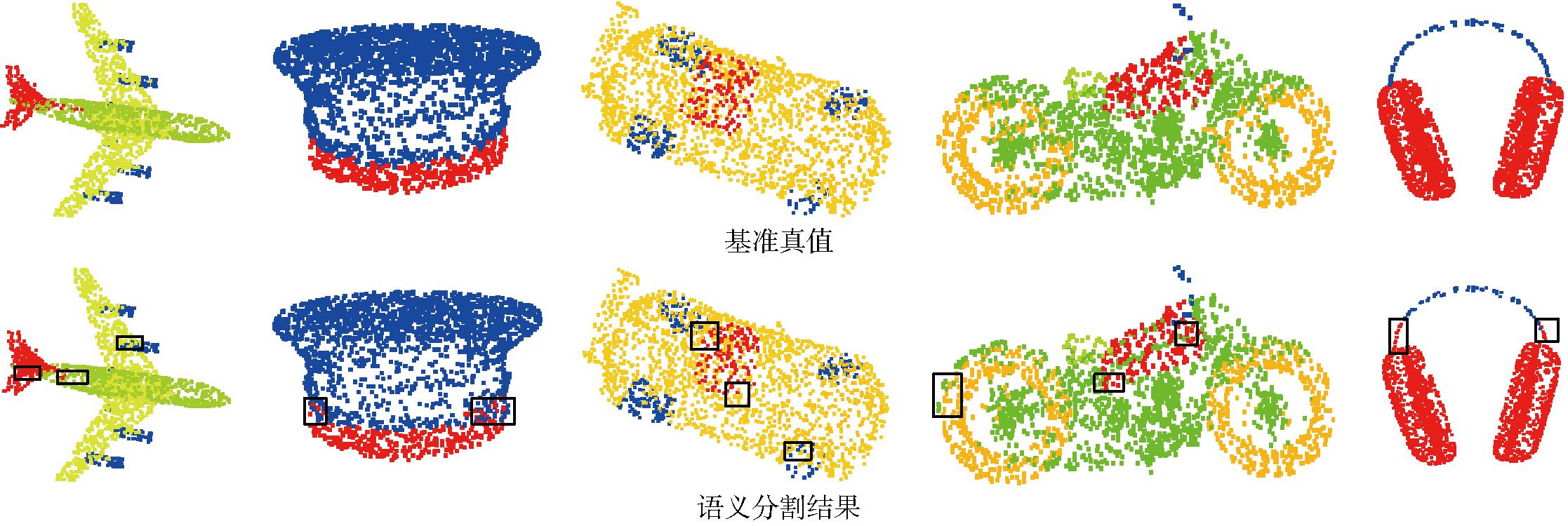

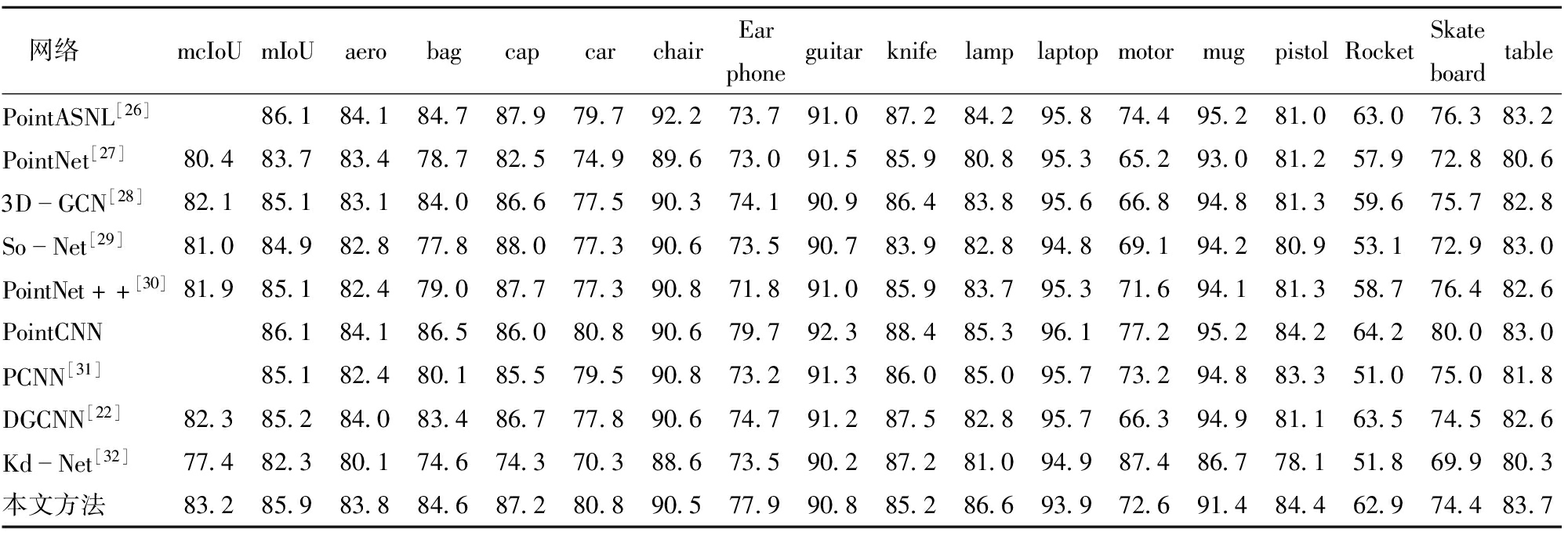

为了进一步评估本文方法泛化性和鲁棒性,选用ShapeNet[25]数据集进行语义分割,并与其他方法进行定量对比。ShapeNet数据集有16 880个3D点云,其中训练集有14 006个模型,测试集有2 874个模型。该数据集有16个类,注释50个部分,每个点云包含2~6个部分。由于点云数据包含大量的点,直接将其送入网络训练会占用大量计算资源,降低训练速度,对于提高网络的分割性能意义不大,因此采用前文提到的最远点降采样策略将所有点云点数降到2 048后送入到网络中进行训练。图13为本文方法在ShapeNet数据集上的分割可视化结果,分割错误主要集中在不同语义类的边界处,其他区域识别正确。本文方法对ShapeNet数据集中每种物件语义分割定量结果如表8所示,展示了每个类别IoU、平均类IoU(mcIoU)和平均实例IoU(mIoU)。mcIoU为所有形状类别的平均IoU,mIoU通过计算所有测试实例的平均IoU得到。

图13 ShapeNet数据集分割结果可视化

Fig.13 Visualization of segmentation results of ShapeNet dataset

表8 ShapeNet数据集分割结果

Tab.8 Segmentation results of ShapeNet dataset %

网络mcIoUmIoUaerobagcapcarchairEarphoneguitarknifelamplaptopmotormugpistolRocketSkateboardtablePointASNL[26]86.184.184.787.979.792.273.791.087.284.295.874.495.281.063.076.383.2PointNet[27]80.483.783.478.782.574.989.673.091.585.980.895.365.293.081.257.972.880.63DGCN[28]82.185.183.184.086.677.590.374.190.986.483.895.666.894.881.359.675.782.8SoNet[29]81.084.982.877.888.077.390.673.590.783.982.894.869.194.280.953.172.983.0PointNet++[30]81.985.182.479.087.777.390.871.891.085.983.795.371.694.181.358.776.482.6PointCNN86.184.186.586.080.890.679.792.388.485.396.177.295.284.264.280.083.0PCNN[31]85.182.480.185.579.590.873.291.386.085.095.773.294.883.351.075.081.8DGCNN[22]82.385.284.083.486.777.890.674.791.287.582.895.766.394.981.163.574.582.6KdNet[32]77.482.380.174.674.370.388.673.590.287.281.094.987.486.778.151.869.980.3本文方法83.285.983.884.687.280.890.577.990.885.286.693.972.691.484.462.974.483.7

由表8可知,本文方法mcIoU和mIoU分别达到83.2%和85.9%,其中mcIoU优于其他网络,mIoU仅次于PointASNL[26]和PointCNN。PointASNL引入非局部神经网络,这种架构能够捕捉点云中远距离点之间的依赖关系。使其能够从更广的上下文中理解点云的全局结构。在处理复杂形状或稀疏点云的数据时更为突出。PointCNN通过X-Transformation将不规则点云数据转换为适合卷积操作的结构。这使得它能够充分利用卷积神经网络优势,在处理不规则点云数据时更加出色。由于ShapeNet数据集点云涵盖了多种物体类别,不同类别之间的几何复杂度差异大,本文方法处理结构复杂物体能力和泛化能力不及PointASNL和PointCNN。综上所述,这是这两类网络mIoU优于本文方法的原因。

设计5种组合来验证各模块对植物分割任务的有效性,选取前文中的番茄点云作为数据集。未采用注意力局部(邻域)特征提取模块时使用的是图卷积模块,未采用双近邻插值模块时使用的是最近邻插值模块。表9为5种组合mIoU定量结果。

表9 消融实验结果

Tab.9 Results of ablation experiments %

组合ALEFMMHSSAM&CAMDNNIMmIoUA×××82.25B√××85.29C√√×86.84D√×√85.66E√√√87.32

注:√表示使用此模块,×表示不使用此模块。

由表9可知,随着模块添加,网络分割性能也在不断提高,其中添加注意力局部(邻域)特征提取模块对网络分割性能提升比较明显,mIoU提升3个百分点。多头空间自注意注意力和通道注意力模块对网络的性能影响较大,mIoU提升1.55个百分点。对网络性能影响最小的是双近邻插值上采样模块,语义分割指标mIoU提升0.4个百分点。通过叠加这3个模块,比单独使用其中一种或两种的分割效果要好,进一步证明所提各模块的有效性。

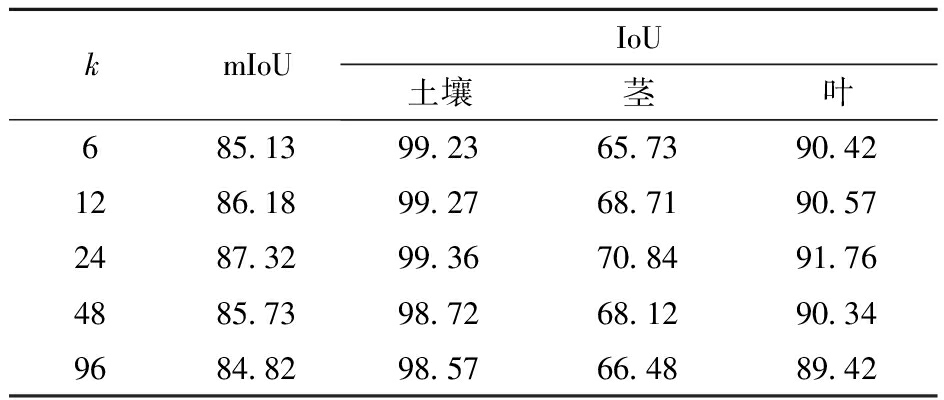

注意力局部特征提取模块中邻域k值的设置对于能否有效捕获局部信息至关重要。为了研究其对网络性能的影响,基于完整的网络即E组合,以番茄点云作为数据集,设置不同数值进行测试。

当k发生变化时,语义分割指标变化如表10所示。随着k不断增大,评价指标先是不断升高,然后逐渐下降,当k为24时,各项IoU达到最高。当k设置过小(k=6)时,网络将无法充分捕捉点云中的整体结构和上下文信息,而当k设置过大(k=96)时,网络会导致局部特征的细节丢失、引入无关信息,并增加计算复杂度,降低网络对细节的敏感度和性能。

表10 不同邻域k设置下本文方法性能结果

Tab.10 Quantitative analysis of performance of proposed method under different neighborhood k settings %

kmIoUIoU土壤茎叶685.1399.2365.7390.421286.1899.2768.7190.572487.3299.3670.8491.764885.7398.7268.1290.349684.8298.5766.4889.42

植物器官语义分割对于植物表型研究、农业自动化、植物生长监测等领域具有重要意义。根据语义类别对大规模植物数据集Pheno4D进行重新标记。提出了一个基于注意力机制的植物三维点云语义分割网络。该网络模型集成了注意力局部(邻域)特征提取模块、双近邻插值上采样模块、多头空间自注意力和通道注意力模块,以充分提取局部特征、恢复点云特征和利用全局信息。本文方法在Pheno4D和Planest3D植物点云数据集上mIoU分别达到87.32%、79.68%、94.73%、91.43%、95.02%,优于当前流行的3种网络,较好地完成了植物器官语义分割任务。通过相关交叉验证实验,证实了网络具有较好的泛化能力。在ShapeNet数据集上的实验结果进一步验证了网络泛化性和鲁棒性。通过消融实验证明了所提出各模块的有效性。

[1] ARAUS J L,CAIRNS J E.Field high-throughput phenotyping:the new crop breeding frontier[J].Trends Plant Sci.,2014,19(1):52-61.

[2] CHAIVIVATRAKUL S,TANG L,DAILEY M N,et al.Automatic morphological trait characterization for corn plants via 3D holographic reconstruction[J].Computers and Electronics in Agriculture,2014,109:109-203.

[3] 张慧春,周宏平,郑加强,等.植物表型平台与图像分析技术研究进展与展望[J].农业机械学报,2020,51(3):1-17.ZHANG Huichun,ZHOU Hongping,ZHENG Jiaqiang,et al.Research progress and prospect in plant phenotyping platform and image analysis technology[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(3):1-17.(in Chinese)

[4] JAY S.In-field crop row phenotyping from 3D modeling performed using structure from motion[J].Computers and Electronics in Agriculture,2015,110:70-77.

[5] 宋彦,杨帅,郑子秋,等.基于多头自注意力机制的茶叶采摘点语义分割算法[J].农业机械学报,2023,54(9):297-305.SONG Yan,YANG Shuai,ZHENG Ziqiu,et al.Semantic segmentation algorithm based multi-headed self-attention for tea picking points[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(9):297-305.(in Chinese)

[6] 顾文娟,魏金,阴艳超,等.基于改进DeepLabv3+的番茄图像多类别分割方法[J].农业机械学报,2023,54(12):261-271.GU Wenjuan,WEI Jin,YIN Yanchao,et al.Multi-category segmentation method of tomato image based on improved DeepLabv3+[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(12):261-271.(in Chinese)

[7] PATURKAR A,GUPTA G S,BAILEY D.Making use of 3D models for plant physiognomic analysis:a review[J].Remote Sensing,2021,13(11):2232.

[8] 梁秀英,周风燃,陈欢,等.基于运动恢复结构的玉米植株三维重建与性状提取[J].农业机械学报,2020,51(6):209-219.LIANG Xiuying,ZHOU Fengran,CHEN Huan,et al.Three-dimensional maize plants reconstruction and traits extraction based on structure from motion[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(6):209-219.(in Chinese)

[9] MIAO T,ZHU C,XU T,et al.Automatic stem-leaf segmentation of maize shoots using three-dimensional point cloud[J].Computers and Electronics in Agriculture,2021,187:106310.

[10] 杨琳,翟瑞芳,阳旭,等.结合超体素和区域增长的植物器官点云分割[J].计算机工程与应用,2019,55(16):197-203.YANG Lin,ZHAI Ruifang,YANG Xu,et al.Segmentation of plant organs point clouds through super voxel-based region growing methodology[J].Computer Engineering and Applications,2019,55(16):197-203.(in Chinese)

[11] 肖奕同,刘帅,侯晨连,等.基于三维点云的大豆植株器官分割及表型分析[J].中国农业科技导报,2023,25(8):115-125.XIAO Yitong,LIU Shuai,HOU Chenlian,et al.Organ segmentation and phenotypic analysis of soybean plants based on three-dimensional point clouds[J].Journal of Agricultural Science and Technology,2023,25(8):115-125.(in Chinese)

[12] 彭程,李帅,苗艳龙,等.基于三维点云的番茄植株茎叶分割与表型特征提取[J].农业工程学报,2022,38(9):187-194.PENG Cheng,LI Shuai,MIAO Yanlong,et al.Stem-leaf segmentation and phenotypic trait extraction of tomatoes using three-dimensional point cloud[J].Transactions of the CSAE,2022,38(9):187-149.(in Chinese)

[13] CHEN Y,XIONG Y,ZHANG B,et al.3D point cloud semantic segmentation toward large-scale unstructured agricultural scene classification[J].Computers and Electronics in Agriculture,2021,190:106445.

[14] GUO Y,WANG H,HU Q,et al.Deep learning for 3D point clouds:a survey[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,43(12):4338-4364.

[15] BOULCH A,GUERRY J,LE SAUX B,et al.SnapNet:3D point cloud semantic labeling with 2D deep segmentation networks[J].Computers &Graphics,2018,71:189-198.

[16] GUO X,SUN Y,YANG H.FF-Net:feature-fusion-based network for semantic segmentation of 3D plant point cloud[J].Plants,2023,12(9):1867.

[17] LI D,LI J,XIANG S,et al.PSegNet:simultaneous semantic and instance segmentation for point clouds of plants[J].Plant Phenomics,2022:9787643.

[18] HAN B,LI Y,BIE Z,et al.MIX-NET:deep learning-based point cloud processing method for segmentation and occlusion leaf restoration of seedlings[J].Plants,2022,11(23):3342.

[19] SUN Y,GUO X,YANG H.Win-Former:window-based transformer for maize plant point cloud semantic segmentation[J].Agronomy,2023,13:2723.

[20] SCHUNCK D,MAGISTRI F,ROSU R A,et al.Pheno4D:a spatio-temporal dataset of maize and tomato plant point clouds for phenotyping and advanced plant analysis[J].PLoS One,2021,16(8):e0256340.

[21] KEREM M,YUSUF  ,SERVER K S,et al.PLANesT-3D:a new annotated dataset for segmentation of 3D plant point clouds[J].arXiv Preprint,arXiv:2407.21150,2024.

,SERVER K S,et al.PLANesT-3D:a new annotated dataset for segmentation of 3D plant point clouds[J].arXiv Preprint,arXiv:2407.21150,2024.

[22] WANG Y,SUN Y,LIU Z,et al.Dynamic graph CNN for learning on point clouds[J].ACM Transactions on Graphics,2018,38(5):1-12.

[23] LI Y,BU R,SUN M,et al.PointCNN:convolution on x-transformed points[J].Advances in Neural Information Processing Systems,2018,31:820-830.

[24] ZHANG Z,HUA B S,YEUNG S K.Shellnet:efficient point cloud convolutional neural networks using concentric shells statistics[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision,2019:1607-1616.

[25] YI L,KIM V G,CEYLAN D,et al.A scalable active framework for region annotation in 3D shape collections[J].ACM Transactions on Graphics,2016,35(6):1-12.

[26] YAN X,ZHENG C,LI Z,et al.PointASNL:robust point clouds processing using nonlocal neural networks with adaptive sampling[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2020:5589-5598.

[27] QI C R,SU H,MO K,et al.PointNet:deep learning on point sets for 3D classification and segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:652-660.

[28] LIN Z,HAUNG S,WANG Y F.Convolution in the cloud:learning deformable kernels in 3D graph convolution networks for point cloud analysis[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2020:1800-1809.

[29] LI J,CHEN B M,LEE G H.So-net:self-organizing network for point cloud analysis[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:9397-9406.

[30] QI C R,YI L,SU H,et al.Pointnet++:deep hierarchical feature learning on point sets in a metric space[J].Advances in Neural Information Processing Systems,2017,30:5099-5108.

[31] ATZMON M,MARON H,LIPMAN Y,et al.Point convolutional neural networks by extension operators[J].arXiv Preprint,arXiv:1803.10091,2018.

[32] KLOKOV R,LEMPITSKY V.Escape from cells:deep kd-networks for the recognition of 3D point cloud models[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:863-872.