小麦是世界上分布面积最广泛的粮食作物之一,在全球粮食生产和粮食安全中发挥着关键作用[1-2]。然而,世界人口持续增长、气候变化的日益加剧以及耕地面积不断减少,对小麦育种提出了新的要求,因此需要培育具备抗逆性和高产潜力的优良品种。近年来的研究是利用新型感知技术将基因组学和表型组学相结合,构建“基因型+表型”智慧育种体系,挖掘作物重要表型性状与基因的关联性以提高作物选育效率[3-4]。然而,这些技术需要对大量作物表型样本进行筛选,依靠人工方法(如人工测量和肉眼识别)采集作物表型数据存在程序繁琐、工作量大、效率低和主观因素影响等问题[5]。同时,传统方法获取的表型数据覆盖范围有限,分析的种质资源数量不足,难以支撑大规模育种研究。目前,基于传感器技术、人工智能和育种技术的高通量表型机器人技术正在快速发展,这标志着高通量表型数据采集向实现智能化和数字化迈出了重要一步[6]。因此,开发高通量表型数据自动化采集与解析的作物表型鉴定机器人,对减少劳动力投入、降低表型采集工作的主观性影响以及提高育种工作中的表型解析效率具有重要意义。

近年来,计算机视觉和深度学习技术的迅猛发展推动了其在各个领域的广泛应用,尤其在植物表型检测方面取得了显著进展[7]。这些技术已成功应用于麦穗及小麦叶部病斑的识别[8]、茶芽计数[9]和水果检测[10]等任务。然而,现有的大部分研究侧重于对采集的数据进行处理,缺乏实时性,无法满足实际应用中的高效性需求。为便于采集作物表型,国内外学者也进行了广泛探索。例如,美国伊利诺伊大学香槟分校(UIUC)开发了低成本的跟踪式移动机器人来收集单个植物的表型数据,实现玉米株高以及茎宽的测量[11]。卡内基梅隆大学(CMU)开发了一种新型机器人地面平台,通过部署机械手来测量植物茎秆强度[12]。在国内,姚照胜等[13]开发了农田信息采集车,用于大范围田间数据的定时、定点采集。刘英旋等[14]设计了轮式小型农田信息采集机器人,尽管采集信息种类较全,但在田间工作时受障碍物、地形起伏及作物遮挡的影响较大,通过性和适应性不足。为解决此问题,唐政等[15]、汪小旵等[16]和YAO等[17]均设计优化了一种轻量化的无人车载田间作物表型获取平台,提高了平台在复杂条件下的适应性与数据采集的稳定性。WANG等[18]则在植物表型机器人上部署了番茄实力分割模型,实现番茄成熟度检测。然而,以上研究大多集中于算法的改进以及信息采集设备的研发,对作物表型解析系统的集成与应用研究尚不成熟,特别是在复杂田间环境中尚未实现高通量、高精度表型数据解析。

为此,本研究设计一种小麦表型机器人底盘并提出一种基于表型机器人的小麦关键生育期表型检测方法,通过融合小麦出苗检测、抽穗期监测及开花期判定等表型解析方法实现田间小麦关键生育期表型数据的高效自动化采集与解析。

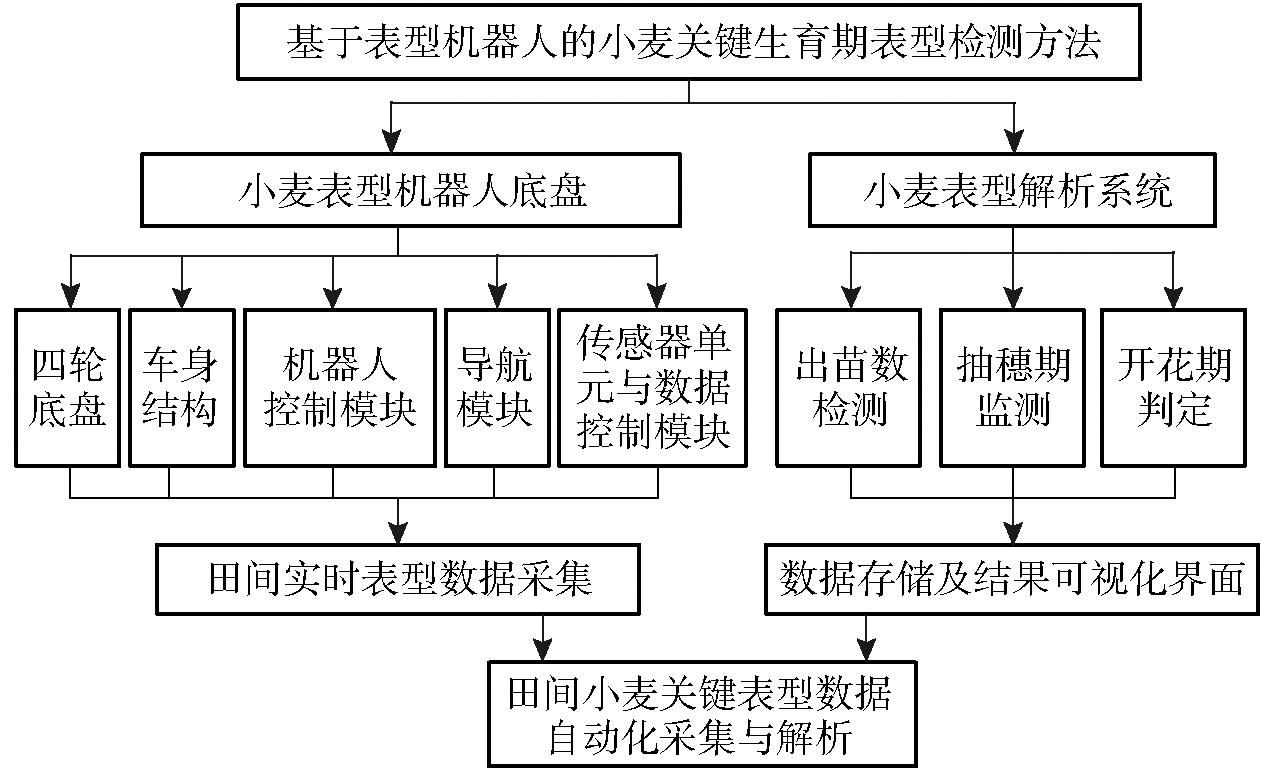

基于表型机器人的小麦关键生育期表型检测方法集高通量采集、多功能集成与自动化表型解析于一体,旨在适应田间复杂的作业环境,满足小麦表型参数高精度检测的实际需求。本研究采用模块化和高度集成化的设计理念,兼具功能扩展性和田间适应性,能够完成关键生育期(如出苗期、抽穗期、开花期)小麦表型数据的高效采集与深度解析。基于表型机器人的小麦关键生育期表型检测方法总体技术路线图如图1所示,主要分为小麦表型机器人底盘和表型解析系统两部分,两部分相互配合实现从田间数据采集到结果分析的全流程自动化处理。表型机器人底盘由四轮底盘、车身结构、机器人控制模块、导航模块和传感器单元与数据控制模块组成。其中,四轮底盘采用四轮独立驱动,车身结构采用高地隙车架提高地形适应性以保证机器人在田间环境下小麦全生育期的稳定作业。机器人控制模块主要负责底盘运行的核心功能,包括行进、转向、速度调节、停止等运动控制。导航模块采用手柄控制模式和基于RTK(Real-time kinematic)技术的自主导航模式。在手柄控制模式下,操作人员利用车体前方底部的摄像头获取实时视频流,对行驶路径和环境进行实时监控,灵活调整其运动轨迹。高精度RTK系统控制下,实现厘米级定位,确保机器人能够按照设定路径在田间精准导航。传感器单元与数据控制模块集成了RGB传感器、边缘计算设备、可视化模块以及电源模块,配合表型解析系统完成表型数据的实时采集、解析、可视化与存储。

图1 基于表型机器人的小麦关键生育期表型检测方法总体技术路线图

Fig.1 Overall technical roadmap of wheat phenotypic detection method for key growth stage based on phenotyping robot

小麦表型解析系统基于模块化的软件架构,不同表型解析功能被分配至独立模块,如出苗数检测模块、抽穗期监测模块和开花期判定模块,能够高效完成表型数据的自动化处理。系统同时具备数据可视化与远程交互能力,将解析结果通过无线网络传输至用户端或远程服务器,便于科研人员或农田管理者实时获取分析结果。整个系统通过高效的数据处理算法与边缘计算设备,实现了表型参数的高精度、动态化监测,为精准育种提供了可靠依据。

在具体工作中,机器人依托规划的路线进入目标作业区域,调取所需的传感器模块进行小麦生长参数与田间环境数据的实时采集。采集到的数据通过表型解析系统进行解析,最终将结果存储于本地或传输至远程服务器。通过模块化设计和高性能计算的融合,系统实现了数据采集-处理-可视化的一体化流程,大幅提升了田间表型检测的效率与精准度,为推动农业智能化和现代化提供了技术支持。

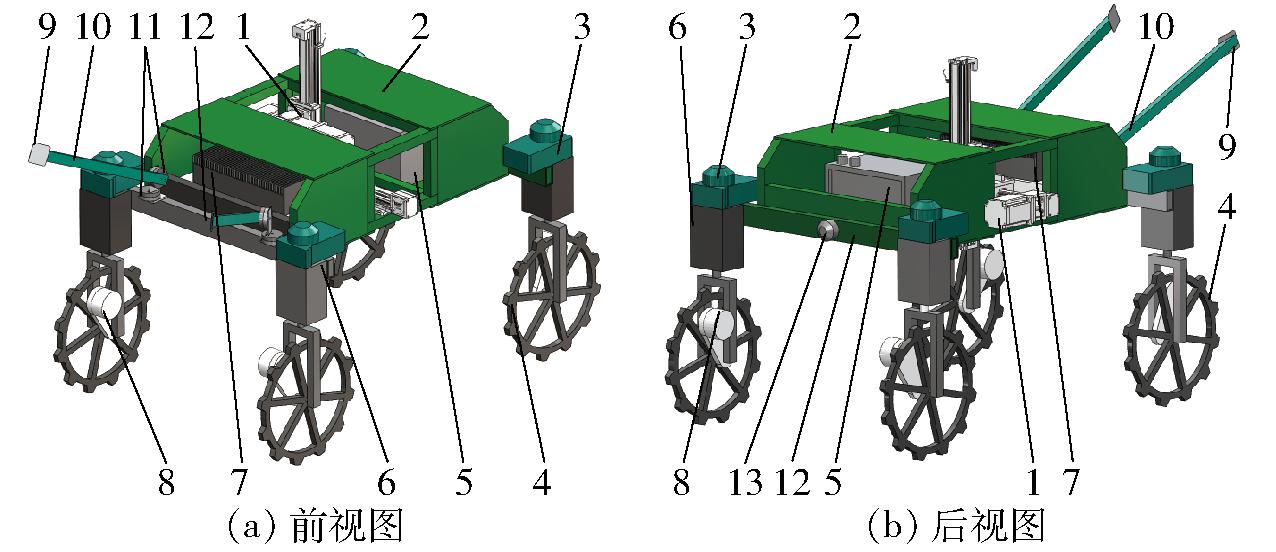

小麦表型机器人采用模块化设计理念,注重适应性以应对复杂地形和多样化作业需求。机器人底盘基于铰接式结构设计,将车体划分为前、后两部分,后车轮与后车架支撑横梁通过铰接轴与整体车架相连接,实现车体具有独立的摆动和倾斜能力,来提升机器人在不平整田间地形中的稳定性和通过性,同时确保各车轮始终与地面保持接触,有效避免卡顿或翻车现象。此外,该结构能够显著降低地形起伏引起的震动对RGB相机等传感器的影响,从而保障高精度的数据采集。

机器人底盘采用四轮独立驱动设计,并配备齿状轮胎,以提供强大的抓地力,防止在松软或湿滑土壤中打滑并能够跨越杂草和石块等田间障碍物。车轮宽度为3 cm,能够减少对土壤的压陷深度,增强整体稳定性,同时确保轮胎在田间长期作业中的耐用性。底盘离地间隙约为130 cm,可适应小麦从苗期到成熟期(0~100 cm)的全生长周期,避免对作物的损伤。此外,为了适应不同试验地块的小区宽度和小麦行距,底盘设计了可调节轮距,轮距横向调节机构与车架支撑横梁通过螺栓紧固连接,通过手动可将轮距横向调节机构带动车轮沿车架支撑横梁横向移动来调整轮间距,调节范围为120~150 cm,能够满足不同种植模式的需求,提高作业灵活性。为了进一步提升田间适应性,底盘采用低重心设计,增强抗倾覆能力,确保在不平坦或斜坡地形上的稳定性。底盘主要由高强度铝合金和不锈钢材料构成,兼顾轻量化与强度,并经过精密焊接与表面处理,具有较强的耐腐蚀性能,适用于长期田间作业。机器人底盘还支持全方位运动,四轮均可绕垂直轴旋转90°,实现灵活转向,提高田间作业效率。

在相机和传感器的安装方面,底盘采用双圆盘啮合调节机构来实现拍摄角度的调整,适配不同生育阶段的表型采集需求。底盘预留了扩展接口,支持附加模块,从而满足多任务作业需求并支持功能升级。根据表型机器人的尺寸和机械要求,利用Solidworks构建了机器人的3D模型,田间小麦表型鉴定机器人底盘结构如图2所示,实物如图3所示。整车长230 cm、宽160 cm、高150 cm,车轮直径为50 cm。在实际测试中,机器人有效载荷约为100 kg,配备60 V、30 A·h锂电池,可连续运行约5 h。田间测试结果表明,该机器人在松软或湿滑的地形中表现出卓越的越障能力和抓地力,同时有效减少了地形颠簸对表型数据采集精度的干扰。铰接式底盘设计提高了机器人通过田垄和坑洼地形的平稳性,确保传感器采集到高精度数据,最大程度减少对作物和地表的破坏。这种底盘结构既满足了田间表型信息高通量采集的技术需求,也为精准农业和作物改良研究提供了可靠的硬件支撑。

图2 田间小麦表型机器人底盘结构图

Fig.2 Chassis structure diagram of field wheat phenotyping robot

1.滑台模组 2.机器人车架 3.车轮转向电机轴 4.高地隙车轮 5.锂电池 6.轮距横向调节机构 7.机器人控制系统 8.车轮驱动电机 9.传感器固定底座 10.支架 11.齿盘式角度调节机构 12.车架支撑横梁 13.铰接关节连接轴

图3 小麦表型机器人底盘实物图

Fig.3 Physical prototype of wheat phenotyping robot chassis

1.滑台模组 2.机器人车架 3.车轮转向电机轴 4.高地隙车轮 5.锂电池 6.轮距横向调节机构 7.机器人控制系统 8.车轮驱动电机 9.传感器固定底座 10.支架 11.齿盘式角度调节机构 12.车架支撑横梁 13.供电模块 14.边缘计算设备 15.可视化屏幕 16.导航接收器 17.实时位置观测相机 18.RGB相机

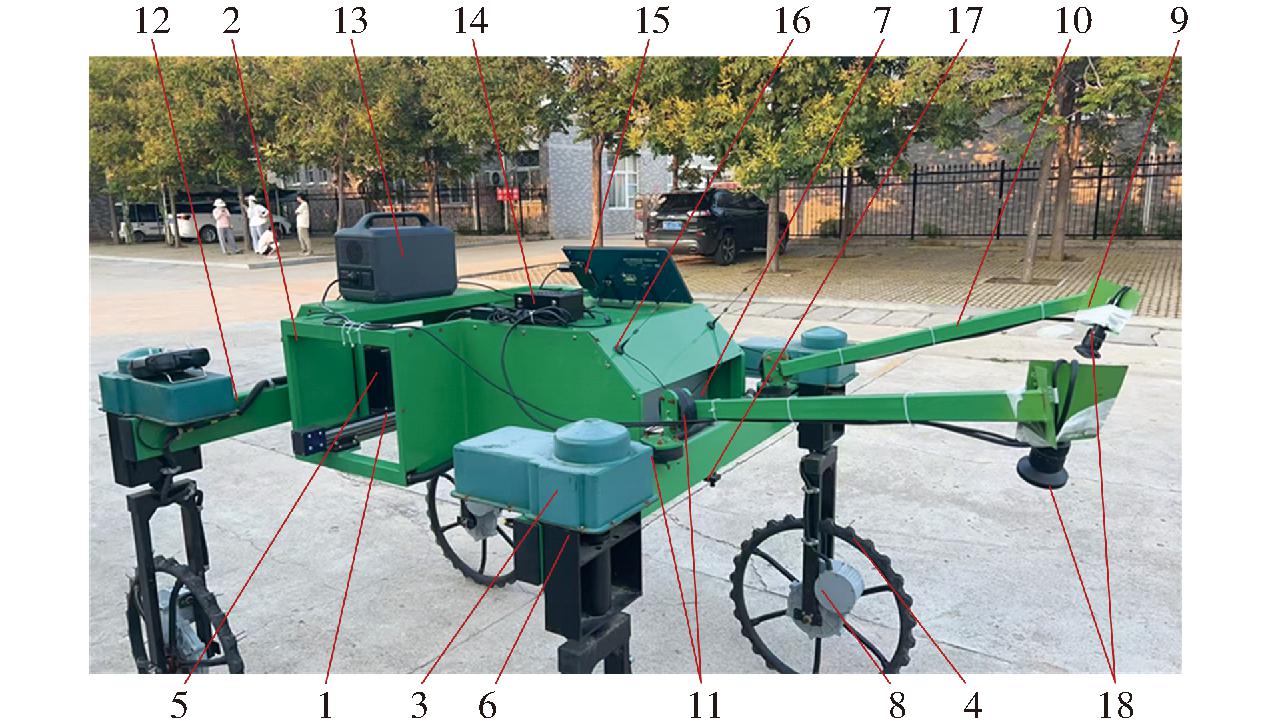

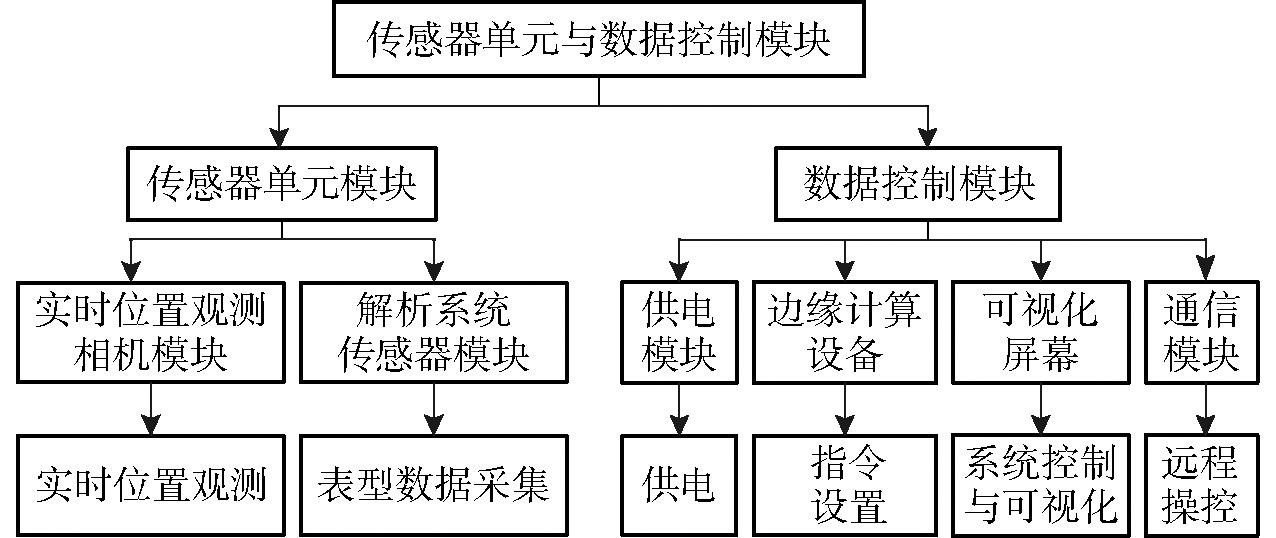

传感器单元与数据控制模块由传感器单元模块和数据控制模块组成,如图4所示。其中,传感器单元模块包括实时位置观测相机模块和小麦表型解析系统传感器模块。实时位置观测相机模块固定安装于底盘底部,主要用于实时监测底盘的运行状态及作物生长状态等信息,并将监测数据实时传输至数据控制模块以保障机器人运动的稳定性与安全性。小麦表型解析系统传感器模块固定安装在滑台模组底部和传感器固定底座上,负责采集小麦表型关键数据。本系统选用华睿A7500CG20作为核心成像传感器,具备500万像素的分辨率(2 448像素×2 048像素),全局快门成像性能,并可在帧率24 f/s下高效运行,功耗仅为3.8 W,适合田间复杂环境。相机搭载1.1英寸、2 000万像素的6 mm镜头,实现超高清分辨率成像,确保小麦表型特征的精准采集与清晰记录。

图4 传感器单元与数据控制模块构成图

Fig.4 Diagram of sensor unit and data control module composition

数据控制模块由边缘计算设备、供电模块、可视化屏幕和通信模块构成。边缘计算设备固定安装于机器人车体上方,与传感器单元模块连接,负责对采集数据的实时处理与存储。电源适配器为设备提供稳定供电,确保长时间运行。可视化屏幕实时显示传感器采集的图像和解析的结果数据,用户可以通过触控界面调取采集图像和视频数据,并查阅传感器采集的实时数据及历史记录。通信模块通过TCP/IP协议支持边缘计算设备与手机客户端的无线通信,可在局域网或Wi-Fi环境下实现机器人与客户端的实时数据交互和远程操控。手机客户端分为控制组件、传感器数据组件和表型解析组件,界面以全屏模式显示车载摄像头画面,支持远程调整摄像头视角及表型数据采集功能。系统集成的通信框架及客户端功能设计高效且便捷,为小麦表型数据的高精度采集和实时解析提供了重要支持。

对作物发育生长阶段的监测是作物育种和精准农业中至关重要的组成部分。小麦关键生育期表型解析系统旨在实现小麦关键生育阶段(如出苗期、开花期和抽穗期)表型的精准检测与自动化解析。系统融合多传感器与边缘计算并集成出苗检测方法与前期研究提出的抽穗期监测及开花期判定等表型解析方法,实现了高通量、多场景、多尺度的表型数据采集与分析,能够精准捕获小麦在关键生育期的表型特征,如出苗数、小花数、小穗数、麦穗数、抽穗期和开花期等,并生成统计图表和生长趋势分析结果。与传统人工测量相比,小麦关键生育期表型解析系统显著提高了表型数据的解析效率和精度,同时降低了劳动强度与主观性强的问题,为提高育种进程中的表型解析效率提供了技术支撑。

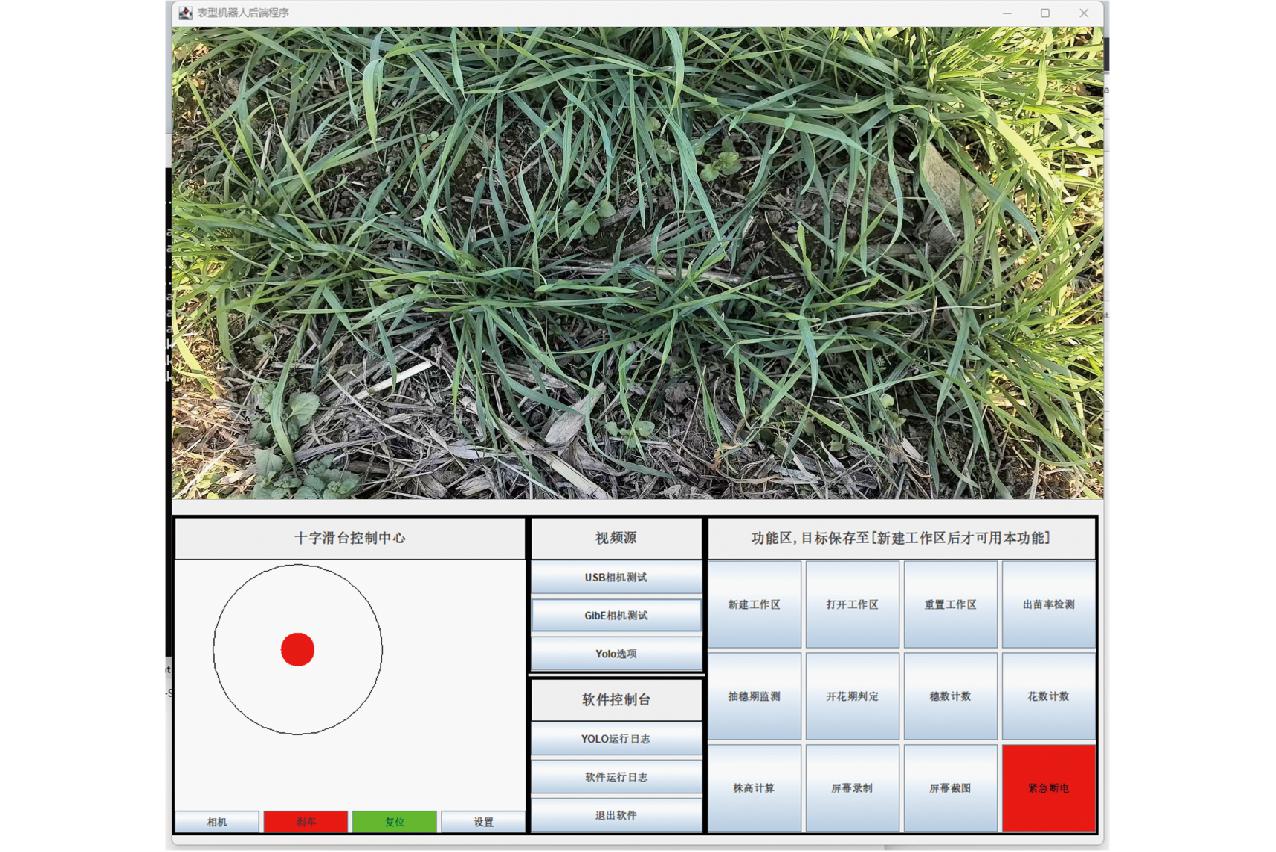

本研究构建的小麦表型解析系统集成了小麦出苗数检测及前期研究提出的抽穗期监测和开花期判定等表型解析方法,并通过现代化软件开发技术设计了直观且功能丰富的用户界面,实现了关键生育期表型数据的精准检测与可视化解析。系统用户界面采用模块化设计,基于Java Swing框架开发,具备简洁明了的布局和高度可操作性,用户无需复杂的技术背景即可快速熟练使用。功能层面,用户界面集成了小麦出苗数检测、抽穗期监测和开花期判定等核心算法,并提供数据采集、实时结果展示、参数设置和组件控制等多项功能。此外,系统支持通过标准串口协议(如RS-232和RS-485)与外部硬件设备(如滑动模组)进行数据交互,增强了设备兼容性和应用场景的多样性。为增强交互性,系统支持图表动态生成、实时数据可视化及结果导出,并通过移动端支持功能实现与智能手机的联动操作,为用户提供随时随地访问和管理系统的便利。为确保软件运行的稳定性与扩展性,系统模块化设计采用Docker技术,封装各功能模块,从而保证开发与部署环境的一致性。此外,利用SQL和NoSQL数据库(如MySQL和MongoDB)存储和管理大规模表型数据,支持高效的数据查询和更新操作。小麦表型解析系统用户界面如图5所示。

图5 表型解析系统用户界面

Fig.5 Phenotyping analysis system interface

在数据采集和分析方面,系统的相机模块通过OpenCV实现高性能的图像处理和视觉数据分析,支持小麦表型特征的精准提取。同时,软件提供了Python和JavaScript脚本的调用接口,便于用户自定义算法扩展和功能优化。脚本执行由ProcessBuilder调度,实现了多线程任务管理和并发处理,进一步提升了系统的响应速度和稳定性。为确保系统日志管理的高效性,采用log4j2框架记录并追踪运行状态,通过内嵌日志功能实时显示软件运行情况,增强了操作的透明性与可追溯性。在表格数据的处理与可视化展示方面,系统使用Apache POI库进行数据的读取、写入和格式化,支持灵活的表型数据管理与输出。

作物出苗的准确测量对于评估土壤和环境对出苗的影响至关重要[19]。在小麦育种研究中,出苗密度是决定作物生长和产量优化的重要农艺因素,同时在基因型筛选和比较分析中起到关键作用[20-21]。此外,通过检测小区中的出苗数和抽穗数,可进一步评估小麦品种的有效分蘖数[22]。目前,传统田间幼苗计数依赖专业人员的视觉观察,但这一过程耗时费力,劳动强度大,不适合大面积田间试验[23-24]。尤其在降雨或霜冻等不良天气后,田间土壤条件可能限制其在田间行走,进一步降低了表型数据解析的效率和时效性。

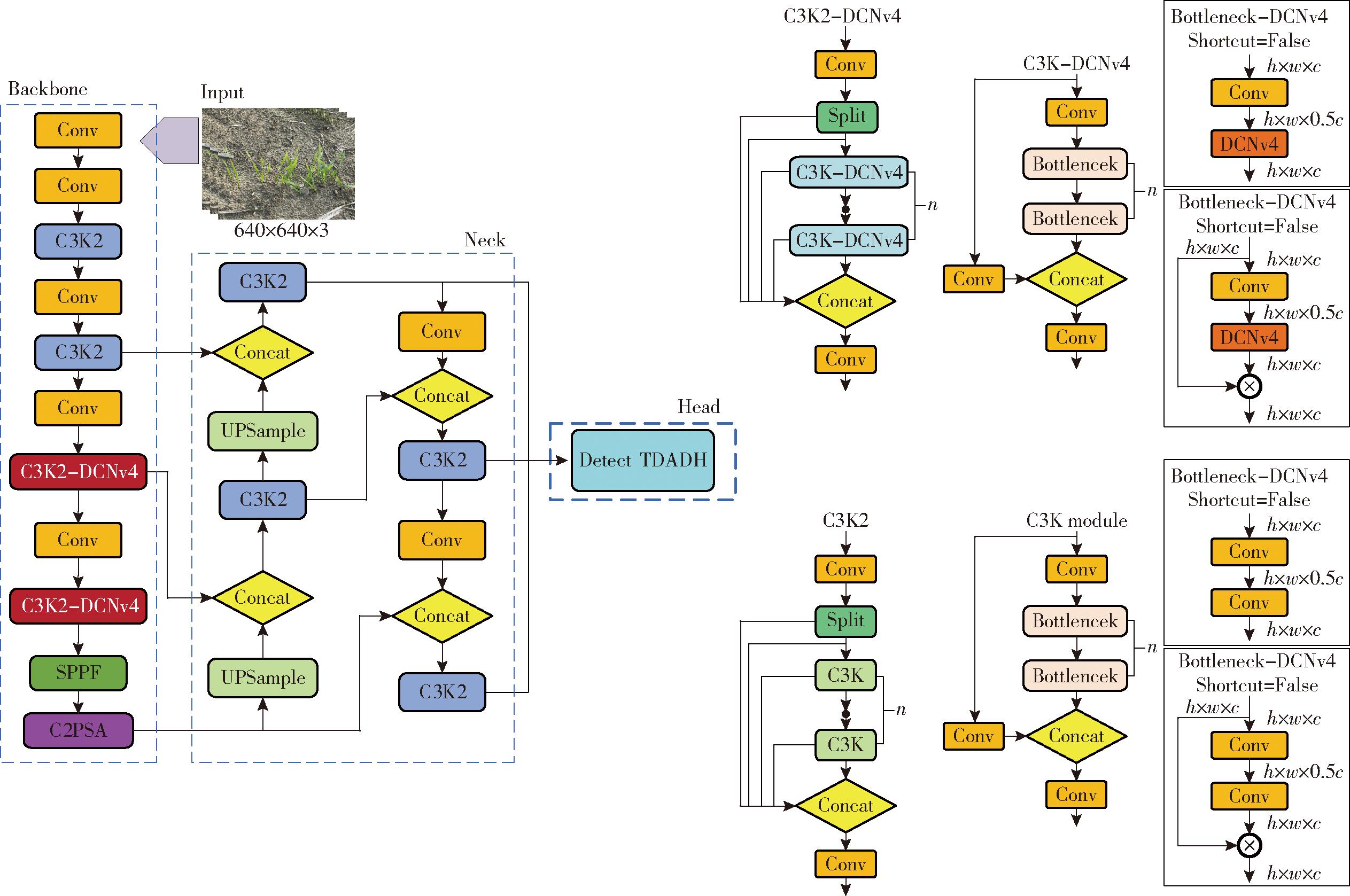

为此,本研究提出一种轻量化的TD-YOLO v11模型,用于实现小麦出苗检测。YOLO v11模型是YOLO目标检测系列的最新进展,其架构包括骨干网络(Backbone)、颈部网络(Neck)和检测头网络(Head)[25]。YOLO v11在以往YOLO模型的基础上专注于优化特征提取过程和模型的整体设计,在检测精度和计算需求之间取得更有效的平衡[26]。该模型引入基于Transformer的特征提取模块,并集成了C3K2和C2PSA模块,增强了特征捕获能力,特别适合检测小目标和部分遮挡目标[27]。总体而言,YOLO v11模型实现了速度与精度的均衡,具有适用于高性能计算环境的高效特征提取和检测能力,适用于边缘设备部署。因此,综合考虑模型准确率与速度,选择YOLO v11模型作为基线模型。然而,在密集场景下检测小麦幼苗时,YOLO v11的检测精度仍存在改进空间。

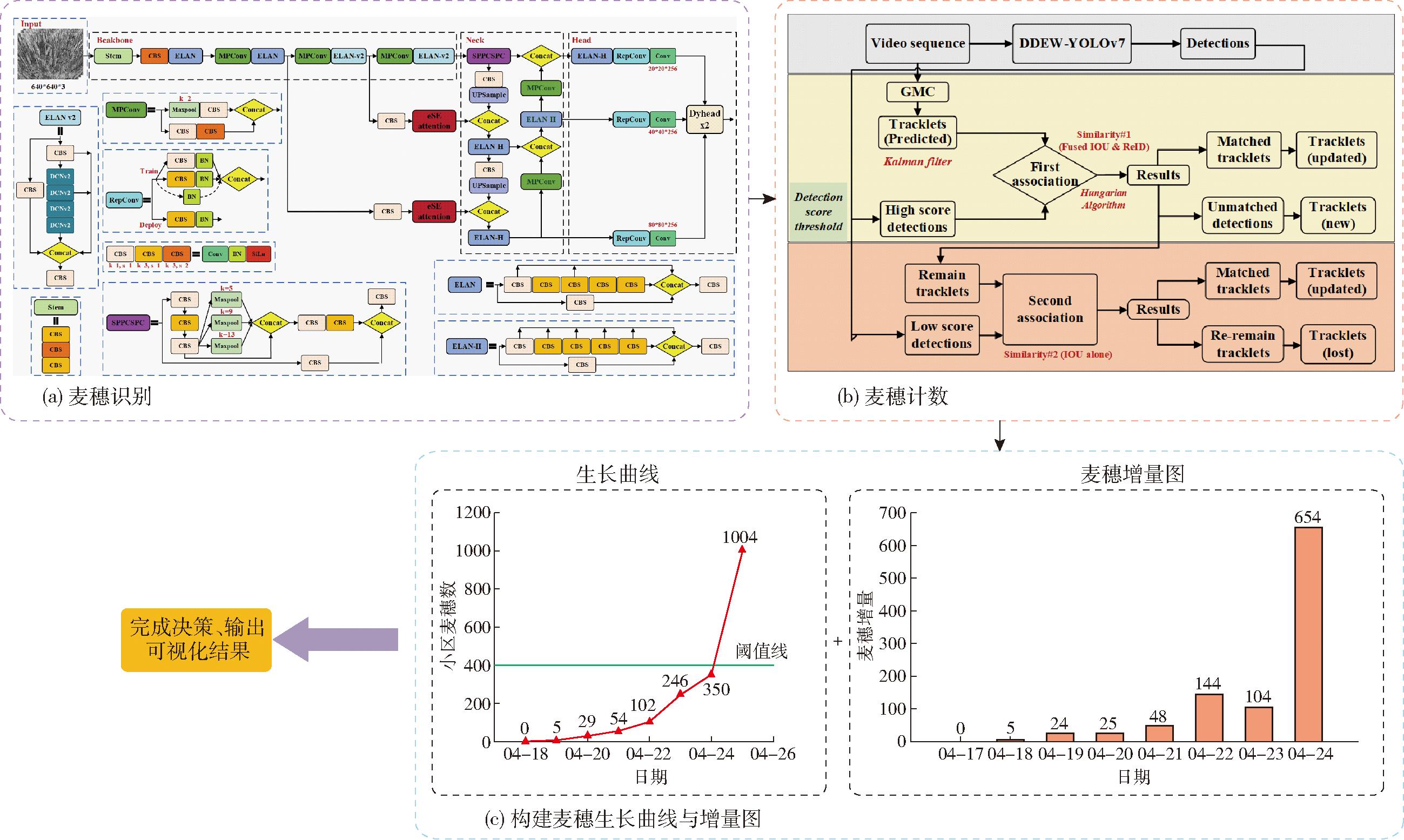

因此,本文针对小麦出苗的特殊场景对模型进行了优化,提出了改进模型TD-YOLO v11,改进后的网络模型结构如图6所示。该模型包含两项关键改进,首先,用可变性卷积模块(Deformable convolutional v4,DCNv4)替换特征提取网络中一些卷积模块来优化特征融合网络。可变形卷积(DCN)系列模块保留了卷积的优点,并将稀疏注意力与自适应小窗口聚集相结合,具有更快的收敛速度和卓越的性能。通过将DCNv4与C3K2模块相结合扩大了感受野,增强了提取全局信息的能力,同时用更少的网络参数提取特征,降低了计算复杂度与参数量,实现精度与参数的权衡。然后,引入任务动态对齐检测头(Task dynamic align detection head,TDADH)以进一步利用来自颈部层的信息,通过动态选择特征,促进分类和定位任务之间的一致性,确保模型能够在检测过程中优化分类和定位性能。

图6 TD-YOLO v11模型结构图

Fig.6 Structure diagram of TD-YOLO v11 model

3.2.1 可变性卷积网络DCNv4

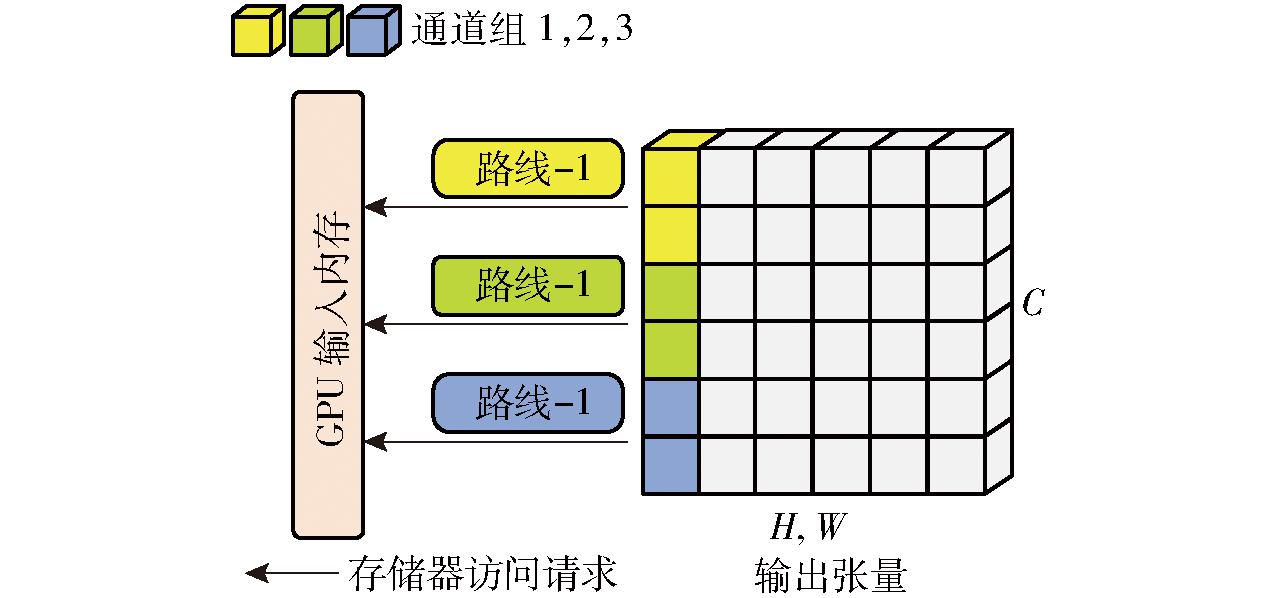

为提升YOLO v11网络在小麦出苗数检测中的性能,尤其是在小目标检测方面的表现,本文引入DCNv4模块对YOLO v11进行改进[28]。传统卷积在处理小目标时,容易引入大量无关的上下文信息,这些冗余信息会干扰特征提取过程,从而影响检测精度。为此,本研究采用DCNv4模块替代YOLO v11骨干网络中的部分卷积,显著提高了特征提取的针对性和网络性能。DCNv4模块结构如图7所示。

图7 DCNv4模块结构图

Fig.7 Diagram of DCNv4 module architecture

与固定采样的传统卷积不同,DCNv4模块通过生成偏移量和调制参数,动态调整规则采样点的分布,从而自适应地根据目标的形状和空间位置捕捉特征[29-30]。这种灵活的采样方式不仅有效提升了模型对形态变化和复杂背景的适应能力,还优化了特征提取的效率。同时,DCNv4模块结合自适应空间聚合机制,克服了传统卷积在空间建模和长距离依赖上的不足,进一步加快了模型的收敛速度,增强了推理效率,降低了计算复杂度与参数量,使其更加适合边缘计算设备的部署[31-32]。本文通过将DCNv4模块与C3K2模块结合,显著增强了网络对小麦苗期几何形变的适应能力,并在保证计算效率的基础上提升了检测精度。

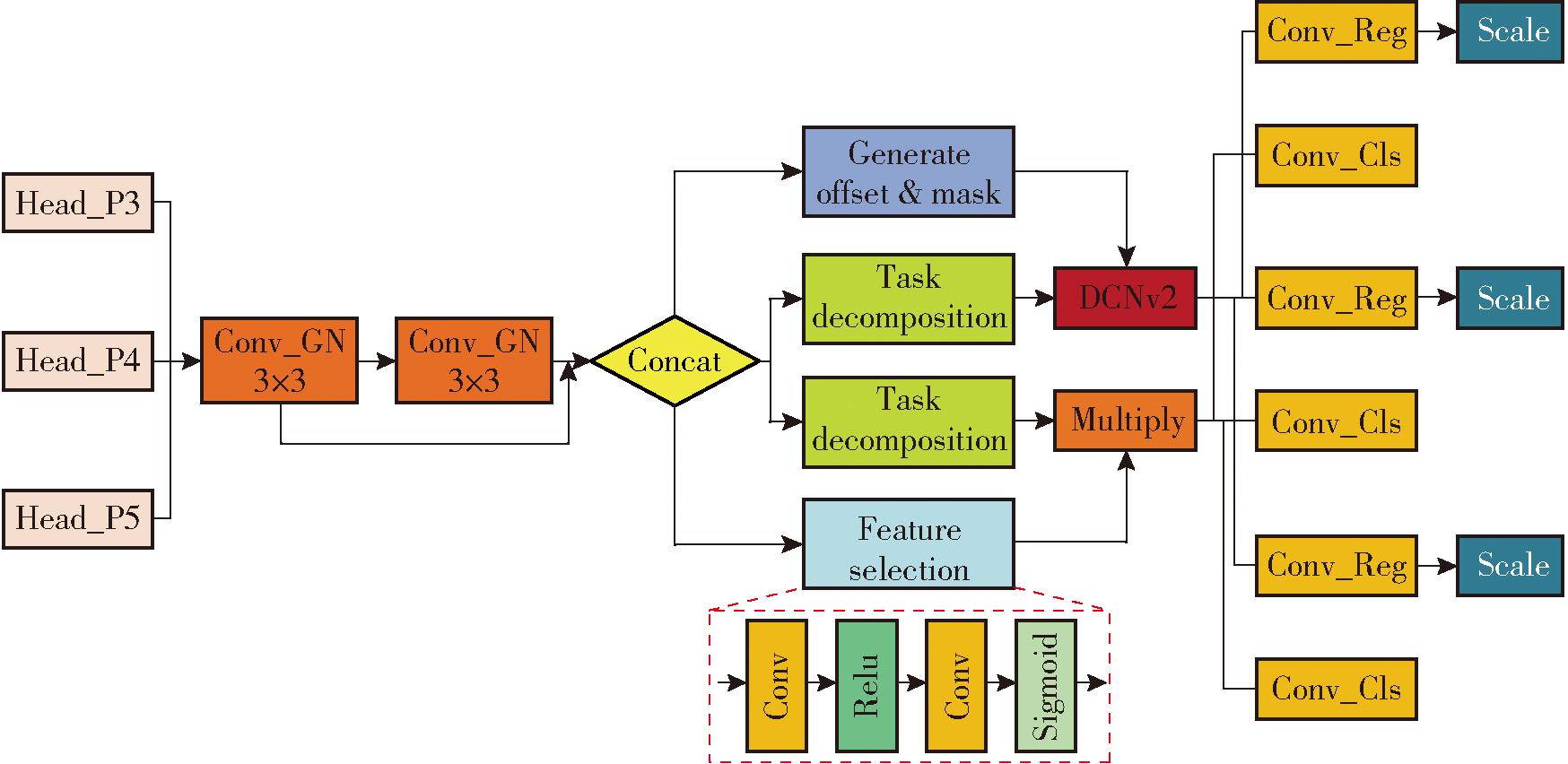

3.2.2 任务动态对齐检测头(TDADH)

现有目标检测算法通常采用独立的分类和定位分支设计,导致两个任务之间缺乏充分交互,从而限制了模型的综合性能。为此,本研究在YOLO v11检测头中引入了一种任务对齐动态检测头,通过任务分解和动态特征对齐策略,显著提升出苗数检测任务的精度和效率,并有效降低了计算复杂度[33]。

TDADH首先通过两个共享的组归一化(Group normalization,GN)卷积块提取高质量输入特征。GN卷积块不依赖批量大小,适用于小样本场景,显著提升了分类和定位性能。提取的共享特征随后进入任务分解模块:分类分支提取类别表征特征,回归分支提取回归特征,为后续任务提供针对性的输入,确保分类与定位的精确性[34]。在定位任务中,TDADH引入动态特征对齐模块,利用可变形卷积网络(Deformable convolutional networks v2,DCNv2)生成偏移量(offset)和掩码(mask),动态调整卷积核以适应目标在位置、尺度及形态上的变化,从而提升边界框拟合精度。分类分支结合层次化注意力机制与交互特征动态选择分类特征,并通过Sigmoid 函数对输出进行归一化,确保分类结果的准确性。为解决目标尺度适配问题,在输出端,TDADH模块加入特征缩放模块(Scale),动态调整特征尺度。在推理阶段,结合分布焦距损失(Distribution focal loss,DFL)对边界框回归值进行解码,进一步提升边界框的定位精度。通过任务分解和动态对齐策略,TDADH有效解决了分类与定位任务之间交互不足的问题,大幅提升了检测效率和精度,同时显著减少了模型参数数量,使其更加轻量化和高效。在复杂的小目标检测场景中,TDADH结合层次化注意力机制增强了特征提取能力,表现出卓越的检测性能和资源适应性,适合部署于边缘计算设备等资源受限的平台上[35]。TDADH模块结构如图8所示。

图8 TDADH模块结构图

Fig.8 Diagram of TDADH module structure

3.2.3 数据集构建与评价指标

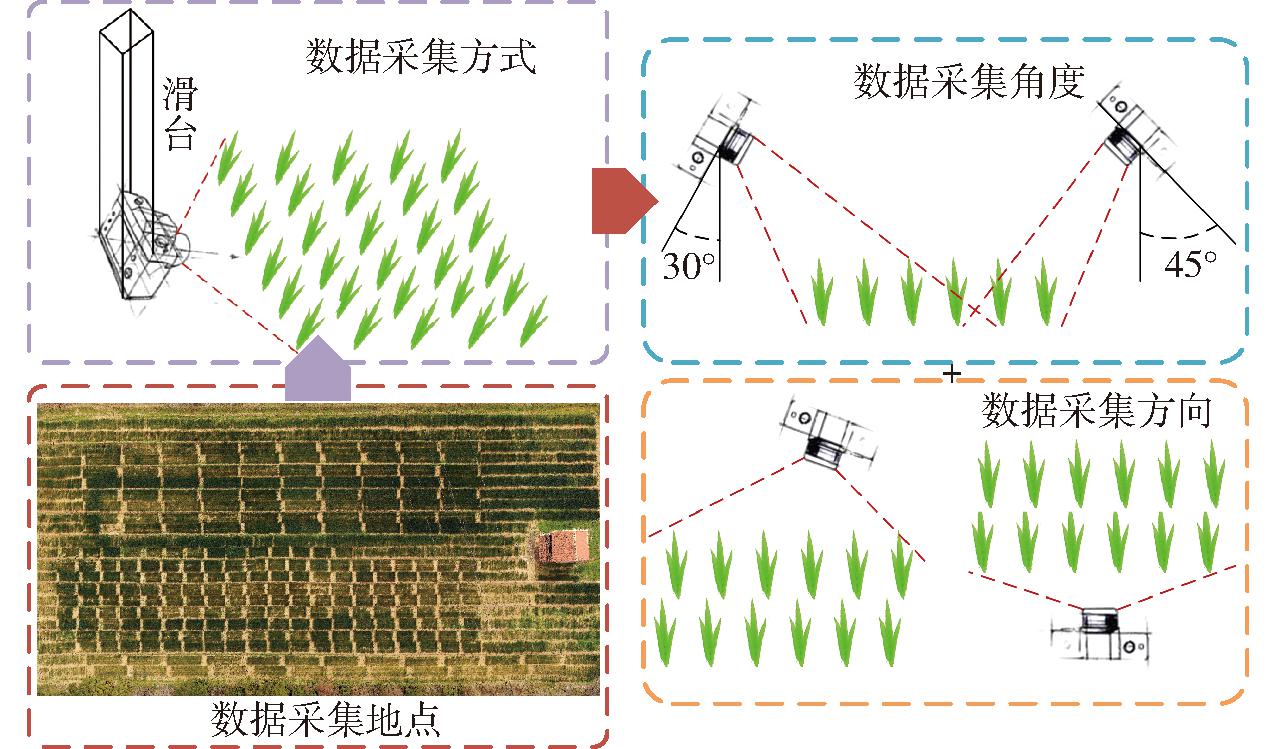

数据采集区域位于山东省泰安市山东农业大学农学试验站(36.90°N,117.90°E),本研究采用表型机器人进行图像采集以确保数据一致性,采集过程如图9所示。为了确保数据的多样性并增强模型在复杂条件下的泛化性,从多角度、多方位采集晴天和阴天、不同时段、不同品种和不同密度的出苗图像。试验田块种植了多个小麦基因型,每小区种植一个基因型,种植时间为10月至次年6月,播种密度为100~150粒/m2,数据采集时间为播种后7~20 d。

图9 出苗期数据采集过程

Fig.9 Seedling emergence data collection process

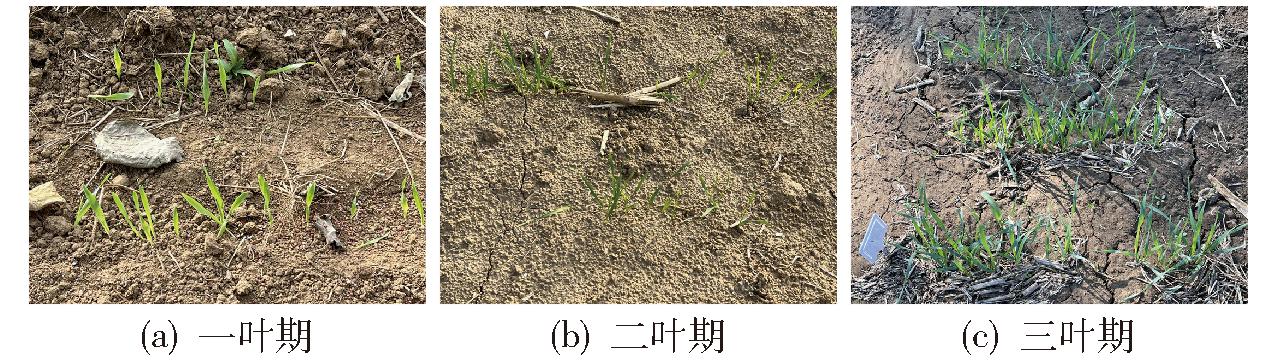

为确保覆盖小麦出苗的关键阶段,选取小麦一、二、三叶期的图像进行数据采集(如图10所示)。随后,利用T-Rex Label工具对图像中的幼苗位置进行精确标注,标注类别为“spike”。标注后生成标准化的txt格式标签文件,其中包含矩形标注框的类别、相对高度、宽度以及中心点坐标等信息。最终构建了包含1 838幅图像的数据集,涵盖不同的小麦品种(如山农48、济麦44、山农27以及杂交品种等)、种植密度和多种天气条件。数据集按8∶2比例随机划分为训练集与验证集,用于模型训练和测试。

图10 小麦出苗图像

Fig.10 Wheat seedling emergence images

选取精确率(Precision,P)、召回率(Recall,R)、平均精度均值(mean Average Precision,mAP)、参数量和浮点运算次数(Floating-point operations per second,FLOPs)对模型的运算效率与复杂度进行评价。

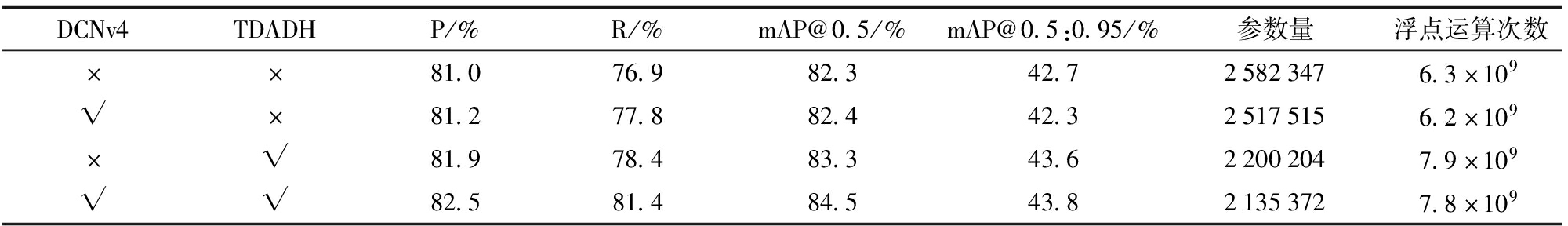

3.2.4 消融实验

为了证明所提出的改进策略在原始YOLO v11模型上的有效性,在小麦出苗数据集上对TD-YOLO v11模型中的DCNv4模块、TDADH模块分别进行消融实验,结果如表1所示,表中×表示未采用此模块,√表示采用此模块;mAP@0.5表示交并比阈值设定为0.5时计算得到的平均精度均值,mAP@0.5:0.95表示交并比阈值从0.5递增至0.95,取10个阈值下的mAP值,并计算其平均值。

表1 消融实验结果

Tab.1 Results of ablation experiments

DCNv4TDADHP/%R/%mAP@0.5/%mAP@0.5:0.95/%参数量浮点运算次数××81.076.982.342.725823476.3×109√×81.277.882.442.325175156.2×109×√81.978.483.343.622002047.9×109√√82.581.484.543.821353727.8×109

根据实验结果,加入DCNv4模块和TDADH后,模型在多个评估指标上均有所提升,尤其是R(从76.9%提升至81.4%)和mAP@0.5(从82.3%提升至84.5%)指标表现尤为突出。通过这两个模块的优化,模型在处理小目标检测时的能力得到增强,特别是在复杂背景下,目标形态和尺度变化的适应性得到了改善。在计算复杂度方面,尽管引入DCNv4和TDADH后,浮点运算次数有所增加(从6.3×109提升至7.8×109),但参数量减少了446 975,表明该模型在精度和计算效率之间实现了有效平衡。尤其是在参数量减少的同时,模型的存储需求和推理效率得到优化,具备了更好的适应性和扩展性。这种性能与复杂度的平衡使得改进后的模型不仅适用于高精度的目标检测任务,也能够在边缘计算平台等资源受限的场景下部署和应用。总体而言,提出的TD-YOLO v11模型通过有效集成DCNv4和TDADH,显著提高了检测精度和适应性,同时在计算资源上实现了优化,适用于复杂田间环境中的小麦出苗高效、精确监测。

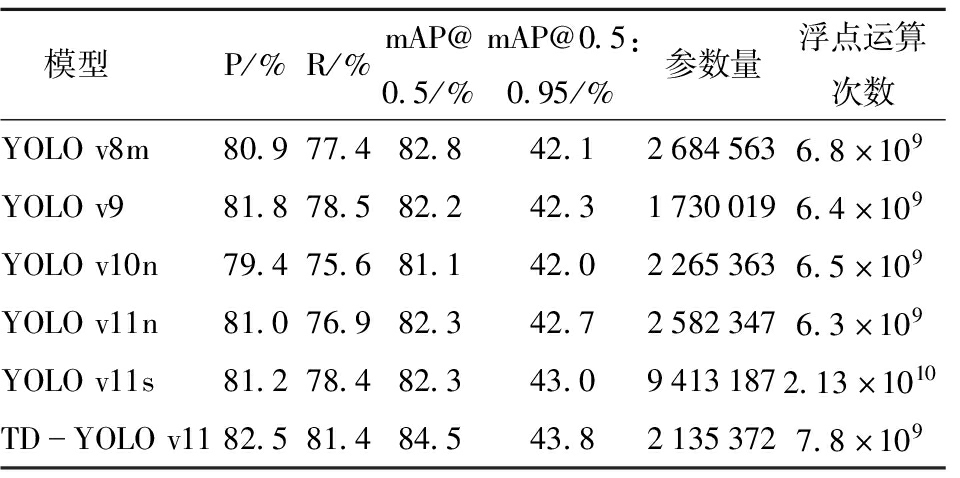

3.2.5 出苗检测模型性能对比

为全面评估TD-YOLO v11模型在小麦出苗检测任务中的综合性能,将其与YOLO v8m、YOLO v9、YOLO v10n、YOLO v11和YOLO v11s等当前主流的轻量化目标检测模型在测试集上进行对比实验,实验结果如表2所示。

表2 不同出苗检测模型性能对比

Tab.2 Performance comparison of different seedling emergence detection models

模型P/%R/%mAP@0.5/%mAP@0.5:0.95/%参数量浮点运算次数YOLOv8m80.977.482.842.126845636.8×109YOLOv981.878.582.242.317300196.4×109YOLOv10n79.475.681.142.022653636.5×109YOLOv11n81.076.982.342.725823476.3×109YOLOv11s81.278.482.343.094131872.13×1010TDYOLOv1182.581.484.543.821353727.8×109

本研究所提出的TD-YOLO v11模型相比于YOLO v11模型准确率、召回率、mAP@0.5和mAP@0.5:0.95分别提高了1.5、4.5、2.2、1.1个百分点。与对比模型中性能表现最好的YOLO v9模型相比,TD-YOLO v11模型准确率、召回率、mAP@0.5和mAP@0.5:0.95分别提高了0.7、2.9、2.3、1.5个百分点。尽管浮点运算次数有所增加,但模型的计算复杂度提升带来了性能的显著提高,且参数量减少了446 975,有效优化了计算效率和存储需求,使得模型在边缘计算设备上的部署更加高效。这一结果表明,TD-YOLO v11模型在出苗检测识别中,能够提供良好的整体性能,是完成识别任务的优选模型。

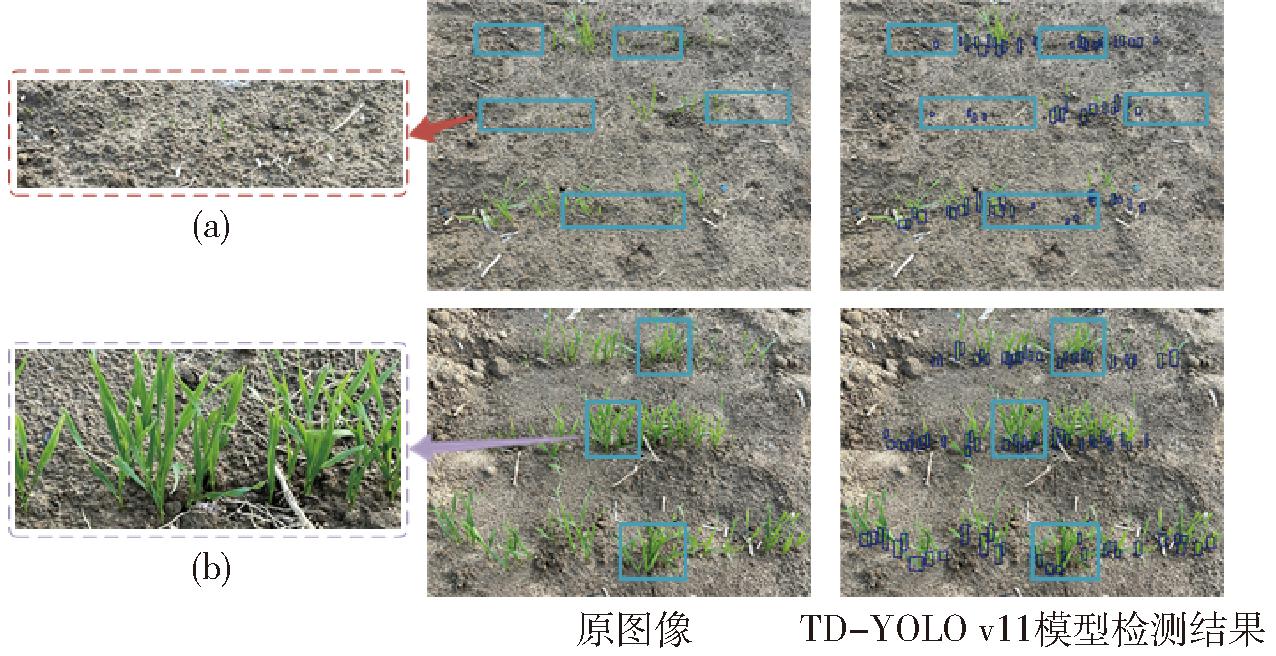

为验证改进模型在出苗检测任务中的综合性能,本研究在测试集上进行试验。结果显示,部分检测结果较差,如图11所示。图中,蓝色框为出现漏检目标的情况,箭头指示了对应的放大图像。如图11a所示,在小麦生长初期,部分植株由于生长缓慢未进入一叶期,目标较小且受土壤噪声的干扰难以进行检测。此外,如图11b所示,在小麦生长至二、三叶期时,部分小麦叶片生长茂密,造成严重的遮挡问题。因此,这些问题导致模型训练精度难以进一步提高。基于此,后续试验针对一、二叶期小麦进行出苗检测,以验证模型的检测精度。

图11 TD-YOLO v11模型在测试集上检测结果

Fig.11 Detection results of TD-YOLO v11 model on test set

3.2.6 模型实际应用验证

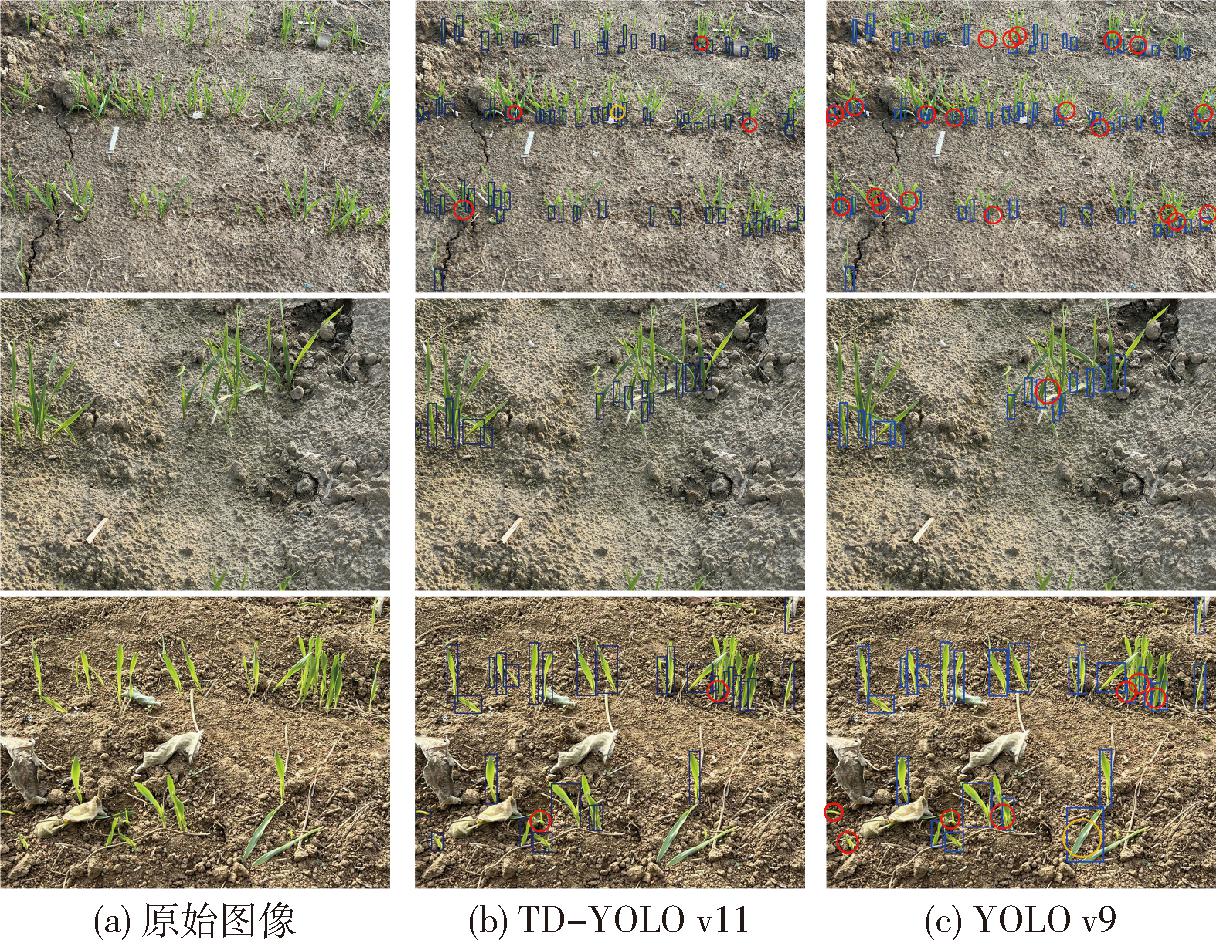

为直观验证提出的TD-YOLO v11模型的检测效果,将改进模型与表现最好的YOLO v9模型在边缘计算设备进行了部署,并针对一、二叶期小麦进行检测。检测结果如图12所示,其中,红色圆圈标注了漏检目标,黄色圆圈标注了误检目标。实验过程中,TD-YOLO v11能够以速度51.28 f/s进行实时推理,而YOLO v9模型的推理速度为61.35 f/s。

图12 出苗检测模型测试结果对比

Fig.12 Comparison of test results of seeding detection models

检测结果显示,在出苗密度较高的情况下,TD-YOLO v11模型出现了少量漏检的情况,但在同样的测试图像上表现出更好的检测性能,能够有效识别出YOLO v9模型遗漏的目标。尽管改进模型相较于YOLO v9在推理速度上有所下降,但依然满足田间出苗检测任务对于实时性的需求,同时从图12可以看出TD-YOLO v11模型对小麦出苗有很好的识别效果,性能远优于其他模型。

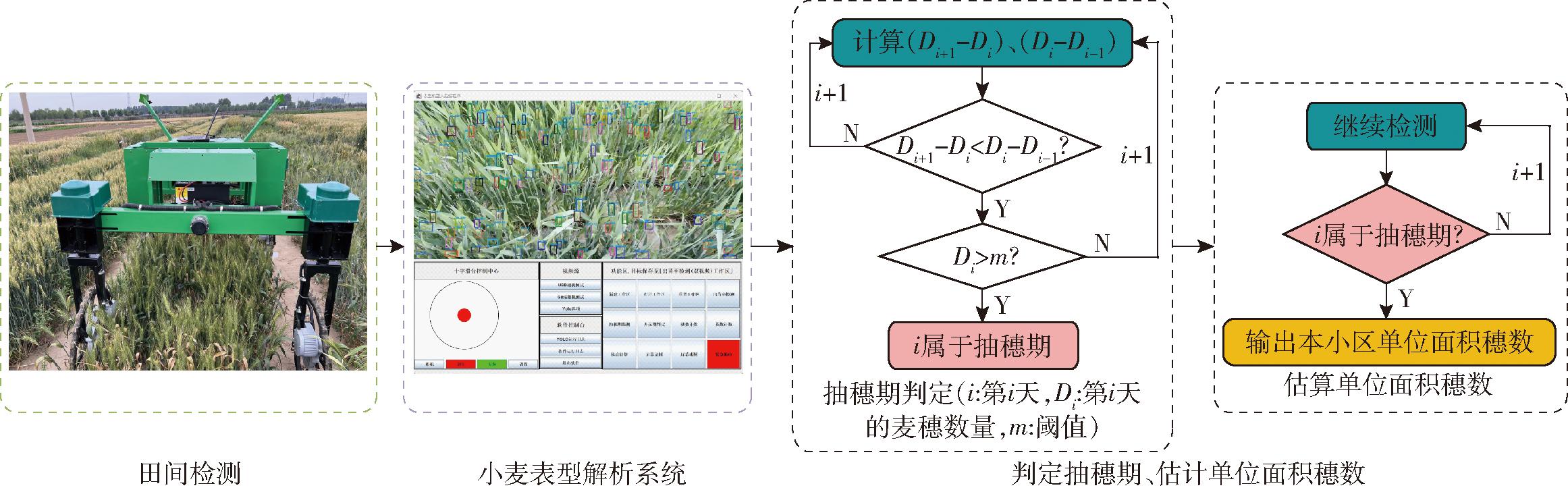

抽穗期是小麦生殖周期中最关键的时期之一,标志着小麦从营养生长转变到生殖生长[36]。这一时期的麦穗数和抽穗时间等性状不仅反映了小麦的生长发育状况,还影响着灌浆期,最终影响产量。监测抽穗期有助于育种者评估小麦生长速度、生长周期、抗逆性、环境适应性,并有助于识别具有强适应性和最佳抽穗特性的基因型,指导制定有效的育种策略[37]。根据农艺学标准,田间小麦群体抽穗期判定标准为田间植株中50%以上的植株完成抽穗[38]。

基于前期研究提出的田间小麦抽穗期实时监测方法开展应用,将其集成至小麦表型解析系统中,实现抽穗期的动态监测,判定抽穗期并估算单位面积穗数[39]。田间小麦抽穗期实时监测流程如图13所示。

图13 田间小麦抽穗期实时监测流程图

Fig.13 Flowchart for real-time monitoring of heading date of wheat in field

其中,小麦表型解析系统在抽穗期监测流程如图14所示。首先基于前期研究提出算法完成麦穗的检测与计数,并基于每日检测结果构建小麦穗生长曲线和生长图。然后系统完成决策并输出可视化结果。

图14 小麦表型解析系统抽穗期监测流程图

Fig.14 Flowchart for heading stage monitoring in wheat phenotyping analysis system

小麦开花期是小麦育种过程中研究的关键阶段,其对产量、品质和抗逆性具有重要影响[40]。开花期的准确监测不仅能够为田间管理提供数据支撑,还对育种目标的实现起到重要作用[41]。通过对开花期表型特征的动态监测,可为发掘调控开花的关键基因提供数据支持,进而加速分子标记辅助育种的进程[42]。根据农艺学标准,田间小麦群体开花期判定标准为田间植株中50%以上的小穗达到开花状态标准[38]。

基于前期研究提出的田间小麦开花期实时判定方法开展应用,将其集成至小麦表型解析系统中,实现开花期表型特征的自动化精准监测[43]。田间小麦开花期判定流程如图15a所示,表型机器人沿小麦垄前进,并将数据输入至小麦表型解析系统中完成小穗与小花数量的检测并判定开花期。其中,小麦表型解析系统在开花期的判定流程如图15b所示。首先在小区随机取样,然后将数据输入至前期研究提出算法,完成小花与小穗的检测并计算开花率。最后系统完成决策并将结果可视化。

图15 田间小麦开花期判定流程图

Fig.15 Flowchart for determining flowering stage of wheat in field

为评估所提出的基于表型机器人的小麦关键生育期表型检测方法的性能,本研究设计并开展了一系列田间试验,涵盖了小麦出苗期、抽穗期和开花期。通过多种评估指标对提出的基于表型机器人的小麦关键生育期表型检测方法性能进行验证分析。

田间试验于2023年10月在山东省泰安市泰山区的小麦试验田进行。小麦于2023年10月种植完成,试验分别在出苗期、抽穗期和开花期晴朗天气10:00—14:00开展。为保证数据采集的准确性,表型机器人沿小麦垄方向以0.1 m/s匀速直线行驶,实时通过手机查看表型解析结果。

为验证所提出方法的有效性,试验分别采用人工计数和系统检测两种方式对不同地块进行评估。每次试验完成后,由两名经验丰富的农艺家按照标准进行目测验证,确保人工与自动检测数据的一致性。选取决定系数(R2)、均方根误差(RMSE)和相对均方根误差(rRMSE)作为评价指标。

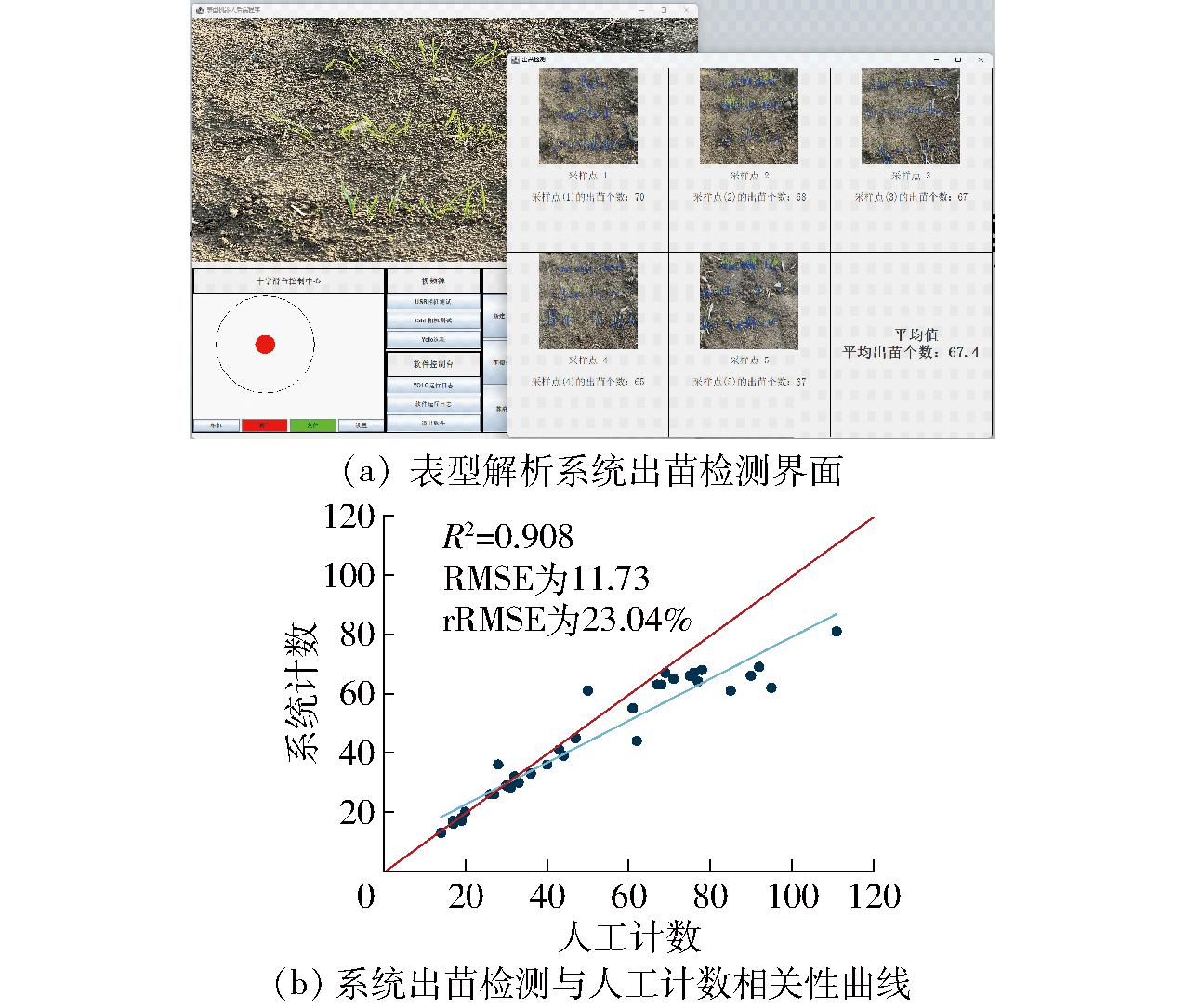

在出苗期的检测过程中,每个小区沿设定路径随机选取5个点进行测量,记录检测的出苗数量,并计算平均值作为该小区的出苗数。试验结果如图16所示,其中,图16a为所提出表型检测方法的出苗检测结果界面,图16b为出苗数检测结果的相关性曲线。

图16 田间出苗数检测结果

Fig.16 Seedling emergence rate detection results in field

结果表明,基于表型机器人的小麦关键生育期表型检测方法与人工测量结果高度一致,R2达到0.908,RMSE为11.73,rRMSE为23.04%。这些结果表明,改进的检测方法在小麦出苗期的识别精度和稳定性方面表现优异,能够有效地为小麦表型分析提供准确的数据支持。

利用提出的基于表型机器人的小麦关键生育期表型检测方法,本研究完成了抽穗期的实时监测。通过检测每个小区的麦穗数量,系统生成时序麦穗生长曲线与增量图,并记录每次检测日期及当天的麦穗数。当麦穗增量图发生变化且达到预设阈值时,系统自动判定抽穗期并估计本小区的单位面积穗数。试验结果如图17所示。

图17 田间抽穗期检测结果

Fig.17 Detection results of heading stage in field

结果表明,麦穗计数的检测结果与人工测量高度相似(R2=0.988),且RMSE和rRMSE分别为63.76和9.1%。验证了该方法小麦抽穗期动态实时监测的有效性。这一结果为后续的抽穗期判定及单位面积穗数估算提供了可靠的数据支持,为精准农业中的作物生长监测与产量预测奠定了基础。

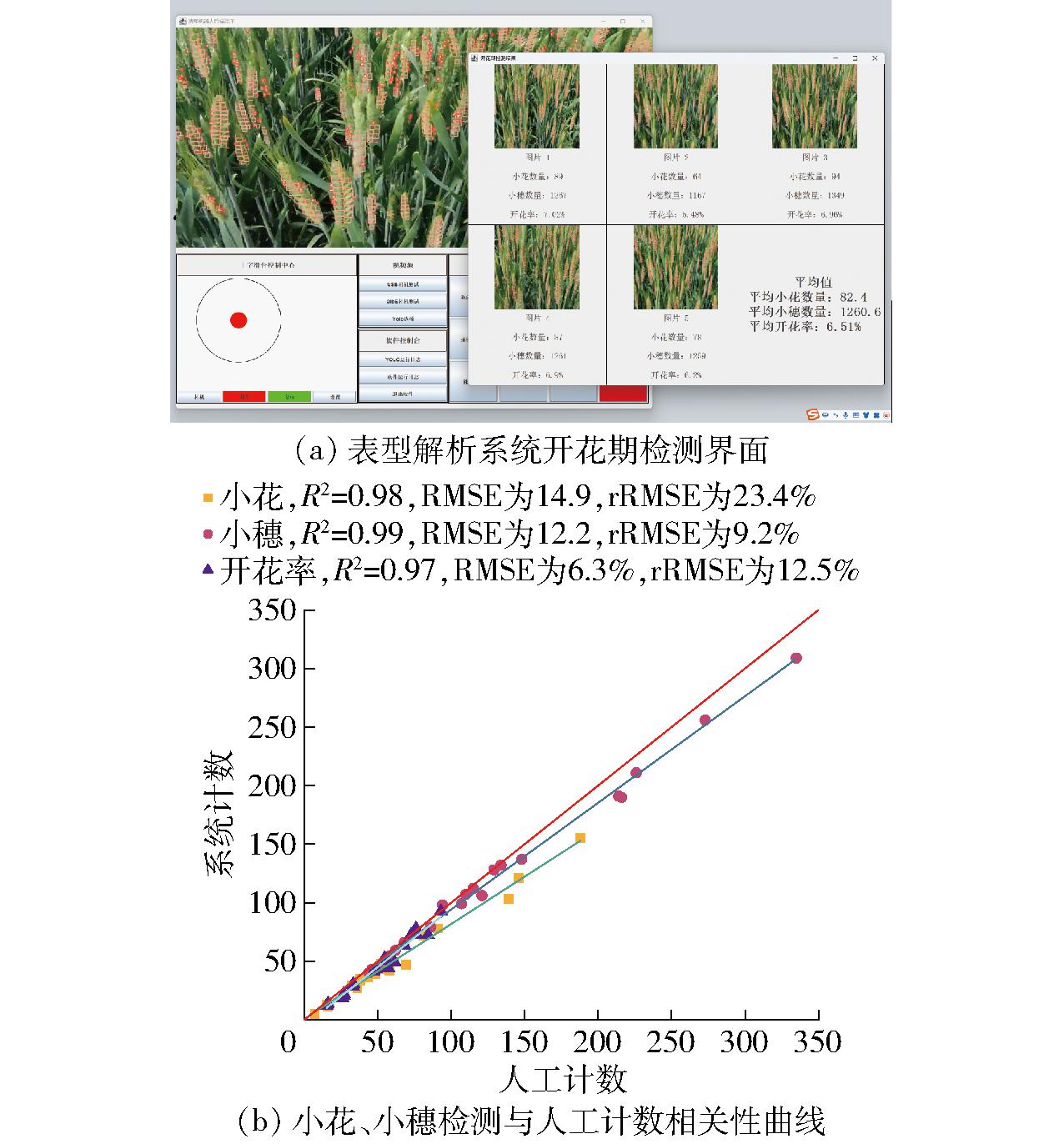

在开花期的检测过程中,每个试验小区沿设定路径随机选取5个点,分别检测小花和小穗的数量,以此计算开花率,并将其平均值作为该小区的开花率。通过提出的基于表型机器人的小麦关键生育期表型检测方法,当开花率超过50%时,小麦表型解析系统自动完成开花期的判定。试验结果如图18所示。

图18 田间开花期检测结果

Fig.18 Detection results of flowering stage in field

结果表明,所提出的系统能够准确捕捉小麦开花期的动态变化,开花率计算结果与人工测量高度相似(R2=0.97),且RMSE和rRMSE分别为6.3%和12.5%。这些试验结果验证了该系统在小麦不同生育期的表型检测能力,表明其具有较高的准确性和可靠性,且在实际田间应用中具有重要的价值。

(1)针对现有小麦表型数据采集与解析的自动化程度低、结构功能单一等问题,研制了小麦表型机器人底盘并提出一种基于表型机器人的小麦关键生育期表型检测方法。

(2)提出了TD-YOLO v11模型,实现了复杂田间环境下小麦出苗的检测,田间试验表明,提出的方法在小麦出苗期的识别精度和稳定性方面表现优异(R2为0.908,RMSE为11.73,rRMSE为23.04%)。

(3)通过田间试验验证,该小麦关键生育期表型检测方法有助于精确判定小麦的生长阶段,并对麦穗数、小穗数、花数和出苗数等关键表型性状进行准确检测,可以为育种表型检测提供高效、可靠的技术支持。

[1] 鲍文霞,赵诗意,黄林生,等.基于轻量级密集多尺度注意力网络的小麦叶部锈病识别方法[J].农业机械学报,2024,55(11):21-31.BAO Wenxia,ZHAO Shiyi,HUANG Linsheng,et al.Lightweight dense multi-scale attention network for identification of rust on wheat leaves[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(11):21-31.(in Chinese)

[2] PAUX E,LAFARGE S,BALFOURIER F,et al.Breeding for economically and environmentally sustainable wheat varieties:an integrated approach from genomics to selection[J].Biology,2022,11(1):149.

[3] CROSSA J,FRITSCHE-NETO R,MONTESINOS-LOPEZ O A,et al.The modern plant breeding triangle:optimizing the use of genomics,phenomics,and enviromics data[J].Frontiers in Plant Science,2021,12:651480.

[4] ATEFI A,GE Y,PITLA S,et al.Robotic technologies for high-throughput plant phenotyping:contemporary reviews and future perspectives[J].Frontiers in Plant Science,2021,12:611940.

[5] HU Q,FAN Z,ZHANG X,et al.Robust localization and tracking control of high-clearance robot system servicing high-throughput wheat phenotyping[J].Computers and Electronics in Agriculture,2025,229:109793.

[6] RUI Z,ZHANG Z,ZHANG M,et al.High-throughput proximal ground crop phenotyping systems—a comprehensive review[J].Computers and Electronics in Agriculture,2024,224:109108.

[7] 翟肇裕,张梓涵,徐焕良,等.YOLO算法在动植物表型研究中应用综述[J].农业机械学报,2024,55(11):1-20.ZHAI Zhaoyu,ZHANG Zihan,XU Huanliang,et al.Review of applying YOLO family algorithms to analyze animal and plant phenotype[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(11):1-20.(in Chinese)

[8] XU X,QIAO H,MA X,et al.An automatic wheat ear counting model based on the minimum area intersection ratio algorithm and transfer learning[J].Measurement,2023,216:112849.

[9] LI Y,MA R,ZHANG R,et al.A tea buds counting method based on YOLOV5 and Kalman filter tracking algorithm[J].Plant Phenomics,2023,5:0030.

[10] WANG Z,WALSH K,KOIRALA A.Mango fruit load estimation using a video based MangoYOLO-Kalman filter-hungarian algorithm method[J].Sensors,2019,19(12):2742.

[11] YOUNG S N,KAYACAN E,PESCHEL J M.Design and field evaluation of a ground robot for high-throughput phenotyping of energy sorghum[J].Precision Agriculture,2019,20(4):697-722.

[12] MUELLER-SIM T,JENKINS M,ABEL J,et al.The robotanist:a ground-based agricultural robot for high-throughput crop phenotyping[C]∥2017 IEEE International Conference on Robotics and Automation (ICRA).IEEE,2017:3634-3639.

[13] 姚照胜,刘涛,刘升平,等.农田信息采集车设计与试验[J].农业机械学报,2019,50(10):236-242.YAO Zhaosheng,LIU Tao,LIU Shengping,et al.Design and experiment of farmland information collection vehicle[J].Transactions of the Chinese Society for Agricultural Machinery,2019,50(10):236-242.(in Chinese)

[14] 刘英旋,万腾.轮式田间信息采集机器人开发与控制系统设计[J].农机化研究,2022,44(1):124-129.LIU Yingxuan,WAN Teng.Development and control system design of wheeled field information acquisition robot[J].Journal of Agricultural Mechanization Research,2022,44(1):124-129.(in Chinese)

[15] 唐政,余越,刘羽飞,等.田间作物表型获取无人车平台主体结构设计与优化[J].浙江大学学报(农业与生命科学版),2023,49(2):280-292.TANG Zheng,YU Yue,LIU Yufei,et al.Design and optimization of main structure of unmanned vehicle-based field crop phenotyping platform[J].Journal of Zhejiang University (Agriculture and Life Sciences),2023,49(2):280-292.(in Chinese)

[16] 汪小旵,李泽晟,陈彦宇,等.高地隙农田信息采集机器人设计与试验[J].农业机械学报,2023,54(6):65-77.WANG Xiaochan,LI Zesheng,CHEN Yanyu,et al.Design and experiment of farmland information collection robot[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(6):65-77.(in Chinese)

[17] YAO L,YUAN H,ZHU Y,et al.Design and testing of a wheeled crop-growth-monitoring robot chassis[J].Agronomy,2023,13(12):3043.

[18] WANG Y,GOU W,WANG C,et al.Method for the real-time detection of tomato ripeness using a phenotype robot and RP-YolactEdge[J].International Journal of Agricultural and Biological Engineering,2024,17(2):200-210.

[19] BANERJEE B P,SHARMA V,SPANGENBRG G,et al.Machine learning regression analysis for estimation of crop emergence using multispectral UAV imagery[J].Remote Sensing,2021,13(15):2918.

[20] LIU T,YANG T,LI C,et al.A method to calculate the number of wheat seedlings in the 1st to the 3rd leaf growth stages[J].Plant Methods,2018,14:1-14.

[21] LIU S,BARET F,ANDRIEU B,et al.Estimation of wheat plant density at early stages using high resolution imagery[J].Frontiers in Plant Science,2017,8:739.

[22] JIN X,LIU S,BARET F,et al.Estimates of plant density of wheat crops at emergence from very low altitude UAV imagery[J].Remote Sensing of Environment,2017,198:105-114.

[23] PENG J,REZAEI E E,ZHU W,et al.Plant density estimation using UAV imagery and deep learning[J].Remote Sensing,2022,14(23):5923.

[24] 侯依廷,饶元,宋贺,等.复杂大田场景下基于改进YOLOv8的小麦幼苗期叶片数快速检测方法[J].智慧农业(中英文),2024,6(4):128-137.HOU Yiting,RAO Yuan,SONG He,et al.A rapid detection method for wheat seedling leaf number in complex field scenarios based on improved YOLOv8[J].Smart Agriculture,2024,6(4):128-137.(in Chinese)

[25] KHANAM R,HUSSAIN M.YOLOv11:an overview of the key architectural enhancements[J].arXiv Preprint,arXiv:2410.17725,2024.

[26] WEI J,NI L,LUO L,et al.GFS-YOLOV11:a maturity detection model for multi-variety tomato[J].Agronomy,2024,14(11):2644.

[27] SOUDEEP S,MRIDHA M F,JAHIN M A,et al.DGNN-YOLO:dynamic graph neural networks with YOLOV11 for small object detection and tracking in traffic surveillance[J].arXiv Preprint,arXiv:2411.17251,2024.

[28] XIONG Y,LI Z,CHEN Y,et al.Efficient deformable convnets:rethinking dynamic and sparse operator for vision applications[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2024:5652-5661.

[29] LI Y,HU Z,ZHANG Y,et al.DDEYOLOv9:network for detecting and counting abnormal fish behaviors in complex water environments[J].Fishes,2024,9(6):242.

[30] GUO W,CHEN H,GUO J.A insulator defect detection method based on YOLO and ChatGPT[C]∥2024 6th International Conference on Industrial Artificial Intelligence (IAI).IEEE,2024:1-6.

[31] ZOU S,YANG Q.Exploring SAR-centered multi-source data fusion for flood mapping with transformer and convolution based ensemble models[C]∥IGARSS 2024—2024 IEEE International Geoscience and Remote Sensing Symposium.IEEE,2024:776-779.

[32] MA D,YANG C,AO L,et al.Lightweight motorcycle helmet detection based on improved YOLOv7-Tiny[C]∥2024 6th International Conference on Communications,Information System and Computer Engineering (CISCE).IEEE,2024:1126-1132.

[33] FENG C,ZHONG Y,GAO Y,et al.Tood:task-aligned one-stage object detection[C]∥2021 IEEE/CVF International Conference on Computer Vision (ICCV).IEEE,2021:3490-3499.

[34] SUN H,ZHANG W,MA D,et al.YOLO-WTDL:a lightweight wind turbine blades defect detection model based on YOLOv8[C]∥2024 7th Asia Conference on Energy and Electrical Engineering (ACEEE).IEEE,2024:46-51.

[35] TANG P,DING Z,JIANG M,et al.LBT-YOLO:a lightweight road targeting algorithm based on task aligned dynamic detection heads[J].IEEE Access,2024,12:180422-180435.

[36] HU X,HUANG Y,SUN W,et al.Shifts in cultivar and planting date have regulated rice growth duration under climate warming in China since the early 1980s[J].Agricultural and Forest Meteorology,2017,247:34-41.

[37] BAI X,CAO Z,ZHAO L,et al.Rice heading stage automatic observation by multi-classifier cascade based rice spike detection method[J].Agricultural and Forest Meteorology,2018,259:260-270.

[38] ZADOKS J C,CHANG T T,KONZAK C F.A decimal code for the growth stages of cereals[J].Weed Research,1974,14(6):415-421.

[39] SONG X,ZHANG W,PAN W,et al.Real-time monitor heading dates of wheat accessions for breeding in-field based on DDEW-YOLOv7 model and BotSort algorithm[J].Expert Systems with Applications,2024,267:126140.

[40] 朱荣胜,李帅,孙永哲,等.作物三维重构技术研究现状及前景展望[J].智慧农业(中英文),2021,3(3):94-115.ZHU Rongsheng,LI Shuai,SUN Yongzhe,et al.Research advances and prospects of crop 3D reconstruction technology[J].Smart Agriculture,2021,3(3):94-115.(in Chinese)

[41] VELUMANI K,MADEC S,SALAN D B.An automatic method based on daily in situ images and deep learning to date wheat heading stage[J].Field Crops Research,2020,252:107793.

[42] 刘楠,李海峰,窦艳华,等.普通小麦及其近缘物种花序,小穗和小花的形态结构分析[J].麦类作物学报,2015,35(3):293-299.LIU Nan,LI Haifeng,DOU Yanhua,et al.Morphology and structure analyses on inflorescence,spikelet and floret of bread wheat and its relatives[J].J.Triticeae Crops,2015,35(3):293-299.(in Chinese)

[43] SONG X,LIU L,WANG C,et al.Real-time determination of flowering period for field wheat based on improved YOLOv5s model[J].Frontiers in Plant Science,2023,13:1025663.