柑橘是我国南方栽培面积最广、经济地位最重要的经济水果,柑橘产业已经成为我国多地农村经济的支柱产业[1]。出口销售成为柑橘产业发展的新方向。然而,柑橘国际市场竞争激烈,与日本、美国等国的柑橘品种相比,中国的柑橘品种并无明显的价格或品质优势[2]。因此,进行柑橘品种的迭代升级,是增强我国柑橘竞争力、推动我国柑橘产业发展的重要手段。

在培育柑橘新品种时,需要将待筛选的柑橘种苗集中种植,对其性状进行观察与记录,十分耗费人力与时间成本。巡检机器人作为新兴的机器人研究方向,已经在电力、化工、煤矿等领域得到了初步应用,可以执行较高重复性或危险性的工作[3-7]。对于工作于不同环境中的巡检机器人,研究者通常会对底盘设计、建图导航算法以及视觉识别模型进行优化,从而低成本、高效、安全地完成巡检工作[8-12]。目前,研究者尝试研发适用于农业场景的巡检机器人,并在巡检机器人上搭载不同类型的传感器,从而获取农作物的表型信息、病虫害侵染情况或者动物的生长状态[13-17],为农业生产提供及时的指导与预警。

由于不同柑橘育苗环境结构具有较大差别,部分环境中存在高大树冠或保温大棚,而农业场景中常用的GPS定位导航易受树冠或保温大棚的影响,不具备足够的普遍适用性,因此有必要采取对柑橘育苗环境具有更优普遍适用性的定位方案。激光雷达点云匹配定位融合IMU的定位方法已经被证明可以在充满建筑物的结构化场景中提供精准的定位数据[18-19],该方法在复杂的农业场景中的定位性能值得探究。另外,鉴定柑橘种苗表型信息是评估其生长状态的关键,利用株高等表型信息可以分析柑橘苗的长势以及健康状况,以此来筛选出更优质的品种或更科学的种植方法[20-21],而株高等核心参数需要通过目标植株识别后获取。基于深度学习的图像技术能够高效执行检测与分割任务,在多场景中表现优异[22-26],但是柑橘育苗场所的环境背景过于复杂,不同行的种苗在视野内互相干扰,显著提升了图像处理的难度。

针对柑橘种苗基地中巡检机器人定位精度要求高、种苗识别难度大的问题,本文利用基于激光雷达的建图与定位技术,结合惯导IMU与激光里程计信息实现在柑橘育苗环境中的精准定位,利用深度信息对复杂环境进行过滤,并结合深度学习模型对目标种苗进行智能检测,以期实现对柑橘苗生长高度的无人化巡检与记录。

巡检机器人系统主要由负责采集数据与执行动作的硬件以及负责处理数据的软件两部分组成。整个系统的硬件部分如图1所示,四轮电动底盘为差速底盘;工控机作为整个系统的中控设备,为机器人系统所有算法与程序提供运行的环境;雷达、IMU与深度相机为机器人系统的定位及识别算法进行数据采集;路由器负责雷达与工控机之间的通讯,同时提供巡检系统人机交互所需的局域网;便携式WiFi为工控机提供以太网,保障工控机所需的网络通讯。

图1 巡检机器人

Fig.1 Inspection robot

1.雷达 2.深度相机 3.IMU 4.便携式WiFi 5.屏幕 6.四轮电动底盘 7.逆变器 8.工控机 9.路由器

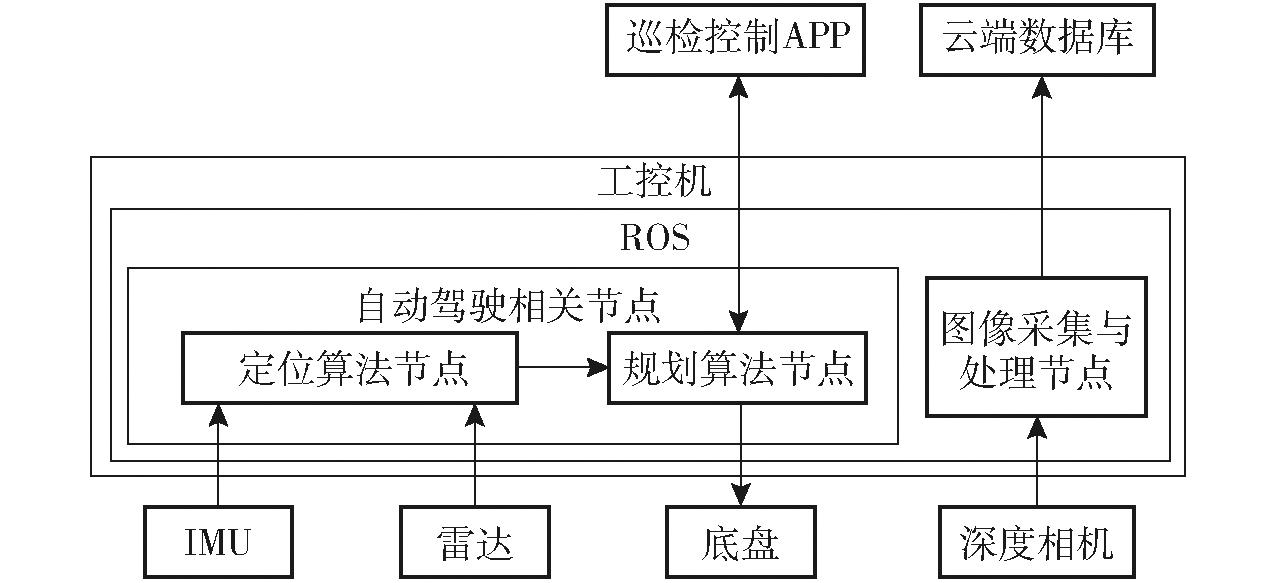

巡检机器人系统软件部分由巡检控制APP、自动驾驶算法、图像采集与处理程序和云端数据库组成。其中自动驾驶算法和图像采集与处理程序以节点的形式运行在ROS框架下。自动驾驶算法又包括建图、定位、路径规划以及底盘控制等算法。图像采集与处理程序负责处理深度相机所采集的柑橘苗图像数据,并将结果发送至云端数据库进行保存。巡检控制APP适配于安卓系统,可以通过ROS框架下的通讯模式向巡检机器人发布启动巡检、暂停巡检或结束巡检等指令。巡检机器人系统各部分硬件与软件间的配合关系如图2所示。

图2 巡检机器人系统硬件与软件间配合关系

Fig.2 Coordination between hardware and software of inspection robot system

雷达、IMU、深度相机以及图像采集与处理程序会在巡检机器人开机后自行启动,为即将开始的巡检做好准备。之后通过巡检APP来控制巡检的开始、暂停与结束。随着巡检的进行,云端数据库会同步收到并保存得到的柑橘苗图像和高度信息。

巡检机器人被布置在武汉市一处柑橘育苗基地内。该育苗基地的种植区长约100 m,宽约90 m,其垄间道路宽约1.5 m,基地内柑橘苗均匀排列种植。

基地现场环境如图3所示,该环境较为空旷,不存在影响RTK定位的环境因素,同时其场景重复、特征稀疏的特点又为巡检机器人采用的定位方法带来了较大挑战,因此该育苗基地适合开展巡检机器人定位试验。

图3 柑橘育苗基地现场环境

Fig.3 Citrus nursery site environment

巡检时,巡检机器人行走在场地的垄道中,位于车身两侧的深度相机同时采集垄道两旁的柑橘苗图像数据,并最终得到柑橘苗高度信息。

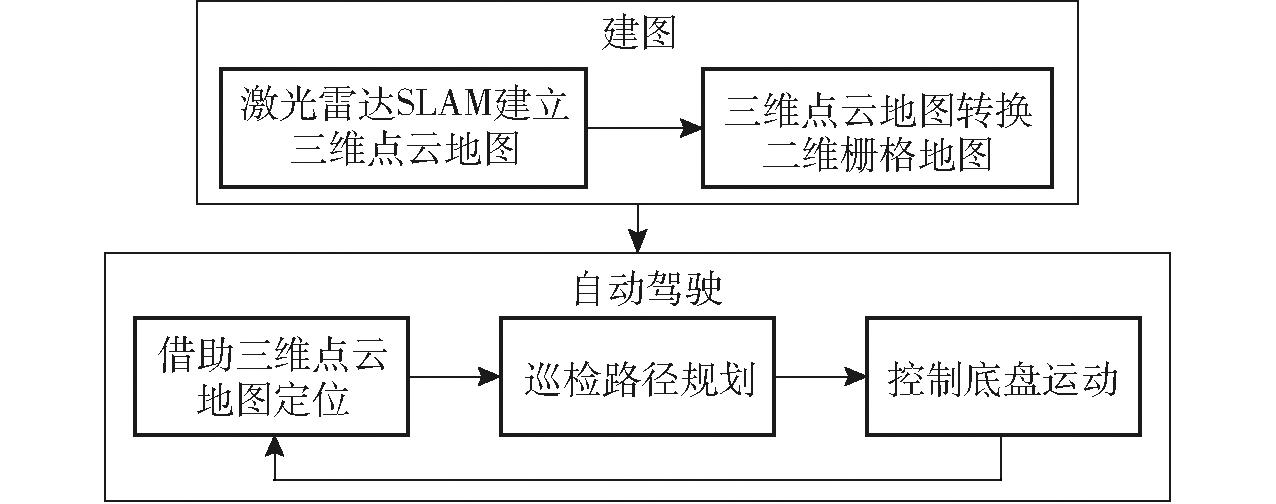

本研究采用基于激光雷达与IMU的三维SLAM进行建图及定位。自动驾驶流程如图4所示,其中建图算法包括三维激光雷达SLAM算法和将三维点云地图转二维栅格地图的投影算法。建图算法用于在前期获取巡检区域的三维点云地图和二维栅格地图。自动驾驶时,首先由定位算法通过已有的三维点云地图获取巡检机器人所在位置,之后由路径规划算法规划出到达目标点的全局路径与局部路径,最后控制巡检机器人按照规划出的路径行走,不断重复这个过程,直至巡检机器人到达目标点。

图4 自动驾驶流程示意图

Fig.4 Schematic of autonomous driving process

巡检机器人采用LIO-SAM三维激光雷达SLAM算法进行地图构建。LIO-SAM是一种基于因子图的紧耦合激光雷达里程计框架,不仅解决了先前算法在大场景中偏移过多的问题,同时其在局部范围而非全局范围内的关键帧匹配也提高了算法实时性能[27]。LIO-SAM因子图包括IMU预积分因子、激光里程计因子、GPS因子以及回环检测因子,将IMU预积分因子与激光里程计因子结合后可以实现定位精度的进一步提升。

从i时刻到j时刻的IMU预积分计算公式为

(1)

(2)

(3)

式中 vij——i时刻到j时刻速度增量

Ri——i时刻旋转矩阵

vj——j时刻速度

vi——i时刻速度

g——重力加速度

tij——i时刻到j时刻时间间隔

Pi——i时刻位置向量

Pj——j时刻位置向量

Pij——i时刻位置到j时刻位置位置向量

Rj——j时刻旋转矩阵

Rij——i时刻位姿到j时刻位姿旋转矩阵

通过式(1)~(3)解算的IMU预积分,不仅作为因子被添加到因子图中,又为关键帧与局部地图的匹配提供了优化求解初值。

在激光里程计因子中,首先利用一系列子关键帧构建局部体素地图,接着将新的关键帧与局部地图进行匹配,找到对应特征,之后计算特征间的距离,最后求解i时刻到i+1时刻的相对位姿转换矩阵。计算激光帧中特征与局部地图中对应的边缘特征或平面特征间的距离,即

(4)

(5)

式中 dek——边缘特征k与对应边缘特征距离

![]() 边缘特征k位置向量

边缘特征k位置向量

![]() 对应边缘特征中点u位置向量

对应边缘特征中点u位置向量

![]() 对应边缘特征中点v位置向量

对应边缘特征中点v位置向量

dpk——平面特征k与对应平面特征距离

![]() 平面特征k位置向量

平面特征k位置向量

![]() 对应平面特征中点u位置向量

对应平面特征中点u位置向量

![]() 对应平面特征中点v位置向量

对应平面特征中点v位置向量

![]() 对应平面特征中点w位置向量

对应平面特征中点w位置向量

之后通过高斯牛顿法解算公式

(6)

式中 Ti+1——i+1时刻变换矩阵![]() i+1时刻激光雷达帧中边缘特征的集合

i+1时刻激光雷达帧中边缘特征的集合![]() i+1时刻激光雷达帧中平面特征的集合

i+1时刻激光雷达帧中平面特征的集合

得到最优变换,即连接两个位姿的激光里程计因子。每当机器人的位姿改变超过了设定的阈值时,利用iSAM2[28]的方法,结合所有因子得到节点图的最新节点,即可获取当前的机器人位姿。

在建图时,使用遥控器控制巡检机器人,以0.5 m/s在柑橘育苗基地的小路中行走,行走轨迹覆盖每一条道路,并在此过程中通过激光雷达与IMU的驱动器实时发布传感器数据,算法节点获取这些信息后建立三维地图。

为了提高巡检安全性,需要获取划分出可通行区域的二维栅格地图。首先使用CloudCompare软件对三维地图进行人工裁剪,划分出清晰的可通行域。利用投影算法对裁剪后的三维地图采取直通滤波和半径滤波的处理,以此来划定投影的范围并去除点云中的离群点,然后将三维点云地图中的点投影至二维平面,得到二维栅格地图。

巡检机器人采用HDL_localization算法进行巡检过程中的定位。该算法基于无迹卡尔曼滤波框架,融合先验的IMU数据和点云匹配得到的测量结果,得到更加精准的定位值。

为了避免由于测量误差、环境改变而引起的定位失效,使用基于正态分布的NDT算法[29]进行点云匹配。NDT算法首先将点云地图栅格化,求出每个栅格中点云的中心点q,接着计算每个栅格中基于里面每个点到中点差值的协方差矩阵Σ,由此得到每个栅格点的高斯分布模型。结合所有栅格的分布模型,计算机器人处在某一位置的概率

(7)

式中 P——机器人处于某一位置的概率

x′i——原始点云数据第i个点在地图中的坐标

q——第i个点所在的栅格中心点坐标

最后通过牛顿法,不断优化得到点云匹配的最优解。

在一个定位周期中,HDL_localization首先利用IMU的数据得到初步预测定位。互相关系数计算式为

(8)

(9)

xk+1=xk+1|k+Kk+1|k(zk+1-zk+1|k)

(10)

式中 Tk+1|k——互相关系数

ωi——第i个Sigma点权重

xk+1|k——k+1时刻预测值

Xk+1|k,i——第i个Sigma点对应的预测值

zk+1|k——k+1时刻预测值

Zk+1|k,i——第i个Sigma点对应的预测值

Kk+1|k——卡尔曼增益

![]() k+1时刻预测值协方差的逆

k+1时刻预测值协方差的逆

zk+1——k+1时刻测量值

xk+1——k+1时刻最终预测值

接着结合NDT算法的观测定位对预测定位进行无迹卡尔曼滤波优化,得到准确的定位结果。

2.3.1 巡检路径规划

因为巡检路线相对固定,同时为避免在巡检过程中因机器人位姿不当导致采集的图像数据质量差,巡检机器人将Dijkstra全局路径规划算法与TEB[30]局部路径规划算法相结合,实现全局路径的定义及局部路线的实时优化调整。

Dijkstra规划算法在节点图中进行全局路径规划,节点图由人工在需要巡检的路径上设置多个点位得到。节点被划分为路径点与路径端点,路径端点为路径中的转折点,相邻的点之间相互连接。将每个路径端点设定为目标点,采用ROS机器人框架中的action通信机制,每当巡检机器人到达一个目标点后,立即将路径上的下一目标点作为新的目标点,保证巡检的顺利进行。Dijkstra算法寻找最优路径的公式为

dv=min{dv,du+ωu,v}

(11)

式中 dv——到达节点v代价

du——到达节点u代价

ωu,v——节点u和节点v之间的权重

因此,Dijkstra算法会遍历所有节点,找到到达目标点的最短路径。将巡检路径上的每个转折点作为目标点,即可保证巡检机器人按照设定的路线进行巡检。

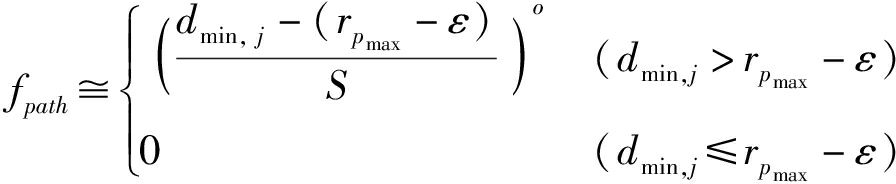

TEB算法是一种多目标优化算法,会在机器人行走时进行路径跟随、运动学、速度与加速度等多个方面的约束和优化。其中路径跟随约束与最短路径约束的数学描述为

(12)

(13)

式中 fpath——跟随路径惩罚值

dmin,j——机器人位姿与全局路径的最短距离

rpmax——机器人位姿与全局路径的最大允许距离

ε——界限值附近的微小偏移

S——缩放倍数

o——多项式阶数

fk——最短路径惩罚值

tc——相邻位姿间花费的时间

通过施加以上两种约束,可以使得巡检机器人在巡检时尽可能径直地走向路径中的下一节点,确保其行走在田垄间时的位姿。

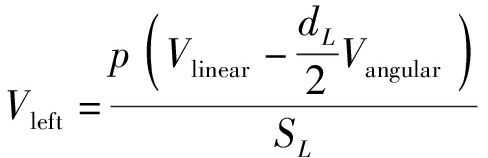

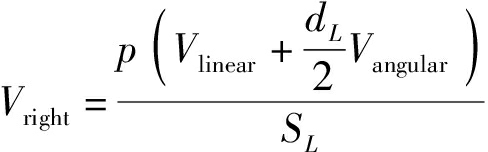

2.3.2 底盘控制

工控机通过CAN总线控制底盘左右电机的转速。通过订阅局部路径规划器发布的/cmd_vel话题,获取规划器规划出的机器人当前线速度与角速度,再根据已知的参数,解算出电机转速,公式为

(14)

(15)

式中 Vleft——机器人左轮电机转速,r/s

Vright——机器人右轮电机转速,r/s

Vlinear——机器人线速度,m/s

Vangular——机器人角速度,rad/s

dL——左轮与右轮之间的距离,m

SL——轮胎周长,m

p——电机转速与轮胎转速的减速比

最后以频率10 Hz向底盘电机发送速度指令,保证底盘流畅运动。

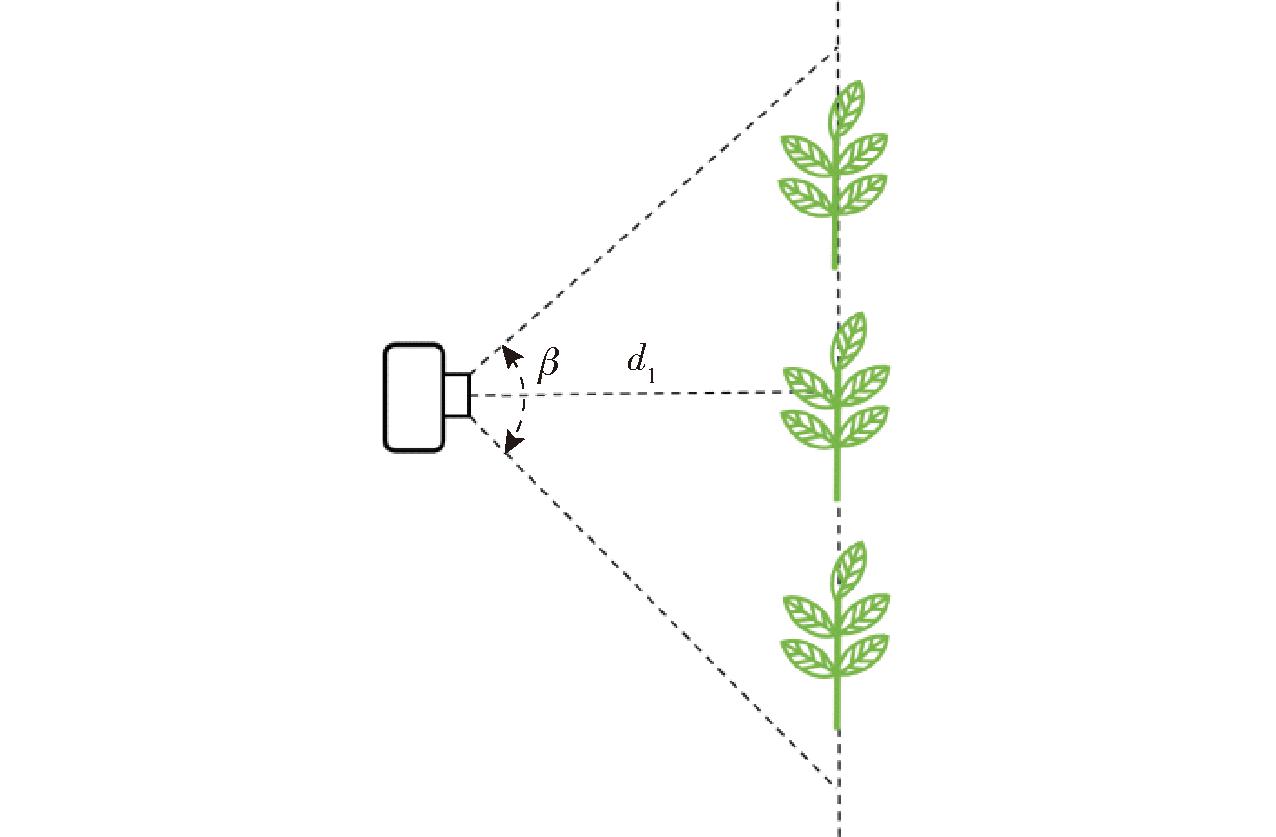

使用D435i型相机驱动,将位于巡检机器人两侧的相机所采集到的RGB图像和深度图像实时地以ROS话题形式发布。RGB图像与深度图像的分辨率均为1 280像素×720像素。数据采集和处理程序订阅两部相机对应的ROS话题,同时对获取到的图像进行抽帧处理。相机与柑橘苗的位置关系如图5所示,为了与巡检速度进行适配,确保每次巡检对每株柑橘苗采集约m组数据,计算抽帧的间隔图像数量

(16)

图5 位置关系示意图

Fig.5 Location relationship schematic

式中 β——深度相机水平视角,(°)

d1——相机到柑橘苗所在直线的距离,m

F——深度相机帧率,f/s

V——机器人移动速度,m/s

3.2.1 柑橘苗识别算法

抽帧获取的RGB图像会被依次送入训练好的模型中,从而识别出图像中柑橘苗和包含其编号信息的二维码。

巡检机器人系统使用YOLO v8s模型对柑橘苗和对应二维码进行识别。YOLO v8s可以一次性从输入图像中同时预测出所有物体的位置和类别,显著降低了计算的复杂度。其多尺度处理和轻量化设计也使得YOLO v8在资源受限的设备上同样可以实现高效部署。因此,YOLO v8适用于巡检机器人在巡检中完成实时的识别任务。

3.2.2 数据集构建与模型训练

采集数据时,控制机器人以约速度0.5 m/s缓慢移动,模拟真实巡检时的速度。利用ROS框架中提供的rosbag工具记录两台RealSense深度相机所拍摄的柑橘苗画面。所采集的数据来自同一地点从午后至傍晚具有不同光照情况的不同时段。对记录的视频数据进行处理,最后共得到2 036幅图像,按照4∶1将其中1 636幅图像划分为训练集,400幅图像划分为测试集。

使用Labelme软件对采集到的图像进行人工标注,对图像中第1排的柑橘苗和二维码均使用矩形框进行标注。标注时矩形框紧贴图像中第1排的柑橘苗与二维码的边缘,尽可能使识别出柑橘苗后标注的矩形框具有同样的特点,便于后续进行柑橘苗高度的计算。

采用Pytorch深度学习框架,操作平台为Windows 10,GPU为GeForce RTX3070(8 GB显存),处理器为AMD Ryzen 7 5800H,运行内存为32 GB。模型共经过了300个周期的训练,批处理大小设置为32,采用adam优化器,学习率为0.001。

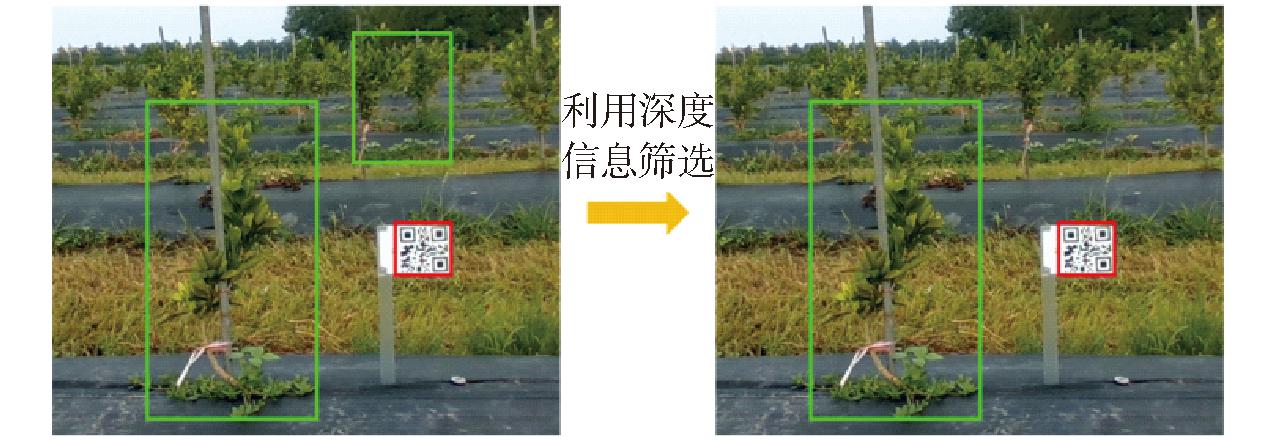

3.2.3 训练结果与识别优化

最终训练后模型在测试集上的测试结果为:对图像中第1排柑橘苗召回率为95.02%,精确率为92.35%,对图像中二维码召回率为98.43%,精确率为100%。受背景中柑橘苗的影响,对第1排柑橘苗检测的精确率较低,因此为了获取更精确的检测结果,有必要将错误识别出的背景中的柑橘苗去除。

采用以下方法分辨识别出的柑橘苗是否为背景中的柑橘苗:设定深度阈值,当柑橘苗所在区域内超出深度阈值的像素点数量超过该区域内像素点总数的一定比例时,判定该区域内的柑橘苗为背景中的柑橘苗。去除图像中错误识别的柑橘苗后,结果如图6所示。筛选结束后,利用位置关系进行柑橘苗与二维码的匹配。

图6 筛选前后对比

Fig.6 Before and after screening

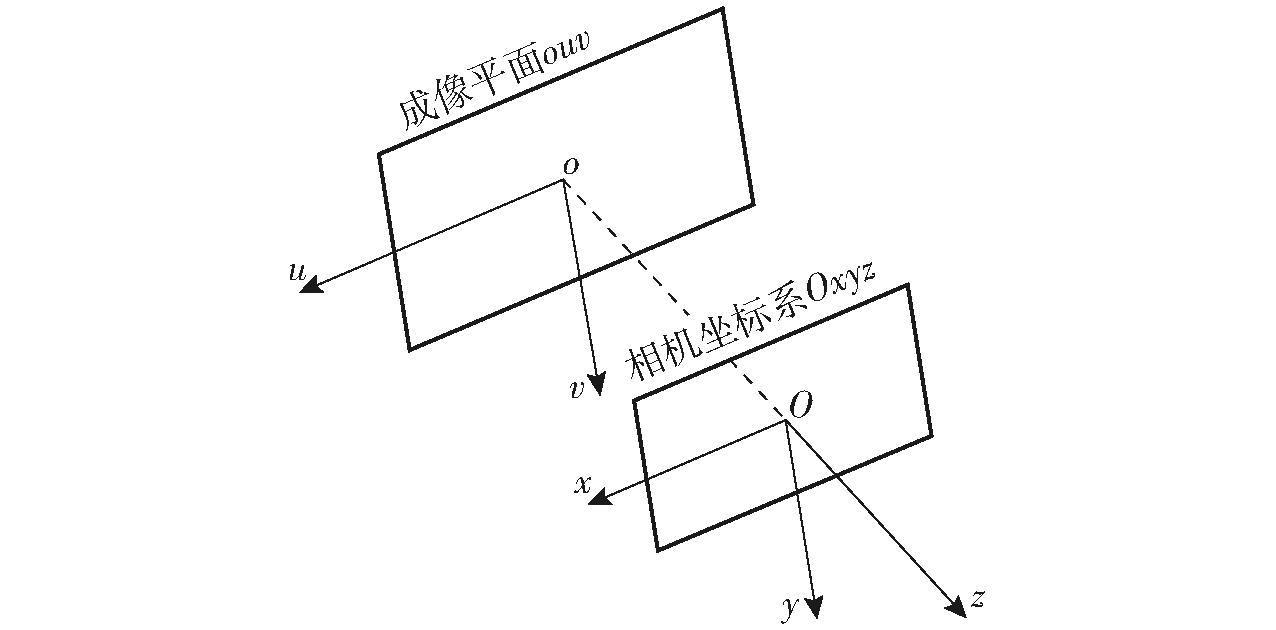

3.3.1 小孔成像模型

小孔成像模型中成像平面与相机坐标系的关系如图7所示。

图7 小孔成像模型

Fig.7 Small hole imaging model

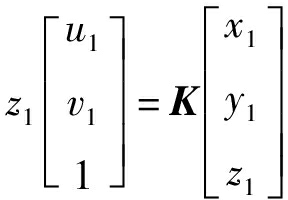

若已知成像平面中一点(u1,v1)的深度为z1,可以得到画面中该点对应的实际位置在相机坐标系中的坐标(x1,y1,z1),计算式为

(17)

式中 K——深度相机内参矩阵

3.3.2 计算方法

柑橘苗的高度被定义为柑橘苗最高点到根部所在地面的竖直方向距离。采用3种方法计算柑橘苗的高度。

前两种方法采用深度相机获取的点云信息计算柑橘苗高度。在前两种方法中,首先需要获取柑橘苗最高像素点Γ与根部附近地面像素点的合集Δ,为此对深度图像中标注框区域进行阈值筛选。在筛选时,超过一定深度的点被视为背景中的点,而低于一定深度的点则被视为噪声点,符合阈值条件的像素点则包括组成柑橘苗的点与近距离的地面点。在符合条件的像素点中,具有最小坐标v的像素点被视为Γ。利用最大坐标v划定范围得到合集Δ。之后通过公式(17)计算得到Γ在相机坐标系下的空间坐标φ以及像素点集合Δ对应的的点云集合δ。

方法1计算式为

(18)

(19)

式中 f——平面方程

A、B、C、D——平面方程系数或常数

![]() 集合δ中第i个点坐标

集合δ中第i个点坐标

(φx,φy,φz)——柑橘苗最高点坐标

h——柑橘苗高度,m

n——合集Δ中点云数量

该方法求解柑橘苗最高点到拟合地面平面的距离,以此距离表示柑橘苗高度。在公式(18)中,使用最小二乘法求解拟合的平面方程表达式。

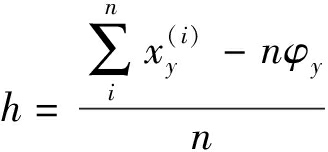

方法2计算式为

(20)

该方法将柑橘苗最高点与集合λ中点平均y坐标差值视为柑橘苗高度。

方法3利用已知的二维码尺寸信息,将其作为参考,通过识别的柑橘苗与二维码在图像中的比例计算得出柑橘苗高度,计算式为

(21)

式中 l1——柑橘苗标注框高度,m

l2——二维码标注框高度,m

L——二维码实际高度,m

如图8所示,计算得到的高度结果会被标记在图像中,该图像会被上传至云端数据库。

图8 标记后图像

Fig.8 Image after marking

SLAM建图精度和定位算法性能直接影响到巡检机器人在巡检过程中的定位精度,定位精度又直接影响到巡检机器人可靠性和巡检安全性,因此有必要对巡检机器人定位精度进行试验,以验证其可靠性和安全性。

4.1.1 试验方法

使用高精度定位模块(维特智能WTRTK-982)提供的定位作为参考定位,该模块的RTK定位可以提供误差为1 cm+1 ppm的位置信息。将定位模块的主天线安置于雷达上方,直接获取雷达所在位置定位信息,便于与定位算法获取的定位信息进行比较。WTRTK-982模块所提供的位置信息为WGS84坐标,无法直接与定位算法得出的局部直角坐标系坐标进行比较,需要对二者进行转换。将WGS84坐标系转换为PCS_WGS_1984_UTM_30N坐标系,后者为在WGS84坐标系下,位于北纬30°的UTM投影直角坐标系。UTM坐标系与三维点云地图的局部直角坐标系可以通过旋转平移计算进行相互转换。

试验前首先进行SLAM建图,试验时控制巡检机器人以巡检时的速度进行移动,每隔1 s记录下该时刻的WGS84坐标与三维点云地图直角坐标。将WGS84坐标转换为UTM坐标,利用已知点位的点云地图坐标与UTM坐标逆向解算出二者间的坐标转换矩阵。最后比较两种方法获取到的定位结果。

4.1.2 试验结果

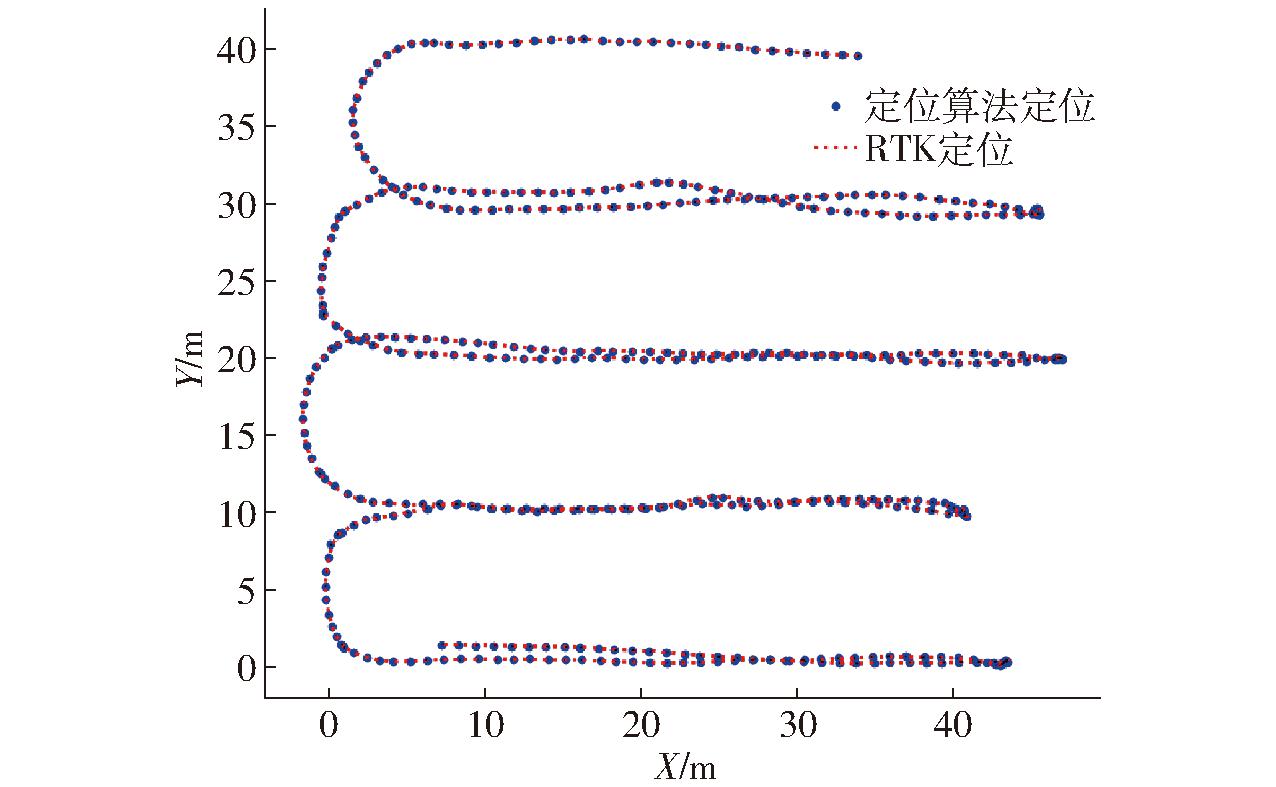

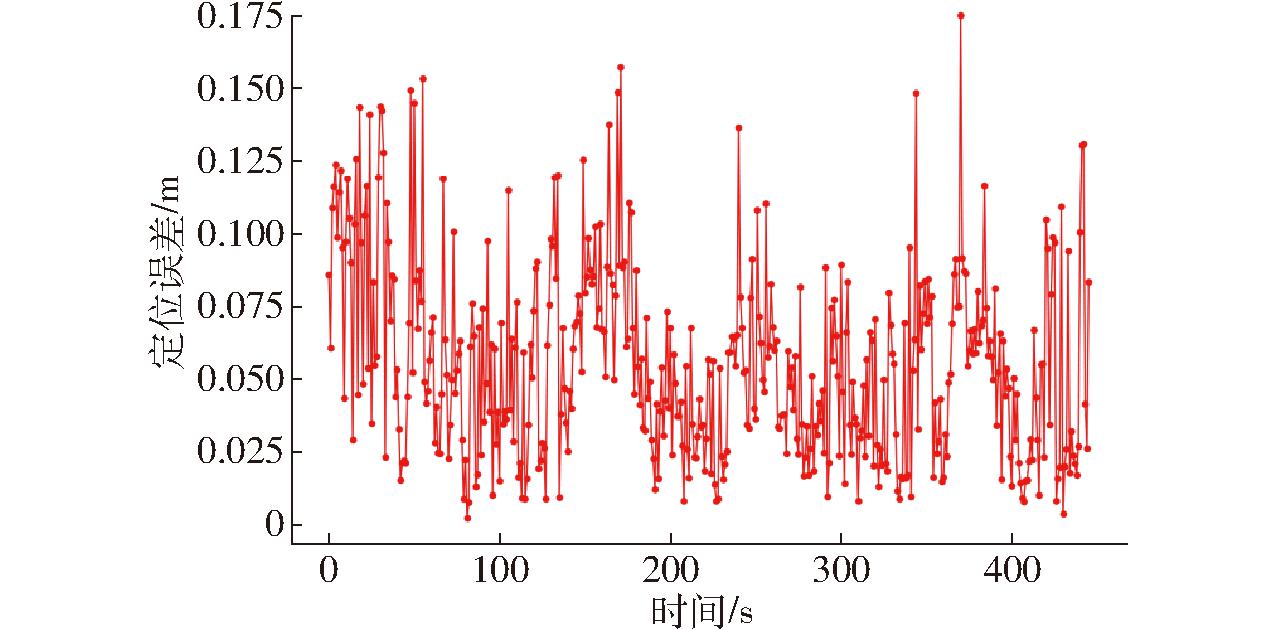

通过两种定位方式获取的巡检机器人在试验中的行走轨迹与两种定位方法间的定位误差如图9和图10所示。

图9 试验中的轨迹

Fig.9 Trajectory from experiment

图10 定位误差变化曲线

Fig.10 Positioning error variation curve

从图9可以看出,本次试验中通过两种定位方法得到的定位几乎一致,无明显差别。通过两种定位方法得到的定位最大相对误差为0.175 m,平均相对误差为0.056 m。因此,巡检机器人定位精度满足巡检过程中的安全性和可靠性要求。

图10反映出在巡检机器人移动过程中,其定位误差波动的频率与幅度较大,经分析后认为,这一现象可能是由巡检机器人移动时加速度的剧烈变化所导致。由于所使用的定位算法使用上一时刻的IMU数据计算当前时刻的先验定位结果,当巡检机器人的切向加速度或法向加速度出现剧烈变化时,由上一时刻的IMU数据计算得到的先验定位结果便失去了可靠性,最终导致定位误差剧烈波动。

为了获取更准确的柑橘苗生长高度,对3种计算方法得到的计算结果与通过人工测量获取的柑橘苗高度的真实值进行对比,测量的真实值精确到厘米级。

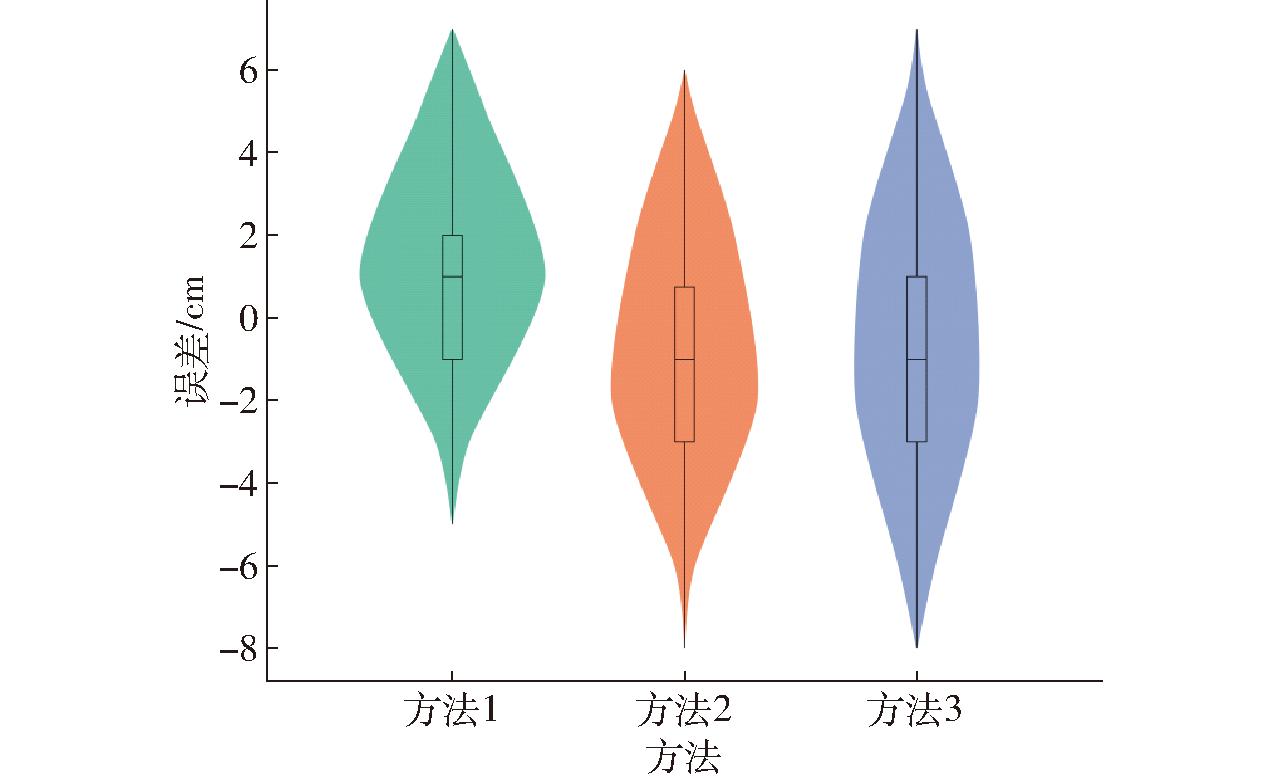

试验时控制巡检机器人自主巡检,使用rosbag工具记录下巡检过程中深度相机所拍摄的RGB图像和深度图像,之后分别使用3种方法对柑橘苗进行高度计算。3种方法的结果与人工测量真实值间的误差与绝对误差如图11与表1所示。

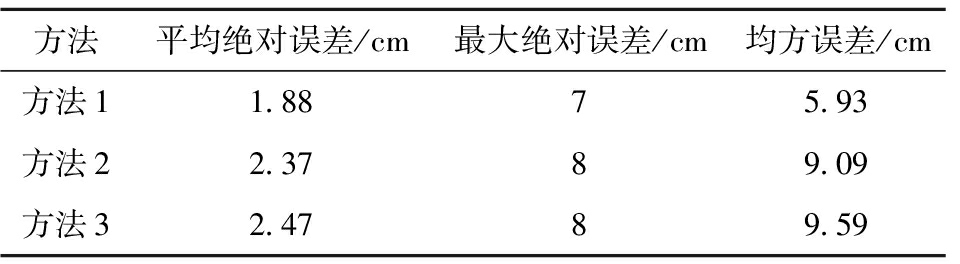

表1 不同方法结果对比

Tab.1 Comparison results of different methods

方法平均绝对误差/cm最大绝对误差/cm均方误差/cm方法11.8875.93方法22.3789.09方法32.4789.59

图11 不同方法误差分布

Fig.11 Box plots of results of different methods

通过表1可以看出,方法1结果的平均绝对误差与最大绝对误差均为最小,通过图11中小提琴图形状与表1中均方误差的对比也可以得出,方法1的误差分布在真实值附近更加集中。以上结果说明结果的准确性和稳定性,方法1均明显优于其它方法,因此巡检机器人采用方法1计算柑橘苗的高度。

(1)提出了一种适用于柑橘育苗研究的全自动柑橘表型巡检机器人系统。其中巡检机器人采用三维SLAM建图与三维点云匹配融合IMU定位方案,试验中平均定位误差仅为5.6 cm,最大定位误差为17.5 cm。

(2)巡检机器人使用YOLO v8s网络检测柑橘苗与二维码,在测试集中对二者的召回率为95.02%与98.43%,精确率为92.35%与100%。

(3)提出了3种柑橘苗高度计算方法,试验中最优计算方法平均绝对误差为1.88 cm,最大绝对误差为7 cm,均方误差为5.93 cm2。

(4)巡检机器人可以通过移动设备一键控制,巡检过程中的数据可以实时上传至云端数据库,该巡检机器人系统具备实用价值。

[1] 李馨雨,阳文娟,何丽波.我国柑橘产业布局变迁及其影响因素研究[J].农业科技与信息,2024(5):135-139,143.

[2] 谭俊杰,杨尚东,周柳强,等.基于中国-东盟水果贸易的广西优质柑橘产业发展策略探析[J].南方农业学报,2020,51(2):470-476.TAN Junjie,YANG Shangdong,ZHOU Liuqiang,et al.High-quality citrus industry development strategies of Guangxi based on China-ASEAN fruit trade[J].Journal of Southern Agriculture,2020,51(2):470-476.(in Chinese)

[3] 彭向阳,金亮,王锐,等.变电站机器人智能巡检技术及应用效果[J].高压电器,2019,55(4):223-232.PENG Xiangyang,JIN Liang,WANG Rui,et al.Substation robot intelligent inspection technology and its application[J].High Voltage Apparatus,2019,55(4):223-232.(in Chinese)

[4] 张春晓,陆志浩,刘相财.智慧变电站联合巡检技术及其应用[J].电力系统保护与控制,2021,49(9):158-164.ZHANG Chunxiao,LU Zhihao,LIU Xiangcai.Joint inspection technology and its application in a smart substation[J].Power System Protection and Control,2021,49(9):158-164.(in Chinese)

[5] 董诗绘,牛彩雯,戴琨.基于深度强化学习的变电站巡检机器人自动化控制方法研究[J].高压电器,2021,57(2):172-177.DONG Shihui,NIU Caiwen,DAI Kun.Study on automatic control method of substation inspection robot based on deep reinforcement learning[J].High Voltage Apparatus,2021,57(2):172-177.(in Chinese)

[6] 赵星檑,张新元.四足仿生巡检机器人在上湾选煤厂的应用[J].洁净煤技术,2023,29(增刊):185-188.ZHAO Xinglei,ZHANG Xinyuan.Application of four-legged bionic inspection robot in Shangwan coal preparation plant[J].Clean Coal Technology,2023,29(Supp.):185-188.(in Chinese)

[7] 郭爱军,赵明辉.多传感器融合的巡检机器人系统研究[J].煤炭技术,2023,42(12):233-235.GUO Aijun,ZHAO Minghui.Research on multi-sensor fusion inspection robot system[J].Coal Technology,2023,42(12):233-235.(in Chinese)

[8] 邓军,李钊,王伟峰,等.基于改进ILS-RVND算法的工业园区智能巡检机器人路径规划方法[J].现代电子技术,2021,44(18):167-171.DENG Jun,LI Zhao,WANG Weifeng,et al.Improved ILS-RVND algorithm based path planning method of intelligent inspection robot in industrial park[J].Modern Electronics Technique,2021,44(18):167-171.(in Chinese)

[9] 赵崇娟,朱奕弢,胡钰莹,等.基于改进A*算法的变电站自动巡检路径规划研究[J].机械设计,2024,41(增刊):153-158.ZHAO Chongjuan,ZHU Yitao,HU Yuying,et al.Research on automatic path planning of substation inspection robot based on improved A* algorithm[J].Journal of Machine Design,2024,41(Supp.):153-158.(in Chinese)

[10] 刘兴华.变电站巡检机器人视觉导航路径快速提取方法[J].电子设计工程,2024,32(13):23-26,31.LIU Xinghua.Fast extraction method of visual navigation path for substation inspection robot[J].Electronic Design Engineering,2024,32(13):23-26,31.(in Chinese)

[11] 王宏伟,刘亚东,田兵,等.基于空间关系的变电站巡检机器人巡检点自主生成方法[J].高电压技术,2022,48(8):2982-2990.WANG Hongwei,LIU Yadong,TIAN Bing,et al.Autonomous generation method of substation inspection robot inspection point based on spatial relationship[J].High Voltage Engineering,2022,48(8):2982-2990.(in Chinese)

[12] 杨权,樊绍胜.基于图像预处理和语义分割的电力巡检机器人视觉导航方法[J].电力科学与技术学报,2023,38(6):248-258.YANG Quan,FAN Shaosheng.Visual navigation method for electric power inspection robot based on image preprocessing and semantic segmentation[J].Journal of Electric Power Science and Technology,2023,38(6):248-258.(in Chinese)

[13] MUELLER-SIM T,JENKINS M,ABEL J,et al.The robotanist:a ground-based agricultural robot for high-throughput crop phenotyping[C]∥2017 IEEE International Conference on Robotics and Automation (ICRA),2017:3634-3639.

[14] 李秋洁,丁莉.基于移动多线激光雷达扫描的树冠叶面积估计方法[J].农业机械学报,2024,55(9):308-315,480.LI Qiujie,DING Li.Crown leaf area estimation based on mobile multi-layer LiDAR scanning[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(9):308-315,480.(in Chinese)

[15] 赵文文,王海峰,朱君,等.猪舍消杀巡检机器人系统设计与试验[J].农业机械学报,2022,53(增刊2):270-277.ZHAO Wenwen,WANG Haifeng,ZHU Jun,et al.Research and design of pig house disinfecting inspection robot system[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(Supp.2):270-277.(in Chinese)

[16] 班超,董乃希,黄修炼,等.基于多维感知的玉米大田巡检平台设计与试验[J].农业机械学报,2023,54(9):44-52,73.BAN Chao,DONG Naixi,HUANG Xiulian,et al.Design and experiment of maize field inspection platform based on multi-dimensional perception[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(9):44-52,73.(in Chinese)

[17] 王毅,何宇,王恺,等.巡检机器人获取柑橘树上果实完整表面信息方法研究[J].农业机械学报,2020,51(4):232-240.WANG Yi,HE Yu,WANG Kai,et al.Method of getting complete surface information of citrus by inspection robot[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(4):232-240.(in Chinese)

[18] 崔文,薛棋文,李庆玲,等.基于三维点云地图和ESKF的无人车融合定位方法[J].工矿自动化,2022,48(9):116-122.CUI Wen,XUE Qiwen,LI Qingling,et al.Unmanned vehicle fusion positioning method based on 3D point cloud map and ESKF[J].Journal of Mine Automation,2022,48(9):116-122.(in Chinese)

[19] 张文玥,娄小平,陈福笛.移动机器人多传感器融合定位仿真研究[J].计算机仿真,2023,40(3):436-441.ZHANG Wenyue,LOU Xiaoping,CHEN Fudi.Research on multi-sensor fusion localization simulation of mobile robot[J].Computer Simulation,2023,40(3):436-441.(in Chinese)

[20] 金方伦,冯世华,黎明,等.不同氮磷钾肥组合对塑料大棚柑橘苗生长发育的影响[J].园艺与种苗,2011(3):39-41.JIN Fanglun,FENG Shihua,LI Ming,et al.Effects of different N,P and K combination on the growth and development of citrus seedling in plastic shed[J].Horticulture &Seed,2011(3):39-41.(in Chinese)

[21] 郭伟,赵艳茹.汉中产区柑橘树不同主干高度对比试验[J].西北园艺,2022(3):61-63.

[22] 李善军,梁千月,余勇华,等.柑橘木虱YOLO v8-MC识别算法与虫情远程监测系统研究[J].农业机械学报,2024,55(6):210-218.LI Shanjun,LIANG Qianyue,YU Yonghua,et al.Research on Asian citrus psyllid YOLO v8-MC recognition algorithm and insect remote monitoring system[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(6):210-218.(in Chinese)

[23] 杨信廷,郭向阳,韩佳伟,等.基于TiDE-PatchTST模型的柑橘冷藏效率时序预测模型优化[J].农业机械学报,2024,55(7):396-404.YANG Xinting,GUO Xiangyang,HAN Jiawei,et al.Optimization of citrus cold storage efficiency time-series prediction model Based on TiDE-PatchTST[J].Transactions of the Chinese Society for Agricultural Machinery,2024,55(7):396-404.(in Chinese)

[24] 岳凯,张鹏超,王磊,等.基于改进YOLOv8n的复杂环境下柑橘识别[J].农业工程学报,2024,40(8):152-158.YUE Kai,ZHANG Pengchao,WANG Lei,et al.Recognizing citrus in complex environment using improved YOLOv8n[J].Transactions of the CSAE,2024,40(8):152-158.(in Chinese)

[25] SHE J,ZHAN W,HONG S,et al.A method for automatic real-time detection and counting of fruit fly pests in orchards by trap bottles via convolutional neural network with attention mechanism added[J].Ecological Informatics,2022,70:101690.

[26] CHEN C,LIANG Y H,ZHOU L,et al.An automatic inspection system for pest detection in granaries using YOLOv4[J].Computers and Electronics in Agriculture,2022,201:107302.

[27] SHAN T X,ENGLOT B,MEYERS B,et al.LIO-SAM:tightly-coupled LiDAR inertial odometry via smoothing and mapping[C]∥2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS),2020:5135-5142.

[28] KAESS M,JOHANNSSON H,ROBERTS R,et al.iSAM2:incremental smoothing and mapping using the Bayes tree[J].The International Journal of Robotics Research,2012,31(2):216-235.

[29] BIBER P,STRASSER W.The normal distributions transform:a new approach to laser scan matching[C]∥2003 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2003),2003:2743-2748.

[30] RÖSMANN C,FEITEN W,WÖSCH T,et al.Trajectory modification considering dynamic constraints of autonomous robots[C]∥7th German Conference on Robotics,2012:74-79.