0 引言

目前百香果采摘方式仍以人工为主,消耗大量劳动成本。农业机器人采摘对于解放劳动力以及引领水果产业走向精准化和智能化模式具有重大意义[1]。近年来,利用图像技术对果实检测已成为研究热点[2]。

传统的基于机器学习的图像处理和识别方法主要基于手动设计特征和分类器组合,主要对水果颜色、形状等特征进行研究。BANSAL等[3]通过计算水果和叶片的快速傅里叶变换泄漏值,比较水果和其他物体的泄漏百分比,得到一个阈值,开发了一种从室外彩色图像中检测未成熟的绿色柑橘类水果技术。PENG等[4]在提取特征后采用SVM分类器进行分类识别,实现多种水果识别,并提高了采摘机器人适用性。然而,传统的图像识别方法存在鲁棒性差和处理大规模数据难等问题。

相较于机器学习方法,深度学习网络可快速有效提取目标特征,有效解决数据获取难、位置不准确和采摘效率低等问题。研究发现,针对不同目标有针对性地改进模型可以得到更高的检测精度。TU等[5]提出一种多尺度的MS-F RCNN网络模型,在Faster R-CNN的基础上添加多尺度特征提取器,再分别训练RGB检测器和深度检测器,提升了对百香果小目标的检测能力。WU等[6]通过改进YOLO v3卷积网络,在其特征提取模块中结合DenseNet网络,将多尺度预测化为单尺度预测,实现了在自然环境中快速识别和定位不同成熟度的百香果。YANG等[7]在原YOLO v5s基础模型的主干网络和颈部网络之间加入BCAM,能更好地构建深层次位置特征关系,能够有效提升召回率,但精确度却只有89.15%。GAI等[8]通过改进YOLO v4骨干网络,结合DenseNet将模型先验框的层间密度改为适合樱桃果实形状的圆形标记框,增强了模型特征提取和检测能力。AN等[9]基于YOLOX模型,用自主设计的特征提取模块C3HB替换原有的CSP模块,并加入归一化注意力模块NAM,设计了一种草莓生长检测算法,能有效检测草莓果实生长状态。LI等[10]使用Swin-Transformer结合ConvNext模块对YOLO v7的骨干网络进行优化,能够快速有效检测籽棉中的异物纤维。以上研究虽提高了模型检测精度,但参数量大和计算成本高,增加了嵌入式平台等移动端设备部署难度。

为解决模型参数冗余和计算复杂度高等问题,研究人员开始关注轻量化网络设计[11]、模型剪枝[12]、知识蒸馏[13]等压缩模型方法。轻量化网络设计方法是通过调整网络内部结构,设计较少的模型参数规模和更快速的卷积网络,如MobileNet[14]、shuffleNet[15]、GhostNet[16]等。SHEN等[17]使用通道剪枝算法对YOLO v5s聚类检测模型进行压缩,模型参数量和内存占用量分别减少79%和76%,设计出一种轻量级的葡萄簇检测模型。LYU等[18]采用多教师预激活特征蒸馏框架,使用相对复杂的YOLO v4和YOLO v5l作为教师模型,相对简单的YOLO v4-Tiny作为学生模型,该方法高效地提取特征,大幅提高检测精度。

本文基于改进YOLO v8s模型,构建复杂环境下百香果数据集,构建一个百香果检测模型,以期确保在野外复杂环境中具有较高泛化能力的同时,能够在嵌入式平台上达到实时检测要求。

1 数据集建立

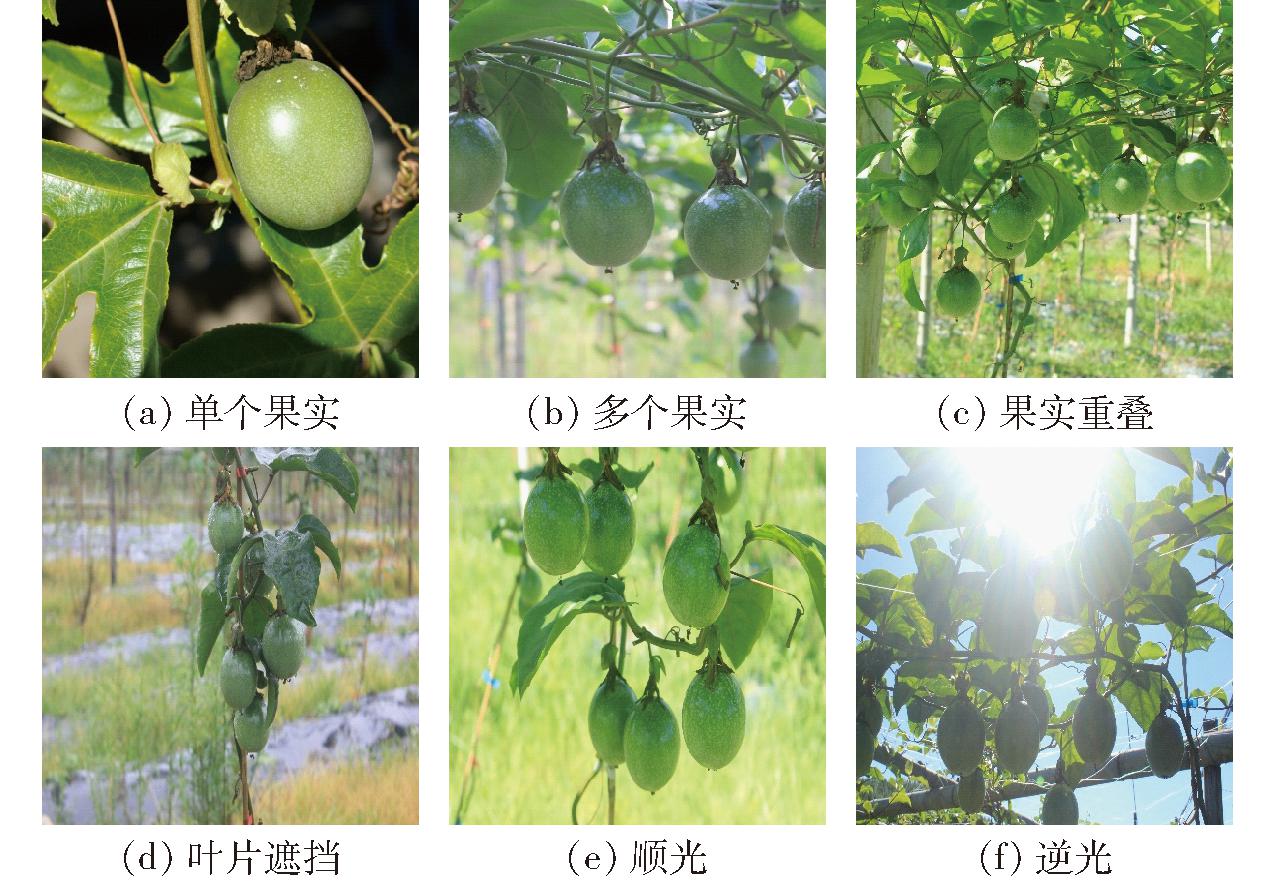

图像采集地点为福建省福州市闽侯县君之誉百香果基地,图像采集设备选用尼康数码相机,采集图像时,相机与果实距离保持在80~100 cm,图像分辨率为1 920像素×1 080像素,保存格式为JPEG。所有数据图像均采集于自然环境中,采用顺光、逆光、俯拍和仰拍等多种拍摄方式,涵盖果实重叠、叶片遮挡、单个果实和多个果实等多种情况,共采集1 500幅图像。采集图像如图1所示。

图1 部分百香果图像

Fig.1 Partial passion fruit images

鉴于单一百香果数据集较少,为了降低因样本不足而导致的模型过拟合现象,对原始数据进行旋转(90°、180°、270°)、添加噪声、镜像(水平镜像、垂直镜像)以及改变亮度等图像增强方式扩充数据集,强调百香果图像整体或局部特征,扩大不同物体特征之间的差别,有利于提高深层次网络训练学习能力,从而提高训练模型鲁棒性和泛化能力。增强后部分图像如图2所示。经过上述的离线数据扩增,最终获得百香果图像3 000幅。对以上图像使用软件LabelImg手动标记百香果目标并绘制边界框,生成xml格式文件。将制作完成的数据集按照8∶1∶1随机分为训练集、验证集和测试集,最终得到训练集2 400幅、验证集300幅和测试集300幅。

图2 数据增强

Fig.2 Data augmentation

2 检测模型改进

2.1 YOLO v8模型

YOLO v8目标检测算法于2023年由Ultralytics公司发布,具有高精度和快速推理速度,是现今性能最好的目标检测模型之一[19]。该模型可以分为输入端(Input)、骨干网络(Backbone)、颈部网络(Neck)和头部网络(Head) 4部分,主要结构如图3所示。输入端使用Mosaic数据增强方式对百香果图像随机缩放、裁剪、拼接后作为训练数据,此外,引入YOLOX[20]中提出的最后10个epoch关闭Mosaic的操作,该方式不仅丰富了数据集而且增强网络模型鲁棒性。主干网络主要负责提取图像特征,可分为3部分:标准卷积(Conv)模块、C2f模块、SPPF模块。Conv模块包括卷积层、批量归一化层和激活函数层。C2f模块主要是参考C3模块和ELAN[21]的思想进行设计,在一个维度上将输入特征图分成两部分,在减少计算量的同时丰富梯度流信息,有助于提高模型非线性表示能力。SPPF模块连接主干网络和颈部网络,通过不同的卷积核提取百香果特征后再融合不同尺度的特征信息。颈部网络使用PAN-FPN结构,FPN结构从上往下采样提取语义特征,提高模型多尺度检测精度,PAN结构从下往上采样提取丰富的位置信息,并与高分辨率特征图拼接,增强目标定位能力。检测网络以目标概率类别、置信度分数以及目标框位置作为最终输出结果。

图3 YOLO v8网络结构

Fig.3 YOLO v8 network structure

YOLO v8算法具有出色的灵活性,研究人员可根据网络深度和宽度选定YOLO v8的不同模型。本研究使用自制百香果数据集测试4个版本的检测性能,结果如表1所示。为节约嵌入式设备内存和降低计算成本,选择YOLO v8s作为基准模型。

表1 不同YOLO v8模型性能对比

Tab.1 Comparison of performance of different YOLO v8 models

模型精确率/%召回率/%平均精度/%模型内存占用量/MBYOLO v8s93.8091.8094.1021.40YOLO v8m93.5093.0095.2049.60YOLO v8l95.1092.5095.8083.50YOLO v8x94.5092.1095.70130.00

2.2 YOLO v8模型改进

为了增加模型信息交换效率,提高其检测精度,在YOLO v8s模型基础上进行改进。图4为改进后模型结构图。

图4 改进后YOLO v8s-GD模型结构图

Fig.4 Improved YOLO v8s-GD model structure

2.2.1 颈部网络重新构造

在深度学习网络中,改进模型鲁棒性和泛化能力不仅取决于修改主干网络,修改颈部网络也能产生类似效果。在YOLO系列模型中通常使用特征金字塔(FPN)及其变体来融合多层次特征,但这种融合方法有一个显著缺陷:当需要跨层融合信息时,传统FPN结构无法无损地传递信息,在一定程度上阻碍了信息融合。本研究选取聚集和分发机制[22] (Gather-and-distribute, GD)替换YOLO v8颈部网络,GD机制通过全局融合多层次特征信息注入更高层,实现YOLO v8中高效的信息交换,能够显著增强颈部网络信息融合能力,提高模型在不同百香果尺寸下的性能。颈部网络选取的GD机制结构如图5所示。GD机制包括浅层聚集和分发(Low-GD)和深层聚集和分发(High-GD)两部分,分别通过卷积和自注意力机制提取和融合特征。 Low-GD主要用于融合模型浅层的特征信息,图中B2、B3、B4和B5为主干网络提取到的特征,经过FAM模块将特征图尺寸统一成与B4特征图相同的大小,再经过IFM模块将其按照通道数拆分成两部分,以适应不同的模型尺寸,最后经过Inject模块将全局特征信息注入到不同层次输出。High-GD主要负责深层特征信息,其分辨率为Low-GD的1/2,在结构上与Low-GD类似,但输入信息是由Low-GD生成的特征P3、P4和P5。通过上述方案修改,低层次和高层次特征信息被有效融合。颈部网络同时具有高层次语义特征和低层次定位特征,与此同时,网络增加了大目标检测敏感度,提高了中大目标检测能力。

图5 GD机制结构图

Fig.5 Architecture of GD mechanism

2.2.2 模型剪枝

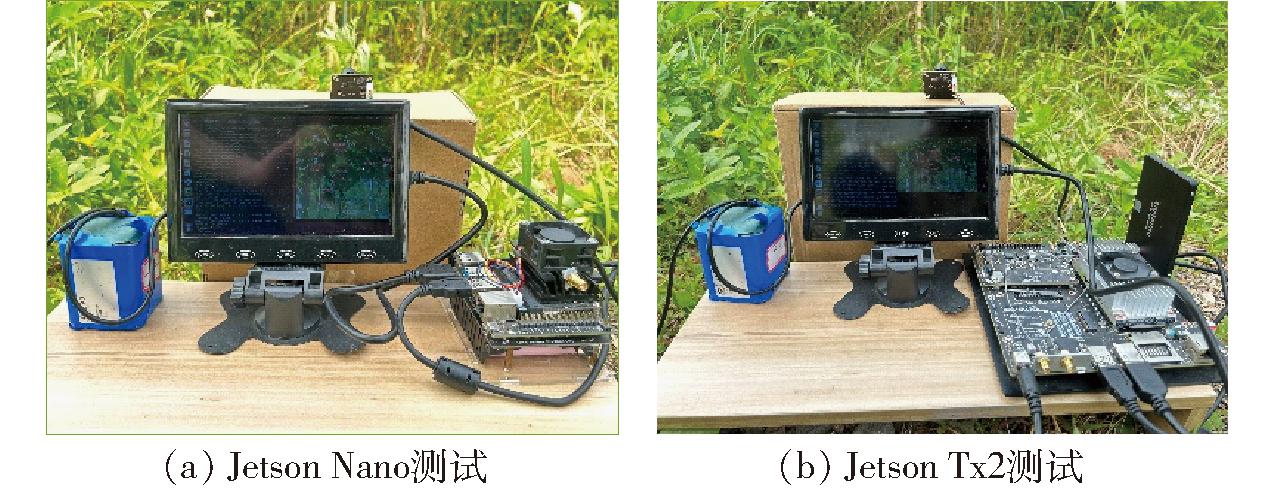

由于在有限的存储空间和计算资源的嵌入式设备上部署神经网络相当困难,因此需要对模型计算量和参数量进一步压缩[23]。神经网络模型从卷积层到全连接层存在过多冗余参数,神经网络剪枝即将网络结构中的冗余部分去除,这些部分移除后不会影响模型表达能力。采用基于层自适应稀疏度的幅度剪枝[24](Layer-adaptive sparsity for the magnitude-based pruning, LAMP)对模型进行修剪。在剪枝过程中,判断是否去除某个通道结构的依据是这个通道的评分,在每一个连接中都有一个权重,目前评价标准是比较权重绝对值,而LAMP评分是权重平方,评分较小的权重被认为是冗余部分,即需修剪部分。LAMP是一种全局剪枝,设计思路如下:

神经网络权重张量有二维矩阵,也有四维,为给出LAMP分数的统一定义,将所有权重张量都展开为一维向量,对于每个展开的向量根据给定索引排序,μ、ν表示权重索引,W[μ]和W[ν]表示索引μ、ν映射权重,假设权重根据其索引大小排序,即当μ<ν时,W[μ]≤W[ν]成立,即LAMP评分计算式为

(1)

(W[μ])2表示目标连接的权重平方,![]() 表示在同一层中索引大于μ的连接的权重平方和。即分母表示当前同一层连接当中所有剩余连接的权重平方和,其他索引小于μ的连接已经被剪除。根据式(1)可知,权重平方越大,对应的LAMP评分越高,因此评分也反映连接重要程度。评分较低的权重项被认为是相对不重要的部分被剪除。在LAMP剪枝中设置好目标剪枝比率后,会对具有较小LAMP分数的连接进行全局剪枝,直到满足所需的全局稀疏性约束。而且LAMP评分每一层都存在一个分数为1的连接,意味着每一层中至少会保留一个存活连接,有效避免层崩溃。通过LAMP算法的应用,能够有效减少模型参数量,使其更适合在资源受限的嵌入式设备上进行部署。

表示在同一层中索引大于μ的连接的权重平方和。即分母表示当前同一层连接当中所有剩余连接的权重平方和,其他索引小于μ的连接已经被剪除。根据式(1)可知,权重平方越大,对应的LAMP评分越高,因此评分也反映连接重要程度。评分较低的权重项被认为是相对不重要的部分被剪除。在LAMP剪枝中设置好目标剪枝比率后,会对具有较小LAMP分数的连接进行全局剪枝,直到满足所需的全局稀疏性约束。而且LAMP评分每一层都存在一个分数为1的连接,意味着每一层中至少会保留一个存活连接,有效避免层崩溃。通过LAMP算法的应用,能够有效减少模型参数量,使其更适合在资源受限的嵌入式设备上进行部署。

2.2.3 知识蒸馏

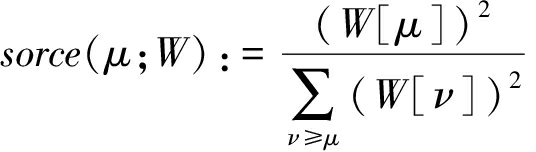

知识蒸馏是进一步提高模型检测精度的有效方法[25]。尽管目前蒸馏在YOLO系列网络改进中尚未被广泛使用,特别是对于单一目标的小模型。针对剪枝后模型,最终使用蒸馏技术在本模型上实现性能提升。首先,合理地选用教师模型。为了确保学生和教师模型在提取特征图的尺度一致,根据百香果数据集训练结果,选用改进后的YOLO v8-GD模型作为教师模型对剪枝后模型进行蒸馏。使用一种适用于密集目标检测的跨任务一致协议的蒸馏方法[26],该蒸馏方法通过模仿教师检测器的logit输出来传递知识,主要由2个蒸馏损失值构成:二分类蒸馏损失值![]() 和基于IoU的定位蒸馏损失值

和基于IoU的定位蒸馏损失值![]() 通过这两个损失值来分别传递分类知识和定位知识,具体流程如图6所示。

通过这两个损失值来分别传递分类知识和定位知识,具体流程如图6所示。

图6 知识蒸馏流程图

Fig.6 Knowledge distillation flowchart

数据集输入到蒸馏过程中有两个分支:①将百香果数据输入到YOLO v8-GD教师模型中。②将百香果数据送入到剪枝后学生模型中,经过预测后分别得到教师模型和学生模型的二元分类图。通过计算每个二元分类图的二进制交叉损失值来提取分类知识,再根据每个分类图的重要性赋予权重,得到二分蒸馏损失值![]() 从而学生模型能够继承教师模型的正确预测能力。二元分类蒸馏损失值计算式为

从而学生模型能够继承教师模型的正确预测能力。二元分类蒸馏损失值计算式为

(2)

其中

(3)

式中 wi, j——样本x重要性权重

LBCE——二进制交叉熵损失值

![]() 二元分类分数第i个位置和第j类

二元分类分数第i个位置和第j类

在得到二元分类图的同时会得到教师模型和学生模型定位图,对于输入的百香果样本,利用锚点位置和定位预测得到每个百香果位置边界框,通过计算教师模型边界框和学生模型边界框之间的IoU,引入损失加权策略,得到基于IoU的定位蒸馏损失值![]() 将定位知识从教师模型转移到学生模型。定位蒸馏损失值计算公式为

将定位知识从教师模型转移到学生模型。定位蒸馏损失值计算公式为

(4)

式中 u′i——教师模型边界框和学生模型边界框之间的IoU

本文使用的知识蒸馏算法总损失函数由二分类蒸馏损失值和基于IoU的定位蒸馏损失值组成,以提高分类和定位任务的能力。综合蒸馏损失值计算式为

(5)

式中 a1——分类蒸馏损失值权重

a2——局部蒸馏损失值权重

2.3 实验环境

为了验证文中所改进算法在不同实验环境下的有效性,搭建3种不同的实验平台,包括计算机开发平台以及两种嵌入式测试平台。在计算机开发平台上选用Windows 10 x64操作系统,CPU为Intel® CoreTM i7-10700F CPU 2.90 GHz,GPU为NVIDIA GeForce RTX 3070 8 G,运行内存为 32 GB RAM。

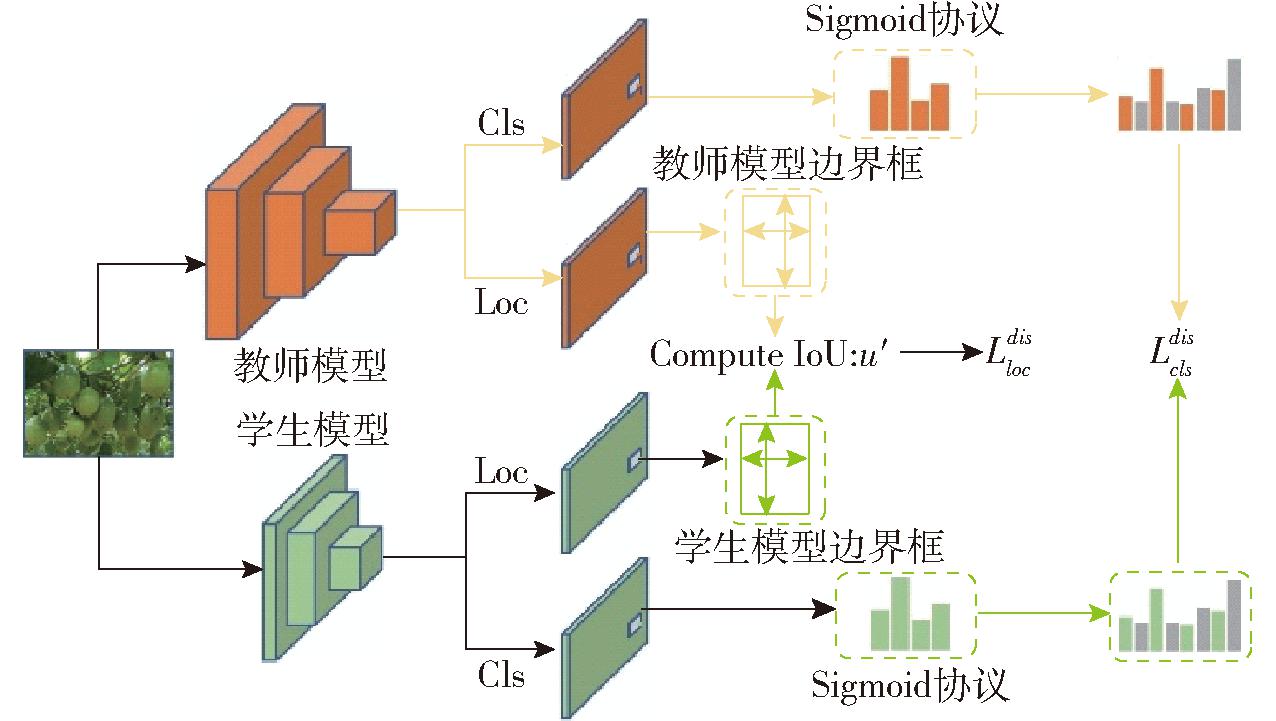

嵌入式测试平台选用英伟达公司台的Jetson Nano和Jetson Tx2设备,主要用于模型推理和测试。实验环境选用Ubuntu 18.04系统,系统配置为Jetpack 4.5、CUDA 10.2、cuDNN 8.0。编程语言为Python 3.6,深度学习框架采用Pytorch 1.8.1、Torchvision 0.9.1。测试图如图7所示。

图7 嵌入式设备测试图

Fig.7 Embedded device test chart

2.4 模型评价指标

为了评估改进后模型检测性能,采用精确率(P)、召回率(R)、平均精度(AP)、参数量(Param)、每秒浮点运算次数(FLOPs)、模型内存占用量、帧率(FPS)作为评价指标。

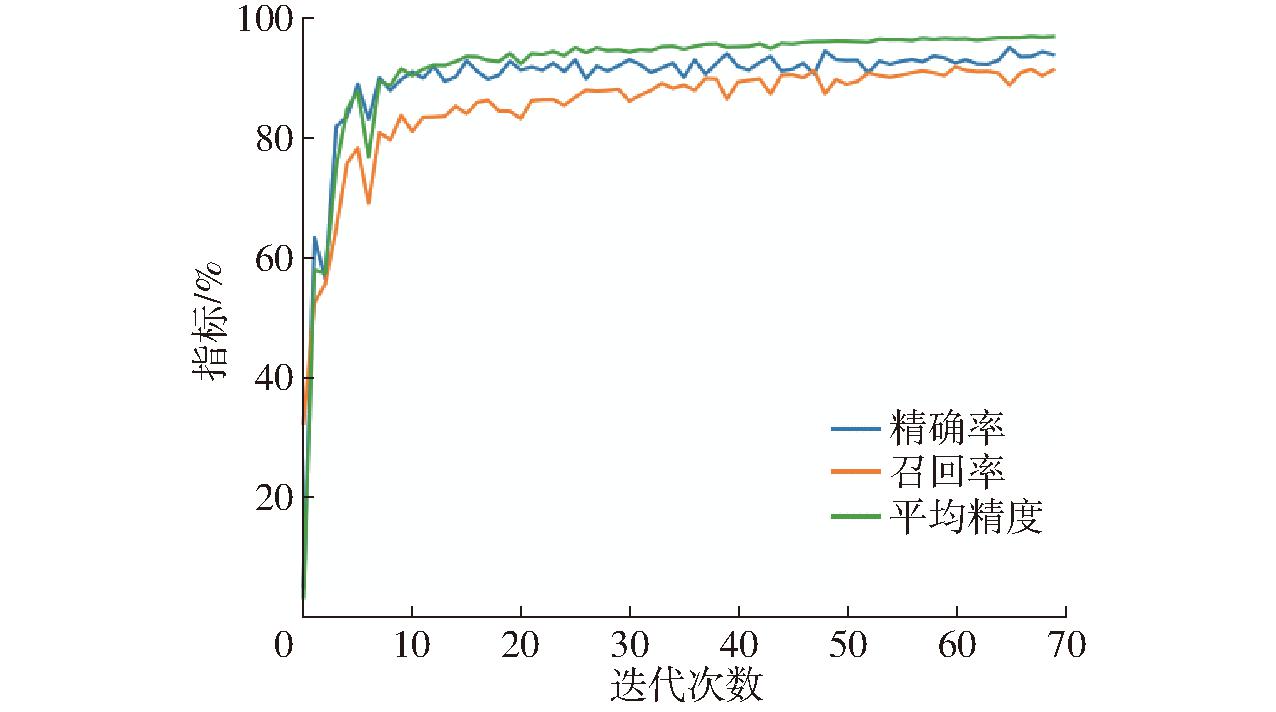

在计算机开发平台训练具体参数如下:输入图像为640像素×640像素,批量大小、初始学习率和初始动量分别设置为16、0.001和0.937。测试时设置置信度为0.5,交并比(IoU)为0.7。优化器设置为Adam。将训练迭代次数设置为70,以获得最佳模型,训练70次后,测试集精确率、召回率和平均精度变化曲线如图8所示。网络训练前10次内,所有指标迅速上升,然后进入稳定收敛阶段。60次后,平均精度平缓上升,曲线收敛,表明模型训练效果优。

图8 训练模型参数指标变化曲线

Fig.8 Trend of parameters of training model

3 结果与分析

3.1 不同颈部网络对比

为了选取一个特征融合效果最好的网络作为YOLO v8s模型的颈部网络,比较不同特征融合层和配置对颈部网络性能的影响,选取5种类型的颈部网络,即加权双向特征金字塔网络(BIFPN)[27]、尺度序列特征融合网络(ASF)[28]、通用特征金字塔网络(GFPN)[29]、高级筛选特征金字塔网络(HSFPN)[30]、GD机制。为了避免偏差,保持主干网络和检测头不变,实验结果如表2所示。

表2 不同颈部网络性能对比

Tab.2 Comparison of different neck networks

模型精确率/%召回率/%平均精度/%浮点计算次数/FLOPs参数量模型内存占用量/MBYOLO v8BIFPN94.6091.3095.002.500×10107.360×10614.30YOLO v8ASF93.7092.7095.603.010×10101.128×10721.70YOLO v8GFPN95.0091.9095.402.920×10101.211×10723.60YOLO v8HSFPN93.7092.1094.602.390×10107.130×10613.80YOLO v8GD94.9091.6095.902.990×10101.361×10726.40

相较于原始YOLO v8s模型,改进后模型(YOLO v8s-GD)精确率和平均精度(AP)分别提升1.1、1.8个百分点,表明有利于复杂环境下百香果特征提取,但是参数量和模型内存占用量分别提升2.48×106、5 MB,降低了模型检测速度,不利于在嵌入式设备上部署。相比于YOLO v8-BIFPN、YOLO v8-ASF、YOLO v8-GFPN、YOLO v8-HSFPN模型平均精度提高0.9、0.3、0.5、1.3个百分点,说明GD机制在特征融合方面的有效性,保障了在后续轻量化过程中模型精度不会受到太大的影响。所提出的 5种网络代替颈部后的结果和原网络结果有差距,表明网络有效性受到其参数量和特殊网络结构的影响。经过替换颈部网络提升了模型平均精度。

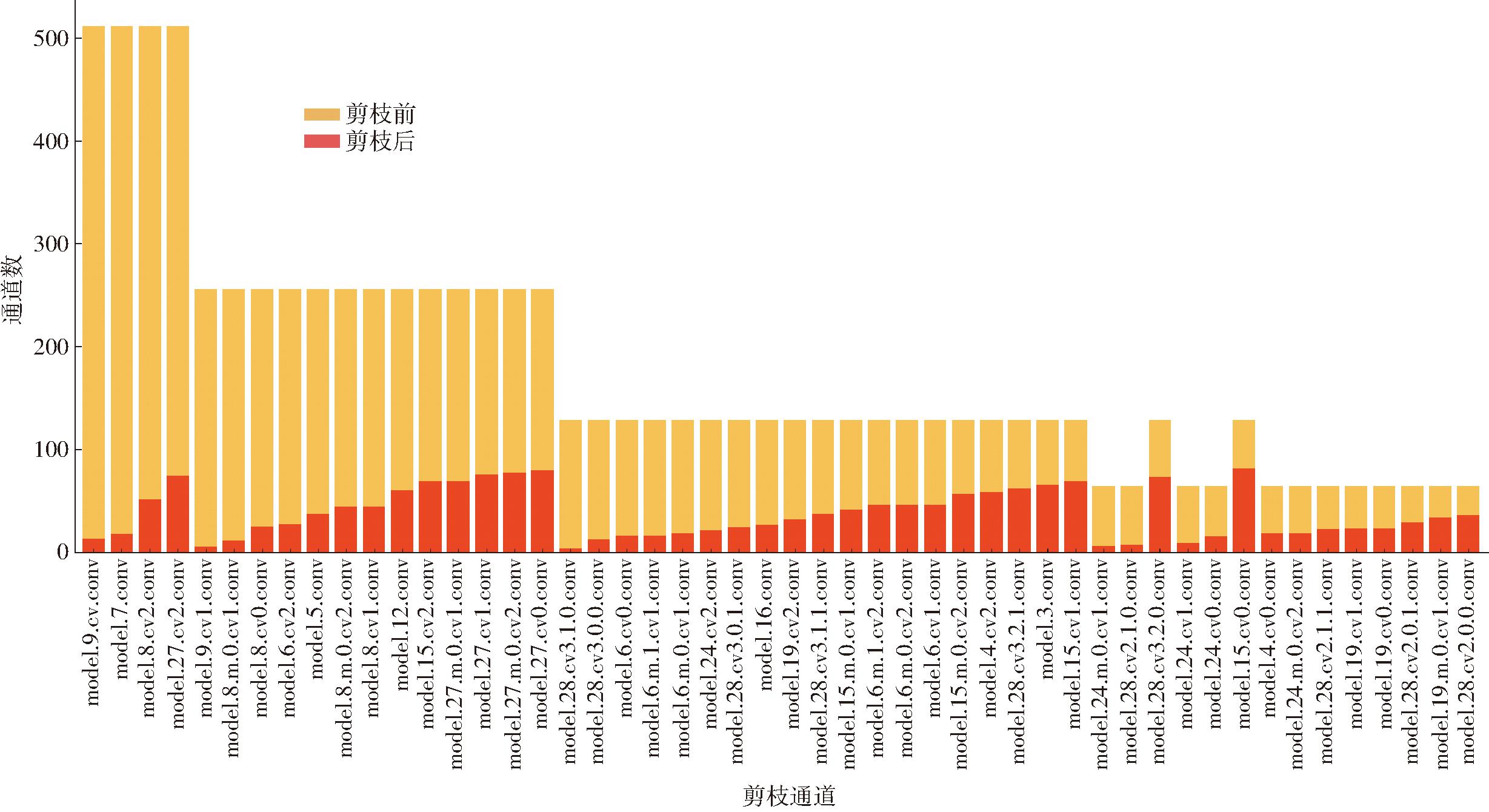

3.2 模型剪枝实验

在模型修剪时,发现随着压缩比率的增加,模型损失精度也随之增加。表3为不同压缩比率下模型性能指标。当压缩比率小于3时,精确率、召回率和平均精度影响较小,浮点计算次数、参数量和模型内存占用量大幅减小;在压缩比率大于3后,召回率和平均精度大幅降低,但参数量和模型内存占用量变化不大,说明在压缩比率大于3后,修剪通道已经影响到模型性能,所以本研究取压缩比率为3的剪枝策略对模型进行修剪。

表3 不同压缩比率对改进模型性能的影响

Tab.3 Impact of different compression ratios on improved model

压缩比率精确率/%召回率/%平均精度/%浮点计算次数/FLOPs参数量模型内存占用量/MB2.094.1091.2095.601.480×10105.91×10611.72.593.5090.7095.201.180×10104.64×1069.293.093.7090.3094.709.80×1094.02×1068.113.593.5088.2091.208.40×1093.77×1067.624.092.7087.9089.507.30×1093.59×1067.28

图9为LAMP剪枝策略下,按照修剪程度排序的各通道的修剪前后情况对比,可以看出在替换颈部网络的同时,也带来了大量冗余参数。

图9 各通道修剪前后对比

Fig.9 Comparison of each channel before and after pruning

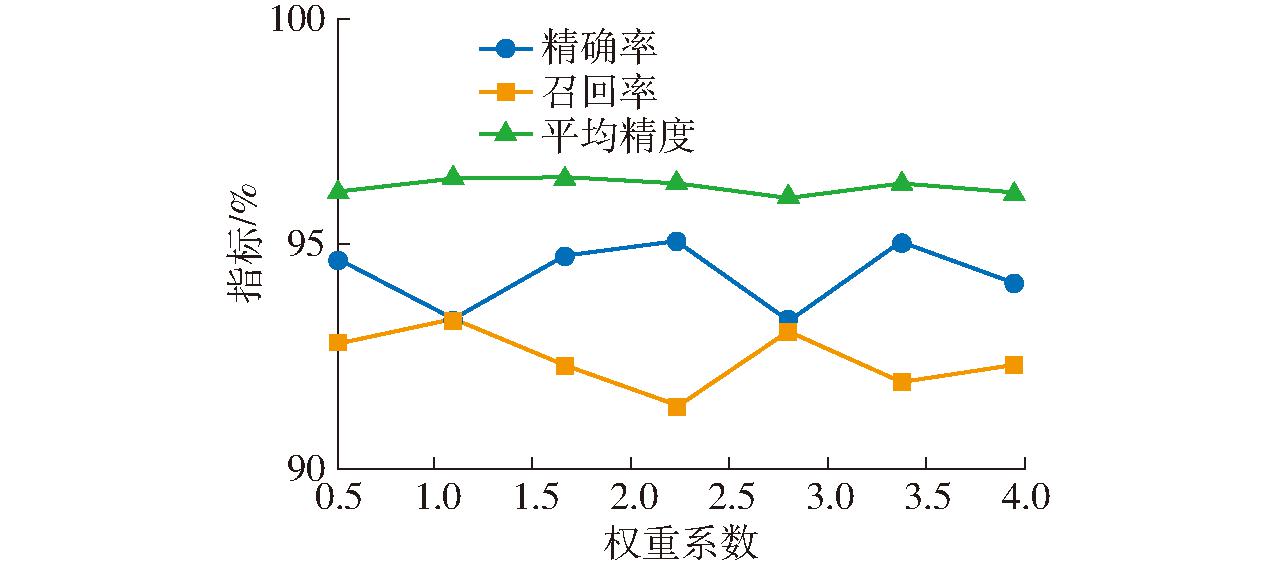

3.3 知识蒸馏实验

在蒸馏实验中发现蒸馏权重系数对蒸馏效果有很大的影响。因此在学生模型和教师模型(YOLO v8s-GD)基础上探讨不同蒸馏权重系数对知识蒸馏的影响。结果如图10所示。从图10可以看出,当蒸馏权重系数为2.0时,蒸馏后模型具有较高精确率和平均精度,分别为94.70%和96.40%。随着蒸馏权重系数的不同,精确率和召回率曲线出现上下波动,说明不同权重系数会导致模型关注百香果特征信息不同。而平均精度均值一直趋于较高的水平,说明蒸馏后模型对百香果检测性能良好。

图10 不同权重系数下模型性能

Fig.10 Model performance with different weight coefficients

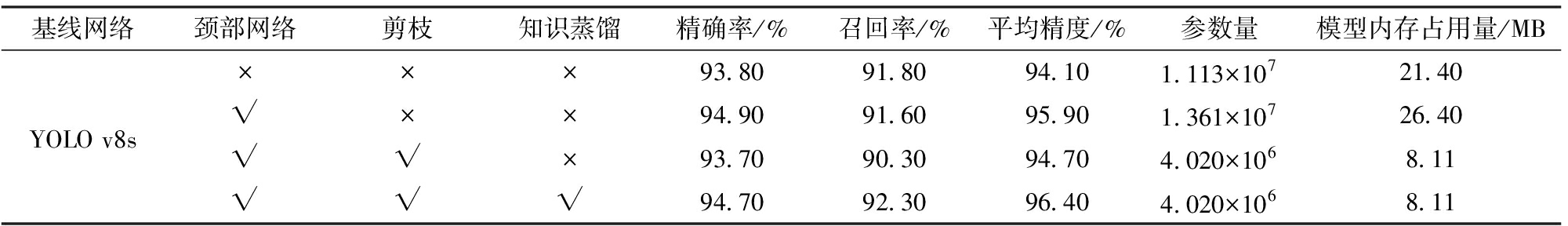

3.4 消融实验

消融实验旨在分析每一种改进存在的价值。以自制数据集为基础进行了消融实验,对改进后模型进行测试,实验结果如表4所示。从表4可看出,在YOLO v8s基线网络上进行更换颈部网络、轻量化剪枝、知识蒸馏增强等操作,改进后网络精度可满足检测要求。使用GD机制替换颈部网络更有利于百香果特征融合,模型精度相较于基线网络提升1.8个百分点。然而,模型参数量和模型内存占用量也随之增加,造成上述原因是改进模型提取更多的百香果参数,不利于嵌入式模型部署。为了弥补上述缺陷,利用剪枝算法对模型冗余参数进行修剪,可以看出,模型参数量和模型内存占用量都有大幅度降低,但由于参数量减少引起精确率、召回率和模型精度有所下降。使用知识蒸馏增强的方式,教师网络给学生网络传递丰富的百香果特征信息,大幅度提升了剪枝后模型精度。与基线网络相比,经过上述改进后模型精确率、召回率和平均精度分别提高0.9、0.5、2.3个百分点,模型参数量和模型内存占用量分别减小63.88%和62.10%。

表4 消融试验结果

Tab.4 Ablation experiment

基线网络颈部网络剪枝知识蒸馏精确率/%召回率/%平均精度/%参数量模型内存占用量/MB×××93.8091.8094.101.113×10721.40YOLO v8s√××94.9091.6095.901.361×10726.40√√×93.7090.3094.704.020×1068.11√√√94.7092.3096.404.020×1068.11

注:×表示不使用该改进方法;√表示使用该改进方法。

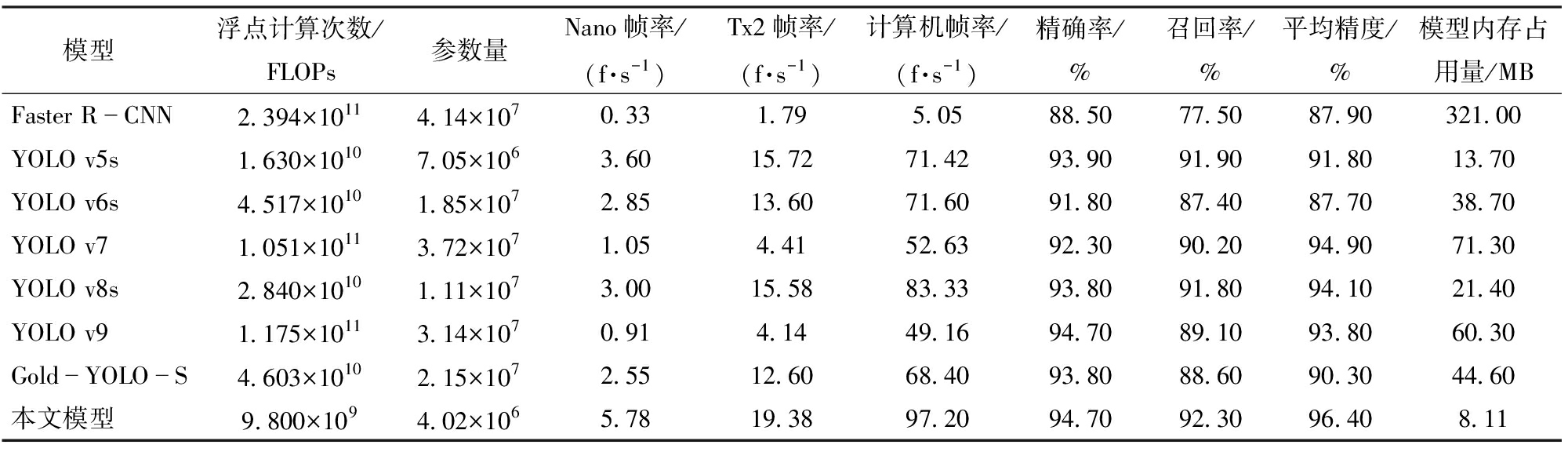

3.5 与不同检测模型对比

为了比较改进后模型与目前主流目标检测模型性能,以浮点计算次数、参数量、帧率、精确率、召回率、平均精度和模型内存占用量为指标,将本文模型与模型Faster R-CNN、YOLO v5s、YOLO v6s、YOLO v7、YOLO v8s、YOLO v9和Gold-YOLO-S在同一自制数据集上进行对比,实验结果如表5所示。由表5可看出,Faster R-CNN作为二阶段目标检测算法,其参数量和浮点计算次数都较大,且模型内存占用量更是比一阶段目标检测算法大,因此认为二阶段目标检测算法不太满足本数据集轻量化的实时检测需求。本研究改进后模型平均精度为96.4%,相较于原始YOLO v8s提高2.3个百分点,相较于Faster R-CNN、YOLO v5s、YOLO v6s、YOLO v7、YOLO v9和Gold-YOLO-S分别提高8.5、4.6、8.7、1.5、2.6、6.1个百分点。本文模型平均精度最优,说明对百香果检测能力强。改进后模型内存占用量和参数量分别为8.11 MB、和4.02×106,约为原始YOLO v8s模型的1/3。从实时检测速度来看,本文模型在计算机的检测速度均优于其他7类模型,在Jetson Nano和Jetson Tx2嵌入式设备上的实时检测速率分别为5.78、19.38 f/s,约为YOLO v5s的1.61、1.23倍,约为YOLO v8s的1.93、1.24倍,基本满足实时检测的要求。浮点计算次数相比于Faster R-CNN减少95.91%,相比于YOLO v5s和YOLO v6s减少39.88%和78.30%,相比于YOLO v7和YOLO v8s减少90.68%和65.50%,相比于YOLO v9和Gold-YOLO-S减少91.66%和78.71%。通过以上分析,本文模型在多个指标方面均展现出优越性,具有良好的综合性能,在移动终端上具有更好的实时性,适用于轻量级实时目标检测场景。

表5 不同网络检测性能对比

Tab.5 Comparison on detection performance of different networks

模型浮点计算次数/FLOPs参数量Nano帧率/(f·s-1)Tx2帧率/(f·s-1) 计算机帧率/(f·s-1) 精确率/%召回率/%平均精度/%模型内存占用量/MBFaster RCNN2.394×10114.14×1070.331.795.0588.5077.5087.90321.00YOLO v5s1.630×10107.05×1063.6015.7271.4293.9091.9091.8013.70YOLO v6s4.517×10101.85×1072.8513.6071.6091.8087.4087.7038.70YOLO v71.051×10113.72×1071.054.4152.6392.3090.2094.9071.30YOLO v8s2.840×10101.11×1073.0015.5883.3393.8091.8094.1021.40YOLO v91.175×10113.14×1070.914.1449.1694.7089.1093.8060.30GoldYOLOS4.603×10102.15×1072.5512.6068.4093.8088.6090.3044.60本文模型9.800×1094.02×1065.7819.3897.2094.7092.3096.408.11

3.6 改进前后识别效果对比

根据模型对比验证结果,选用YOLO v5s、YOLO v8s以及本文模型在百香果的检测中进行可视化对比,随机选择光照影响、遮挡和多目标情况下进行测试。选取置信度阈值为0.5,IoU阈值为0.7,其检测结果如图11所示。图中红色矩形框为预测目标框,黑色矩形框为漏检目标。根据A组的对比实验结果可以看出,当受光照影响较大时,3种模型均出现漏检现象,其中YOLO v5s和YOLO v8s漏检2个百香果对象,而本文模型仅漏检1个百香果对象;根据B组实验可以看出,遮挡较为严重时,本文模型检测效果优异,而YOLO v5s和YOLO v8s分别漏检3个和2个百香果对象;根据C组实验,在多目标检测时,可以看出本文模型可以检测到另外两个模型检测不到的小目标。从置信度方面看,本文模型置信度较高,说明改进后模型检测效果优。本文模型具有良好的鲁棒性和泛化能力。

图11 3种模型检测效果对比

Fig.11 Comparison of detection effects of three models

4 结论

(1)针对复杂自然环境下轻量化百香果目标快速检测问题,在YOLO v8s的基础上,替换模型中的颈部网络为聚集和分发机制,提升模型特征融合能力;采用剪枝策略对改进后模型修剪,减少模型浮点计算次数和模型参数量,同时减小模型内存占用量;使用知识蒸馏学习策略提高网络模型的检测精度。最终实现了具有低计算量、低时延性和高精度百香果快速检测模型。

(2)实验结果表明,改进模型精确率、召回率和平均精度分别为94.70%、92.30%和96.40%。与Faster R-CNN、YOLO v5s、YOLO v6s、YOLO v7和YOLO v9模型相比,在百香果数据集上该模型具有最高的平均精度和最佳的综合性能。相比较于原YOLO v8s基线网络模型,精确度、召回率和平均精度分别提高0.9、0.5、2.3个百分点,模型参数量、浮点计算次数和模型内存占用量分别下降63.88%、65.50%和62.10%。并且在计算机和两种嵌入式设备上检测帧率分别提高13.87、2.78、3.8 f/s。改进后模型平均精度等均优于对比模型,且参数量和模型内存占用量均最低。

(3)结果表明,改进后轻量化模型检测效果优于YOLO v5s和YOLO v8s,对于百香果识别效果更好,能够快速精准检测出复杂环境下和多目标场景的百香果,兼顾精度同时满足实时性需求,说明改进模型综合性能最优,具有较好的鲁棒性,可为百香果采摘识别提供支持。

[1] 鲍秀兰,马志涛,马萧杰,等.丘陵果园自然环境下柑橘采摘机器人设计与试验[J].农业机械学报,2024,55(4):124-135.

BAO Xiulan, MA Zhitao, MA Xiaojie, et al. Design and experiment of citrus picking robot in hilly orchard natural environment[J]. Transactions of the Chinese Society for Agricultural Machinery,2024,55(4):124-135.(in Chinese)

[2] 张领先,景嘉平,李淑菲,等.基于图像自动标注与改进YOLO v5的番茄病害识别系统[J].农业机械学报,2023,54(11):198-207.

ZHANG Lingxian, JING Jiaping, LI Shufei, et al. Tomato disease recognition system based on image automatic labeling and improved YOLO v5[J]. Transactions of the Chinese Society for Agricultural Machinery,2023,54(11):198-207.(in Chinese)

[3] BANSAL R, LEE W S, SATISH S. Green citrus detection using fast Fourier transform (FFT) leakage[J]. Precision Agriculture, 2013, 14(1): 59-70.

[4] PENG H, SHAO Y, CHEN K, et al. Research on multi-class fruits recognition based on machine vision and SVM[J]. IFAC-PapersOnLine, 2018, 51(17): 817-821.

[5] TU S, PANG J, LIU H, et al. Passion fruit detection and counting based on multiple scale Faster R-CNN using RGB-D images[J]. Precision Agriculture, 2020, 21(5): 1072-1091.

[6] WU X, TANG R. Fast detection of passion fruit with multi-class based on YOLO v3[C]∥Proceedings of 2020 Chinese Intelligent Systems Conference: Volume II. Springer Singapore, 2021: 818-825.

[7] YANG R, HU Y, YAO Y, et al. Fruit target detection based on BCo-YOLO v5 model[J]. Mobile Information Systems, Hindawi, 2022, 2022: e8457173.

[8] GAI R, CHEN N, YUAN H. A detection algorithm for cherry fruits based on the improved YOLO-v4 model[J]. Neural Computing and Applications, 2023, 35(19): 13895-13906.

[9] AN Q, WANG K, LI Z, et al. Real-time monitoring method of strawberry fruit growth state based on YOLO improved model[J]. IEEE Access, 2022, 10: 124363-124372.

[10] LI Q, MA W, LI H, et al. Cotton-YOLO: improved YOLO v7 for rapid detection of foreign fibers in seed cotton[J]. Computers and Electronics in Agriculture, 2024, 219:108752.

[11] 张震,周俊,江自真,等.基于改进YOLO v7轻量化模型的自然果园环境下苹果识别方法[J].农业机械学报,2024,55(3):231-242.

ZHANG Zhen, ZHOU Jun, JIANG Zizhen, et al. Lightweight apple recognition method in natural orchard environment based on improved YOLO v7 model[J]. Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):231-242.(in Chinese)

[12] MENG F, CHENG H, LI L, et al. Pruning filter in filter[J]. Advances in Neural Information Processing Systems,2020,33:17629-17640.

[13] 黄海松,陈星燃,韩正功,等.基于多尺度注意力机制和知识蒸馏的茶叶嫩芽分级方法[J].农业机械学报,2022,53(9):399-407,458.

HUANG Haisong, CHEN Xingran, HAN Zhenggong, et al. Tea buds grading method based on multiscale attention mechanism and knowledge distillation[J]. Transactions of the Chinese Society for Agricultural Machinery,2022,53(9):399-407,458.(in Chinese)

[14] HOWARD A,SANDLER M,CHEN B, et al.Searching for MobileNetV3[C]∥2019 IEEE/CVF International Conference on Computer Vision (ICCV), 2019: 1314-1324.

[15] MA N, ZHAN X, ZHENG H T, et al. Shufflenet v2: practical guidelines for efficient cnn architecture design[C]∥Proceedings of the European Conference on Computer Vision (ECCV), 2018: 116-131.

[16] TANG Y, HAN K, GUO J, et al. GhostNetv2: enhance cheap operation with long-range attention[J]. Advances in Neural Information Processing Systems, 2022, 35: 9969-9982.

[17] SHEN L, SU J, HE R, et al. Real-time tracking and counting of grape clusters in the field based on channel pruning with YOLO v5s[J]. Computers and Electronics in Agriculture, 2023, 206: 107662.

[18] LYU S, ZHAO Y, LIU X, et al. Detection of male and female litchi flowers using YOLO-HPFD multi-teacher feature distillation and FPGA-embedded platform[J]. Agronomy, 2023, 13(4): 987.

[19] 梁秀英,贾学镇,何磊,等.基于YOLO v8n-seg和改进Strongsort的多目标小鼠跟踪方法[J].农业机械学报,2024,55(2):295-305,345.

LIANG Xiuying, JIA Xuezhen, HE Lei, et al. Multi-object mice tracking based on YOLO v8n-seg and improved Strongsort[J]. Transactions of the Chinese Society for Agricultural Machinery,2024,55(2):295-305,345.(in Chinese)

[20] GE Z, LIU S, WANG F, et al. YOLOX: exceeding YOLO series in 2021[J]. arXiv preprint arXiv:2107.08430, 2021.

[21] WANG C Y, BOCHKOVSKIY A, LIAO H Y M. YOLO v7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023: 7464-7475.

[22] WANG C, HE W, NIE Y, et al. Gold-YOLO: efficient object detector via gather-and-distribute mechanism[J]. Advances in Neural Information Processing Systems, 2024, 36: 51094-51112.

[23] GUI Z, CHEN J, LI Y, et al. A lightweight tea bud detection model based on YOLO v5[J]. Computers and Electronics in Agriculture, 2023, 205: 107636.

[24] LEE J, PARK S, MO S, et al. Layer-adaptive sparsity for the magnitude-based pruning[J]. arXiv preprint arXiv:2010.07611, 2020.

[25] GOU J, YU B, MAYBANK S J. et al. Knowledge distillation: a survey[J]. International Journal of Computer Vision, 2021, 129:1789-1819.

[26] YANG L, ZHOU X, LI X, et al. Bridging cross-task protocol inconsistency for distillation in dense object detection[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2023: 17175-17184.

[27] TAN M, PANG R, LE Q V. Efficientdet: scalable and efficient object detection[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2020: 10781-10790.

[28] KANG M, TING C M, TING F F, et al. ASF-YOLO: a novel YOLO model with attentional scale sequence fusion for cell instance segmentation[J]. arXiv preprint arXiv:2312.06458, 2023.

[29] XU X, JIANG Y, CHEN W, et al. Damo-YOLO: a report on real-time object detection design[J]. arXiv preprint arXiv:2211.15444, 2022.

[30] CHEN Y, ZHANG C, CHEN B, et al. Accurate leukocyte detection based on deformable-DETR and multi-level feature fusion for aiding diagnosis of blood diseases[J]. Computers in Biology and Medicine, 2024, 170: 107917.