0 引言

水稻作为我国主要粮食作物之一,实现水稻稳产、高产一直是我国农业生产的目标[1]。然而,在水稻生产过程中会出现各种病害,直接影响水稻生长发育,如不及时处理往往会大规模传播,导致产量和品质的大幅下降,造成巨大的经济损失。以稻瘟病为例,水稻种植田块在病害流行年份损失可达 10%~30%,甚至达 40%~50%,稻谷年损失数十万吨[2]。农药处理是防治水稻病害的主要方法,但无节制地使用农药会造成环境破坏[3]。因此,如何准确快速识别水稻病害,并及时采取相应的防治措施,对保证水稻高产、减少经济损失具有重要作用。

目前,水稻病害诊断通常依靠植保专家和农技人员根据经验进行目视判断,但人工方法费时费力,且主观性强,不能满足现代农业生产发展的需求。随着计算机视觉技术的发展,图像处理和机器学习技术辅助诊断成为农业植株病害检测和分类的重要工具[4-6]。此类研究多以植株病斑区域与健康区域的颜色、大小和形态等差异为基准,通过人工干预提取和选择目标特定图像特征,借助支持向量机、决策树、神经网络等分类算法实现植株病害类别的判断[7-10]。但此类研究的病害识别准确度严重依赖于特征提取,而人工设计的特征在表征植株病害的特定信息方面具有局限性且泛化能力弱,其多用于处理单一背景下采集的单个疾病斑块图像。而水稻病害种类多且田间自然环境下水稻病害拍摄的背景复杂多变,如多株水稻植株、光照变化、大的健康水稻叶片等复杂的背景信息,人工设计的图像特征对其鲁棒性较低,难以将水稻病害区域特征从复杂背景中提取出来,从而导致水稻病害的漏检和误检。

相比传统计算机视觉技术方法,深度学习技术凭借其卓越的特征学习能力,在许多图像分析研究中表现出很高的泛化性能,现已被应用于农业植株病害识别领域[11-14]。文献[15]针对少样本和复杂背景下水稻病害识别精度低,提出了一种两阶段识别模型,基于YOLOX检测水稻感病部位以获取病害斑块图像集,利用Siamese网络对水稻病害斑块图像进行病害识别,病害识别平均精度均值(mAP)可达95.58%。文献[16]在ResNet18和ResNet34模型中嵌入自注意力机制,以增强模型特征提取能力,结果表明集成注意力机制的ResNet34识别准确率更高。文献[17]提出了一种基于改进MobileNetV3的轻量级水稻病害识别模型,采用嵌入通道注意力机制的MobileNetV3提取特征,并以训练SVM为分类器实现病害识别。文献[18]针对YOLO v5模型在水稻病害叶片检测计算复杂度高、计算速度慢等问题,提出一种基于改进YOLO v5模型的水稻病害叶片识别检测方法,结果表明模型复杂度降低,识别精度达97%。

基于深度学习的植株病害识别效果取决于模型在训练过程中能否学习到丰富的有用特征。水稻病害多出现于稻叶上,稻叶结构呈细条型,不利于小尺寸病斑区域特征的学习,且水稻病害种类多,病斑尺寸和形状不一,不同的病害具有相似的特征,这要求深度学习模型具有更加灵敏的特征提取能力。尽管复杂网络结构能提取丰富的图像特征,获得较高的识别精度,但计算量大,实时性弱,难以在移动设备上部署。文献[19] 针对复杂的病虫害背景环境下病虫害检测精度低的问题,结合DenseBlock和跨阶段部分网络融合模块(CSPDarknet53 to 2-stage FPN,C2f)[20]改进YOLO主干网络,采用DenseBlock获取浅层边缘纹理信息,基于C2f丰富主干网络的梯度流信息,以优化特征提取能力,增强了模型在复杂环境的鲁棒性。文献[21]为了实现复杂环境下玉米雄流苏的准确检测和密度评估,在YOLO v7中加入空间深度转换卷积(Space-to-depth convolution, SPDConv)[22]优化模型对玉米雄穗图像尺度变化的适应性,实验表明SPDConv结构对低分辨率图像和小目标检测非常有效。文献[23]在YOLO v5中引入轻量级卷积GsConv[24]对特征映射进行深度可分卷积,完成通道间信息交互的同时减少模型参数计算,提高模型运行效率。

基于上述分析,本文针对田间自然环境下水稻病害识别过程中背景复杂、不同病害间表型特征差异不显著、叶片病害发生初期病斑小等特点,以穗瘟病、叶瘟病、胡麻斑病、稻曲病和白枯病5种常见水稻病害为研究对象,以YOLO v5为基本框架,提出一种改进YOLO v5的水稻病害识别模型(RiceDiseaseNet, RDN-YOLO)。在自然环境下采集水稻病害图像,制作水稻病害数据集;利用C2f模块、SPDConv模块改进模型主干网络,增强模型特征提取能力;在模型颈部网络嵌入SPDConv结构,进一步提升对病害呈斑点状的小目标特征的提取能力,并利用轻量级卷积GsConv替换模型颈部网络中标准卷积,以减轻模型复杂度的同时获得较高精确率和较强鲁棒性。

1 数据材料

1.1 病害图像获取

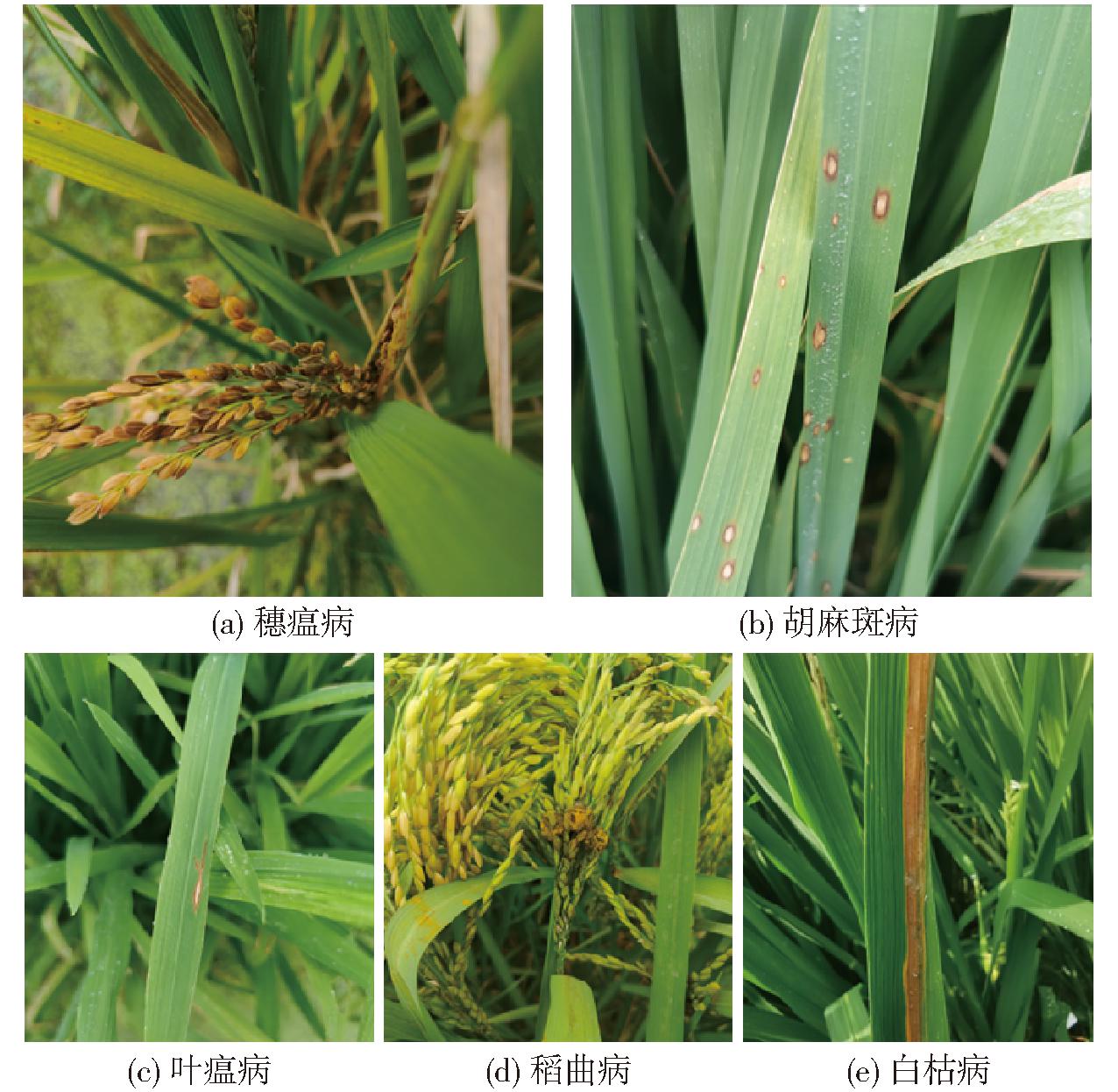

本研究选用5种常见的水稻叶、穗部病害进行识别,包括水稻白枯病(bacterial blight)、叶瘟病(leaf blast)、胡麻斑病(leaf spot)、稻曲病(smut)和穗瘟病(ear blast),5种水稻病害构成的数据集有2种,数据集1为自制的田间水稻叶、穗部病害图像数据集,图像于2023年7—10月采集自安徽农业大学郭河试验基地和安徽省农业科学院植保所试验基地,采集设备为Canon EOS 100D型相机和iPhone 11智能手机,图像分辨率分别为5 184像素×3 456像素和4 032像素×3 024像素,共采集病害图像样本960幅。数据集2为Kaggle官方网站(https:∥www.kaggle.com)公开的Rice disease datasets。图1分别显示了自制的数据集中部分样本示例。为减小后续网络训练所占用的内存和显存,对数据集图像进行压缩处理,处理后图像分辨率为640像素×640像素。

图1 自制水稻病害数据集部分样本

Fig.1 Samples of self-built rice disease dataset

1.2 数据集构建

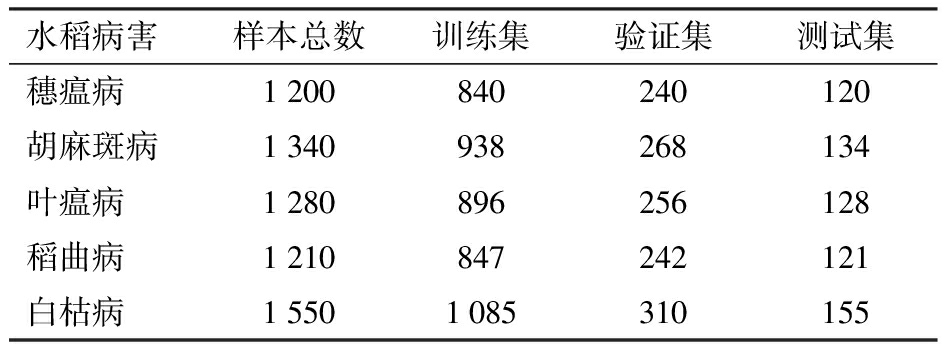

为避免数据集中不同类别病害图像数量不均衡造成模型过拟合或欠拟合,并能增强模型鲁棒性和泛化能力,分别使用图像翻转、随机旋转、 亮度随机减弱或增强、对比度增强或减弱等方式进行数据集扩增,并剔除信息丢失的图像后得到6 580幅病害图像,使用labellmg工具对图像进行单目标标注,标注过程如图2所示。该数据集按照比例7∶2∶1划分为训练集、验证集和测试集,对应的样本数量如表1所示。

表1 水稻病害数据集构成

Tab.1 Composition of rice disease dataset

水稻病害样本总数训练集验证集测试集穗瘟病1200840240120胡麻斑病1340938268134叶瘟病1280896256128稻曲病1210847242121白枯病15501085310155

图2 水稻病害标注过程

Fig.2 Rice disease labeling process

2 水稻病害识别模型设计

2.1 模型结构概述

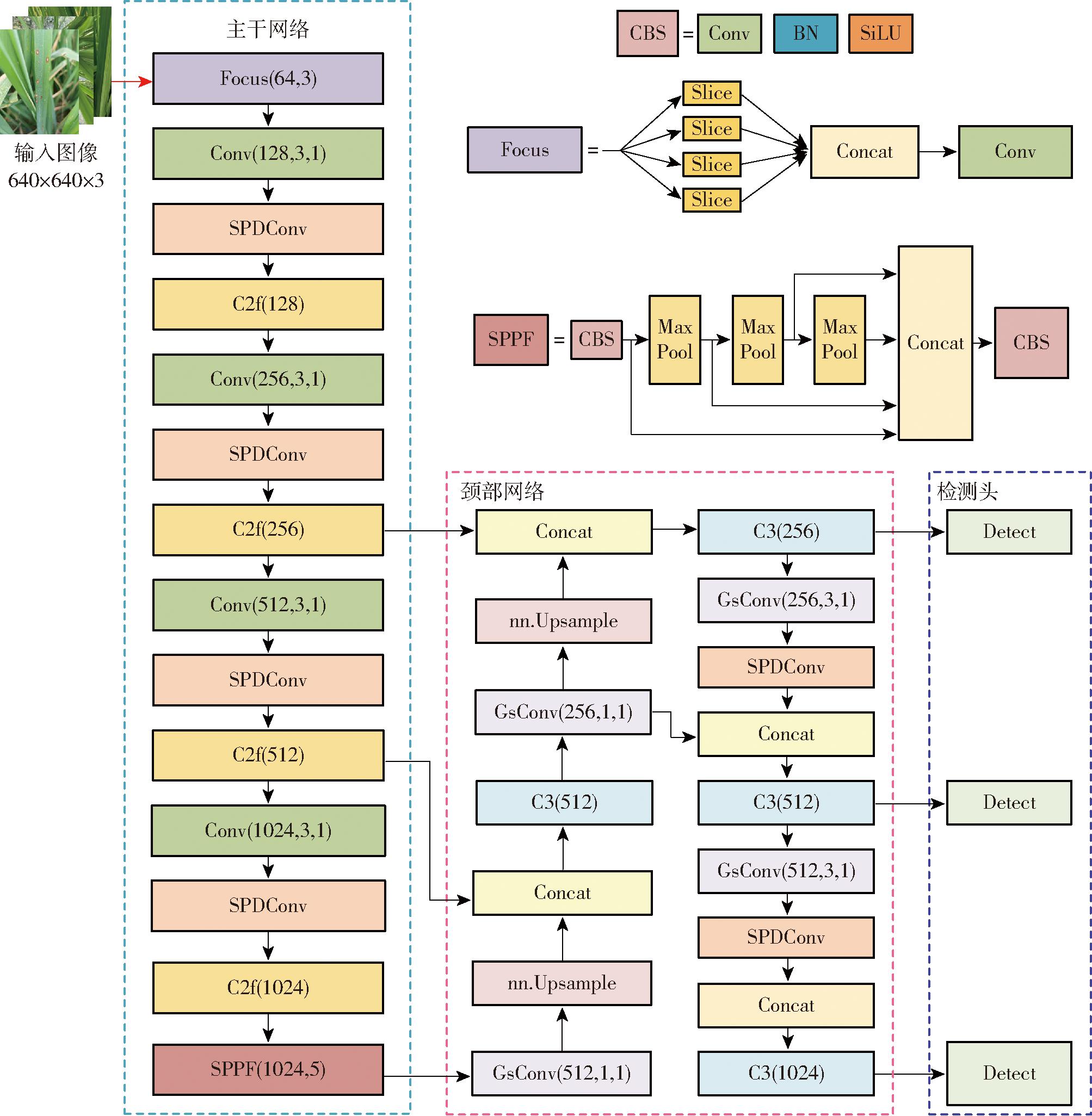

YOLO系列模型属于单阶段目标检测模型,经历多次迭代, 而在诸多版本中,YOLO v5模型具有相对轻量化的网络结构[25]。YOLO v5的网络结构由输入端、 骨干网络、 颈部网络和预测端组成,输入端的数据通过骨干网络的卷积操作提取特征,后经颈部网络进行多层次的特征融合,输入到预测端生成检测目标的类别及位置信息,其对于大中型、显著性目标的检测具有良好的效果。但水稻叶、穗部病害图像背景复杂,且不同类病害在图像中可能表征差异小,同类病害却在形状、位置、大小上差异大,YOLO v5在特征提取时的下采样方式会丢失病害部分关键特征尤其是小目标病害特征,易导致误检、 漏检现象。为有效解决自然背景中病斑图像关键特征提取不充分的问题,并权衡模型检测速度,本文选择检测速度快、模型尺寸小的YOLO v5s为基准模型,在特征信息提取和特征融合方面进行了YOLO v5模型改进,以在不增加模型参数量和计算量的前提下,提高自然背景中水稻病害识别精度。改进后的水稻病害识别网络模型RDN-YOLO结构图如图3所示,首先,在主干网络的特征提取阶段嵌入了C2f模块,使模型的特征提取集中在病斑目标区域,降低复杂背景的干扰;其次,为增强模型对小目标的识别能力,在特征提取和特征融合阶段中增加SPDConv卷积结构,同时为降低模型复杂程度并保持病害识别精度和鲁棒性,在特征融合阶段采取轻量级卷积GsConv替换颈部网络中标准卷积。

图3 水稻病害识别模型RDN-YOLO整体结构图

Fig.3 Structure of rice disease detection model RDN-YOLO

2.2 主干网络特征提取优化

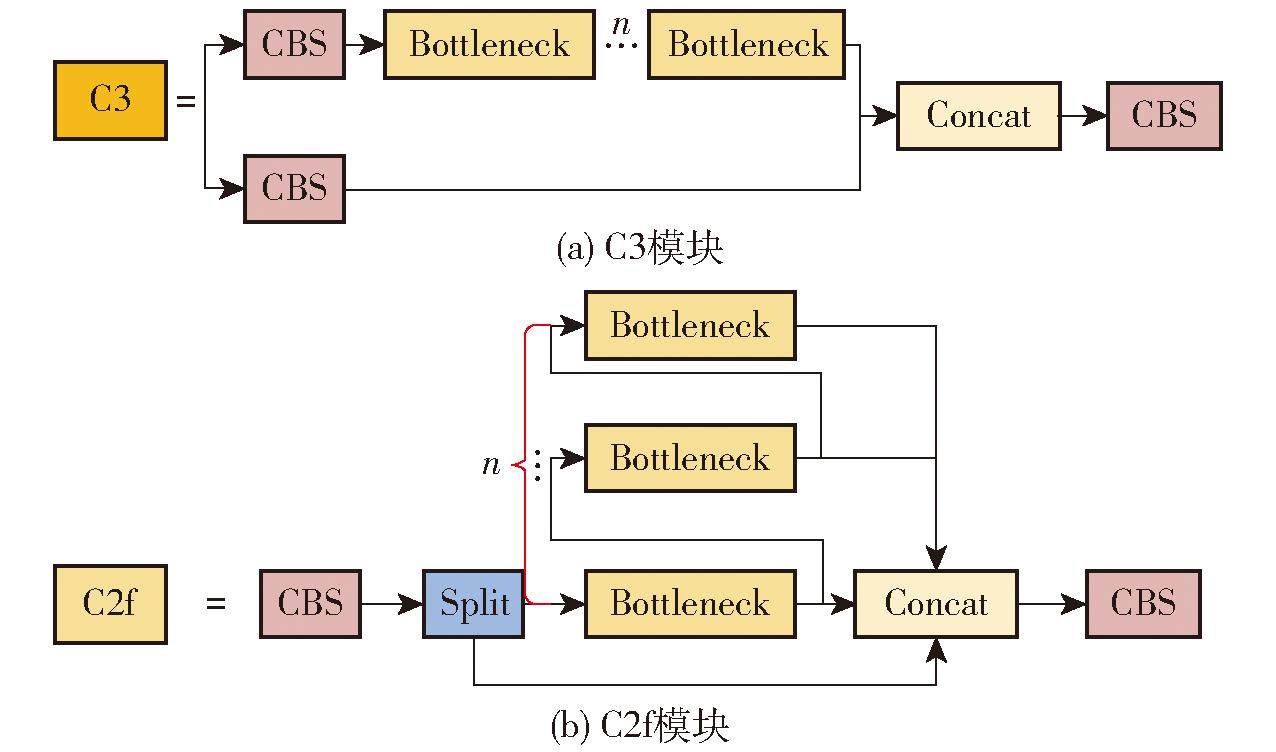

YOLO v5采用C3结构设计主干网络的特征提取模块,C3模块结构如图4a所示,由3个标准CBS模块层和若干瓶颈层组成,瓶颈层之间通过串联来增强网络的感受野。由于水稻病害种类多,同一类型病害在形态、位置、大小上差异可能较大,而不同类型病害却存在相似病斑,且自然环境下采集的水稻病害图像常捕捉到复杂背景,包括田间多株水稻植株、大的健康水稻叶片以及杂草等,这可能会造成网络提取的特征图中特征信息冗余或小病斑的图像特征不明显。C3模块瓶颈层间串联结构没有利用图像中不同区域的梯度信息,感知区域小,不具有全局建模和长距离建模能力[26],特别是针对复杂背景下类间相似病斑,极易造成图像中病斑和周围背景之间的上下文信息丢失,无法充分捕捉到病斑的细节信息,导致难以准确检测复杂背景下水稻叶、穗部病害。而C2f模块通过引入特征分支处理与融合等策略,增强不同尺度上细节特征和语义特征的传播和利用,可有效避免特征信息丢失,丰富特征表达能力。因此,本文在主干网络特征提取阶段引入C2f模块,以提高复杂背景下水稻病害识别准确度。

图4 C3和C2f模块结构

Fig.4 Structure of C3 and C2f modules

C2f模块结构如图4b所示,该模块通过CBS中卷积内核对特征图进行通道间互换,采用split操作对输入的特征图进行分层,一部分特征保留,一部分特征经多个瓶颈层处理,通过特征向量转移和模块内多层嵌套卷积有效地学习多尺度特征,并结合残差和跳跃建立它们之间的连接,实现不同尺度特征图之间的信息传播和融合。C2f模块使得网络可获得图像中不同区域更为丰富的梯度流信息,利用这些信息指导网络训练,增强网络对水稻叶、穗部病害的低级、高级特征表示能力,更有效地提取丰富的强特征表观的病害特征信息,减少无用信息干扰,从而提高复杂背景下水稻叶、穗部病害检测精度。

YOLO v5模型主干网路用于对输入的水稻病害图像进行特征提取,加入C2f提高网络在复杂环境下的特征提取能力,但水稻叶、穗部分布的早期病斑如胡麻斑病、稻瘟病等常呈细小斑点状病症,相较于图像的宽高,其往往属于小目标,用于模型学习的特征信息较少。此外,小目标病斑往往伴随着其他大目标如健康叶片等,在检测过程中,大目标往往会主导学习过程,从而导致模型对部分小目标病斑关注度较低甚至不关注,能学习到小目标的上下文特征信息有限,造成小目标病斑不被检或误检。在这种情况下,卷积神经网络的水稻病害识别性能就会大大降低。与此同时,在YOLO v5中,CNN模型常通过跨步卷积和池化操作进行下采样以输出特定尺寸的特征图,会造成目标的细粒度信息丢失以及模型提取更多的低表达性特征,造成模型对小目标特征学习不足,使小目标的检测精度下降。

针对跨步卷积和池化操作对特征图进行下采样过程中可能丢失小目标病斑特征信息的问题,在主干网络的C2f之前引入空间到深度卷积模块SPDConv,取代原始网络中的跨步卷积和池化。空间到深度卷积模块SPDConv由空间到深度层(Space-to-depth ,SPD)和非跨步卷积层(Non-strided convolution, Conv)组成,如图5所示,SPD层按照下采样尺度因子对水稻叶、穗部病害特征图X(S,S,C1)进行下采样,在水稻叶、穗部病害识别模型中设下采样尺度(scale)为2,则病害特征图X(S,S,C1)将被分割为4个相同尺寸的子特征图,映射式为

f(0,0)=X[0:S:scale,0:S:scale]

(1)

f(1,0)=X[1:S:scale,0:S:scale]

(2)

f(0,1)=X[0:S:scale,1:S:scale]

(3)

f(1,1)=X[scale-1:S:scale,scale-1:S:scale]

(4)

图5 当scale=2时SPDConv示意图

Fig.5 Schematic of SPDConv when scale=2

子特征图较输入特征图实现了对特征图下采样2倍,下采样图中包含了原图全局空间特征信息,增加了模型特征提取能力;在通道维度上对上述4个相同尺寸的子特征图进行拼接,获得中间特征图X′(S/2,S/2,4C1),以减小特征图的空间维度尺寸,增加通道维度中特征层信息;再采用非跨步卷积以逐像素卷积的方式对特征图X′(S/2,S/2,4C1)进行卷积操作,以利用增加的卷积层中的可学习参数来减少通道数的同时将全局空间特征信息保留在通道维度。因此,在主干网络中引入SPDConv,基于SPDConv中的空间到深度层对水稻病害特征图进行下采样,并保留通道维度中的所有判别特征信息,结合无步长卷积操作,实现不减小特征图尺寸情况下进行特征提取,以增加通道尺度上病害图像细粒度信息的保留,从而有助于提高模型对水稻叶、穗部病害尤其小病斑的检测能力。

2.3 颈部网络卷积轻量化

颈部网络主要实现对骨干网络提取到的图像特征的融合,然后将融合结果送至检测端进行识别。在原始的YOLO v5中,主干网络提取的特征图像在颈部网络中经过卷积、上采样和拼接处理,使得不同层次的特征图空间信息逐渐传递到通道中,可能导致特征图中语义信息部分丢失,特别是浅层小目标的重要特征,从而造成病害图像中相似表征病害和小目标病害的识别率降低。虽然密集卷积可基于建立每个通道之间的隐藏连接来减少语义信息的丢失,增加密集卷积层数,获得丰富的目标特征信息,但目标位置信息会变弱,小目标位置损失更大,且网络深度会增加模型计算负担。此外,YOLO v5s最终会输出3个不同层次不同分辨率的特征图到检测头,但低分辨率特征图中小目标病害的特征表示所包含的语义信息较少,而空间信息丰富的底层特征具有更高的分辨率,更适合小目标检测。

为此,将SPDConv模块嵌入到两个低分辨率的特征图生成阶段,替换原始的跨步卷积层,通过SPDConv结构将输入特征图的空间维度转换为通道维度,以在保留细粒度信息的情况下增加特征图的深度,获取尽可能多的空间信息,提升颈部网络对呈斑点部位的小目标病害特征及其位置信息的融合,提高模型对小目标病斑特征表达的学习能力,从而提高模型对小目标病斑的检测性能。然而,SPDConv的引入会增加参数量,且在YOLO v5中,颈部网络通过标准卷积提取特征通道信息的耦合,随着网络的加深,将会增加计算成本。为平衡颈部网络特征提取能力和网络复杂度,采用轻量级卷积GsConv来代替颈部网络融合结构中的标准卷积。

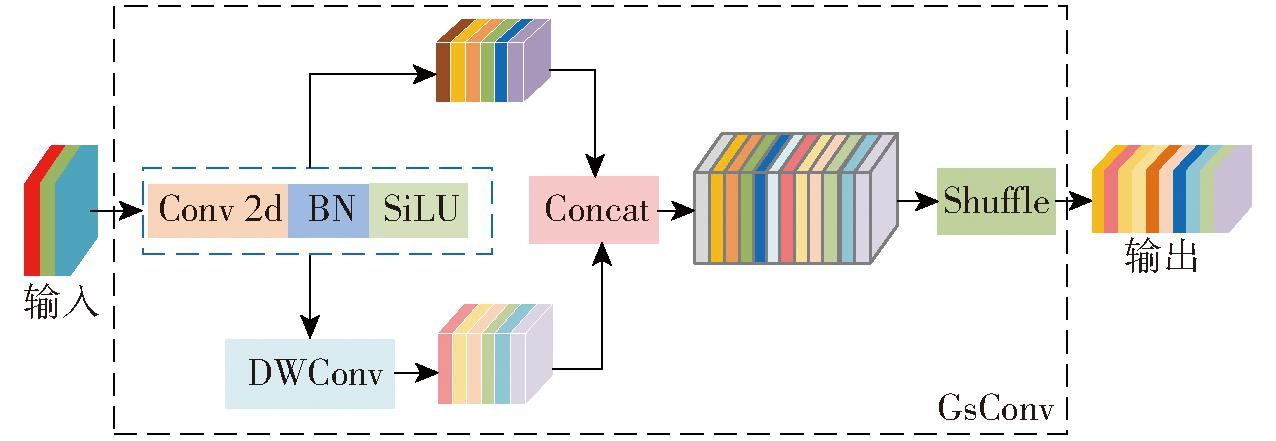

GsConv模块是一种结合密集和稀疏卷积的轻量级卷积层设计,相比标准卷积,GsConv通过在特征图上引入全局稀疏性,在通道之间保持尽可能多的连接,实现对全局信息进行有效聚合的同时仅对稀疏位置进行卷积计算。GsConv模块结构如图6所示,输入特征图通过标准卷积下采样,在此基础上进行深度可分离卷积操作,并在通道维度进行两种卷积后特征图的拼接,结合Shuffle 操作将标准卷积生成的信息渗透到深度可分离卷积的输出中。GsConv将标注卷积与深度可分卷积相结合,增强了特征提取和融合能力,能够更好地捕捉图像中的关键特征。同时,它通过稀疏卷积避免了冗余信息和复杂计算。GsConv与标准卷积的计算复杂度比r计算公式为

(5)

图6 GsConv模块结构图

Fig.6 Structure diagram of GsConv

式中 W——特征图宽度

H——特征图高度

K1——每一个卷积核通道宽度

K2——每一个卷积核通道高度

D1——输入通道数

D2——输出通道数

根据r的计算式可见,相比于标准卷积层将所有卷积核都与每一个输入特征通道进行计算,GsConv可有效地减少计算量和模型训练参数。使用计算量小的GsConv代替YOLO v5s颈部网络中部分标准卷积层,可实现YOLO v5s的轻量化,并基于标准卷积与深度可分离卷积组合的密集卷积特性,在一定程度上避免病害特征空间信息的丢失,保持模型的识别性能。

3 实验结果

3.1 实验平台与参数设置

本文研究模型训练与测试,在配备Intel(R)-CPU Intel i7-13700K CPU、2.30 GHz运行频率、NVIDIA GeForce RTX 4080 GPU和Windows 10 64位操作系统的计算机上执行。网络输入尺寸为640×640×3,迭代次数(Eopch)设置为300,批量大小(batch size)为8,网络模型初始化采用加载预训练的权重初始化主干网络,初始学习率为0.01,采用SGD算法优化,计算每个权重参数的自适应学习率,深度学习框架使用PyTorch,编程语言为Python。

3.2 评价指标

为定量评估模型的识别性能,采用精确率、召回率、平均精度均值(Mean average precision,mAP)和参数量作为评价指标。

在实验中,使用交并比(IoU)判定预测框和真实框的接近程度,当预测框与真实框的 IoU 大于 0.5 时, 将检测结果视为正确得到的mAP, 记作 mAP0.5。参数量用来表示模型大小或算法复杂性,通常,参数量越小,表示模型所需的计算能力越小,对硬件性能要求越低,越能在终端进行部署。

3.3 实验结果分析

3.3.1 消融实验

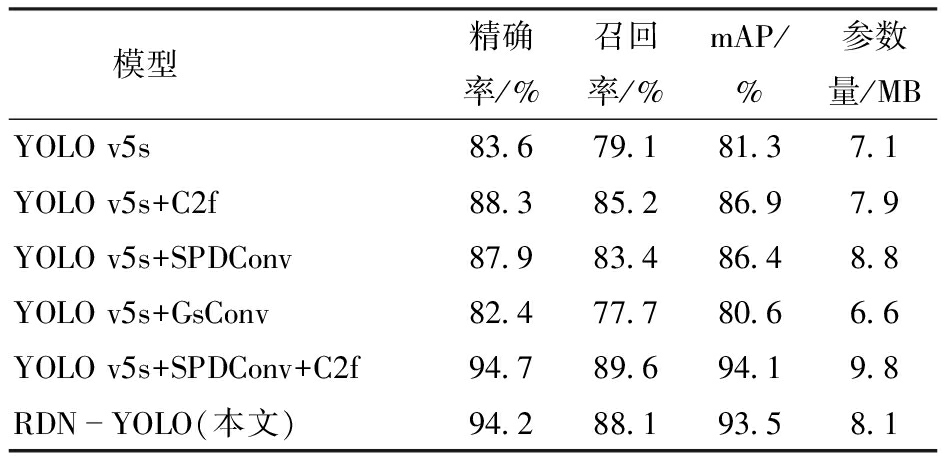

为了验证本文设计的水稻叶、穗部病害识别网络模型RDN-YOLO中SPDConv、C2f和GsConv的有效性,基于自制的病害数据集样本数据分别对YOLO v5s、YOLO v5s+C2f、YOLO v5s+SPDConv等6种结构进行性能测试。表2为6种结构的具体性能参数对比结果,从表中可以看出,与YOLO v5s相比,C2f模块和SPDConv模块嵌入到YOLO v5s,使得YOLO v5s+C2f、YOLO v5s+SPDConv和YOLO v5s+C2f +SPDConv的各项指标均优于YOLO v5s,其中,YOLO v5s+C2f在精确率、召回率和mAP相较YOLO v5s分别提升4.7、6.1、5.6个百分点;YOLO v5s+SPDConv在精确率、召回率和mAP相较YOLO v5s分别提升4.3、4.3、5.1个百分点,而YOLO v5s+C2f +SPDConv在精确率、召回率和mAP相对于YOLO v5s分别提升9.7、8.3、11.4个百分点。可见C2f和SPDConv组合集成到YOLO v5s网络,所得到的模型相比YOLO v5s以及单独添加C2f模块和SPDConv模块,识别性能更好,表明C2f嵌入在主干网络中能够对病害识别网络产生正向的效果,增强主干网络对复杂背景下水稻叶、穗部病害的感知能力,而SPDConv在主干网络和颈部网络的嵌入进一步增强模型对水稻病害有效特征的关注,提高了模型识别效果。然而,C2f模块、SPDConv模块的嵌入会增加模型层数,与YOLO v5s相比,参数量增加38.0%。GsConv模块的引入会降低模型参数量,与YOLO v5s相比,参数量降低7.0%,虽在精确率、召回率、mAP分别下降1.2、1.4、0.7个百分点。将GsConv模块与YOLO v5s、C2f模块、SPDConv模块组合构建的本文RDN-YOLO网络模型,不仅实现了网络的轻量化,比仅使用C2f和SPDConv组合下降17.3%,虽略逊于YOLO v5s,但在精确率、召回率和mAP方面,比YOLO v5s增加10.6、9.0、12.2个百分点。

表2 不同模块组合的模型性能参数

Tab.2 Performance parameters of different module combinations

模型精确率/%召回率/%mAP/%参数量/MBYOLO v5s83.679.181.37.1YOLO v5s+C2f88.385.286.97.9YOLO v5s+SPDConv87.983.486.48.8YOLO v5s+GsConv82.477.780.66.6YOLO v5s+SPDConv+C2f94.789.694.19.8RDNYOLO(本文)94.288.193.58.1

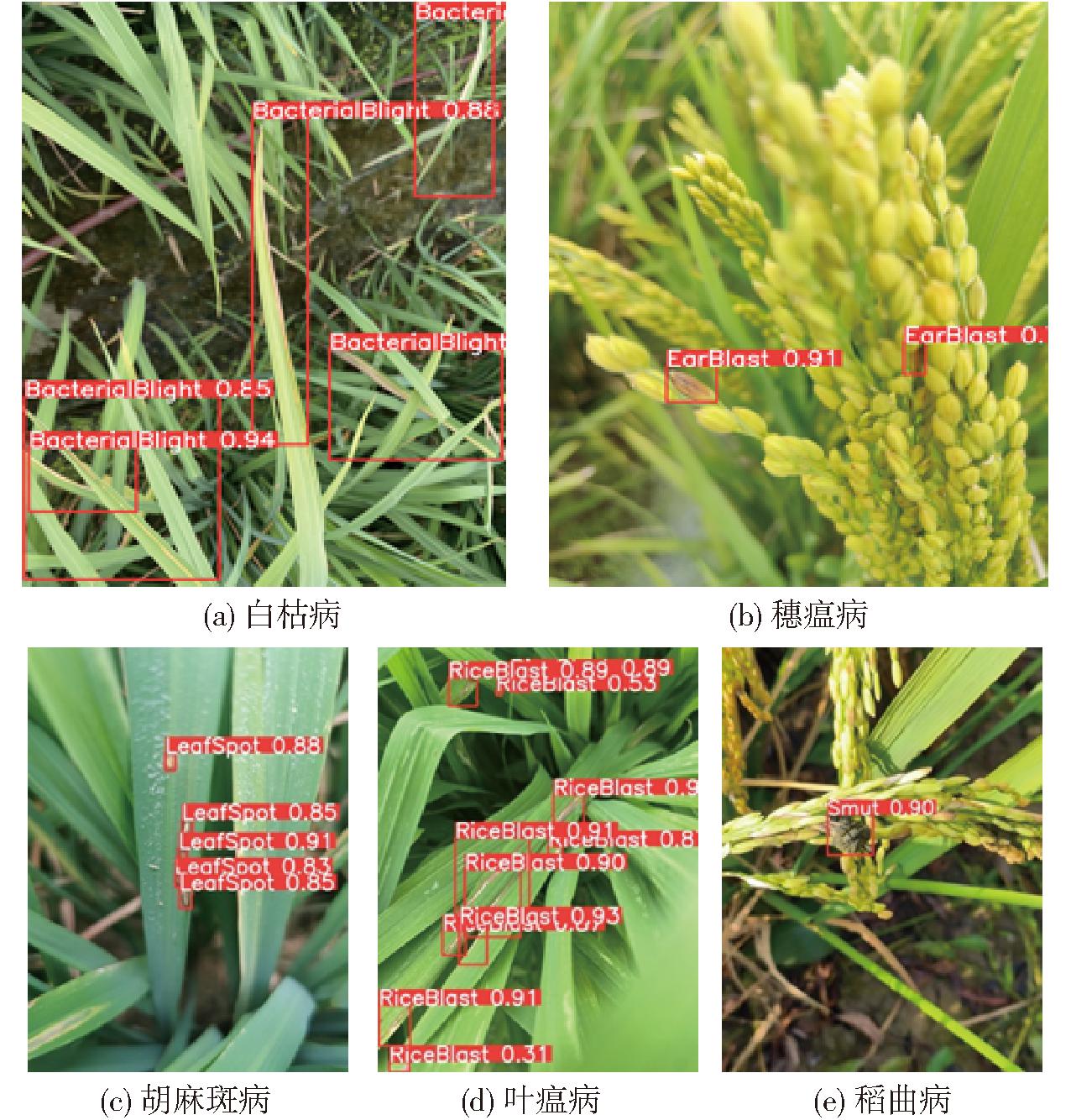

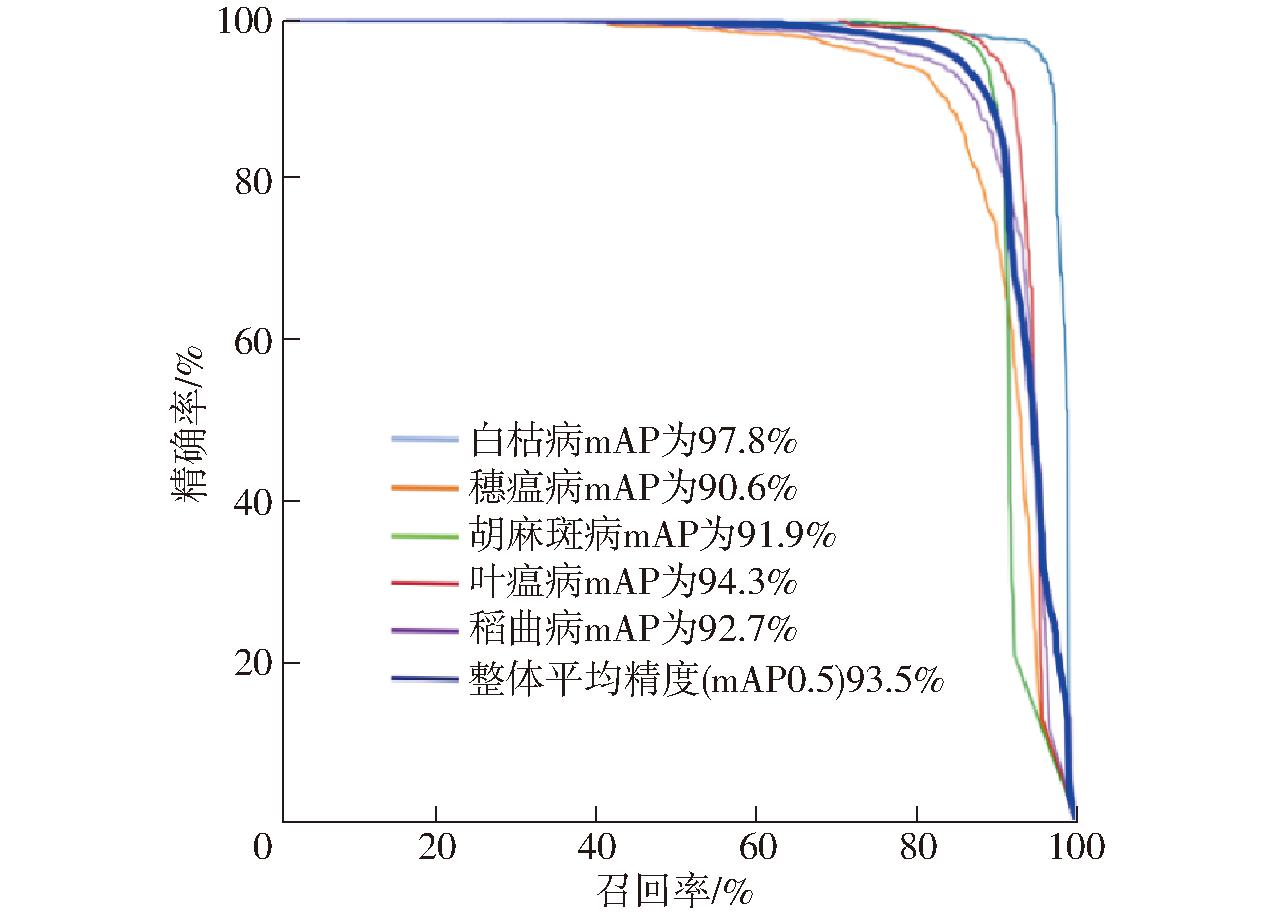

由以上分析可以看出,C2f、SPDConv和GsConv组合使用的RDN模型,在复杂背景下检测水稻病害中取得较好检测效果的同时也保持了一定的轻量级优势。为了直观显示RDN-YOLO模型的病害识别效果,图7显示了RDN-YOLO模型对水稻叶、穗部病害识别的效果,RDN-YOLO能够在多株水稻植株、大的健康水稻叶片及杂草等共存的复杂环境下很好地检测出多尺度、不同种类的水稻叶、穗部病害,且漏检和误检情况较少。除此,为量化分析RDN-YOLO对不同病害的识别效果,使用RDN-YOLO在训练过程中得到的精确率和召回率绘制了不同病害精确率-召回率曲线,如图8所示,精确率-召回率曲线与坐标轴围成的面积即为该类型的平均精度,即交并比阈值为0.5时类型的平均精度均值。

图7 RDN-YOLO水稻病害识别效果

Fig.7 Results of rice disease identification of RDN-YOLO

图8 RDN-YOLO模型P-R曲线

Fig.8 P-R curves of RDN-YOLO model

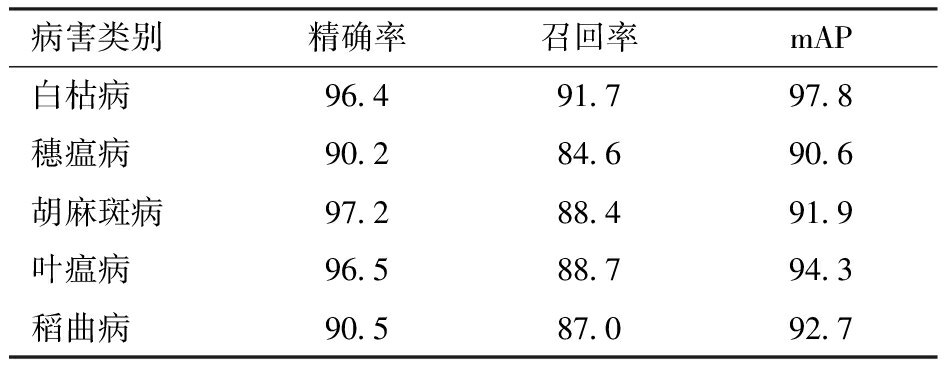

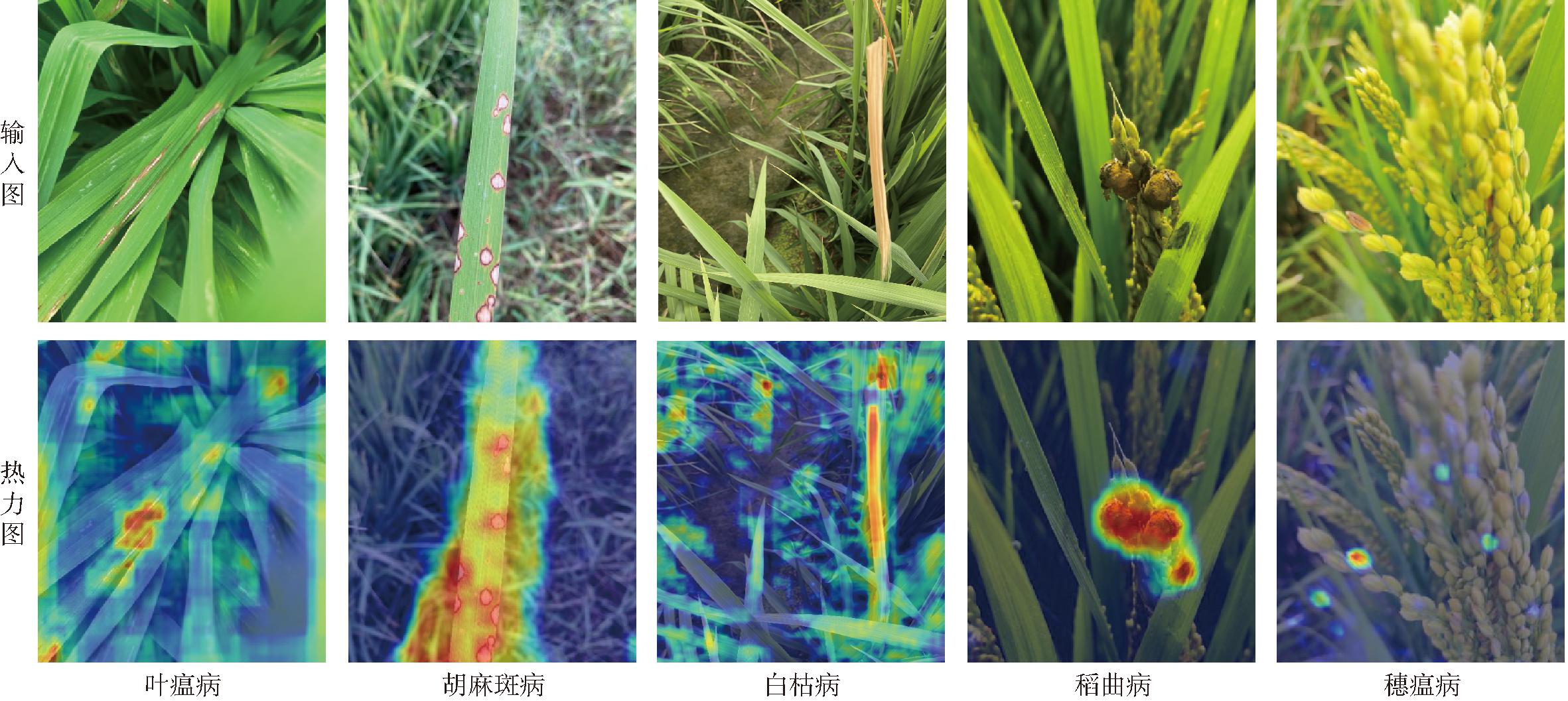

由图8可见,在不同类型水稻病害下,曲线与坐标轴之间的面积差很小,表明RDN-YOLO模型对不同类病害的识别具有较强鲁棒性。RDN-YOLO对不同水稻病害识别性能参数如表3所示,与白枯病、胡麻斑病和叶瘟病相比较,模型对穗瘟病与稻曲病的检测精度较低,利用CardCAM可视化热力图对RDN-YOLO模型输出的不同水稻病害特征进行可视化,结果如图9所示,该图能够直观显示区域关注度高低,特征越明显,对应位置热度越高。由图9可见,RDN-YOLO对不同病害主体部分能较好关注,由于穗瘟病区域存在健康稻穗对其不同程度遮挡,而早期稻曲病的颜色表观与稻穗和稻叶差异小,且穗瘟病与稻曲病的样本数量较少于其他3种病害的样本数量,这些可能造成穗瘟病和稻曲病的强特征表观的特征学习不足,从而导致检测精度相对低于其他病害,后期研究中将扩充样本数量和引入注意力机制,在各病害样本数量平衡的同时增强模型对各病害强特征表观的关注。

表3 不同病害检测性能

Tab.3 Performance comparison of different diseases %

病害类别精确率召回率mAP白枯病96.491.797.8穗瘟病90.284.690.6胡麻斑病97.288.491.9叶瘟病96.588.794.3稻曲病90.587.092.7

图9 RDN-YOLO水稻病害识别的可视化热力图

Fig.9 Visualized heat maps of rice disease identification of RDN-YOLO

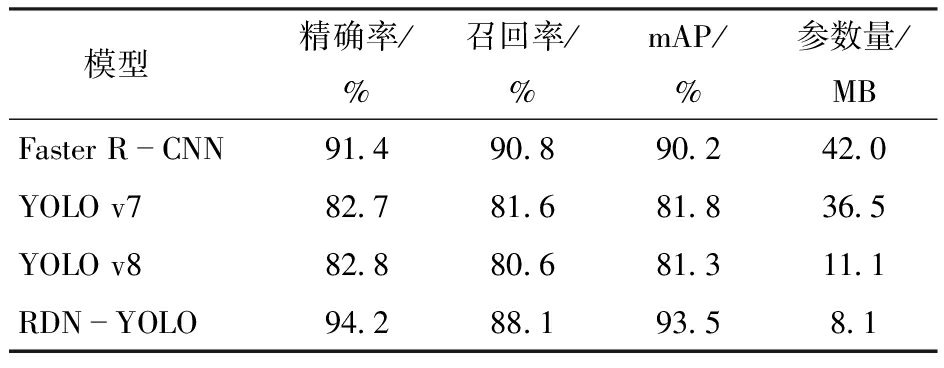

3.3.2 不同识别模型结果对比

为定性评价本文构建的水稻病害识别模型RDN-YOLO的检测结果,将其与具有代表性的两阶段目标识别网络Faster R-CNN、一阶段目标识别网络YOLO v7和YOLO v8对测试集中的水稻病害图像进行检测结果对比,如图10所示。从图 10中Faster R-CNN 的识别结果中可知,该模型能够识别图像中形态特征较完整的水稻病害, 但对于同一病害的不同特征表现或病斑尺度变化的适应性差,存在漏检情况。从图10中YOLO v7的识别结果中可知, 该模型较Faster R-CNN改善了病害漏检情况,但对遮挡的病害目标仍存在漏检;从图10中YOLO v8的识别结果中可知,该模型降低了不同病害漏检情况,但对于健康叶片遮挡病害或小尺寸病害,存在重识别和误识别情况;从图10中RDN-YOLO的识别结果中可知,该模型对不同尺度、类间差异大的病害都能取得较好的识别效果。

图10 不同模型病害识别对比结果

Fig.10 Comparison results of rice disease identification of different detection models

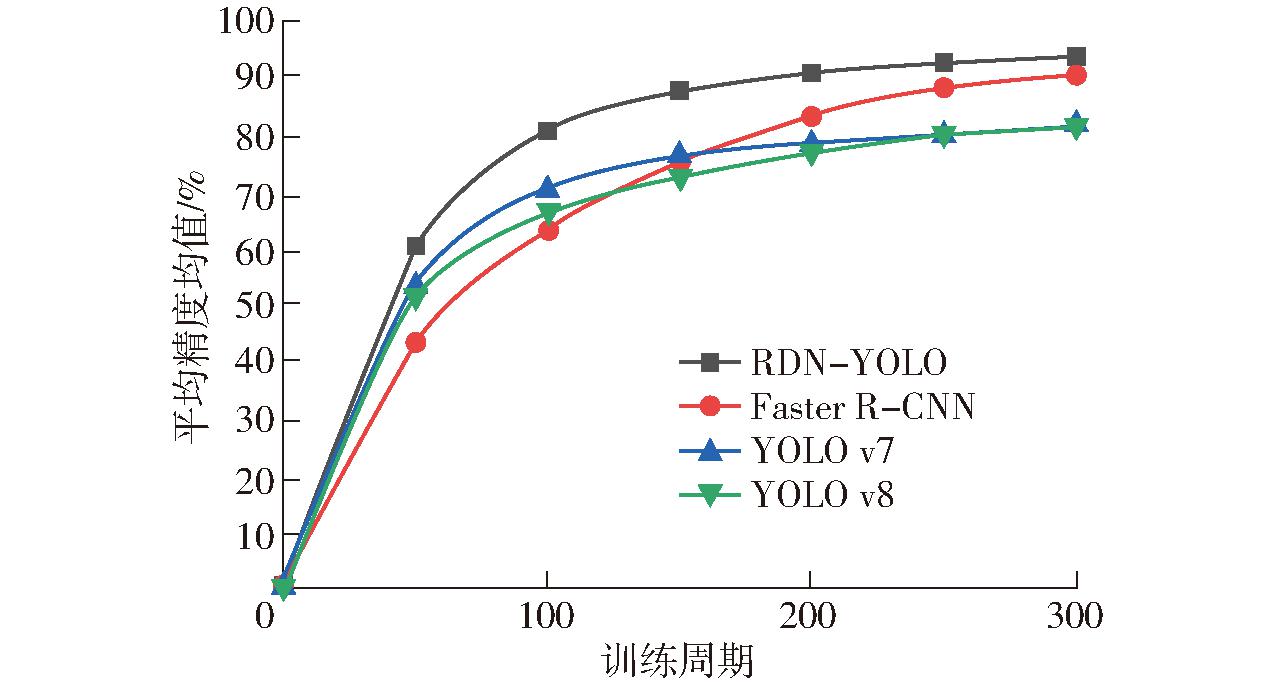

为定量比较模型的性能,按照如上所述的实验参数设置对RDN-YOLO模型、Faster R-CNN、YOLO v7 模型以及YOLO v8 模型进行对比实验,训练过程中4种网络均采用相同的损失函数,图11所示为相同的迭代次数下各模型的mAP变化曲线。由图11可以看出,在相同的迭代次数下,一阶段模型的收敛速度较二阶段快,与Faster R-CNN、 YOLO v7和YOLO v8相比,RDN-YOLO能达到收敛速度较快且取得最优的mAP,各模型具体的mAP如表4所示。从表4中可知,与其他模型相比,RDN-YOLO模型精确率、平均精度均值都是最优的,分别为 94.2%、93.5%, 其精确率和平均精度均值 (mAP) 与 Faster R-CNN、YOLO v7、YOLO v8 模型相比分别提升2.8、3.3个百分点,11.5、11.7个百分点,11.4、12.2个百分点。本文模型在原始 YOLO v5s 的基础上进行了轻量化改进,改进之后的模型参数较Faster R-CNN、YOLO v7、YOLO v8 模型分别降低了33.9、28.4、3 MB。

表4 不同模型的性能比较

Tab.4 Performance comparison of different models

模型精确率/%召回率/%mAP/%参数量/MBFaster RCNN91.490.890.242.0YOLO v782.781.681.836.5YOLO v882.880.681.311.1RDNYOLO94.288.193.58.1

图11 不同模型的mAP变化曲线

Fig.11 The mAP change curves during training of different models

4 结论

(1)针对自然环境下水稻病害识别精度受病害种类多、类间差异小、类内差异大、复杂背景等因素影响,以YOLO v5s为基本框架,提出了一种复杂背景下水稻病害识别网络模型RDN-YOLO。该模型使用C2f和SPDConv改进主干网络,增强网络的特征提取能力,并在颈部网络引入SPDConv进一步增强模型对小目标的识别能力,使用GsConv来进行轻量化。

(2)在对水稻病害检测识别时,所提模型RDN-YOLO的识别精确率为94.2%、召回率为88.1%,平均精度均值(mAP)为93.5%,模型参数量为8.1 MB。与YOLO v5、Faster R-CNN、YOLO v7、YOLO v8模型相比,RDN-YOLO具有更好的水稻病害检测识别性能,在农业实际应用中具有广阔的应用前景。

[1] 朱梦远,杨红兵,李志伟. 高光谱图像和叶绿素含量的水稻纹枯病早期检测识别[J].光谱学与光谱分析,2019,39(6): 1898-1904.

ZHU Mengyuan, YANG Hongbing, LI Zhiwei. Early detection and identification of rice sheath blight disease based on hyperspectral image and chlorophyll content[J]. Spectroscopy and Spectral Analysis, 2019,39(6): 1898-1904. (in Chinese)

[2] 黄双萍, 孙超, 齐龙,等. 基于深度卷积神经网络的水稻穗瘟病检测方法[J]. 农业工程学报,2017,33(20):169-176

HUANG Shuangping, SUN Chao, QI Long, et al. Rice panicle blast identification method based on deep convolution neural network[J]. Transactions of the CSAE, 2017, 33(20): 169-176. (in Chinese)

[3] WANG Y, WANG H, PENG Z. Rice diseases detection and classification using attention based neural network and Bayesian optimization[J]. Expert Systems with Applications, 2021, 178: 114770.

[4] ANNABEL L, ANNAPOORANI T, DEEPALAKSHMI P. Machine learning for plant leaf disease detection and classification—a review[C]∥International Conference on Communication and Signal Processing, 2019: 538-542.

[5] PANTAZI X, MOSHOU D, TAMOURIDOU A. Automated leaf disease detection in different crop species through image features analysis and one class classifiers[J]. Computers and Electronics in Agriculture, 2019, 156: 96-104.

[6] 廖娟, 陶婉琰 ,臧英,等.农作物病虫害遥感监测关键技术研究进展与展望[J].农业机械学报, 2023,54(11): 1-19.

LIAO Juan, TAO Wanyan, ZANG Ying, et al. Research process and prospect of key technologies in crop disease and insect pest monitoring[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(11): 1-19. (in Chinese)

[7] 陈宇, 路阳, 蔡娣, 等. 基于SPSO+SVM的水稻叶部病害识别方法研究[J].上海农业学报, 2021,37(6): 136-142.

CHEN Yu, LU Yang, CAI Di, et al. Study on recognition method of rice leaf diseases based on SPSO+SVM[J]. Acta Agriculturae Shanghai, 2021,37(6): 136-142. (in Chinese)

[8] 王震, 褚桂坤, 张宏建, 等.基于无人机可见光图像Haar-like特征的水稻病害白穂识别[J].农业工程学报, 2018,34(20): 73-82.

WANG Zhen, CHU Guikun, ZHANG Hongjian, et al. Identification of diseased empty rice panicles based on Haar-like feature of UAV optical image[J]. Transactions of the CSAE, 2018, 34(20): 73-82. (in Chinese)

[9] KUMARI C, PRASAD S, MOUNIKA G. Leaf disease detection: feature extraction with K-means clustering and classification with ANN[C]∥International Conference on Computing Methodologies and Communication, 2019: 1095-1098.

[10] CHOUHAN S, SINGH U, JAIN S. Automated plant leaf disease detection and classification using fuzzy based function network[J]. Wireless Personal Communications, 2021, 121(3): 1757-1779.

[11] FERENTINOS K. Deep learning models for plant disease detection and diagnosis[J]. Computers and Electronics in Agriculture, 2018, 145: 311-318.

[12] NAGARAJU M, CHAWLA P, UPADHYAY S, et al. Convolution network model based leaf disease detection using augmentation techniques[J]. Expert Systems, 2022, 39(4): e12885.

[13] XUE Z, XU R, BAI D, et al. YOLO-Tea: a tea disease detection model improved by YOLO v5[J]. Forests, 2023,14(2): 415.

[14] 张林鍹, 巴音塔娜, 曾庆松. 基于StyleGAN2-ADA和改进YOLO v7的葡萄叶片早期病害检测方法[J]. 农业机械学报,2024,55(1): 241-252.

ZHANG Linxuan, BA Yintana, ZENG Qingsong. Grape disease detection method based on StyleGAN2-ADA and improved YOLO v7[J]. Transactions of the Chinese Society for Agricultural Machinery, 2024,55(1): 241-252. (in Chinese)

[15] PAN J, WANG T, WU Q. RiceNet: a two stage machine learning method for rice disease identification[J]. Biosystems Engineering, 2023, 225: 25-40.

[16] STEPHEN A, PUNITHA A, CHANDRASEKAR A. Designing self-attention-based ResNet architecture for rice leaf disease classification[J]. Neural Computing and Applications, 2023, 35(9): 6737-6751.

[17] 崔金荣, 魏文钊, 赵敏.基于改进MobileNetV3的水稻病害识别模型[J].农业机械学报, 2023,54(11): 217-224,276.

CUI Jinrong, WEI Wenzhao, ZHAO Min. Rice disease identification model based on improved MobileNetV3[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(11): 217-224,276. (in Chinese)

[18] 杨波, 何金平, 张立娜.基于改进SPP-x的YOLOv5神经网络水稻叶片病害识别检测[J].中国农机化学报,2023,44(9): 190-197.

YANG Bo, HE Jinping, ZHANG Li’na. Identification and detection of rice leaf diseases by YOLOv5 neural network based on improved SPP-x[J]. Journal of Chinese Agricultural Mechanization, 2023,44(9): 190-197. (in Chinese)

[19] ZHANG L, DING G, LI C, et al. DCF-Yolov8: an improved algorithm for aggregating low-level features to detect agricultural pests and diseases[J]. Agronomy, 2023, 13(8): 2012.

[20] ZHANG B, LI Z, TONG P, et al. Non-uniform imaging object detection method based on NU-YOLO[J]. Optics &Laser Technology, 2024, 174: 110639.

[21] WU W, ZHANG J, ZHOU G, et al. ESG-YOLO: a method for detecting male tassels and assessing density of maize in the field[J]. Agronomy, 2024, 14(2): 241.

[22] WAN W, WANG L, WANG B, et al. Space to depth convolution bundled with coordinate attention for detecting surface defects[J]. Signal, Image and Video Processing, 2024,18(4): 1-14.

[23] 李尚平, 卞俊析,李凯华,等. 基于改进YOLO v5s的复杂环境下蔗梢分叉点识别与定位[J].农业机械学报, 2023,54(11):247-248.

LI Shangping, BIAN Junxi, LI Kaihua, et al. Identification and height localization of sugarcane tip bifurcation points in complex environments based on improved YOLO v5s[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(11):247-248. (in Chinese)

[24] LI H, LI J, WEI H, et al. Slim-neck by GSConv: a better design paradigm of detector architectures for autonomous vehicles[J]. arXiv Preprint, arXiv:2206.02424,2022.

[25] WANG D, HE D. Channel pruned YOLO V5s-based deep learning approach for rapid and accurate apple fruitlet detection before fruit thinning[J]. Biosystems Engineering, 2021, 210: 271-281.

[26] 马宏兴, 董凯兵, 王英菲, 等. 基于改进YOLO v5s的轻量化植物识别模型研究[J].农业机械学报, 2023,54(8): 267-276.

MA Hongxing, DONG Kaibing, WANG Yingfei, et al. Lightweight plant recognition model based on improved YOLO v5s[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(8): 267-276. (in Chinese)