0 引言

作物制图是农业遥感和地理信息科学领域的一项重要应用[1-3],卫星遥感和深度学习算法的快速发展,为实现大范围作物制图提供了重要技术支撑[4]。目前利用深度学习算法对遥感影像作物制图的相关研究主要采用全监督训练范式[5-6],此类方法需要大量标记训练数据[7-8],而人工标注训练数据成本高,在实际遥感应用场景中很难满足这一要求。相对于全监督学习,半监督学习方法根据标记数据,挖掘未标记数据的有效信息,可达到降低人工成本和提升模型性能的目的[9-11]。

现有半监督学习方法大多采用自训练[12]、一致性正则化[13-14]、对抗训练[15]等策略,其中,通过对抗训练利用未标记数据是半监督学习的研究热点。对抗训练起源于生成对抗网络(Generative adversarial network, GAN)[16-17],GAN分为生成网络和判别网络,生成网络负责生成高质量的虚假图像以欺骗判别网络,判别网络则需要判断出真实图像和虚假图像。训练过程中,生成网络和判别网络相互博弈,逐渐提高模型整体性能。对抗训练思想在半监督语义分割方法设计上具有重要的启发性,例如AdvSemiSeg[18]采用不同分割网络作为生成网络和判别网络,生成网络接收有标签和无标签的训练样本,输出预测概率图;判别网络接收有标签样本的预测概率图和真实标签图,输出图像像素来自真实标签的置信度。在AdvSemiSeg模型参数优化过程中,生成网络与判别网络对抗训练,一方面鼓励生成网络可以输出接近真实标签图的预测概率分布以欺骗判别网络;另一方面不断提高判别网络的鉴别能力,以期从判别网络输出的置信图中选择高置信度像素赋予伪标签,为生成网络提供无标签样本的监督损失,挖掘无标签样本的图像信息。

AdvSemiSeg在自然图像半监督语义分割任务中取得了显著效果,许多研究将该方法的设计思路应用于遥感领域。耿艳磊等[19]将UNet和FCN分别作为生成网络和判别网络,利用生成网络对遥感影像进行地物(建筑、地表、低矮植被、树木、汽车)分割,证明了对抗训练策略对该遥感任务的有效性。WANG等[15]提出了一种多尺度对抗学习方法用于改善遥感影像小目标地物识别效果,该方法的生成网络接收3种不同像素尺寸(1、0.75、0.5倍)的输入图像,学习遥感影像地物的多尺度特征。此外,CHEN等[20]设计了一种应用于遥感影像道路分割任务的SemiRoadExNet方法,与AdvSemiSeg不同的是,该方法的生成网络输出类别概率图和熵图,其判别网络也分为类别概率判别网络和熵判别网络,通过增加生成网络与熵判别网络的对抗训练过程,提高道路分割精度。逯焕宇等[21]提出了一种SWTUNet方法用于遥感影像水体分割,该方法将Swin Transformer(ST)引入生成网络用于改善水体提取效果。这些研究表明,诸如AdvSemiSeg的对抗训练策略在遥感影像各种分割应用中具有广泛适用性。

为了缓解深度学习遥感影像作物制图对标记样本的数量要求,本文基于对抗训练策略提出一种改进AdvSemiSeg的半监督语义分割方法。对于生成网络,设计一种STMF-DeepLabv3+结构,将Swin Transformer作为生成网络的骨干网络,建模遥感图像中的长距离依赖关系,以提高生成网络的特征编码能力。为进一步利用骨干网络不同阶段特征图的语义信息,设计一个自下而上的逐阶段多尺度特征融合(Multi-scale fusion,MF)模块,以增强生成网络语义表达能力。对于判别网络,之前大多研究主要采用4个卷积层的FCN实现。在对抗训练过程中,判别网络接收生成网络预测的类别概率图或训练样本的真实标签图,仅有单通道信息的真实标签图经过4个卷积层的通道扩增和压缩处理后,可能存在一定的信息损失,最终影响判别网络对输入来源的正确判断。为此,将通道注意力机制引入判别网络,以提高判别网络对关键通道特征的感知能力,避免对抗训练时产生的信息损失问题。通过优化AdvSemiSeg的生成网络和判别网络,以期提升遥感影像作物制图精度。

1 研究区与数据源

1.1 研究区概况

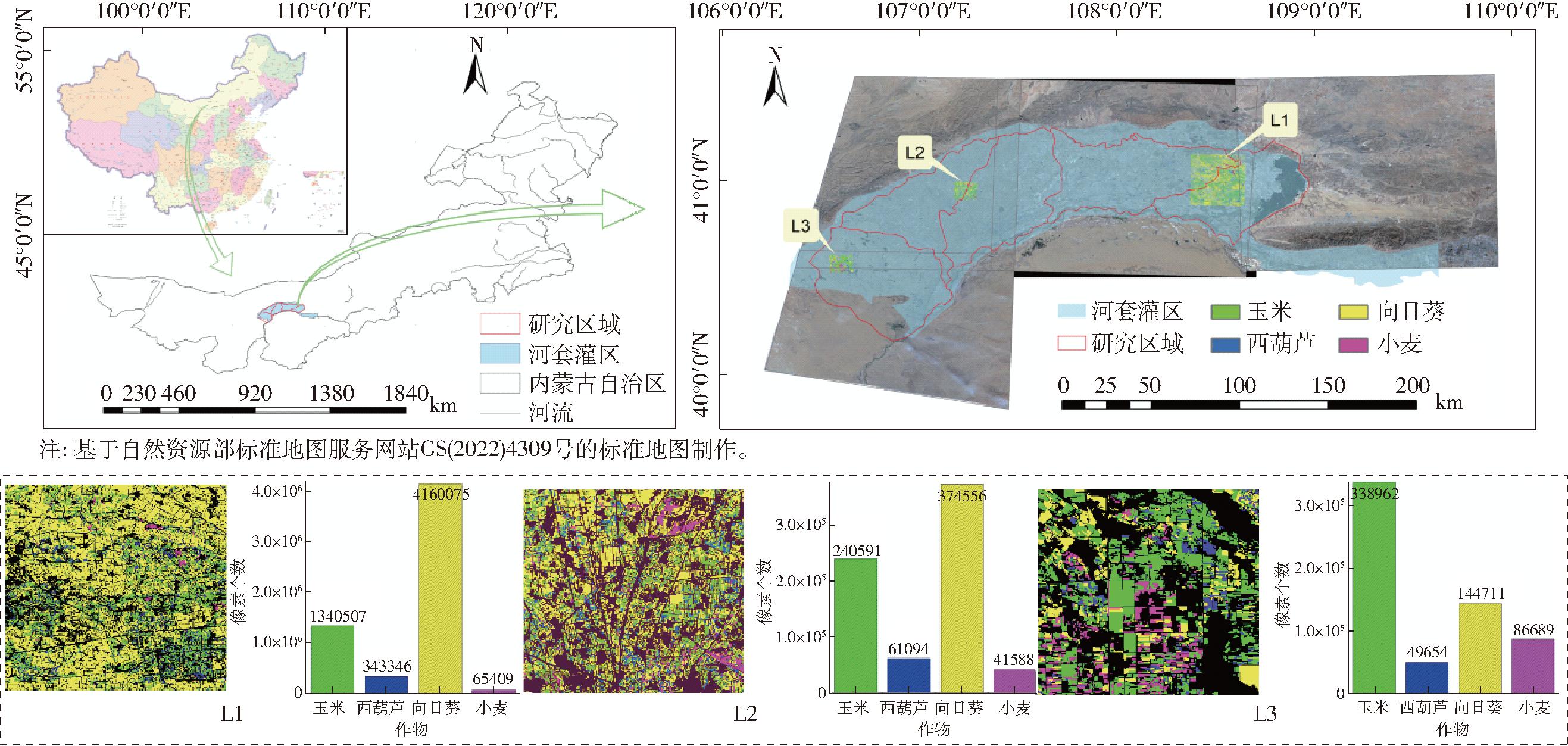

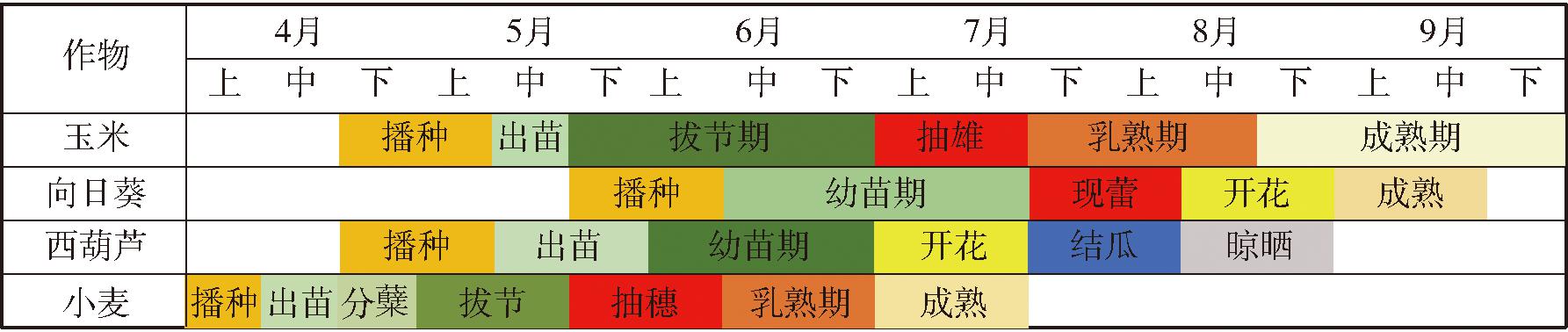

选取内蒙古河套灌区内5个旗县(磴口县、杭锦后旗、临河区、五原县、乌拉特前旗乌梁素海以西)为研究区域。如图1所示,河套灌区(40.1°~41.4°N,106.1°~109.4°E)东西长270 km,总面积超过1.18×106 hm2,现有耕地7.337×105 hm2,主要种植玉米、西葫芦、向日葵、小麦等[22]。该区复种指数相对较小,大多数耕地一年一作,作物生长季节为4月至9月(图2)。

图1 研究区域概况

Fig.1 Overview of study area

图2 河套灌区主要作物物候期

Fig.2 Phenological calendar of main crops in Hetao Irrigation District

1.2 Sentinel-2影像数据集

本研究使用Sentinel-2 L1C数据,根据玉米、西葫芦、向日葵和小麦作物的物候期数据,在美国地质调查局地球探测器数据门户网站下载2022年4—9月包含研究区域的Sentinel-2数据(每月一景,时间点分别为4月21日、5月26日、6月30日、7月25日、8月24日和9月23日)。此后对下载影像进行大气校正(Sen2Cor)、重采样(SNAP)、波段组合(ENVI 5.6)、镶嵌(ENVI 5.6)、图像配准(ENVI 5.6)和研究区裁切(Argis 10.8)预处理操作,所有影像投影为UTM/WGS84。预处理过程中移除对地表作物监测作用小的卷云波段,共获取72波段的多时相Sentinel-2遥感影像数据。依据研究团队2022年河套灌区野外实地调研结果,在Argis 10.8上标注图1中L1、L2、L3区域的作物,包含背景、玉米、西葫芦、向日葵和小麦5种类别。在制作Sentinel-2遥感数据集时,按尺寸256像素×256像素和重叠度75%对L1、L2区域的遥感影像进行裁剪,获得3 581幅图像。本研究将L1、L2、L3区域对应的图像分别作为训练集(3 190幅)、验证集(391幅)和测试集,同时在训练集中选取25%的图像作为标记样本,剩余75%作为未标记样本。

2 研究方法

本文提出一种改进AdvSemiSeg的半监督语义分割方法对遥感影像进行作物制图,该方法采用AdvSemiSeg作为基础框架,包括优化的生成网络和判别网络。

2.1 AdvSemiSeg概述

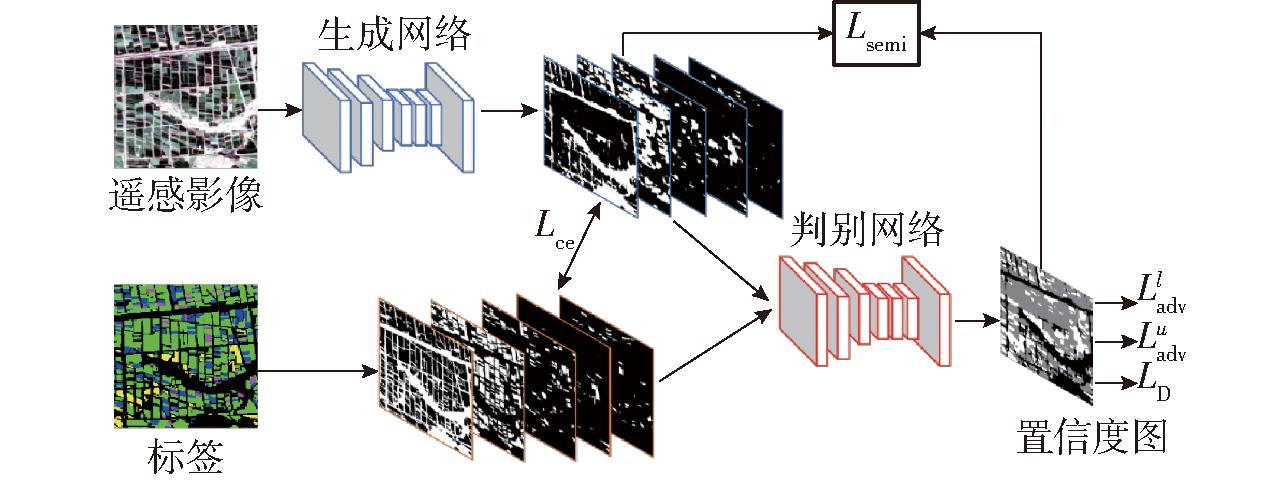

AdvSemiSeg框架如图3所示,主要由生成网络G(·)和判别网络D(·)构成。生成网络接收输入图像x,包括标记图像xl和未标记图像xu,输出类别概率G(x);判别网络接收生成网络的预测结果G(x)或真实标签y,输出像素来自真实标签y的置信度。训练过程中,对于判别网络G(xl),使用标记图像xl和真实标签y,通过判别网络输出结果D(G(xl))与D(y)的二元交叉熵损失LD,确保判别网络对输入来源做出正确判断。对于生成网络G(·),使用标记图像xl、未标记图像xu、真实标签y,通过多任务损失LG优化网络训练,LG计算式为

(1)

图3 AdvSemiSeg总体框架

Fig.3 Overall framework of AdvSemiSeg

式中 Lce——标记图像交叉熵损失

![]() 标记图像对抗损失

标记图像对抗损失

![]() 未标记图像对抗损失

未标记图像对抗损失

Lsemi——未标记图像半监督损失

![]() 权重因子

权重因子

Lce用于约束分割结果G(xl)与真实标签y的一致性。![]() 和

和![]() 期望生成网络输出的概率分布接近真实标签,使判别网络误认为样本数据的预测结果来自真实标签。Lsemi旨在挖掘无标记图像高置信度像素的有效信息。为了防止模型受到初始不准确预测结果的影响,先利用标记图像训练生成网络,然后随机采样标记图像和未标记图像进行对抗训练,联合更新生成网络和判别网络的模型参数。AdvSemiSeg的对抗训练策略可以有效利用无标签样本,提高模型泛化能力。

期望生成网络输出的概率分布接近真实标签,使判别网络误认为样本数据的预测结果来自真实标签。Lsemi旨在挖掘无标记图像高置信度像素的有效信息。为了防止模型受到初始不准确预测结果的影响,先利用标记图像训练生成网络,然后随机采样标记图像和未标记图像进行对抗训练,联合更新生成网络和判别网络的模型参数。AdvSemiSeg的对抗训练策略可以有效利用无标签样本,提高模型泛化能力。

2.2 生成网络

生成网络用于分割遥感影像作物类型。以DeepLabv3+[23]作为生成网络的基线网络,DeepLabv3+是计算机视觉领域一种经典的语义分割网络,该网络采用编码器-解码器结构。编码器包括骨干网络和空洞卷积特征金字塔(Atrous spatial pyramid pooling,ASPP)模块。骨干网络用于从原始图像中提取特征,生成低级语义特征图;而ASPP模块通过一系列操作(包括1×1卷积,扩张率为6、12、18的3×3空洞卷积和全局平均池化)对低级语义特征图进行多尺度特征提取,生成高级语义特征图。解码器则负责将低级和高级语义特征图进行通道融合,输出分割结果。

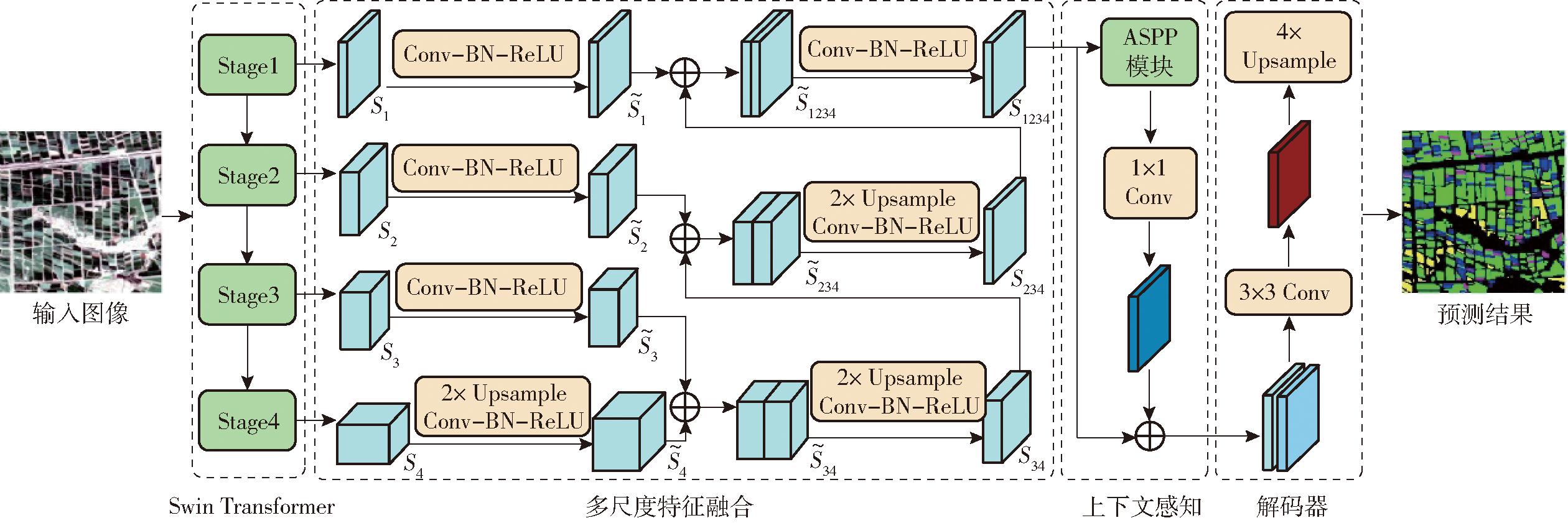

为了提升基线网络特征编码能力,将Swin Transformer[24]作为骨干网络。此外,引入MF模块进一步提升基线网络的语义表达能力。为了区分于基线网络,将这一改进后的生成网络命名为STMF-DeepLabv3+,其结构如图4所示。Swin Transformer由4个阶段(Stage)组成,每个阶段通过窗口多头自注意力和移动窗口多头自注意力机制建立特征图的远程依赖关系,优化特征表示。对于给定尺寸为H×W的输入图像,经过4个阶段处理后,分别得到尺寸为H/4×W/4、H/8×W/8、H/16×W/16 和H/32×W/32的特征图S1、S2、S3和S4。这些特征图反映了遥感影像在不同层次上的语义表达,即浅层特征图主要表达局部细节和纹理等相关信息,而深层特征图则表达了更抽象的语义概念。

图4 生成网络

Fig.4 Network structure of generator

为了利用不同语义表达的特征图,MF模块采用自下而上的逐阶段融合策略。具体而言,先将S3和S4融合为S34,再将S34与S2融合为S234,最后将S234与S1融合为S1234。这种自下而上的融合策略可以最大程度地保留浅层特征图的细节信息,提高遥感影像作物田块的边缘分割效果,而逐阶段的融合策略则有助于避免不同阶段特征图直接融合时可能存在的语义鸿沟问题。在MF模块处理过程中,为了使不同阶段特征图的像素尺寸保持一致,融合前对较低分辨率的深层特征图执行2倍上采样操作,对齐较高分辨率的浅层特征图,然后采用通道叠加方式进行融合。此外,为了提高训练效率,采用Conv-BN-ReLU层对融合前后的特征图进行通道数量减半的卷积处理,减小MF模块计算量。借鉴DeepLabv3+方法,将MF模块输出特征图S1234定义为低级语义特征图,随后利用ASPP模块对其进行多尺度特征提取,生成高级语义特征图。低级与高级语义特征图的融合过程以及解码器的处理过程与DeepLabv3+保持一致。尽管MF模块和ASPP模块都执行了多尺度操作,但它们的侧重有所不同。MF模块侧重于融合不同语义表达的多尺度特征图;而ASPP模块侧重于在特征图中提取多尺度信息,用于改善网络的上下文感知能力。

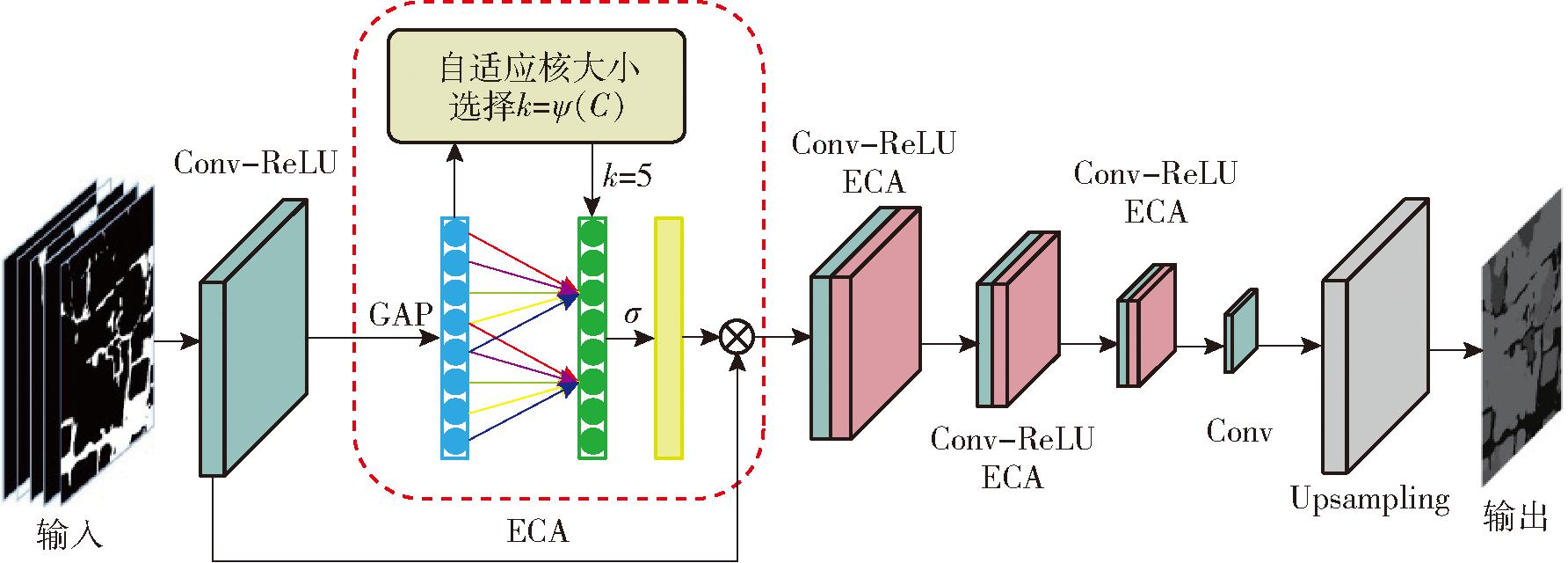

2.3 判别网络

判别网络用于判断输入样本是否来自真实标签。本研究采用与文献[18,25]相同的全卷积神经网络作为判别网络,该网络输出与原始图像同等尺寸的置信度图。为了进一步提升判别网络性能,引入通道注意力机制对不同通道特征图的表征信息进行自适应学习,通过选择性地加权不同通道特征,优化判别网络对关键信息的感知能力。

判别网络结构如图5所示,主要由4个Conv-ReLU-ECA层和1个Conv-Upsampling层构成。卷积层的核大小为4×4,步长为2,通道数量分别为64、128、256、512、1。在前4个卷积层后面均加入ReLU函数作为激活函数提升判别网络的非线性表达能力。随后采用通道注意力(Efficient channel attention,ECA)网络[26]对ReLU函数输出的不同通道特征进行自适应学习。ECA网络的前向计算过程如下:首先利用核大小为k×k的一维卷积对经过全局平均池化(Global average pooling,GAP)后的特征图进行卷积处理;然后利用Sigmoid(σ)函数将一维卷积的输出结果映射到0到1之间,得到每个通道的注意力分数;最后根据注意力分数对每个通道特征图进行加权处理。利用一维卷积计算注意力分数主要有2点优势:①没有对通道特征降维,避免了降维操作引起的信息损失。②通过计算每个通道及其k个相邻通道的特征来捕获局部跨通道交互信息,这种处理方式更加轻量与高效。一维卷积的核尺寸(k)根据输入的特征通道数量自适应调整,计算公式为

(2)

图5 判别网络

Fig.5 Network structure of discriminator

式中 |·|odd——取最近邻奇数操作r

C——通道数量

在判别网络中,最后一个卷积层融合所有通道特征图的信息,输出通道数为1的预测结果;上采样层将预测结果重新缩放至输入图像尺寸;Sigmoid函数将预测结果映射至0到1之间,表示输入来自真实标签的概率。本研究采用优化的判别网络提高对输入样本来源的判断能力。

3 实验

3.1 实验设置

使用PaddlePaddle框架(2.0.4版本)实现所提方法,在一块GPU-NVIDIA GeForce RTX 3090显卡上训练模型,批处理大小为16,训练周期共100轮,第50轮后联合优化生成网络和判别网络的模型参数。训练生成网络和判别网络时,使用动量参数为0.9、衰减系数为4.0×10-5的随机梯度下降算法和初始学习率为10-4的多项式衰减策略优化模型训练。对于各损失项权重因子,将![]() 设置为0.01、0.001、0.1。生成伪标签阈值设置为0.2。

设置为0.01、0.001、0.1。生成伪标签阈值设置为0.2。

为了评价所提方法性能,选择一些先进的半监督语义分割算法进行比较,主要包括ClassMix[13]、CutMix[14]、AdvSemiSeg[18]、ST++[27]、FixMatch[28]、UniMatch[29]、CCT[30]方法,其中AdvSemiSeg方法在原文使用DeepLabv2作为生成网络。为了与STMF-DeepLabv3+公平比较,本研究同时采用DeepLabv3+作为AdvSemiSeg的生成网络,该方法标记为AdvSemiSeg*。

对于每类作物的分割结果,采用交并比(Intersection of union,IoU)进行评估;对于遥感影像的作物制图结果,采用mIoU、F1值和总体分类精度(Overall accuracy,OA)进行评估。

3.2 实验结果

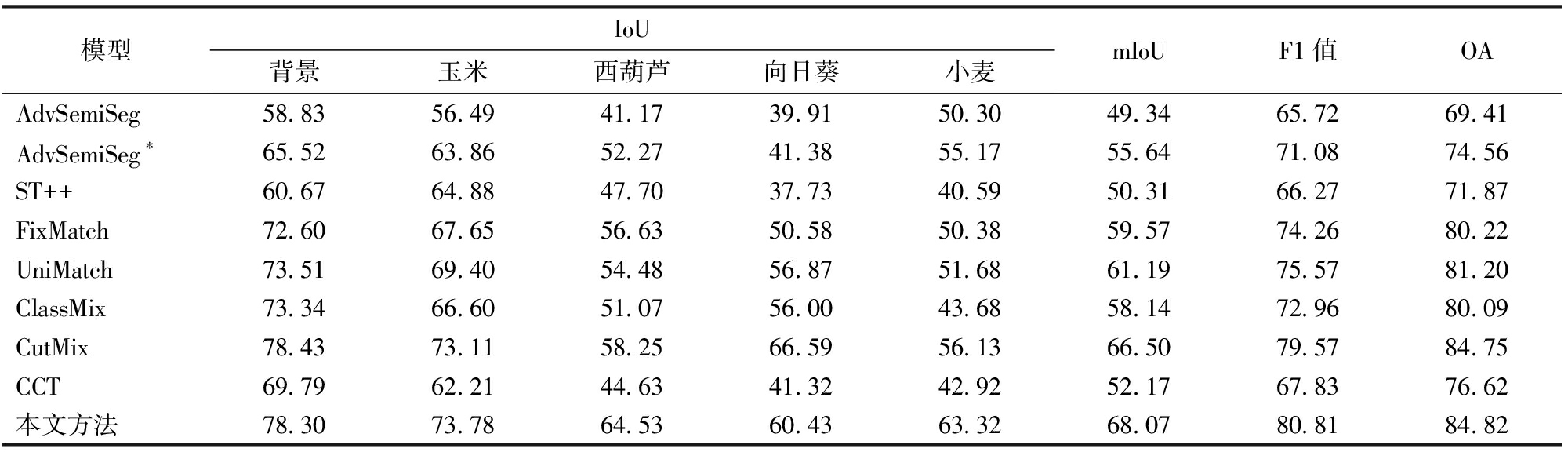

3.2.1 不同方法分割精度比较

各方法性能评估精度如表1所示,在玉米、西葫芦、小麦分割结果中,所提方法表现最佳,其IoU分别达到73.78%、64.53%、63.32%;在背景和向日葵的分割结果中,CutMix方法表现最佳,所提方法达到次优水平,其IoU分别为78.3%、60.43%。综合考虑所有作物的分割性能,所提方法mIoU、F1值、OA均实现了最优,依次为68.07%、80.81%、84.82%,相比于次优的CutMix分别提高1.57、1.24、0.07个百分点。此外,对比采用不同生成网络的AdvSemiSeg方法,所提方法通过优化生成网络和判别网络,大幅提高了各种作物分割精度。这些结果表明,本文方法在Sentinel-2遥感影像作物制图上具有明显优势。

表1 不同方法分割精度

Tab.1 Accuracy of different methods %

模型IoU背景玉米西葫芦向日葵小麦mIoUF1值OAAdvSemiSeg58.8356.4941.1739.9150.3049.3465.7269.41AdvSemiSeg∗65.5263.8652.2741.3855.1755.6471.0874.56ST++60.6764.8847.7037.7340.5950.3166.2771.87FixMatch72.6067.6556.6350.5850.3859.5774.2680.22UniMatch73.5169.4054.4856.8751.6861.1975.5781.20ClassMix73.3466.6051.0756.0043.6858.1472.9680.09CutMix78.4373.1158.2566.5956.1366.5079.5784.75CCT69.7962.2144.6341.3242.9252.1767.8376.62本文方法78.3073.7864.5360.4363.3268.0780.8184.82

3.2.2 不同方法识别效果比较

图6展示了各方法对不同作物的识别效果。这4种作物中,所提方法对玉米的识别效果最佳。玉米在遥感影像中的冠层纹理均匀,田块边缘分界线清晰,识别难度最低,其它方法对玉米的识别效果亦是如此。其次,所提方法对小麦和西葫芦的识别效果优于其它方法。这2种作物在研究区域内的种植比例很小,有标记训练样本的数量也相对较少。所提方法通过优化判别网络,充分利用未标记训练集中的有效信息,提高识别精度。在向日葵的识别中,CutMix方法表现最好,所提方法次之。这可能因为向日葵抗逆性较强,可以在不同盐碱化程度的土壤上种植,而不同土壤在卫星遥感影像中的反射率差异很大,受种植环境影响,向日葵易与其它类别混淆。CutMix方法在训练过程中通过混合训练样本,将向日葵置于不同背景下,提高了模型的抗干扰能力。此外,从各作物田块边缘的分割效果来看,所提方法具有明显优势,这可能归因于多尺度特征融合模块能够最大化保留浅层特征图的局部细节信息,使田块分割完整。综合比较所有方法对各作物识别效果,本文方法优于其它对比方法。

图6 不同方法识别效果

Fig.6 Segmentation results of different methods

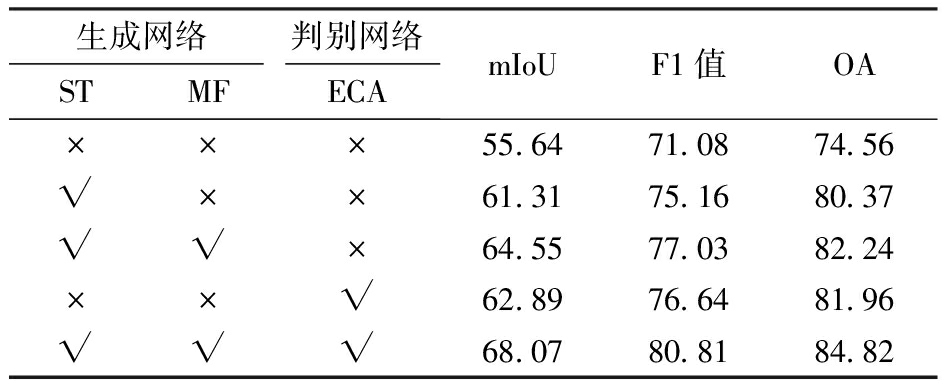

3.2.3 消融实验

为了探究STMF-DeepLabv3+和在判别网络中引入ECA模块对模型性能的影响,将AdvSemiSeg*作为基线方法,在基线方法中分别引入ST、MF模块、ECA模块。实验结果如表2所示,引入上述模块可以在不同程度上提高模型对遥感影像的制图精度。与采用ResNet101作为骨干网络的基线方法相比,采用ST进行遥感影像特征提取更具有优势,其mIoU提高5.67个百分点;MF模块通过融合ST各阶段特征图,增强了网络的语义表达能力,其mIoU提高3.24个百分点。以上结果表明了STMF-DeepLabv3+网络的先进性。此外,引入ECA模块可以增强判别网络对关键通道特征的感知能力,相比于基线方法,其mIoU提高7.25个百分点。综合引入所有模块能够实现最佳性能,实验结果表明了本研究从优化生成网络和判别网络两方面对AdvSemiSeg改进的有效性。

表2 消融实验结果

Tab.2 Ablation results %

生成网络判别网络STMFECAmIoUF1值OA×××55.6471.0874.56√××61.3175.1680.37√√×64.5577.0382.24××√62.8976.6481.96√√√68.0780.8184.82

注:√表示添加此模块,×表示不添加此模块。

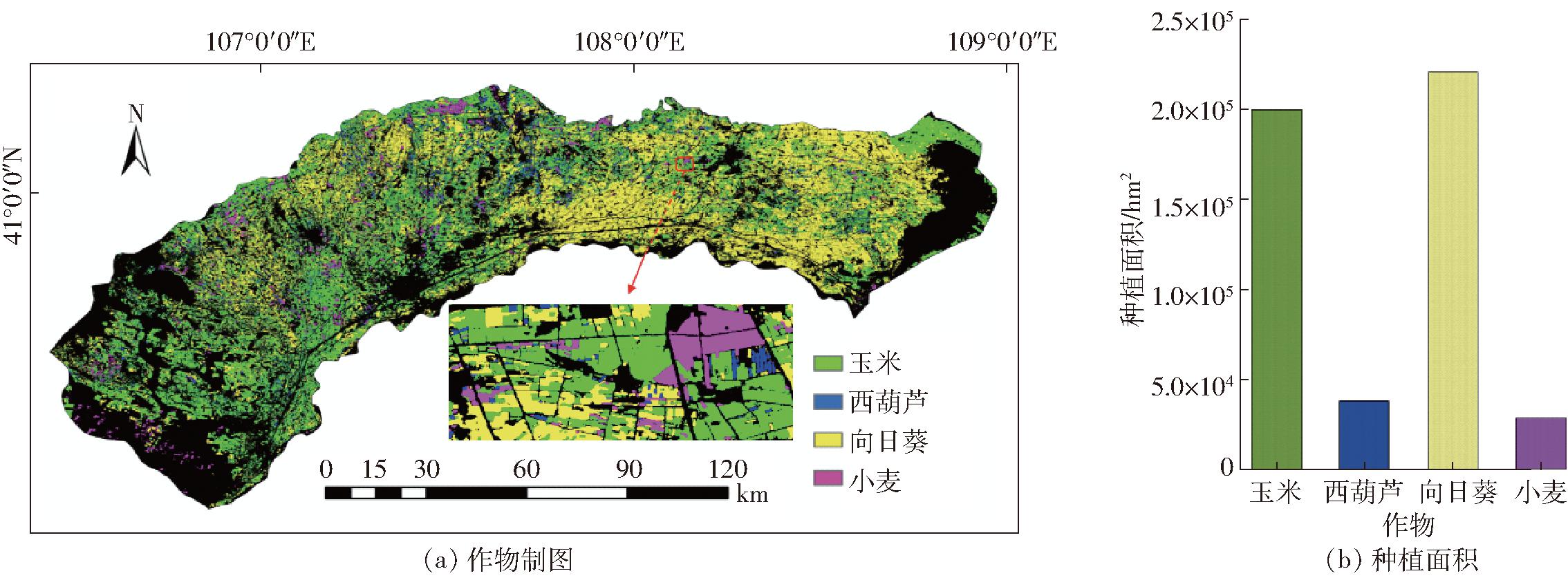

3.2.4 作物种植信息提取

将本文方法应用于河套灌区2022年Sentinel-2遥感影像,提取各作物种植区域及面积。如图7所示,该灌区主要种植玉米和向日葵,这两种作物在图7中分布较均匀,其像元数量分别为19 956 028、24 045 944,约1.996×105、2.405×105 hm2;而西葫芦及小麦种植面积相对较小,从遥感影像中提取的像元数量分别为3 784 059、2 915 076,约3.78×104、2.92×104 hm2,其中小麦主要种植在河套灌区的中西部区域。

图7 河套灌区作物种植信息

Fig.7 Planting information in Hetao Irrigation District

4 讨论

4.1 样本尺寸对模型性能的影响

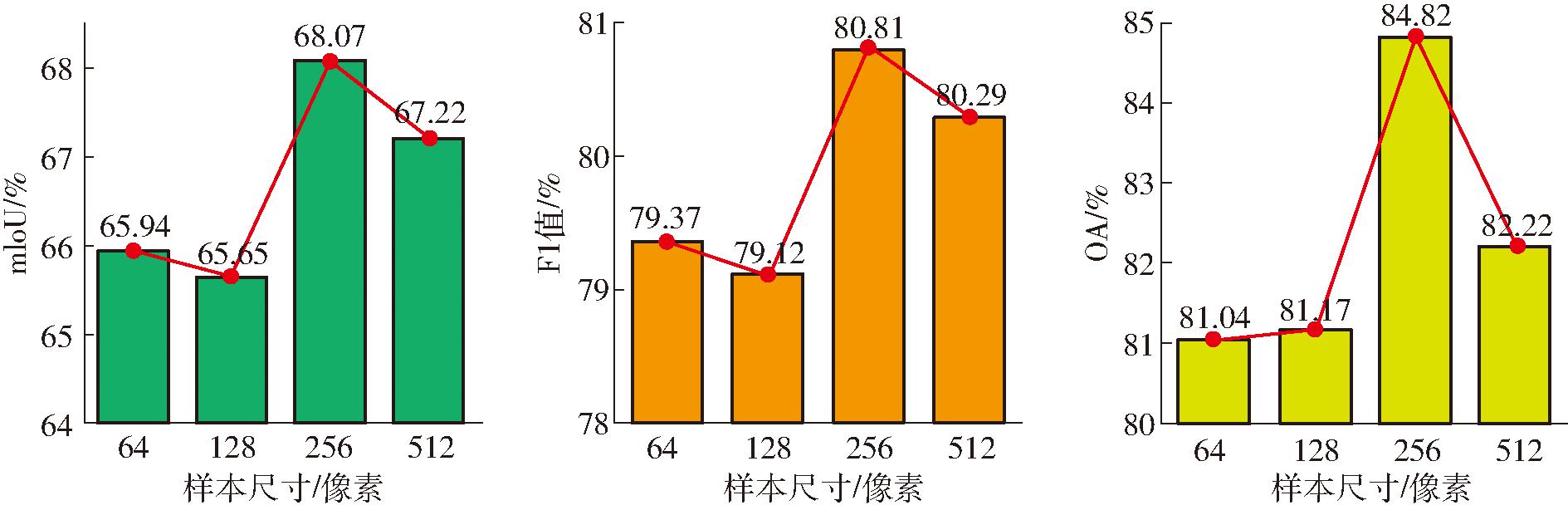

制作遥感数据集通常需要将原始影像按照一定尺寸进行裁剪,以便适应网络训练的需求。不同裁剪尺寸可能对模型性能产生不同程度影响。为了探究该参数对Sentinel-2遥感影像作物制图的影响,将裁剪尺寸分别设置为64像素×64像素、128像素×128像素、256像素×256像素和512像素×512像素,获得不同样本尺寸的遥感数据集,使用这些数据集训练所提方法。实验结果如图8所示,当样本图像尺寸为64像素×64像素或128像素×128像素时,模型性能基本类似。当样本尺寸从128像素增加到256像素时,模型精度明显提升,这可能因为网络能够从增大的样本图像中学习到更丰富的上下文信息。然而当样本尺寸从256像素增加到512像素时,模型精度轻微下降,这可能由于尺寸增大导致了数据集中有效样本数量减少,增加了模型在训练过程中出现过拟合的风险。实验结果表明,在一定范围内增加样本尺寸可以提高Sentinel-2遥感影像作物制图精度,其中256像素的样本尺寸表现最佳。

图8 不同样本尺寸对模型性能的影响

Fig.8 Model performance with different cropping sizes

4.2 局限性与展望

基于AdvSemiSeg方法,对生成网络和判别网络分别进行了优化。然而在实际过程中,采用固定阈值方式筛选无标记数据高置信度像素,缺乏灵活性,在处理不同数据集时,需要进行多次调参实验才能实现较优的语义分割性能;此外,在整个训练阶段,仅使用单个阈值也不是一种最合理的方式。今后研究中,可以根据网络性能动态调整伪标签阈值,类似于ZHANG等[31]提出的在线课程学习方式。其次,无标记数据低置信度的像素仍具有一些潜在和有价值的信息,这些像素可能是地物的边界组成像素[20]。本文方法缺乏对这些像素的合理利用,如何设计一种安全的训练策略或网络架构,利用低置信度的像素信息仍是一个值得探索的研究点。综合上述,提升半监督遥感作物分类方法的性能将不仅通过增强生成网络或者判别网络实现,也可以进一步优化高置信度像素的筛选机制和提高低置信度像素的利用率,采用分级策略对这2种不同置信度的像素进行训练,合理利用未标记数据的全部信息,提高遥感影像作物分割效果。

5 结束语

提出了一种改进AdvSemiSeg的半监督语义分割方法,用于Sentinel-2遥感影像作物制图任务。所提方法采用STMF-DeepLabv3+作为生成网络预测作物类别,以及带有通道注意力的全卷积网络作为判别网络预测输入样本来自真实标签的置信度。在生成网络中,引入Swin Transformer和多尺度特征融合模块增强生成网络的特征编码能力和语义表达能力,改善遥感影像分割效果。在判别网络中,引入ECA模块对不同通道特征图的表征信息进行自适应学习, 增强判别网络对关键通道特征的感知能力,避免真实标签在输入判别网络后出现信息损失的问题。整个训练过程中,判别网络为生成网络提供未标记数据的对抗损失和高质量伪标签,提高生成网络的泛化性能。在河套灌区作物种植信息提取上进行了相应实验,与AdvSemiSeg、ST++、FixMatch、UniMatch、ClassMix、CutMix、CCT半监督语义分割方法相比,所提方法性能明显提升。

[1] 陈水森, 柳钦火, 陈良富, 等. 粮食作物播种面积遥感监测研究进展[J]. 农业工程学报, 2005, 21(6): 166-171.

CHEN Shuisen, LIU Qinhuo, CHEN Liangfu, et al. Review of research advances in remote sensing monitoring of grain crop area[J]. Transactions of the CSAE, 2005, 21(6): 166-171. (in Chinese)

[2] 刘哲, 刘帝佑, 朱德海, 等. 作物遥感精细识别与自动制图研究进展与展望[J]. 农业机械学报, 2018, 49(12): 1-12.

LIU Zhe, LIU Diyou, ZHU Dehai, et al. Review on crop type fine identification and automatic mapping using remote sensing[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(12): 1-12. (in Chinese)

[3] KYERE I, ASTOR T, GRAΒ R, et al. Agricultural crop discrimination in a heterogeneous low-mountain range region based on multi-temporal and multi-sensor satellite data[J]. Computers and Electronics in Agriculture, 2020, 179: 105864.

[4] CASTELO-CABAY M, PIEDRA-FERNANDEZ J A, AYALA R. Deep learning for land use and land cover classification from the Ecuadorian Paramo[J]. International Journal of Digital Earth, 2022, 15(1): 1001-1017.

[5] 赵龙才, 李粉玲, 常庆瑞. 农作物遥感识别与单产估算研究综述[J]. 农业机械学报, 2023, 54(2): 1-19.

ZHAO Longcai, LI Fenling, CHANG Qingrui. Review on crop type identification and yield forecasting using remote sensing[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(2): 1-19. (in Chinese)

[6] 董秀春, 刘忠友, 蒋怡, 等. 基于WorldView-2影像和语义分割模型的小麦分类提取[J]. 遥感技术与应用, 2022, 37(3): 564-570.

DONG Xiuchun, LIU Zhongyou, JIANG Yi, et al. Winter wheat extraction of WorldView-2 image based on semantic segmentation method[J]. Remote Sensing Technology and Application, 2022, 37(3): 564-570. (in Chinese)

[7] COSTA H, FOODY G M, BOYD D S. Supervised methods of image segmentation accuracy assessment in land cover mapping[J]. Remote Sensing of Environment, 2018, 205: 338-351.

[8] WANG Zhimin, WANG Jiasheng, YANG Kun, et al. Semantic segmentation of high-resolution remote sensing images based on a class feature attention mechanism fused with Deeplabv3+[J]. Computers and Geosciences, 2022, 158: 104969.

[9] REDDY Y, VISWANATH P, REDDY B E. Semi-supervised learning: a brief review[J]. International Journal of Engineering and Technology, 2018, 7(1.8): 81-85.

[10] CHEN Jifa, SUN Buyang, WANG Lizhe, et al. Semi-supervised semantic segmentation framework with pseudo supervisions for land-use/land-cover mapping in coastal areas[J]. International Journal of Applied Earth Observation and Geoinformation, 2022, 112: 102881.

[11] 陈理, 韩毅, 杨广,等. 基于改进半监督模型的空间异质性农田特征提取研究[J].农业机械学报, 2023, 54(12): 173-185.

CHEN Li, HAN Yi, YANG Guang, et al. Spatially heterogeneous cropland characteristic extraction based on improved semi-supervised models[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(12): 173-185. (in Chinese)

[12] ZHANG Mingmei, XUE Yongan, ZHAN Yuanyuan, et al. Semi-supervised semantic segmentation-based remote sensing identification method for winter wheat planting area extraction[J]. Agronomy, 2023, 13(12): 2868.

[13] OLSSON V, TRANHEDEN W, PINTO J, et al. ClassMix: segmentation-based data augmentation for semi-supervised learning[C]∥Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, 2021: 1369-1378.

[14] YUN S, HAN D, OH S J, et al. CutMix: regularization strategy to train strong classifiers with localizable features[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 6023-6032.

[15] WANG Jiaqi, LIU Bing, ZHOU Yong, et al. Semisupervised multiscale generative adversarial network for semantic segmentation of remote sensing image[J]. IEEE Geoscience and Remote Sensing Letters, 2020, 19: 1-5.

[16] GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]∥Advances in Neural Information Processing Systems, 2014: 2672-2680.

[17] HAN Wei, FENG Ruyi, WANG Lizhe, et al. A semi-supervised generative framework with deep learning features for high-resolution remote sensing image scene classification[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 145: 23-43.

[18] HUNG W C, TSAI Y H, LIOU Y T, et al. Adversarial learning for semi-supervised semantic segmentation[J]. arXiv Preprint, arXiv:1802.07934, 2018.

[19] 耿艳磊, 邹峥嵘, 何帅帅. 基于半监督生成对抗网络的遥感影像地物语义分割[J]. 测绘与空间地理信息, 2020, 43(4): 36-39.

GENG Yanlei, ZOU Zhengrong, HE Shuaishuai. Semantic segmentation of objects in remote sensing images based on semi-supervised generative adversarial nets[J]. Geomatics and Spatial Information Technology, 2020, 43(4): 36-39. (in Chinese)

[20] CHEN Hao, LI Zhenghong, WU Jiangjiang, et al. SemiRoadExNet: a semi-supervised network for road extraction from remote sensing imagery via adversarial learning[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2023, 198: 169-183.

[21] 逯焕宇, 张永宏, 马光义,等. 基于半监督对抗学习的遥感图像水体提取[J]. 计算机工程, 2024,50(7):251-263.

LU Huanyu, ZHANG Yonghong, MA Guangyi, et al. Semi-supervised adversarial learning based water body extraction from remote sensing images[J]. Computer Engineering, 2024, 50(7): 251-263. (in Chinese)

[22] LI Guang, CUI Jiawei, HAN Wenting, et al. Crop type mapping using time-series Sentinel-2 imagery and U-Net in early growth periods in the Hetao irrigation district in China[J]. Computers and Electronics in Agriculture, 2022, 203: 107478.

[23] CHEN L C, ZHU Y, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]∥Proceedings of the European Conference on Computer Vision, 2018: 801-818.

[24] LIU Ze, LIN Yutong, CAO Yue, et al. Swin transformer: hierarchical vision transformer using shifted windows[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 10012-10022.

[25] RADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[J]. arXiv Preprint, arXiv:1511.06434, 2015.

[26] WANG Qilong, WU Banggu, ZHU Pengfei, et al. ECA-Net: efficient channel attention for deep convolutional neural networks[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 11534-11542.

[27] YANG Lihe, ZHUO Wei, QI Lei, et al. ST++: make self-training work better for semi-supervised semantic segmentation[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2022: 4268-4277.

[28] SOHN K, BERTHELOT D, CARLINI N, et al. FixMatch: simplifying semi-supervised learning with consistency and confidence[J]. Advances in Neural Information Processing Systems, 2020, 33: 596-608.

[29] YANG Lihe, QI Lei, FENG Litong, et al. Revisiting weak-to-strong consistency in semi-supervised semantic segmentation[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2023: 7236-7246.

[30] OUALI Y, HUDELOT C, TAMI M. Semi-supervised semantic segmentation with cross-consistency training[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 12674-12684.

[31] ZHANG Bowen, WANG Yidong, HOU Wenxin, et al. FlexMatch: boosting semi-supervised learning with curriculum pseudo labeling[J]. Advances in Neural Information Processing Systems, 2021, 34: 18408-18419.