0 引言

我国火龙果产业发展迅猛,现已成为全球第一大火龙果生产国[1]。随着种植面积不断扩大,现阶段其产业面临如下问题:火龙果果实采摘以人工为主,工作效率低且无法准确掌握最佳采摘时间,影响产量与品质,导致生产的标准化与产业化水平低;随着国内劳动力紧缺,人工成本逐年提高,严重影响火龙果产业的健康发展。因此,降低生产成本,提高采摘效率,实现火龙果机械化、智能化采摘迫在眉睫。目标检测技术因其具有自动、高效、准确的特点,是实现自动化采摘的关键。

近年来,目标检测技术不断创新,针对果实检测的研究已经取得一定进展[2-4]。随着神经网络技术的不断突破,基于深度学习的目标检测方法发展迅速,与基于特征的传统机器视觉方法[5-8]相比,基于深度学习的目标检测方法[9-11]能够同时学习到低维度和高维度的特征,具有更高的精度和更好的泛化能力[12]。WU等[13]采用YOLO v7网络结合多数据增强的方法实现复杂田间场景下的油茶果实检测,准确率为94.76%。周佳良等[14]采用幽灵卷积注意力模块来替换YOLO v5网络中的C3模块,实现火龙果识别准确率为96.2%。商枫楠等[15]将CBAM(Convolutional block attention module)添加到YOLOX-Nano主干网络,实现在自然环境下火龙果检测AP0.5为98.9%。NAN等[16]提出WGB-YOLO网络实现火龙果多果检测,检测mAP为86.0%。王金鹏等[17]设计轻量级YOLO v4-LITE17模型,采用MobileNet-v3网络作为YOLO v4骨干网络,并引入了注意力机制,使火龙果识别平均准确率达到96.48%。以上研究是针对果实的粗粒度检测,没有考虑果实细粒度的性能特征,如果实品质、成熟度。

研究人员已经认识到果实成熟度[18-19]、病害[20]、品质[21]、轮廓姿态[22]等具体性能指标识别对生产应用的重要性,并提出了针对性的研究方案。如马瑞峻等[23]提出PITAYA-YOLO v5模型对火龙果成熟度进行识别,使用k-means++算法重新生成锚框,将CSPDarkNet替换成PPLCNet作为骨干网络,加入SE(Squeeze and excitation)注意力模块和加权双向特征金字塔网络(Bi-FPN),并引入αDIoU损失函数,最终模型平均精度均值为94.90%,平均检测时间达到20.2 ms。容典[24]实现对脐橙表面缺陷的快速检测,设计脐橙缺陷检测系统,检测准确率达到95.8%。朱立学等[25]设计注意力残差U-Net图像分割网络,利用图像处理技术和相机成像模型进行火龙果三维姿态估计,实现火龙果图像分割和姿态估计。上述研究虽然取得一定成效,但仅限于检测单一细粒度指标,很少有研究关注果实多性能指标,且缺少大规模的数据集,难以满足农业真实场景的需要,在实际应用中具有局限性。

为了解决上述难题,本文对复杂真实环境下火龙果品质与成熟度双指标检测方法展开研究。构建复杂背景火龙果数据集,通过图像增强技术改善光照(天气、光线)环境,并对当前网络精度与性能优势相对均衡的YOLO v7网络进行改进,提出YOLO v7-RA模型(R为Res3,A为ACmix)。该模型设计ELAN_R3结构来重构YOLO v7主干网络,在主干网和检测头之间加入ACmix模块,以期实现复杂背景下火龙果品质与成熟度双指标的精准检测,为火龙果智能化采摘装置的研发提供新方法、新思路。

1 数据采集与预处理

数据数量与质量在神经网络模型中起到关键作用,目前火龙果图像公开数据集很少。本文首先采用自适应鉴别器增强的样式生成对抗网络(Stylebased generative adversarial networks 2-adaptive discriminator augmentation,StyleGAN2-ADA)对火龙果图像数据进行扩充,构建复杂环境火龙果图像数据集;然后针对扩充后的数据集存在的环境噪声问题,采用伽马变换进行图像增强操作,改善光照环境,凸显果实特征,提高数据集质量。

1.1 数据集构建

在火龙果实际采摘场景中,成熟且优质的果实是采摘目标,这些果实存在互相遮挡、背景杂乱、光线波动、多目标等复杂情况,因此采集复杂真实环境下的火龙果图像,构建丰富、均衡的火龙果数据集尤为重要。

1.1.1 图像采集

选择苏州市吴江区龙泉嘴果园作为实验基地,在火龙果种植温室内采用佳能ILCE-7型相机拍摄火龙果图像,拍摄方式为手持,拍摄位置和角度多变,采集距离20~80 cm,自然曝光,图像分辨率为3 600像素×2 700像素,以JPG格式存储。

图1为采集图像示例,为了适应不同的作业环境,分别在不同天气(晴天、阴天)、不同光线(顺光、逆光)、不同视角(仰视、俯视、平视)进行数据采集,其中包括多个果实、果实互相重叠、枝干遮挡等情况,果实状态包括未熟、已熟、坏果和好果。

图1 复杂环境火龙果图像

Fig.1 Pitaya image in complex environment

共采集原始图像6 000幅,对采集的火龙果样本进行质量筛选,去除高度模糊、图像重复、图像内无果实等无效图像,得到5 000幅图像作为原始数据集。

1.1.2 StyleGAN2-ADA数据集扩充

为了提高模型泛化能力,需对数据集进行扩充。首先,对数据进行归一化处理,将分辨率统一调整为1 024像素×1 024像素。然后,采用StyleFAN2-ADA[26]生成更真实、更多样化的火龙果图像,最终获得10 000幅有效火龙果数据集。

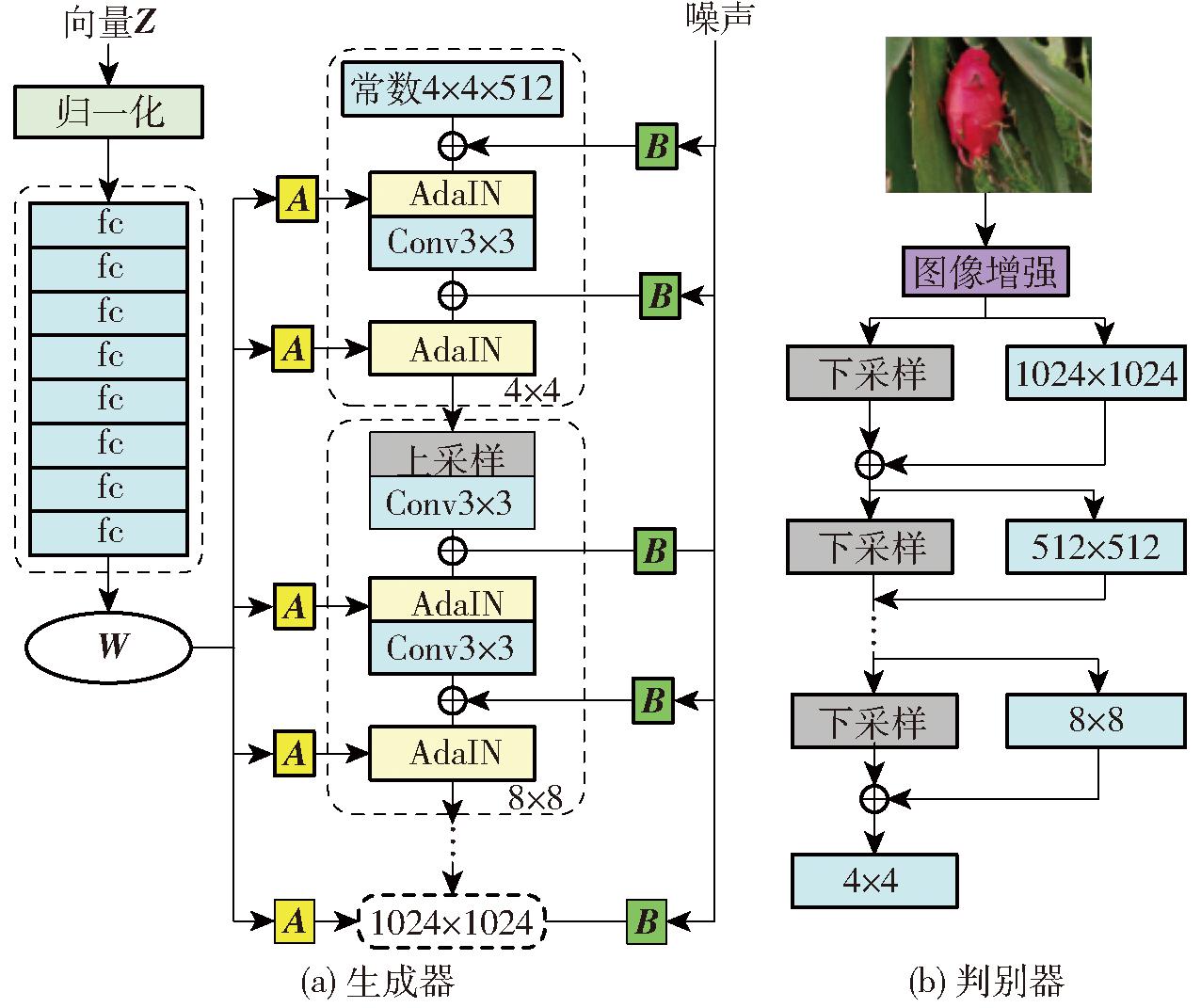

StyleFAN2-ADA由生成器和判别器构成,生成器输入潜在编码和随机噪声,并输出虚拟火龙果图像,判别器对接收到的训练数据和虚拟数据进行分类,鉴别其真伪。通过训练使生成器和判别器相互博弈,最终达到纳什均衡。

具体结构如图2所示,在生成器结构中,潜在向量Z由生成器输入到映射网络中,并将其编码为控制不同特征的中间向量W,对W进行仿射变换A生成风格控制向量Sstyle,用于控制特征风格。合成网络的输入由常量、风格控制向量Sstyle和噪声B组成,经过8次上采样层,使用自适应实例标准化(Adaptive instance normalization,AdaIN)和卷积,生成分辨率为1 024像素×1 024像素的虚拟火龙果图像。AdaIN模块表达式为

图2 StyleGAN2-ADA结构图

Fig.2 StyleGAN2-ADA structure diagram

式中 Adain(xi,y)——自适应实例标准化

xi——第i层的特征图

ys,i、yb,i——收缩因子、偏差因子

μ(xi)、σ(xi)——各个通道特征图方差和均值

判别器采用自适应鉴别增强机制(Adaptive discriminator augmentation,ADA),引入随机增强概率p,通过自适应机制调整p决定是否对真实或者生成的图像做旋转、调色差等图像增强操作,避免模型过拟合,提高生成图像质量。

如图3所示,StyleFAN2-ADA模型生成的火龙果图像通过肉眼无法辨别真假,生成图像质量高,实现了火龙果数据集增广。

图3 StyleFAN2-ADA生成图像对比

Fig.3 StyleFAN2-ADA generated image comparison

1.1.3 数据集标注

将数据集统一用LabelImg进行人工标注,添加标签,标签命名为Mature_good、Mature_bad、Immature_good、Immature_bad,分别表示成熟优质果、成熟劣质果、不成熟优质果、不成熟劣质果。标注原则:在视野范围内,根据火龙果颜色和是否为坏果进行标记。果实表面是红色标记为已成熟果实,果实表面是绿色标记为未成熟果实,果实表面有裂纹、腐烂等标记为坏果,果实表面完好无损标记为好果;有遮挡的果实,人工估计被遮挡区域进行标记;视野内存在较远果实,像素面积小于20像素×20像素,则不进行标记。为了对模型进行训练和评价,将标记数据按比例8∶1∶1分为训练集、验证集和测试集。

1.2 图像增强

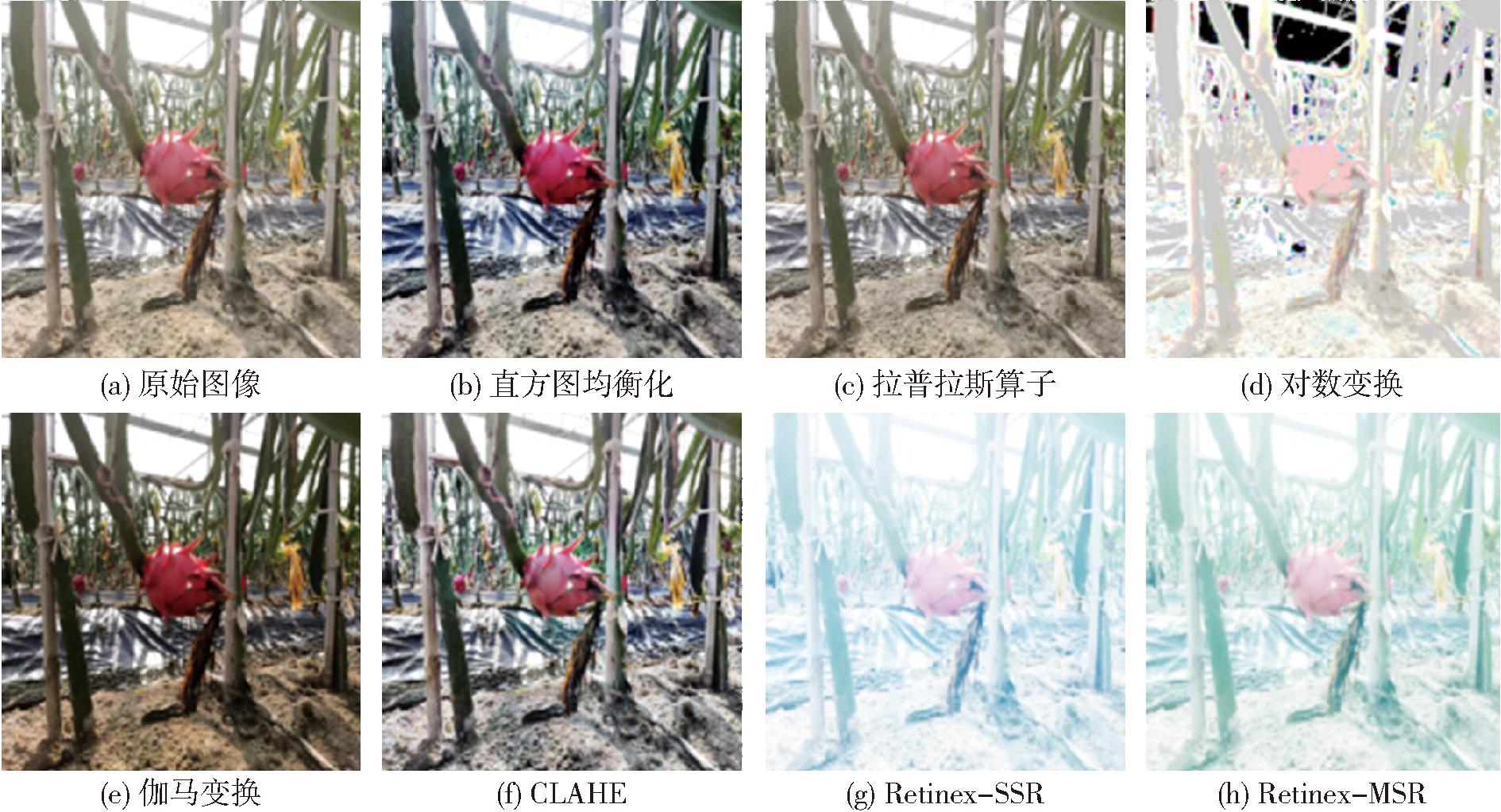

在阴天或逆光条件下采集的图像中火龙果模糊不清晰,大大降低模型稳定性。因此,为了凸显火龙果特征,采用图像增强技术进行数据预处理,提高图像对比度,突出图像细节,降低光照条件差异对视觉效果的影响,增强模型的抗噪性。本文对火龙果图像进行7种图像增强算法操作,通过对比筛选出最优算法,包括直方图均衡化、拉普拉斯算子、对数变换、伽马变换、限制对比度自适应直方图均衡化(Contrast limited adaptive histogram equalization,CLAHE)、Retinex-SSR和Retinex-MSR算法。结果如图4所示,观察发现伽马变换算法能够降低光照对火龙果的影响,突出果实轮廓,使果实更加清晰,效果最佳。因此,最终采用伽马变换进行图像增强。

图4 不同图像增强算法结果对比

Fig.4 Comparison results of different image enhancement algorithms

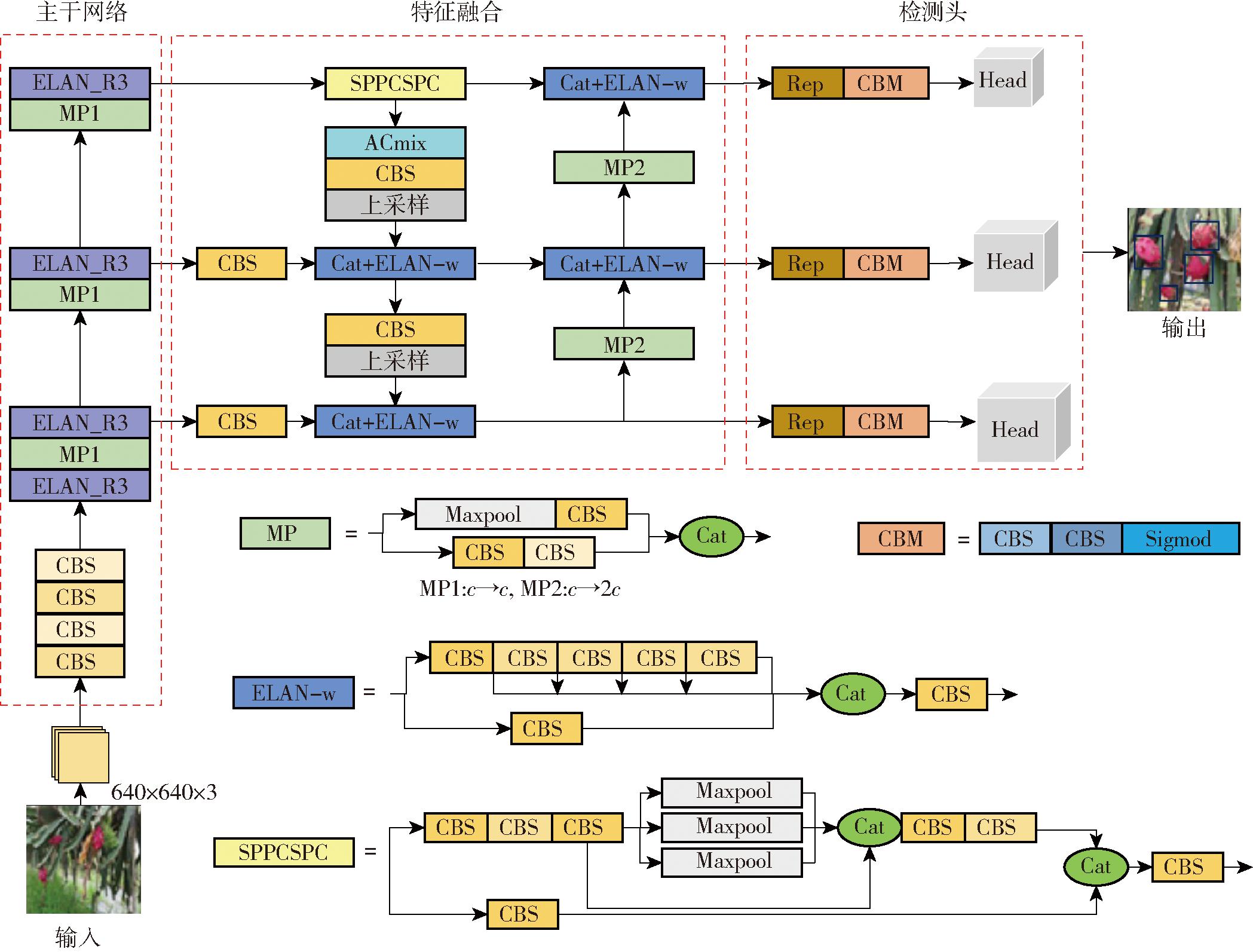

2 模型构建

YOLO v7目标检测算法于2022年7月推出,具有较高的检测速度和检测精度[27]。由于其均衡的综合性能,已经成为了目标检测研究中热门算法,展现了广泛的应用前景。YOLO v7网络由主干网络、特征融合和检测头3部分组成。主干网络包括CBS卷积网络、ELAN卷积网络和MP卷积网络,主要用来提取大、中、小不同粒度的特征图信息,然后输入到特征融合模块。特征融合模块采用PA-FPN结构,将提取的不同粒度特征分别学习,集中融合,得到尽可能多的图像特征。检测头模块采用3个检测头,通过重参数化REP卷积结构进行结果预测,最终得到目标的类别概率、置信度和位置坐标信息。

2.1 主干网络

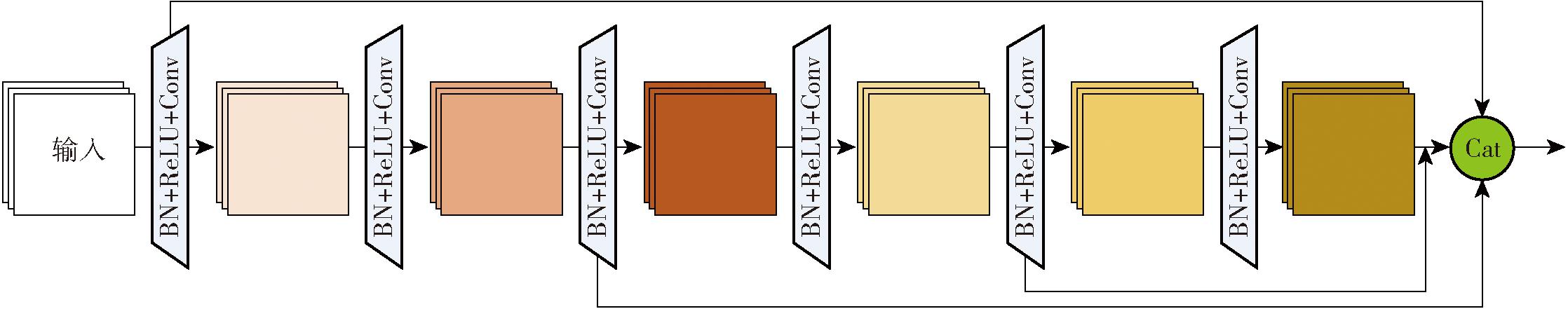

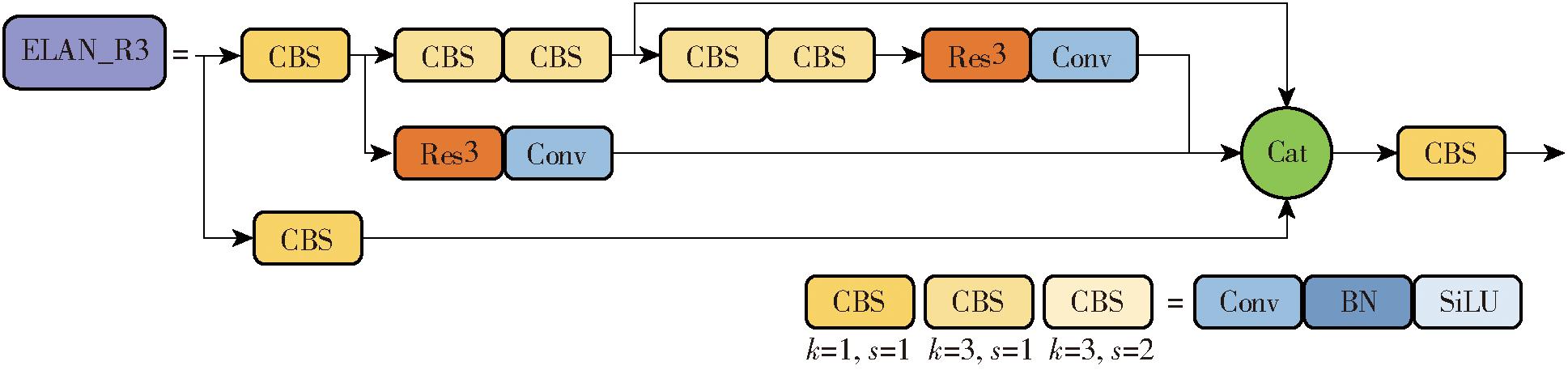

为了筛选出高品质、成熟火龙果果实,本文不仅对果实成熟度进行检测,还需要实现缺陷检测、多果检测。火龙果表面缺陷检测(如碰伤、腐烂、小炭疽点等)和多个果实检测均属于小目标检测。原来的主干网络首先通过4个CBS堆叠操作来对输入图像进行4次卷积运算,提取底层特征,然后通过MP和ELAN模块提取细粒度特征。然而,这种结构会提取大量重复特征信息,导致丢失一些细粒度特征[28],对小目标检测不友好。为此,本文设计Res3网络单元改进ELAN模块[29]。如图5所示,Res3网络设置多个融合分支结构,使上层特征能更细粒度地融合,减少网络对重复特征的利用,方便捕捉火龙果果实细粒度特征。改进后的ELAN结构如图6所示,命名为ELAN_R3。

图5 Res3网络结构图

Fig.5 Res3 network structure

图6 ELAN_R3模块

Fig.6 ELAN_R3 module

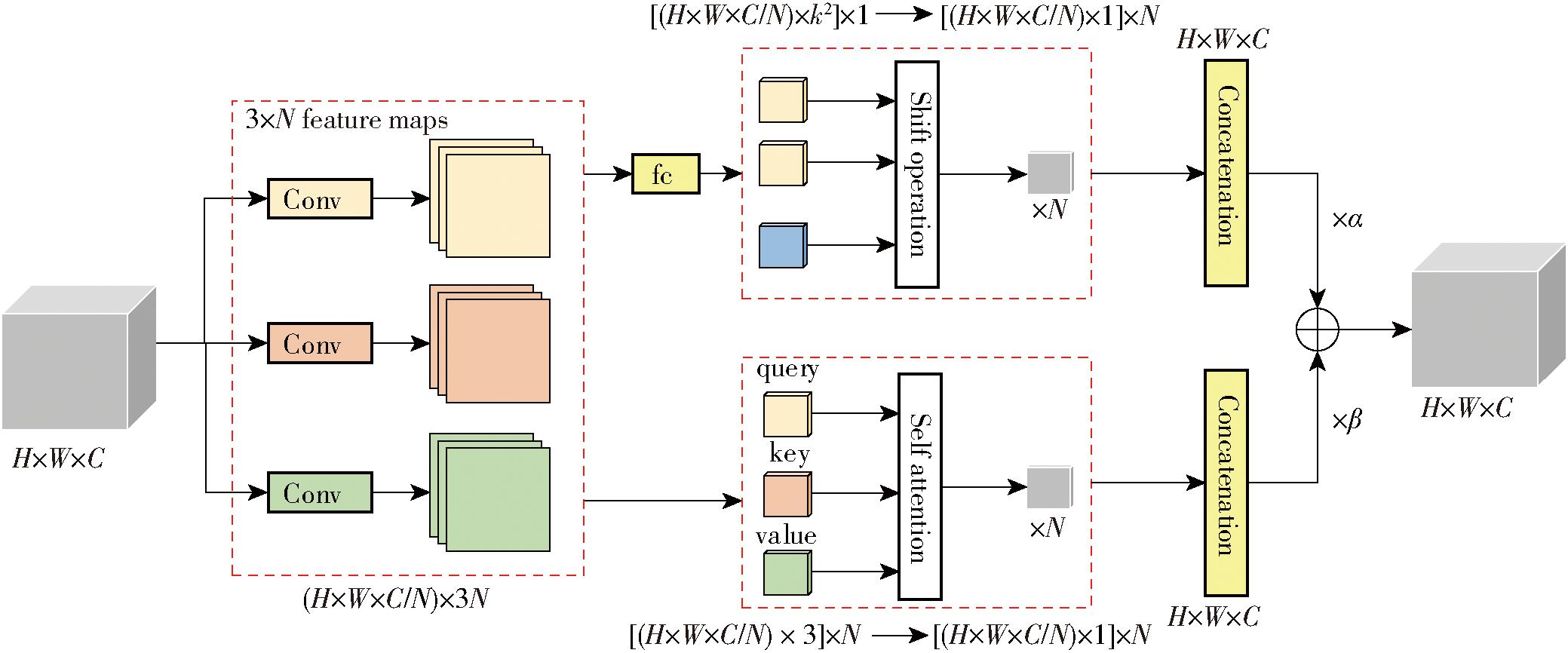

2.2 ACmix注意力模块

为了增强模型对果实区域的关注度,防止杂乱背景信息干扰,提高模型对遮挡果实检测的准确性,本文引入ACmix注意力机制[30]。ACmix充分利用卷积和自注意机制两模块互补特性,结合各自优势,避免复杂投影,以最小计算开销集成卷积和自注意力机制。如图7所示,图中H、W、C、N分别表示特征图长度、特征图宽度、通道数量、自注意力头数量。首先,通过3个1×1卷积映射输入特征,得到中间特征。然后,以不同的模式(分别为自注意和卷积)对中间特征进行重用和聚合。由于2个模块共享相同的1×1卷积操作,因此只需执行一次投影,并将这些中间特征映射分别用于不同的聚合操作,这大大降低模型复杂度,增强模型对特征的整合能力,减少噪声干扰。

图7 ACmix结构图

Fig.7 ACmix structure

2.3 YOLO v7-RA

本文对YOLO v7网络进行改进,构建火龙果检测模型,命名为YOLO v7-RA。如图8所示,设计ELAN_R3网络改进主干网络的ELAN模块,使模型更好地理解火龙果图像的细节特征,提高果实品质与成熟度分类任务的准确性和鲁棒性。在特征融合前,将ACmix模块加在主干网络SPPCSPC模块之后,增强主干网络对果实关键特征和位置信息的感知能力,降低杂乱背景的影响。

图8 YOLO v7-RA模型

Fig.8 YOLO v7-RA model

3 实验与结果分析

3.1 实验平台与参数设置

本文火龙果品质与成熟度双指标检测实验环境配置为:Windows 11操作系统,CPU为Core i9-12800H,GPU为NVIDIA GeForce RTX 3070 Ti,编程语言为Python 3.9,采用Pytorch 1.11.0+CUDA 11.3+cudnn 8.2.0深度学习框架。

在训练网络时,将输入图像尺寸调整为640像素×640像素,初始学习率设置为0.01,批处理尺寸为16,动力为0.937,权重衰减为0.000 5,训练轮数为120次,使用Adam优化器更新参数,采用余弦退火算法调整学习率,使模型快速精准地收敛到全局最优。

3.2 评价指标

为了验证YOLO v7-RA模型的有效性,综合评价模型性能,使用精准率(P)、召回率(R)、均值平均精度(mAP)、帧率(FPS)作为评价指标。P、R能够综合评估模型的检测效果。mAP能够体现模型在火龙果双指标检测中的整体性能情况,使验证更全面、客观。mAP0.5表示阈值为0.5的mAP。FPS表示每秒处理图像数量,评估火龙果检测模型速度。

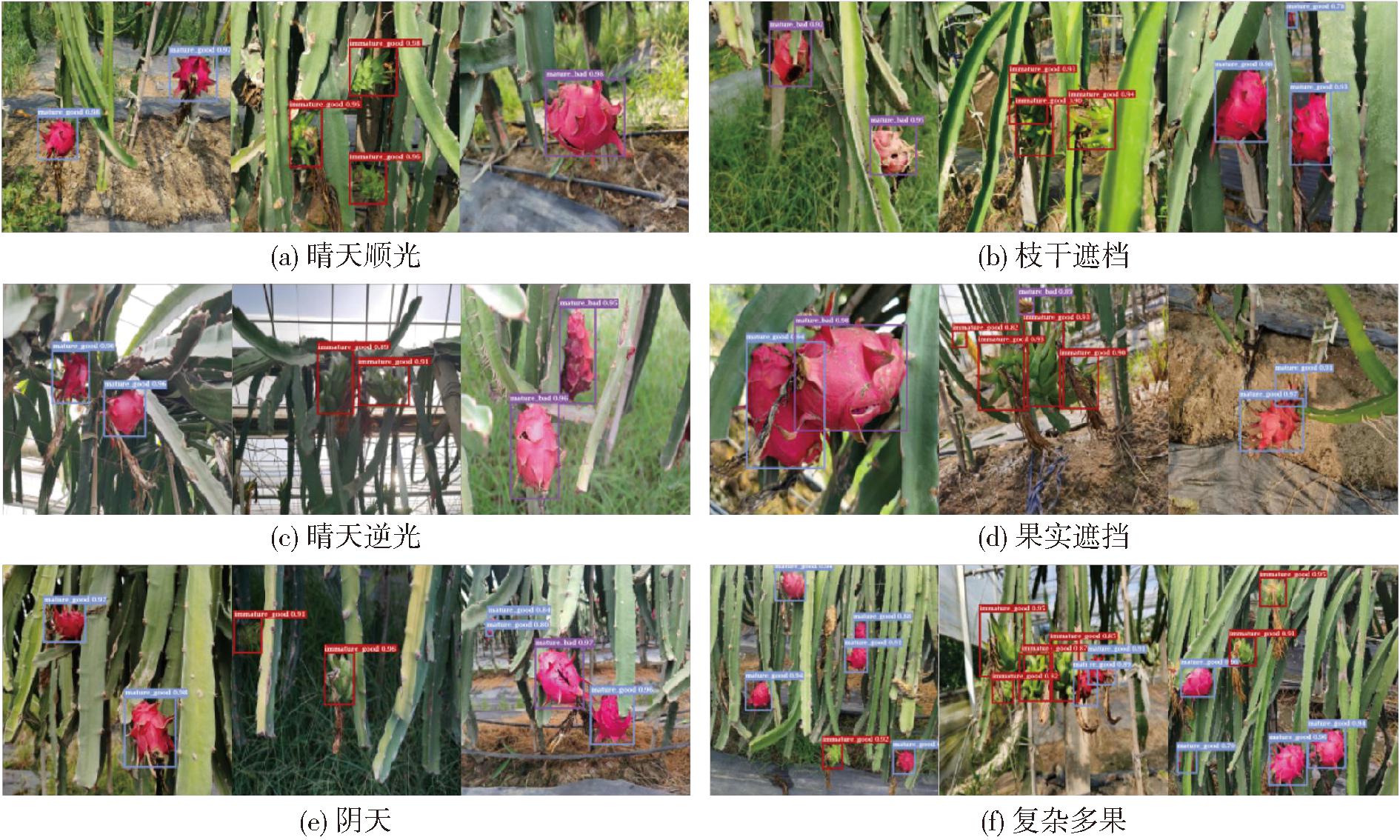

3.3 YOLO v7-RA在复杂背景下双指标检测结果

为了验证YOLO v7-RA模型准确性和稳定性,本文在真实场景下对火龙果果实进行品质与成熟度双指标检测。图9a、9c、9e分别为火龙果在晴天顺光、晴天逆光、阴天3种场景下的检测结果。结果表明,模型能够有效区分火龙果的成熟情况,并通过果实表面是否存在明显的缺陷、损伤等特征确定火龙果品质。不同光线对模型影响较低,具有良好的稳定性。

图9 YOLO v7-RA双指标检测结果

Fig.9 YOLO v7-RA dual-index detection results

图10a为YOLO v7-RA模型在测试集上的目标损失函数曲线、边框损失函数曲线和双指标分类损失函数曲线。观察得出,前20轮训练快速拟合,在30轮训练后损失函数均趋于平稳,训练120轮后损失值保持稳定,表明YOLO v7-RA模型有良好的收敛性。图10b评价指标曲线表明YOLO v7-RA模型经过120轮训练后每个评价指标均稳定,精准率为97.4%,召回率为97.7%,mAP0.5为96.2%。通过以上实验验证了该模型在火龙果品质与成熟度双指标检测任务中的准确性和稳定性。

图10 YOLO v7-RA模型检测结果曲线

Fig.10 YOLO v7-RA model detection result curves

3.4 YOLO v7-RA模型对果实遮挡、多果的检测结果

为了验证YOLO v7-RA模型的泛化能力,对遮挡的火龙果果实进行检测,选择300幅遮挡果实图像进行测试。在枝干遮挡、果实互相遮挡情况下,火龙果果实检测精准率达到91.4%,具有较高精准率。图9b、9d、9f为火龙果在枝干遮挡、果实遮挡、多果复杂环境下检测结果。结果表明双指标检测精准率略有降低,但模型依然能稳定检测出遮挡、背景复杂且距离较远的小果实。分析原因是人工标注会忽略距离过远、果实过小或遮挡过严重的果实,但是这类果实即使成功检测,也不具备采摘条件。总体来说,模型在环境干扰、小目标检测情况下均表现优异,具有较好泛化能力。

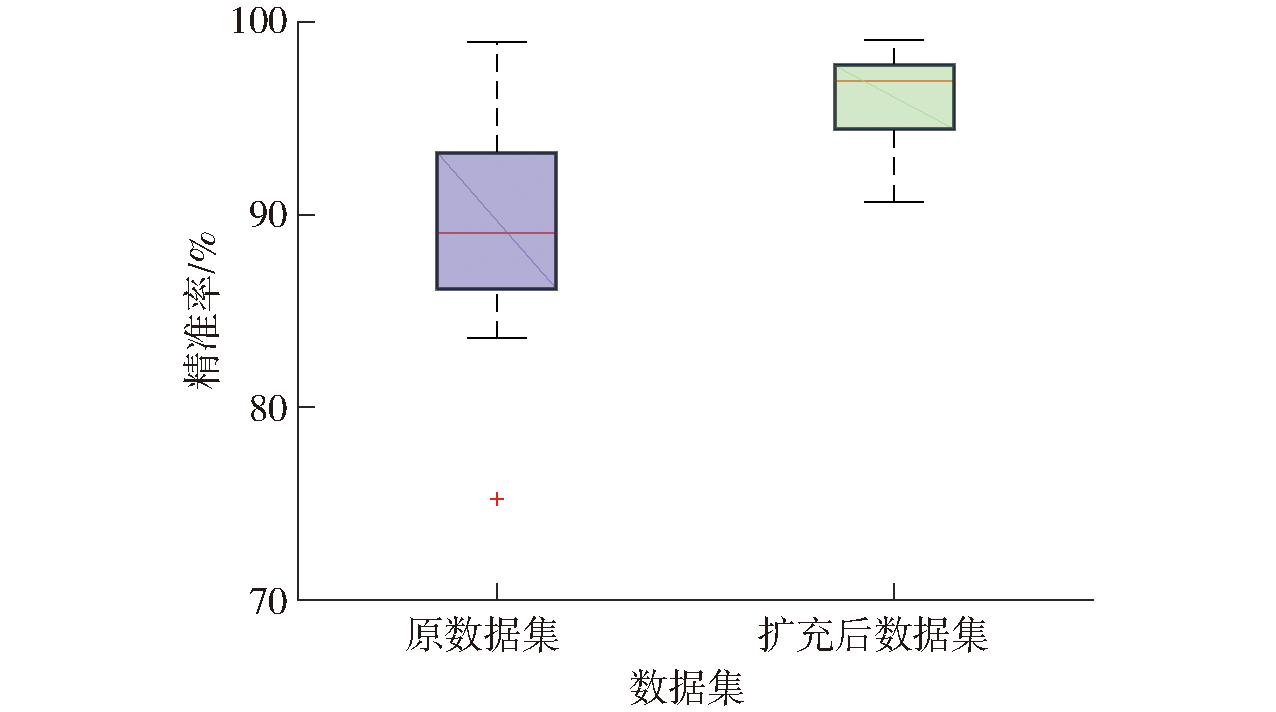

3.5 数据集扩充对模型性能的影响

为了客观评价StyleGAN2-ADA算法对模型的影响,使用精准率箱型图对比火龙果数据集扩充前和扩充后对火龙果的检测性能。如图11所示,通过箱型图对比发现,原数据集精准率分布存在较大差异,离群值多,表明原始复杂环境火龙果数据集数据量不足,导致检测结果不稳定。StyleGAN2-ADA算法扩充数据后精准率箱体长度较短,中位准确率高,离群值少,提高了模型精准度和泛化能力。

图11 StyleGAN2-ADA检测精准率对比

Fig.11 Comparison of StyleGAN2-ADA detection precision

3.6 消融实验

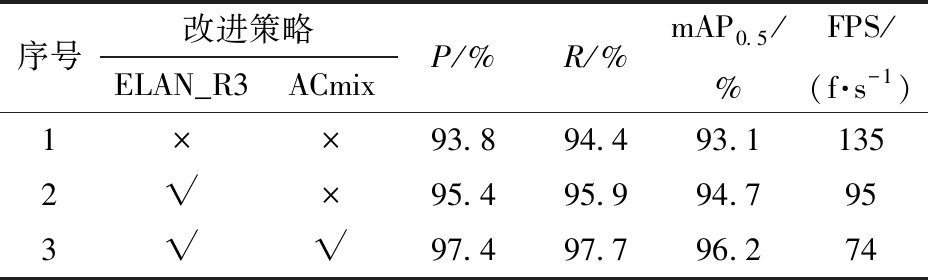

为了直观分析ELAN_R3模块、ACmix注意力机制对模型性能优化的效果,在相同实验条件下,将不同改进策略分别加入到YOLO v7网络中。共设置3组实验,首先,使用原始YOLO v7模型;然后,利用ELAN_R3模块改进主干网络;最后,同时利用ELAN_R3模块和ACmix混合注意力机制2种改进策略,结果如表1所示。

表1 消融实验结果

Tab.1 Ablation results

注:“√”表示采用此策略,“×”表示未采用此策略。

序号改进策略ELAN_R3ACmixP/%R/%mAP0.5/%FPS/(f·s-1)1××93.894.493.11352√×95.495.994.7953√√97.497.796.274

从表1可知,对比实验1和实验2,使用ELAN_R3模块的主干网络模型在精准率和召回率方面有明显提高,mAP0.5提高1.6个百分点,说明ELAN_R3模块对算法的主干网络性能有较大提升。实验3在原网络中同时引入ELAN_R3模块和ACmix模块,模型精准率、召回率和mAP0.5分别提高3.6、3.3、3.1个百分点,模型检测速度略有下降,但本文模型明显改善了火龙果检测精度。

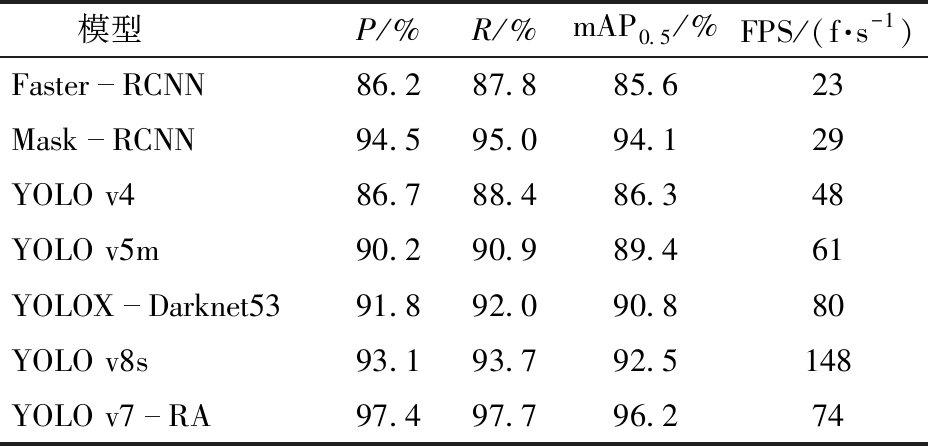

3.7 不同检测模型对比实验

为了进一步验证YOLO v7-RA模型的优势,本文将YOLO v7-RA与当下主流目标检测模型,包括两阶段目标检测模型Faster-RCNN、Mask-RCNN和一阶段目标检测模型YOLO v4、YOLO v5m、YOLOX-Darknet53、YOLO v8s进行对比分析。

从表2可知,两阶段目标检测模型中,Faster-RCNN的P、R、mAP0.5及FPS显著低于其他模型,无明显优势;Mask-RCNN的P、R、mAP0.5值比YOLO v4、YOLO v5m、YOLOX-Darknet53、YOLO v8s高,比YOLO v7-RA低,但相较一阶段检测模型速度最慢,是以牺牲速度保证精准度。在两阶段目标检测模型中,YOLO v7-RA的P、R、mAP0.5及FPS均高于YOLO v4、YOLO v5m;YOLOX-Darknet53、YOLO v8s的检测速度比YOLO v7-RA快,但YOLO v7-RA的P、R、mAP0.5分别比YOLOX-Darknet53高5.6、5.7、5.4个百分点,比YOLO v8s高4.3、4、3.7个百分点。综上结果表明,YOLO v7-RA模型在火龙果检测的检测精度和检测速度之间取得良好的平衡,能更高效地对火龙果品质与成熟度进行精准检测。

表2 不同模型对比实验结果

Tab.2 Different models comparison experimental results

模型P/%R/%mAP0.5/%FPS/(f·s-1)FasterRCNN86.287.885.623MaskRCNN94.595.094.129YOLO v486.788.486.348YOLO v5m90.290.989.461YOLOXDarknet5391.892.090.880YOLO v8s93.193.792.5148YOLO v7RA97.497.796.274

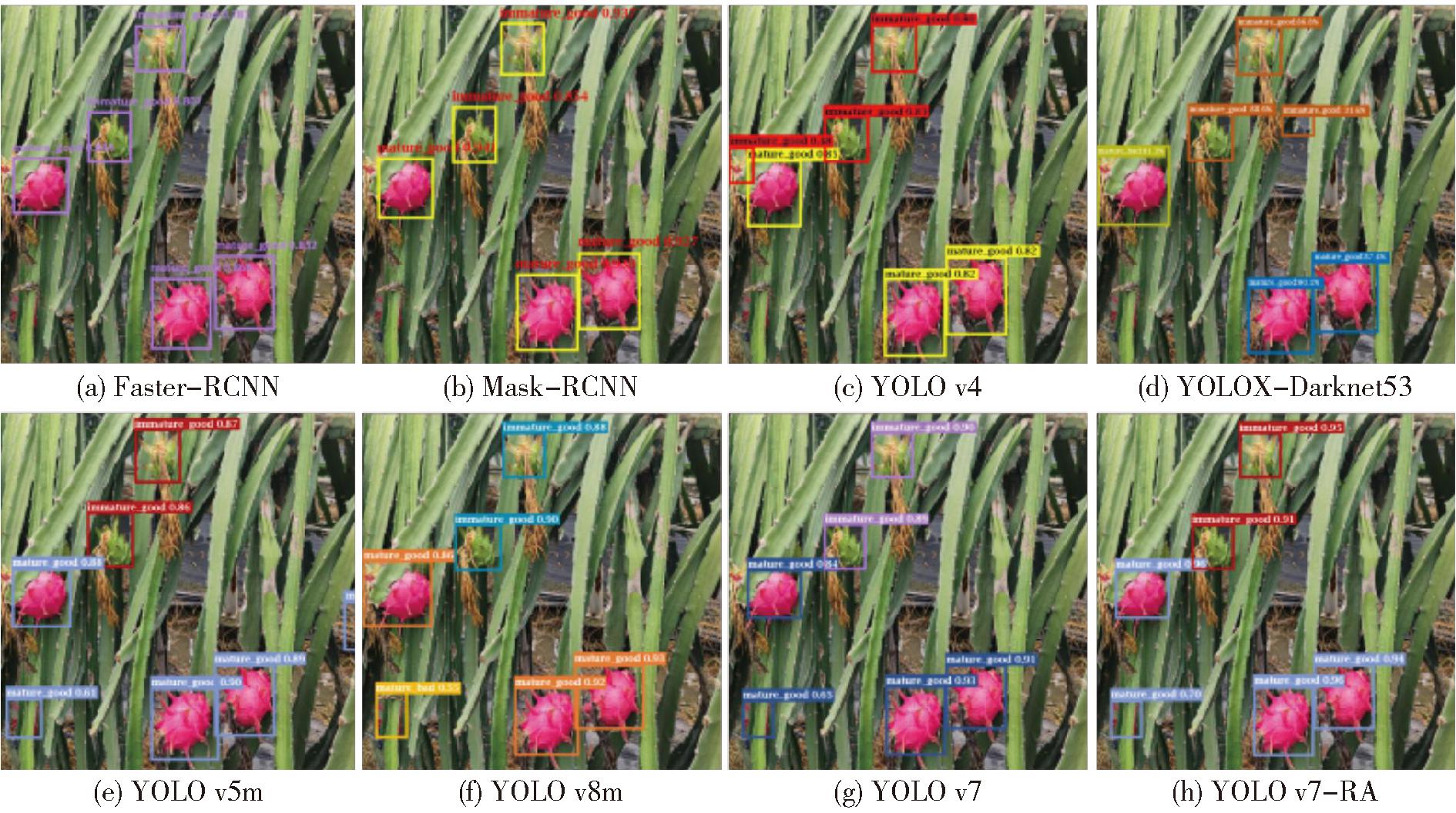

图12为在多果、果实相互遮挡等复杂情况下的火龙果品质与成熟度双指标检测结果。观察发现,Faster-RCNN、Mask-RCNN、YOLO v4、YOLO v5m、YOLOX-Darknet53存在漏识、误识现象,即被错误认为是火龙果或背景区域。YOLO v4、YOLOX-Darknet53、YOLO v8s存在对遮挡果实分类错误现象。YOLO v7对遮挡果实的判断能力较好,但检测精度有待提高。根据火龙果采摘经验表明,果实错误识别会造成严重损害,如损坏果实或枝条[31]。YOLO v7-RA在保证一定检测速度的同时,在果实定位、检测精度、误识率上均优于其他模型,具有良好的鲁棒性。

图12 不同模型检测结果

Fig.12 Different model detection results

4 结论

(1)针对火龙果多性能指标检测难的问题,本文提出一种基于YOLO v7-RA的火龙果检测方法,实现了在复杂环境下对火龙果品质和成熟度的准确检测。

(2)构建复杂环境火龙果数据集,针对采集的火龙果图像,利用StyleGAN2-ADA进行数据扩充,通过图像增强技术对数据集预处理,降低光照环境影响,为模型研究提供可靠的数据支持。提出YOLO v7-RA检测模型。设计ELAN_R3改进ELAN模块,增强对细粒度特征的捕捉能力,有效改善多指标识别效果。融入ACmix注意力机制,强化网络的特征共享能力,降低背景信息的干扰。

(3)提出方法精准率为97.4%,召回率为97.7%,mAP0.5为96.2%,FSP为74 f/s。在复杂环境下,能快速准确地检测出火龙果品质与成熟度特性,具有良好的稳定性和泛化能力,对火龙果智能采摘具有积极意义。

[1] 赵玉山.我国火龙果产量跃居全球第一[J].中国果业信息,2023,40(2):52.

[2] WANG Peng, NIU Tong, HE Dongjian. Tomato young fruits detection method under near color background based on improved Faster R-CNN with attention mechanism[J]. Agriculture, 2021, 11(11): 1059.

[3] ZHENG Zhenhui, XIONG Juntao, LIN Huan, et al. A method of green citrus detection in natural environments using a deep convolutional neural network[J]. Frontiers in Plant Science, 2021, 12: 705737.

[4] 苟园旻,闫建伟,张富贵,等.水果采摘机器人视觉系统与机械手研究进展[J].计算机工程与应用,2023,59(9):13-26.GOU Yuanwen, YAN Jianwei, ZHANG Fugui, et al. Research progress on vision system and manipulator of fruit picking robot[J]. Computer Engineering and Applications, 2023, 59(9): 13-26. (in Chinese)

[5] WANG Chenglin, ZOU Xiangjun, TANG Yunchao, et al. Localisation of litchi in an unstructured environment using binocular stereo vision[J].Biosystems Engineering, 2016, 145:39-51.

[6] 邓子青,王阳,张兵,等. 基于Otsu算法与形态学的火龙果图像分割研究[J]. 智能计算机与应用,2022,12(6):106-109.DENG Ziqing, WANG Yang, ZHANG Bing, et al. Research on pitaya image segmentation based on Otsu algorithm and morphology[J]. Intelligent Computer and Applications, 2022,12(6):106-109. (in Chinese)

[7] 舒田,陈智虎,刘春艳,等. 火龙果植株高光谱识别与特征波段提取[J]. 贵州农业科学,2022,50(3):117-124.SHU Tian, CHEN Zhihu, LIU Chunyan, et al. Hyperspectral identification and characteristic bands extraction of pitaya plant[J]. Guizhou Agricultural Sciences, 2022,50(3):117-124. (in Chinese)

[8] 肖冬娜,周忠发,尹林江,等. 融合颜色指数与空间结构的喀斯特山地火龙果单株识别[J]. 激光与光电子学进展,2022,59(10):489-503.XIAO Dongna, ZHOU Zhongfa, YIN Linjiang, et al. Identification of single plant of karst mountain pitaya by fusion of color index and spatial structure[J]. Advances in Laser and Optoelectronics, 2022,59(10):489-503. (in Chinese)

[9] 孔凡国, 李志豪, 仇展明, 等. 基于改进YOLOv5-s的火龙果多任务识别与定位[J]. 电子测量技术, 2023, 46(18): 155-162.KONG Fanguo, LI Zhihao, QIU Zhanming, et al. Multitasking recognition and positioning of pitaya based on improved YOLOv5-s[J]. Electronic Measurement Techonlogy, 2023, 46(18): 155-162. (in Chinese)

[10] 宋怀波, 尚钰莹, 何东健. 果实目标深度学习识别技术研究进展[J]. 农业机械学报, 2023, 54(1): 1-19.SONG Huaibo, SHANG Yuying, HE Dongjian. Review on deep learning technology for fruit target recognition[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(1): 1-19. (in Chinese)

[11] LIANG Cuixiao,XIONG Juntao,ZHENG Zhenhui, et al. A visual detection method for nighttime litchi fruits and fruiting stems[J]. Computers and Electronics in Agriculture,2020,169: 105192.

[12] 张阳婷, 黄德启, 王东伟, 等. 基于深度学习的目标检测算法研究与应用综述[J]. 计算机工程与应用, 2023, 59(18): 1-13.ZHANG Yangting, HUANG Deqi, WANG Dongwei, et al. Review on research and application of deep learning-based target detection algorithms[J]. Computer Engineering and Applications, 2023, 59(18): 1-13. (in Chinese)

[13] WU Delin, JIANG Shan, ZHAO Enlong, et al. Detection of Camellia oleifera fruit in complex scenes by using YOLOv7 and data augmentation[J]. Applied Sciences,2022,12(22): 11318.

[14] 周佳良,王金鹏,张跃跃, 等.基于GCAM-YOLOv5的火龙果快速检测方法[J].林业工程学报,2023,8(3):141-149.ZHOU Jialiang, WANG Jinpeng, ZHANG Yueyue, et al. Fast detection method of dragon fruits based on GCAM-YOLOv5[J]. Journal of Forestry Engineering, 2023,8(3):141-149. (in Chinese)

[15] 商枫楠,周学成,梁英凯, 等.基于改进YOLOX的自然环境中火龙果检测方法[J].智慧农业(中英文),2022,4(3):120-131.SHANG Fengnan, ZHOU Xuecheng, LIANG Yingkai, et al. Detection method for dragon fruit in natural environment based on improved YOLOX[J]. Smart Agriculture, 2022,4(3):120-131. (in Chinese)

[16] NAN Yulong, ZHANG Huichun, ZENG Yong,et al. Intelligent detection of Multi-Class pitaya fruits in target picking row based on WGB-YOLO network[J].Computers and Electronics in Agriculture, 2023, 208: 107780.

[17] 王金鹏,高凯,姜洪喆,等.基于改进的轻量化卷积神经网络火龙果检测方法[J].农业工程学报,2020,36(20):218-225.WANG Jinpeng, GAO Kai, JIANG Hongzhe, et al. Method for detecting dragon fruit based on improved lightweight convolutional neural network[J]. Transactions of the CSAE, 2020, 36(20): 218-225. (in Chinese)

[18] 陈仁凡, 谢知, 林晨. 基于YOLO-ODM的温室草莓成熟度的快速检测[J]. 华中农业大学学报, 2023, 42(4): 262-269.CHEN Renfan, XIE Zhi, LIN Chen. YOLO-ODM based rapid detection of strawberry ripeness in greenhouse[J]. Journal of Huazhong Agricultural University, 2023, 42(4): 262-269. (in Chinese)

[19] LIU Zhu, YIN Hua. YOLOv7-Peach: an algorithm for immature small yellow peaches detection in complex natural environments[J]. Sensors, 2023, 23(11): 5096.

[20] 张林鍹, 巴音塔娜, 曾庆松. 基于StyleGAN2-ADA和改进YOLO v7的葡萄叶片早期病害检测方法[J]. 农业机械学报, 2024, 55(1): 241-252.ZHANG Linxuan, BA Yintana, ZENG Qingsong. Grape disease detection algorithm based on StyleGAN2-ADA and improved YOLO v7[J]. Transactions of the Chinese Society for Agricultural Machinery, 2024, 55(1): 241-252. (in Chinese)

[21] 范安琪,左常洲,彭菁, 等.基于双目立体视觉的冻干草莓外部品质等级检测方法研究[J].南京农业大学学报,2023,46(2):396-404.FAN Anqi, ZUO Changzhou, PENG Qing, et al. Study on detecting method of external quality level of freeze-dried strawberry based on binocular stereo vision[J]. Journal of Nanjing Agricultural University, 2023,46(2):396-404. (in Chinese)

[22] 王昱, 姚兴智, 李斌, 等. 基于改进YOLO v7-tiny的甜椒畸形果识别算法[J]. 农业机械学报, 2023, 54(11): 236-246.WANG Yu, YAO Xingzhi, LI Bin, et al. Malformed sweet pepper fruit identification algorithm based on improved YOLO v7-tiny[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(11): 236-246. (in Chinese)

[23] 马瑞峻,何浣冬,陈瑜, 等.基于改进YOLOv5的火龙果成熟度识别方法[J].沈阳农业大学学报,2023,54(2):196-206.MA Ruijun, HE Huandong, CHEN Yu, et al. Recognition method for maturity of pitaya based on improved YOLOv5[J]. Journal of Shenyang Agricultural University, 2023,54(2):196-206. (in Chinese)

[24] 容典.脐橙表面缺陷的机器视觉快速检测研究及嵌入式系统应用[D]. 杭州: 浙江大学,2017.RONG Dian. Study on rapid detection of navel orange surface defect based on machine vision and embedded system application[D]. Hangzhou: Zhejiang University, 2017. (in Chinese)

[25] 朱立学, 赖颖杰, 张世昂, 等. 基于改进U-Net的火龙果采摘图像分割和姿态估计方法[J]. 农业机械学报, 2023, 54(11): 180-188.ZHU Lixue, LAI Yingjie, ZHANG Shi’ang, et al. Image segmentation and pose estimation method for pitaya picking robot based on enhanced U-Net[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(11): 180-188. (in Chinese)

[26] KARRAS T, AITTALA M, HELLSTEN J, et al. Training generative adversarial networks with limited data[J]. Advances in Neural Information Processing Systems, 2020, 33: 12104-12114.

[27] WANG Chienyao, BOCHKOVSKIY Alexey, LIAO Hongyuan.YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[J]. arXiv e-prints, arXiv: 2207. 02696, 2022.

[28] HUSSAIN Muhammad, Al-AQRABI Hussain, MUNAWAR Muhammad, et al. Domain feature mapping with YOLOv7 for automated edge-based pallet racking inspections[J]. Sensors, 2022, 22(18): 6927.

[29] ZHANG Yuan, SUN Youpeng, WANG Zheng, et al. YOLO v7-RAR for urban vehicle detection[J]. Sensors, 2023, 23(4): 1801.

[30] PAN Xuran, GE Chunjiang, LU Rui, et al. On the integration of self-attention and convolution[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022: 815-825.

[31] 王金鹏, 周佳良, 张跃跃, 等. 基于优选YOLOv7模型的采摘机器人多姿态火龙果检测系统[J]. 农业工程学报,2023,39(8):276-283.WANG Jinpeng, ZHOU Jialiang, ZHANG Yueyue, et al.Multi-pose dragon fruit detection system for picking robots based on the optimal YOLOv7 model[J]. Transactions of the CSAE, 2023, 39(8): 276-283. (in Chinese)