0 引言

作物种质资源具有丰富的遗传多样性,是作物遗传育种研究的物质基础[1],其表型性状的智能化、精准化、规模化鉴定是发掘优异种质及优异等位基因[2]、加速育种进程的重要手段。近年来,主要作物的种质资源多年多点性状时序性精准鉴定工作陆续开展,但传统人工方式的作物表型性状鉴定费时、费力、主观性强,且对作物存在一定的破坏性。随着遥感技术、传感器技术、GPU等芯片技术以及图像处理技术的快速发展,作物表型性状田间高通量、高精度、自动无损鉴定研究逐步展开[3-7]。其中,无人机搭载可见光传感器凭借机动灵活、成本低、作业效率高和图像直观等优势,成为采集作物表型信息的重要手段[8-10];深度学习技术凭借特征选择不依赖人工、算法泛化能力强等优势,在作物表型鉴定研究中获得了广泛应用[9,11-13]。

玉米在保障国家粮食安全中发挥着重要作用。雄穗性状作为玉米生长发育过程中的重要农艺性状[14],是玉米种质资源鉴定工作中的重点。许多学者利用深度学习技术,基于玉米可见光图像开展雄穗检测技术研究,杨蜀秦等[15]提出了一种基于骨干网络简化和在特征提取网络中添加坐标位置信息的改进CenterNet检测模型,实现了玉米雄穗检测精度和速度的提升。张晓勐等[16]以YOLO v4作为基准模型,采用GhostNet 替换主干特征提取网络,采用深度可分离卷积模块替换加强特征提取网络中的普通卷积模块,并将激活函数更换为ReLU6,实现了玉米雄穗检测精度与速度的提升。LIU等[17]采用ResNet替换Faster R-CNN的特征提取网络,并修改锚框尺寸,提高无人机航拍玉米雄穗图像的检测效果。JIA等[18]利用无人机连续10 d采集不同生长阶段的玉米雄穗图像,通过在YOLO v5的基础上添加CA注意力机制提升了模型对雄穗的检测精度。SONG等[19]利用无人机采用倾斜拍摄的方式连续8 d采集不同生长阶段的玉米雄穗图像,通过在YOLO v5的基础上添加SE注意力机制以及替换损失函数的方式提升了模型对雄穗的检测精度。

目前,玉米雄穗检测研究已取得了较好的效果,但已有模型的训练所采用的图像数据集大多涉及品种少,雄穗类型较为单一。在田间玉米种质资源鉴定工作中涉及丰富的种质资源,雄穗大小、形态结构及颜色呈现较大差异。现有玉米雄穗检测模型用于玉米种质资源雄穗检测精度有限。鉴于此,迫切需要建立用于玉米种质资源雄穗检测的图像数据集,并据此构建用于玉米种质资源雄穗检测的网络模型。本文利用无人机平台搭载可见光传感器采集田间玉米种质资源雄穗图像,以当前主流的YOLO系列模型[20-24]YOLO v7-tiny为基础并进行改进,提出一种轻量化的玉米种质资源雄穗检测模型,以期为利用无人机航拍可见光图像进行玉米种质资源雄穗实时、精准检测提供技术支撑。

1 试验数据获取

1.1 数据采集

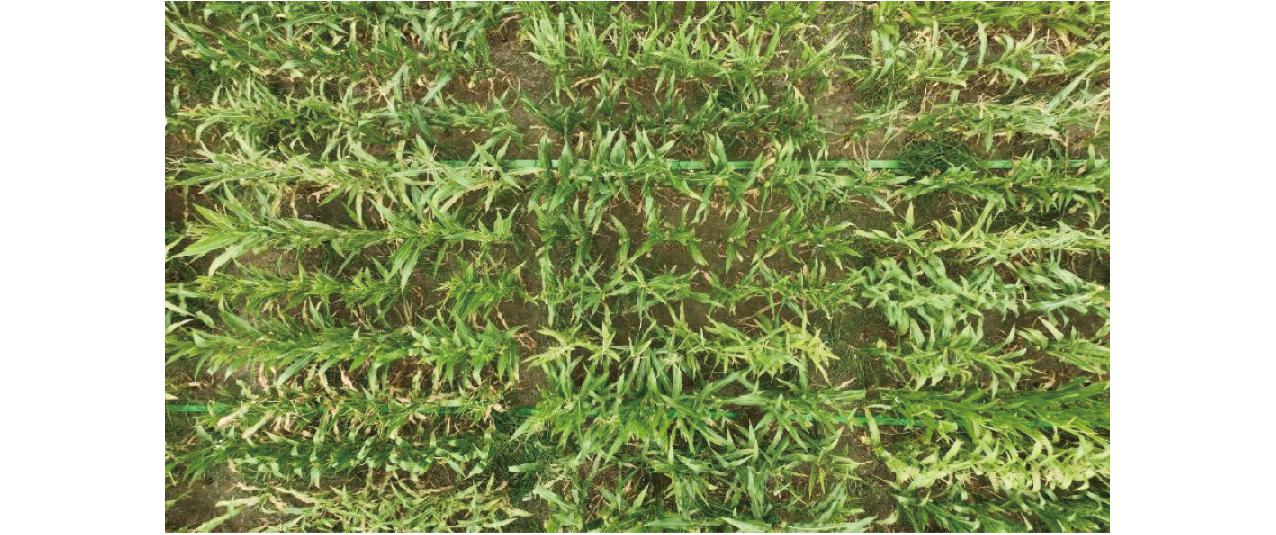

图像数据于2022年夏玉米种植季从河南省新乡市平原新区河南现代农业研究开发基地农作物种质资源研究所种植的玉米种质资源试验田中采集。分别于2022年8月9日、12日、16日、22日、26日对试验田中包含300余份种质资源材料的固定区域进行图像采集,获取这些材料雄穗不同生长时期的图像。采集设备为大疆DJI Mavic 3型无人航拍器,光学镜头等效焦距24 mm,飞行高度为5 m,镜头垂直地面拍摄。每次采集60幅图像,5次共获得300幅图像。图像分辨率为5 280像素×2 970像素和 5 280像素×3 956像素,采集的图像如图1所示。

图1 无人机采集的玉米种质资源雄穗样本图像

Fig.1 Tassel sample image of maize germplasm resources collected by UAV

1.2 数据集构建

将300幅原始图像切片分割为1 280像素×1 280像素的等尺寸图像,去除无雄穗或玉米植株过少的图像,最终获得1 961幅有效图像。利用LabelImg工具标注雄穗,生成VOC格式的.xml文件,再将其转换为YOLO格式的.txt文件,最后将标注好的图像随机划分为训练集1 574幅、验证集187幅、测试集200幅。玉米种质资源雄穗数据集中雄穗的大小、形态结构及颜色差异较大,部分雄穗呈现过小、与背景高度相似、被遮挡及相互交错的情况。图2为数据集中的雄穗状态样本。

图2 玉米雄穗状态样本

Fig.2 Samples of maize tassel state

2 玉米种质资源雄穗检测改进YOLO v7-tiny模型

2.1 YOLO v7-tiny模型

YOLO v7-tiny是YOLO v7面向边缘 GPU设计的轻量化模型。YOLO v7是模型精度和推理性能比较均衡的目标检测模型,模型内存占用量为74.8 MB,参数量为3.65×107,包含定义输入图像形状以及图像预处理等操作的Input部分、用于提取输入图像特征的Backbone部分和进行特征高效融合[25-26]及预测输出的Head部分。为简化结构,实现模型轻量化,YOLO v7-tiny减少了YOLO v7中卷积模块CBS(Conv2d+BN+SiLU)的个数,并将其中的激活函数替换成LeakyReLU以减少计算量,即卷积模块替换成CBL(Conv2d+BN+LeakyReLU);缩减优化了YOLO v7中的ELAN和SPPCSPC模块,直接用简单的最大池化(MP)和CBL分别替换了YOLO v7中的池化模块(MP+3CBS)和RepConv模块。使得YOLO v7-tiny模型内存占用量缩小到12.3 MB,参数量缩减到6.01×106。

2.2 改进YOLO v7-tiny模型

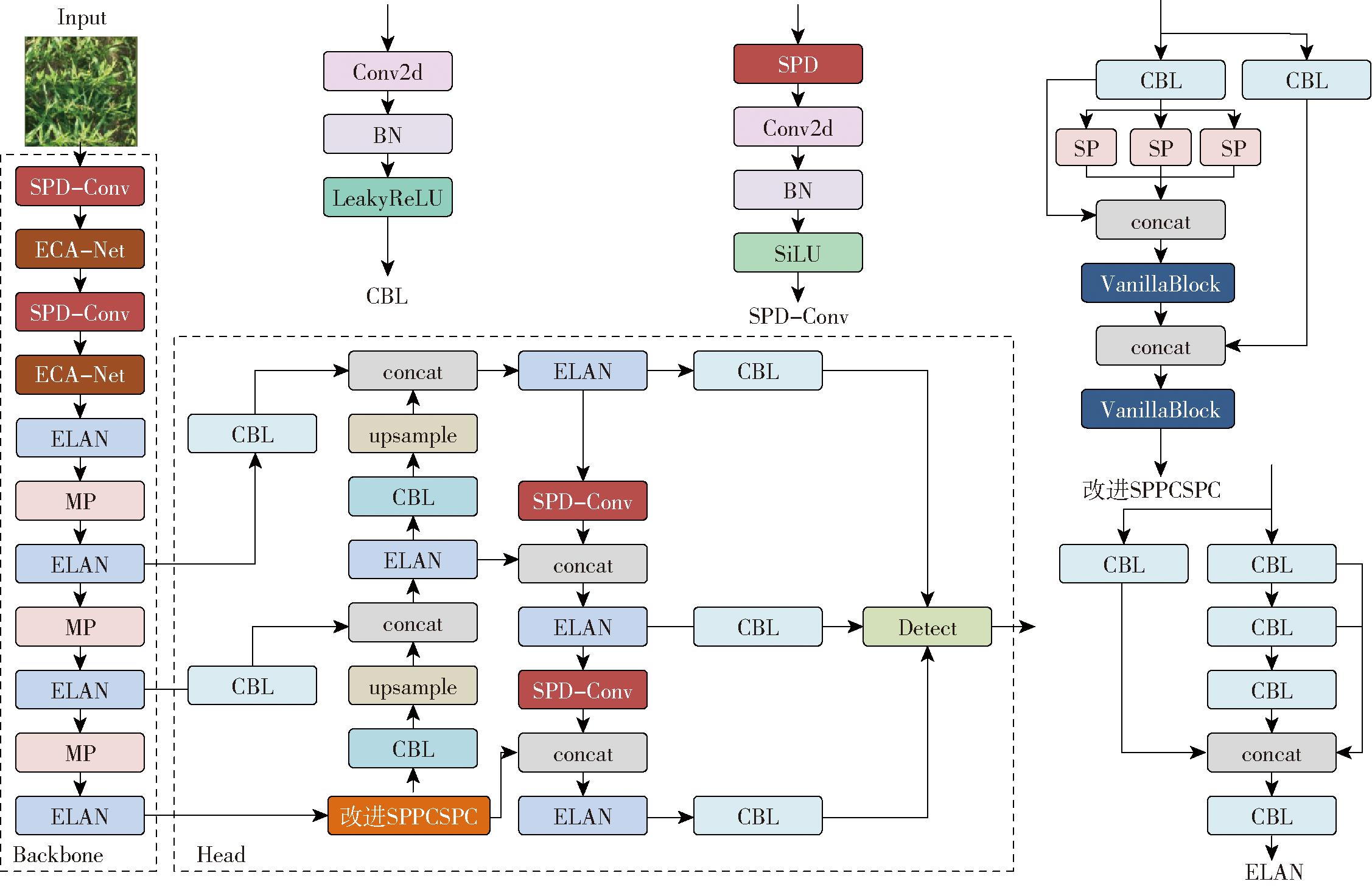

针对玉米种质资源雄穗大小、形态结构及颜色差异大,无人机搭载可见光传感器相比地面采集图像分辨率低,图像中部分雄穗过小、与背景相似度高、被遮挡、相互交错状态等情况带来的雄穗检测精度低的问题,对YOLO v7-tiny模型进行改进。改进YOLO v7-tiny模型的网络结构如图3所示。首先,采用SPD-Conv模块替换模型中步长为2的4个CBL卷积模块,以提升网络对雄穗,尤其是过小雄穗的检测效果;然后,采用VanillaBlock替换SPPCSPC模块中SP操作后的2个CBL模块,以增强模型非线性能力;最后,在Backbone的SPD-Conv模块后添加ECA-Net模块,进一步增强网络特征提取能力。

图3 改进YOLO v7-tiny模型网络结构图

Fig.3 Network structure of improved YOLO v7-tiny

2.2.1 SPD-Conv

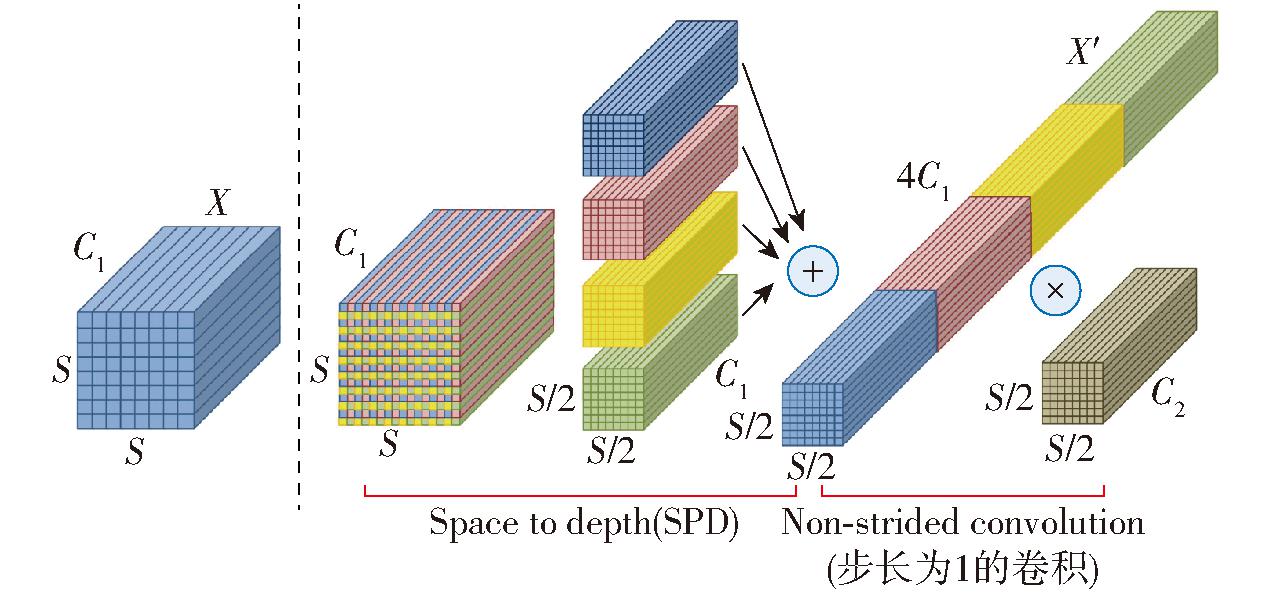

针对目标检测任务中对低分辨率图像、小目标采用跨步卷积及池化导致重要信息丢失从而无法较好地提取有效特征的问题,SUNKARA等[27]提出了SPD-Conv模块。SPD-Conv由1个SPD(Space to depth)层和1个Non-strided卷积层组成,是一种将图像空间信息转换为深度信息的技术,从而减少信息损失并提高网络对低分辨率图像和小目标的学习能力。图4为比例因子(scale)等于2时的SPD-Conv网络示意图。对于给定任何形状为S×S×C1的特征图X,通过SPD层得到4个形状为(S/2,S/2,C1)的特征图,沿通道维度将这些子特征图连接,获得一个形状为(S/2,S/2,4C1)的特征图X′。为尽可能地保留特征信息,使用滤波器数量为C2、步长为1的卷积将特征图X′最终变换为形状为(S/2,S/2,C2)的特征图。

图4 scale为2时的SPD-Conv示意图

Fig.4 Diagram of SPD-Conv when scale was 2

无人机航拍雄穗图像存在相比地面采集图像分辨率低以及较小雄穗和背景特征相似度高的情况,而YOLO v7-tiny中Backbone的前2个CBL模块以及Head下采样部分的2个CBL模块采用步长为2的卷积操作,会损失较多信息从而导致检测效果下降。本文采用SPD-Conv模块替换YOLO v7-tiny中的上述4个CBL卷积模块,从而提升模型对低分辨率图像和过小雄穗的处理能力。

2.2.2 VanillaBlock

人工神经网络多采用增加网络复杂度的方式提升模型性能,这些复杂操作为在嵌入式设备上部署深度学习模型带来挑战。华为诺亚方舟实验室等机构的研究者提出了一种极简的神经网络模型VanillaNet[28],VanillaNet避免高深度、残差和自注意力等复杂操作,仅包含最简单的卷积计算,非常适合资源有限的环境。VanillaNet通过采用深度训练策略和并发堆叠激活函数增强模型的非线性能力,以提高模型性能。深度训练策略将1个卷积层拆分为2个卷积层,由传统非线性激活函数A(x)和恒等映射加权得到的A′(x)作为2个卷积使用的激活函数。A′(x)计算公式为

A′(x)=(1-λ)A(x)+λx

(1)

式中,λ为当前迭代周期(epoch)数和迭代周期总数的比值。 随着模型训练的进行,λ逐渐从0变为1,A′(x)逐渐从A(x)变为x,此时2个卷积层融合成1个卷积层。

并发堆叠激活函数:如果将网络中输入的单个激活函数表示为A(x),A(x)的并发堆叠可表示为

(2)

式中 n——堆叠激活函数数量

ai、bi——每个激活的规模、偏置

As(x)——堆叠的激活函数

VanillaBlock是VanillaNet的核心组件,主要包含卷积和池化操作,通过提升模型非线性,提高特征信息提取能力,从而提高目标检测准确性。为使模型体量更小,YOLO v7-tiny简化了SPPCSPC模块,主要保留了其中用来获得不同感受野的池化模块,结构更简单却一定程度弱化了模型的特征提取能力。因此,本文采用VanillaBlock模块替换SPPCSPC模块中SP操作后的2个CBL模块,用以增强模型非线性,从而提升对雄穗特征的提取能力。

2.2.3 ECA-Net

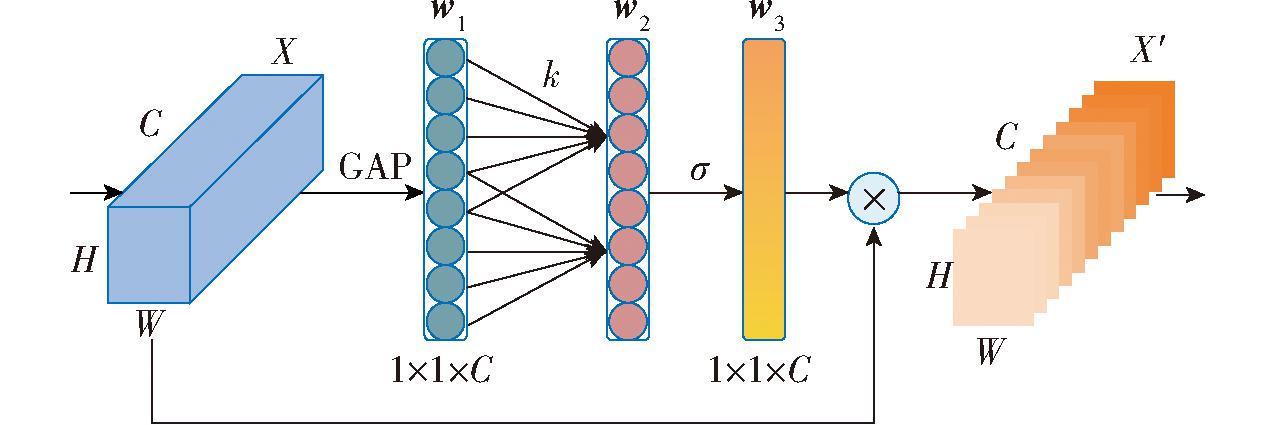

通道注意力机制的目标是自适应地调整通道特征的权重,使得网络可以更好地关注重要特征,抑制不重要特征。ECA-Net[29]在卷积操作中引入通道注意力机制,以捕捉不同通道之间的关系,从而提升特征表示能力,其结构如图5所示。

图5 高效通道注意力模块示意图

Fig.5 Diagram of efficient channel attention module

首先,将输入特征图X通过全局平均池化(Global average pooling,GAP),得到1×1×C的特征向量w1,实现全局上下文信息融合;然后计算自适应卷积核k的大小,经过卷积核大小为k的一维卷积得到一个通道权重向量w2;再经过Sigmoid激活函数将权重向量w2映射在0~1之间得到w3;最后,将w3与输入特征图X相乘,获得加权后的特征图X′。

ECA-Net能够避免通道降维造成的损失,在不增加过多参数和计算成本的情况下,有效地增强网络的表征能力。为进一步提升改进YOLO v7-tiny模型对雄穗特征的提取能力,本文将ECA模块添加在Backbone中的SPD-Conv模块后面。

2.3 试验环境及参数设置

试验用计算机平台的操作系统为Ubuntu 22.04.3LTS,处理器为12th Gen Intel® CoreTM i7-12700×20,内存为128 GB,显卡为GeForce RTX 4090。采用的编程语言及版本为Python 3.8.16,Torch版本为2.0.1+cu118。本试验中所有改进训练所使用的优化器为AdamW,初始学习率为0.01,权重衰减系数为0.000 5,动量为0.937,训练迭代轮次为300,批处理量为16,输入网络图像设置为640像素×640像素。

2.4 模型评价指标

采用精确率、召回率、IoU阈值为0.5时的平均精度均值(Mean average precision,mAP@0.5)、推理速度、参数量、浮点运算量和模型内存占用量7个指标评价模型。

3 结果与分析

3.1 消融试验

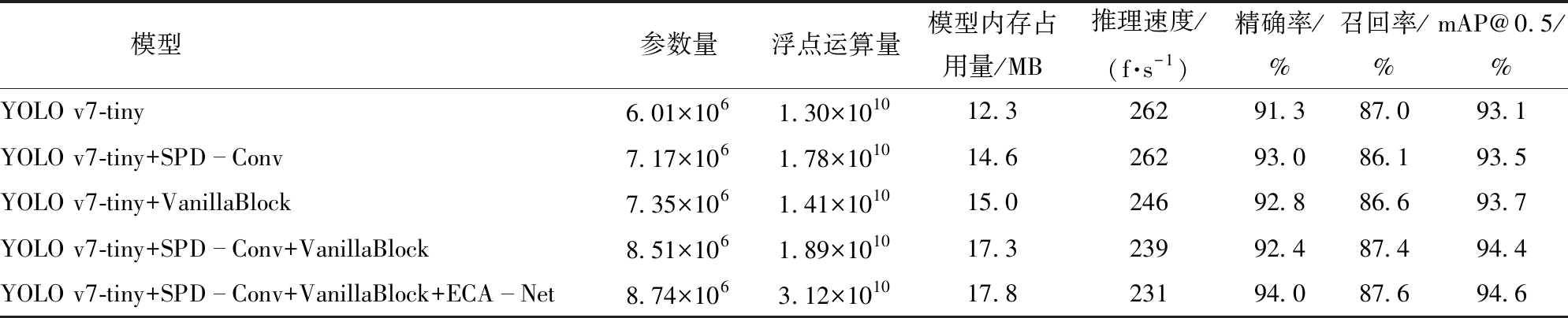

为验证SPD-Conv模块、VanillaBlock模块和ECA-Net模块改进模型对雄穗检测性能的提升效果,以YOLO v7-tiny为基线模型进行消融试验,试验结果如表1所示。由表1可知,单独引入SPD-Conv模块和VanillaBlock模块,模型平均精度均值分别为93.5%和93.7%,相比YOLO v7-tiny模型分别提升0.4、0.6个百分点。在上述2种改进策略共同作用下,模型平均精度均值获得进一步提升,达到94.4%;再添加ECA-Net模块后得到最终改进模型,平均精度均值达到94.6%,实现了检测精度的最大提升。

表1 消融试验结果

Tab.1 Results of ablation experiment

模型参数量浮点运算量模型内存占用量/MB推理速度/(f·s-1)精确率/%召回率/%mAP@0.5/%YOLO v7-tiny6.01×1061.30×101012.326291.387.093.1YOLO v7-tiny+SPDConv7.17×1061.78×101014.626293.086.193.5YOLO v7-tiny+VanillaBlock7.35×1061.41×101015.024692.886.693.7YOLO v7-tiny+SPDConv+VanillaBlock8.51×1061.89×101017.323992.487.494.4YOLO v7-tiny+SPDConv+VanillaBlock+ECANet8.74×1063.12×101017.823194.087.694.6

从表1中也可以看到,采用3种改进策略不同程度上增加了模型参数量、计算量和模型内存占用量,推理速度也有一些下降,但仍能够满足资源受限设备上部署需求。考虑到无人机航拍可见光图像进行玉米种质资源雄穗检测中面临的各种复杂现实情况,提升模型的检测精度相比降低参数量、计算量和模型内存占用量更为重要,改进后模型更适合玉米种质资源雄穗检测任务。

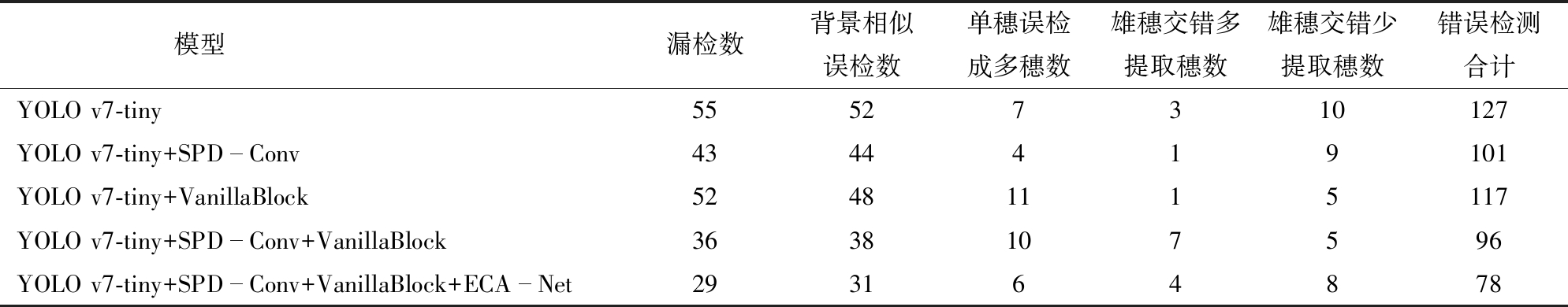

3.2 模型改进效果

为更直观展示模型改进前后的检测效果,从200幅测试集图像中随机选择50幅分析3种改进策略对雄穗检测错误的影响,50幅图像中雄穗共计884个。雄穗检测错误主要包括雄穗尤其是较小雄穗的漏检、与雄穗高度相似背景被误检为雄穗、雄穗形态结构丰富及被部分遮挡等导致将单个雄穗误检为多个,以及相互交错雄穗个数提取错误等方面,检测效果见表2。单独引入SPD-Conv模块,除对雄穗交错少提取穗数改善效果不明显外,对其他错误检测情况均有较大改善。单独引入VanillaBlock模块对相互交错情况下的雄穗提取效果突出,雄穗交错处雄穗提取错误由改进前的13个,减少为6个;漏检和误检情况相比单独引入SPD-Conv模块较多。同时引入SPD-Conv和VanillaBlock模块,总体错误检测情况得到进一步改善,尤其是对漏检和背景相似误检的改善效果明显。在3种改进策略的联合作用下,改进YOLO v7-tiny模型错误检测总数相比YOLO v7-tiny模型从127个减少到78个,减少38.58%;其中,对漏检和背景相似误检的改善非常明显,漏检数从55个减少到29个,误检数从52个减少到31个,相比改进前分别减少47.27%和40.38%;对单个雄穗误检为多个及雄穗交错导致的雄穗个数提取错误也有改善,错误数相比改进前分别减少14.29%和7.69%。

表2 不同改进策略检测效果对比

Tab.2 Comparison of detection effects of different improvement strategies

模型漏检数背景相似误检数单穗误检成多穗数雄穗交错多提取穗数雄穗交错少提取穗数错误检测合计YOLO v7-tiny55527310127YOLO v7-tiny+SPDConv4344419101YOLO v7-tiny+VanillaBlock52481115117YOLO v7-tiny+SPDConv+VanillaBlock3638107596YOLO v7-tiny+SPDConv+VanillaBlock+ECANet293164878

图6为模型改进前后对雄穗检测效果对比(漏检、背景相似误检及雄穗个数提取错误处分别用青色、紫色和红色圆圈标识)。从图6中可以看出,YOLO v7-tiny模型漏检雄穗11个、背景相似误检2处、雄穗个数提取错误4处;改进YOLO v7-tiny模型漏检雄穗 4个、背景相似误检为雄穗1处、雄穗个数提取错误2处。综合表2和图6可以看出,模型改进后,大幅度降低了雄穗尤其是较小雄穗的漏检、与雄穗高度相似背景被误检为雄穗情况的发生,单个雄穗误检为多个以及相互交错雄穗个数提取错误的情况也得到了改善,整体检测效果得到了提升。

图6 模型改进前后检测效果对比

Fig.6 Comparison of detection effects before and after model improvement

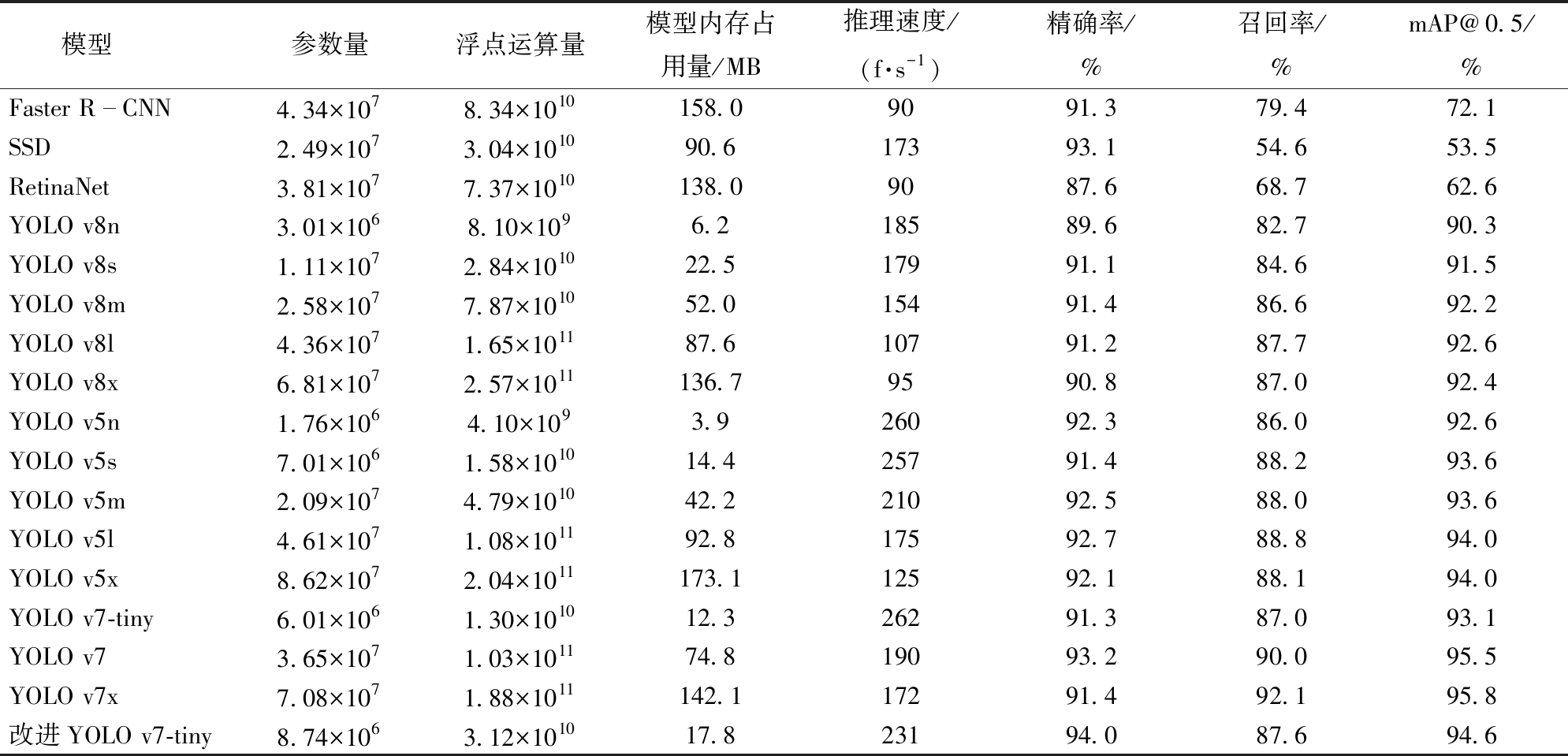

3.3 不同目标检测模型性能对比

为进一步评估改进YOLO v7-tiny模型对玉米种质资源雄穗的检测性能,与Faster R-CNN、SSD、RetinaNet和YOLO系列其他模型进行了对比试验,试验结果如表3所示。从表3可知,改进YOLO v7-tiny模型相比YOLO v8n、YOLO v8s、YOLO v5n、YOLO v5s、YOLO v7-tiny等轻量级模型具有最高的平均精度均值,分别高4.3、3.1、2.0、1.0、1.5个百分点;相比非轻量级模型,仅次于YOLO v7和YOLO v7x,分别低0.9、1.2个百分点,比YOLO v8x和YOLO v5x分别高2.2、0.6个百分点;相比非YOLO系列的Faster R-CNN、SSD和RetinaNet分别高22.5、41.1、32.0个百分点。表3所示模型中,参数量、计算量和模型内存占用量最优的是YOLO v5n,推理速度最快的是YOLO v7-tiny,改进YOLO v7-tiny相比部分轻量级模型在参数量、计算量、模型内存占用量或推理速度上虽然不具备优势,但在保持轻量化的同时具有最高的检测精度。综上,改进YOLO v7-tiny模型相比其他轻量级模型具有更强的特征提取能力,在检测精度上有较大优势,且满足资源受限设备上部署的需求,更适合玉米种质资源雄穗实时检测任务。

表3 不同模型检测性能对比

Tab.3 Comparison of detection performance of different models

模型参数量浮点运算量模型内存占用量/MB推理速度/(f·s-1)精确率/%召回率/%mAP@0.5/%Faster RCNN4.34×1078.34×1010158.09091.379.472.1SSD2.49×1073.04×101090.617393.154.653.5RetinaNet3.81×1077.37×1010138.09087.668.762.6YOLO v8n3.01×1068.10×1096.218589.682.790.3YOLO v8s1.11×1072.84×101022.517991.184.691.5YOLO v8m2.58×1077.87×101052.015491.486.692.2YOLO v8l4.36×1071.65×101187.610791.287.792.6YOLO v8x6.81×1072.57×1011136.79590.887.092.4YOLO v5n1.76×1064.10×1093.926092.386.092.6YOLO v5s7.01×1061.58×101014.425791.488.293.6YOLO v5m2.09×1074.79×101042.221092.588.093.6YOLO v5l4.61×1071.08×101192.817592.788.894.0YOLO v5x8.62×1072.04×1011173.112592.188.194.0YOLO v7-tiny6.01×1061.30×101012.326291.387.093.1YOLO v73.65×1071.03×101174.819093.290.095.5YOLO v7x7.08×1071.88×1011142.117291.492.195.8改进YOLO v7-tiny8.74×1063.12×101017.823194.087.694.6

同时,从表3也可以看出,YOLO系列最新版本的YOLO v8在玉米种质资源雄穗检测任务上的平均精度均值低于YOLO v7和YOLO v5,这表明YOLO系列模型高版本相比低版本在检测效果上并非对所有数据集都具备优势。张震等[30]对自然果园环境下苹果识别中同样出现了YOLO系列低版本模型的平均精度均值高于高版本模型的情况。综上,在目标检测任务中,需要根据具体数据集选择合适的目标检测模型。

4 结论

(1)针对玉米种质资源雄穗的多样性及无人机航拍图像用于目标检测任务客观上存在的复杂性,以YOLO v7-tiny为基础模型,通过引入SPD-Conv模块和VanillaBlock模块,并添加ECA-Net模块的方法,建立玉米种质资源雄穗检测模型,模型精确率为94.0%、召回率为87.6%、平均精度均值为94.6%,平均精度均值相比YOLO v7-tiny模型提升1.5个百分点,相比YOLO v8s、YOLO v5s模型分别高3.1、1.0个百分点。该方法有效增强了模型特征提取能力,提升了玉米种质资源雄穗的检测精度。

(2)从50幅测试集图像在不同改进策略下的检测结果的对比分析可知,SPD-Conv模块对漏检情况改善效果明显、VanillaBlock模块对相互交错下的雄穗提取效果突出,ECA-Net有效增强了图像特征提取能力。在本文3种改进策略的综合作用下,大幅度降低了雄穗漏检、相似背景被误检为雄穗以及单个雄穗误检为多个等情况的发生,对处于被遮挡和相互交错状态下的雄穗检测效果也有一定提升。

(3)改进模型内存占用量为17.8 MB,推理速度为231 f/s,相比YOLO v7-tiny及YOLO系列其他版本中轻量级模型,在少量损失模型内存占用量及推理速度的情况下,显著提升了雄穗检测精度。改进模型能够满足资源受限设备上的部署需求,为玉米种质资源雄穗实时、精准鉴定提供技术支撑。

[1] 李永祥,李会勇,扈光辉,等.玉米应用核心种质的构建与应用[J].植物遗传资源学报,2023,24(4): 911-916.LI Yongxiang,LI Huiyong,HU Guanghui, et al.Construction and utilization of applied core collection in maize[J]. Journal of Plant Genetic Resources,2023,24(4): 911-916.(in Chinese)

[2] 王晓鸣,邱丽娟,景蕊莲,等.作物种质资源表型性状鉴定评价:现状与趋势[J].植物遗传资源学报,2022,23(1):12-20.WANG Xiaoming,QIU Lijuan,JING Ruilian, et al. Evaluation on phenotypic traits of crop germplasm:status and development[J]. Journal of Plant Genetic Resources, 2022,23(1):12-20. (in Chinese)

[3] 温维亮,郭新宇,张颖,等.作物表型组大数据技术及装备发展研究[J].中国工程科学,2023,25(4):227-238.WEN Weiliang,GUO Xinyu,ZHANG Ying, et al. Technology and equipment of big data on crop phenomics[J]. Strategic Study of CAE, 2023,25(4):227-238. (in Chinese)

[4] 袁培森,薛铭家,熊迎军,等.基于无人机高通量植物表型大数据分析及应用研究综述[J].农业大数据学报,2021,3(3):62-75.YUAN Peisen,XUE Mingjia,XIONG Yingjun,et al. Analysis and application of high-throughput plant phenotypic big data collected from un-manned aerial vehicles[J].Journal of Agricultural Big Data,2021,3(3):62-75. (in Chinese)

[5] 程曼,袁洪波,蔡振江,等.田间作物高通量表型信息获取与分析技术研究进展[J].农业机械学报,2020,51(增刊1):314-324.CHENG Man,YUAN Hongbo,CAI Zhenjiang,et al. Review of field-based information acquisition and analysis of high-throughput phenotyping[J].Transactions of the Chinese Society for Agricultural Machinery,2020,51(Supp.1):314-324. (in Chinese)

[6] 徐胜勇,李磊,童辉,等.基于RGB-D相机的黄瓜苗3D表型高通量测量系统研究[J].农业机械学报,2023,54(7):204-213,281.XU Shengyong,LI Lei,TONG Hui, et al. High-throughput measurement system for 3D phenotype of cucumber seedlings using RGB-D camera[J]. Transactions of the Chinese Society for Agricultural Machinery,2023,54(7):204-213,281. (in Chinese)

[7] 向友珍,安嘉琪,赵笑,等.基于无人机多光谱遥感的大豆生长参数和产量估算[J].农业机械学报,2023,54(8):230-239.XIANG Youzhen,AN Jiaqi,ZHAO Xiao, et al. Soybean growth parameters and yield estimation based on UAV multispectral remote sensing[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(8):230-239. (in Chinese)

[8] AVNERI A, AHARON S, BROOK A, et al.UAS-based imaging for prediction of chickpea crop biophysical parameters and yield[J].Computers and Electronics in Agriculture, 2023, 205:107581.

[9] LIN Z,GUO W.Sorghum panicle detection and counting using unmanned aerial system images and deep learning[J].Frontiers in Plant Science, 2020, 11:534853.

[10] KIM D W, JEONG S J, LEE W S,et al.Growth monitoring of field-grown onion and garlic by CIE L*a*b* color space and region-based crop segmentation of UAV RGB images[J].Precision Agriculture, 2023, 24(5):1982-2001.

[11] 慕君林,马博,王云飞,等.基于深度学习的农作物病虫害检测算法综述[J].农业机械学报,2023,54(增刊2):301-313.MU Junlin,MA Bo,WANG Yunfei, et al.Review of crop disease and pest detection algorithms based on deep learning[J].Transactions of the Chinese Society for Agricultural Machinery,2023,54(Supp.2):301-313. (in Chinese)

[12] GAO C F, GUO W, YANG C H, et al.A fast and lightweight detection model for wheat fusarium head blight spikes in natural environments[J].Computers and Electronics in Agriculture, 2024, 216:108484.

[13] 胡松涛,翟瑞芳,王应华,等.基于多源数据的马铃薯植株表型参数提取[J].智慧农业(中英文),2023,5(1):132-145.HU Songtao, ZHAI Ruifang, WANG Yinghua, et al. Extraction of potato plant phenotypic parameters based on multi-source data[J]. Smart Agriculture, 2023, 5(1): 132-145. (in Chinese)

[14] 贾波,崔敏,谢庆春,等.基于SNP标记的玉米雄穗主要性状QTL定位分析[J].西南农业学报,2019,32(7):1469-1473.JIA Bo,CUI Min,XIE Qingchun, et al. QTL analysis of tassel traits based on SNP markers in maize[J]. Southwest China Journal of Agricultural Sciences,2019,32(7):1469-1473. (in Chinese)

[15] 杨蜀秦,刘江川,徐可可,等.基于改进CenterNet的玉米雄蕊无人机遥感图像识别[J].农业机械学报,2021,52(9):206-212.YANG Shuqin,LIU Jiangchuan,XU Keke, et al.Improved CenterNet based maize tassel recognition for UAV remote sensing image[J].Transactions of the Chinese Society for Agricultural Machinery,2021,52(9):206-212.(in Chinese)

[16] 张晓勐,朱德利,余茂生.无人机遥感图像中的玉米雄穗轻量化检测模型[J].江西农业大学学报, 2022,44(2):461-472.ZHANG Xiaomeng,ZHU Deli,YU Maosheng.Lightweight detection model of maize tassel in UAV remote sensing image[J].Acta Agriculturae Universitatis Jiangxiensis,2022,44(2):461-472.(in Chinese)

[17] LIU Y L,CEN C J,CHE Y P,et al.Detection of maize tassels from UAV RGB imagery with Faster R-CNN[J].Remote Sensing,2020, 12(2): 338.

[18] JIA Y J, FU K, LAN H, et al. Maize tassel detection with CA-YOLO for UAV images in complex field environments[J]. Computers and Electronics in Agriculture, 2024, 217: 108562.

[19] SONG C Y, ZHANG F, LI J S, et al.Detection of maize tassels for UAV remote sensing image with an improved YOLOX model[J].Journal of Integrative Agriculture,2023,22(6):1671-1683.

[20] REDMON J,DIVVALA S K,GIRSHICK R B,et al.You only look once: unified, real-time object detection[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016: 779-788.

[21] JOCHER G.YOLO v5 release v6[EB/OL].[2021-10-12].https:∥github.com/ultralytics/YOLO v5/releases.

[22] LI C Y,LI L L,JIANG H L,et al.YOLO v6:a single-stage object detection framework for industrial applications[EB/OL].[2022-09-07]. https:∥arxiv.org/abs/2209.02976.

[23] WANG C Y,BOCHKOVSKIY A,LIAO H Y M.YOLO v7:trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[EB/OL].[2022-07-06]. https: ∥arxiv.org/abs/2207.02696.

[24] JOCHER G.Ultralytics YOLO v8[EB/OL].[2023-01-11]. https:∥github.com/ultralytics/ultralytics.

[25] LIU S, QI L, QIN H F, et al.Path aggregation network for instance segmentation[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:8759-8768.

[26] LIN T Y, GIRSHICK R.Feature pyramid networks for object detection[C]∥ Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2017:936-944.

[27] SUNKARA R, LUO T. No more strided convolutions or pooling:a new CNN building block for low-resolution images and small objects[C]∥European Conference on Machine Learning and Principles and Practice of Knowledge Discovery in Databases,2022: 443-459.

[28] CHEN H T,WANG Y H,GUO J Y,et al.VanillaNet: the power of minimalism in deep learning[EB/OL].[2023-05-22]. https:∥arxiv.org/abs/2305.12972.

[29] WANG Q L, WU B G, ZHU P F, et al. ECA-Net:efficient channel attention for deep convolutional neural networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2020:11531-11539.

[30] 张震,周俊,江自真,等.基于改进YOLO v7轻量化模型的自然果园环境下苹果识别方法[J].农业机械学报,2024,55(3):231-242,262ZHANG Zhen, ZHOU Jun,JIANG Zizhen, et al. Lightweight apple recognition method in natural orchard environment based on improved YOLO v7 model[J]. Transactions of the Chinese Society for Agricultural Machinery,2024,55(3):231-242,262.(in Chinese)