0 引言

我国是世界上最大的山羊奶生产和消费国,羊奶产量占世界的46.1%以上[1-2]。传统养殖中缺乏对奶山羊生长过程和孕期健康状况的有效监测手段,存在山羊奶品质较低、有效营养成分不足等问题[3]。及时获取奶山羊的各项生理指标有助于管理者进行养殖方案调整,有助于适配不同生长阶段奶山羊生长需求[4-5]。其中,体温作为判断奶山羊生理状态和健康状况的重要指标,有助于提升奶山羊处于疾病、发情或其他极端情况时的防护水平[6-7]。传统的侵入式兽用直肠温度计等无法连续、长期观测奶山羊体温[8-9],且易导致应激反应及动物伤害[10],严重时可能会导致产奶量下降[11]。如何选择奶山羊关键测温部位并实现奶山羊体温的非侵入式测量,具有重要研究意义[12-13]。

热红外相机是目前使用最为广泛的动物体温测量装置之一[14]。刘刚等[15]提出了一种基于改进YOLO v4的生猪耳根温度检测方法,对生猪关键部位检测精度为95.71%,检测速度为60.21 f/s,可以满足生猪关键部位定位和温度实时检测的需求。CUTHBERTSON等[16]开发了一种使用红外热成像技术进行奶牛体温检测的方法,该方法通过架设在不同位置的3台热红外相机准确捕捉牛眼温度,通过滚动中值和99百分位数来处理数据并计算躯干温度。经测试,其中第97和99分位数的平滑最大值与被测动物直肠核心温度的相关性最高。沈明霞等[17]提出了一种红外热成像技术和深度学习相结合的肉鸡体温检测模型,可以快速、准确地检测肉鸡体温,试验结果表明,该模型在测试集上的查准率和查全率分别为96.77%和100%,基于多元线性回归和BP神经网络的反演模型平均相对误差分别为0.33%和0.29%。POLAT等[18]使用热红外成像技术检测体温变化判断奶牛是否患有乳房炎,经过测试发现,基于热红外图像的乳房炎判断方式和一般临床上的加州乳腺炎检测方法的准确性误差为3%左右。为实现生猪体温非接触式自动监测,肖德琴等[19]提出了一种基于热红外图像的生猪耳温自动提取算法,经过测试其对猪只耳部区域温度的检测准确率为97.6%,单帧图像的平均检测时间为12 ms,表明所提出的体温提取算法具有较好的可靠性和可行性。

与生猪群体相比,奶山羊体表覆盖有皮毛[20],会影响温度测量准确性,适合奶山羊测温部位为眼、嘴、肛门、阴道和乳房。与奶山羊其他部位相比,乳房部位通常来说毛皮覆盖率较低,测温结果稳定,是目前最具代表性的测温部位[21]。本研究借助YOLO v5s模型所具备的高检测速度和精度优势[22],通过加入轻量化网络结构和注意力机制,提出一种针对奶山羊乳房部位目标提取方法,在降低输入图像质量要求的同时,实现奶山羊乳房关键部位检测,以期为奶山羊非接触式温度测量提供依据,并为奶山羊非接触式体温监测系统设计奠定基础。

1 数据采集及处理

1.1 数据采集

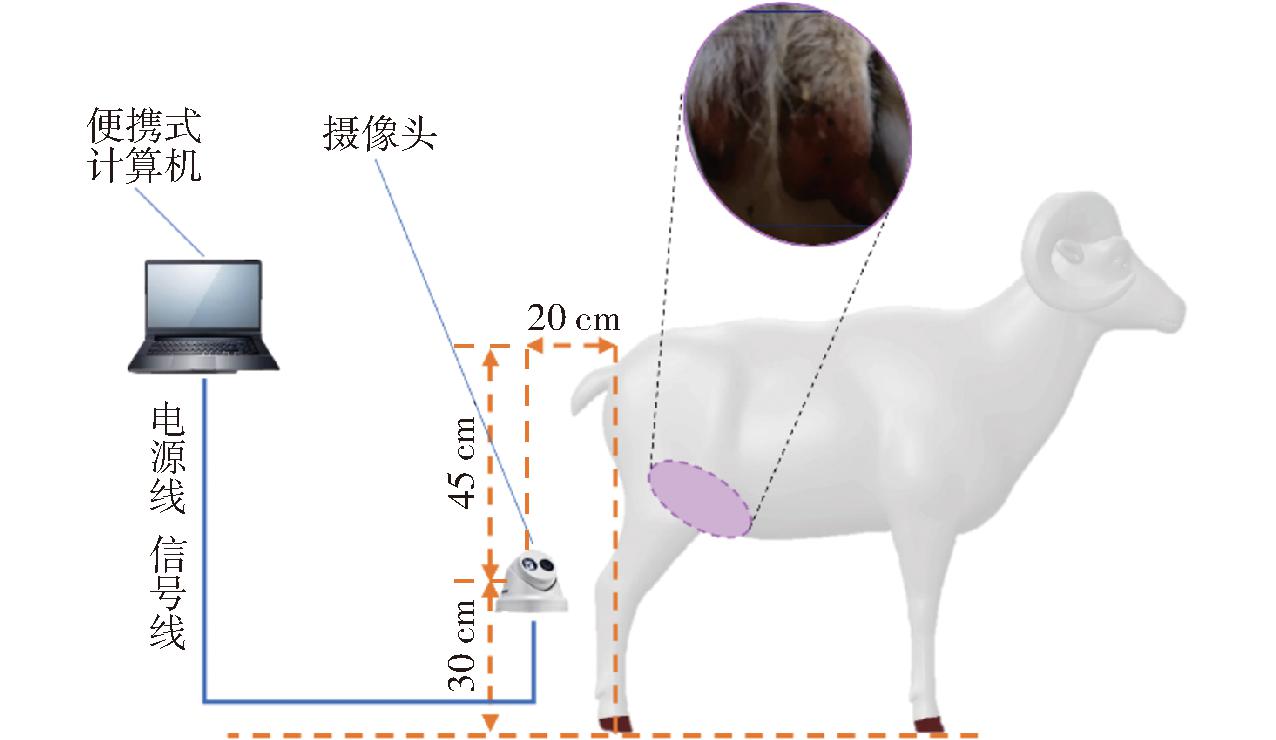

研究对象来自于陕西省杨陵区西北农林科技大学畜牧试验基地,数据采集对象为萨能奶山羊,选取生理年龄在2~3岁并已受孕2个月以上的53头奶山羊进行数据采集。数据采集于2023年1—5月,采集时间均为08:00—11:00。数据采集设备为海康威视公司热成像双光谱半球型网络摄像机,产品型号为DS-2TD1216B-3/PA,通过热成像双光谱半球型网络摄像机采集热红外视频,设备热成像镜头焦距为3 mm,拍摄帧率为25 f/s,测温范围为-20~150℃,测温精度为0.1℃,反射温度为20℃,外部光学传输为1,大气温度为16~25℃,相对湿度为50%,红外拍摄分辨率为1 280像素×720像素,拍摄获得的图像视频保存为mp4格式。基于热红外设备的非接触测温方式,其测温结果与被测部位发射率有关,实验研究表明,毛发通常具有较低的热辐射发射率,因此在热辐射过程中能够更多地保留热能。而皮肤热辐射发射率较高,能够更有效地散发热能[23]。而奶山羊身躯大部分受毛发覆盖,不利于热红外摄像头对发散热辐射的捕获,因此,在对奶山羊乳房关键部位数据采集时,参考BYRNE等[24]采集奶牛乳房部位热红外图像时的设置,将热红外摄像机反射率参数设置为0.98。在实际拍摄过程中,搭配相关软件IVMS-4200与IVMS-4800进行热红外视频的拍摄、存储与温度检测。同时,为了消除设备使用时可能存在的测温精度误差,在热红外图像数据采集前,通过发射率为1的参考黑体在相同环境条件下对设备进行了温度校正,以确保设备使用过程中符合测温精度规范。实际数据采集过程如图1所示,将热红外摄像机通过数据线与便携式计算机相连接,并在计算机端将摄像头与相关软件完成硬件绑定后,打开热红外检测仪的热红外摄像头。采集人员携带设备位于被固定的羊身后,距离羊只约20 cm处,采集人手持采集设备在离地面约30 cm高度向斜上方拍摄,开启屏幕录制后,通过计算机端显示的实时画面对热红外摄像机进行调整,直至奶山羊乳房部位完整置于热红外成像仪监视画面中心,待画面稳定并继续拍摄约3 s后,完成奶山羊乳房关键部位和体温数据采集。除此之外,测温结果受距离影响会有一定误差,考虑到本研究数据采集距离较近(20 cm),远小于热辐射强度衰减距离(1.5 m),因此在数据处理时忽略距离因素对结果的影响[25]。

图1 数据采集现场示意图

Fig.1 Data acquisition scene diagram

1.2 数据处理

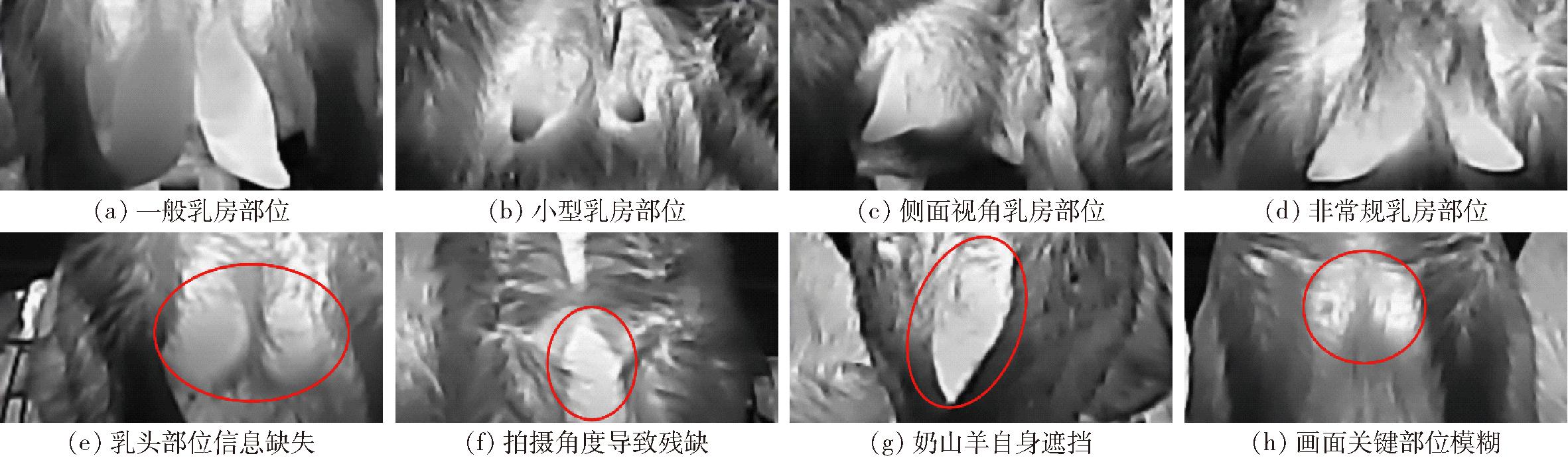

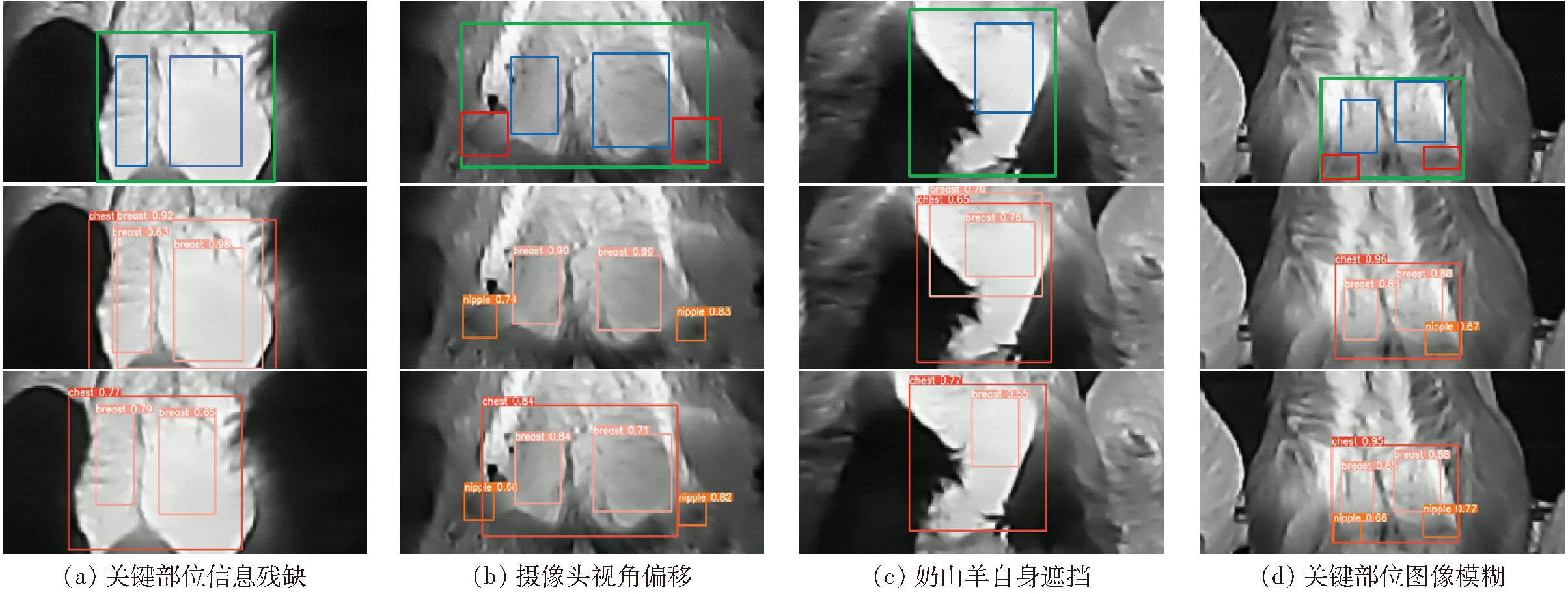

本研究共采集53头奶山羊的乳房红外信息图像4 611幅,部分奶山羊乳房关键部位热红外图像如图2a~2d所示。由于动物身躯毛皮厚度会导致采集到的动物温度不同,所以针对所采集图像包含的不同部分,通过软件LabelImg将图像划分为整个乳房部位、无毛皮肤裸露部位和乳头3部分,分别标记为“chest”、“breast”和“nipple”。将标注好的数据集按照7∶2∶1划分为训练集、验证集与测试集,分别包含3 204、954、453幅图像,均为YOLO格式数据集。

图2 部分数据效果示例

Fig.2 Part of data effect

受拍摄角度及奶山羊频繁移动的影响,部分图像数据难以包含所有部位信息,同时,受热红外摄像机本身低像素和低分辨率影响,获取的图像存在视野狭窄、图像模糊、有效信息不足、图像质量较差等问题。如图2e~2h红色标记区域的奶山羊乳房关键部位所示,所采集得到的热红外图像存在关键部位信息残缺不全、拍摄视野狭窄导致的部位残缺、被奶山羊其他部位严重遮挡以及关键部位画面模糊等问题,对检测网络关键部位识别任务提出了极大挑战。

在数据集制作时,保留了部分质量一般图像和劣质图像,并将不同品质的图像进行统计,其中训练集中包含完整信息图像2 100幅,关键部位残缺不全图像753幅,画面模糊图像351幅。为探究网络模型鲁棒性,在验证集和测试集中也放入部分劣质图像。其中,训练集、验证集与测试集中包含的图像分别选自不同的奶山羊个体,以消除同种个体数据对网络训练结果的影响。经统计,训练集中包含完整信息图像2 100幅,关键部位残缺不全图像753幅,画面模糊图像351幅。验证集中包含完整信息图像611幅,关键部位残缺不全图像268幅,画面模糊图像75幅。测试集中包含完整信息图像262幅,关键部位残缺不全图像154幅,画面模糊图像37幅。

1.3 实验平台

数据采集平台与实验平台均为Windows 10操作系统,模型训练环节所使用的处理器为13th Gen Intel(R) Core(TM) i5-13600KF @ 3.50 GHz,内存为32 GB,显卡型号为NVIDIA GeForce RTX 4070Ti,使用PyTorch框架、PyCharm编辑器、Python编程语言进行模型训练。训练网络所用数据集均为实验室采集制作的奶山羊乳房热红外图像数据集,批量大小(Batchsize)设置为128,迭代次数(Epoch)设置为200,学习率设置为0.01。

2 研究方法与网络模型

2.1 改进YOLO v5系列模型结构

YOLO (You only look once)网络结构模型在目标检测和语义分割等方面有着良好的性能表现[26-27]。最新的YOLO v8网络在检测精度和速度上有了进一步提升。但是,YOLO v8模型更大且占用较大的计算资源与储存空间,这使得该网络模型更难在一般的嵌入式设备和移动式设备上迁移使用。同时,受制于更多的模型参数,该模型结构的检测速度较慢,在训练时占用的训练时间更多。在同系列的网络结构中,YOLO v5系列结构网络在参数更少的同时,可以兼顾检测精度和检测速度,更适合奶山羊乳房关键部位热红外检测的实际需求。YOLO v5s网络结构包括Input、Backbone、Neck 和Prediction 4部分。其中,Input层用于接收输入图像;Backbone部分主要采用CSPDarknet网络结构,用于完成输入图像的初步特征提取;Neck接收上一部分提取的图像特征,输入特征金字塔网络(Feature pyramid networks,FPN)结构[28],从而进一步加强图像特征的提取,并且不同层提取到的特征信息在其中进行不同程度的聚合,进一步获得更多的目标特征。经过上2个层后的输入图像已经分解为具有固定宽高和通道数的特征点,这些特征点被输入网络的Head部分,按照任务要求完成目标分类或回归操作。

为了保证原有模型在目标检测中的性能,并在减少网络模型参数的同时提升网络在奶山羊乳房关键部位的检测精度,本研究以YOLO v5s框架为基础进行了结构改进。将原模型中Backbone网络的部分卷积模块替换为ShuffleNetV2结构,用于降低网络部署和训练过程中的参数量,实现轻量化网络设计。在Neck网络检测头引入注意力机制CBAM结构,在降低网络复杂程度的同时,保证奶山羊关键部位检测精度。改进后的网络结构如图3所示。

图3 改进YOLO v5网络结构示意图

Fig.3 Improved YOLO v5 network structure diagram

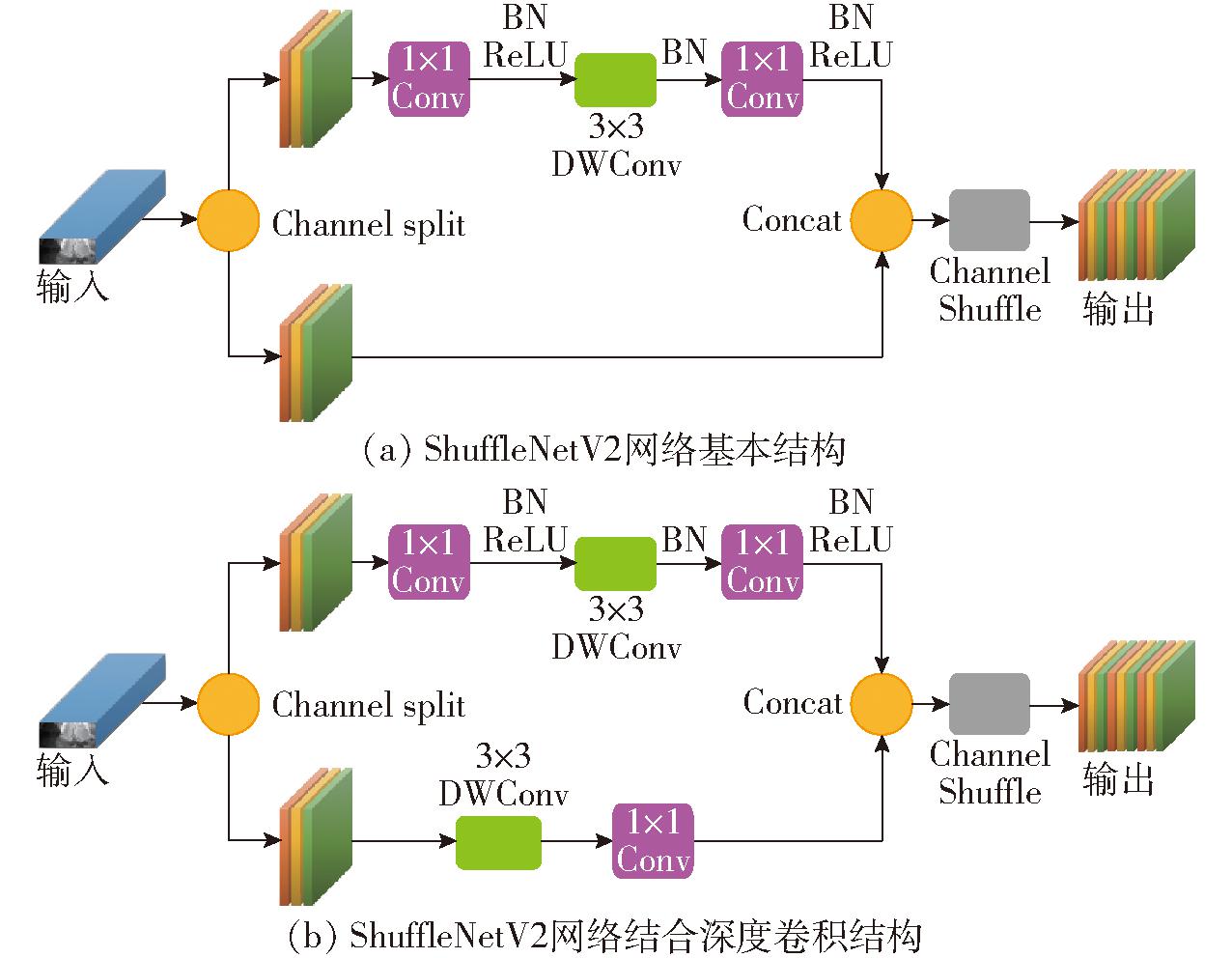

2.2 ShuffleNetV2轻量模型

在实际深度网络模型训练中,模型网络复杂程度是重要的参考指标。通常,网络复杂度越高则训练模型所需要时间越长,同时,大量的网络层级结构和参数会影响目标检测速度。由于原模型网络结构较大,本研究将ShuffleNetV2结构引入网络主干部分,降低了图像提取特征层网络参数量。MA等[29]在详细分析了ShuffleNet和MobileNet系列网络的结构问题后,在其基础上改进得到ShuffleNetV2网络结构,该结构优点如下:①ShuffleNetV1采用大量Bottleneck Layer结构,使得这些层的输入和输出通道数不同,导致网络训练中的内存使用量大幅增加,降低了训练速度。②ShuffleNetV1网络大量使用1×1组卷积,而分组过多会增加设备内存的使用量。③部分网络模块如Inception结构等大多选择采用“多路”结构,即在一个模块中堆叠大量不同的小卷积层和池化层,这样的网络碎片化结构会降低模型的并行度,使网络检测速度变慢。④ShuffleNetV2移除了ResNet残差单元中需要较大内存使用量的ReLU和shortcut,显著提升了网络速度。

如图4所示,为了改善ShuffleNetV1的缺陷,ShuffleNetV2版本引入Channel Split运算。具体来说,输入的特征图在通道维度分成2个分支,左边分支做同等映射,右边分支包含3个连续卷积,并且输入和输出通道相同,且2个1×1卷积不再是组卷积,这2个分支已被分成2组。对2个分支的输出结果进行Concat操作,并对2个分支Concat结果进行Channel Shuffle以保证2个分支信息融合。在同等条件下,ShuffleNetV2网络相比其他模型速度更快,且未损失已有的检测准确度。

图4 ShuffleNetV2框架结构示意图

Fig.4 ShuffleNetV2 frame structure diagrams

2.3 CBAM注意力机制

在网络实际训练中,输入的训练图像中存在着任务目标的同时也包含着其他噪声。在对输入图像进行处理时,结构网络对需要注意的识别目标所在区域进行更多关注,从而完成干扰条件下对目标是否存在或目标准确位置的准确判断。本研究在网络Head前端引入注意力机制CBAM结构,用于加强对奶山羊乳房关键目标部位的特征提取能力。

注意力机制有多种实现形式,本实验采用由WOO等[30]提出的CBAM注意力机制。与其他注意力机制相比,CBAM注意力机制将通道注意力机制和空间注意力机制进行结合,可以有效地捕捉输入图像中的区域相关性,提升图像特征的表达能力。如图5所示,通道注意力机制将特征图在空间维度上压缩成一维矢量。通过平均值池化和最大值池化来进行压缩,可以聚合特征映射的空间信息,并输入共享网络,压缩输入特征图的空间维数,逐元素求和合并以产生通道注意力特征图。空间注意力机制是对图像的通道数进行压缩,在通道维度层面分别进行了平均值池化和最大值池化。将池化后的结果和前面所提取到的特征图(通道数均为1)合并得到一个2通道的特征图。综合来看,CBAM将通道注意力机制和空间注意力机制进行了结合,与仅使用一种注意力机制相比,其在网络训练中关键目标的特征提取中有更强的效果。添加CBAM之后,卷积网络上层输出的结果会先通过通道注意力模块与原输入加权后,再经过空间注意力模块与原加权结果再一次进行加权而得到最终结果。

图5 注意力机制CBAM结构示意图

Fig.5 CBAM structure diagrams of attention mechanism

2.4 网络评价指标

为评价改进网络性能,采用精确率(Precision,P)、召回率(Recall,R)、平均精度均值(Mean average precision,mAP)、参数量(Params)、浮点运算量(Floating point operations,FLOPs)共5个指标对模型进行评价。

同时,在对网络检测效果通过1.2节测试集进行试验时,由于热红外图像质量不高且图像中关键目标形状相似,故在测试中多次调节结构参数以避免关键目标部位重复检测。经实验,当将改进网络预测框置信度(Confidence)阈值设置为0.50、预测框与真实框交并比(Intersection over union, IoU)阈值设置为0.45时,可有效解决上述问题。在后续通过相同测试集对其他网络进行结果对比实验时,也进行相同参数设置。

3 结果与讨论

3.1 网络训练结果与效果

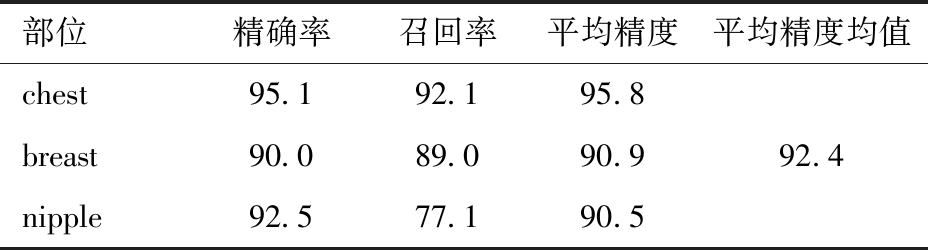

所使用网络经过200轮次训练后,该网络精确率为93.7%,召回率为86.1%,平均精度均值为92.4%,参数量为8×105,浮点运算量为1.9×109。同时,由表1可以看出,由奶山羊乳房各不同部位的训练检测结果可以看出,在参与训练的奶山羊乳房的不同部位中,整个乳房部位检测准确率最高,乳房下部的无毛部分和乳头部位的检测准确率均在90%以上,符合实际使用中的检测精度要求。

表1 奶山羊乳房各部位检测结果

Tab.1 Detection results of various parts of milk goat udder %

部位精确率召回率平均精度平均精度均值chest95.192.195.8breast90.089.090.992.4nipple92.577.190.5

为了检测经过训练后的网络在实际目标检测中的应用效果,使用在同一时间和不同时间与训练数据同时采集且未输入网络中进行训练的奶山羊乳房图像数据进行测试,部分检测结果如图6所示,图中第1行为模型测试所使用的部分输入图像,这些图像包含信息残缺、视角偏移、关键部位遮挡和图像模糊等情况,正确的标记区域由不同颜色的方框标出,其中,绿色方框表示标签chest,蓝色方框表示标签breast,红色方框表示标签nipple。第2行为YOLO v5s网络检测奶山羊关键部位的效果,第3行为改进YOLO v5s网络检测奶山羊关键部位的效果。相对相机位置端正、目标位置清晰的图像数据而言,该网络有最好的检测效果。由图6可知,改进网络对摄像头视角偏移、图像关键部位残缺、奶山羊自身部位遮挡和图像模糊等情况有更好的检测效果。其中,目标部位由检测框标出,检测框左上方显示检测类别与检测结果置信度。

图6 改进网络检测效果

Fig.6 Improved network detection effect

同时,为了在训练中使检测网络随时对网络的训练过程进行修正,模型使用损失函数来计算预测信息和真实信息的距离,并通过反向传播更新部分训练参数,来降低真实值与预测值之间的距离,使得模型生成的预测值逐渐贴近真实值,从而达到提升精度的目的。YOLO v5s采用的损失函数L计算公式为

L=aLobj+bLrect+cLclc

(1)

式中 Lobj——置信度损失函数

Lrect——边界框损失函数

Lclc——分类损失函数

a——置信度损失函数计算权重

b——边界框损失函数计算权重

c——分类损失函数计算权重

从式(1)中可以看出,网络模型的损失函数包含置信度损失值、边界框损失值和分类损失值。其中,矩形框损失值通过CIOU loss计算,置信度损失值与分类损失值均用BCE loss计算。训练中a、b、c分别设置为0.4、0.3和0.3。

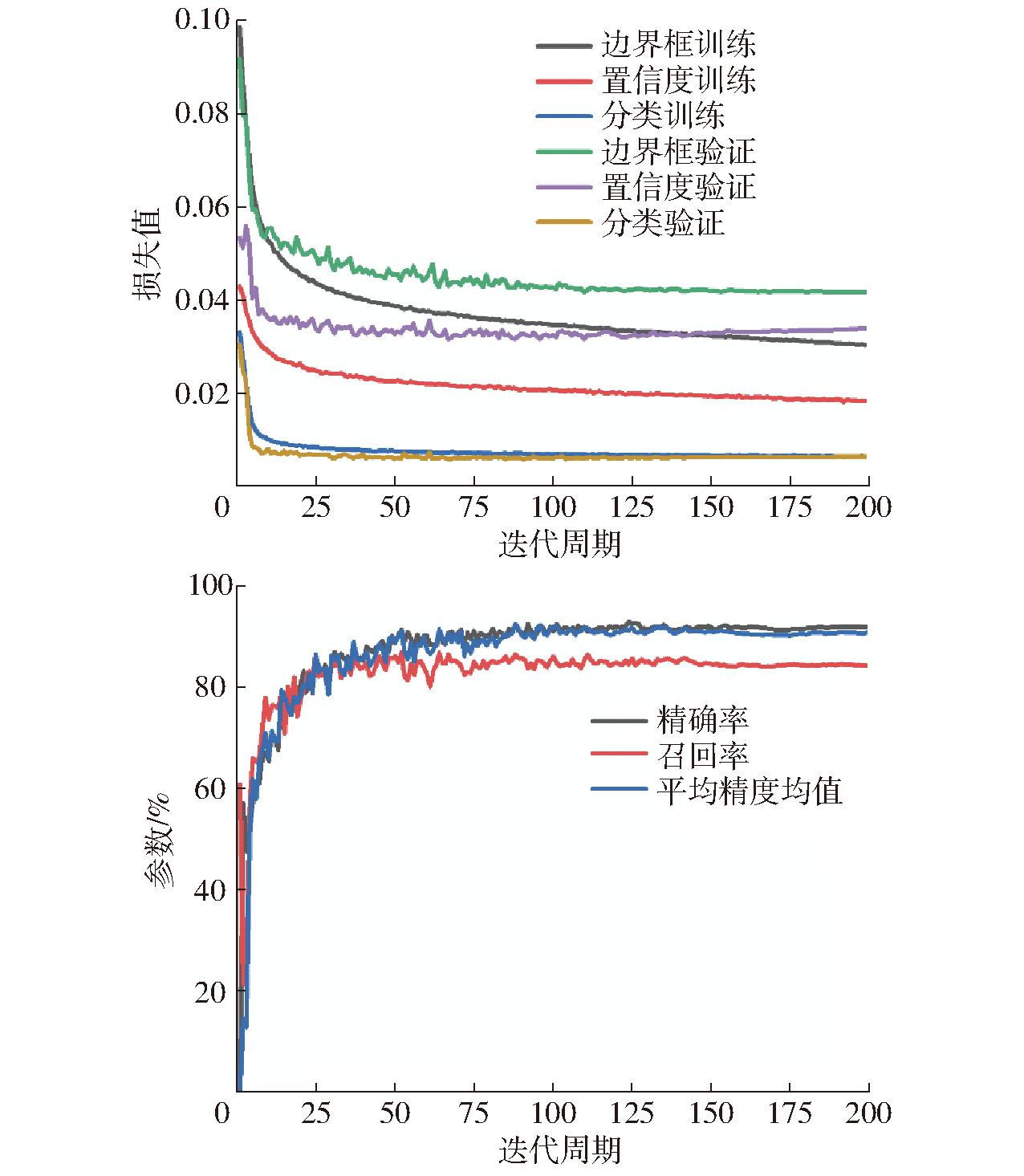

该网络训练时性能曲线如图7所示,可见网络训练过程中精确率、召回率和平均精度均值等指标逐渐提升,并在第100个迭代周期之后逐渐趋于稳定。

图7 改进网络性能变化曲线

Fig.7 Improved network performance variation curves

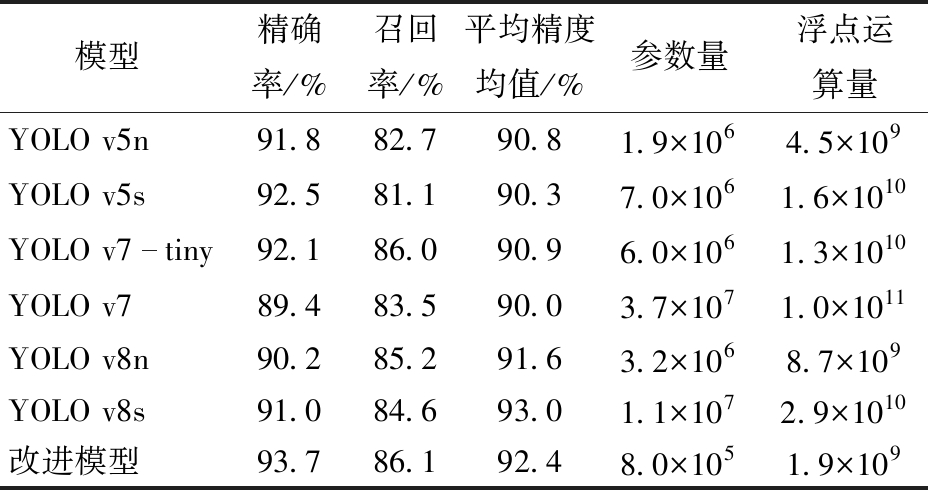

3.2 不同算法检测效果比较

3.2.1 检测网络结果比较

为评价改进网络对奶山羊乳房关键部位的检测效果,本研究在相同数据集上对YOLO v5n、YOLO v5s、YOLO v7-tiny、YOLO v7、YOLO v8n和YOLO v8s网络进行训练,在相同训练条件下,结果如表2所示。由表2可知,改进模型在精确率、召回率和平均精度均值等指标上均有一定程度的提升,且显著降低了网络参数量和浮点运算量。其中,改进模型的参数量分别比YOLO v5n、YOLO v5s、YOLO v7-tiny、YOLO v7、YOLO v8n和YOLO v8s降低57.9%、88.6%、86.7%、97.8%、75.0%和92.9%,浮点运算量分别降低57.8%、87.9%、85.6%、98.2%、78.2%和93.4%。改进模型在未损失检测精度和精确率的基础上显著降低了模型参数量和浮点运算量,更易于网络模型迁移部署。

表2 不同框架模型检测效果

Tab.2 Different frame model detection effect

模型精确率/%召回率/%平均精度均值/%参数量浮点运算量YOLO v5n91.882.790.81.9×1064.5×109YOLO v5s92.581.190.37.0×1061.6×1010YOLO v7tiny92.186.090.96.0×1061.3×1010YOLO v789.483.590.03.7×1071.0×1011YOLO v8n90.285.291.63.2×1068.7×109YOLO v8s91.084.693.01.1×1072.9×1010改进模型93.786.192.48.0×1051.9×109

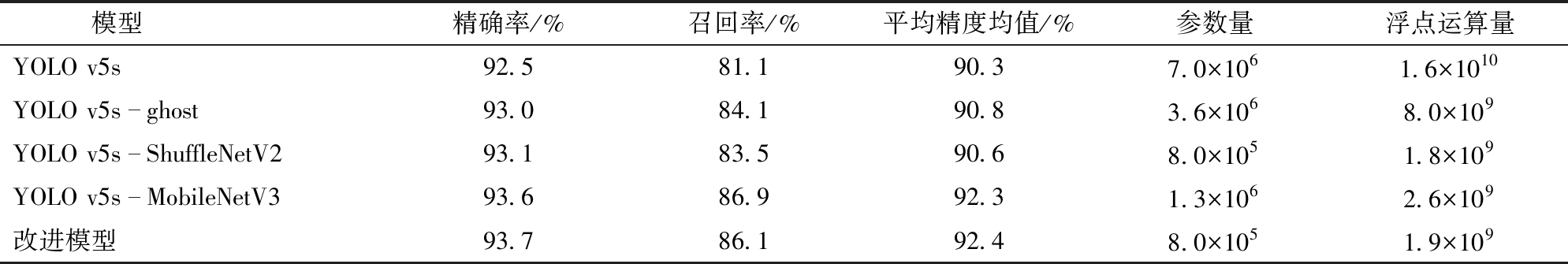

3.2.2 轻量化模块对网络模型的影响

轻量化网络结构可有效降低模型内存占用量,在网络不同平台运行及迁移具有显著优势。为了探究不同轻量结构模块对网络模型的影响,对ghost、ShuffleNetV2、MobileNetV3、轻量化网络结构进行了对比实验。分别添加上述轻量化模块并构建相同结构的模型,同时利用相同训练图像采用改进模型进行试验,并使用相同测试集评估不同改进模型算法的性能,测试结果如表3所示。

表3 不同轻量化模块对网络模型的影响

Tab.3 Influence of different lightweight modules

模型精确率/%召回率/%平均精度均值/%参数量浮点运算量YOLO v5s92.581.190.37.0×1061.6×1010YOLO v5sghost93.084.190.83.6×1068.0×109YOLO v5sShuffleNetV293.183.590.68.0×1051.8×109YOLO v5sMobileNetV393.686.992.31.3×1062.6×109改进模型93.786.192.48.0×1051.9×109

由表3可知,改进网络模型在奶山羊乳房关键部位检测精确率为93.7%,召回率为86.1%,平均精度均值为92.4%,模型参数量为8.0×105,浮点运算量为1.9×109。与其他对比模型相比,改进模型在保证检测精度和有效性的前提下具有最少的参数量和运算量,显著提升了模型性能。

3.2.3 注意力机制对网络模型的影响

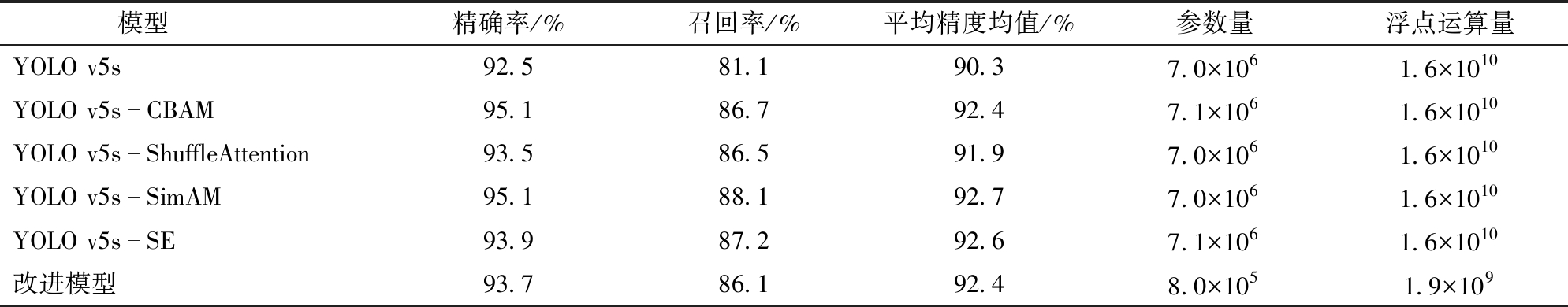

注意力机制可以有效地加强网络对任务目标的识别能力,为了探究不同注意力机制模块对网络模型的影响,对CBAM、ShuffleAttention、SimAM、SE注意力机制模块进行对比实验。分别添加CBAM、ShuffleAttention、SimAM、SE注意力机制构建相同结构的模型,并与改进模型利用相同训练图像进行实验,迭代周期设置为200,使用相同测试集评估不同改进模型性能,测试结果如表4所示。

表4 不同注意力模块对网络模型的影响

Tab.4 Influence of different attention modules on network model

模型精确率/%召回率/%平均精度均值/%参数量浮点运算量YOLO v5s92.581.190.37.0×1061.6×1010YOLO v5sCBAM95.186.792.47.1×1061.6×1010YOLO v5sShuffleAttention93.586.591.97.0×1061.6×1010YOLO v5sSimAM95.188.192.77.0×1061.6×1010YOLO v5sSE93.987.292.67.1×1061.6×1010改进模型93.786.192.48.0×1051.9×109

由表4可见,改进模型在检测精度上具有良好的性能,精确率为93.7%,召回率为86.1%,平均精度均值为92.4%,模型权重、模型参数量和浮点运算量无明显变化。该测试结果表明,添加注意力机制可以在不显著改变模型权重、模型参数量和模型计算量的同时提升模型精度,其中,改进模型在未损失太多精度情况下显著降低模型参数量和浮点运算量,性能提升明显。

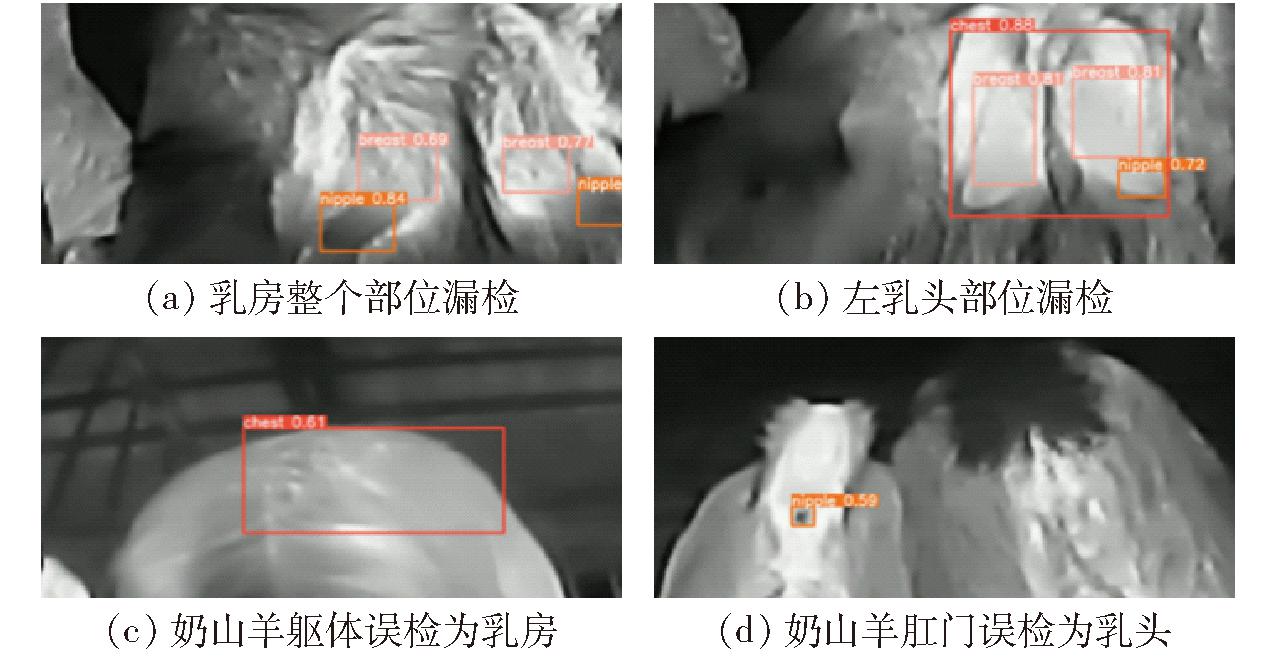

3.3 网络模型漏检误检情况讨论

3.3.1 漏检

如图8所示,在输入图像存在部分极端情况时,目标检测网络输出结果可能会出现漏检。如图8a所示,模型存在无法正确定位检测整个乳房区域的问题,如图8b所示检测结果存在部分部位漏检现象。经分析可能原因如下:①热红外设备成像精度普遍偏低,低质量图像会对检测精度造成一定影响,随着图像分辨率的降低,精度也随之下降,导致漏检。②拍摄设备或奶山羊本身高速移动导致图像目标边沿模糊,模型无法正确识别边缘信息,造成漏检现象。③由于清洁不到位奶山羊乳房部位附着泥污,导致该部位温度信息不全或缺失,使检测过程中难以提取关键点信息造成个别部位漏检。

图8 网络漏检误检情况示例

Fig.8 Examples of network missing and false detection

3.3.2 误检

如图8所示,在输入图像存在部分与目标部位高度相似时,目标检测网络的输出结果可能会出现误检情况。如图8c所示,模型将奶山羊躯体部位误检为乳房部位。图8d将奶山羊肛门部位误检为乳头部位。经分析可能原因如下:①当图像中奶山羊乳房部位关键特征较少而与奶山羊其他部位(如躯体)呈现大面积的相似特征,会对检测精度造成一定影响,图像中相似特征部位面积增大,导致网络出现误判。②当奶山羊其他身体部位与乳房部位特征相似时,网络无法做出有效辨别,如奶山羊肛门部位出现时会出现误检情况。

4 结论

(1)在YOLO v5s目标检测模型的基础上,结合轻量化结构ShuffleNetV2和注意力机制CBAM,提出了一种改进的奶山羊乳房关键部位检测模型,改进后网络模型精确率为93.7%,召回率为86.1%,平均精度均值为92.4%,参数量为8.0×105,浮点运算量为1.9×109,表明其可以完成高准确率的奶山羊乳房区域检测任务。

(2)改进模型在热红外成像设备位于特定的角度拍摄时可以高精度完成任务目标的检测,在部分极端情况、图像质量不高时仍然可以完成任务目标的检测。

(3)对比分析结果表明,本文模型能够在保证奶山羊乳房目标关键部位检测精度的同时,有效降低检测模型浮点运算量和参数量,更有利于模型实现在不同环境下的迁移部署。

[1] PULINA G, MILAN M J, LAVIN M P, et al. Invited review: current production trends, farm structures, and economics of the dairy sheep and goat sectors[J]. Journal of Dairy Science, 2018, 101(8): 6715-6729.

[2] OLIVER S P, MURINDA S E. Milk and raw milk consumption as a vector for human disease[M]. Zoonotic Pathogens in the Food Chain, 2011.

[3] QUIGLEY L, O’SULLIVAN O, STANTON C, et al. The complex microbiota of raw milk[J]. FEMS Microbiology Reviews, 2013, 37(5): 664-698.

[4] 张宏鸣,孙扬,赵春平,等. 反刍家畜典型行为监测与生理状况识别方法研究综述[J]. 农业机械学报,2023,54(3):1-21.ZHANG Hongming, SUN Yang, ZHAO Chunping, et al. Review on typical behavior monitoring and physiological condition identification methods for ruminant livestock[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(3):1-21. (in Chinese)

[5] ALSAAOD M, SCHAEFER A L, BUSCHER W, et al. The role of infrared thermography as a non-invasive tool for the detection of lameness in cattle[J]. Sensors, 2015, 15(6): 14513-14525.

[6] 何东健, 宋子琪. 基于热红外成像与骨架树模型的奶牛眼温自动检测[J]. 农业机械学报, 2021, 52(3): 243-250.HE Dongjian, SONG Ziqi. Automatic detection of dairy cow’s eye temperature based on thermal infrared imaging technology and skeleton tree model[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(3): 243-250.(in Chinese)

[7] KEARTON T R, DOUGHTY A K, MORTON C L, et al. Core and peripheral site measurement of body temperature in short wool sheep[J]. Journal of Thermal Biology, 2020, 90: 102606.

[8] KIM H, MIN Y, CHOI B. Real-time temperature monitoring for the early detection of mastitis in dairy cattle: methods and case researches[J]. Computers and Electronics in Agriculture, 2019, 162: 119-125.

[9] REY B, FULLER A, HETEM R S, et al. Microchip transponder thermometry for monitoring core body temperature of antelope during capture[J]. Journal of Thermal Biology, 2016, 55: 47-53.

[10] 张磊, 董茹月, 侯宇,等. 奶牛体温评价指标及测定方法研究进展[J]. 动物营养学报, 2020, 32(2): 548-557.ZHANG Lei, DONG Ruyue, HOU Yu, et al. Research progress on evaluation indices and measurements of body temperature in dairy cows[J]. Chinese Journal of Animal Nutrition, 2020, 32(2): 548-557.(in Chinese)

[11] MCMANUS C, TANURE C B, PERIPOLLI V, et al. Infrared thermography in animal production: an overview[J]. Computers and Electronics in Agriculture, 2016, 123: 10-16.

[12] GEORGE W D, GODFREY R W, KETRING R C, et al. Relationship among eye and muzzle temperatures measured using digital infrared thermal imaging and vaginal and rectal temperatures in hair sheep and cattle[J]. Journal of Animal Science, 2014, 92(11): 4949-4955.

[13] VIGUIER C, ARORA S, GILMARTIN N, et al. Mastitis detection: current trends and future perspectives[J]. Trends in Biotechnology, 2009, 27(8): 486-493.

[14] ROBERTO J V B, SOUZA B B D, FURTADO D A, et al. Thermal gradients and physiological responses of goats in the semiarid of Brazil using infrared thermography[J]. Journal of Animal Behaviour &Biometeorology, 2014, 2(1): 11-19.

[15] 刘刚, 冯彦坤, 康熙. 基于改进YOLO v4的生猪耳根温度热红外视频检测方法[J]. 农业机械学报, 2023, 54(2): 240-248.LIU Gang, FENG Yankun, KANG Xi. Detection method of pig ear root temperature based on improved YOLO v4[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(2): 240-248.(in Chinese)

[16] CUTHBERTSON H, TARR G, GONZALEZ L A. Methodology for data processing and analysis techniques of infrared video thermography used to measure cattle temperature in real time[J]. Computers and Electronics in Agriculture, 2019, 167: 105019.

[17] 沈明霞, 陆鹏宇, 刘龙申,等. 基于红外热成像的白羽肉鸡体温检测方法[J]. 农业机械学报, 2019, 50(10): 222-229.SHEN Mingxia, LU Pengyu, LIU Longshen, et al. Body temperature detection method of ross broiler based on infrared thermography[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(10): 222-229.(in Chinese)

[18] POLAT B, COLAK A, CENGIZ M, et al. Sensitivity and specificity of infrared thermography in detection of subclinical mastitis in dairy cows[J]. Journal of Dairy Science, 2010, 93(8): 3525-3532.

[19] 肖德琴, 林思聪, 刘勤,等. 基于红外热成像的生猪耳温自动提取算法[J]. 农业机械学报, 2021, 52(8): 255-262.XIAO Deqin, LIN Sicong, LIU Qin, et al. Automatic ear temperature extraction algorithm for live pigs based on infrared thermography[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(8): 255-262.(in Chinese)

[20] MILLER B A, LU C D. Current status of global dairy goat production: an overview[J]. Asian-Australasian Journal of Animal Sciences, 2019, 32(8): 1219-1232.

[21] HOVINEN M, SIIVONEN J, TAPONEN S, et al. Detection of clinical mastitis with the help of a thermal camera[J]. Journal of Dairy Science, 2008, 91(12): 4592-4598.

[22] 许兴时, 王云飞, 华志新,等. 融合YOLO v5s与通道剪枝算法的奶牛轻量化个体识别方法[J]. 农业工程学报, 2023, 39(15): 152-62.XU Xingshi, WANG Yunfei, HUA Zhixin, et al. Light-weight recognition network for dairy cows based on the fusion of YOLO v5s and channel pruning algorithm[J]. Transactions of the CSAE, 2023, 39(15):152-162.(in Chinese)

[23] STUART-FOX D, NEWTON E, CLUSELLA-TRULLAS S. Thermal consequences of colour and near-infrared reflectance[J]. Philosophical Transactions of the Royal Society B-Biological Sciences, 2017, 372(1724): 20160345.

[24] BYRNE D T, BERRY D P, ESMONDE H, et al. Investigation of the relationship between udder quarter somatic cell count and udder skin surface temperature of dairy cows measured by infrared thermography[J]. Journal of Animal Science, 2018, 96(10): 4458-4470.

[25] 张志强, 王萍, 赵三军,等. 目标距离与角度对红外热成像仪测温精度影响分析[J]. 天津大学学报(自然科学与工程技术版), 2021, 54(7): 763-770.ZHANG Zhiqiang, WANG Ping, ZHAO Sanjun, et al. Influences of target distance and angle on temperature measurement accuracy of infrared thermal imager[J]. Journal of Tianjin University(Science and Technology), 2021, 54(7):763-770.(in Chinese)

[26] REDMON J, DIVVALA S K, GIRSHICK R B, et al. You only look once: unified, real-time object detection[J]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 779-788.

[27] SHANG Y Y, XU X S, JIAO Y T, et al. Using lightweight deep learning algorithm for real-time detection of apple flowers in natural environments[J]. Computers and Electronics in Agriculture, 2023, 207: 107765.

[28] LIN T Y, DOLL R P, GIRSHICK R B, et al. Feature pyramid networks for object detection[J]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 936-944.

R P, GIRSHICK R B, et al. Feature pyramid networks for object detection[J]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 936-944.

[29] MA N, ZHANG X, ZHENG H, et al. ShuffleNet V2: practical guidelines for efficient CNN architecture design[J]. arXiv: 2018, 1807.11164.

[30] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[J]. arXiv: 1807.06521, 2018.