0 引言

我国农业生产不断向规模化、集约化、精准化方向发展,对农业装备智能化、自动化需求也在不断增加[1]。苹果是我国产量最大的水果,其自动化采摘技术尤其是视觉识别技术更是当前研究的热点[2]。快速准确实现苹果目标检测是自动化采摘的关键[3]。复杂果园环境下的苹果目标检测受诸多因素的影响:枝叶对果实产生的遮挡;不同天气条件下复杂光照环境的影响;果实之间的相互重叠遮挡;采摘机器人本身算力有限;检测算法运算量大、参数量高等。因此,随着采摘成本不断增加、农业劳动力紧缺,实现复杂果园环境下苹果目标的智能化、自动化检测具有非常重要的实际意义。

苹果成熟度检测本质上属于目标检测范畴[4-5]。目标检测方法主要分为基于机器学习和深度学习。近年来,基于自动特征提取的深度学习目标检测方法已广泛应用于苹果目标检测。武星等[6]提出一种轻量化的YOLO v3卷积神经网络模型用于苹果目标检测,该方法在检测速度和准确率方面均有显著提高,其检测速度为116.96 f/s,F1值为94.57%,平均精度均值为94.69%。闫彬等[7]针对苹果的采摘方式提出一种基于改进的YOLO v5m苹果识别方法,将苹果采摘方式分为可直接采摘、迂回采摘和不可采摘3类,其识别结果均优于原YOLO v5m、YOLO v3和EfficientDet-D0。LIU等[8]提出一种基于YOLO v5s的苹果目标检测方法,通过引入空间到深度的卷积模块避免信息丢失,并结合上下文增强模块丰富特征金字塔网络信息,该方法验证了YOLO v5s模型的稳健性。以上研究虽然能够实现苹果目标的检测,但大多只针对成熟期苹果目标进行检测,而实际果园环境复杂、多种品种类型水果同时种植、成熟度不同,对不同成熟度苹果目标的检测能够直接决定果实的运输和贮藏方式,对果实价格及风味也会造成较大影响。同时,面对非结构化的苹果园,受自然光线、天气、绿色果实、采集角度、样本数量等影响,以上算法精度、鲁棒性及适用性相较于传统机器学习算法虽有大幅提升,但在检测远距离及遮挡目标时仍存在漏检和置信度偏低的问题,难以满足果园测产和自动采摘的实时作业需求,平衡检测速度、检测精度和模型计算复杂度仍是当前算法研究的重点。

YOLO v7[9]网络模型与其前身YOLO v5相比,通过改进骨干网络和特征融合方法等,进一步提升了检测精度;使用空间金字塔池化(Spatial pyramid pooling,SPP)+路径聚合网络(Path aggregation network, PANet)实现多尺度特征融合,在保持较高检测精度的同时提高了检测速度。因此,本文针对复杂果园环境不同成熟度苹果进行检测,并对模型进行轻量化设计,增强小目标及远景目标的检测性能,提高模型对不同场景的适应性。以YOLO v7为基础网络实现复杂果园环境下苹果目标的检测,改进原有YOLO v7模型,将窗口多头自注意力机制引入原始骨干网络,增强模型对不同环境的泛化能力;在特征融合网络引入ASFF模块实现特征空间权重的自适应调整和融合,以提升对远景小目标的识别效果。

1 材料与方法

1.1 图像采集

本研究试验数据集采集于山西省晋中市太谷区白城村试验果园(北纬37°21′,东经112°30′),研究对象为富士苹果。考虑到机械臂在采摘过程中需要适应复杂的果园环境,采用OPPO Reno5型智能手机选取多种角度分别采集晴天、阴雨天等条件下的苹果图像,采集时间为2023年7—9月,采集距离为0.5~1.5 m。共采集苹果图像1 225幅,图像尺寸为3 468像素×4 624像素,格式为JPEG。复杂果园环境包括顺光、逆光、阴雨天、单果、多果、近景、远景、果实重叠、枝叶遮挡等情况,部分样本图像如图1所示。

图1 复杂果园环境下苹果样本图像

Fig.1 Sample images of apple in complex orchard environment

1.2 数据增强

复杂果园环境下采集的图像样本数量分布如表1所示。由表1可知,由于存在光照与天气等不确定因素,获取的图像样本分布不均衡,解决样本不均衡问题可以消除模型对不同类别的偏向性,降低模型过拟合风险[10]。为了提高苹果目标检测模型的鲁棒性和泛化性,需对图像样本进行数据扩增[11]。本文采用垂直翻转、水平翻转、伽马变换、自适应直方图变换、随机亮度等方法增强图像对比度,提高模型获取目标信息的能力;考虑到图像获取过程中由于枝叶抖动、相机晃动等情况导致的运动模糊情况,对图像进行运动模糊处理。经过数据扩增之后每种环境下图像数量均在1 200幅左右,总样本图像为 3 015幅,具体样本数如表1所示。将数据集按照比例7∶2∶1划分为训练集(2 110幅)、验证集(603幅)和测试集(302幅)。

表1 复杂果园环境下苹果图像样本数量分布

Tab.1 Distribution of apple image samples in complex orchard environment

样本类别环境单果多果顺光逆光夜间雨后遮挡无遮挡套袋未套袋近景远景原始样本781147632593122258982243226999947278扩充样本113512581085120512181156108911231034118712051203

1.3 数据集搭建

采用Labelme标注软件对不同成熟度苹果数据集进行人工标注,标注框为苹果最小外接矩形,尽可能减少背景对目标检测的干扰。根据果实成熟情况,将苹果目标分别标注为未成熟(Immature)、半成熟(Semimature)及成熟(Mature)3种类别。具体标注规则为:图像中枝叶遮挡严重的苹果目标不予标注,颜色为绿色的目标标注为未成熟,着色面积低于80%的目标标注为半成熟,着色面积高于80%至全红的目标标注为成熟。标注后产生的标注信息文件为json类型文件,需将数据格式转换为YOLO模型所需txt文件类型。

1.4 苹果成熟度检测模型建立

1.4.1 改进YOLO v7网络模型构建

YOLO v7网络结构由输入端(Input)、骨干网络(Backbone)和检测头(Head)3部分组成[12],该模型提出了重参数化卷积(RepConv)、高效聚合网络(Efficient layer aggregation network,ELAN)、动态标签分配等策略,使其在检测精度和效率上取得较好的平衡[13]。检测头部分引入Rep模块与SPPCSPC模块,Rep模块分为训练模块和推理模块,训练模型时将不同卷积层以及批归一化层合并为一个卷积模块,在网络推理时对训练模块中的参数进行重参数化操作,在保证模型性能的条件下加速了网络推理[14]。

YOLO v7网络中对特征提取仅采用卷积操作,卷积层通常只会建模邻域像素之间的关系,难以捕捉长距离的依赖关系,导致小目标特征易丢失,出现远景果实漏检问题。而自注意力机制更加关注每个像素特征之间的关系,可以对卷积操作所得特征进行补充,使得模型能够更好地捕捉长距离的依赖关系[15-17],提高对远景果实的检测能力。YOLO v7采用多尺度特征图思想实现特征融合,以获取丰富的语义信息,然而,YOLO系列的单阶段目标检测模型在特征融合过程中,不同层级之间的特征存在信息不一致性问题。本研究为复杂果园环境下的苹果成熟度检测,因此,以YOLO v7为基础模型,采用窗口多头自注意力机制改进原始骨干网络,充分提取复杂果园环境下目标的上下文信息,在提高特征表达能力的同时降低模型计算量,进而达到模型轻量化的目的;为了解决跨尺度融合问题,在检测头部分引入ASFF结构,该结构通过自适应地融合来自不同层级特征图的信息,可增强模型对不同尺度目标的检测能力,有效解决漏检或误检问题。改进后的YOLO v7-ST-ASFF苹果成熟度检测模型结构如图2所示。

图2 基于YOLO v7-ST-ASFF的复杂果园环境下苹果成熟度检测模型结构

Fig.2 Maturity detection model structure of apple in complex orchard environment based on YOLO v7-ST-ASFF

1.4.2 Swin transformer模块

融合不同尺度的特征是提高目标检测网络识别性能的一个重要手段[18]。低层特征图的分辨率较高,但语义性较低,所含噪声也较多;高层特征图具有较强的语义信息,但其分辨率较低,对图像细节的感知能力也较差。因此,对高层与低层特征进行有效融合,是改善模型检测性能的关键。

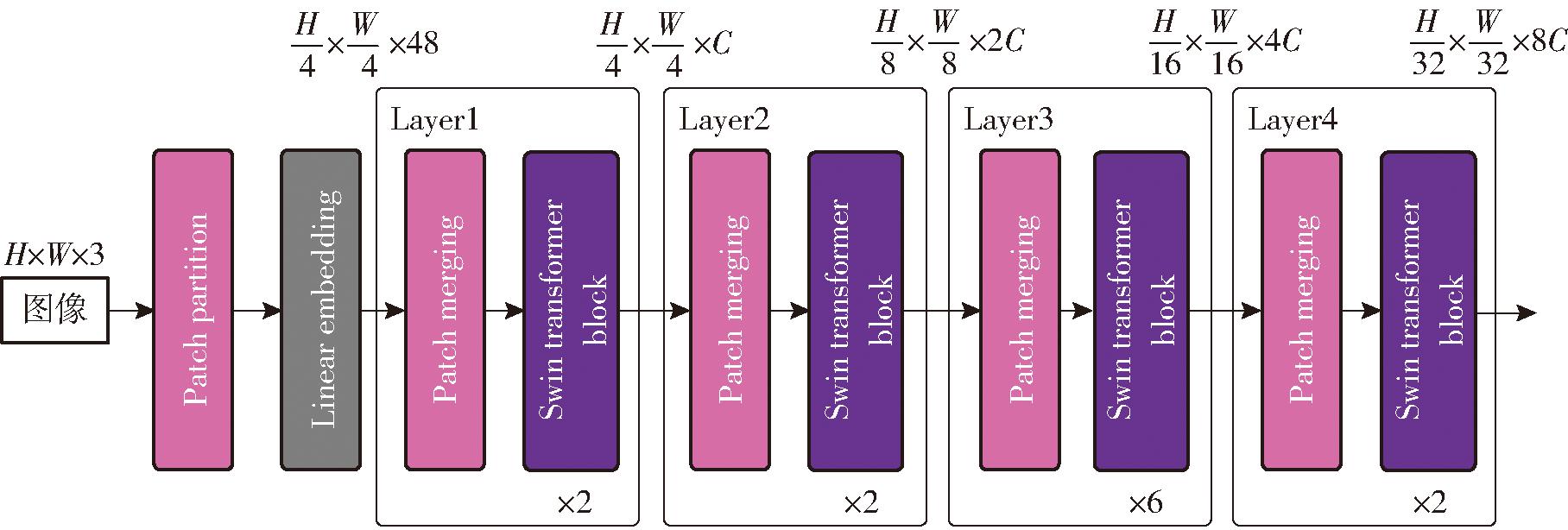

Transformer[19]模块通过引入自注意力机制,使模型能够全局感知输入的上下文信息,从而提高模型的表达能力和推理能力。近年来,Transformer在目标检测、语义分割等任务中都表现出优异的性能。Transformer从自然语言处理应用到计算机视觉领域,需面临视觉实体变化大、图像分辨率高等问题。而Swin transformer[20]引入2个关键概念——分层特征图和滑动窗口注意力,可有效解决以上问题。Swin transformer模块整体架构如图3所示,它由图像分块层(Patch partition)、线性嵌入层(Linear embedding)和4个Layer组成,每个Layer由多个图块拼接层(Patch merging)和Swin transformer block模块构成。

图3 Swin transformer模块结构

Fig.3 Structure of Swin transformer module

在ResNet等卷积神经网络中,特征图下采样大多采用卷积操作完成,而Swin transformer模块中的下采样则采用无卷积Patch merging技术实现,其中“Patch”是特征图中的最小单位。假设输入图像的高度、宽度、通道数分别为H、W、3,通过Patch partition层可将每4×4相邻的像素分块为一个Patch,并沿通道方向展开,使得图像维度变为(H/4)×(W/4)×48;然后,通过Linear embedding层对每个像素的通道数据做线性变换,使图像维度变成(H/4)×(W/4)×C,其中C为投影维度。通过每个Patch merging后,输出特征图高和宽会减半,通道数翻倍,其中Layer2、Layer3、Layer4的输出特征图分别为(H/8)×(W/8)×2C、(H/16)×(W/16)×4C和(H/32)×(W/32)×8C。随着网络层次的加深,节点的感受野也在不断扩大。

Swin transformer以Transformer结构为基础,将标准多头自注意力模块(Multi-head self-attention, MSA)替换为窗口多头自注意力模块(Window multi-head self-attention, W-MSA)和滑动窗口多头注意力模块(Shift window multi-head self-attention, SW-MSA)。图4为Swin transformer block结构。该模块由2个子单元组成,每个子单元由一个归一化层(Norm)、一个注意力模块,后接另一个归一化层和一个多层感知机(Multilayer perceptron, MLP)层组成;第1个子单元使用W-MSA模块,第2个子单元使用SW-MSA模块。

图4 Swin transformer block结构

Fig.4 Structure of Swin transformer block

1.4.3 ASFF模块

传统的YOLO v7模型在特征金字塔网络(Feature pyramid networks,FPN)的基础上结合了自顶向下和自底向上的特征融合功能,能够自适应地调整各尺度特征的空间融合权重。但多尺度融合会造成不同层级之间的特征信息冲突,即不一致性。不同特征尺度之间的不一致性是基于FPN的单阶段检测器的主要限制。

ASFF模块能够对冲突信息进行空间过滤以抑制不一致性,可改善特征的尺度不变性[21]。因此,本文引入ASFF模块来抑制不同层级之间特征的信息冲突,提高PANet的融合效果,进而提高目标检测能力。ASFF模块结构如图5所示。

图5 ASFF模块结构

Fig.5 Structure of ASFF module

1.5 损失函数

YOLO v7的损失函数由分类损失、回归框损失和目标检测损失3部分构成,其中回归框损失为CIoU。在目标检测中,框回归(Bounding box regression, BBR)是决定目标定位性能的关键步骤。YOLO v7中的CIoU未考虑难易样本的平衡问题,导致评估结果可能存在偏差。因此,本研究使用WIoU[22]损失函数代替CIoU,该损失函数能够有效解决质量较好和质量较差样本间的BBR平衡问题,提高模型的收敛速度和检测准确性。

1.6 试验环境配置与网络参数设置

试验所用操作系统为Windows 10,CPU型号为Intel(R) Core(TM) i7-12700F CPU@2.10 GHz,GPU型号为NVIDIA GeForce RTX 3080,运行内存为32 GB,1 TB机械硬盘,编程语言为Python 3.9,使用的深度学习框架为Pytorch 1.13.0,GPU加速库为CUDA 11.7、CUDNN 8.4.1。训练时初始学习率为0.001,批处理量为16,动量为0.9,迭代次数为100。网络在前20轮训练时,损失值快速下降,训练80轮之后损失值基本趋于稳定。因此,本研究将训练100轮结束后输出的模型确定为面向苹果采摘机器人的目标检测模型。

1.7 模型评价指标

对苹果成熟度的检测需要考虑检测精度和速度。在模型检测精度方面,选用精确率(Precision,P)、召回率(Recall,R)和平均精度(Average precision,AP)作为评价指标;在模型检测性能方面,选取平均精度均值(mAP)、平均检测时间(ADT)和模型内存占用量作为评价指标。

2 试验结果与分析

2.1 YOLO v7-ST-ASFF模型试验结果

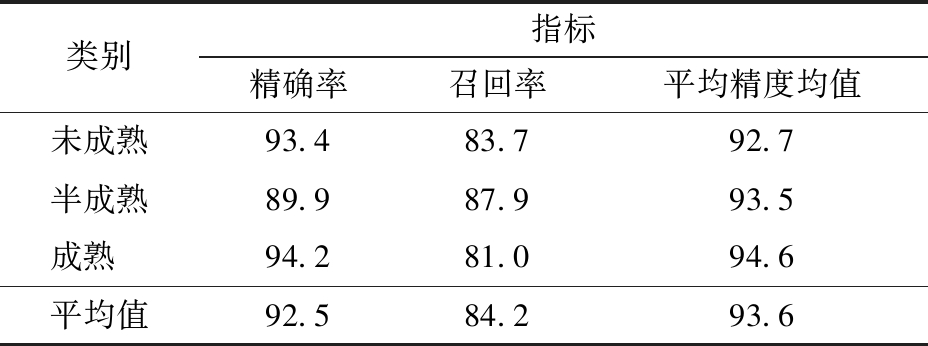

为验证YOLO v7-ST-ASFF模型的性能,对测试集中的302幅苹果图像进行评价,表2为本文模型在不同成熟度级别的检测结果,图6h为改进模型的部分检测结果图。从表2可知,本文模型针对未成熟、半成熟和成熟苹果目标检测的平均精度均值分别为92.7%、93.5%和94.6%,不同成熟度目标检测的精确率、召回率和平均精度均值可达92.5%、84.2%和93.6%,表明检测效果较好。从图6h中可知,本文模型针对多目标、单目标、顺光、逆光、远景、近景以及套袋、未套袋环境下的苹果目标检测效果都较好,能够满足复杂环境下苹果目标的检测。

表2 YOLO v7-ST-ASFF模型检测结果

Tab.2 Detection results of YOLO v7-ST-ASFF model %

类别指标精确率召回率平均精度均值未成熟93.483.792.7半成熟89.987.993.5成熟 94.281.094.6平均值92.584.293.6

图6 不同目标检测模型对比

Fig.6 Comparison results of different object detection models

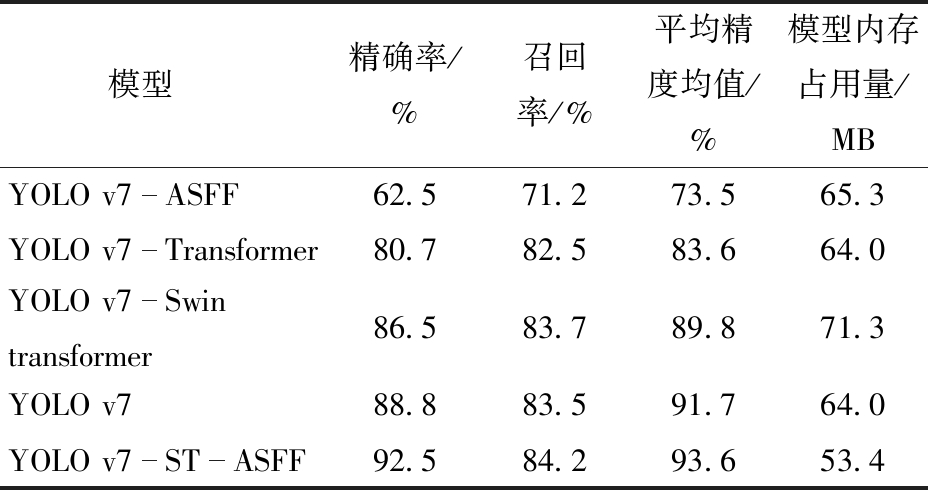

2.2 YOLO v7-ST-ASFF模型消融试验结果

本研究设置了5组消融试验,分别为ASFF作为YOLO v7检测头、YOLO v7替换骨干网络为Transformer模块、YOLO v7替换骨干网络为Swin transformer模块、YOLO v7模型和本文YOLO v7-ST-ASFF模型,所有模型采用的损失函数均为WIoU。从定量角度分析5组网络性能,并对测试集中的苹果图像进行客观评价,结果如表3所示。从表3可知,本文提出的YOLO v7-ST-ASFF模型平均精度均值均高于其他4组模型,且模型内存占用量有一定的降低。

表3 YOLO v7-ST-ASFF模型消融试验结果

Tab.3 Ablation results of YOLO v7-ST-ASFF model

模型精确率/%召回率/%平均精度均值/%模型内存占用量/MBYOLO v7ASFF62.571.273.565.3YOLO v7Transformer80.782.583.664.0YOLO v7Swin transformer86.583.789.871.3YOLO v788.883.591.764.0YOLO v7STASFF92.584.293.653.4

2.3 不同目标检测模型对比

2.3.1 不同目标检测模型定性与定量对比

为定性评价YOLO v7-ST-ASFF模型的检测结果,本文将改进模型与Faster R-CNN[23]、SSD[24]、YOLO v3[25]、YOLO v5[26]、YOLO v7以及YOLO v8[27]目标检测模型对测试集中的苹果图像进行算法对比,结果如图6所示。

从图6b可知,使用Faster R-CNN模型,近景、远景多目标成熟果实检测效果都较差,多数目标被检测为半成熟级别;逆光未成熟果实检测效果较好,能够检测出小目标;阴雨天多目标半成熟果实、套袋未成熟果实检测效果尚可,但检测准确率较低;顺光单目标检测效果较差,存在重复检测问题;远景多目标未成熟检测效果一般,存在漏检情况。从图6c可知,使用SSD模型,近景、远景多目标成熟果实检测准确率较低,多数目标被检测为半成熟级别;逆光未成熟果实检测效果较好,能够检测出小目标;阴雨天多目标半成熟果实、套袋未成熟果实检测准确率较低;顺光单目标检测效果较差,存在重复检测问题;远景多目标未成熟检测效果较差,存在漏检情况。从图6d可知,使用YOLO v3模型,多目标成熟果实、阴雨天多目标半成熟果实、逆光未成熟果实、顺光单目标果实检测准确率都较高;远景多目标未成熟检测效果较差,存在漏检情况;远景多目标成熟果实检测效果尚可,少数目标被检测为半成熟级别;套袋未成熟果实检测效果尚可。从图6e可知,使用YOLO v5模型,多目标成熟果实检测效果较差,存在重复检测问题;逆光未成熟果实检测效果较差,存在误检情况,部分检测结果将叶片检测为果实;阴雨天多目标半成熟果实、远景多目标成熟果实检测效果较差,存在检测级别误检情况;顺光单目标果实检测准确率较低;远景多目标未成熟果实、套袋未成熟果实检测效果尚可,但检测准确率较低。从图6f可知,使用YOLO v7模型,多目标成熟果实、阴雨天多目标半成熟果实、远景多目标成熟果实、套袋未成熟果实检测效果都较好,检测准确率较高;逆光未成熟果实检测效果较好,能够对拍摄不完整目标进行检测;顺光单目标果实检测效果较差,存在重复检测问题;远景多目标未成熟检测效果较差,由于远景未成熟目标与叶片杂草颜色差异较小,只有部分目标能够检测出,且检测准确率较低。从图6g可知,使用YOLO v8模型,多目标成熟果实、阴雨天多目标半成熟果实、顺光单目标果实检测准确率较高;逆光未成熟果实检测效果尚可;远景多目标未成熟检测效果较差,只有极少部分目标能够检测出,且检测准确率较低;远景多目标成熟果实、套袋未成熟果实检测效果较差,检测准确率较低。从图6h可知,使用YOLO v7-ST-ASFF模型,多目标成熟果实、逆光未成熟果实、阴雨天气多目标半成熟果实、顺光单目标果实、远景多目标成熟果实检测效果均较好,检测准确率较高;远景多目标未成熟检测效果尚可,存在漏检问题;套袋未成熟果实检测效果一般,存在漏检情况。

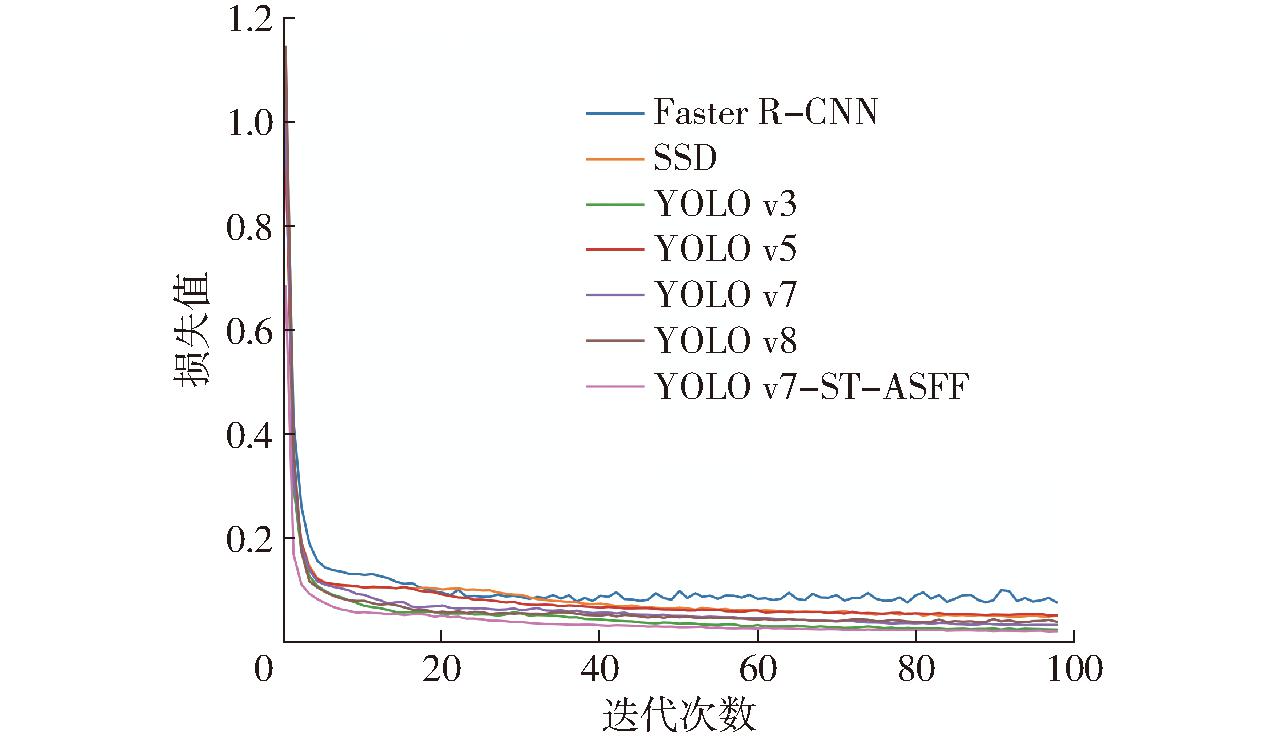

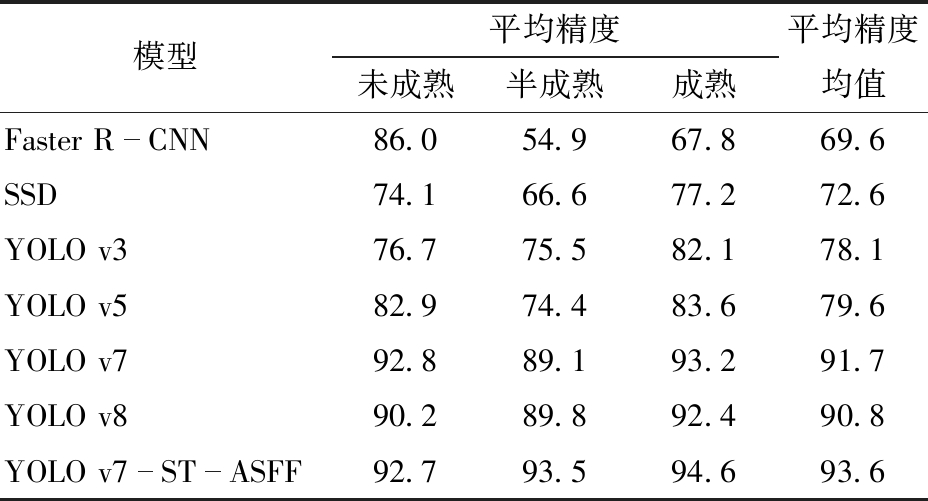

为定量比较改进模型的性能,本文将改进模型与Faster R-CNN、SSD、YOLO v3、YOLO v5、YOLO v7、YOLO v8模型在测试集上进行性能比较,表4为不同检测模型在测试集中的性能结果。从表4可知,与其他模型相比,本文改进模型精确率、召回率及平均精度均值均最优,分别为92.5%、84.2%和93.6%。通过使用ST模块改进骨干网络能够减少模型内存占用量,本文模型为53.4 MB,ADT为45 ms,均优于其他模型。图7为不同检测模型在训练集上的总损失值对比。从图7可知,不同模型训练轮次大多在80后趋于稳定,收敛到固定值;Faster R-CNN模型随着训练轮次的增加,损失值波动较大,其他模型整体变化趋势差距较小;与其他模型相比,本文提出的YOLO v7-ST-ASFF模型收敛速度最快。

表4 不同检测模型在测试集中的性能

Tab.4 Performance of different detection models in test sets

模型精确率/%召回率/%平均精度均值/%ADT/ms模型内存占用量/MBFaster RCNN55.876.669.68265.3SSD57.574.672.66757.5YOLO v373.778.378.17871.3YOLO v575.578.679.65655.8YOLO v788.883.591.78964.0YOLO v889.883.490.85358.3YOLO v7STASFF92.584.293.64553.4

图7 不同目标检测模型训练损失值对比

Fig.7 Training loss results of different detection models

2.3.2 不同目标检测模型不同成熟度对比

表5为不同检测模型在测试集中不同成熟度的检测结果。从表5可知,与其他算法相比,本文改进的YOLO v7-ST-ASFF算法针对未成熟、半成熟和成熟苹果目标检测的平均精度均值均最高。Faster R-CNN模型针对半成熟苹果目标检测结果最差,针对未成熟苹果目标检测结果良好。SSD模型针对不同成熟度苹果目标检测结果均优于Faster R-CNN模型。YOLO v3和YOLO v5模型针对不同成熟度苹果目标检测结果均不太理想。YOLO v7和YOLO v8模型针对不同成熟度苹果目标的检测结果均较好,其平均精度均值可达90%以上。

表5 不同检测模型在测试集中不同成熟度检测结果

Tab.5 Performance of different detection models in different maturity in test sets %

模型平均精度未成熟半成熟成熟平均精度均值Faster RCNN86.054.967.869.6SSD74.166.677.272.6YOLO v376.775.582.178.1YOLO v582.974.483.679.6YOLO v792.889.193.291.7YOLO v890.289.892.490.8YOLO v7STASFF92.793.594.693.6

2.4 不同回归框损失函数对比

原始YOLO v7模型采用CIoU作为预测框和真实框之间的损失函数,即回归框损失。CIoU将边界框的长宽比作为惩罚项加入到损失函数中,一定程度上可加快预测框的回归收敛过程,但当收敛到预测框和真实框的长和宽呈线性比例时,惩罚项则恒为零,存在不合理性。因此,对比分析CIoU、EIoU(Efficient intersection over union)、GIoU(Generalized intersection over union)、SIoU(Smooth intersection over union)和WIoU损失函数对模型性能的影响。不同损失函数在训练集上的性能及损失值如表6和图8所示。从表6可知,原始CIoU损失函数的精确率、召回率和平均精度均值都最低,WIoU平均精度均值为93.6%,均优于其他损失函数。从图8可以看出,EIoU损失值最大,均高于CIoU、GIoU、SIoU和WIoU;GIoU和SIoU损失曲线下降趋势相似,且均高于CIoU和WIoU;CIoU损失曲线在经过一次上升下降之后,在迭代次数为30左右时出现明显的上升再下降波动,表明该模型存在一定过拟合现象,无法满足模型收敛性要求;WIoU拥有更小的收敛损失,且收敛速度较快,与其他损失函数相比,从性能分析和收敛速度上该损失函数都最优。

表6 不同损失函数在训练集中的性能

Tab.6 Performance of different loss functions in training sets

损失函数精确率/%召回率/%平均精度均值/%模型内存占用量/MBCIoU79.478.281.853.4EIoU80.489.389.953.4GIoU89.284.991.953.4SIoU91.785.192.253.4WIoU92.584.293.653.4

图8 不同损失函数在训练集上的损失值对比

Fig.8 Training loss curves of different loss functions

2.5 热力图

目标检测热力图是图像中信息对于预测结果的贡献排名,分数越高(颜色越红)的地方表示在输入图像中该区域对网络的响应越高、贡献越大。本研究采用Grad-CAM(Gradient-weighted class activation mapping)方法对改进YOLO v7-ST-ASFF模型进行热力图可视化,热力图中像素值表示该像素区域对于检测结果的重要性。图9为部分复杂果园环境下苹果图像检测热力图,从图9中可看出,本文YOLO v7-ST-ASFF模型的检测热力图更加贴近真实果实区域,能够注意到不同环境情况下的苹果目标。

图9 YOLO v7-ST-ASFF模型检测热力图

Fig.9 Heat maps of YOLO v7-ST-ASFF model

3 结论

(1)针对复杂果园环境下目标检测网络对不同成熟度苹果检测精度不高问题,改进原有YOLO v7模型,将ST模块引入原始骨干网络,有效获取长距离依赖关系,提高特征表达能力以适应复杂的果园环境。引入ASFF改进特征融合网络实现特征空间权重的自适应调整和融合,模型在小尺度、远景图像下的目标检测性能提升明显。

(2)本文模型对未成熟、半成熟和成熟苹果目标检测的平均精度均值分别为92.7%、93.5%和94.6%,所有成熟度级别检测的平均精确率、召回率和平均精度均值可达92.5%、84.2%和93.6%。针对多目标、单目标、顺光、逆光、远景、近景以及套袋、未套袋检测效果都较好,能够满足复杂环境下苹果目标检测。

(3)设置了5组消融试验验证网络性能,分别为ASFF作为YOLO v7检测头、YOLO v7替换骨干网络为Transformer模块、YOLO v7替换骨干网络为Swin transformer模块,原始YOLO v7模型和本文YOLO v7-ST-ASFF模型。从定量的角度分析5组网络性能,试验结果表明,本文改进的YOLO v7-ST-ASFF模型平均精度均高于其他4组模型,且模型内存占用量有一定的降低。

(4)与Faster R-CNN、SSD、YOLO v3、YOLO v5、YOLO v7及YOLO v8模型对测试集中的苹果图像进行对比,改进的YOLO v7-ST-ASFF模型针对多目标成熟果实、逆光未成熟果实、阴雨天气情况下多目标半成熟果实、顺光单目标果实检测效果都较优,且检测准确率较高。本文模型与其他模型相比,精确率、召回率及平均精度均值也最优。通过使用ST模块改进骨干网络能够减少模型内存占用量,降低对硬件的要求,提升模型可移植性。在模型训练过程中,改进YOLO v7-ST-ASFF模型收敛速度最快。

(5)由于远景未成熟目标与叶片颜色相似程度较高,本文模型针对远景未成熟多目标果实、套袋未成熟果实检测效果一般,存在漏检情况,影响了检测结果。

[1] 龙燕,高研,张广犇. 基于改进HRNet的单幅图像苹果果树深度估计方法[J]. 农业工程学报, 2022, 38(23): 122-129.LONG Yan, GAO Yan, ZHANG Guangben. Depth estimation of apple tree in single image using improved HRNet[J]. Transactions of the CSAE, 2022, 38(23): 122-129. (in Chinese)

[2] 曾晏林,贺壹婷,蔺瑶,等. 基于BCE-YOLO v5的苹果叶部病害检测方法[J]. 江苏农业科学, 2023, 51(15): 155-163.ZENG Yanlin, HE Yiting, LIN Yao, et al. A detection method for apple leaf diseases based on BCE-YOLO v5[J]. Jiangsu Agricultural Sciences, 2023, 51(15): 155-163. (in Chinese)

[3] ZHANG C, ZHANG H, ZHANG C. Multi-objective detection and tracking algorithm for unmanned street view based on improved YOLO v5 and DeepSORT under complex scenes[C]∥2022 IEEE 4th International Conference on Civil Aviation Safety and Information Technology (ICCASIT), 2022.

[4] YAN B, FAN P, LEI X, et al. A real-time apple targets detection method for picking robot based on improved YOLO v5[J]. Remote Sensing, 2021, 13(9): 1619.

[5] TIAN Yunong, YANG Guodong, WANG Zhe, et al. Apple detection during different growth stages in orchards using the improved YOLO-V3 model[J]. Computers and Electronics in Agriculture, 2019, 157: 417-426.

[6] 武星,齐泽宇,王龙军,等. 基于轻量化YOLO v3卷积神经网络的苹果检测方法[J]. 农业机械学报, 2020, 51(8): 17-25.WU Xing, QI Zeyu, WANG Longjun, et al. Apple detection method based on light YOLO v3 convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(8): 17-25. (in Chinese)

[7] 闫彬,樊攀,王美茸,等. 基于改进YOLO v5m的采摘机器人苹果采摘方式实时识别[J]. 农业机械学报, 2022, 53(9): 28-38, 59.YAN Bin, FAN Pan, WANG Meirong, et al. Real-time apple picking pattern recognition for picking robot based on improved YOLO v5m[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(9): 28-38, 59. (in Chinese)

[8] LIU J, WANG C, XING J. YOLO v5-ACS: improved model for apple detection and positioning in apple forests in complex scenes[J]. Forests, 2023,14(12): 2304.

[9] ZHANG X, HUANG D. Research on UAV ground target detection based on improved YOLO v7[C]∥2023 3rd International Conference on Computer, Control and Robotics (ICCCR), 2023: 28-32.

[10] LI Lili, YANG Hua, WANG Bin. Cerasus humilis cultivars identification with small-sample and unbalanced dataset based on EfficientNet-B0+Ranger networks[J]. INMATEH-Agricultural Engineering, 2023, 69(1):225-236.

[11] YU G, SHAO B. Garbage classification and detection based on improved YOLO v7 network[C]∥2023 International Conference on Pattern Recognition, Machine Vision and Intelligent Algorithms (PRMVIA), 2023: 103-107.

[12] 于春涛,李金阳,石文强,等.基于改进YOLO v7的杂交大豆苗期胚轴颜色检测模型[J]. 中国农业大学学报, 2024, 29(2): 11-22.YU Chuntao, LI Jinyang, SHI Wenqiang, et al. Color detection model of hybrid soybean hypocotyl based on an improved YOLO v7 object detection model[J]. Journal of China Agricultural University, 2024, 29(2): 11-22. (in Chinese)

[13] 李非凡,沈新锋,赵和平,等. 基于计算机人工智能YOLO v7算法的物体表面缺陷检测方法[C]∥第十七届全国信号和智能信息处理与应用学术会议论文集,2023:9.LI Feifan, SHEN Xinfeng, ZHAO Heping, et al. Object surface defect detection method based on computer artificial intelligence YOLO v7 algorithm[C]∥Proceedings of the 17th National Conference on Signal and Intelligent Information Processing and Application, 2023: 9. (in Chinese)

[14] 邹振涛,李泽平. 改进YOLO v7的航拍图像目标检测[J/OL]. 计算机工程与应用: 1-12[2023-12-27]. http:∥kns.cnki.net/kcms/detail/11.2127.TP.20231016.1108.016.html.ZOU Zhentao, LI Zeping. Improved YOLO v7 for UAV image object detection[J/OL]. Computer Engineering and Applications: 1-12[2023-12-27]. http:∥kns.cnki.net/kcms/detail/11.2127.TP.20231016.1108.016.html.(in Chinese)

[15] WANG S, WU D, ZHENG X. TBC-YOLO v7: a refined YOLO v7-based algorithm for tea bud grading detection[J]. Frontiers in Plant Science, 2023, 14: 1223410.

[16] MENG X, LI C, LI J, et al. YOLO v7-MA: improved YOLO v7-based wheat head detection and counting[J]. Remote Sensing, 2023, 15(15): 3770.

[17] HE Y, SU B, YAN J, et al. Research on underwater object detection of improved YOLO v7 model based on attention mechanism: the underwater detection module YOLO v7-C[C]∥Proceedings of the 2022 4th International Conference on Robotics, Intelligent Control and Artificial Intelligence, 2022: 302-307.

[18] HASSAN M, HUDA S, HASSAN M, et al. Early detection of cardiovascular autonomic neuropathy: a multi-class classification model based on feature selection and deep learning feature fusion[J]. Information Fusion, 2022, 77: 70-80.

[19] STRUDEL R, GARCIA R, LAPTEV I, et al. Segmenter: transformer for semantic segmentation[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 7262-7272.

[20] LIU Z, LIN Y, CAO Y, et al. Swin transformer: hierarchical vision transformer using shifted windows[C]∥Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 10012-10022.

[21] 耿艳利,林彦伯,付艳芳,等. 基于Transformer与自适应空间特征融合的群猪目标检测算法研究[J]. 东北农业大学学报 ,2023, 54(1): 88-96.GENG Yanli, LIN Yanbo, FU Yanfang, et al. Study on pigs target detection algorithm based on Transformer and adaptively spatial feature fusion[J]. Journal of Northeast Agricultural University, 2023, 54(1): 88-96. (in Chinese)

[22] 齐向明,柴蕊,高一萌. 重构SPPCSPC与优化下采样的小目标检测算法[J]. 计算机工程与应用, 2023, 59(20): 158-166.QI Xiangming, CHAI Rui, GAO Yimeng. Algorithm of reconstructed SPPCSPC and optimized downsampling for small object detection[J]. Computer Engineering and Applications, 2023, 59(20): 158-166. (in Chinese)

[23] KALIDINDA L D, VIJAYABASKAR V. Plant disease detection using Faster RCNN networks[C]∥2022 International Conference on Computing, Communication and Power Technology (IC3P), 2022: 260-263.

[24] 李振波,李萌,吴宇峰,等. 基于优化SSD算法的冰鲜鲳鱼新鲜度评估方法研究[J]. 农业机械学报, 2021, 52(增刊): 472-481.LI Zhenbo, LI Meng, WU Yufeng, et al. Evaluation method of iced pomfret freshness based on improved SSD[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(Supp.): 472-481. (in Chinese)

[25] WANG K, LIU M. YOLO v3-MT: a YOLO v3 using multi-target tracking for vehicle visual detection[J]. Applied Intelligence, 2022, 52(2): 2070-2091.

[26] REN J, WANG Z, ZHANG Y, et al. YOLO v5-R: lightweight real-time detection based on improved YOLO v5[J]. Journal of Electronic Imaging, 2022, 31(3): 033033.

[27] ZHOU Y, ZHU W, HE Y, et al. YOLO v8-based spatial target part recognition[C]∥2023 IEEE 3rd International Conference on Information Technology, Big Data and Artificial Intelligence (ICIBA). IEEE, 2023: 1684-1687.