0 引言

路径规划是果园机器人自主导航重要环节之一,而同时定位与地图构建(Simultaneous localization and mapping, SLAM)[1]能够实现在未知环境的结构重建,进而能够满足果园机器人的定位、路径规划、避障等需求,已被广泛应用在果园机器人的自主导航中。目前建图中常用的传感器有激光雷达[2-5]、各类相机[6-8]以及多传感器融合[9-10]等。

在建图方面,薛金林等[3]提出了改进Gmapping的果园二维地图精准构建算法,通过改进R-GPF实现地面点云快速分割和BAT启发式自适应重采样算法获得定位信息,为重定位、导航等提供了保障。CHEN等[7]提出了一种基于动态立体匹配算法的手眼立体视觉建图系统,建立复杂果园全局地图以适应果园采摘任务要求。LIU等[8]提出了一种ORB-SLAM3和激光雷达融合果园重建算法估计机器人姿态,并结合YOLO v5识别RGB图像中的苹果,实现非结构化自然环境中的苹果实时定位检测。在建图所用传感器中,相机因其价格低、灵活、实时和导航精度高等优点而被广泛应用[11]。

目前常见的视觉SLAM算法有MonoSLAM(单目)[12]、ORB-SLAM(单目为主)[13]、SVO(单目)[14]、DTAM(RGBD)[15]、RTAB-MAP(双目和RGBD)[16]等,其中ORB-SLAM是常用视觉建图算法,该算法中ORB特征提取相较于SURF、SIFT等算法速度提升明显,除此之外ORB-SLAM算法的ORB字典的应用对回环检测减少累计误差发挥了重要作用,但是该算法以单目相机为主,双目运行效果较差。而ORB-SLAM2[17]算法,支持双目和RGBD相机,集定位、建图、闭环等功能于一体,可以实现大场景下地图构建,得到广泛应用。

董蕊芳等[18]融合环境3D、2D占据特征及路标位置等信息,提出基于ORB-SLAM2的多图层地图定位导航,实现了森林公园的路径规划。LI等[19]根据ORB-SLAM2提出实现语义立体V-SLAM算法,消除环境中运动物体的影响,提高运动轨迹计算的精确性。虽然ORB-SLAM2算法被广泛应用在各个领域,但是所生成的点云稀疏,且在阴暗光照条件下特征无法很好匹配且产生跟踪丢失,无法满足果园行间路径规划需求,针对ORB-SLAM2点云地图稀疏问题,丛佩超等[6]使用RGBD在原有算法基础上对局部点云进行了拼接与体素滤波,实现了该算法在果园三维稠密地图构建上的应用,但仍未解决阴暗光照下特征提取丢失等问题。

针对上述问题,本文设计一种基于自适应阈值ORB特征提取的ORB-SLAM2算法,阈值根据不同光照进行调整,解决阴暗光线下特征跟踪丢失问题,增加阴暗弱光条件下特征点的提取数量,且添加基于双目深度图融合的稠密点云构建模块,以提升复杂果园环境下三维地图构建质量。

1 果园视觉建图与定位方法

1.1 算法框架与整体流程

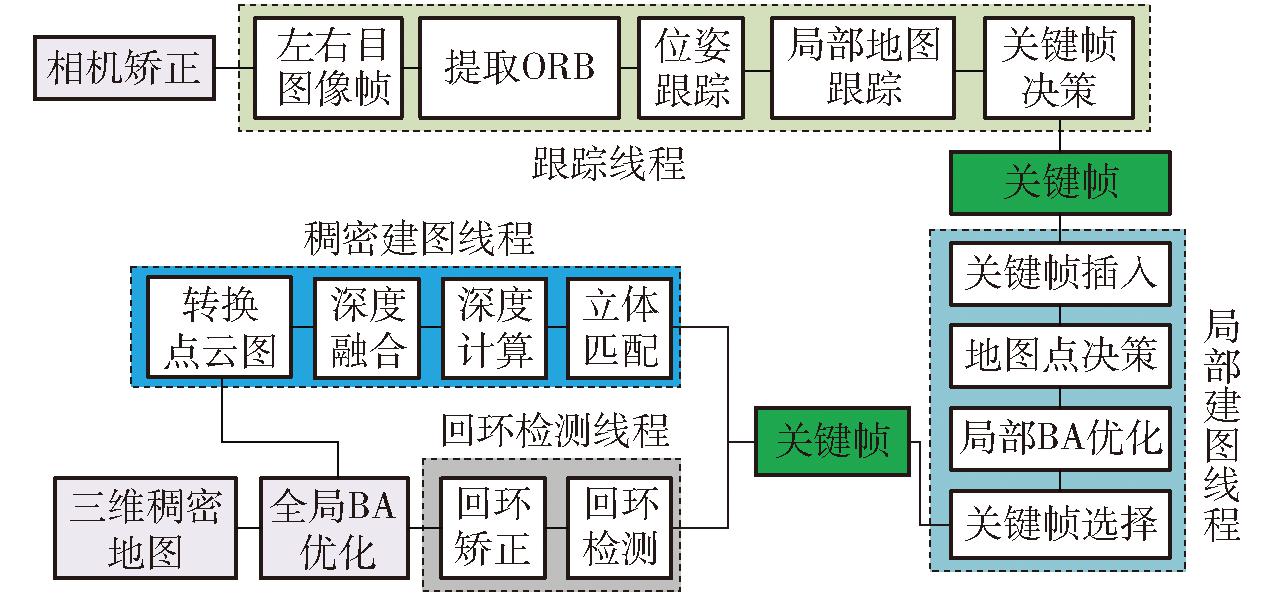

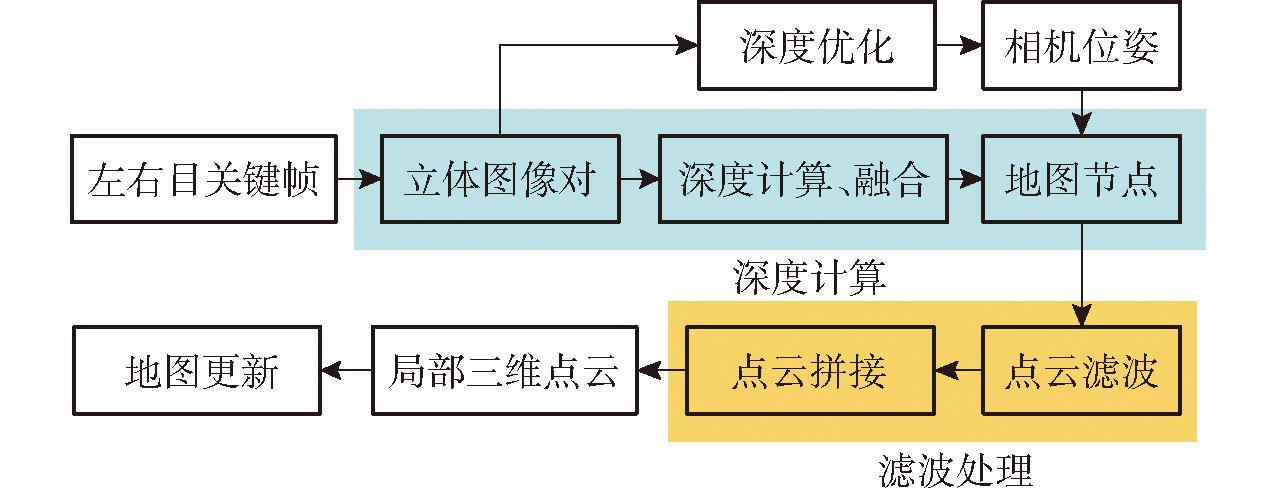

传统ORB-SLAM2包括跟踪、局部建图和回环检测3个线程[20],在跟踪线程中优化特征点提取方式,提出自适应阈值FAST角点提取,增加阴暗光照条件下特征点匹配数量。为满足果园导航需求,本文在原有3个线程的基础上增加稠密建图线程,如图1所示,整个流程分为双目相机获取图像、特征点法里程计、后端位姿优化、回环检测与果园稠密地图构建5个步骤。

图1 果园双目稠密建图算法框图

Fig.1 Framework of binocular dense mapping algorithm in orchard

通过计算图像像素然后求解阈值从而提取图像ORB特征点,经过滤波后提取关键帧获取相机位姿信息完成局部地图跟踪,生成的关键帧用于地图点的生成,通过局部BA优化完成局部建图;对左右目图像进行立体匹配,计算图像深度以获得果园行间稠密点云;选择优质关键帧参与回环检测并进行回环矫正,对获得的点云地图进行全局BA优化,最终生成果园三维稠密点云地图。

1.2 相机运动与投影模型

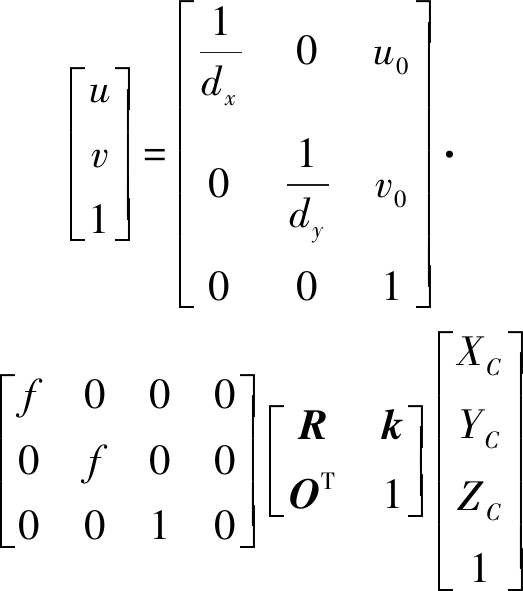

1.2.1 相机模型与坐标转换

相机成像原理主要是小孔成像模型,如图2所示,对于空间中某点P1,对应4个坐标系及坐标分别为:世界坐标系(XW,YW,ZW)、相机坐标系(XC,YC,ZC)、图像物理坐标系(x,y)和像素坐标系(u,v)等4个坐标系[21]。

图2 相机成像模型

Fig.2 Model of camera imaging

点P1由世界坐标到像素坐标的转换关系为

(1)

式中 dx、dy——图像中每个像素宽度和长度

u0、v0——图像坐标相对于像素坐标的位置偏移量

R——相机旋转矩阵

k——相机平移向量

O——零矩阵

f——相机焦距

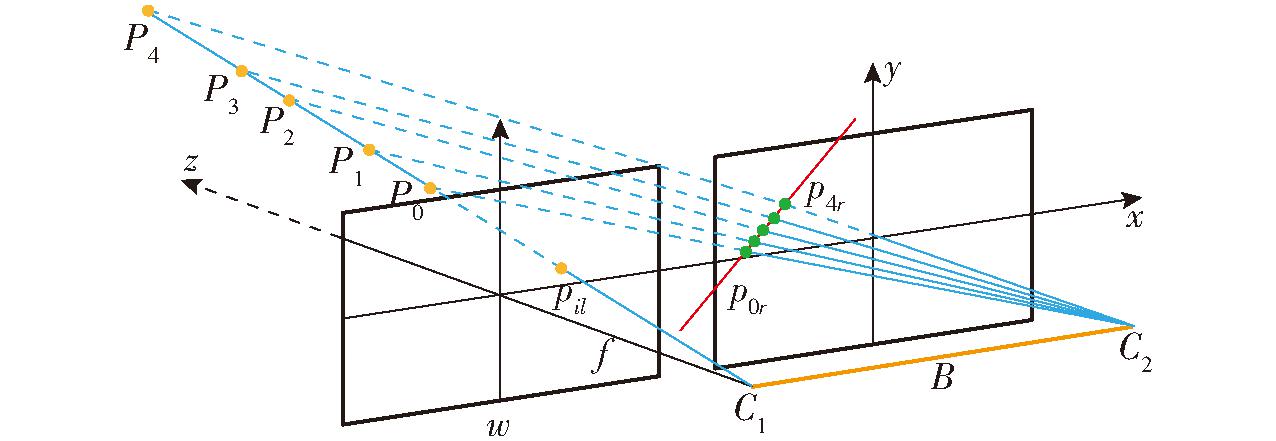

为了更好地表达果园空间的三维信息,需要根据果园空间点完成三维地图构建,即通过获得匹配点求解三维坐标以及进而求解相机的投影矩阵完成地图点间的匹配。如图3所示,对于空间中点P0~P4,其在相机C1中的投影位置均在pil处,单一相机无法获得该点具体位置,需根据相机C2进一步求解获得该点距离。深度图的获取与融合基于视差原理,利用C1和C2从不同位置获取待测物体的2幅图像,经过系统计算处理获取图像对应点间的位置偏差,进而可以获取物体三维几何信息。

图3 双目测距原理

Fig.3 Principle of distance measurement by binocular camera

空间点P1在坐标系C1和C2下的坐标分别为(xl,yl,zl)、(xr,yr,zr),像素坐标为(ul,vl)、(ur,vr),根据相似三角形原理,在世界坐标系下P1坐标满足

(2)

其中

D=ul-ur

(3)

式中 B——双目相机两个光心距离(基线)

D——相机左右视差

1.2.2 相机运动与观测方程

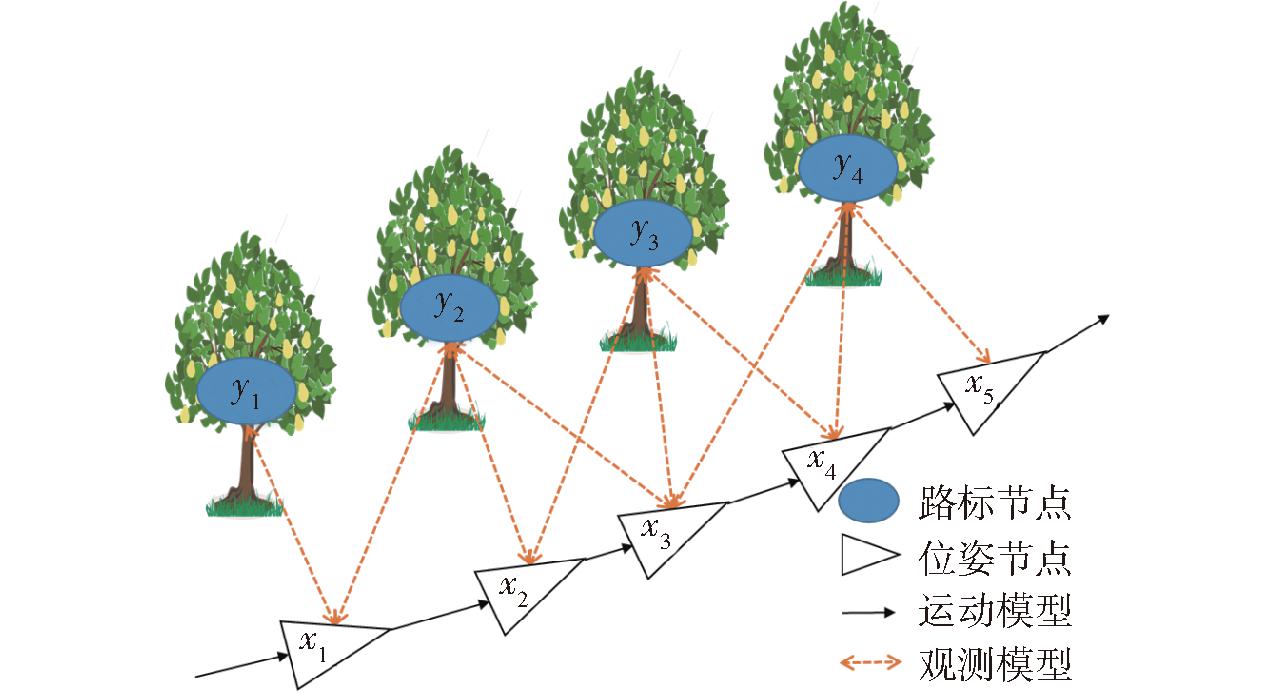

相机在果园行间行进时,为了计算其运动状态和果树位置,通过运动方程和观测方程来进行描述,如图4所示,从t-1时刻到t时刻,相机运动方程和在t时刻相机对果树点的观测方程为

(4)

图4 果园环境下相机运动状态

Fig.4 Motion of camera in orchard

式中 xt——t时刻相机位姿

ut——t时刻相机输入

ωt——测量噪声

yi——被观测的果树点i位置信息

zt,i——在xt位置,相机对果树点i的观测数据

ϑt,i——观测噪声

g、h——相机运动函数和观测函数模型

2 基于改进ORB-SLAM2的果园稠密建图

2.1 特征点提取与双目匹配

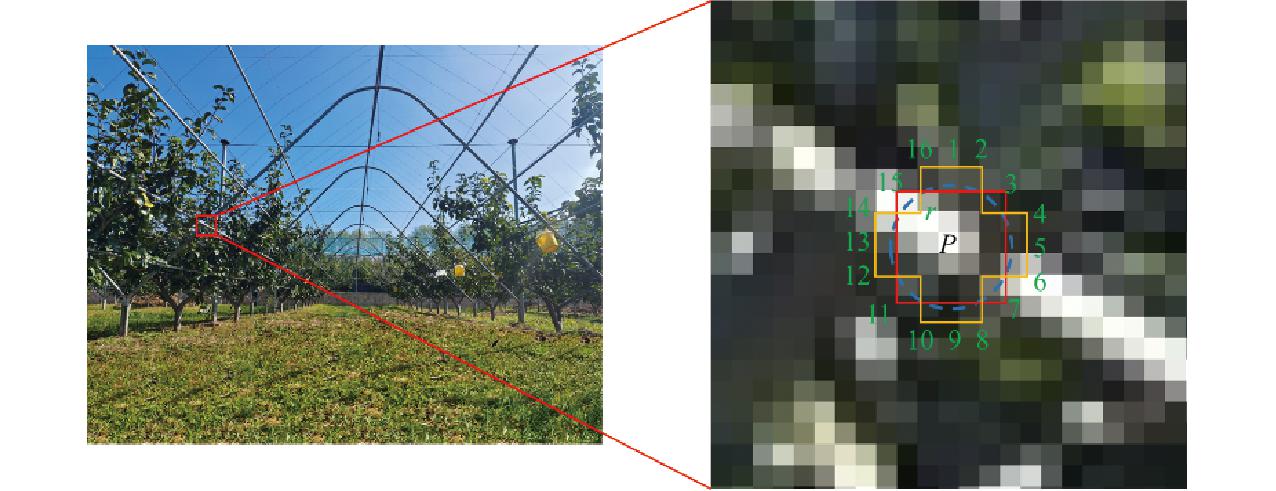

ORB(Oriented FAST and rotated BRIEF)的特征点包括关键点和描述子两部分[22],其关键点为改进的FAST[23]角点,传统FAST关键点提取流程为[24]:选取图像中像素点P(x0,y0),其像素值为I(x0,y0),并设置一个阈值T,其大小为0.2I(x0,y0);以点P为圆心,选择半径r的圆边上的16个点,如图5所示,若这16个像素点中有连续12个点满足

图5 传统ORB特征点提取

Fig.5 Traditional ORB feature point extraction

|I(xi,yi)-I(x0,y0)|>T

(5)

式中 I(xi,yi)——点(xi,yi)处的像素值

则认为该像素点为关键点。

根据上述分析,阈值T可以看作是点P与其邻域内点的对比关系,T越大,则点P周围点在[I(x0,y0)-T,I(x0,y0)+T]内概率越高,即特征点数量越少,反之T越小,特征点数量越多。果园环境易受树叶遮挡,光线变化多端,在光线较弱的环境中,点P与其周围点像素差距很小,特征点数量会急剧减少,不利于果园地图构建与导航[25],对于光线变化十分复杂的环境,特征点匹配过程会增加计算量而降低系统效率。因此,本文设计一种自适应阈值FAST角点提取方法,阈值可以根据图像的总体像素变化情况而改变,首先获取图像的像素均值,然后各点灰度与整体均值进行比较,每幅图像像素对比关系即新阈值T′计算公式为

(6)

其中![]()

(7)

式中 μ——比例系数,取0~1

H、W——图像高度、宽度

![]() 该图像所有点的像素均值

该图像所有点的像素均值

由式(6)可知,该阈值是通过求解图像像素标准差获得,在进行特征点提取时,阴暗光照条件导致图像整体像素标准差偏小,所求解的阈值偏小,因此获得较多特征点;若光照过强,则采用比例系数降低该阈值以获得足够的特征点,初步设定比例系数μ=1和目标特征点数量,遍历所有图像帧,若特征点数量未达到目标值,则以步长0.05减小μ,直到达到目标值或μ=0。保留响应值较大的特征点,完成对特征点的筛选,然后采用高斯金字塔和灰度质心法计算关键点的尺度和方向。

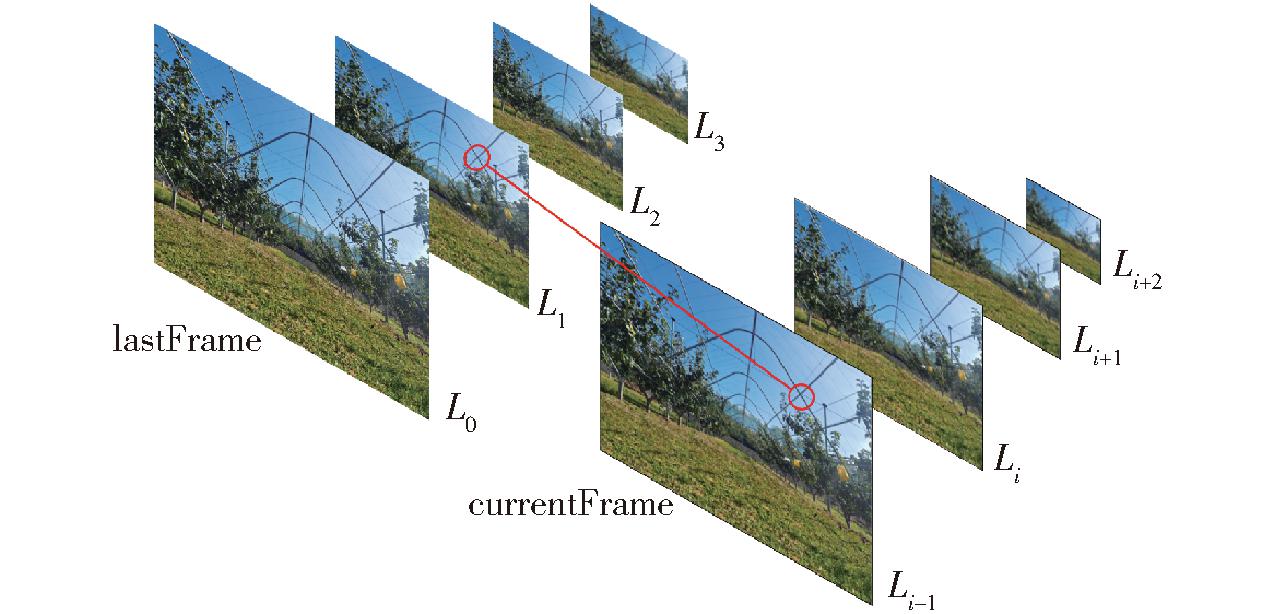

增大图像像素尺寸可以增加特征点检测数量,多尺度图像进行融合可以获得更多的特征点数量,因此对同一图像按照等比例逐层进行扩大和缩放,获得不同分辨率的图像,构建图像高斯金字塔,如图6所示,在特征匹配过程中,通过匹配不同层上的图像,实现尺度不变特性。

图6 高斯图像金字塔

Fig.6 Gaussian image pyramid

假设L0层图像尺寸为H×W,则第Li层图像特征点数量为

(8)

式中 α——缩放因子

Ni——第Li层特征点数量

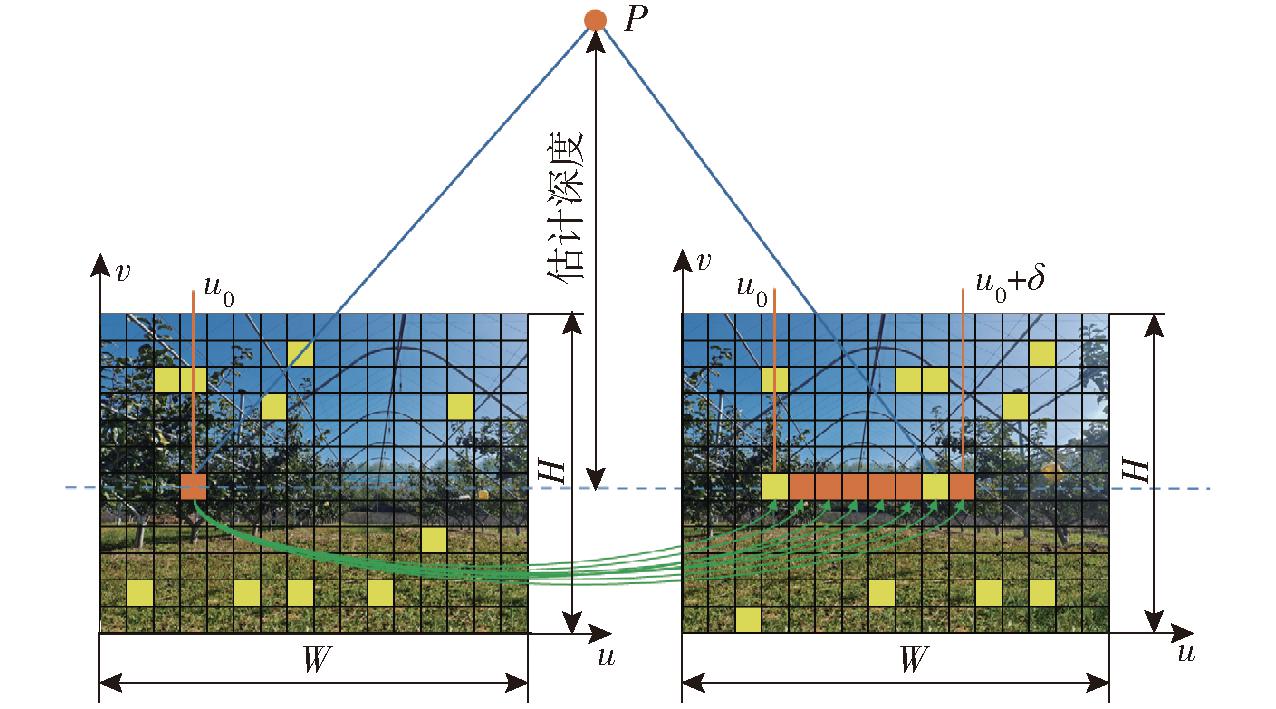

对获得的左右双目图像进行特征点匹配,通过计算左右目视差估计特征点深度(图7),先对右目特征点逐行统计;对于左目图像特征点,根据描述子距离和金字塔层级判断匹配,在右目图像对应带状区域内[minUR, maxUR]搜索,完成粗匹配;对粗匹配获得的匹配点对,以左目特征点为中心获得宽度为W的矩形块,在右目图像中以同样大小建立滑动窗口,通过模块匹配算法计算左右目图像相似度,进而完成精匹配;进行亚像素插值,拟合最佳匹配点与匹配点两侧坐标点曲线;记录右目匹配点和深度信息,对于离群点进行删除。模块匹配算法计算式为

图7 双目匹配示意图

Fig.7 Diagram of binocular matching

SAD(x,y,l)=

(9)

2.2 关键帧提取与位姿估计优化

关键帧的选择对整个建图至关重要,因为其不仅保存二维图像特征点而且会保存三维地图点信息。关键帧选择要在保证稠密建图需求的同时尽可能地减少局部计算量,跟踪线程会产生关键帧并将其传送给局部建图线程,遍历当前帧地图点,基于该地图点观测重新构造共视图,获取与其他关键帧的共视程度并且将超过阈值的按照共视权重进行排序,保存这些关键帧构成的生成树,调整关键帧共视阈值,剔除共视程度相对较低的关键帧,使跟踪检测产生的优质关键帧全部用于稠密建图。

由于相机标定和追踪存在误差,在三维重建和不同关键帧间的位姿估计中产生较大累计误差,影响整体建图精度,因此需要进行优化。优化分为局部优化和全局优化。局部优化时,优化当前关键帧的一级共视关键帧位姿和局部地图点位姿。

全局优化过程中,除第1个关键帧外,其他所有关键帧和三维地图点均参与优化[26]。在相机初始化时,利用对极约束求解相机的运动,对于空间点P1(X1,Y1,Z1,1),根据相机针孔模型得到P1在左右成像平面上的投影点为

(10)

式中 s1、s2——点P1在相机坐标系下的深度

p1、p2——点P1在图像中的像素位置

K——相机内参矩阵

完成特征点提取与匹配,根据特征点估计相机位姿,获得双目图像深度信息,使用非线性最小化投影误差对相机的位姿进行估计,即求解相机旋转矩阵R与平移向量k。本文通过最小化投影误差求解最佳相机位姿。

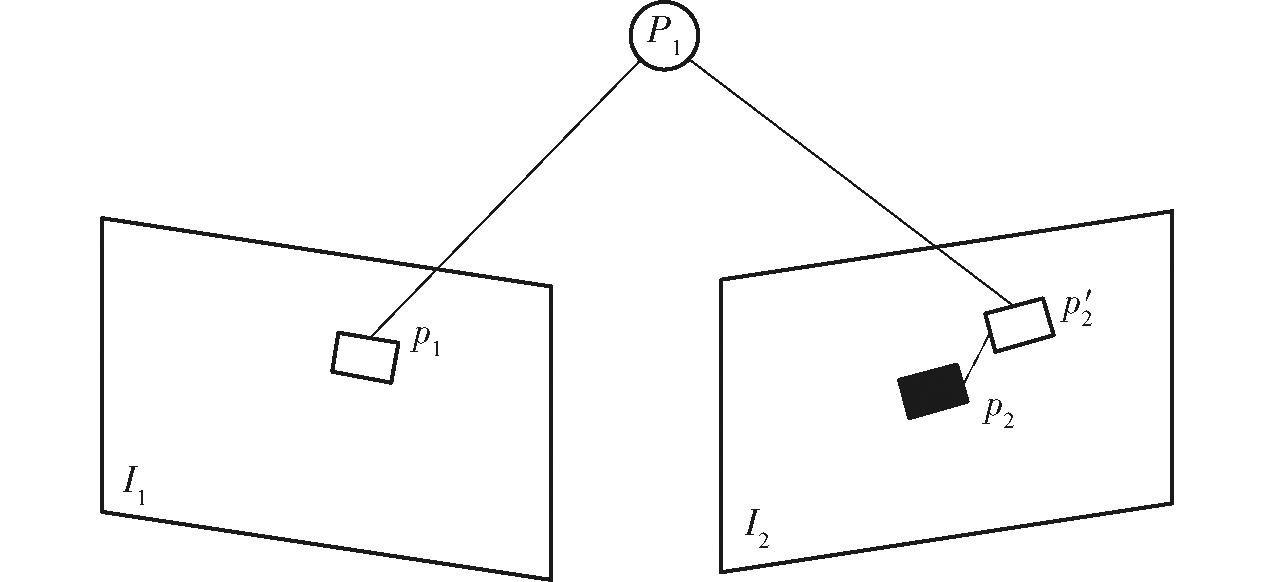

对于空间中n个点,齐次坐标为Pi(Xi,Yi,Zi,1),在图像I1、I2上对应的齐次坐标分别为p1(u1,v1,1)、p′2(u′2,v′2,1),由于误差的存在,在I2上的观测值为p2(u2,v2,1),如图8所示,该空间点在图像中理想重投影满足关系

图8 重投影误差示意图

Fig.8 Diagram of reprojection error

s2u2=KΣ(ξ∧)Pi

(11)

式中 Σ(ξ∧)——相机由图像I1到I2位姿变换矩阵

由于相机位姿未知,加上观测点存在噪声,使得在求解时存在误差,其值为

(12)

对于空间中所有特征点,其误差最小二乘计算公式为

(13)

为了求解最佳相机位姿,需要使得重投影误差最小。

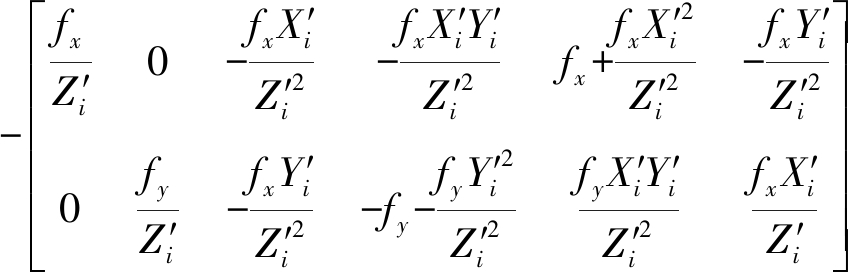

相机坐标系下点Pi的坐标为P′i,取前三维坐标,根据坐标变换关系和链式法则,求解误差相对于位姿的雅可比矩阵,得到

![]() =

=

(14)

其中

![]()

(15)

同理优化特征点的空间位置,有

(16)

2.3 果园三维稠密地图构建

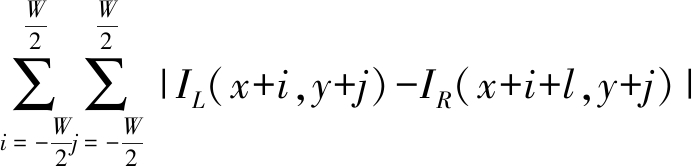

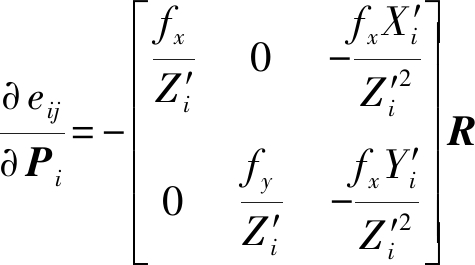

在ORB-SLAM2原有3个线程基础上增加双目稠密建图线程,解决点云稀疏问题,满足后续果园机器人导航需求。稠密建图的基本流程(图9)为:首先对左右目图像关键帧进行匹配获得立体图像对;根据匹配程度和视差选择全局视角,通过立体图像对计算深度信息并进行深度融合获取地图节点;然后对立体图像对进行深度优化获取相机位姿,将相机位姿关联到地图节点;通过对地图节点等进行滤波、拼接等处理生成局部三维地图点云;最后进行全局地图更新。

图9 基于深度图融合的果园稠密点云构建流程

Fig.9 Construction process of orchard dense point cloud based on depth map fusion

在选择全局视角时,要求图像内容尽可能相似,即拥有更多的共同特征点,对于视图I0,对其邻域候选图像集合N={I0,I1,I2,…,IN}中的每一帧进行评价,评价方法为

(17)

式中 gI(I0)——视图I0在候选图像集合中的特征共视评价分数

Q——2幅图像的共视地图点

ωN——2幅图像视差描述因子

ωs——2幅图像在共视点Q处的分辨率相似性

在进行果园稠密建图时,除了进行双目特征匹配外,还要对获取到的局部点云进行拼接处理,该过程包括点云滤波、匹配、加权、剔除噪点等。

将地图点转换为点云坐标,默认相机初始位置为世界坐标原点,获取到的深度图转换为点云的计算过程为

(18)

通过迭代最近点(Iterative closest point, ICP)对点云进行配准,对于源点云pi∈{p0,p1,…,pN},求解其到固定的目标点云qi∈{q0,q1,…,qM}组成曲面的距离,对每个点pi(xi,yi,zi,1)寻找距其最近的点qj(xj,yj,zj,1),计算最小距离

(19)

由于旋转矩阵R与欧拉角有关,平移向量与三维坐标有关,通过最小二乘对相机旋转和平移进行求解,通过迭代计算其收敛性,完成点云配准。

3 果园稠密建图试验

为验证本文算法的有效性,将试验分为数据集仿真、算法性能试验和果园环境稠密地图构建试验3部分,仿真试验选择KITTI官方odometry数据集进行验证,通过EVO测评工具对本文算法和原始算法获得的位姿信息进行比较。果园试验所用计算机为搭载Ubuntu 18.04操作系统的NVIDIA官方Jetson Xavier开发板套件,采用的相机为ZED-stereo型双目立体相机,相较于RGBD,该相机能够很好地应用于室外环境,具有距离远、实时性强、分辨率高等优点,其外部参数如表1所示,对相机标定后获取的内部参数如表2所示。

表1 相机外部参数

Tab.1 External parameters of binocular camera

参数外形尺寸/(mm×mm×mm)深度/m视场角/(°)数据速率/Hz光圈/F数值175.25×30.25×43.100.2~20110(H)×70(V)×120(D)3601.8

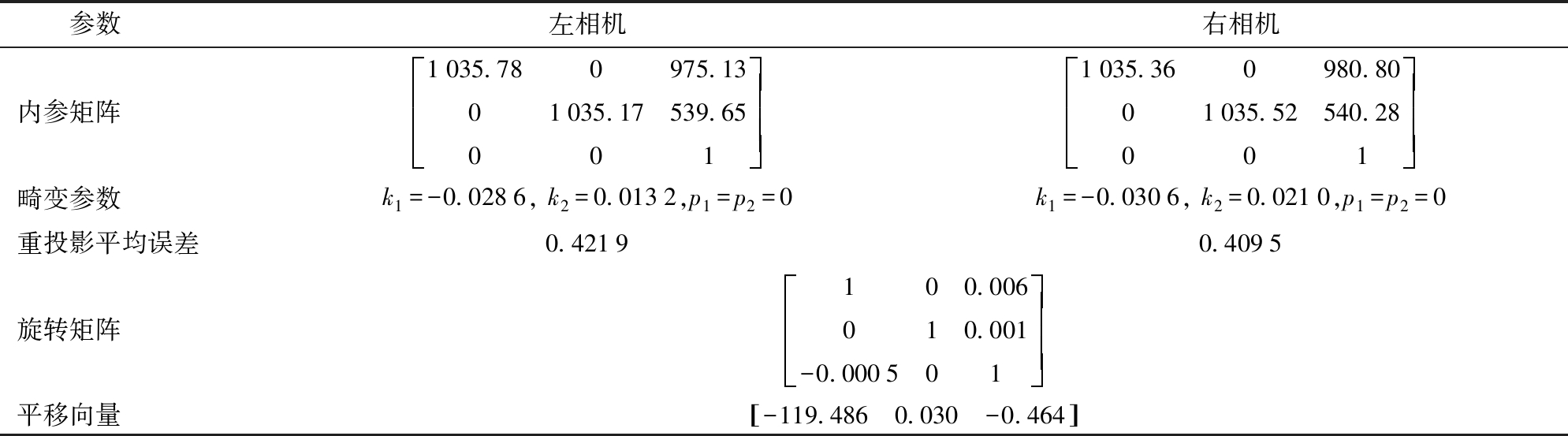

表2 相机内部参数

Tab.2 Intrinsics of binocular camera

参数左相机右相机内参矩阵1035.780975.1301035.17539.65001éëêêêùûúúú1035.360980.8001035.52540.28001éëêêêùûúúú畸变参数k1=-0.0286, k2=0.0132,p1=p2=0k1=-0.0306, k2=0.0210,p1=p2=0重投影平均误差0.42190.4095旋转矩阵100.006010.001-0.000501éëêêêùûúúú平移向量-119.4860.030-0.464[]

3.1 数据集测试

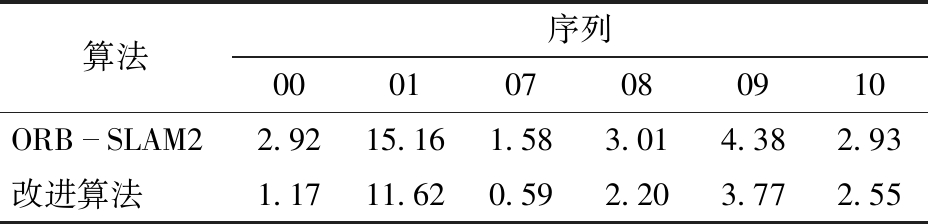

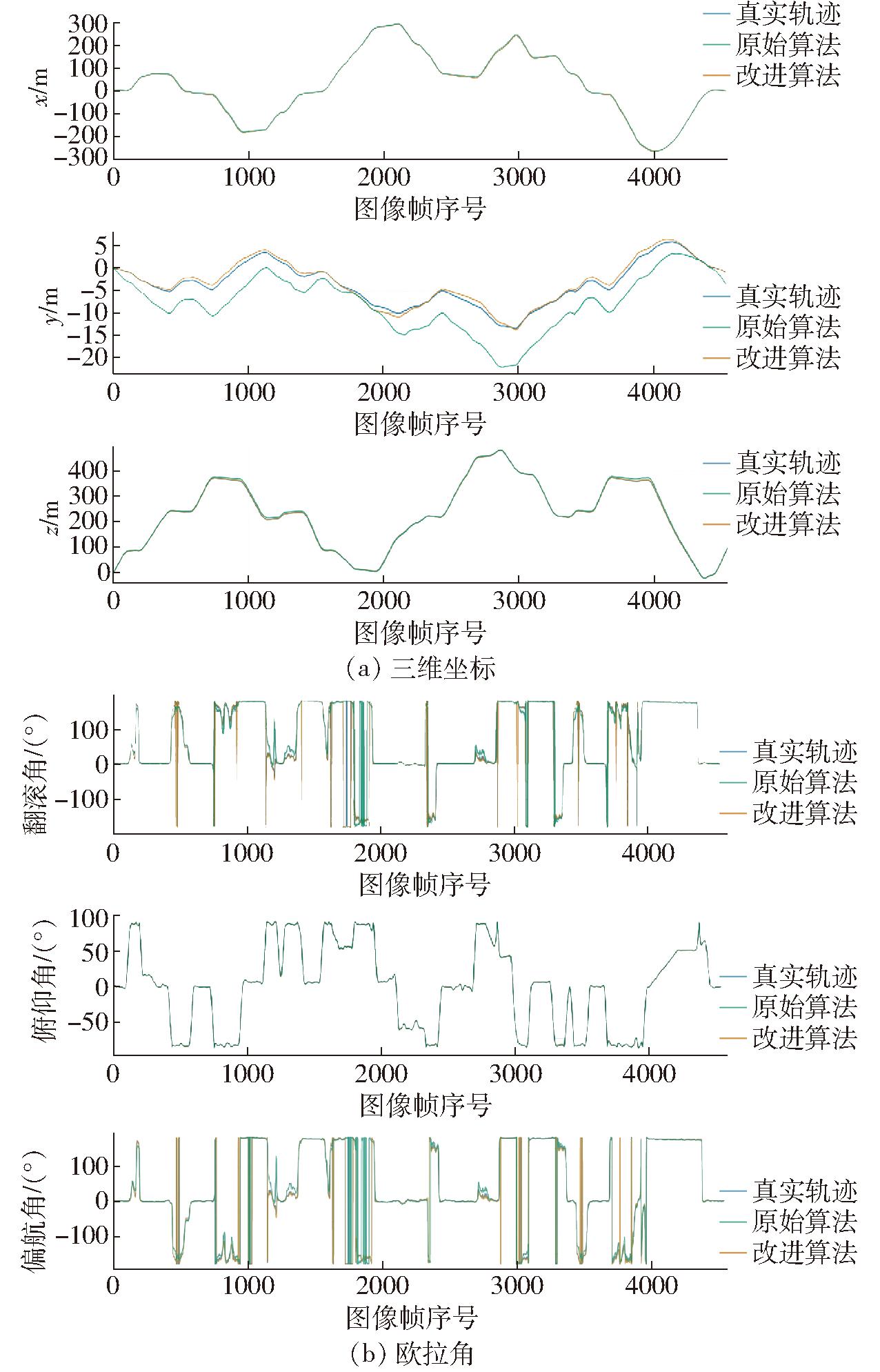

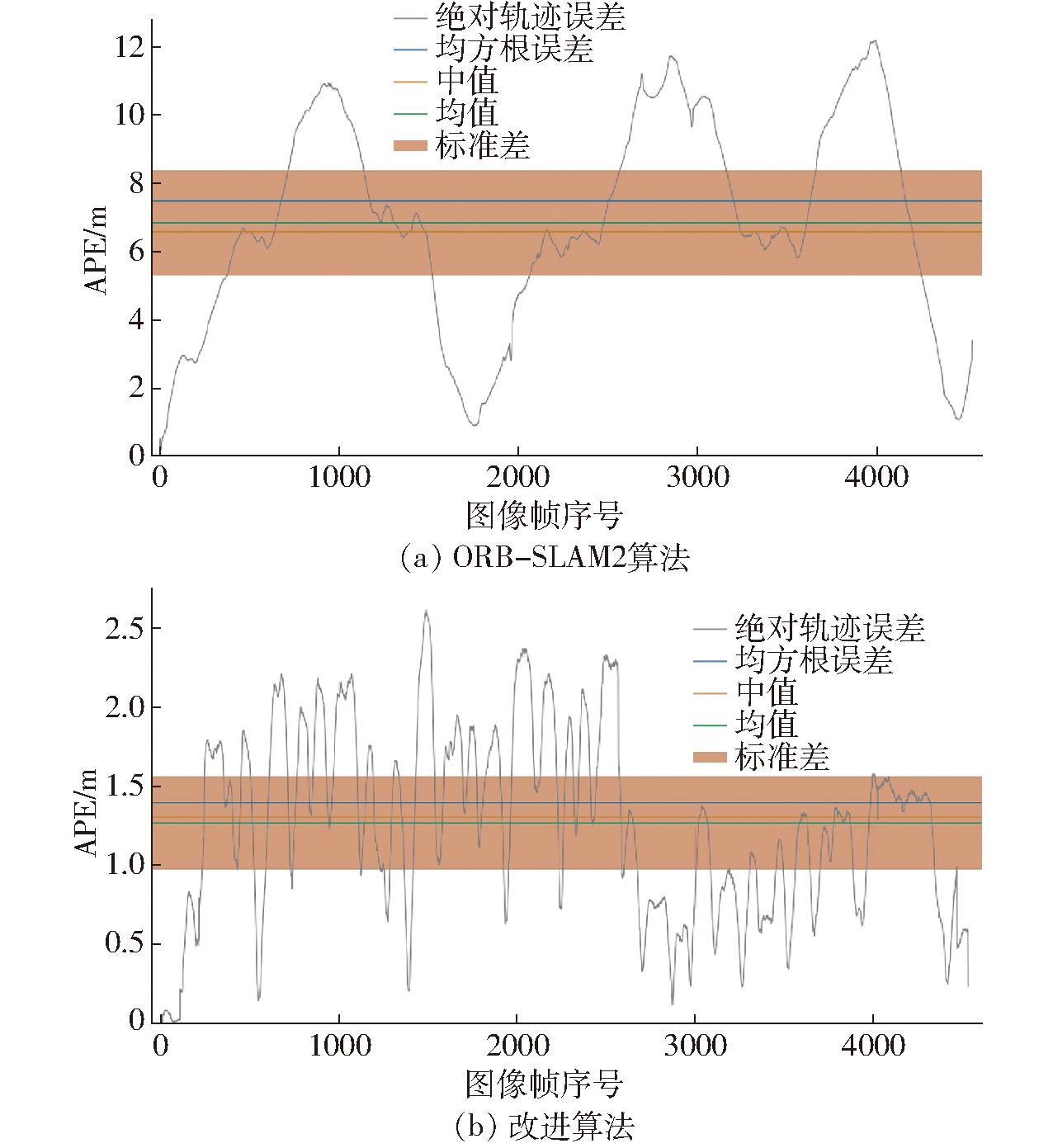

利用KITTI官方odometry中的grayscale数据集00-10序列对原始ORB-SLAM2算法和本文改进的算法进行测试,通过EVO对2种算法的运行轨迹等结果进行评估,比较真实位姿和估计位姿,并计算绝对轨迹误差(APE)均值、最大值和最小值等,图10~12为00序列测试结果,不同序列误差标准差如表3所示。

表3 绝对轨迹误差标准差

Tab.3 Standard deviation of APE m

算法序列000107080910ORBSLAM22.9215.161.583.014.382.93改进算法1.1711.620.592.203.772.55

图10 轨迹误差地图

Fig.10 Error mapped onto trajectory

图11 估计位姿和真实位姿比较

Fig.11 Comparison of estimated pose and true pose

图12 绝对误差

Fig.12 The absolute error

通过图10~12和表3可知,本文改进的ORB-SLAM2算法较原始算法绝对轨迹误差更加收敛,其中在KITTI数据集00和07序列绝对轨迹误差标准差分别下降60.5%和62.6%,在其他序列分别不同程度下降,表明本文改进算法相较原始算法定位精度有所提高。

3.2 果园行间稠密建图试验

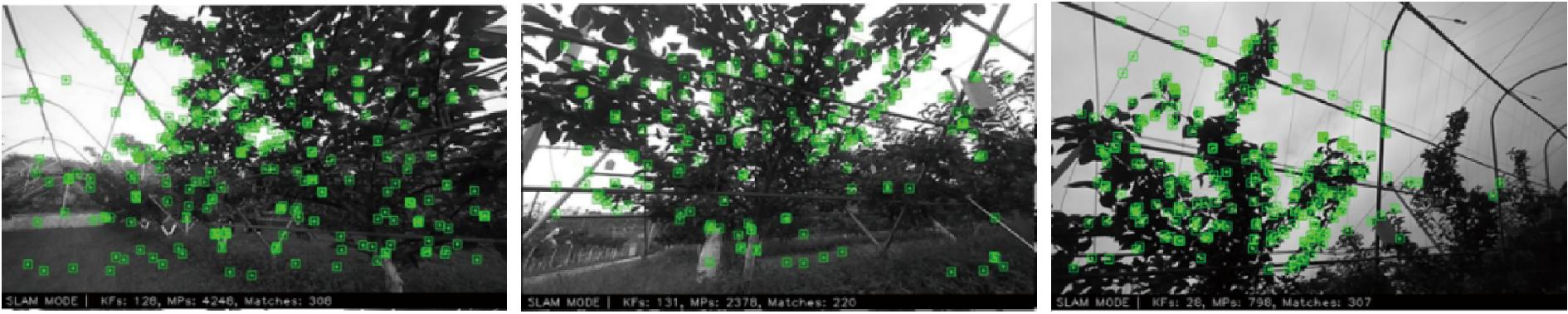

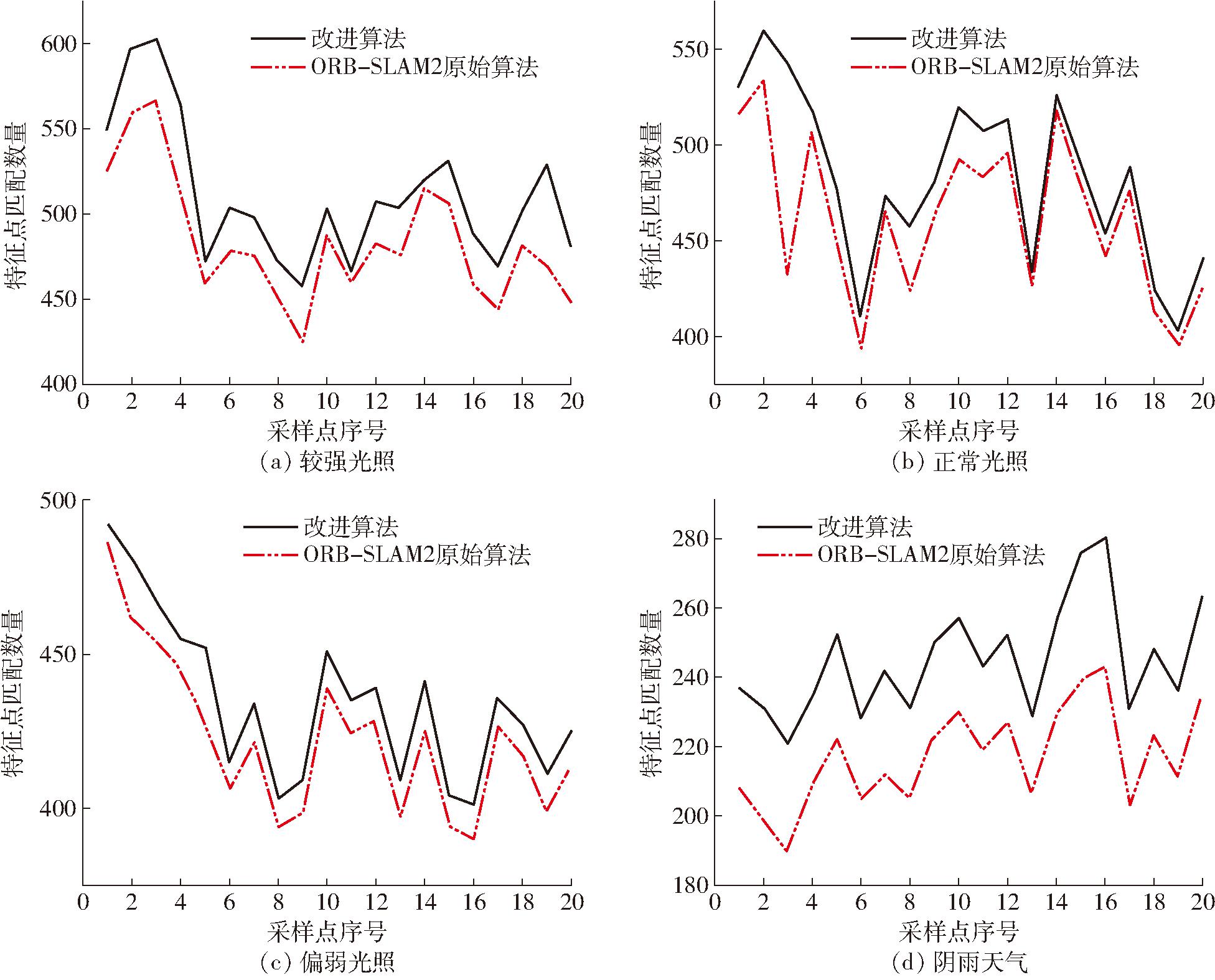

为进一步验证本文算法的基本性能和果园行间稠密建图的有效性,选择在南京农业大学浦口校区内进行模拟试验和江苏省农业科学院梨园内进行果园实地试验,梨园主要树型为Y型棚架,行距6 m、株距1.5 m(含棚架),选择不同光照条件进行直线定位、特征点匹配测试,并进行果园稠密地图构建试验。

3.2.1 光照测试

选择较强光照、正常光照、偏弱光照和阴雨天气验证本文算法在不同光条件下的性能,选取20个采样点,分别获取不同场景下匹配特征点数量,测试结果如图13、14和表4所示。在4种不同光照条件下,本文所改进算法较原始算法,特征点匹配数量平均分别增加5.32%、4.53%、8.93%、12.91%,表明不同光照时都有一定程度的增加,在光线较暗条件下增加尤为明显,说明该算法较原始算法有更好的光照适应性。

表4 特征点匹配数量

Tab.4 Number of matching feature points

算法较强光照正常光照偏弱光照阴雨天气ORBSLAM2485.20461.30399.30216.85改进算法511.00482.25434.95244.85特征点平均增加率/%5.324.538.9312.91

图13 特征点匹配效果(部分)

Fig.13 Feature point matching

图14 不同光照条件下特征点匹配数量

Fig.14 Number of feature points matching under different lighting conditions

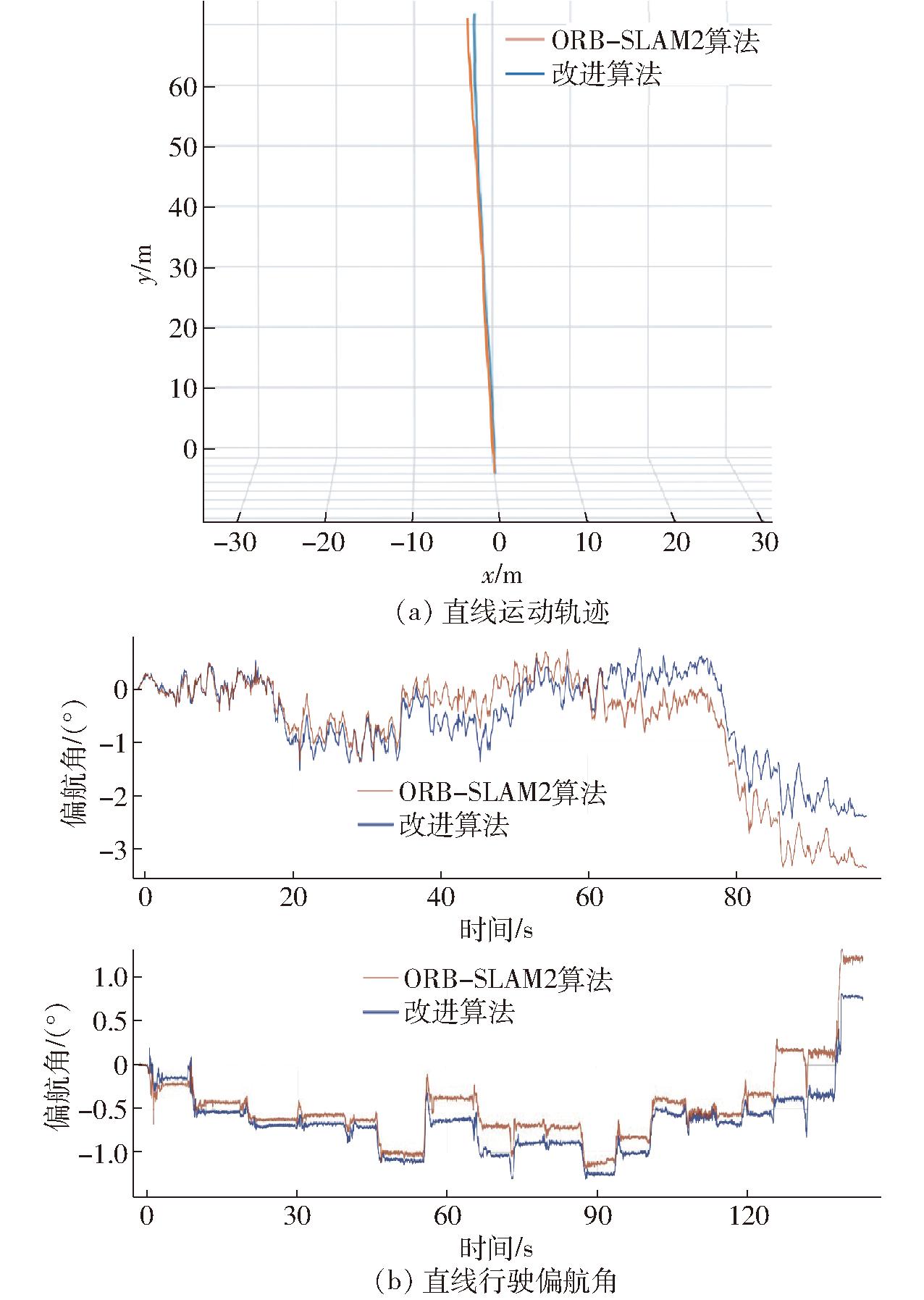

选取果园内某一行进行直线行驶试验,使机器人在果树行中间匀速行驶,获取行驶过程中相机位姿等信息,并与原始算法进行对比,结果如图15、16所示。

图15 果园行间直线行驶定位试验

Fig.15 Driving by straight line in orchard

根据图16b可知,本文改进算法相较于原始算法偏航角更加收敛,表明机器人位姿更加稳定,本文算法更能反映机器人真实位姿。记录行驶过程中关键帧匹配数量和平均跟踪时间如表5所示,结果表明,本文改进算法关键帧提取数量较原始算法下降2.86%,平均跟踪时间减少39.3%。

表5 关键帧提取情况

Tab.5 Key frame extraction

算法关键帧数/帧平均跟踪时间/sORBSLAM25240.089改进算法5090.054

图16 直线行驶位置信息

Fig.16 Position information for straight driving

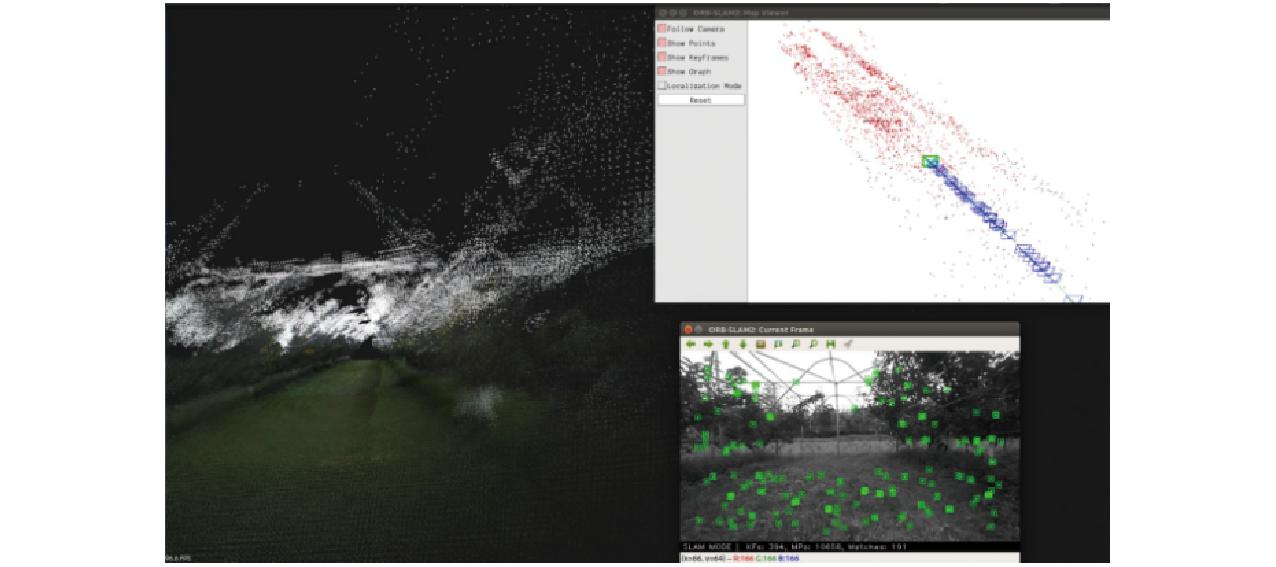

3.2.2 稠密地图构建

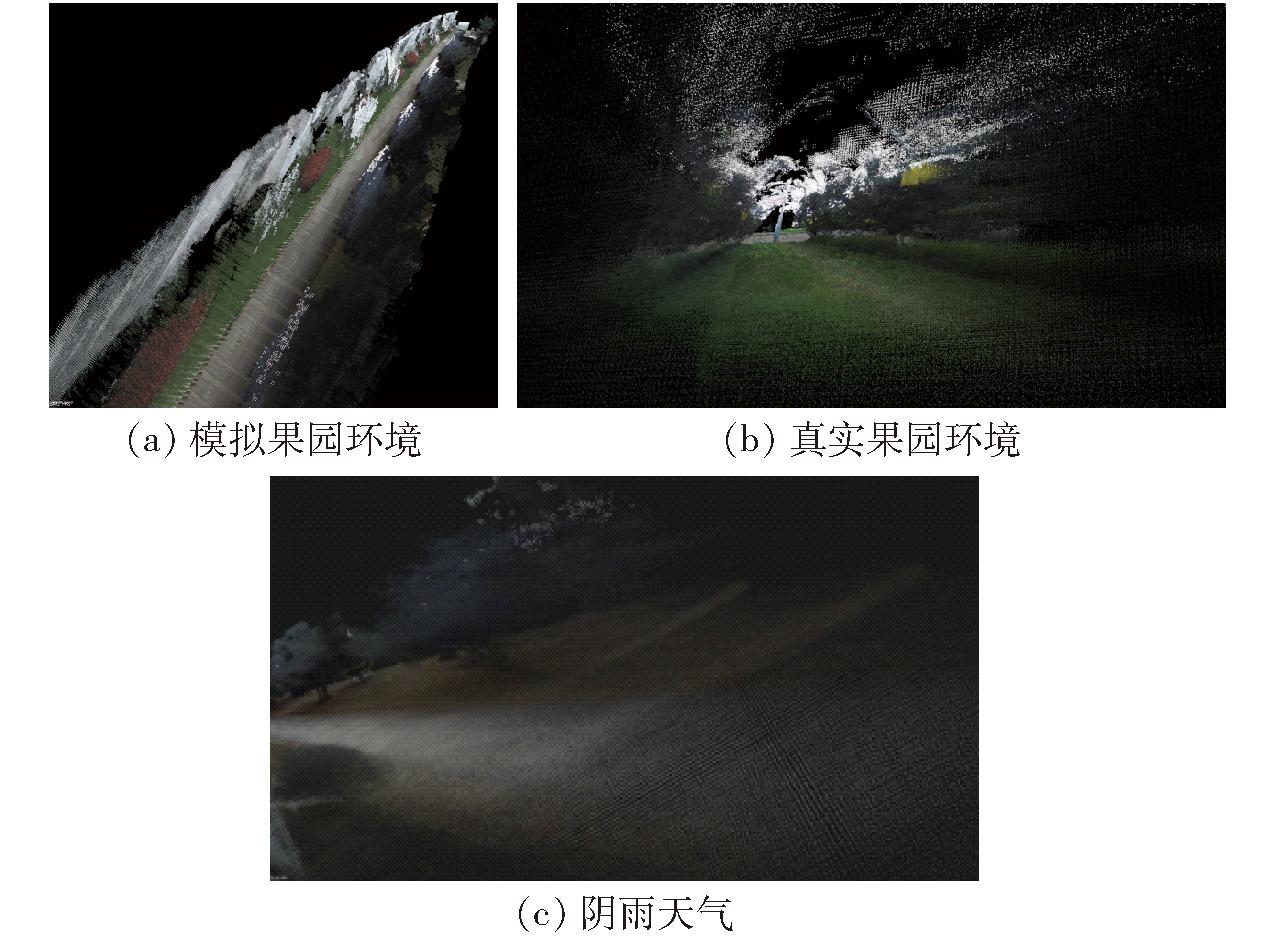

分别进行模拟果园环境试验、果园行间实地建图试验和阴雨天气试验,模拟果园环境试验和阴雨天气试验时,选择学校灌木丛进行测试,结果如图17所示。

图17 不同场景稠密地图构建

Fig.17 Dense map construction in different scenarios

由图17可知,本文算法能够适应阴暗光照条件,满足果园环境的稠密建图需求,所建成的点云地图与真实环境基本吻合,因此,本文算法具备较强的果园三维稠密点云地图构建能力。

综上,相较于原始算法,本文所改进的算法轨迹误差有明显下降,能够更好地拟合机器人位姿信息,适应不同光照、不同环境信息,很好地反映果园真实环境信息,满足果园三维稠密点云地图构建需求。

4 结论

(1)提出一种自适应阈值的FAST角点提取方式,搭建了基于双目深度图融合的稠密建图模块,实现了果园行间的三维稠密地图构建。

(2)基于KITTI数据集进行了不同序列上的仿真测试,并且将本文所提算法与原始ORB-SLAM2算法进行了比较,结果表明本文所提算法绝对轨迹误差标准差在不同序列上均有不同程度下降,其中在00序列和07序列分别下降60.5%和62.6%,表明本文算法估计的位姿更接近相机真实位姿,精确度更高。

(3)在较强光照、正常光照、偏弱光照和阴雨天不同光照条件下,本文所提算法的特征点匹配数量较原始算法分别提高5.32%、4.53%、8.93%、12.91%,表明本文所提算法能较好适应不同光照条件。

(4)果园环境下进行了直线行驶和稠密建图试验。直线行驶试验表明,本文所提算法提取的关键帧数量较原始算法下降2.86%,平均跟踪时间减少39.3%,定位精确度更高,能够很好地反映机器人位姿信息。稠密建图试验表明,在果园中能够很好地进行果树等特征点匹配,稠密建图效果良好。

(5)本文所提算法无论是在基本性能还是在果园地图构建效果方面较原始算法都有很大提高,可为果园中作业机器人自主导航提供技术支持。

[1] LIU H, ZHANG G, BAO H. A survey of monocular simultaneous localization and mapping[J]. Journal of Computer-Aided Design &Computer Graphics, 2016, 28(6):855-868.

[2] YUN S, TING W, SHILIANG S, et al. GR-LOAM: LiDAR-based sensor fusion SLAM for ground robots on complex terrain[J]. Robotics and Autonomous Systems, 2021, 140(5):103759.

[3] 薛金林, 王培晓, 周俊, 等. 基于改进Gmapping算法的果园二维环境地图精准构建[J]. 农业机械学报, 2023, 54(7):26-34, 55.XUE Jinlin, WANG Peixiao, ZHOU Jun, et al. Accurate construction of orchard two-dimensional environmental map based on improved Gmapping algorithm[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(7):26-34, 55. (in Chinese)

[4] 耿丽杰, 顾健, 别晓婷,等. 基于Scan Context与NDT-ICP相融合的果园建图方法研究[J]. 中国农机化学报, 2022, 43(7):44-50.GENG Lijie, GU Jian, BIE Xiaoting, et al. Research on orchard SLAM method based on Scan Context and NDT-ICP fusion[J]. Journal of Chinese Agricultural Mechanization, 2022,43(7): 44-50. (in Chinese)

[5] PIERZCHA A M, GIGUèRE P, ASTRUP R. Mapping forests using an unmanned ground vehicle with 3D LiDAR and graph-SLAM[J]. Computers and Electronics in Agriculture, 2018, 145:217-225.

A M, GIGUèRE P, ASTRUP R. Mapping forests using an unmanned ground vehicle with 3D LiDAR and graph-SLAM[J]. Computers and Electronics in Agriculture, 2018, 145:217-225.

[6] 丛佩超, 崔利营, 万现全, 等. 基于改进ORB-SLAM2的果园喷药机器人定位与稠密建图算法[J]. 农业机械学报, 2023, 54(7):45-55.CONG Peichao, CUI Liying, WAN Xianquan, et al. Localization and dense mapping algorithm for orchard spraying robot based on improved ORB-SLAM2[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(7):45-55. (in Chinese)

[7] CHEN Mingyou, TANG Yunchao, ZOU Xiangjun, et al. 3D global mapping of large-scale unstructured orchard integrating eye-in-hand stereo vision and SLAM[J]. Computers and Electronics in Agriculture, 2021, 187:106237.

[8] LIU Tianhao, KANG Hanwen, CHEN Chao. ORB-Livox: a real-time dynamic system for fruit detection and localization[J]. Computers and Electronics in Agriculture, 2023, 209:107834.

[9] 尹艺杰, 李宁, 王超. 基于多传感器融合的同步定位与建图方法研究[J]. 传感器与微系统, 2023, 42(8):54-57.YIN Yijie, LI Ning, WANG Chao. Research on SLAM method based on multi-sensor fusion[J]. Transducer and Microsystem Technologies,2023,42(8):54-57. (in Chinese)

[10] 罗亮, 谈莉斌, 余晓流, 等. 一种融合二维激光雷达和RGB-D相机的移动机器人建图方法研究[J]. 制造业自动化, 2023, 45(4):137-140, 190.LUO Liang, TAN Libin, YU Xiaoliu, et al. Research on a mobile robot mapping method based on the fusion of 2D LiDAR and RGB-D camera[J]. Manufacturing Automation, 2023,45(4):137-140, 190. (in Chinese)

[11] BAI Yuhao, ZHANG Baohua, XU Naimin, et al. Vision-based navigation and guidance for agricultural autonomous vehicles and robots: a review[J]. Computers and Electronics in Agriculture, 2023, 205(3):1-15.

[12] DAVISON A J, REID I D, MOLTON N D, et al. MonoSLAM: real-time single camera SLAM[J]. IEEE Computer Society, 2007, 29(6):1052-1067.

[13] MUR-ARTAL R, MONTIEL J M M, TARDOS J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. 2015,31(5):1147-1163.

[14] FORSTER C, PZZOL M, SCARAMUZZA D. SVO: fast semi-direct monocular visual odometry[C]∥International Conference on Robotics &Automation,2014.

[15] NEWCOMBE R A, LOVEGROVE S J, DAVISON A J. DTAM: dense tracking and mapping in real-time[C]∥International Conference on Computer Vision IEEE Computer Society, 2011.

[16] LABBE M, MICHAUD F. Online global loop closure detection for large-scale multi-session graph-based SLAM[C]∥RSJ International Conference on Intelligent Robots and Systems. IEEE, 2014.

[17] MUR-ARTAL R, TARD S J D. ORB-SLAM2: an open-source SLAM system for monocular, stereo, and RGB-D cameras[J]. IEEE Transactions on Robotics, 2017, 33(5):1255-1262.

S J D. ORB-SLAM2: an open-source SLAM system for monocular, stereo, and RGB-D cameras[J]. IEEE Transactions on Robotics, 2017, 33(5):1255-1262.

[18] 董蕊芳,王宇鹏,阚江明.基于改进ORB-SLAM2的机器人视觉导航方法[J].农业机械学报,2022,53(10):306-317.DONG Ruifang, WANG Yupeng, KAN Jiangming. Visual navigation method for robot based on improved ORB-SLAM2[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(10):306-317. (in Chinese)

[19] LI Y, SONG G, HAO S, et al. Semantic stereo visual SLAM toward outdoor dynamic environments based on ORB-SLAM2[J]. The Industrial Robot,2023,50(3):542-554.

[20] 徐武, 高寒, 王欣达, 等. 改进ORB-SLAM2算法的关键帧选取及地图构建研究[J]. 电子测量技术, 2022, 45(20):143-150.XU Wu, GAO Han, WANG Xinda, et al.Research on key frame selection and map construction of improved ORB-SLAM2 algorithm[J]. Electronic Measurement Technology, 2022,45(20):143-150. (in Chinese)

[21] DAVISON A J, REID I D. Mnocular depth cues and techniques for 3D computer vision[J]. Artificial Intelligence Review,1998,12(5-6): 331-376.

[22] 高翔,张涛,刘毅,等. 视觉SLAM十四讲:从理论到实践[M]. 北京: 电子工业出版社, 2019.

[23] ROSTEN E. Machine learning for high-speed corner detection[C]∥Proceedings of the European Conference on Computer Vision, Springer-Verlag, 2006.

[24] 朱晏辰. 基于SLAM的非合作目标相对位姿测量研究[D]. 哈尔滨:哈尔滨工业大学, 2018.ZHU Yanchen. Research on measurement of relative pose for non-cooperative space targets based on SLAM[D]. Harbin: Harbin Institute of Technology,2018. (in Chinese)

[25] 欧伟贤, 夏益民, 蔡述庭, 等. 基于改进ORB特征提取匹配与关键帧选择的VSLAM[J]. 工业控制计算机, 2023, 36(5):83-86.OU Weixian, XIA Yimin, CAI Shuting, et al. VSLAM based on improved ORB feature extraction matching and keyframe selection[J]. Industrial Control Computer,2023,36(5):83-86. (in Chinese)

[26] 林炜. 基于双目立体视觉的空间稀疏特征环境建图研究[D]. 北京:华北电力大学(北京), 2017.LIN Wei. Map-building research on spatial sparse feature based on stereo vision[D]. Beijing:North China Electric Power University(Beijing),2017.(in Chinese)