2022年,我国香梨产量突破1.8×107 t,成为果农主要的经济收入来源之一。目前香梨采摘方式主要依靠手工采摘,费时费力,效率低,很难满足作业周期短、采摘任务重、采摘需求急的要求[1]。在现代农业生产实践中,农产品采摘方式正逐渐向机械化和智能化方向发展,更多的机器人开始投入生产实际,并逐渐取代了传统的人工劳作。然而,在自然环境中,由于天气、光线、果实颜色与背景相似,果实和枝干之间相互遮挡等问题的影响,极大地增加了水果目标检测难度。

随着计算机算力的不断增强,深度学习技术在目标检测这一领域展现出了显著的优势[2]。相较于传统的目标检测方法,深度卷积神经网络能够自动地从其训练数据中提取多个层次的特征,使得该模型展现出更高的泛化和特征提取能力[3-4]。YONG等[5]提出了一种多簇猕猴桃果实识别算法,其识别准确率达到94.78%。黄小玉等[6]提出桃子检测模型,该方法是以MTCNN(多任务卷积神经网络算法)为主干的一种网络,对成熟桃子的检测准确率达到89.3%。HE等[7]提出SPP-Net网络,从之前的单一尺度输入变为了效率更高的多尺度输入。REN等[8]提出了Faster R-CNN网络弥补目标检测速度慢的问题。REDMON 等[9]提出了速度更快的网络模型YOLO,但这种方法检测精度低。后续研究者提出了YOLO v2、YOLO v3、YOLO v4和YOLO v5等来改进检测精度低的问题,但这些网络模型在小目标检测上表现欠佳。随着目标检测技术的不断发展,TIAN等[10]提出了一种改进的YOLO v3模型,用于在不同光照条件、复杂背景以及遮挡等情况下检测不同成熟度的苹果。王立舒等[11]提出一种改进 YOLO v4-Tiny的蓝莓成熟度识别方法,该方法在遮挡与光照不均等复杂场景中平均精度较高。LÜ等[12]提出了一种轻量级的目标检测YOLO v5-CS 模型,在YOLO v5 网络中加入了注意力模块,自然环境中对绿色柑橘识别准确率达98.23%。YOLO v7引入了结构重参数化和动态标签分配,使得模型具有更快的速度和更高的精度,同时具备更强的鲁棒性,能很好地应对光线不足和遮挡情况下的目标检测,在智慧农业各领域中得到了广泛的应用[13]。虽然,目标检测在农副产品检测研究领域已取得了良好的效果,但对于水果目标检测而言,其精度与速度仍需提升,当检测距离远且有遮挡时,会产生漏检与误检等现象。

针对现有目标检测模型对自然环境中香梨检测精度不佳的问题,本文提出一种改进的M-YOLO v7-SCSN+F成熟期香梨目标检测模型。该模型将YOLO v7-5的骨干网络替换为轻量级的MobileNetv3网络,并在特征融合层中引入协同注意力机制(Coordinate attention, CA)模块,以增强网络的特征表达能力,通过实验对比将原YOLO v7中的损失函数CIoU替换为SIoU,并与Normalized Wasserstein distance (NWD)小目标检测机制联合使用,以进一步提高香梨检测精度。同时使用傅里叶变换的数据增强方法[14],分析图像频域信息,重新构建图像的振幅分量来生成新的图像信息。

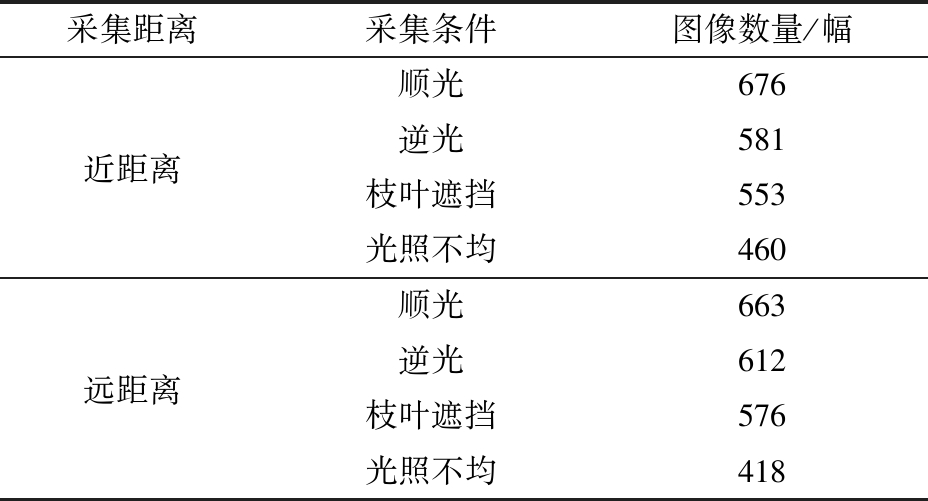

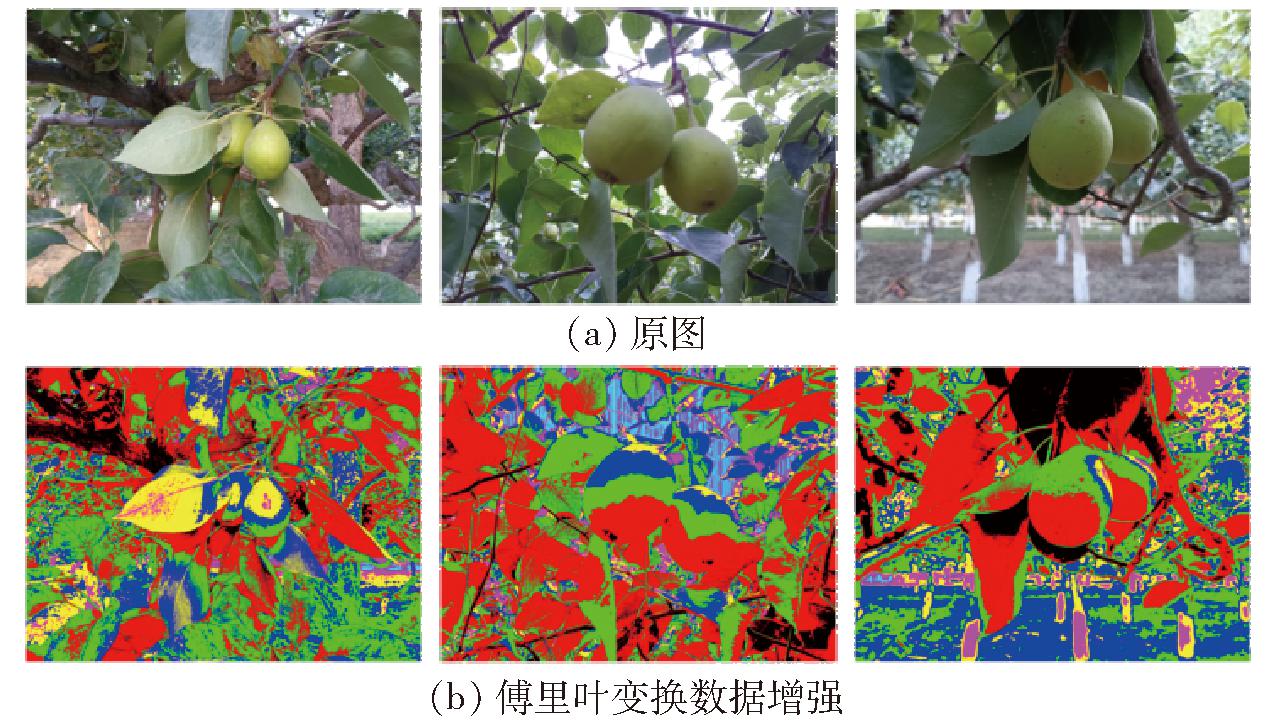

所用的香梨数据集拍摄于塔里木大学园艺实验站新梨7号实验区,研究对象为成熟期新梨7号香梨。实验所用图像使用佳能EOS 77D型相机拍摄,针对智能机器人采摘梨果时遇到的采摘距离不同,光照强弱不均的情况,数据采集设计了远距离(距离为50~100 cm)和近距离(距离为10~30 cm)2种图像拍摄模式,拍摄时间选择在07:00—08:00、13:00—14:00、18:00—19:00 3个时间段,拍摄时间选择在8月15—30日,此时段为香梨成熟期但还未采摘。实验共采集香梨图像4 539幅,其中近距图像2 270幅,远距图像2 269幅,采集图像信息见表1、图1。

图1 不同场景香梨图像

Fig.1 Images of pear in different scenes

表1 采集图像信息

Tab.1 Details of acquired images

采集距离采集条件图像数量/幅顺光676近距离逆光581枝叶遮挡553光照不均460顺光663远距离逆光612枝叶遮挡576光照不均418

为了改善网络训练效果和提高模型泛化能力,采用随机翻转、剪裁、Mosaic 算法和Mixup算法[15]、傅里叶变换频域数据增强算法[16]等数据增广方法增加样本数量。图像增广后数据集共8 631幅,以7∶2∶1划分训练集(6 042幅)、测试集(1 726幅)和验证集(863幅)进行模型训练和测试。

使用 Win10 操作系统,GPU型号为NVIDIA GeForce RTX-3090,处理器型号为Intel(R) Core(TM)i7-12700KF 3.60 GHz,深度学习框架为 PyTorch 2.0,编程平台为 PyCharm,编程语言为 Python 3.8,所有对比算法均在相同环境下运行。为提高网络训练效率,本实验采用冻结训练和解冻训练2种方法进行。冻结骨干网络训练时初始学习率设为0.01,批量大小(Batchsize)设为16,动量设为0.93;解冻后网络训练学习率设为 0.01,Batchsize设为8,动量设为0.93,迭代次数为300。

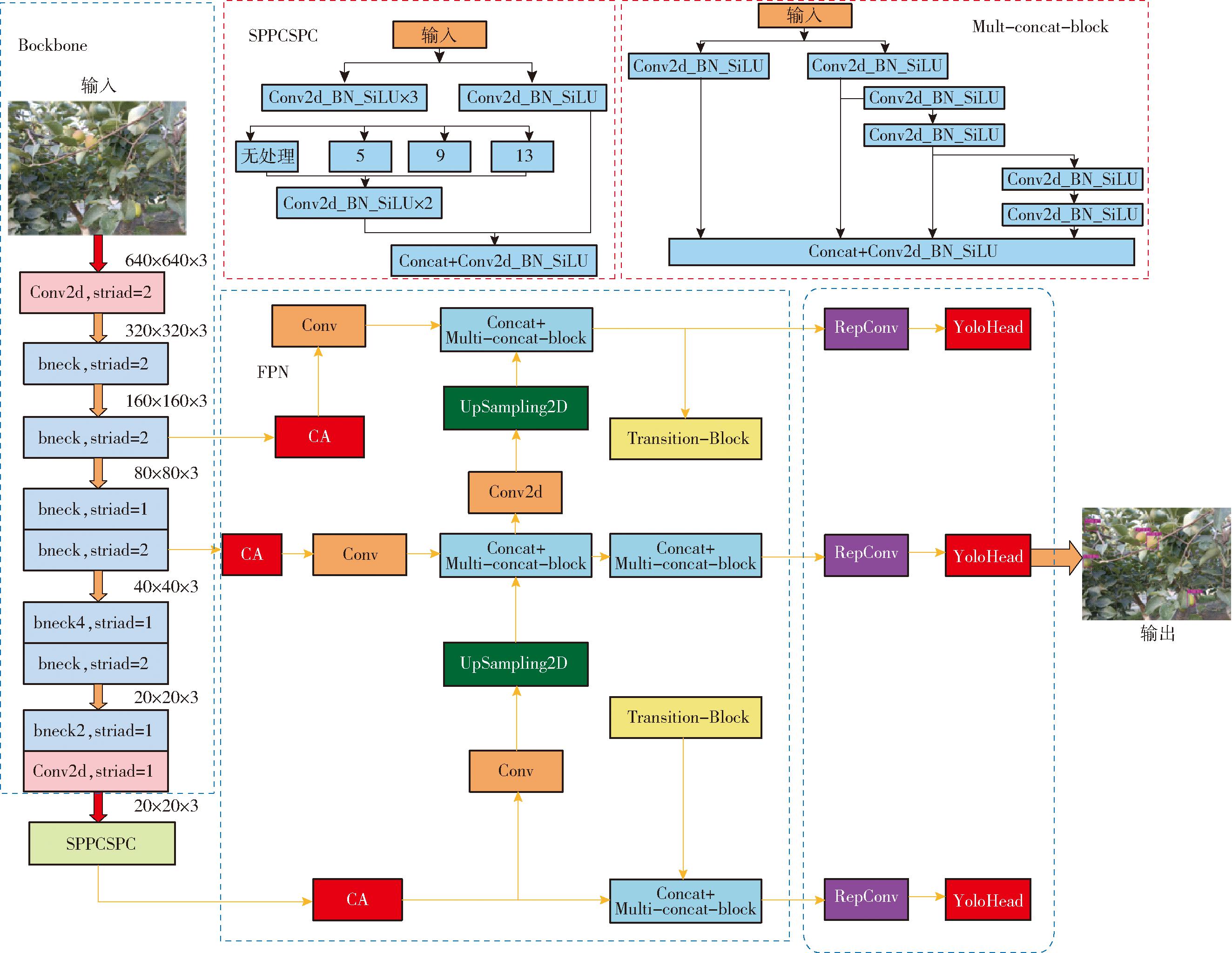

为了解决在自然环境下香梨果实受光照和其他环境因素的影响,检测效果不佳的问题,本研究对YOLO v7-S模型进行了改进,模型将MobileNetv3引入YOLO v7-S模型中作为其骨干特征提取网络,同时在特征融合层中引入协同注意力机制(Coordinate attention, CA)模块,将YOLO v7-S中的损失函数CIoU替换为SIoU,与Normalized Wasserstein distance (NWD)小目标检测机制联合使用。实验采用傅里叶变换(Fourier transform,FT)的数据增强方法,进一步提升模型泛化能力。为描述方便,将本改进方法简称为M-YOLO v7-SCSN+F。改进的M-YOLO v7-SCSN+F模型如图2所示。

图2 改进的M-YOLO v7-SCSN+F模型图

Fig.2 Diagram of improved M-YOLO v7-SCSN+F network model

2.1.1 YOLO v7-S模型主干网络替换

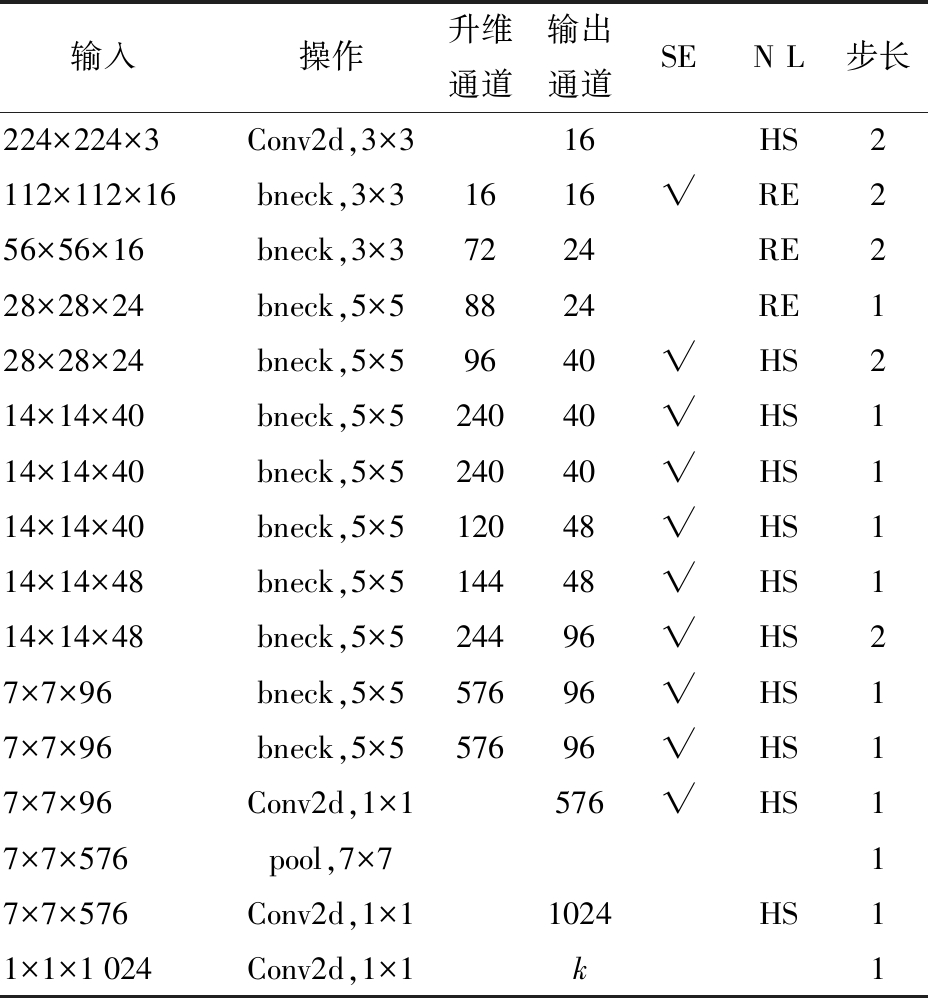

为了使改进的YOLO v7-S模型更符合生产实际,使用MobileNetv3 网络作为YOLO v7模型的骨干网络实现特征提取。MobileNetv3 网络与传统卷积神经网络相比,在准确率小幅降低的前提下大大减少了模型参数量与运算量[17],实现模型轻量化,更有利于部署在移动端,其网络参数设计如表2所示。MobileNetv3 在主干网络中加入了注意力机制(Squeezeand excitation networks, SE)模块[18],使用深度可分离卷积(Depthwise separable convolutions)和逆残差结构(Inverted residual with linear bottleneck)。同时使用H-Swish激活函数代替Swish激活函数,提高了模型性能。

表2 MobileNetv3(small) 网络参数

Tab.2 MobileNetv3(small) network parameters

注:“√”表示本层引入SE模块。

输入操作升维通道输出通道SEN L步长224×224×3Conv2d,3×316HS2112×112×16bneck,3×31616√RE256×56×16bneck,3×37224RE228×28×24bneck,5×58824RE128×28×24bneck,5×59640√HS214×14×40bneck,5×524040√HS114×14×40bneck,5×524040√HS114×14×40bneck,5×512048√HS114×14×48bneck,5×514448√HS114×14×48bneck,5×524496√HS27×7×96bneck,5×557696√HS17×7×96bneck,5×557696√HS17×7×96Conv2d,1×1576√HS17×7×576pool,7×717×7×576Conv2d,1×11024HS11×1×1024Conv2d,1×1k1

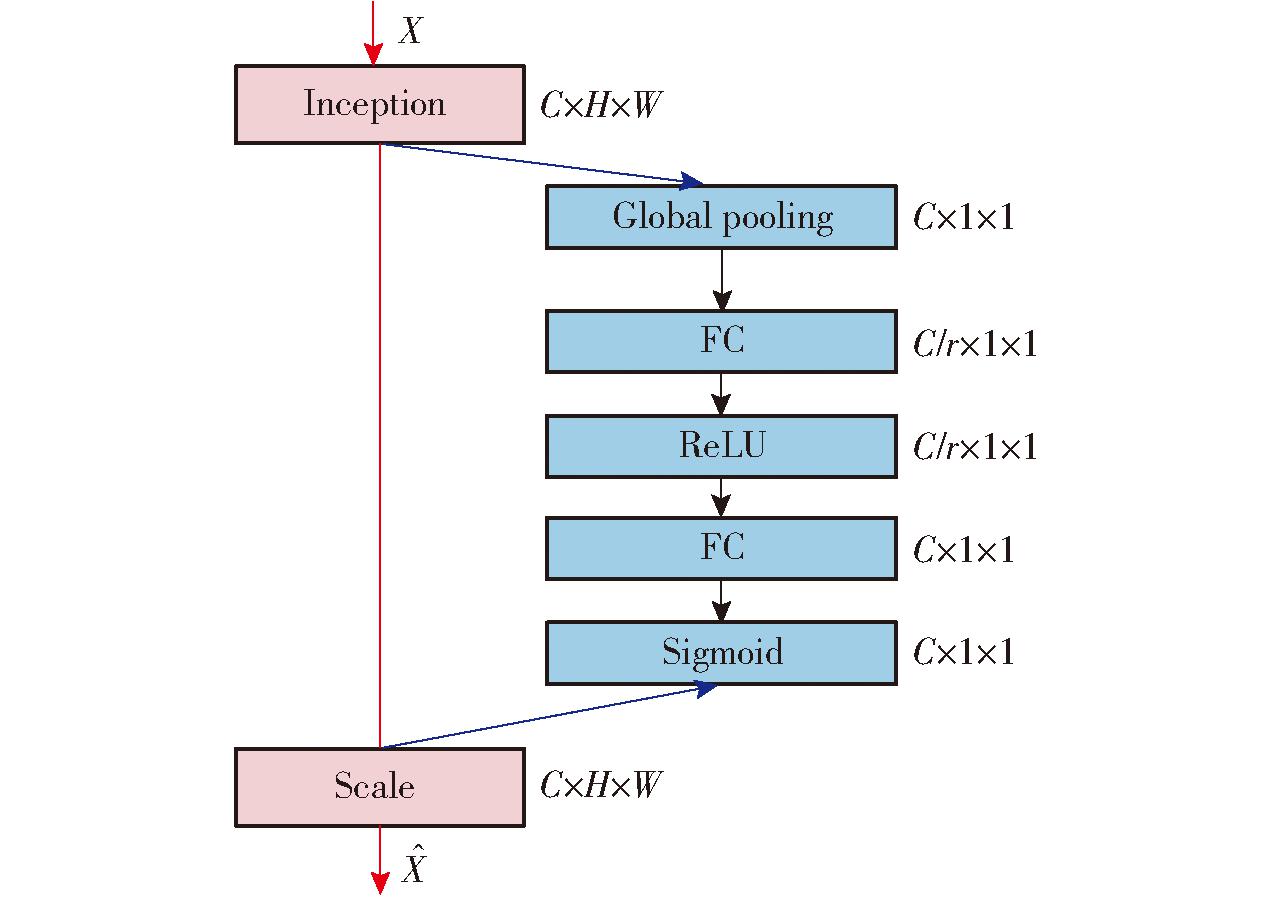

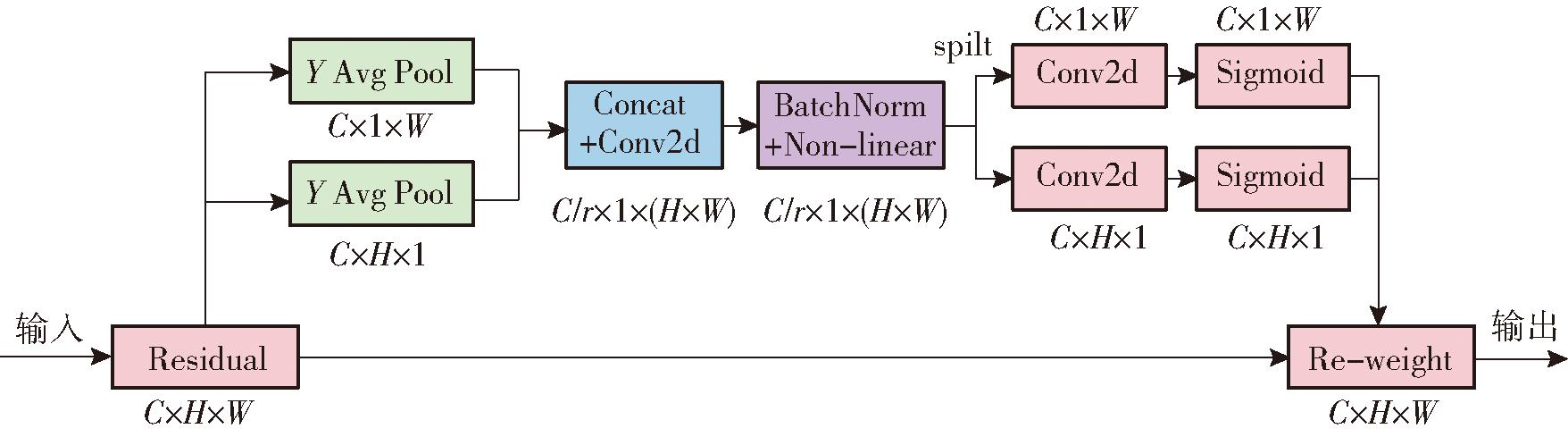

2.1.2 引入SE通道注意力机制和CA协同注意力机制

在MobileNetv3主干网络中加入了SE注意力机制模块,SE注意力机制主要考虑通道注意力(Channel attention),如图3所示。在YOLO v7-S特征融合层引入协同注意力机制模块,该注意力机制不仅可以把通道注意力和空间注意力进行有效的结合,同时在通道注意力中融入了位置信息,避免全局pooling-2D操作造成的位置信息丢失,如图4所示。

图3 SE注意力模块

Fig.3 SE attention module

图4 CA注意力模块

Fig.4 CA attention module

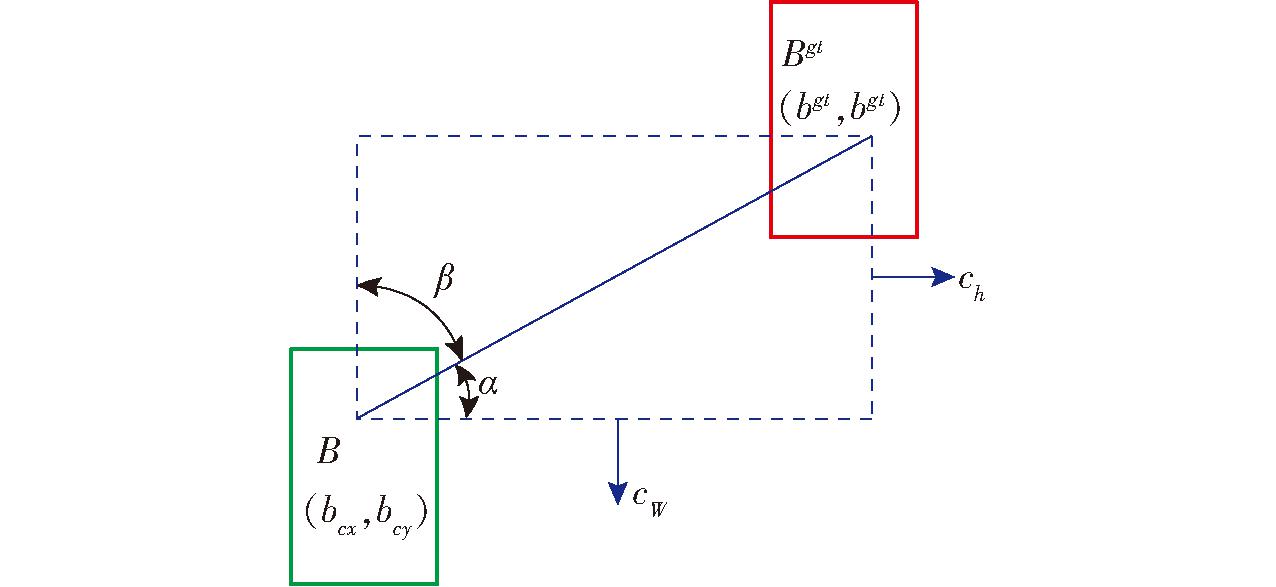

2.1.3 SIoU损失函数与NWD小目标检测机制联用

YOLO v7-S模型算法中,预测框回归损失采用CIoU,但CIoU 并没有考虑到预测框与真实框方向的不匹配。这种方向的不匹配,可能导致收敛速度减慢和收敛效率低。针对CIoU存在的问题,经过实验对比,采用SIoU损失函数替换YOLO v7-S使用的CIoU 损失函数[19]。 SIoU 损失函数进一步考虑了真实框和预测框之间的向量角度,重新定义相关损失函数,SIoU 主要包含:角度损失(Angle cost)、距离损失(Distance cost)、形状损失(Shape cost)、IoU损失(IoU cost),图5为SIoU 参数示意图。

图5 SIoU 参数示意图

Fig.5 Schematic of SIoU parameter

角度损失(Angle cost)计算公式为

(1)

其中

(2)

根据角度损失Λ公式,定义距离损失Δ计算公式为

(3)

其中

(4)

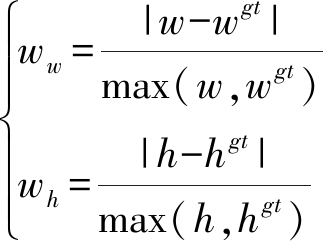

形状损失Ω定义为

(5)

其中

(6)

式中w、h、wgt、hgt分别为预测框和真实框的宽和高。θ控制对形状损失的关注程度,为避免过于关注形状损失而降低对预测框的移动,θ范围为2~6。

SIoU损失定义为

(7)

实验中将NWD[20]小目标检测方法引入香梨的目标检测中,将NWD和SIoU联合使用,实验选择其各占比50%的策略进行,即:Loss_loc=(1-IoU_ratio)(1.0-NWD)+IoU_ratio(1.0-SIoU),这个策略既可以提升目标检测精度,同时又保证模型检测速度。

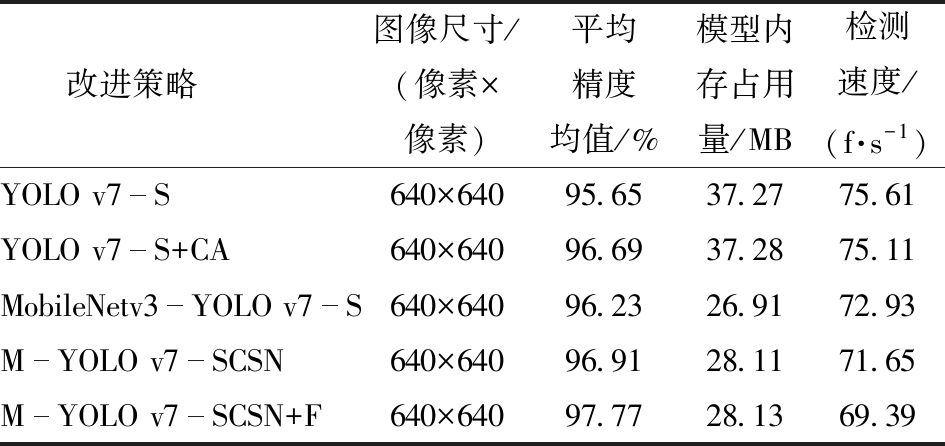

YOLO v7-S模型中使用Mosaic算法和Mixup算法等数据增强方法。这些算法更注重样本的空域表现,但忽略了频域信息。图像频域信息可体现灰度变化的速度,保留图像轮廓信息,对图像进行频域数据增强处理能有效降低外部环境对检测精度的影响。为此,本文引入基于傅里叶变换的频域数据增强算法,以增强YOLO v7模型鲁棒性。

信号在时域和频域之间的变换依赖离散傅里叶变换(Discrete Fourier transform,DFT),二维离散傅里叶变换广泛应用于图像变换,它能将空间域的图像转换到频域上进行研究。对于尺寸为M×N的图像f(x,y),傅里叶变换可以表示为

![]() (μ=0,1,…,M-1;υ=0,1,…,N-1)

(μ=0,1,…,M-1;υ=0,1,…,N-1)

(8)

其中μ、υ为频率变量,μ对应x轴,υ对应y轴,F(μ,υ)是图像f(x,y)傅里叶变换后的频谱。傅里叶反变换能将频域系数变换回空间域,获得重建图像,相应的二维傅里叶反变换为

![]() (x=0,1,…,M-1;y=0,1,…,N-1)

(x=0,1,…,M-1;y=0,1,…,N-1)

(9)

式(8)可分离为

(10)

式(9)可分离为

(11)

傅里叶变换幅度谱和相位谱分别为

(12)

φ(μ,v)=arctan(I(μ,υ)/R(μ,υ))

(13)

其中,R和I表示傅里叶变换系数实部和虚部。

由式(10)、(11)可知,傅里叶变换及傅里叶反变换的核函数具有分离性,且指数部分具有周期性。快速傅里叶变换基于逐次加倍的思想消除了傅里叶变换中的多余计算,提高了计算速率。

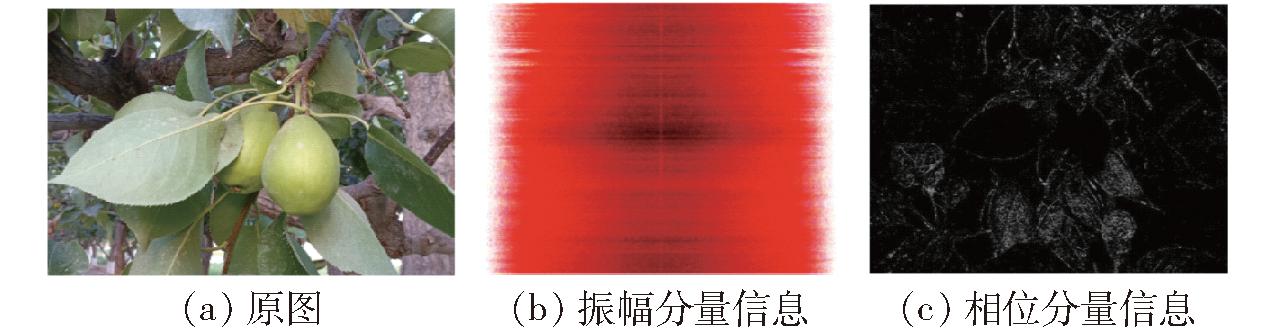

为分析快速傅里叶变换的效果及可行性,从香梨数据集的训练集中随机选择1幅图像。对图像进行快速傅里叶变换,分离图像中的振幅和相位信息,分别进行可视化。振幅、相位分量可视化结果如图6所示。

图6 傅里叶变换振幅分量、相位分量信息图

Fig.6 Diagrams of Fourier transform amplitude and phase components

从图6可以看出,振幅分量给出了图像对比度信息,相位分量给出了图像轮廓信息。在目标检测任务中,相位分量相较于振幅分量更为重要,因为图像轮廓信息能帮助模型更好地提取特征,提升检测精度。

通过分离图像的相位分量,并构建不同的振幅信息来生成新图像。新图像与原图像轮廓相同,但幅值不同,以此达到数据增强的目的,从而增加训练样本多样性,提高所训练模型泛化性。需要注意的是,新的振幅信息来自训练样本中的其他图像,并非随机产生,具体过程描述为:

将2幅图像f(x1,y1)和f(x2,y2)分别进行快速傅里叶变换

F(μ1,υ1)=FFT(f(x1,y1))

(14)

F(μ2,υ2)=FFT(f(x2,y2))

(15)

取对应的振幅|F(μ1,υ1)|和|F(μ2,υ2)|,随机产生一个[0,1]内的随机因子α,以这个随机因子α和(1-α)为权重,组合得到两个新的振幅为

|F′(μ1,υ1)|=α|F(μ2,υ2)|+(1-α)|F(μ1,υ1)|

(16)

|F′(μ2,υ2)|=α|F(μ1,υ1)|+(1-α)|F(μ2,υ2)|

(17)

重新组合相位分量和新的振幅分量,然后进行反傅里叶变换,还原为时域图像。从香梨数据集中随机选取3幅图像,当执行上述数据增强算法并取随机因子α为0.8后,得到的增强样本如图7所示。

图7 傅里叶变换数据增强效果

Fig.7 Effectiveness diagrams of Fourier transform data augmentation

由图7可以看出,经过傅里叶变换数据增强的图像保留了原有的轮廓信息,但交换了各自的色彩和对比度信息。这些图像由于色彩特征的改变成为新的图像样本,从而达到数据增强效果。

在模型检测精度方面,选用精确率(Precision)、召回率(Recall)和平均精度均值(Mean average precision,mAP)作为评价指标;在模型检测性能方面,选用检测速度和模型内存占用量作为评价指标,这些评价指标的具体计算方法见文献[21-22]。

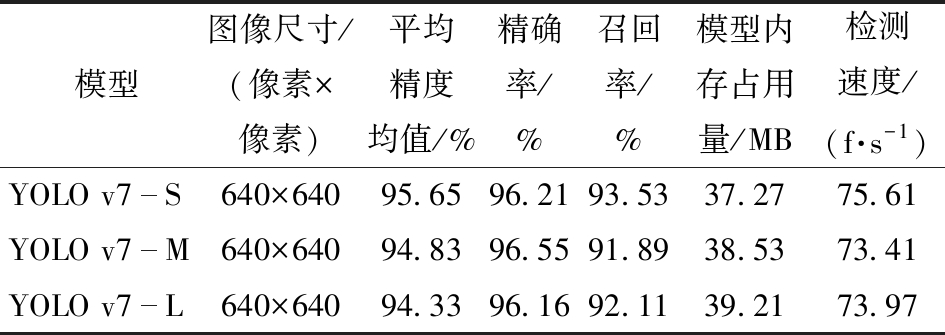

对比YOLO v7-S、YOLO v7-M、YOLO v7-L 3个模型的精确率、召回率、平均精度均值、模型内存占用量和检测速度,见表3,并综合考虑选择模型内存占用量最小、检测速度最快的YOLO v7-S作为基础模型进行改进。

表3 不同YOLO v7检测模型在验证集中的性能结果

Tab.3 Performance comparison of different YOLO v7 detection models in validation set

模型图像尺寸/(像素×像素)平均精度均值/%精确率/%召回率/%模型内存占用量/MB检测速度/(f·s-1)YOLO v7S640×64095.6596.2193.5337.2775.61YOLO v7M640×64094.8396.5591.8938.5373.41YOLO v7L640×64094.3396.1692.1139.2173.97

设计5组消融实验,分别为YOLO v7-S、YOLO v7-S+CA模型(特征融合层中加入CA注意力模块)、MobileNetv3-YOLO v7-S模型(替换YOLO v7-S骨干网络为MobileNetv3)、改进后的M-YOLO v7-SCSN模型(MobileNetv3-YOLO v7-S+CA+SIoU+NWD)和M-YOLO v7-SCSN+F模型(M-YOLO v7-SCSN+傅里叶变换数据增强)的检测性能,采用模型平均精度均值(mAP)和检测速度两个评价指标,在验证集对模型进行评价,评价结果如表4所示。从表4可知,使用MobileNetv3替换YOLO v7-S骨干网络,虽其平均精度均值(mAP)和检测速度略有下降,但其模型内存占用量比YOLO v7-S减少27.8%。在检测精度方面,本实验设计的M-YOLO v7-SCSN+F模型平均精度均值高于其他4组网络模型。

表4 YOLO v7模型消融实验结果

Tab.4 Ablation experiment results for YOLO v7 model

改进策略图像尺寸/(像素×像素)平均精度均值/%模型内存占用量/MB检测速度/(f·s-1)YOLO v7S640×64095.6537.2775.61YOLO v7S+CA640×64096.6937.2875.11MobileNetv3YOLO v7S640×64096.2326.9172.93MYOLO v7SCSN640×64096.9128.1171.65 MYOLO v7SCSN+F640×64097.7728.1369.39

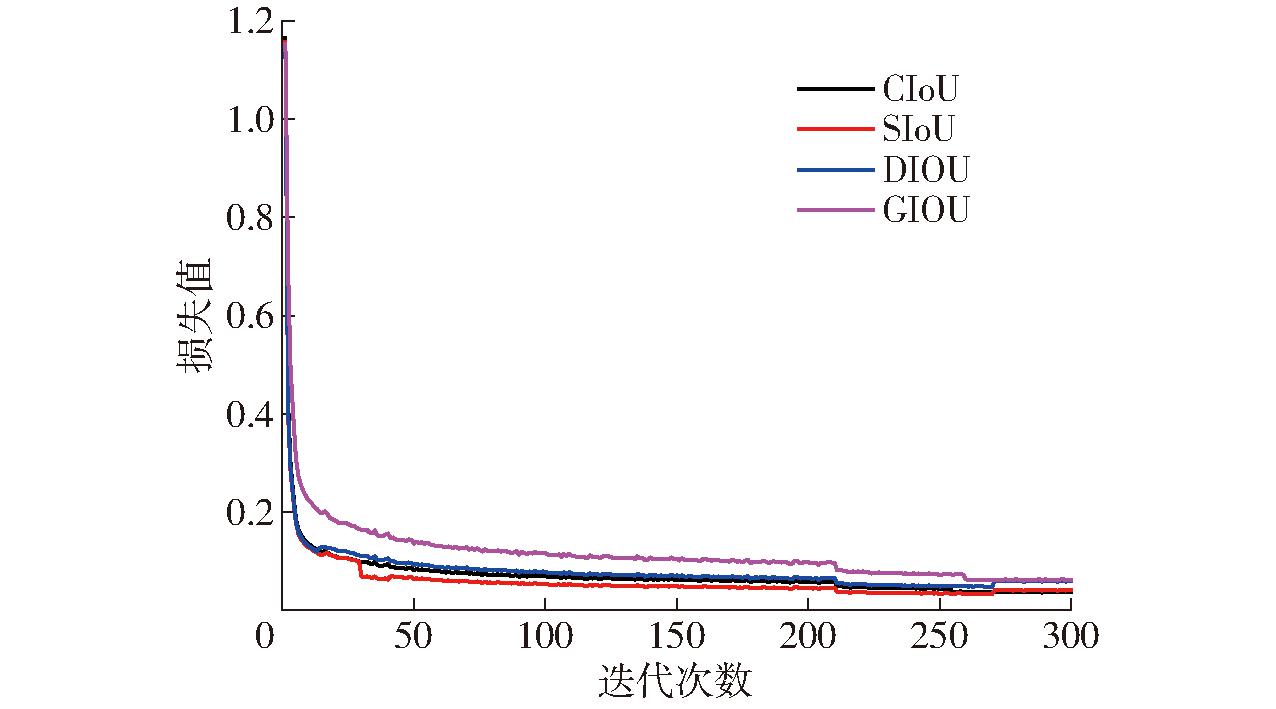

为了分析不同损失函数的性能表现,将YOLO v7-S中原有的损失函数进行替换,表5为CIoU、DIoU[23]、GIoU[24]和SIoU[25]4种损失函数应用YOLO v7-S中的性能表现。图8为使用 4种损失函数模型损失值曲线。由图8可以看出,使用CIoU、DIoU、GIoU、SIoU 损失函数训练模型损失值均可快速收敛并维持在较低损失值。

图8 不同损失函数损失值随迭代次数变化曲线

Fig.8 Curves of loss values with iteration epochs for different loss functions

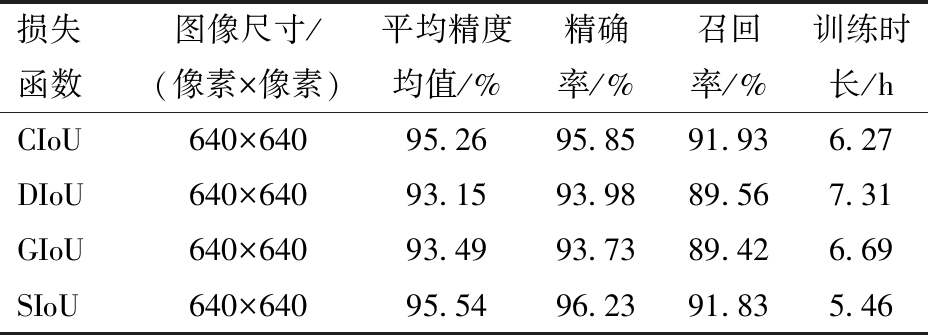

表5 不同损失函数性能比较

Tab.5 Performance comparison of different loss functions

损失函数图像尺寸/(像素×像素)平均精度均值/%精确率/%召回率/%训练时长/hCIoU640×64095.2695.8591.936.27DIoU640×64093.1593.9889.567.31GIoU640×64093.4993.7389.426.69SIoU640×64095.5496.2391.835.46

由表5可知,与CIoU相比使用SIoU损失函数模型的平均精度均值(mAP)和精确率分别高0.28、0.38个百分点,召回率低0.1个百分点,训练时间短0.81 h。与DIoU相比,使用SIoU损失函数的平均精度均值(mAP)、精确率和召回率分别高2.39、2.25、2.27个百分点,训练时长缩短1.85 h;与GIoU相比,使用SIoU损失函数的平均精度均值(mAP)、精确率和召回率分别提高2.05、2.5、2.41个百分点,训练时长缩短1.23 h;根据上述的分析可知,使用 SIoU损失函数进行模型训练,综合优势较为明显,检测精度最高。

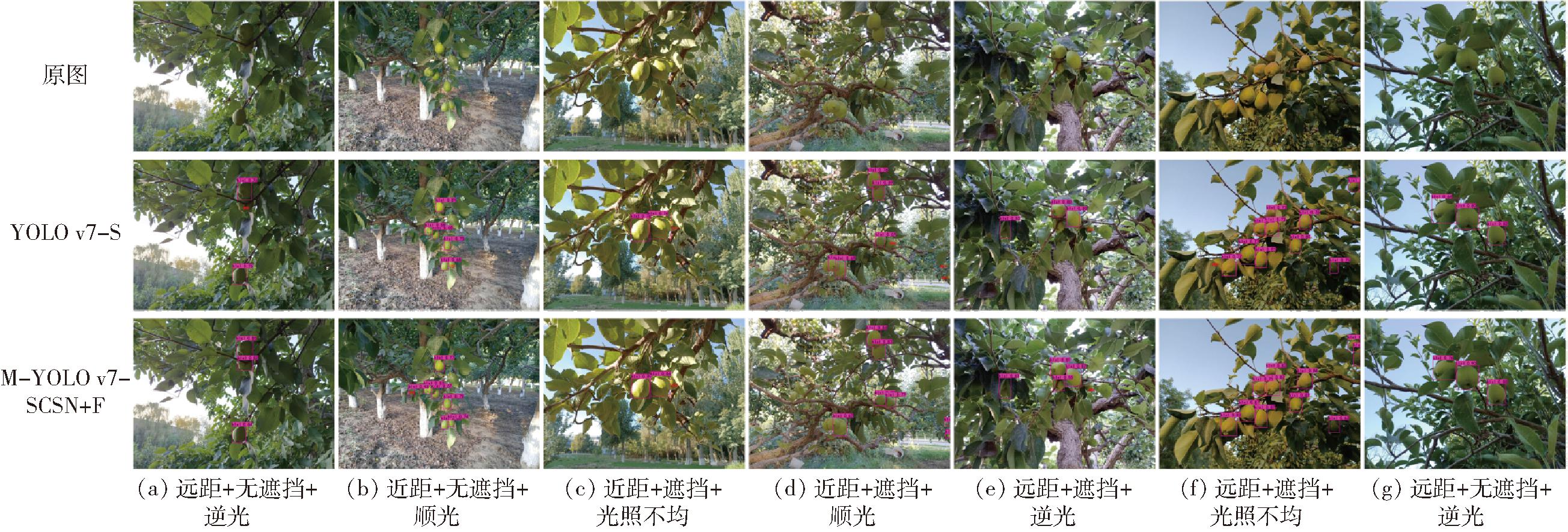

图9为不同距离、有无遮挡、不同光照条件下YOLO v7-S和改进 M-YOLO v7-SCSN+F模型香梨检测结果。

图9 香梨果实图像检测

Fig.9 Images detection of pear fruit

由图9可知,无论是在近距离还是远距离无遮挡顺光、逆光的情况下,YOLO v7-S模型以及 M-YOLO v7-SCSN+F模型均可准确识别香梨果实,没有漏检和误检的情况。在有枝叶遮挡的情况下,YOLO v7-S的检测不够准确,图9a~9f中均出现了漏检和误检现象。 M-YOLO v7-SCSN+F模型仅在光照不均匀且有相邻香梨遮挡(图9c)和远距离有遮挡(图9d~9f)中有个别香梨被漏检现象。

从表6可以看出,近景拍摄数据集测试时,M-YOLO v7-SCSN+F模型均值平均精度(mAP)、精确度和召回率分别比YOLO v7-S高0.70、1.17、1.13个百分点;而在远景数据集中,M-YOLO v7-SCSN+F模型平均精度均值(mAP)、精确率和召回率分别比 YOLO v7-S模型高 1.47、1.60、2.11个百分点。

表6 YOLO v7-S和M-YOLO v7-SCSN+F检测结果对比

Tab.6 YOLO v7-S and M-YOLO v7-SCSN+F in different shooting scene %

模型场景平均精度均值精确率召回率YOLO v7S远景93.6994.2791.51近景95.6395.7493.29MYOLO v7SCSN+F远景95.1695.8793.62近景97.3396.9194.42

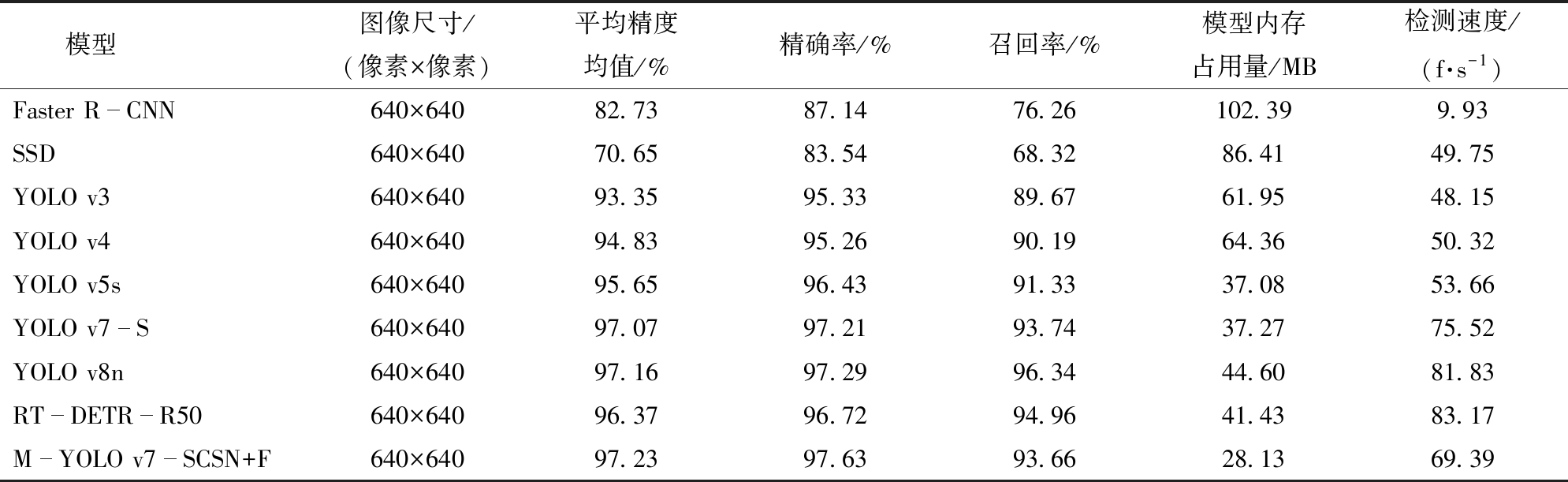

实验使用Faster R-CNN[26]、SSD、YOLO v3[27]、YOLO v4[28]、YOLO v5s[29]、YOLO v7-S[30]、YOLO v8n、RT-DETR-R50模型与M-YOLO v7-SCSN+F模型在验证集上进行性能对比。从表7可以看出,改进后的 M-YOLO v7-SCSN+F模型在验证集的平均精度均值(mAP)、精确率和召回率分别达到 97.23%、97.63%和93.66%,检测速度为 69.39 f/s。其平均精度均值(mAP)与相应模型对比分别提高14.50、26.58、3.88、2.40、1.58、0.16、0.07、0.86个百分点。其模型内存占用量分别减少74.26、58.28、33.82、36.23、8.95、9.14、16.47、13.30 MB,改进后的 M-YOLO v7-SCSN+F模型更有利于部署在生产设备上。

表7 不同类型检测模型在验证集上性能比较

Tab.7 Performance comparison of different types of detection models on validation set

模型图像尺寸/(像素×像素)平均精度均值/%精确率/%召回率/%模型内存占用量/MB检测速度/(f·s-1)Faster RCNN640×64082.7387.1476.26102.399.93SSD640×64070.6583.5468.3286.4149.75YOLO v3640×64093.3595.3389.6761.9548.15YOLO v4640×64094.8395.2690.1964.3650.32YOLO v5s640×64095.6596.4391.3337.0853.66YOLO v7S640×64097.0797.2193.7437.2775.52YOLO v8n640×64097.1697.2996.3444.6081.83RTDETRR50640×64096.3796.7294.9641.4383.17MYOLO v7SCSN+F640×64097.2397.6393.6628.1369.39

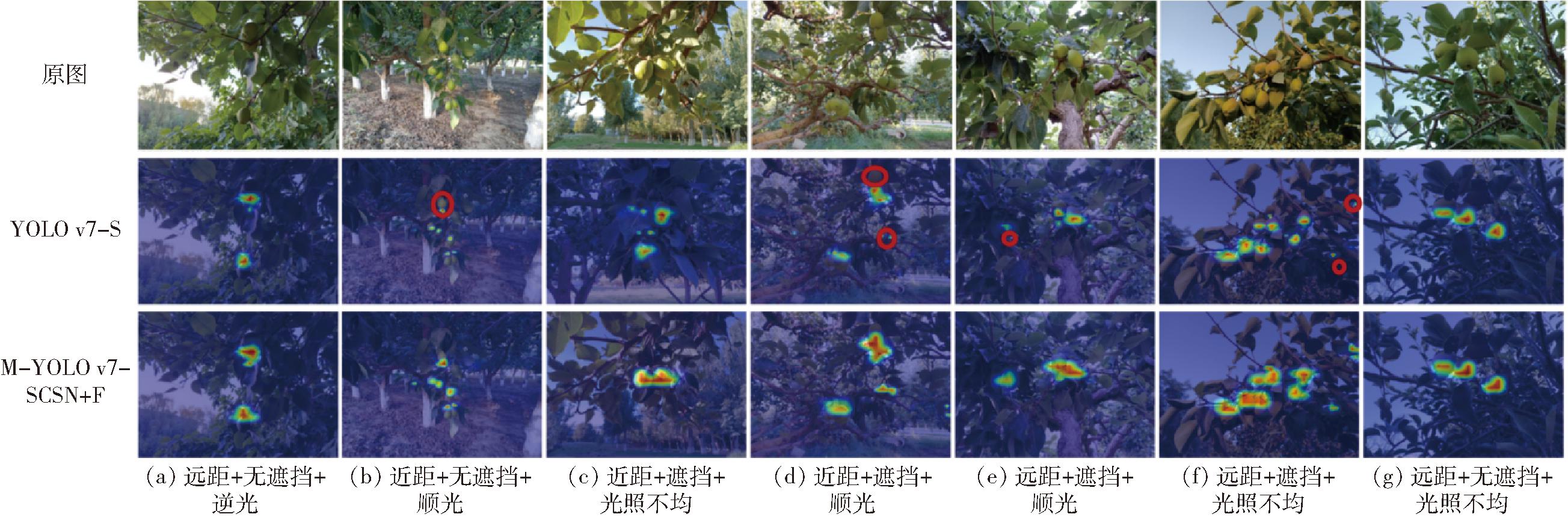

利用Grad-CAM产生目标检测热力图[31],如图10所示。通过香梨图像检测热力图,可以看出M-YOLO v7-SCSN+F模型的目标检测热力图更贴近真实梨果区域。通过图10中圆形圈出的区域可以看出,原YOLO v7-S目标检测热力值相对M-YOLO v7-SCSN+F模型的目标检测热力值更低,表现出漏检现象。通过图10可以看出,M-YOLO v7-SCSN+F模型可从弱语义的目标中提取更强的目标特征,有着较好的鲁棒性和泛化能力。

图10 香梨果实图像检测热力图

Fig.10 Heat maps of pear fruit image detection

(1)以YOLO v7-S为基础网络,针对果园中香梨果实、果叶和枝干之间相互遮挡,不易精准定位的问题,设计了一种轻量化香梨目标检测方法M-YOLO v7-SCSN+F。该模型在验证集的平均精度均值(mAP)、精确率和召回率分别达到97.23%、97.63%和93.66%,检测速度为69.39 f/s。

(2)设计了YOLO v7-S、YOLO v7-S+CA、MobileNetv3-YOLO v7、M-YOLO v7-SCSN和M-YOLO v7-SCSN+F模型的5组消融试验,采用模型检测平均精度均值(mAP)和检测速度两个评价指标,在验证集对模型进行评价,结果表明,M-YOLO v7-SCSN+F网络模型平均精度均值高于其他4组网络模型。

(3)将改进的M-YOLO v7-SCSN+F模型与Faster R-CNN、SSD、YOLO v3、YOLO v4、YOLO v5s、YOLO v7-S、YOLO v8n、RT-DETR-R50模型进行性能对比。结果表明,本研究设计的模型平均精度均值(mAP)与相应模型对比提高14.50、26.58、3.88、2.40、1.58、0.16、0.07、0.86个百分点。此外,改进的M-YOLO v7-SCSN+F模型内存占用量比先进的YOLO v8n和RT-DETR-R50检测模型减少16.47、13.30 MB,更有利于部署在生产设备上。

[1] 邵园园,王永贤,玄冠涛,等.基于高光谱成像的肥城桃品质可视化分析与成熟度检测[J].农业机械学报,2020,51(8):344-350.SHAO Yuanyuan, WANG Yongxian, XUAN Guantao, et al. Visual detection of SSC and firmness and maturity prediction for Feicheng peach by using hyperspectral imaging[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(8): 344-350. (in Chinese)

[2] 宋怀波,尚钰莹,何东健. 果实目标深度学习识别技术研究进展[J]. 农业机械学报,2023,54(1):1-19.SONG Huaibo, SHANG Yuying, HE Dongjian. Review on deep learning technology for fruit target recognition[J]. Transactions of the Chinese Society for Agricultural Machinery,2023, 54(1):1-19. (in Chinese)

[3] 林景栋,吴欣怡,柴毅,等.卷积神经网络结构优化综述[J]. 自动化学报,2020,46(1):24-37.LIN Jingdong, WU Xinyi, CHAI Yi, et al. Structure optimization of convolutional neural networks: a survey[J]. Acta Automatica Sinica, 2020, 46(1): 24-37. (in Chinese)

[4] HE K,ZHANG X, REN S,et al.Deep residual learning for image recognition[C]∥Conference on Computer Vision and Pattern Recognition, 2016: 770-778.

[5] YONG H, ZHANG C. LeNet-5 improvement based on FPGA acceleration[J].The Journal of Engineering,2020,13(7):526-528.

[6] 黄小玉,李光林.基于改进判别区域特征融合算法的近色背景绿色桃子识别[J].农业工程学报,2018, 34(23):23-38.HUANG Xiaoyu, LI Guanglin. Near-color background green peach recognition based on improved discriminative region feature fusion algorithm[J]. Transactions of the CSAE, 2018, 34(23):23-38. (in Chinese)

[7] HE K, ZHANG X, REN S. Spatial pyramid pooling in deep convolutional networks for visual recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9): 1904-1916.

[8] REN S, HE K, GIRSHICK R. Faster R-CNN: towards real-time object detection with region proposal networks[C]∥Advances in Neural Information Processing Systems,2015:91-99.

[9] REDMON J, FARHADI A. Yolo v3: an incremental improvement[J]. arXiv preprint arXiv: 1804.02767, 2018.

[10] TIAN Y, YANG G, WANG Z, et al. Apple detection during different growth stages in orchards using the improved YOLO-v3 model[J]. Computers and Electronics in Agriculture, 2019,157: 417-426.

[11] 王立舒,秦铭霞,雷洁雅,等.基于改进 YOLO v4-Tiny 的蓝莓成熟度识别方法[J].农业工程学报,2021,37(18):170-178.WANG Lishu, QIN Mingxia, LEI Jieya, et al. Blueberry maturity recognition method based on improved YOLO v4-Tiny[J].Transactions of the CSAE, 2021, 37(18):170-178. (in Chinese)

[12] LÜ S, LI R, ZHAO Y, et al. Green citrus detection and counting in orchards based on YOLO v5-CS and AI edge system[J]. Sensors, 2022, 22(2): 576.

[13] WANG C Y,BOCHKOVSKIY A, LIAO H Y M. YOLO v7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors [C]∥Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition.IEEE,2023:7464-7475.

[14] 吕珊.面对复杂场景的鲁棒目标检测算法研究[D].北京:北京交通大学,2022:10-18.LÜ Shan. Research on robust object detection algorithms for complex scenes[D]. Beijing: Beijing Jiaotong University, 2022: 10-18.(in Chinese)

[15] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLO v4:optimal speed and accuracy of object detection[EB/OL][2022-11-13].https:∥arxiv.org/pdf/2004.10934.

[16] 伊建峰,黎思成,吕珊,等. 基于频域数据增强及YOLO v7的动火作业检测模型[J]. 计算机应用,2023,43(增刊): 285-290.YI Jianfeng, LI Sicheng, LÜ Shan, et al. Hot work detection model based on frequency domain data enhancement and YOLO v7[J]. Journal of Computer Applications, 2023,43(Supp):285-290.(in Chinese)

[17] YANG F, LI X, SHEN J. MSB-FCN: multi-scale bidirectional FCN for object skeleton extraction[J]. IEEE Transactions on Image Processing,2020,30:2301-2312.

[18] TAN M, PANG R, LE Q V. Efficientdet: scalable and efficient object detection[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 10781-10790.

[19] HAN K,WANG Y,CHEN H,et al. A survey on vision transformer[J]. IEEE Trans. Pattern Anal. Mach. Intell., 2022,45(1): 87-110.

[20] HOU Q,ZHOU D,FENG J. Coordinate attention for efficient mobile network design[C]∥ Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021:13713-13722.

[21] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]∥Computer Vision and Pattern Recognition. IEEE,2016: 779-788.

[22] REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]∥Computer Vision and Pattern Recognition. IEEE, 2017: 6517-6525.

[23] ZHENG Z, WANG P, LIU W, et al. Distance-IoU loss: faster and better learning for bounding box regression [C]∥Proceedings of the AAAI Conference on Artificial Intelligence, 2020: 1-7.

[24] REZATOFIGHI S H, TSO I N. Generalized intersection over union: a metric and a loss for bounding box regression[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019.

[25] GEVORGYAN Z. SIoU loss: more powerful learning for bounding box regression[J].Computer Vision and Pattern Recognition,2022(5):1-12.

[26] 朱红春,李旭,孟炀,等.基于 Faster R-CNN 网络的茶叶嫩芽检测[J].农业机械学报,2022,53(5):217-224. ZHU Hongchun, LI Xu, MENG Yang, et al. Tea bud detection based on Faster R-CNN network[J].Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(5):217-224. (in Chinese)

[27] 武星,齐泽宇,王龙军,等.基于轻量化 YOLO v3 卷积神经网络的苹果检测方法[J].农业机械学报,2020,51(8):17-25. WU Xing, QI Zeyu, WANG Longjun, et al. Apple detection method based on light-YOLO v3 convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(8):17-25. (in Chinese)

[28] 郭建军,何国煌,徐龙琴,等. 基于改进 YOLO v4 的肉鸽行为检测模型研究[J].农业机械学报,2023,54(4):347-355. GUO Jianjun,HE Guohuang,XU Longqin,et al. Pigeon behavior detection model based on improved YOLO v4[J]. Transactions of the Chinese Society for Agricultural Machinery,2023,54(4):347-355. (in Chinese)

[29] 李健源,柳春娜,卢晓春,等.基于改进YOLO v5s和TensorRT部署的鱼道过鱼监测[J].农业机械学报,2022,53(12):314-322.LI Jiangyuan, LIU Chunna, LU Xiaochun, et al. Fish passage monitoring based on improved YOLO v5s and TensorRT deployment[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(12):314-322. (in Chinese)

[30] 宋怀波,马宝玲,尚钰莹,等. 基于 YOLO v7-ECA 模型的苹果幼果检测[J].农业机械学报,2023,54(6):233-242. SONG Huaibo,MA Baoling,SHANG Yuying,et al. Detection of young apple fruits based on YOLO v7-ECA model[J]. Transactions of the Chinese Society for Agricultural Machinery,2023,54(6):233-242. (in Chinese)

[31] MARTIN D J,FAHAD S K,MICHAEL F,et al. Adaptive color attributes for real-time visual tracking[J]. IEEE Conference on Computer Vision and Pattern Recognition, 2014, 143(1): 1090-1097.