小麦是我国主要的粮食作物之一,2022年全国小麦总产量1.37×109 t[1],小麦生长发育与产量息息相关,对其进行生长监测对我国粮食安全具有重要意义。小麦生育期识别是小麦生长发育监测的重要组成部分,而现阶段小麦生育期信息获取主要依靠人工观测,效率低且耗费大量人力物力,无法满足实时、快速的监测需求。

遥感具有大面积和快速无损的优势,为农作物物候期识别提供了有效的技术手段。杨蜀秦等[2]使用无人机可见光遥感影像对小麦种植行检测划分。周琦等[3]使用无人机多光谱遥感数据对不同生育期小麦冠层SPAD值进行估算,其中拔节期决定系数R2达到0.827。兰仕浩等[4]利用卫星光谱尺度反射率对冬小麦生物量估算,R2达到0.70。杨欣等[5]利用高光谱对冬小麦进行氮素估算,R2达到0.76。但遥感在地块级别技术支持与实时精准服务上略受限,无法在田间地块小尺度上进行实时物候监测。

近年来,深度学习算法的出现极大地提升了图像分类的准确率,其中卷积神经网络[6]在农业图像识别领域备受青睐。随着智能化技术在场景识别、物体分类等方面的研究不断深入,深度学习在农业领域的应用前景日益广阔。利用深度学习的高效率和准确性,逐渐成为了农作物物候特性识别的理想选择。徐建鹏等[7]使用卷积神经网络模型,对水稻生育期进行分类,分类精度达到97.33%。申华磊等[8]使用基于U2-Net的网络模型完成了倒伏面积提取,准确率可达97.25%。李云霞等[9]基于Faster R-CNN和NMS构建了小麦计数模型,其R2可达0.89。孙少杰等[10]使用卷积神经网络与BP神经网络结合对小麦产量进行估算,R2达到0.96。传统深度学习参数量较大,通常难以在移动端设备部署,不能较好地满足实际应用需求。

轻量化网络模型在推理速度和参数量方面具有很大优势,越来越多的研究者开始使用EfficientNet[11]、ShuffleNet[12]、MobileNet[13-15]、GhostNet[16]和FasterNet[17]等轻量化网络模型。杨森森等[18]对MobileViT轻量化网络进行了改进,对田间杂草进行识别,准确率达到99.61%。苗荣慧等[19]利用MobileNetV3改进YOLO V7并对番茄成熟度进行检测,精度达到98.6%,同时将内存占用量控制在66.5 MB。范晓飞等[20]利用MobileNetV1替换YOLO V4主干网络,单幅图像检测耗时达到1.85 s。孙道宗等[21]使用改进的SqueezeNet对茶树叶片分类,参数量减少49.1%,准确率提高7.7%。

真实环境下大田图像背景较为复杂,当前大多数模型识别准确率和效率都不能满足实时识别小麦生育期的需求。本文对FasterNet模型进行改进。在FasterNet模型中引入Channel Shuffle,减少网络参数量;在FasterNet模型中嵌入Swin Transformer模块,加强特征融合并实现自注意力机制,以提高模型精度;对FasterNet的网络框架进行重新编排,提出轻量化模型FSST(Fast shuffle swin transformer),同时在训练过程中引入Lion优化器[22],使模型快速收敛。最终将模型应用于小麦生育期数字图像识别,以期代替部分人工观测任务,为作物物候特性监控提供有效支持。

以河南省冬小麦为研究对象,其生长周期在220~270 d,一般划分为播种期、出苗期、分蘖期、越冬期、返青期、起身期、拔节期、孕穗期、抽穗期、开花期、灌浆期和成熟期12个生育时期。选取小麦越冬期、返青期、拔节期、抽穗期4个生育时期,其冠层图像采集于河南省许昌市河南农业大学许昌校区试验田(34°12′06″N,113°58′26″E),采集时间为2021年1—4月。 试验田属暖温带大陆性季风气候,四季分明,年平均气温14.6℃,年平均无霜期216 d,年平均降水量728.9 mm,适合小麦等粮食作物生长。使用智能手机(小米8,后置1.2×107像素的双摄像头,手机拍摄模式设定为AI模式下的光学变焦,最高分辨率4 344像素×4 344像素) 在距离地面定高1 m进行拍摄,所有图像均在10:00—11:00、14:00—15:00时间段内且在自然光照、自然环境条件下进行采集。所处生育期、拍摄日期与图像数量如表1所示。小麦生育期部分原始图像如图1所示。

图1 小麦生育期原始图像

Fig.1 Raw images of wheat growth stage

表1 不同生育期图像数量

Tab.1 Number of images at different growth stages 幅

生育期拍摄日期图像数量分割后图像数量越冬期2021年1月15日1029182021年3月5日80720返青期2021年3月19日807202021年3月30日80720拔节期2021年4月9日86774抽穗期2021年4月15日83747

本研究将扩充和增强后的数据集按照比例7∶3划分成训练集和验证集。原始图像像素尺寸大,数量有限(共计511幅图像),具有高精度小样本数据集特点。为扩充小麦生育期图像数据集,将原有511幅小麦生育期图像进行等比分割,分割为9份,然后将分割后图像尺寸重新调整至448像素×448像素。至此图像数据集扩充至4 599幅,图像分割方法如图2所示。

图2 图像分割方法

Fig.2 Method of image splite

对于输入图像,尽管进行了分割扩充操作,但仍建立在原始图像之上,为了进一步提高模型鲁棒性,对图像进行增强操作,包括随机裁剪、随机旋转、随机翻转、随机缩放和随机噪声等数据增强技术来增加数据集多样性和提高模型泛化能力,以促进在训练过程中更好地模拟实际场景中的变化和不确定性。每次训练迭代时增强函数会再对输入图像进行增强处理,可以增加数据多样性,从而提升模型泛化能力。

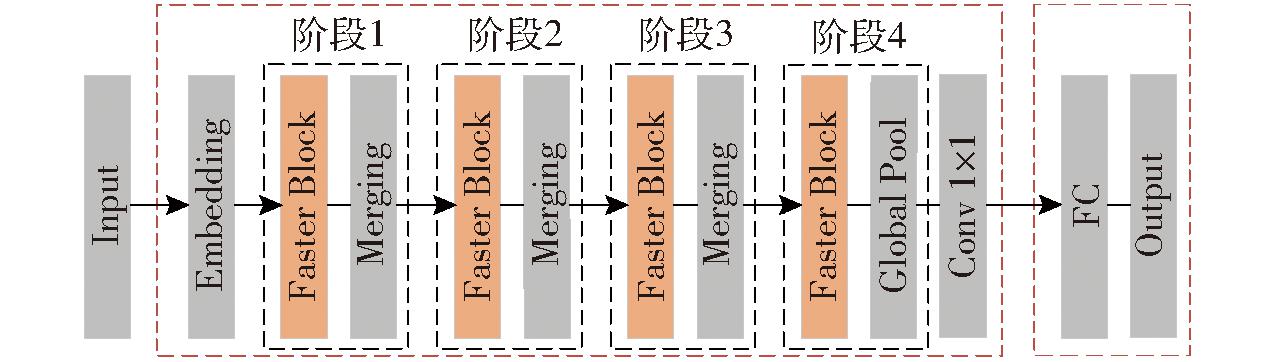

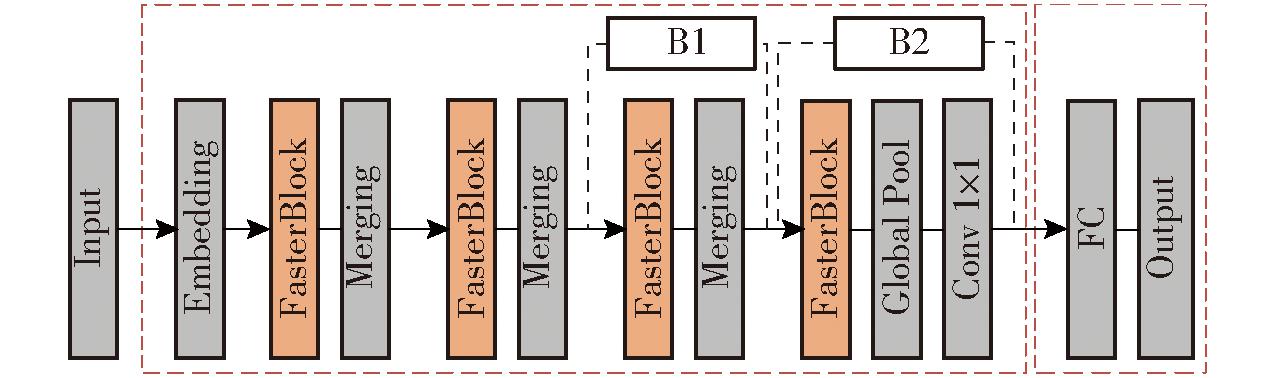

FasterNet是一种高效的神经网络,通常用于完成目标检测任务,并在速度和精度方面进行了优化,优于MobileVit[23]等网络。FasterNet的核心思想是在保持轻量级和高速度的基础上,提高特征表达能力和感受野的覆盖范围。FasterNet网络结构由4个阶段组成,如图3所示。图中每个阶段都是对特征进行提取,仅在卷积核大小上有区别,Embedding模块由一个步长为4的正则卷积组成,Merging层由一个步长为2的卷积组成,用于空间下采样和通道数扩展。

图3 FasterNet网络结构图

Fig.3 Structure of FasterNet

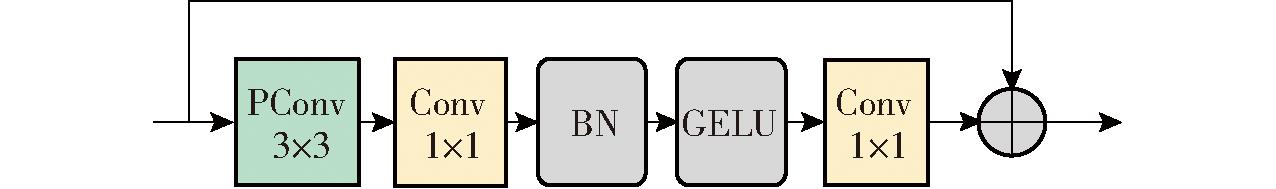

Faster Block模块是FasterNet的核心模块,该模块设计思想来源于GhostNet,在一定程度上解决了特征卷积通道上具有一定冗余的问题,但与GhostNet相比,并没有采用DWConv(深度可分离卷积),而是提出了一种新的被称为PConv(部分卷积)的算子,PConv通过减少冗余计算和内存访问来更有效地提取空间特征。Faster Block模块结构如图4所示。首先使用3×3的PConv提取特征,提取后使用1×1的Conv(标准卷积)进行特征降维,经过BN(Batch normalization)归一化和GELU激活函数后使用1×1的卷积进行升维,最后升维特征与输入特征进行相加得到最终输出。

图4 Faster Block模块结构

Fig.4 Structure of Faster Block

为解决大田环境下小麦背景图像复杂,以及图像尺寸偏大而导致的识别准确率较低、模型尺寸大、处理效率不高的问题,在轻量化、特征融合和网络结构调整3方面对FasterNet进行了改进。

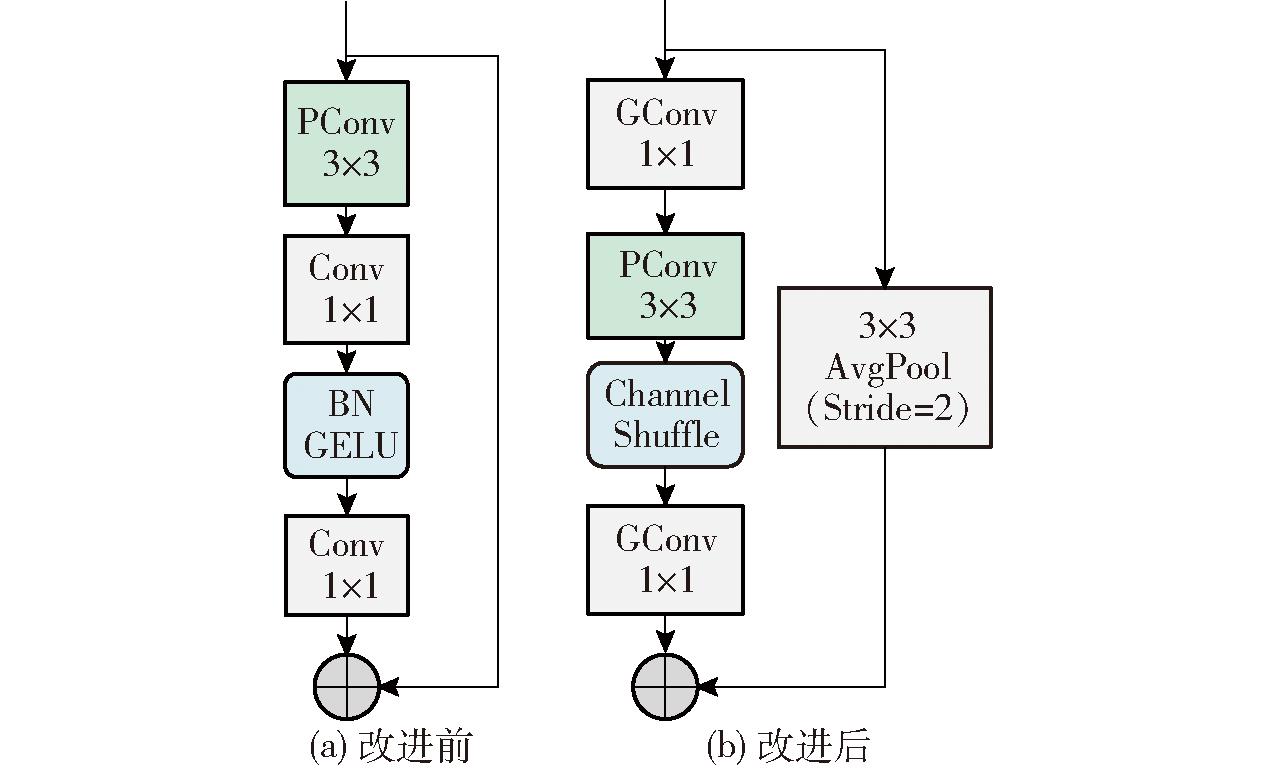

2.2.1 模型轻量化改进

Channel Shuffle操作能够有效地增强特征的跨通道交流,从而提高网络模型性能,同时在一定程度上减少模型计算复杂性。它通过将特征图分组并使用不同的卷积核进行卷积,降低计算复杂度的同时保证模型性能。此外,Channel Shuffle操作还打破了输入特征图不同通道之间的依赖关系,增加了模型泛化能力。同时,它也提高了不同分组特征之间的信息流动,有助于挖掘潜在的特征信息。在FasterNet中,PConv操作虽大幅度提高了计算效率,但模块末尾的1×1卷积仍然存在较大的资源消耗,为进一步提升模型性能,将末尾的1×1卷积块替换为GConv(分组卷积)模块,同时加入Channel Shuffle机制,进而降低参数量和计算量。

原有的Faster Block将最初的特征先进行3×3的部分卷积,然后经过1×1的标准卷积,通过BN归一化和GELU激活函数后再进行1×1的卷积,最终与初始特征进行Add操作。而对Faster Block的改进点主要是在Channel Shuffle的基础上先通过全局平均池化层再与最初的特征进行相加。首先将Faster Block中最后一层Conv操作替换为GConv,降低标准卷积的计算量。同时引入Channel Shuffle机制,然后将3×3的部分卷积模块接入1×1的卷积块,改进的模块结构如图5所示。

图5 Faster Block模块改进图

Fig.5 Improvement of Faster Block

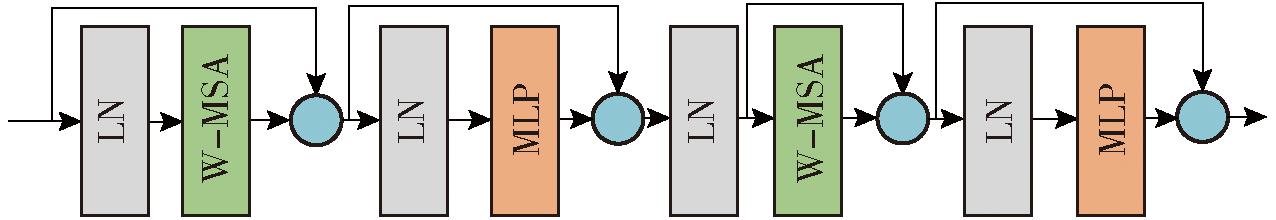

2.2.2 特征融合与注意力机制

特征融合能够综合利用各种信息,使得模型能够更好地理解数据的内在结构和规律。注意力机制是指通过有选择地关注输入信息中的一部分,而忽略其他不太相关的信息来处理任务。Swin Transformer是一种特征融合与注意力机制的综合实现,其结构如图6所示,该模块能够有效地利用Transformer的自注意力机制,捕捉图像中的高级特征,从而提高分类准确率。此外,Swin Transformer通过将图像分解为多个小块并分别进行自注意力计算,降低模型参数量和计算复杂度。

图6 Swin Transformer模块结构图

Fig.6 Structure of Swin Transformer module

Swin Transformer由3个核心模块组成,分别是多头自注意力机制(Windows multi-head self-attention,W-MSA)模块、多层感知机模块(Multi-layer perceptron, MLP)和偏移的多头自注意力机制(Shifted windows multi-head self-attention, SW-MSA)模块。每个模块前都会使用LN(Layer normalization)归一化,在模块后又会使用Add操作将特征相加,通过组合3个模块得到了Swin Transformer结构。将Swin Transformer模块接入到第4层卷积后,使模型融合多尺度特征并实现自注意力机制,可提高模型精度。

2.2.3 网络结构改进

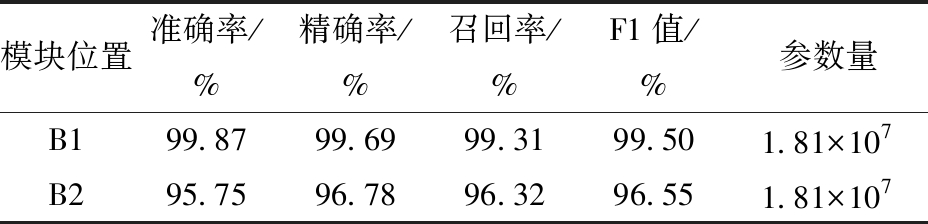

轻量化Swin Transformer模块具有的特征融合和自注意力机制能够显著提升模型综合性能,但Transformer仍然是一个较为复杂的模块,不可避免地增加模型复杂度。FasterNet最初网络结构设计的目的是在千万数量级别的ImageNet数据集[24]进行分类,图像类别多达1 000类。使用的小麦生育期数据集无论是图像数量还是图像类别均远低于ImageNet公共数据集。为此,本文重新设计了FasterNet模型的整体架构以减少模型复杂度,提出一种基于FasterNet的轻量化网络模型FSST(Fast shuffle swin transformer)。FSST模型将模型整体层数减至原来一半,且只包含4个改进的Faster Block模块,并将第1个FasterNet Block中PConv的输出通道数从50降至32,最后一个FasterNet Block中PConv的输出通道数从1 280降至512,其整体架构如图7所示。

图7 FSST网络结构图

Fig.7 Structure of FSST network

Lion(EvoLved sign momentum)是由谷歌在2023年通过数千TPU小时的算力搜索并结合人工干预,得到的一个具有更高的速度且占用内存更少的优化器,其在图像分类、图文匹配、扩散模型、语言模型预训练和微调等多个任务上进行了充分的实验,多数任务都显示Lion比目前主流的Adam[25]、Radam[26]和AdamW[27]优化器有着更好的效果。

Lion优化器更新过程为

(1)

其中![]()

(2)

(3)

式中 gt——损失函数梯度

AdamW优化器更新过程为

(4)

使用Lion替换AdamW优化器,Lion相比AdamW参数更少,同时少缓存一组参数,所以更节约显存,并且去掉AdamW更新过程中计算量最大的除法和开根号运算,使得计算量减少,提升了运算速度。

本实验硬件环境为内存:32 GB,CPU:Intel (R) Core i7 11800F,GPU:NVIDIA V100 32 GB,操作系统为 Windows 11,选用的开源深度学习框架为Torch,通过Torch调用 GPU 实现不同神经网络的训练。实验时,将图像尺寸固定为448像素×448像素,优化器分别采用AdamW和Lion,批次大小设置为16,学习率初始值为0.001,迭代次数为120。通过与FasterNet、GhostNet、ShuffleNetV2和MobileNetV3的比较来评估本研究方法的性能。

使用模型在自建的小麦生育期数据集测试集上的准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1值(F1 score)衡量模型性能,并且使用模型参数量(Parameters)、模型内存占用量、浮点计算量(FLOPs)和100幅生育期图像上平均识别时间作为模型复杂度衡量指标。

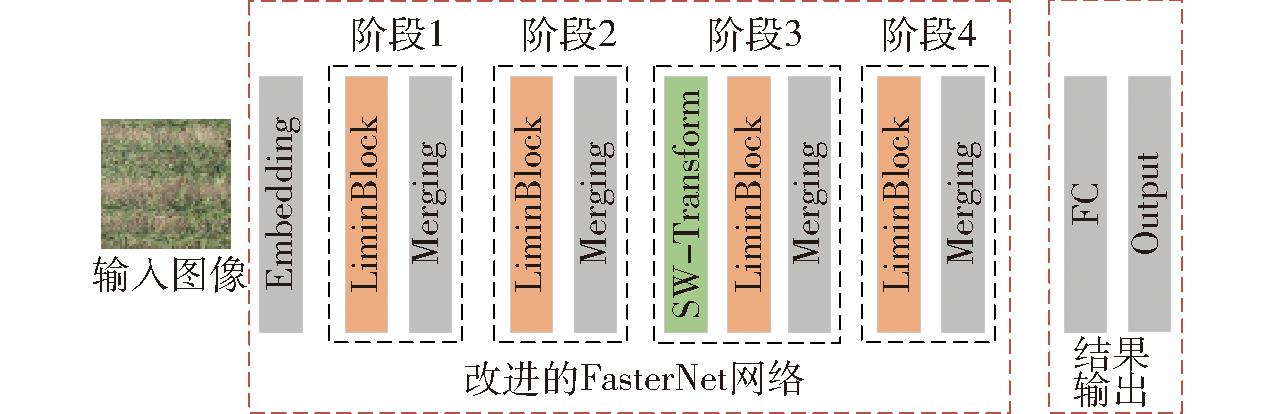

为探究Channel Shuffle模块的位置与网络性能的关系,分别将Channel Shuffle接入模型每个FasterNet Block内部(A1),每个FasterNet Block外部(A2),第1个FasterNet Block和最后1个FasterNet Block之间(A3),并进行对比,如图8所示。

图8 Channel Shuffle添加位置

Fig.8 Position of Channel Shuffle

小麦生育期数据集测试集上结果如表2所示。从表2可以看出,在A1区域添加Shuffle Channel模块,准确率明显升高。其原因是将输入特征与输出特征连接后进行通道混洗,从而达到不同通道间信息交换的目的,增加了模型非线性表示能力[28-29]。在A2区域添加Channel Shuffle,虽然准确率相较于在A1位置提升0.12个百分点,由于添加的Channel Shuffle模块过多,参数量增加5.34×106,同时准确率提升不大,总体不利于轻量化性能提升。而在A3区域添加Channel Shuffle模块后,参数量基本不变且准确率下降,效果最差。

表2 Channel Shuffle在不同位置的效果

Tab.2 Effect of Channel Shuffle at different positions

模块位置准确率/%精确率/%召回率/%F1值/%参数量A198.1592.1392.3189.479.26×106A298.2792.2497.3296.581.46×107A396.4890.5892.1076.279.26×106

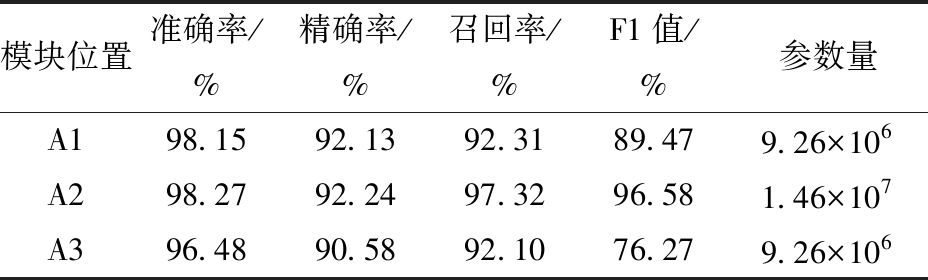

为探究Swin Transformer模块对网络性能的影响,分别将Swin Transformer加入到网络中第3个特征提取模块(B1)和第4个特征提取模块(B2)后进行验证,如图9所示。

图9 Swin Transformer添加位置

Fig.9 Position of Swin Transformer

实验结果如表3所示。从表3可以看出,在B1位置添加Swin Transformer模块后在验证集上最高准确率为99.87%,相较于不添加Swin Transformer模块的基准模型FasterNet准确率96.19%,提高3.68个百分点,其主要原因可能是抽穗期高分辨率图像上具有大量的麦穗,而Swin Transformer模块能够更加关注密集的小目标[30],同时能减少背景干扰带来的影响。而在B2处添加Swin Transformer模块后准确率相较于基准模型下降0.44个百分点,同样遇到了在最后一层卷积上添加模块导致准确率降低的问题,其原因可能是由于特征在B2之前就已经固定。由于增加的模块仅位置不同而数量相同,并没有造成参数量改变。

表3 Swin Transformer在不同位置的效果

Tab.3 Effect of Swin Transformer at different positions

模块位置准确率/%精确率/%召回率/%F1值/%参数量B199.8799.6999.3199.501.81×107B295.7596.7896.3296.551.81×107

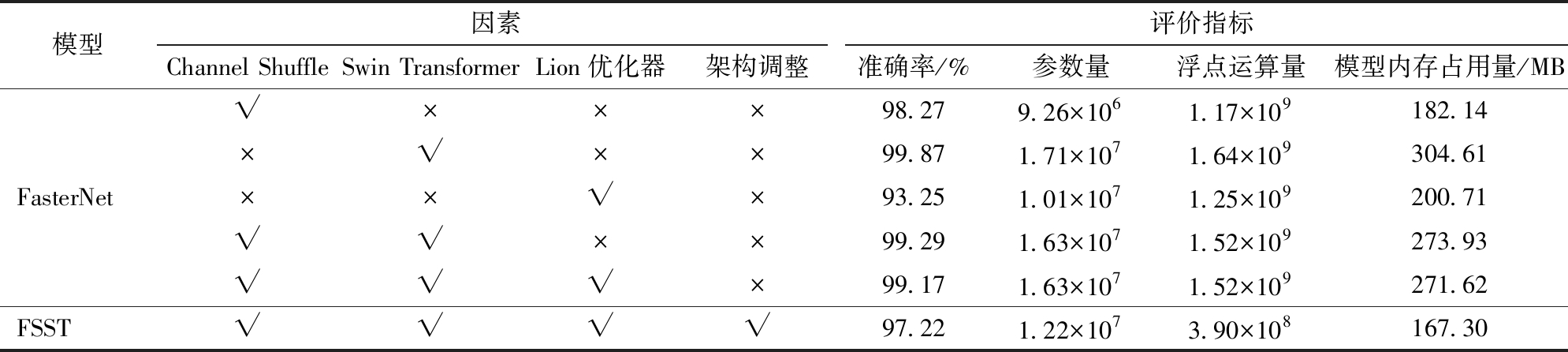

为了探究使用Channel Shuffle、Swin Transformer、Lion优化器和架构调整的改进方式对FasterNet模型性能的影响,在小麦生育期数据集上进行了消融实验,结果如表4所示。

表4 消融实验结果

Tab.4 Results of ablation experiment

注:√表示使用该模块,×表示不使用该模块。

模型因素评价指标Channel ShuffleSwin TransformerLion优化器架构调整准确率/%参数量浮点运算量模型内存占用量/MB√×××98.279.26×1061.17×109182.14×√××99.871.71×1071.64×109304.61FasterNet××√×93.251.01×1071.25×109200.71√√××99.291.63×1071.52×109273.93√√√×99.171.63×1071.52×109271.62FSST√√√√97.221.22×1073.90×108167.30

由表4可知,加入Swin Transformer模块带来的精度提升最明显,比原始FasterNet模型提高3.68个百分点。加入Channel Shuffle后准确率提升虽然较少,但参数量有所降低,Channel Shuffle模块能够同时提升模型准确率并降低参数量和内存占用量。调整网络结构后,准确率下降1.95个百分点,但参数量直接从1.52×109优化至3.90×108,内存占用量也从271.62 MB下降至167.30 MB,与此相比调整网络结构带来准确率降低可忽略不计。

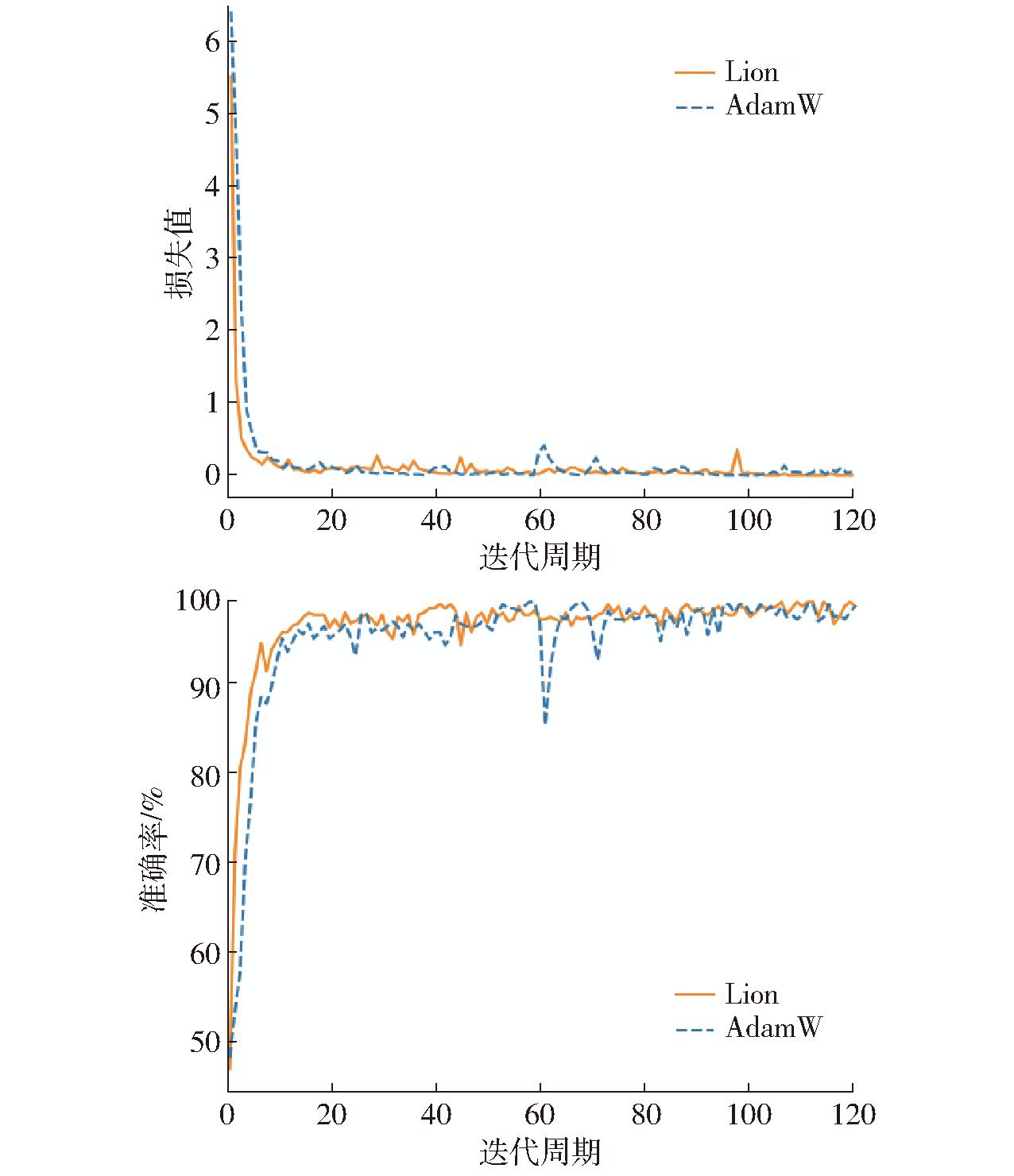

为了提高训练速度,使得模型快速收敛,使用Lion优化器替换AdamW优化器,两种优化器在训练过程中损失值与准确率如图10所示。优化器本身的改变并不能直接影响模型的尺寸、参数量、浮点运算量与内存占用量等相关指标。在小麦生育期验证集中Lion优化器带来的精度提升是模型收敛速度变快的结果,随着轮数持续增加,Lion优化器与AdamW优化器最终准确率接近。

图10 Lion与AdamW训练中损失值与准确率对比

Fig.10 Comparison of training loss and accuracy between Lion and AdamW

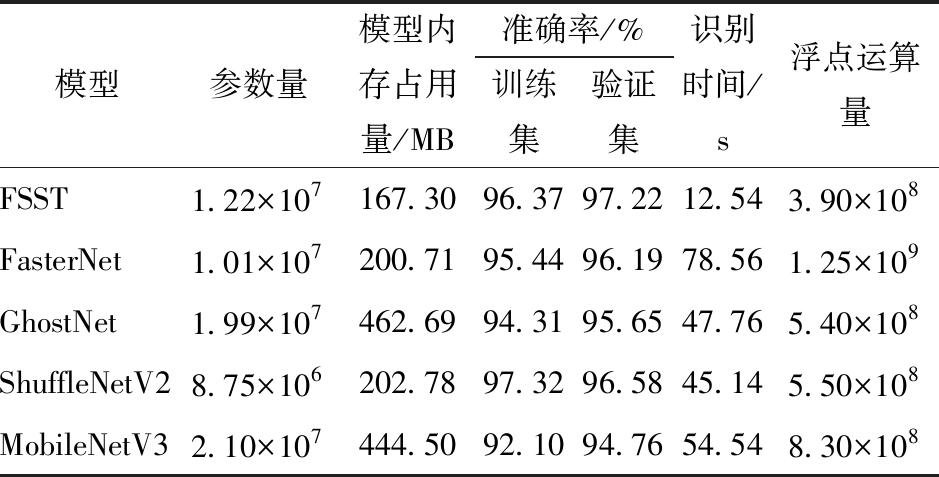

采用FSST、FasterNet、GhostNet、MobileNetV3和ShuffleNetV2共5种深度卷积网络模型获得的小麦生育期图像分类结果如表5所示。

表5 模型性能对比

Tab.5 Comparison of model performance

注:其中识别时间是在Intel i3 550 CPU环境下,累计识别100幅像素尺寸为448像素×448像素图像的总消耗时间。

模型参数量模型内存占用量/MB准确率/%训练集验证集识别时间/s浮点运算量FSST1.22×107167.3096.3797.2212.543.90×108FasterNet1.01×107200.7195.4496.1978.561.25×109GhostNet1.99×107462.6994.3195.6547.765.40×108ShuffleNetV28.75×106202.7897.3296.5845.145.50×108MobileNetV32.10×107444.5092.1094.7654.548.30×108

从表5可以看出,FSST模型对小麦生育期图像识别的准确率最高,且识别速度最快。在参数量上,由于FSST模型中含有Swin Transformer模块,因此相比于FasterNet参数量增加2.10×106。在内存占用量、准确率和识别时间3个指标上,相比于FasterNet、GhostNet、ShuffleNetV2和MobileNetV3,均取得了最优的结果。

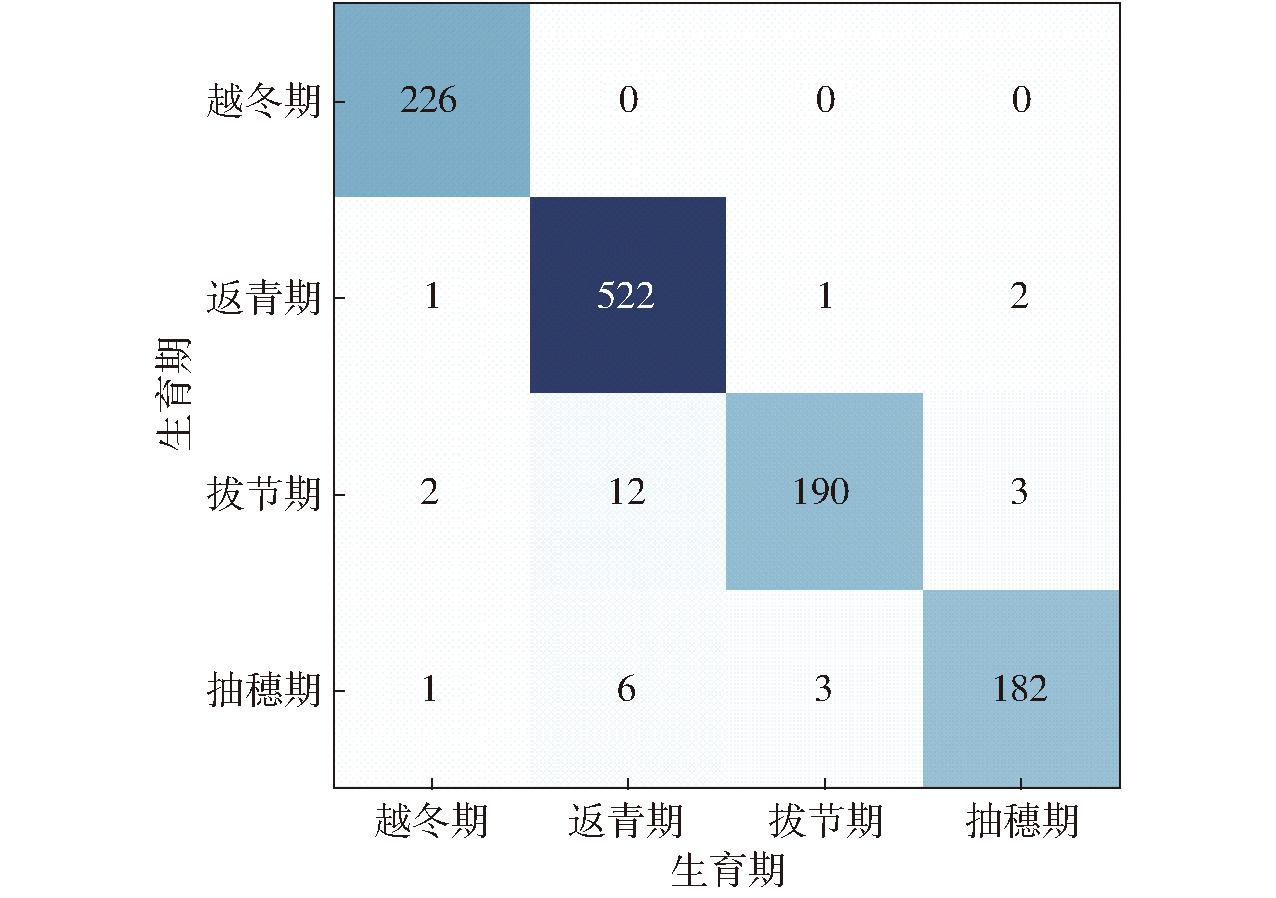

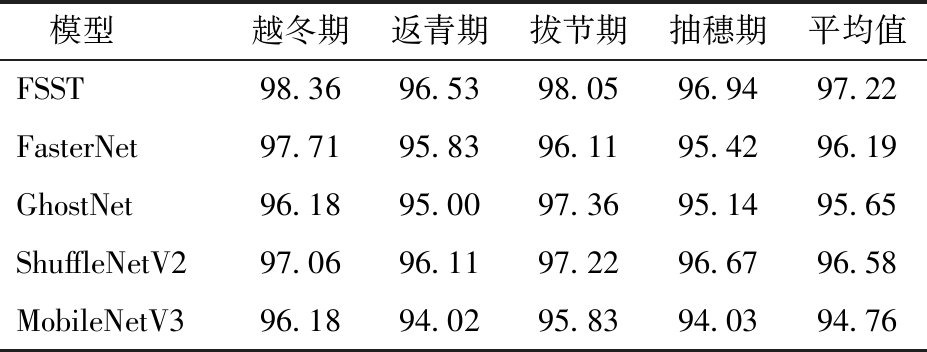

为了验证在实际场景下模型对小麦各生育期的识别率,将上述模型在不同生育期下的测试集上进行识别,结果见表6,FSST网络模型4个生育期平均正确识别率达到97.22%,训练集识别错误样本仅有128个,验证集识别错误样本有31个。各个生育期正确识别率也均优于其他对比模型。其中FSST模型在4个生育期上的混淆矩阵如图11所示。

图11 FSST模型在4个生育期上的混淆矩阵

Fig.11 Confusion matrix of FSST in four growth stages

表6 不同模型在小麦生育期验证集下识别准确率

Tab.6 Recognition accuracy of different models on wheat growth stage validation set %

模型越冬期返青期拔节期抽穗期平均值FSST98.3696.5398.0596.9497.22FasterNet97.7195.8396.1195.4296.19GhostNet96.1895.0097.3695.1495.65ShuffleNetV297.0696.1197.2296.6796.58MobileNetV396.1894.0295.8394.0394.76

由图11可知,大部分识别错误的图像集中在拔节期和抽穗期。而越冬期图像与其他3个生育期图像差异较为明显,识别准确率最高。返青期、拔节期、抽穗期可能由于图像经过一系列增强处理,导致部分关键特征被抹除,如果能够拥有更多不同的训练集图像,或未来采用更好的图像增强策略,可能会提高模型在这3个生育期的识别准确率。

(1)将Channel Shuffle引入到FasterNet中,参数量减少8.4×105。将Swin Transformer加入FasterNet后,模型对特征的提取能力明显增强,在测试集上准确率提高3.68个百分点。

(2)调整网络结构后,调整FasterNet的输出通道数和基本单元的堆叠次数可以大幅度降低模型复杂度,提出的FSST在小麦生育期图像测试集识别准确率为97.22%,并且在Intel i3 550 CPU环境下平均100幅为448像素×448像素生育期图像推理时间为12.54 s。在训练中使用Lion优化器替换AdamW优化器,能够加速网络收敛,并提升网络推理精度。

(3)FSST与FasterNet、GhostNet、ShuffleNetV2、MobileNetV3 4种卷积神经网络模型相比,FSST模型性能更佳,综合表现更好;基于FasterNet改进的FSST模型能够兼顾性能和精度。

(4)提出的方法能够快速精准和轻量化地识别小麦关键生育期,为作物物候特性实时智能监控提供了技术支持。

[1] 中国人民共和国国家统计局. 中国统计年鉴 2022[M]. 北京:中国统计出版社,2022.

[2] 杨蜀秦,林丰山,徐鹏辉,等. 基于无人机遥感影像的多生育期冬小麦种植行检测方法[J]. 农业机械学报,2023,54(2):181-188. YANG Shuqin, LIN Fengshan, XU Penghui, et al. Planting pow detection of multi-growth winter wheat field based on UAV remote sensing image[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(2):181-188.(in Chinese)

[3] 周琦,王建军,霍中洋,等. 不同生育期小麦冠层SPAD值无人机多光谱遥感估算[J]. 光谱学与光谱分析,2023,43(6):1912-1920.ZHOU Qi, WANG Jianjun, HUO Zhongyang, et al. UAV multi-spectral remote sensing estimation of wheat canopy SPAD value in different growth periods[J]. Spectroscopy and Spectral Analysis,2022,42(10):3269-3274.(in Chinese)

[4] 兰仕浩,李映雪,吴芳,等. 基于卫星光谱尺度反射率的冬小麦生物量估算[J]. 农业工程学报,2022,38(24):118-128.LAN Shihao, LI Yingxue, WU Fang, et al.Winter wheat biomass estimation based on satellite spectral-scale reflectance[J]. Transactions of the CSAE, 2022, 38(24):118-128.(in Chinese)

[5] 杨欣,袁自然,叶寅,等. 基于无人机高光谱遥感的冬小麦全氮含量反演[J]. 光谱学与光谱分析,2022,42(10):3269-3274.YANG Xin, YUAN Ziran, YE Yin, et al. Winter wheat total nitrogen content estimation based on UAV hyperspectral remote sensing[J]. Spectroscopy and Spectral Analysis, 2022,42(10):3269-3274.(in Chinese)

[6] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016:770-778.

[7] 徐建鹏,王杰,徐祥,等. 基于RAdam卷积神经网络的水稻生育期图像识别[J]. 农业工程学报,2021,37(8):143-150.XU Jianpeng, WANG Jie, XU Xiang, et al. Image recognition for different developmental stages of rice by RAdam deep convolutional neural networks[J]. Transactions of the CSAE, 2021,37(8):143-150.(in Chinese)

[8] 申华磊,苏歆琪,赵巧丽,等. 基于深度学习的无人机遥感小麦倒伏面积提取方法[J]. 农业机械学报,2022,53(9):252-260,341.SHEN Hualei, SU Xinqi, ZHAO Qiaoli, et al. Extraction of lodging area of wheat barieties by unmanned aerial vehicle remote sensing based on deep learning[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(9): 252-260, 341.(in Chinese)

[9] 李云霞,马浚诚,刘红杰,等. 基于RGB图像与深度学习的冬小麦田间长势参数估算系统[J].农业工程学报,2021,37(24):189-198.LI Yunxia, MA Juncheng, LIU Hongjie, et al. Field growth parameter estimation system of winter wheat using RGB digital images and deep learning[J]. Transactions of the CSAE, 2021, 37(24):189-198.(in Chinese)

[10] 孙少杰,吴门新,庄立伟,等. 基于CNN卷积神经网络和BP神经网络的冬小麦县级产量预测[J]. 农业工程学报, 2022,38(11):151-160.SUN Shaojie, WU Menxin, ZHUANG Liwei, et al. Forecasting winter wheat yield at county level using CNN and BP neural networks[J]. Transactions of the CSAE, 2022,38(11):151-160.(in Chinese)

[11] TAN M, LE Q. Efficientnet: rethinking model scaling for convolutional neural networks[C]∥International Conference on Machine Learning, 2019:6105-6114.

[12] MA N, ZHANG X, ZHEN H T,et al. Shufflenet v2:practical guidelines for efficient CNN architecture design[C]∥Proceedings of the European Conference on Computer Vision,2018:116-131.

[13] ANDREW H, ZHU M L, CHEN B, et al. MobileNets: efficient convolutional neural networks for mobile vision applications[J]. arXiv preprint arXiv: 1704.04861,2017,4.

[14] MARK S, ANDREW H, ZHU Menglong, et al. MobileNetV2: inverted residuals and linear bottlenecks[J]. arXiv preprint arXiv: 1801.04381,2018,1.

[15] ANDREW H, MARK S, CHU G, et al. Searching for MobileNetV3[J]. arXiv preprint arXiv: 1905.02244,2019,5.

[16] HAN K, WANG Y H, TIAN Q, et al. GhostNet: more features from cheap operations[J]. arXiv preprint arXiv: 1911.11907,2019,11.

[17] CHEN J R, KAO S H, HE H, et al. Run, don’t walk: chasing higher FLOPS for faster neural networks[J]. arXiv preprint arXiv: 2303.03667, 2023, 3.

[18] 杨森森,张昊,兴陆,等. 改进MobileViT网络识别轻量化田间杂草[J]. 农业工程学报,2023,39(9):152-160.YANG Sensen, ZHANG Hao, XING Lu, et al. Light weight recognition of weeds in the field based on improved MobileViT network[J]. Transactions of the CSAE, 2023,39(9):152-160.(in Chinese)

[19] 苗荣慧,李志伟,武锦龙. 基于改进YOLO v7的轻量化樱桃番茄成熟度检测方法[J]. 农业机械学报,2023,54(10):225-233.MIAO Ronghui, LI Zhiwei, WU Jinglong. Lightweight maturity detection of cherry tomato based on improved YOLO v7[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(10):225-233.(in Chinese)

[20] 范晓飞,王林柏,刘景艳,等. 基于改进YOLO v4的玉米种子外观品质检测方法[J]. 农业机械学报,2022,53(7):226-233.FAN Xiaofei, WANG Linbai, LIU Jingyan, et al. Corn seed appearance quality estimation based on improved YOLO v4[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022,53(7):226-233.(in Chinese)

[21] 孙道宗,丁郑,刘锦源,等. 基于改进SqueezeNet模型的多品种茶树叶片分类方法[J]. 农业机械学报,2023,54(2):223-230,248.SONG Daozong, DING Zheng, LIU Jinyuan, et al. Classification method of multi-variety tea leaves based on improved SqueezeNet model[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(2):223-230,248.(in Chinese)

[22] CHEN X N, CHEN L, DA H, et al. Symbolic discovery of optimization algorithms[J]. arXiv preprint arXiv: 2302.06675,2023,2.

[23] SACHIN M, MOHAMMAD R. MobileViT: light-weight, general-purpose, and mobile-friendly vision transformer[J]. arXiv preprint arXiv: 2110.02178, 2021, 5.

[24] DENG J, DONG W, SOCHER R, et al. ImageNet: a large-scale hierarchical image database[C]∥IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society, 2009:248-255.

[25] KINGMA D, BA J. Adam: a method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014, 12.

[26] LIU L Y, JIANG H M, HE P C, et al. On the variance of the adaptive learning rate and beyond[J]. arXiv preprint arXiv: 1908.03265, 2019, 8.

[27] ILYA L, FRANK H. Decoupled weight decay regularization[J]. arXiv preprint arXiv: 1711.05101, 2017, 11.

[28] 宋怀波,华志新,马宝玲,等. 基于SimCC-ShuffleNetV2的轻量化奶牛关键点检测方法[J]. 农业机械学报, 2023, 54(10): 275-281,363. SONG Huaibo, HUA Zhixin, MA Baoling, et al. Lightweight keypoint detection method of dairy cow based on SimCC-ShuffleNetV2[J].Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(10): 275-281,363. (in Chinese)

[29] 陈丽,王世勇,高思莉,等. Sentinel-2卫星的多光谱轻量级船舶目标检测算法[J]. 光谱学与光谱分析,2022,42(9):2862-2869. CHEN Li, WANG Shiyong, GAO Sili, et al.Multispectral lightweight ship target detection algorithm for Sentinel-2 satellite[J]. Spectroscopy and Spectral Analysis, 2022, 42(9): 2862-2869.(in Chinese)

[30] 赵辉,黄镖,王红君,等. 基于改进YOLO v7的农田复杂环境下害虫识别算法研究[J]. 农业机械学报,2023,54(10):246-254. ZHAO Hui, HUANG Biao, WANG Hongjun, et al. Pest identification method in complex farmland environment based on improved YOLO v7[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023,54(10):246-254.(in Chinese)