由于不同产区土壤、环境的差异,生产的花生品质明显不同[1-3]。在花生市场上,售卖贴着优质产地标签的劣质花生十分常见。因此,提出一种对花生产地进行品质溯源的技术至关重要。

传统的花生质量鉴别方法主要包括人工感官评价和理化检测两种方法[4]。人工感官评价具有主观性强、重现性差等缺点[5]。理化检测方法是一种破坏性检测,且存在成本高、时效性较差等问题[6]。因此,提出一种快速、无损的客观检测方法以实现花生的产地溯源具有重要的意义。

电子鼻是一种模拟人类嗅觉系统开发的仿生检测系统,它通过交叉敏感的气体传感器阵列获得待测样品的气体信息[7]。高光谱结合图像和光谱分析技术可实现待测样品化学键以及官能团的快速检测[8]。不同产地花生自内而外的气体信息可以表征其整体宏观质量,不同化学键及官能团的信息差异可以表征其整体微观质量。因此,以不同产地花生自身化学质量特性为一致性融合导向,结合宏观和微观信息可以更全面地表征花生整体质量。综上,本文基于电子鼻与高光谱系统的快速、无损的客观方法实现不同产地花生质量的传感检测。

获取气体-光谱双模态信息后,有效的数据处理方法是提升检测性能的重要因素。针对双模态信息数据处理,现主要分析框架为:气体特征提取(光谱波段处理)+特征融合+模式识别。SHI等[9]提取气体信息的时域特征,利用稳定性竞争自适应重加权采样获取重要光谱波段,在结合变量重要性融合双模态信息,最后基于支持向量机实现大米品质辨识。徐赛等[10]利用线性判别分析结合气体-光谱双模态融合信息对番石榴机械损伤进行识别研究。REN等[11]利用偏最小二乘线性判别分析辨识皮蛋质量。AHETO等[12]提取气体信息时域特征,结合竞争自适应重加权采样获取的光谱波段作为融合信息,再结合极限学习机实现猪肉质量辨识。李玉花等[13]设计了一种基于电子鼻和视觉数据融合的检测装置,基于支持向量机建立鸡肉新鲜度分级模型。张春娟等[14]利用电子鼻和近红外光谱技术,构建了支持向量机和偏最小二乘法模型,实现了羊肉中掺入不同比例鸭肉样品的有效鉴别。然而,模式识别方法与特征提取、特征融合过程相互独立,最佳的数据处理组合需要不断尝试,存在人工干预过多、智能化程度低的缺点,这直接导致数据处理方法的泛化能力和分类性能低。集成特征提取、特征处理和模式识别系统过程的方法可提升数据处理的自适应性及分类性能。

卷积神经网络(Convolutional neural networks,CNN)是深度学习的代表算法之一,它通过卷积层进行特征提取与特征处理,利用全连接层进行模式分类,通过设计合理的网络结构即可集成特征提取、特征处理和模式识别的系统过程[15-16]。SHI等[17]利用CNN提取气体-光谱双模态融合特征,并结合全局扩展极限学习机实现大米质量辨识。MEN等[18]提出交错注意力卷积压缩网络融合识别气体-光谱双模态信息,实现不同贮藏期大米质量评价。LIU等[19]构建了输入-修正CNN融合电子鼻与高光谱信息对羊肉的新鲜度进行检测。

CNN具有强大的自适应信息处理能力,气体-光谱双模态信息融合过程中包含提升分类性能的重要特征,也包含降低分类性能的冗余特征。同时,双模态信息的自适应重要性融合过程也直接影响最终的分类性能。现利用CNN处理气体-光谱双模态融合信息未充分考虑重要特征以及信息融合过程对分类性能的影响,也会降低CNN的分类性能。综上,本文提出一种数据融合方法对不同产地花生的气体-光谱双模态检测信息进行处理,以期为花生质量监督提供一种有效的技术。

实验样本来自贵州省铜仁市、山东省烟台市、河南省南阳市、黑龙江省哈尔滨市、辽宁省锦州市、吉林省松原市和河北省沧州市共7种不同种植地区同年生产的同品种(白沙)花生。白沙花生具有果仁饱满、营养价值高、口感好等特点,且具有较好的储存性,深受消费者喜爱[20]。然而,尽管样本来自不同地理位置、相距较远的种植区,但它们仍然表现出相似的外形和颜色特征,人工主观很难判断不同产地花生的质量差异。

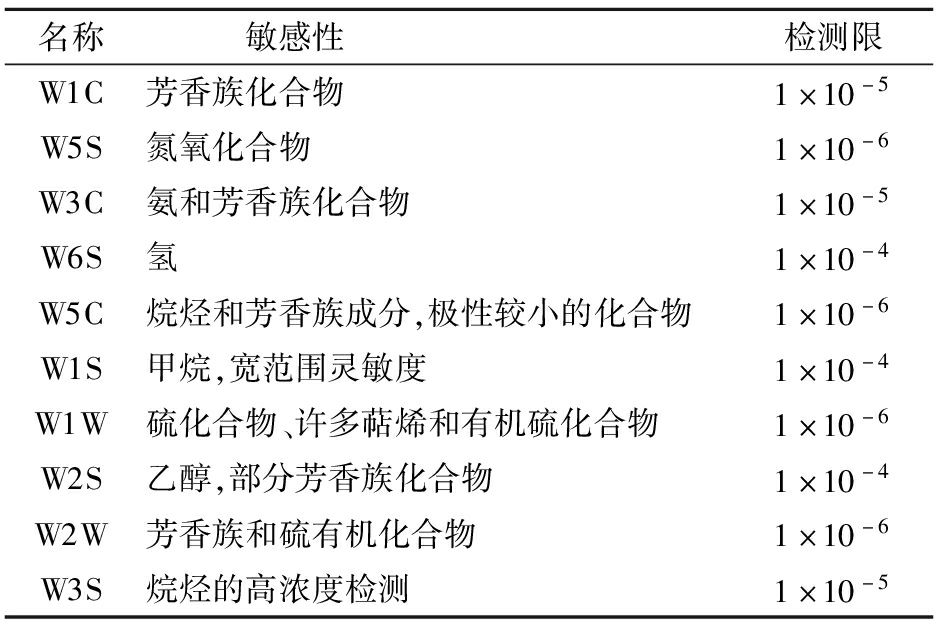

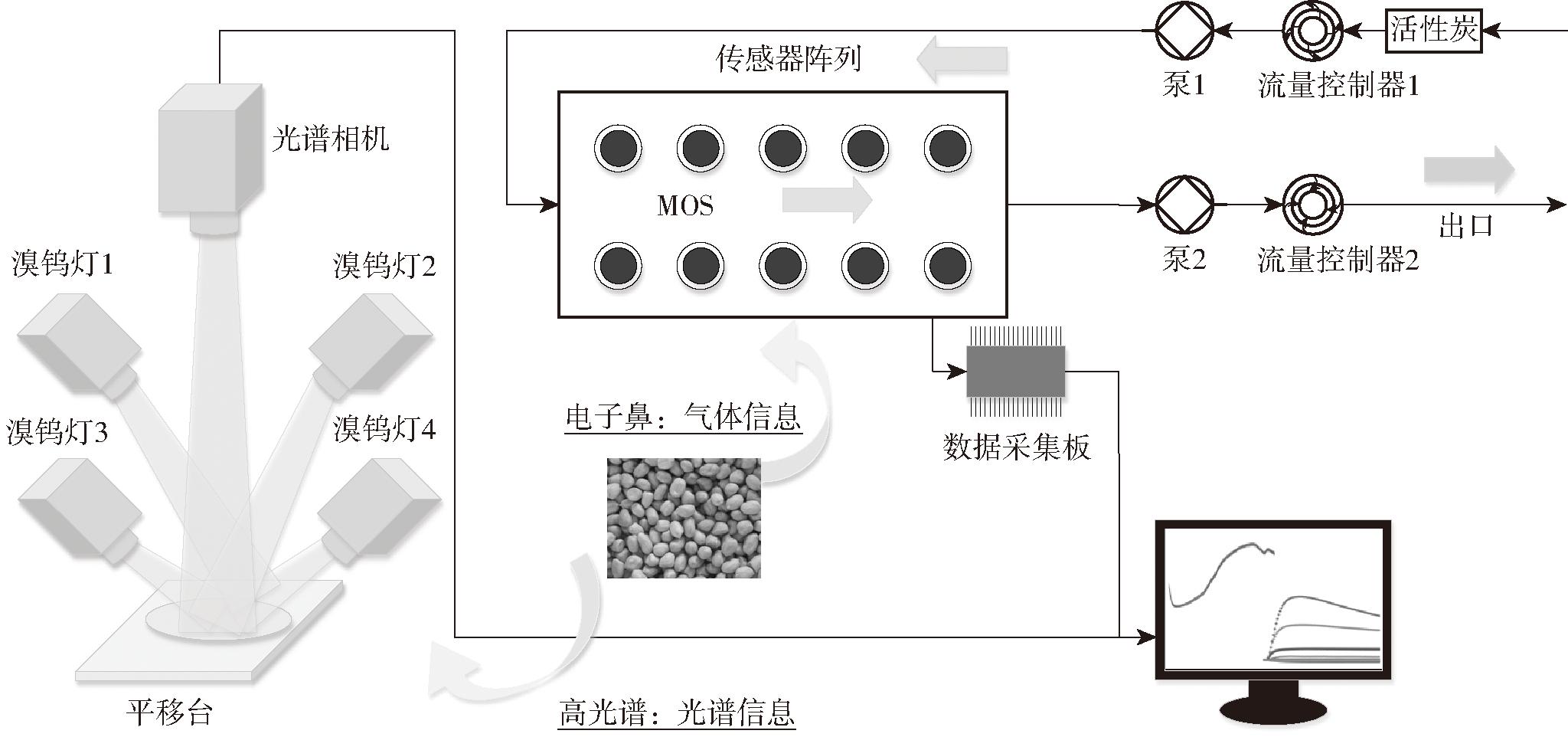

图1为实现花生气体-光谱双模态信息检测的融合系统结构图。本实验利用PEN3电子鼻(Airsense Analytics Inc.,德国)获取花生的气体信息。该装置由数据采集系统、传感器阵列以及采样和清洗通道3部分构成,气体传感器可实现花生整体气体信息的检测。当花生气体与传感器表面接触时会发生氧化还原反应,进而改变传感器电导率G。传感器响应输出为G与经过活性炭过滤后洁净气体与传感器表面接触时产生电导率G0的比值,表1为传感器主要性能参数。

表1 PEN3机器嗅觉系统传感器参数

Tab.1 Sensor parameters of PEN3 machine olfaction system

名称 敏感性检测限W1C芳香族化合物1×10-5W5S氮氧化合物1×10-6W3C氨和芳香族化合物1×10-5W6S氢1×10-4W5C烷烃和芳香族成分,极性较小的化合物1×10-6W1S甲烷,宽范围灵敏度1×10-4W1W硫化合物、许多萜烯和有机硫化合物1×10-6W2S乙醇,部分芳香族化合物1×10-4W2W芳香族和硫有机化合物1×10-6W3S烷烃的高浓度检测1×10-5

图1 电子鼻和高光谱的融合系统结构图

Fig.1 Fusion system architecture diagram of electronic nose and hyperspectral

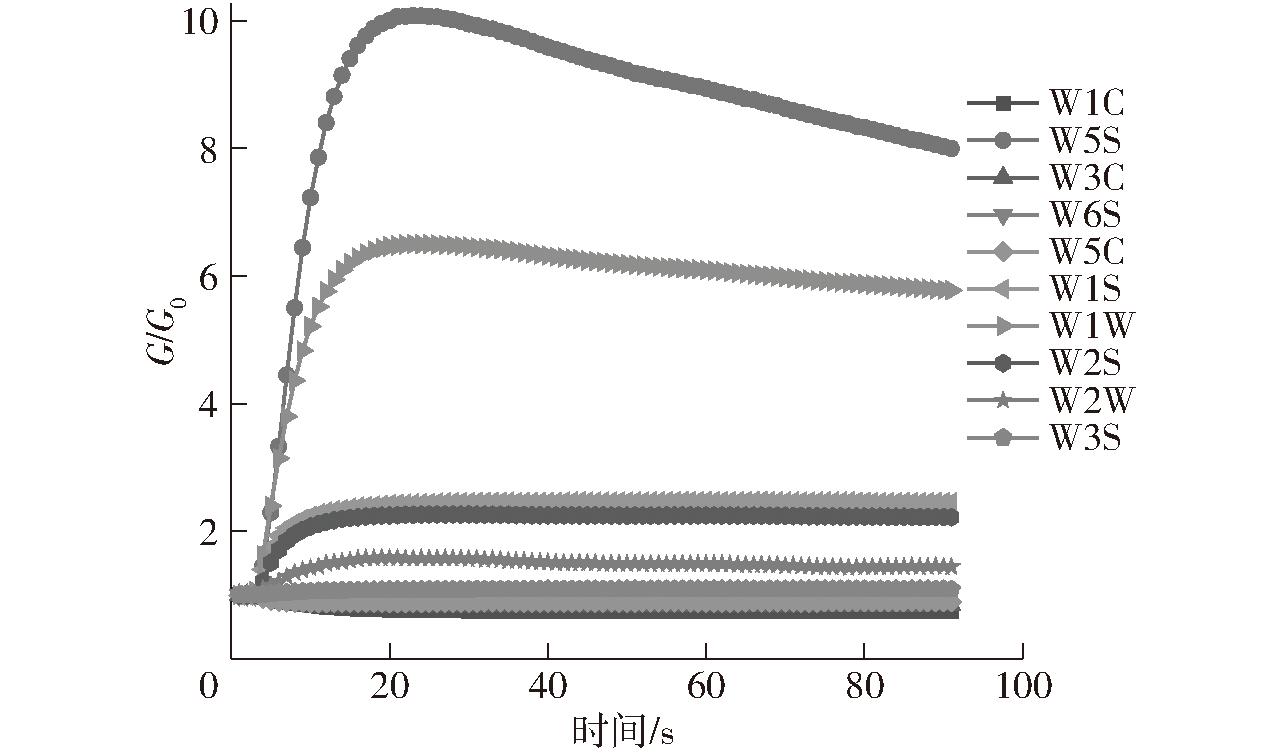

电子鼻实验时,环境温度为(25±1)℃,获取花生气体信息的过程如下:①电子鼻系统开机预热1 h,保证传感器阵列在正常的工作范围内,使其输出稳定的信号。②将250 g花生放置于500 mL的样品瓶中,密封保存40 min以确保顶空空气充足。③在每次实验前,用经活性炭滤过的洁净空气以速度300 mL/min通入系统30 s以清洗气路和传感器气室。④利用动态顶空的采样方法,将花生气体以流速300 mL/min通入系统90 s获取气体信息。以贵州省铜仁市花生为例,图2为花生气体信息响应曲线。⑤为不失一般性,重复步骤②~④。每个产地花生准备50个平行样本,7个产地的花生共获得350个样本,每个样本气体信息数据形式为90×10。其中,90为采样点数量,10为传感器数量。

图2 气体信息响应曲线

Fig.2 Gas information response curves

本实验利用GaiaSorter高光谱图像系统(卓力汉光仪器有限公司)获取花生光谱信息。该系统由光谱相机、电控移动平台、均匀光源和控制软件组成。在检测过程中,电控移动平台以匀速移动花生,通过光谱相机完成反射光采集,并获取光谱图像。该实验系统使用的光谱相机为image-α-V10 LU,光谱相机分辨率为1 344像素×1 024像素,光谱覆盖范围为380~1 038 nm,最大波段数为520。

高光谱实验时,环境温度为(25±1)℃,获取花生光谱信息过程如下:①调整系统参数:光谱相机曝光时间为10 ms,且距离样品10 cm,电控移动平台速度为0.28 cm/s,光源强度在90%以上。②实验过程中,由于光源分布不均、系统噪声等问题会影响获取的光谱图像质量,所以需对光谱图像进行黑白校正以缓解干扰,黑白校正公式为

(1)

式中 U——校正后光谱图像

U0——原始光谱图像

C——全黑标准图像

W——全白标准图像

③将花生放置在直径为20 cm的样品实验盘中,将实验盘放置在电控移动平台上后平台匀速移动,光谱相机获取光谱图像,通过黑白校正处理后完成一次信息采集。④为不失一般性,重复步骤③。每个产地花生准备50个平行样本,7个产地的花生共获得350个样本。

光谱图像尺寸为1 344像素×1 024像素,且图像中包含样品和背景区域,直接处理光谱在有限条件下会增加数据处理难度,降低分类方法稳定性。因此,本文在光谱图像中划定感兴趣区域,计算感兴趣区域的光谱均值,在不损失空间光谱结构的基础上获得光谱信息。经过预实验确定以样品实验盘中心为感兴趣区域中心点,选取200像素×200像素的正方形为感兴趣区域。每个样本获得的光谱信息数据形式为1×520,520为波段数。

1.3.1 光谱信息预处理

由于光的散射、系统及背景干扰等因素,使光谱信息中存在大量噪声。因此,本文利用光谱信息预处理技术提升数据有效性。以贵州省铜仁市花生为例,图3a为原始光谱图像。预处理过程中,首先通过S-G平滑滤波(Savitzky-Golay smoothing,S-G)处理原始光谱数据以减少数据抖动并提高信噪比,然后引入标准正态变量(Standard normal variate,SNV)来消除散射和颗粒尺寸的乘法干扰。图3b为光谱信息的S-G预处理结果,可以看出处理后光谱数据具有良好的平滑性。图3c为进一步利用SNV进行预处理的结果,该方法有效地消除散射和粒度的倍增干扰,减少类内差异。

图3 光谱信息处理过程图

Fig.3 Diagrams of spectral information processing process

1.3.2 信息融合方法

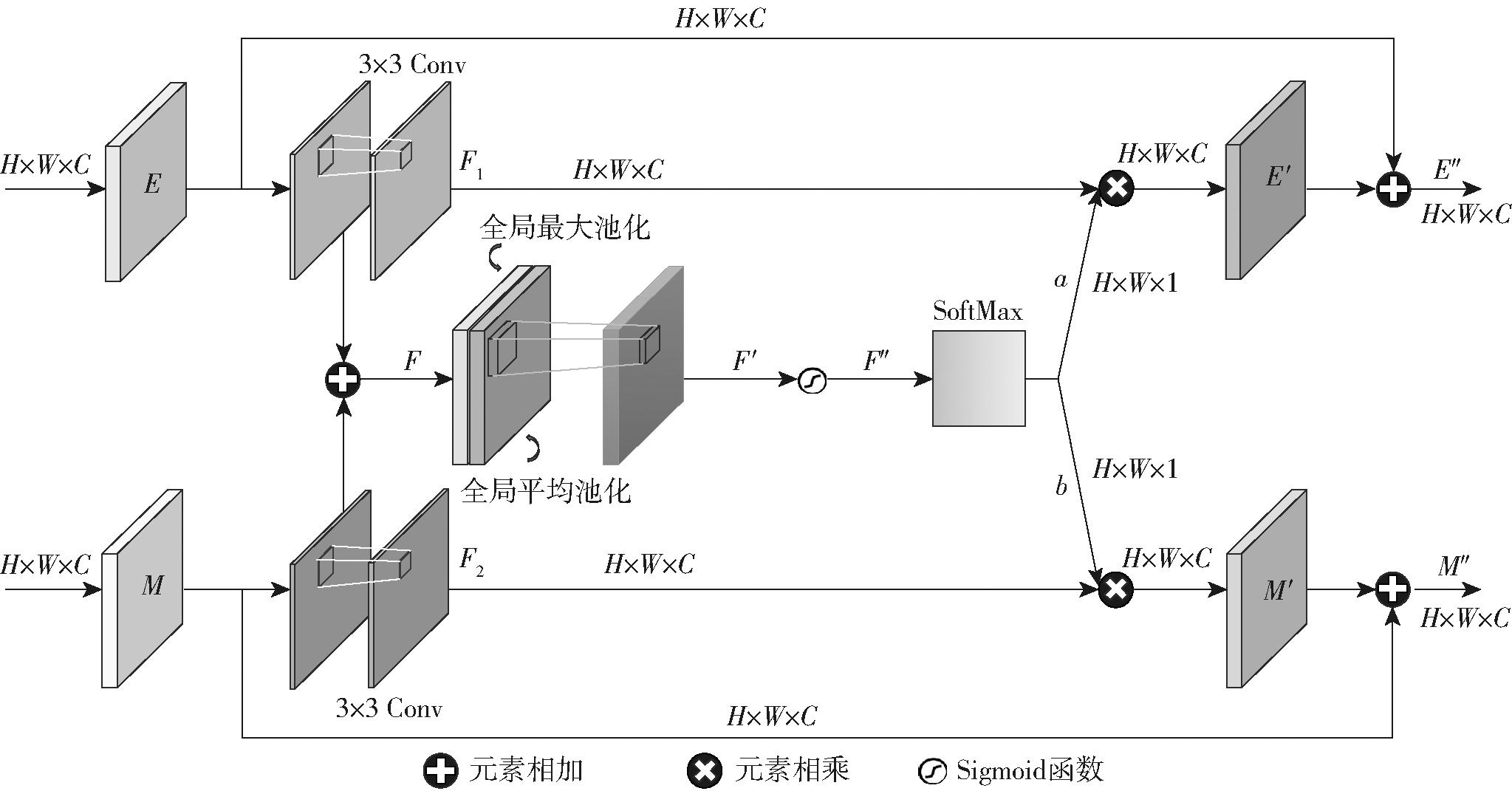

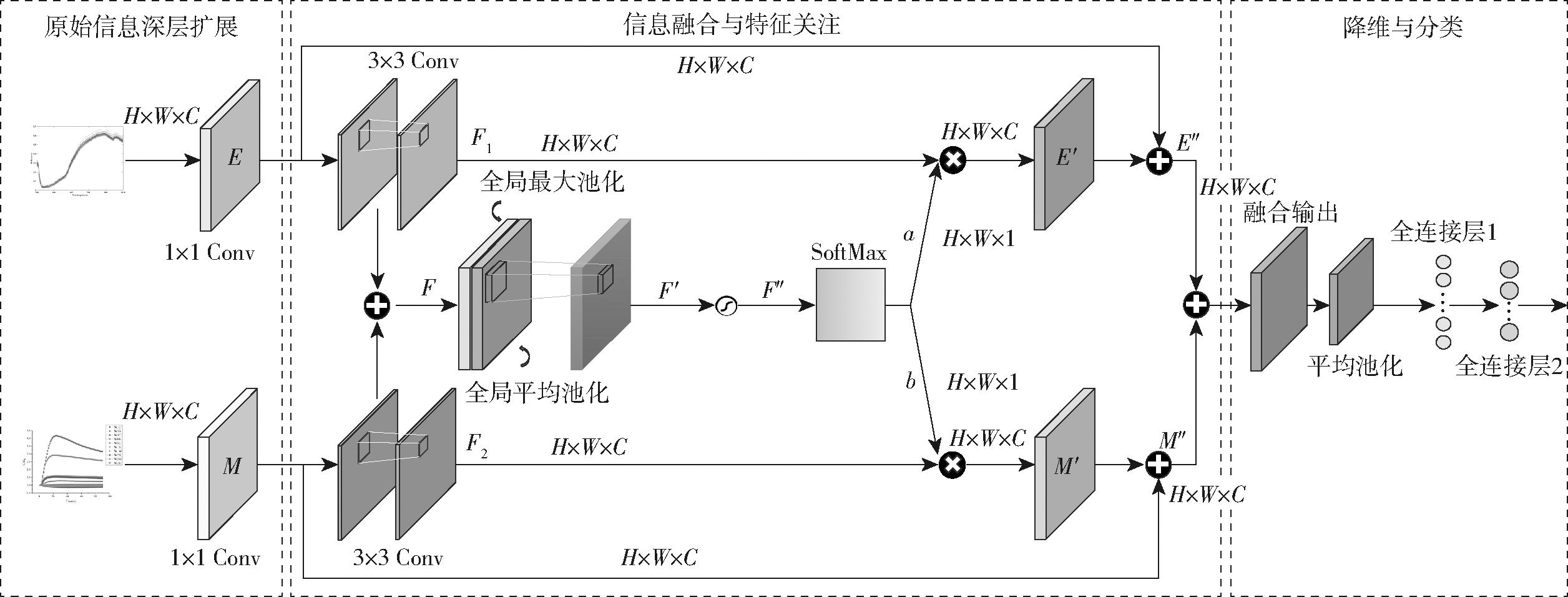

利用交叉敏感的气体传感器阵列获得的检测数据是气体综合信息的输出结果,包含一类化学键和官能团的光谱吸收也是综合信息的输出结果。因此,利用卷积计算对原始气体-光谱双模态信息进行解码是合理的。在解码后的深层信息中,包含提升分类性能的重要特征,也有降低分类性能的冗余特征。因此,本文提出了面向气体-光谱深层融合信息的DFFA模块以实现双模态信息的自适应融合与重要特征关注。图4为DFFA模块结构示意图。

图4 DFFA模块结构示意图

Fig.4 Module structure schematic of DFFA

设深层气体、光谱信息维度为RH×W×C。就深层气体信息而言,H表示时间采样点个数,W表示传感器个数。就深层光谱信息而言,H和W表示矩阵转换后的光谱波段维度,C表示深层卷积通道数。

首先,深层气体信息(E)和光谱信息(M)分别利用3×3卷积核进行特征提取,通过添加填充项保证输入输出尺寸不变,其计算过程可表示为

F1=Conv(E)

(2)

F2=Conv(M)

(3)

式中 F1——经卷积核特征提取后的气体信息

F2——经卷积核特征提取后的光谱信息

Conv——3×3卷积操作

按矩阵元素对双通道的计算结果相加,以获得融合信息,计算过程可以表示为

F=F1+F2

(4)

式中 F——气体、光谱融合信息

然后分别按通道维度方向获得全局最大平均池化和全局平均池化的空间计算结果。全局最大池化可以获得深层融合信息的重要特征,全局平均池化可以获得深层融合信息的整体特征。获得全局最大池化和全局平均池化的计算结果后,利用3×3卷积核融合特征计算结果,再使用Sigmoid激活函数将该计算结果映射到(0,1)区间内,使得各个空间位置得到对应的重要性权重输出。上述计算过程可表示为

F′=Conv(AvgPooling(F);MaxPooling(F))

(5)

F″=Sigmoid(F′)

(6)

式中 F′——融合特征计算结果

F″——各个空间位置的对应重要性权重

AvgPooling——全局平均池化

MaxPooling——全局最大池化

Sigmoid——S型激活函数

进一步,引入SoftMax层以实现软注意力机制计算,该计算方法可以通过网络的自训练过程自适应分配气体-光谱双模态信息的重要性权重,实现信息的有效分流,进而提升融合效率。软注意力计算结果可以表示为

a+b=1

(7)

其中![]()

(8)

(9)

式中 a、b——气体、光谱信息输出重要性权重配比

A、B——SoftMax函数的参数

将软注意力计算结果与深层气体、光谱信息逐元素相乘以获得双模态信息的注意力计算结果。计算过程可以表示为

E′=aE

(10)

M′=bM

(11)

式中 E′——气体信息注意力计算结果

M′——光谱信息注意力计算结果

为避免特征退化,本文将注意力计算结果与原始深层气体、光谱信息融合,以获得整体信息,计算过程表示为

E″=E′+E

(12)

M″=M′+M

(13)

式中 E″——整体气体信息结果

M″——整体光谱信息结果

1.4.1 花生产地辨识网络

基于电子鼻和高光谱系统获得的检测数据具有样本数量少的特点,所以设计的双模态信息分类网络应该具有轻量化的结构特点。经过网络结构调整,图5为基于DFFA注意力机制设计的实现不同产地花生品质溯源的网络结构图,网络名称定义为DFFA-Net。图2为气体信息响应曲线,检测信息包括迅速上升和缓慢下降的整体过程,输出信号的前52 s已经包括上述2个阶段。光谱信息包括520个波段,为保证双模态融合信息处理过程维度的一致性,选择气体信息前52 s数据进行分析,且将光谱信息的维度转换为52×10。具体过程如下:

图5 DFFA-Net网络结构图

Fig.5 Network structure of DFFA-Net

(1)利用点卷积(卷积核尺寸为1×1)对原始气体-光谱双模态信息进行通道扩展以实现双模态深层信息特征提取。

(2)DFFA注意力机制被应用于实现气体-光谱双模态信息的深层特征提取与重要特征的自适应关注。

(3)融合DFFA注意力机制的计算结果,利用2×2的全局平均池化压缩特征矩阵,降低信息维度,提升数据处理效率。

(4)2个全连接层(每层神经元个数分别为128和7)被应用于建立深层气体-光谱双模态融合特征与标记空间的非线性映射关系,实现不同产地花生的品质辨识。

在网络训练过程中,利用Adam优化器训练网络参数,结合交叉熵损失函数计算训练损失以完成误差反向传播。网络训练的迭代次数为200,批训练大小为50。为了缓解梯度消失现象,在所有卷积计算后应用线性整流函数。7个不同产地的花生共包含350个样本,随机选择其中280个样本作为训练集,70个样本作为测试集。基于准确率、精确率和召回率评估DFFA-Net的分类性能,为避免随机性,利用20次计算结果的平均值和标准差作为最终的分类结果。

1.4.2 决策网络结构优化

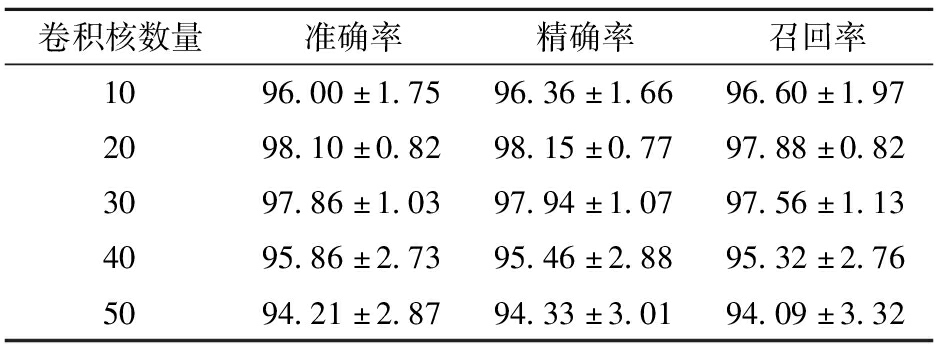

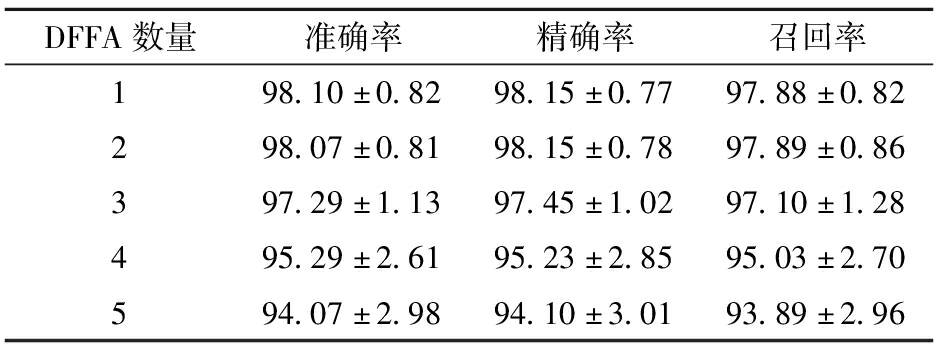

基于电子鼻和高光谱系统获取不同产地花生的检测信息具有样本数量少的特点,在有限样本条件下,DFFA-Net应该具有轻量化的结构特点以保证被充分训练。构建DFFA-Net网络结构的卷积核和DFFA个数直接影响网络的深度,进而影响网络的分类性能。因此,本文对不同卷积核和DFFA数量进行讨论,以确定最佳的DFFA-Net网络结构。

为控制变量,表2为仅包含1个DFFA模块的DFFA-Net在不同卷积核数量下的分类结果。过少的卷积核数量不能充分提取深层融合特征,过多的卷积核数量引入额外参数会造成网络训练不充分。可以看出,当卷积核数量为20时,DFFA-Net获得最佳分类性能:准确率为98.10%、精确率为98.15%、召回率为97.88%。进一步,表3显示了当卷积核数量为20时,不同DFFA数量对DFFA-Net分类性能的影响。当DFFA数量为1或2时,分类性能差异不明显。在增加DFFA数量后,DFFA-Net的分类性能明显下降,这可能由于DFFA数量增加后网络结构变深,更多的可训练参数被引入导致网络训练不充分。基于轻量化网络结构的设计思想,本文选择包含1个DFFA模块的DFFA-Net网络结构实现不同产地花生的品质辨识。

表2 卷积核数量对DFFA-Net分类性能的影响

Tab.2 Effect of number of convolutional kernels on classification performance of DFFA-Net %

卷积核数量准确率精确率召回率1096.00±1.7596.36±1.6696.60±1.972098.10±0.8298.15±0.7797.88±0.823097.86±1.0397.94±1.0797.56±1.134095.86±2.7395.46±2.8895.32±2.765094.21±2.8794.33±3.0194.09±3.32

表3 DFFA数量对DFFA-Net分类性能的影响

Tab.3 Effect of number of DFFA on classification performance of DFFA-Net %

DFFA数量准确率精确率召回率198.10±0.8298.15±0.7797.88±0.82298.07±0.8198.15±0.7897.89±0.86397.29±1.1397.45±1.0297.10±1.28495.29±2.6195.23±2.8595.03±2.70594.07±2.9894.10±3.0193.89±2.96

图6为来自7个不同产地花生气体信息在 52 s的雷达图,雷达图的中心轴数值代表气体传感器响应输出值。相比较于其他气体传感器,W1W和W5S的响应值较高,表明这2个传感器对花生气体信息较为敏感。W3C和W1C的响应值较低,表明二者对花生气体信息响应较弱。整体上,不同产地花生气体信息响应雷达图具有较高的相似性,交叉敏感的气体响应信息仅通过传感器响应数值进行识别分析易导致决策方法发生过拟合现象。

图6 不同产地花生气体信息雷达图

Fig.6 Radar maps of peanut gas information for different origins

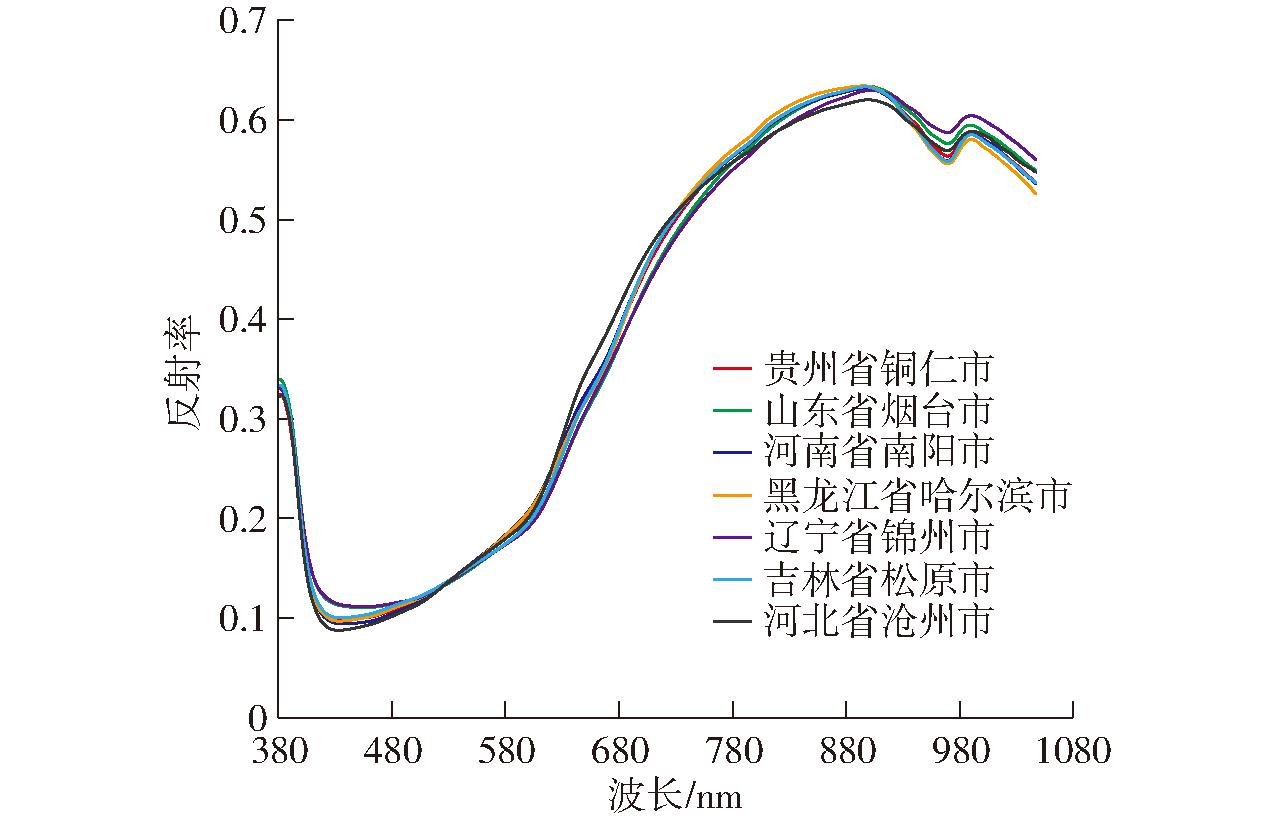

图7为7个不同产地花生经预处理后的平均光谱曲线对比结果,尽管在一些固定的特征波段下不同产地花生的光谱信息值有所差异,但整体平均光谱信息相似性较高。同时,光谱信息也为一类化学官能团综合信息的输出结果,仅通过特定波段的明显差异实现信息辨识也易导致决策方法发生过拟合现象。以不同产地花生自身化学质量特性为一致性融合导向,气体-光谱双模态信息可从宏观和微观信息更全面地表征花生整体质量。提出自适应集成信息解码、特征交互、模式识别的高性能分类方法对提升融合系统检测性能至关重要。

图7 不同产地花生光谱信息差异图

Fig.7 Difference in spectral information of peanuts from different origins

在确定DFFA-Net网络结构后,本文通过消融实验对DFFA模块中的注意力计算过程进行讨论,证明协同利用全局最大池化和全局平均池化的有效性。同时,基于DFFA-Net对双模态信息共同应用的必要性也将通过消融实验被验证。

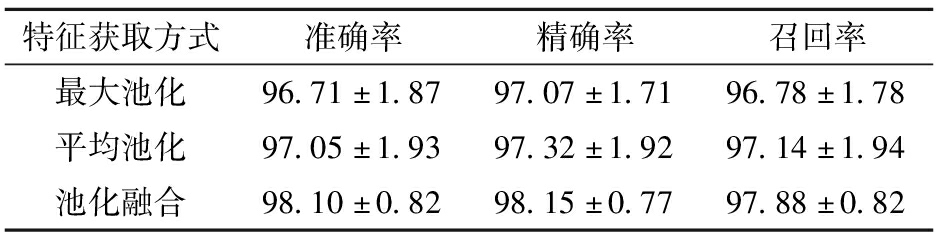

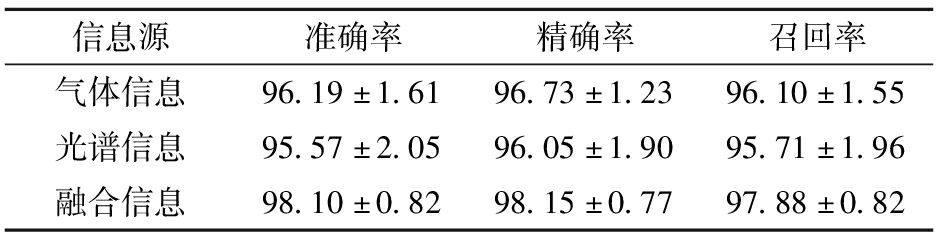

表4为注意力特征计算方式的消融实验分析结果,协同利用全局最大池化和全局平均池化的结果明显优于单独利用单个池化的计算方式。在单独利用池化特征计算的分类结果中,全局平均池化的计算结果略高于全局最大池化,这可能是由于气体-光谱双模态为综合信息的检测结果,全局平均池化有利于计算融合信息整体性。表5为基于DFFA-Net的融合信息共同作用的消融分析结果,对单模态信息进行分类时,DFFA仅包含1个支路的计算方式且不包含SoftMax软注意力计算。可以看出,DFFA-Net对单独气体信息分类结果略优于光谱信息,这也与气体信息雷达图以及光谱信息差异图的直观对比趋势相似。最终,自适应融合气体-光谱双模态信息的DFFA-Net获得了最佳的分类性能,双模态信息共同应用的必要性被验证。

表4 深层特征获取有效性消融分析

Tab.4 Ablation analysis of effectiveness of deep feature acquisition %

特征获取方式准确率精确率召回率最大池化96.71±1.8797.07±1.7196.78±1.78平均池化97.05±1.9397.32±1.9297.14±1.94池化融合98.10±0.8298.15±0.7797.88±0.82

表5 融合信息有效性消融分析

Tab.5 Ablation analysis of fusion information effectiveness %

信息源准确率精确率召回率气体信息96.19±1.6196.73±1.2396.10±1.55光谱信息95.57±2.0596.05±1.9095.71±1.96融合信息98.10±0.8298.15±0.7797.88±0.82

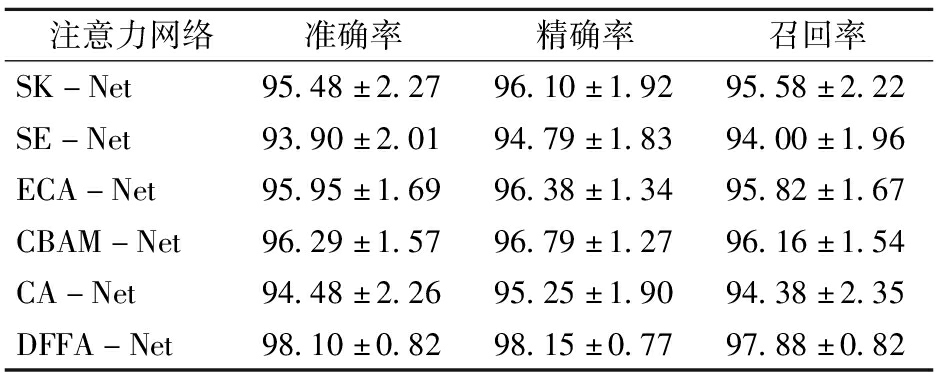

首先以DFFA-Net为基本网络框架,对比分析5种经典的注意力机制模块证明DFFA的有效性。对比的注意力机制包括:Selective kernel networks(SK)[21]、Squeeze and excitation(SE)[22]、Efficient channel attention(ECA)[23]、Convolutional block attention module(CBAM)[24]以及Coordinate attention(CA)[25]。

在对比的注意力机制中,SK、SE、ECA和CA是通道注意力,CBAM结合了通道注意力和空间注意力,本文设计的是空间注意力。表6显示了不同注意力机制在不同产地花生质量分类任务上的性能结果。可以发现,多种通道注意力的整体分类结果低于CBAM及DFFA-Net。相比较于通道注意力中最佳的ECA-Net分类结果,DFFA-Net在准确率、精确率和召回率综合评价方面明显提升。同时,融合通道注意力和空间注意力的CBAM也没有获得最佳的分类性能,这说明尽管结合了通道注意力,由于深层双模态信息更侧重于在空间位置信息的重要性表达,其在空间注意力的关注表征中更为重要。综上,融合空间注意力计算、软注意力信息流分配以及残差结构计算的DFFA-Net获得了最佳分类性能:准确率达到98.10%、精确率为98.15%、召回率为97.88%,有效地实现了不同产地花生整体质量的高性能辨识。进一步,在获得最佳分类结果的同时,DFFA-Net具有最小的分类标准差,在多分类方法的对比结果中获得了最佳的分类稳定性。

表6 DFFA-Net与其他注意力网络的对比结果

Tab.6 Comparison results of DFFA-Net with other attention networks %

注意力网络准确率精确率召回率SK-Net95.48±2.2796.10±1.9295.58±2.22SE-Net93.90±2.0194.79±1.8394.00±1.96ECA-Net95.95±1.6996.38±1.3495.82±1.67CBAM-Net96.29±1.5796.79±1.2796.16±1.54CA-Net94.48±2.2695.25±1.9094.38±2.35DFFA-Net98.10±0.8298.15±0.7797.88±0.82

(1)提出一种有效的气体-光谱双模态信息融合与特征关注注意力机制DFFA模块,该模块通过全局最大池化和全局平均池化作为特征注意力计算方法,利用SoftMax的软注意力计算方式自适应分流气体-光谱融合信息。通过消融实验分析,验证了DFFA-Net的有效性。

(2)基于DFFA模块,DFFA-Net的设计是进行自适应集成特征提取、特征处理及模式识别的系统过程。通过最优结构优化、消融实验与其他注意力网络对比,DFFA-Net获得了最佳分类性能:准确率达到98.10%、精确率为98.15%、召回率为97.88%,也获得了最佳分类稳定性。

[1] YIN D M,WANG Y,ZHANG X G,et al.Development of chloroplast genome resources for peanut(Arachis hypogaea L.) and other species of Arachis[J].Scientific Reports,2017,7(1):11649.

[2] WU Q S,XU L J,ZOU Z Y,et al.Rapid nondestructive detection of peanut varieties and peanut mildew based on hyperspectral imaging and stacked machine learning models[J].Frontiers in Plant Science,2022,13:1047479.

[3] PEREIRA J W D,ALBUQUERQUE M B,MELO P A,et al.Assessment of drought tolerance of peanut cultivars based on physiological and yield traits in a semiarid environment[J].Agricultural Water Management,2016,166:70-76.

[4] MEN H,SHI Y,FU S L,et al.Mining feature of data fusion in the classification of beer flavor information using e-tongue and e-nose[J].Sensors,2017,17(7):1656.

[5] YANG H Y,NI J G,GAO J Y,et al.A novel method for peanut variety identification and classification by improved VGG16[J].Scientific Reports,2021,11(1):15756.

[6] KANG S Y,ZHANG Q L,LI Z Y,et al.Determination of the quality of tea from different picking periods:an adaptive pooling attention mechanism coupled with an electronic nose[J].Postharvest Biology and Technology,2023,197:112214.

[7] LIN H L,CHEN H M,YIN C B,et al.Lightweight residual convolutional neural network for soybean classification combined with electronic nose[J].IEEE Sensors Journal,2022,22(12):11463-11473.

[8] LUO L M,PENG T J,YUAN M L,et al.Preparation of graphite oxide containing different oxygen-containing functional groups and the study of ammonia gas sensitivity[J].Sensors,2018,18(11):3745.

[9] SHI Y,LIU M,SUN A,et al.A data fusion method of electronic nose and hyperspectral to identify the origin of rice[J].Sensors and Actuators A:Physical,2021,332:113184.

[10] 徐赛,陆华忠,周志艳,等.基于高光谱与电子鼻融合的番石榴机械损伤识别方法[J].农业机械学报,2015,46(7):214-219.

XU Sai,LU Huazhong,ZHOU Zhiyan,et al.Identification for guava mechanical damage based on combined hyper-spectrometer and electronic nose[J].Transactions of the Chinese Society for Agricultural Machinery,2015,46(7):214-219.(in Chinese)

[11] REN Y,HUANG X,AHETO J H,et al.Application of volatile and spectral profiling together with multimode data fusion strategy for the discrimination of preserved eggs[J].Food Chemistry,2021,343:128515.

[12] AHETO J H,HUANG X,TIAN X,et al.Multi-sensor integration approach based on hyperspectral imaging and electronic nose for quantitation of fat and peroxide value of pork meat[J].Analytical and Bioanalytical Chemistry,2020,412(5):1169-1179.

[13] 李玉花,史翰卿,熊赟葳,等.融合电子鼻和视觉技术的鸡肉新鲜度检测装置研究[J].农业机械学报,2022,53(11):433-440.

LI Yuhua,SHI Hanqing,XIONG Yunwei,et al.Research of chicken freshness detection device based on electronic nose and vision technology[J].Transactions of the Chinese Society for Agricultural Machinery,2022,53(11):433-440.(in Chinese)

[14] 张春娟,郑晓春,古明辉,等.基于电子鼻和可见/近红外光谱技术的羊肉真实性鉴别[J].现代食品科技,2022,38(12):383-393.

ZHANG Chunjuan,ZHENG Xiaochun,GU Minghui,et al.Authenticity identification of mutton based on electronic nose and visible/near-infrared spectroscopy[J].Modern Food Science and Technology,2022,38(12):383-393.(in Chinese)

[15] TIAN Y H.Artificial intelligence image recognition method based on convolutional neural network algorithm[J].IEEE Access,2020,8:125731-125744.

[16] WANG L,ZHANG Q,QIAN Q,et al.Multispectral palm print and palm vein acquisition platform and recognition method based on convolutional neural network[J].The Computer Journal,2022,65(6):1461-1471.

[17] SHI Y,YUAN H C,XIONG C A,et al.Improving performance:a collaborative strategy for the multi-data fusion of electronic nose and hyperspectral to track the quality difference of rice[J].Sensors and Actuators B:Chemical,2021,333:129546.

[18] MEN H,LIU M,SHI Y,et al.Interleaved attention convolutional compression network:an effective data mining method for the fusion system of gas sensor and hyperspectral[J].Sensors and Actuators B:Chemical,2022,355:131113.

[19] LIU C C,CHU Z J,WENG S Z,et al.Fusion of electronic nose and hyperspectral imaging for mutton freshness detection using input-modified convolution neural network[J].Food Chemistry,2022,385:132651.

[20] CERVINI C,VERHEECKE-VAESSEN C,HE T T,et al.Improvements within the peanut production chain to minimize aflatoxins contamination:an Ethiopian case study[J].Food Control,2022,136:108622.

[21] LI X,WANG W,HU X,et al.Selective kernel networks[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2019:510-519.

[22] HU J,SHEN L,ALBANIE S,et al.Squeeze-and-excitation networks[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2018:7132-7141.

[23] WANG Q,WU B,ZHU P,et al.ECA-Net:efficient channel attention for deep convolutional neural networks[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2020:11534-11542.

[24] WOO S,PARK J,LEE J Y,et al.CBAM:convolutional block attention module[C]∥Proceedings of the European Conference on Computer Vision(ECCV),2018:3-19.

[25] HOU Q,ZHOU D,FENG J.Coordinate attention for efficient mobile network design[C]∥Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Rrecognition,2021:13713-13722.