0 引言

苹果鲜果采摘周期短、操作麻烦,人工采摘强度大、效率低且成本高[1]。苹果采摘机器人高效自动化采摘是解决上述问题的关键[2]。当前苹果采摘机器人主要由感知、决策、控制和执行等子系统构成[3]。对于苹果采摘机器人,其首要任务就是感知果实目标,即从背景环境中识别出果实目标进而构建果实采摘位姿(位置和姿态)[4],其中果实采摘位置构建又称之为定位。由于果园环境中光照、枝叶遮挡、果实重叠等因素使得果实定位不准并且姿态构建困难,影响果实的采摘成功率。

苹果果实的定位方法已有广泛研究,SILWAL等[5]提出圆形霍夫变换算法,通过将苹果果实像素从RGB图像中提取出来并获取果实的圆形边界框,然后结合配准的深度相机测量的对应深度值将圆形边界框内的像素点转换为果实表面点云,最后取所有表面点云三维(Three dimensions,3D)坐标的平均值作为果实的空间位置,但是该方法在果实像素提取时难以完全过滤非目标果实像素,进而引入非目标果实点云,导致定位不准。文献[6-7]则是利用识别算法获取苹果果实边界框,并以边界框的像素中心和深度相机获取的对应深度信息计算出边界框中心的3D坐标,最后将该坐标作为果实的空间位置,这种方法的缺点是当边界框中心的深度信息缺失时将无法进行定位,并且当果实被遮挡或出现果实重叠无法分割时,边界框中心位置将严重偏离目标果实中心进而导致定位失败。另外,结合果实的近球形结构特征,利用深度感知设备获取目标果实表面点云,然后采用诸如3D霍夫变换和随机采样一致性(Random sample consensus,RANSAC)等拟合球的方法获取果实的空间位置坐标[8-9]。考虑到当前点云获取设备精度普遍不高,一些学者提出利用苹果果实点云与其RGB图像之间形成的投影关系来获取果实的空间位置坐标[10-11],以提高定位精度。

为了应对复杂的果园环境,需要进一步构建采摘姿态来引导机械臂以合适姿态接近果实[12-13]。KANG等[8]利用苹果果实点云通过3D霍夫变换拟合出球体获得球心坐标,随后计算所有果实表面点与球心构成的向量姿态角,并以姿态角的平均值构建果实的采摘姿态,但该方法需要大量计算姿态角度。WANG等[14]基于PointNet点云处理网络提出苹果采摘位姿估计网络,将人工标注的果实点云的采摘位姿输入到估计网络中训练,得到估计模型来预测果园环境中果实的采摘位姿,而该方法需要进行大量的人工标注样本。

上述定位方法均未考虑果实重叠和光照等因素带来的点云噪声问题。通常基于图像的识别算法能够分割枝叶等背景,但是对于果实重叠此类算法可能会失效,出现将重叠果实识别成一个果实的情况[15-16],这就导致单纯利用图像识别结果获取的目标果实点云中存在非采摘目标果实的点云,同时,光照等因素又会影响果实点云的精度。因此,直接提取的目标果实点云中必然存在大量的噪声,普通滤波算法又难以滤除这些噪声,最终导致果实定位不准。另外,目前苹果果实姿态构建方法少有报道,并且已有果实采摘姿态构建方法又比较繁琐。基于此,本文提出一种苹果果实采摘位姿准确构建方法。首先采用典型滤波算法对提取的果实点云进行预处理,然后使用所提的RANSAC拟合点云去噪算法进一步滤除由重叠和光照等因素带来的难滤除点云噪声,最后结合处理后的果实点云和图像实例分割后得到的二值化掩膜图像来准确构建果实采摘位姿。

1 试验设备与数据采集

1.1 苹果采摘机器人系统

如图1所示,苹果采摘机器人主要由相机、软指手爪、机械臂、控制柜和移动机器人等组成。其中,使用英特尔公司的RealSense D455型相机,与采摘机器人采用磁吸式连接方式,可以根据苹果果实的生长情况在线调整相机视角;采摘动作执行器使用鳍条式三指软爪,以减少在抓握过程中对果实造成的损伤;运动规划执行器采用遨博公司生产的AUBO-i5型机械臂;底部移动平台为自研的履带式电动移动机器人,可实现果园内自主导航;控制柜内主要包含三指软爪的微型控制器和整机控制器嵌入式MIC770Q型工控机,工控机主要配置英特尔酷睿i5-9500E处理器、英伟达Quadro P2200 5 GB显卡以及16 GB运行内存。苹果采摘机器人软件系统主要基于ROS Noetic开发而来,各个子模块通过ROS的消息、服务和动作来完成通信;运动控制采用MoveIt库,使用RRT-Connect算法进行机械臂的路径规划;视觉系统基于OpenCV和Open3D库开发。

图1 采摘机器人部件组成

Fig.1 Components of picking robot

1.RealSense D455型相机 2.鳍条式三指软爪 3.AUBO-i5型机械臂 4.控制柜 5.履带式移动机器人

1.2 数据采集

深度感知设备目前有RGB-D相机、双目相机和激光雷达等。激光雷达设备价格高昂并且采集的点云为稀疏点云[17],双目相机算法复杂且耗时。考虑到RGB-D相机成本低廉且能够快速获取点云,同时其获取的点云为稠密点云,适合苹果这类小目标对象。因此,选用RealSense D455型RGB-D相机,该相机能够提供RGB、灰度和深度图像,特别地是其能够直接获取对齐到RGB图像的深度图像。对齐的深度图像是指RGB图像中每个像素位置对应的深度值即是对齐的深度图中相同像素位置的像素值。RGB和深度相机有多种分辨率,本研究均选取640像素×480像素,RGB相机视场角90°×65°,深度相机视场角为87°×58°;对于深度相机,当距离为4 m时,深度感知精度误差小于2%,最佳深度感知距离为0.4~6 m。

数据采集对象为果园环境下果实处于成熟期的苹果树,品种为嘎啦和富士等近球形苹果;采集时间为08:00—17:00;相机与果树距离为0.6~1.5 m。

2 果实采摘位姿构建原理

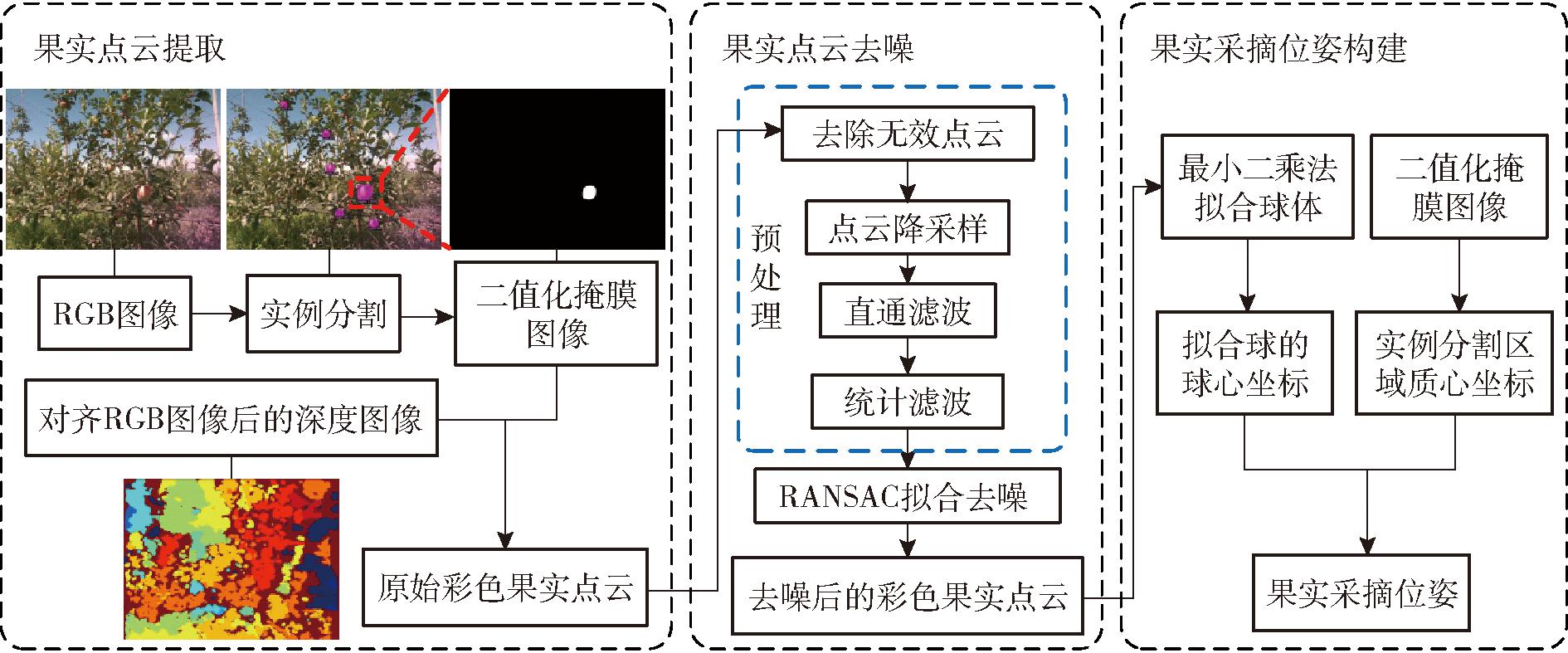

苹果采摘机器人的首要任务是果实采摘位姿的构建。基于RGB-D相机采集的图像信息提出一种果实采摘位姿构建方法,如图2所示。该方法主要包含3个步骤:①提取RGB图像中成功识别的所有苹果果实的点云。②对每个果实的点云依次进行去噪处理,以提高位姿构建精度。③使用去噪后的果实点云和与之对应的二值化掩膜图像,依次构建每个果实采摘位姿。

图2 果实采摘位姿构建原理图

Fig.2 Establishing principle of fruit picking pose

2.1 果实点云提取

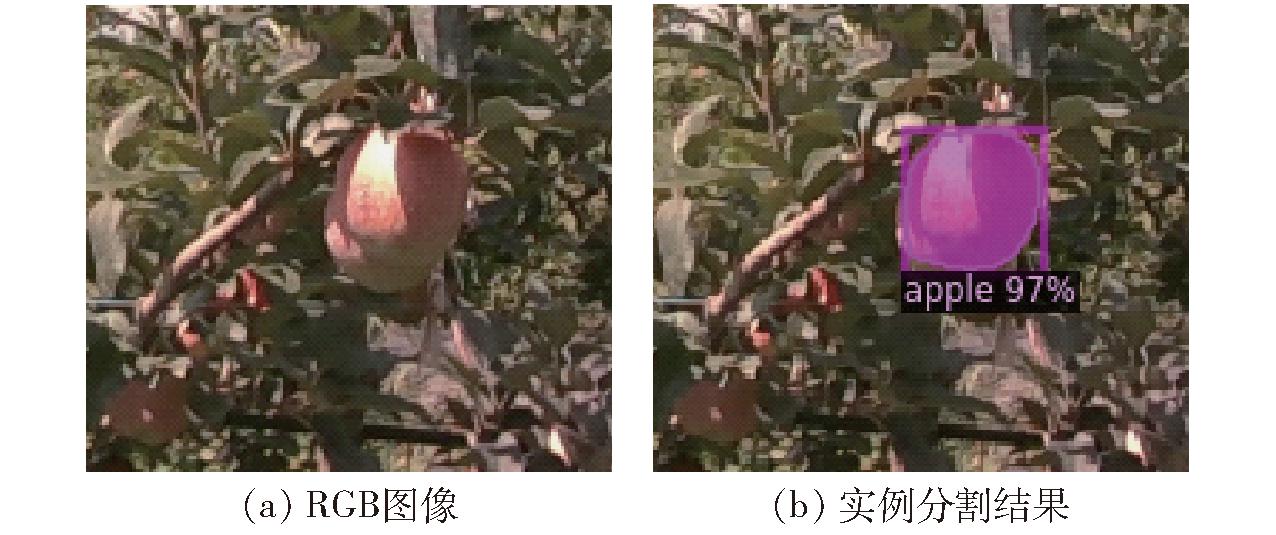

RGB-D相机获取的果树RGB图像中通常会包含多个果实,为了获取图像中每个果实的位姿信息,需要识别出每个果实所占的像素区域。考虑到Mask RCNN实例分割算法的优越表现,选用Detectron2库中的该算法进行模型训练获得预测模型,并利用预测模型对采集到的果树RGB图像进行实例分割[18]。实例分割后可以获得RGB图像中每个果实的二值化掩膜图像,使用此二值化掩膜图像和已对齐到RGB图像的深度图像就能够获取每个果实表面的点云数据。以RGB图像中识别到的某个重叠目标果实为例(图3),构建目标果实的采摘位姿,从RGB图像中识别到的其余果实均依次采用相同方式。

图3 目标果实的实例分割结果

Fig.3 Results of instance segmentation for target fruit

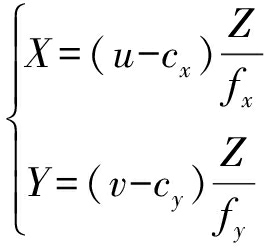

通过Mask RCNN实例分割获得的二值化掩膜图像,可以确定目标果实在RGB图像上所有像素点的坐标,同时像素点坐标对应的深度从对齐的深度图中获得,再结合相机中央透射模型,可计算出RGB图像中的目标果实像素点对应的3D坐标(X,Y,Z)[19]。X、Y计算式为

(1)

式中 cx、cy、 fx、 fy——RGB相机内部参数

u、v——像素点横、纵坐标

Z——像素点(u,v)对应的深度

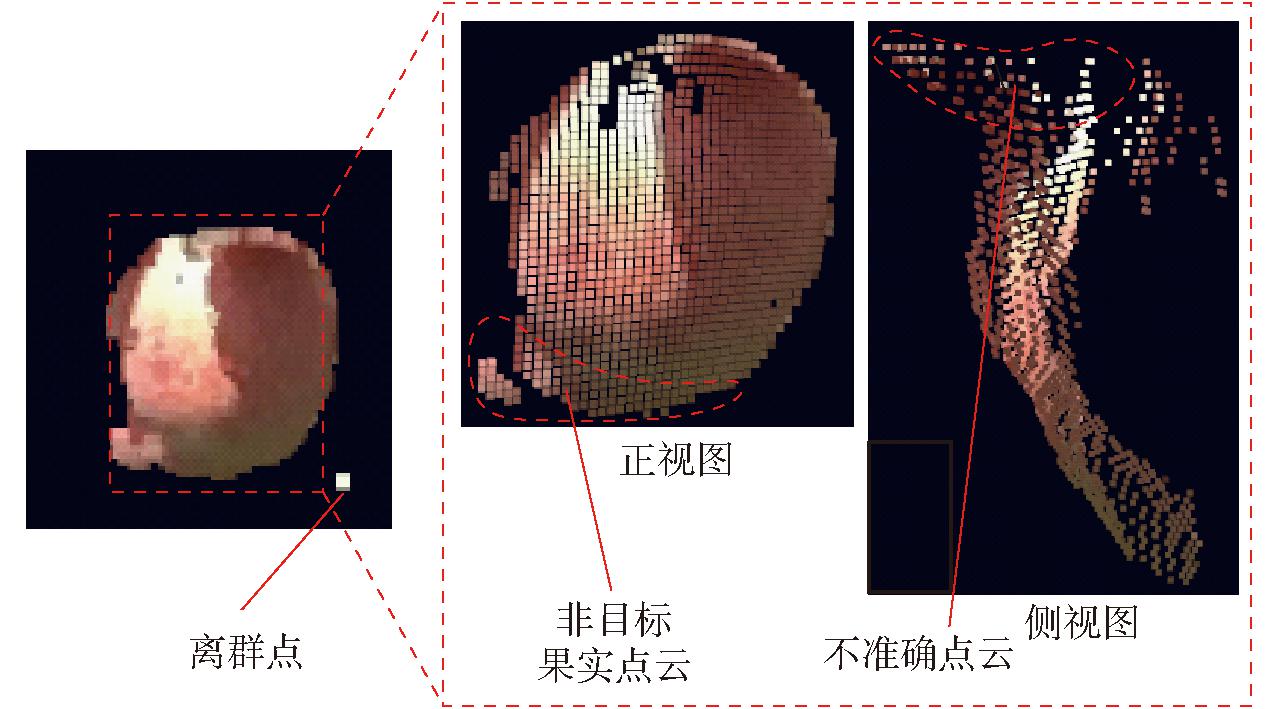

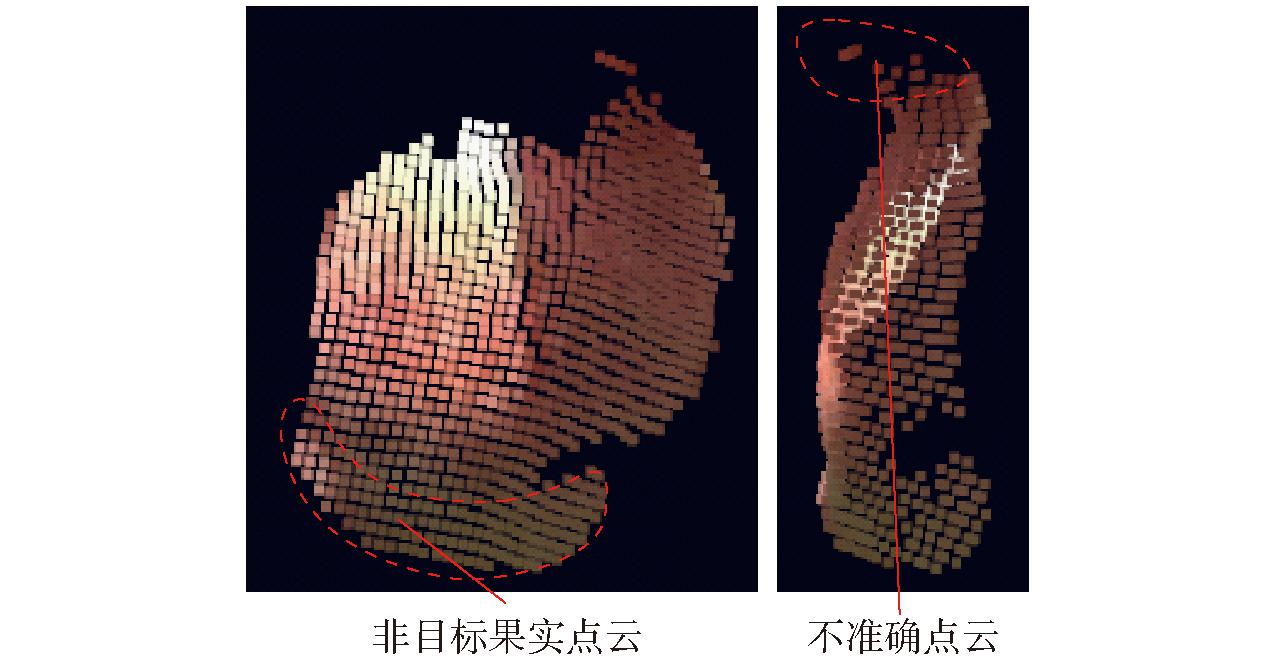

合并果实每个像素点的3D坐标以及该像素点对应的RGB信息,可以提取如图4中所示的原始彩色果实点云。从图4可以观察到,提取的原始点云呈现波浪形,并且存在离群点,造成这一现象的主要原因是受到相机设备本身测量精度以及外界光照等环境因素的影响,致使提取的点云不准确。此外,提取的原始点云中还存在非目标果实点云,其原因在于使用Mask RCNN之类的实例分割算法分割重叠果实时会出现分割失效[15-16],如图3所示,Mask RCNN算法将相邻重叠的2个果实误识别成1个果实。由于上述情形的存在导致提取的果实点云中存在大量噪声点。如果直接使用未经处理的原始点云构建采摘位姿,势必存在较大的误差甚至导致构建失败。因此,对提取的原始点云进行去噪处理至关重要。

图4 提取的原始彩色果实点云

Fig.4 Extracted raw color point cloud

2.2 果实点云去噪

通过2.1节获得的原始点云需要进行预处理。首先,去除深度值为零或空造成的无效点,保证每个点都具有几何意义;随后,对点云进行降采样处理,以降低点云密度,提高点云处理的效率,本文采用体素降采样[20],避免对点云的分布造成影响;其次,使用直通滤波[20],以点云的Z值作为滤波条件,去除远超出机械臂工作空间以及离相机过近的点;最后,采用统计滤波[20]去除点云中存在的离群点。

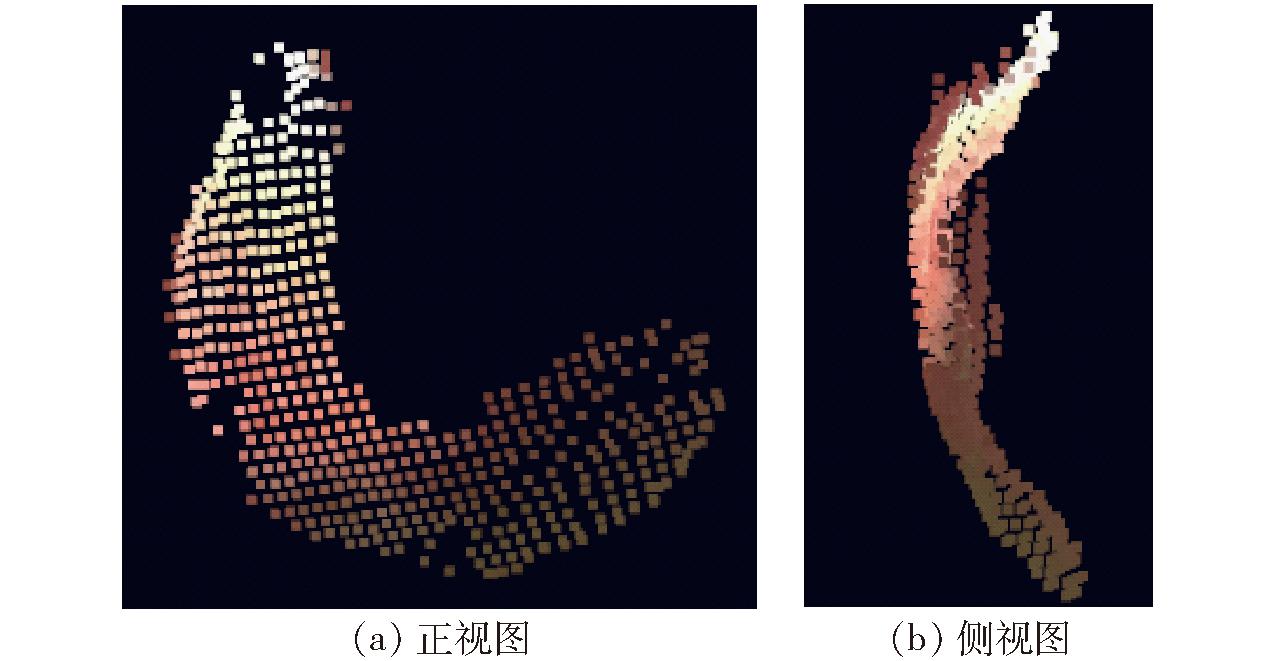

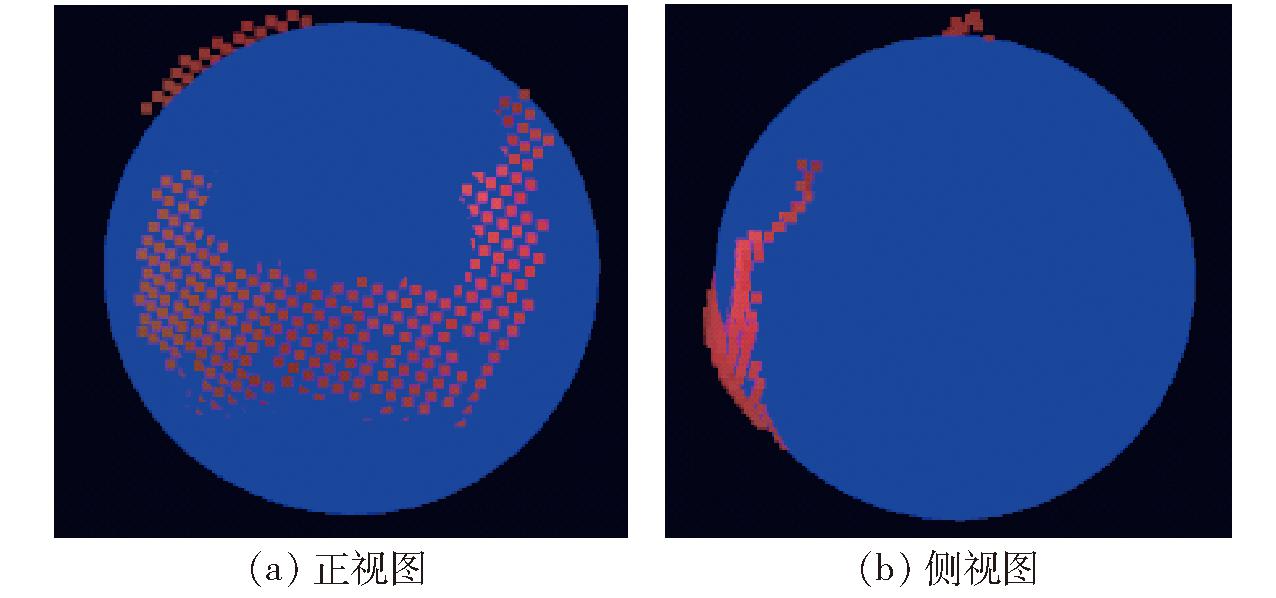

预处理后的点云如图5所示,可以发现仅使用典型滤波算法处理的果实点云依然存在大量不准确点云,特别是对重叠果实中非采摘目标果实的点云滤除基本无效。因此,需要进一步探索新的算法来解决由于重叠和光照等因素带来的点云噪声难滤除问题。考虑到大部分苹果果实的外形为近球形,且尺寸分布在一定的范围内,结合果实3D几何特征,提出一种RANSAC拟合点云去噪算法,以进一步滤除不准确点云和重叠果实中非采摘目标果实的点云,提高果实位姿构建的精度。

图5 预处理后的点云

Fig.5 Pre-processed point cloud

理论上,将果实看作标准的空间球体,那么对于重叠的2个果实,其中一个果实表面的点与另一个果实的球心距离必定大于或等于另一个果实的半径。因此,对于图5中的点云,采用RANSAC拟合球算法提取点云中多个潜在的球体,并将与点云采集设备垂直距离最短的球体作为目标球体,即球心到相机成像平面垂直距离最短的球体,记其球心坐标为O,半径为R。将图5中满足条件的点Pi作为内点,不满足的作为噪声进行去除,具体条件表达式为

‖Pi-O‖-R≤ε

(2)

式中ε为条件阈值,其取值可根据待采摘苹果种类的半径分布情况确定,即将某点到目标球体球心O的距离与该球体半径的差小于条件阈值的点作为内点。RANSAC去噪后结果如图6所示,可以看出重叠果实中非采摘目标果实的点云已被滤除,同时存在的其他噪声点也得到了进一步的滤除。

图6 RANSAC去噪后结果

Fig.6 Denoised with RANSAC fitting

2.3 果实采摘位姿构建

通过构建果实的位姿信息,采摘机器人可以自主调整采摘位姿,然后将调整后的采摘位姿传输至采摘执行机构(机械臂和软爪)完成果实的采收[8,21]。

2.3.1 果实位置构建

RANSAC拟合算法鲁棒性较好,不易受离群点的影响,能够在包含多个球体的点云中检测出相应数量的球体,这是解决由于重叠和光照等因素带来的点云噪声难滤除问题的关键要素之一[9]。该算法的缺点也很明显,即需要选取合理的阈值和迭代次数才能获取较好的拟合精度,这意味着该算法耗时较长,且拟合结果的稳定性较差[9,22]。基于以上几点考虑,本文不直接使用RANSAC拟合的结果,仅将其作为点云去噪的一个环节,即以其拟合结果作为基准设置距离阈值滤除噪声点。经过包括RANSAC拟合等一系列去噪后,使用最小二乘法对去噪后的果实点云进行球体拟合,以获得更为稳定且准确的拟合结果。此外,最小二乘法可以避免直接使用RANSAC拟合方法存在的阈值和迭代次数调优问题[23]。

空间球体方程可表示为

(x-x0)2+(y-y0)2+(z-z0)2=r2

(3)

式中 (x,y,z)——球面点坐标

(x0,y0,z0)——球心坐标

r——球体半径

将式(3)展开可得

(4)

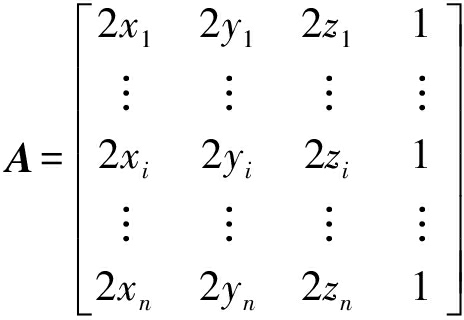

然后,将图6中经过RANSAC去噪后的点云3D坐标代入式(4),并整理得

Ax=B

(5)

其中

式中 (xi,yi,zi)——点云中某点的坐标

由于图6中的点为非严格球面上的点,需要使用最小二乘法求解式(5),即[24]

x=(ATA)-1ATB

(6)

最小二乘法拟合的结果如图7所示,将拟合的球体球心坐标记作Oc,并将其作为目标果实的采摘位置引导采摘执行机构接近果实。

图7 最小二乘法拟合球

Fig.7 Least-squares fitted sphere

2.3.2 果实姿态构建

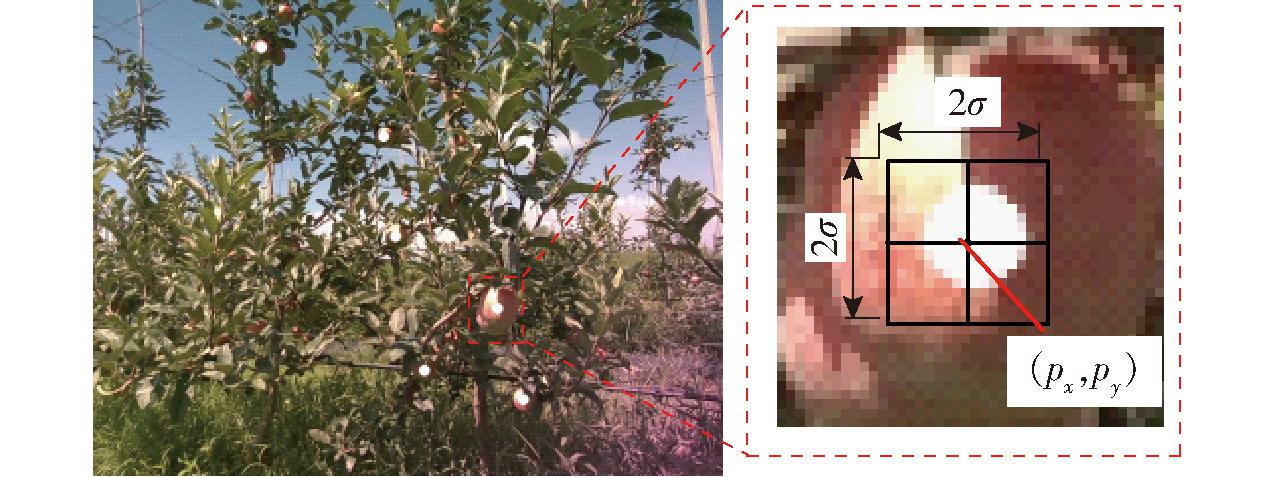

合适的采摘姿态能够提高操作灵活性,从而提高果实采摘成功率[25-26],基于此,本文提出一种果实姿态构建方法。使用RGB图像经实例分割后得到目标果实的二值化掩膜图像,可以获得识别出的目标果实在RGB图像上的图像质心坐标(px,py),如图8所示,其中白色像素点即为图3中的果实图像质心。

图8 果实图像质心求解

Fig.8 Solving apple center of mass

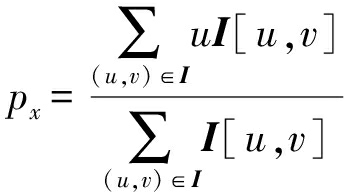

图像质心横坐标px为

(7)

式中 I[u,v]——二值化掩膜图像(u,v)处像素值

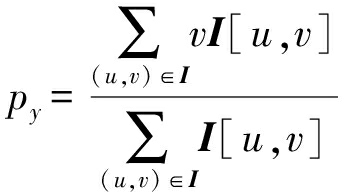

同理,可得图像质心纵坐标py为

(8)

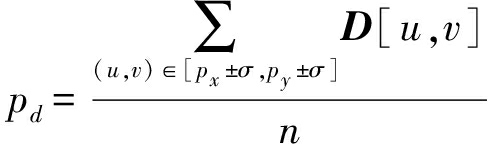

为了防止图像质心(px,py)处的深度缺失,同时提高图像质心处深度的准确性,如图8所示,取图像质心邻域σ内去除无效深度后的像素点深度平均值作为该图像质心的深度

(9)

式中 D[u,v]——图像质心邻域内有效(u,v)像素点的深度

n——图像质心邻域内有效像素点的总数量

随后,将图像质心像素坐标(px,py)和深度pd代入式(1),即可获得识别到的果实图像质心对应的3D坐标,记作P。

结合上述的果实质心3D坐标P和位置坐标Oc,可构建出果实的姿态向量V,即

V=P-Oc

(10)

2.3.3 采摘位姿构建

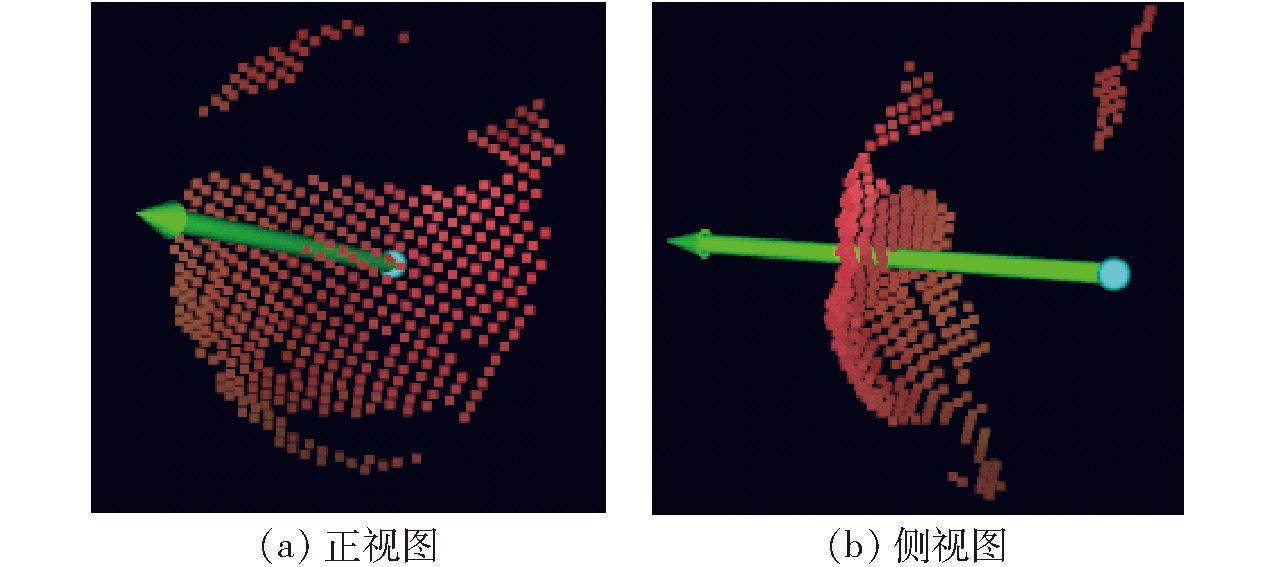

由以上构建的果实姿态向量和位置坐标,可得出图3中果实的位姿,记作(Oc,V)。如图9所示,绿色箭头即表示构建的果实的姿态向量,青色球体表示构建的果实位置坐标。进一步,可得果实的采摘位姿,记作(Oc,-V)。果实采摘时,可将软爪姿态的接近向量设定为-V,并沿着-V方向靠近果实采摘位置Oc。

图9 构建的果实位姿

Fig.9 Established apple pose

使用该采摘位姿的突出优点在于,当果实受遮挡,利用果实部分点云拟合球可能会出现获得的采摘位置Oc误差较大[9],但此时有质心P在软爪的靠近方向上,依然有可能保证采摘成功。反之,质心P误差较大而采摘位置Oc误差较小,同样能够进行有效采摘。这样结合点云的局部和整体信息,提高定位成功率(定位成功率指的是构建的果实位姿信息能够引导采摘机构到达满足其进行采摘操作的正确位置数量与可采摘果实数量的比率),从而减少由于单一信息定位出现较大误差时造成的软爪空操作,有望增加采摘成功率。典型示例如图10所示,即便拟合球心位置严重偏离理想采摘点,本文所提方法构建的采摘位姿依然能保证采摘成功。

图10 拟合球心误差大情况下采摘成功示例

Fig.10 Successful harvesting example in terrible fitting result

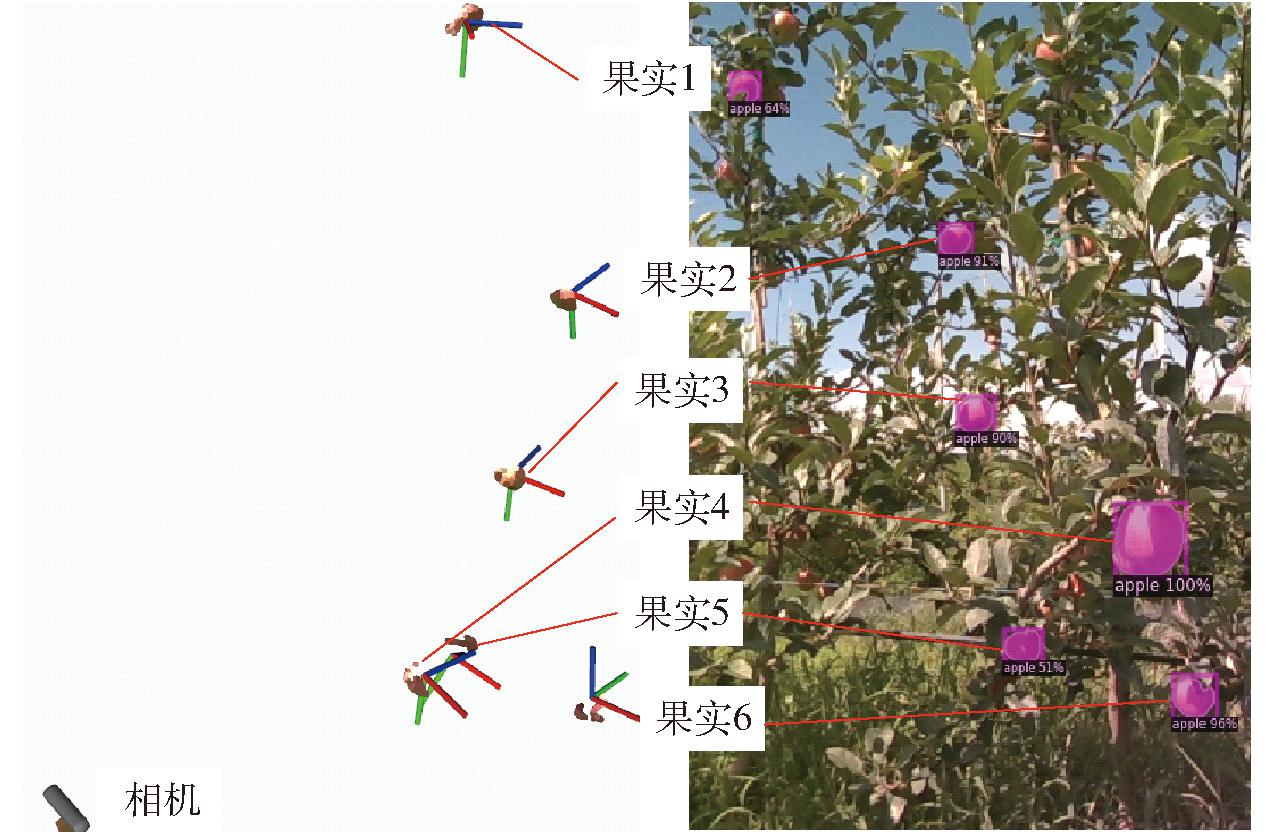

示例果实采摘位姿构建完成后,对RGB图像中的其余果实重复以上点云去噪和位姿构建过程,以获得所有果实的采摘位姿信息,如图11所示,图中蓝色坐标轴即是接近向量。采用本文的位姿构建方法获得的果实接近向量应该是由质心P指向采摘位置Oc,即接近向量所在的直线理论上应该从提取到的果实点云内部区域穿过,如图9所示。从图11中可以看出,果实1、6的采摘位置在提取的果实点云附近,但是构建的接近向量严重超出预期。因此,构建的姿态信息虽能提高操作的灵活性和定位成功率,但必须将接近向量的姿态角限定在一定范围内,这样在果实采摘位置准确的情况下既能保证采摘成功,还能在姿态偏离预期时保证设备的操作安全[14]。

图11 采摘位姿构建结果

Fig.11 Establishing results of picking pose

3 试验与结果分析

3.1 重叠果实点云去噪试验

为了验证所提的RANSAC拟合点云去噪算法对重叠果实去噪的有效性,将真实果园环境下采集到的多组包含重叠果实的RGB图像与对齐的深度图像输入到算法中,观察算法表现情况,部分实际数据输入到算法运行的过程结果如图12所示。从图12可以看出,当果实重叠区域较小时,Mask RCNN实例分割算法对RGB图像上的重叠果实能够有效进行分割,随之重叠果实的点云也能有效进行划分,但还是会存在光照等因素引入的噪声,而RANSAC拟合点云去噪算法能进一步滤除该类噪声。

图12 重叠果实点云去噪试验

Fig.12 Filtering point-cloud experiment within overlapping fruits

样例1~3都是Mask RCNN实例分割失效的情形,明显可以看出分割失效主要出现在果实重叠区域较大,或者果实边界轮廓界限不明显时,在果园环境下,这些情况时有发生。如果不加以干预,目标点云中会存在大量非目标果实的点云,这些点云对于目标果实都是噪声,会影响后期目标果实的定位。从图12中可以看出,普通的滤波算法难以有效解决,但是,经RANSAC去噪后非目标果实点云基本得到滤除,说明了所提方法的有效性。

3.2 采摘位姿构建方法评估

当下制约苹果采摘机器人发展的一个重要因素在于已有采摘系统的采摘效率普遍不高。因此,需要对位姿构建方法的处理速度进行测试评估。首先,将本文提出的算法部署到苹果采摘机器人的整机控制器上,然后将果园场景下采集到的多组包含苹果果实的原始RGB图像和对齐的深度图像输入到位姿构建算法中,并统计位姿构建所需时间,单幅RGB图像实例分割所需平均时间为0.25 s,实例分割后单个目标果实的位姿构建平均时间为0.69 s,总体构建平均时间为0.94 s。苹果采摘机器人设备的单果采摘时间约为8 s[7],本文的位姿构建时间不足1 s,远小于单果采摘总时间,因此能够满足采摘效率的要求。

由于本文提出的RANSAC拟合点云去噪算法采用随机采样点云的方式构建球体模型进行去噪,因此,需要测试其对位姿构建算法稳定性的影响。显然,稳定的位姿构建结果有利于后期误差的补偿。另外,从采摘位姿构建的过程可以看出,姿态的构建稳定性主要依赖于质心P和采摘位置Oc的稳定性。由于质心P稳定性主要取决于相机获取的深度值稳定性,此处不作讨论。因此,本文仅考察采摘位置Oc的构建稳定性。

首先,从采集到的数据中随机选取某对含有果实的RGB图像和对应的深度图像,输入到位姿构建算法中,分别记录识别到的某个果实RANSAC直接拟合和RANSAC去噪后最小二乘法拟合的采摘位置Oc,分别记录为O′c和O″c;其次,分别求位置坐标的模,即‖O′c‖和‖O″c‖;随后,多次重复拟合过程,获得多组‖O′c‖和‖O″c‖后分别计算2种拟合方法对应的位置坐标模的标准差;最后,选取其他若干对RGB和深度图像,重复上述步骤。分别取2种方法的标准差平均值来评估算法的稳定性。RANSAC直接拟合位置模的标准差平均值为 10.8 mm;RANSAC去噪后再使用最小二乘法拟合的标准差平均值为2.6 mm。可以得出使用RANSAC去噪后,再使用最小二乘法拟合球能够明显提升构建的稳定性,稳定性提高76.0%,有利于后期苹果定位误差的补偿。

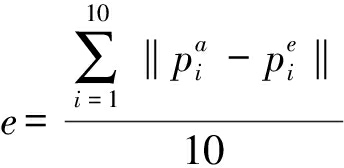

在测试位姿构建算法效率和稳定性之后,进行位姿构建的精度对比试验,以验证所提方法在光照与果实重叠情形下具有更好的位姿构建精度表现。由于姿态的构建精度主要依赖于质心P和采摘位置Oc的坐标精度,而质心P的坐标稳定性取决于相机设备的深度感知精度。因此,此处仍仅考察采摘位置Oc的构建精度,即定位精度。

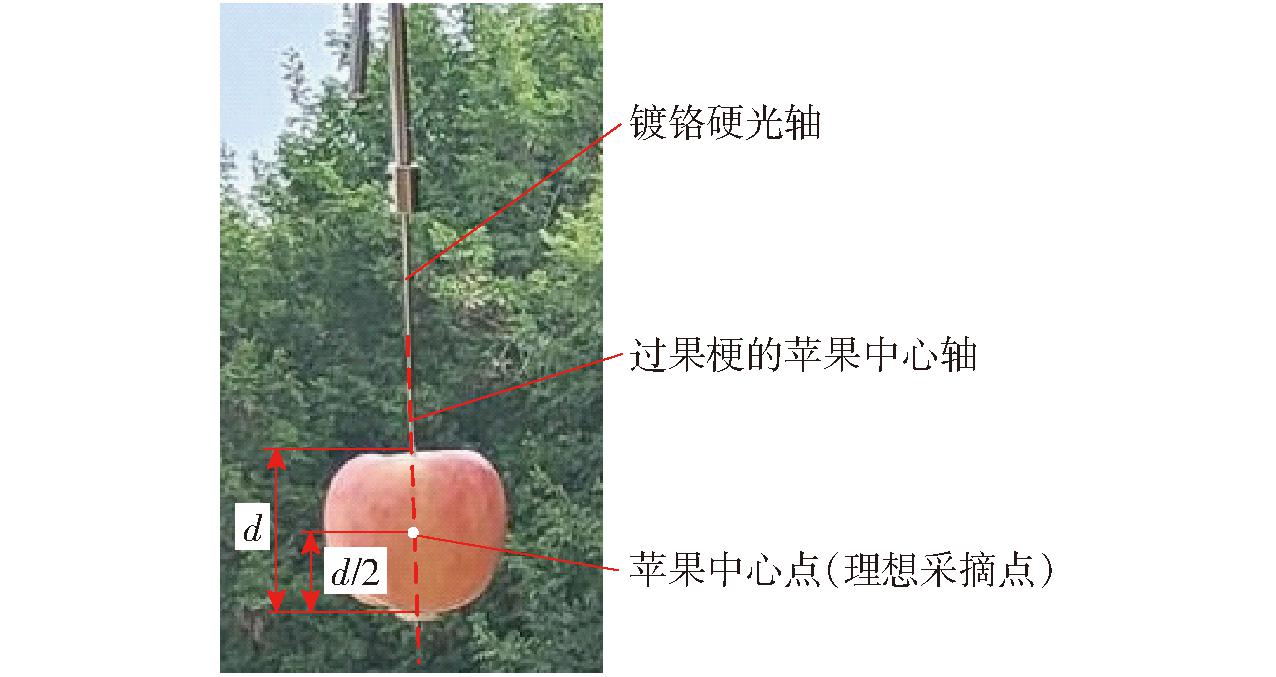

在试验前需要定义苹果的理想采摘点,如图13所示,将过果梗的中心轴上的苹果中心点作为理想采摘点,同时将直径为2 mm的镀铬硬光轴穿过苹果,并使其与苹果中心轴重合。在光轴上标记与苹果理想采摘点重合的点,将理想采摘点“实体化”。将尖端半径为0.2 mm的探针安装在机械臂末端的软爪上。使用工具坐标系标定算法标定出探针尖端在软爪坐标系下的坐标[27]。

图13 理想采摘点

Fig.13 Desired picking point

试验时,随机选取5个不同外形尺寸的成熟苹果作为试验对象,并模拟果园环境下果实重叠并且实例分割失效情形,如图14所示。试验步骤为:首先利用光轴将单个苹果固定在试验台架上并使苹果离相机1 m左右,同时固定另外一个辅助苹果,并调整辅助苹果的位姿以模拟实例分割失效情形,分别记录此时苹果的RANSAC直接拟合和RANSAC去噪后最小二乘法拟合的采摘位置Oc,并通过手眼标定得到的相机到采摘机器人基坐标系下的转换关系,将2种方法拟合的采摘位置Oc分别转换到基坐标系下。随后,引导机械臂运动使得探针尖端触碰到光轴上的理想采摘点,如图15所示;此时借助采摘机器人的运动学参数将探针尖端坐标转换到基坐标系下,可以获得苹果的理想采摘点在基坐标下的坐标。分别在上午、中午和下午不同时间段依次使用5个苹果,并且每个苹果重复使用2次并放置在不同的空间位置,即每个时间段重复10次上述试验步骤,并记录所有试验结果。最后,分别求取不同时段下利用上述2种方法拟合出的采摘位置Oc与理想采摘点的欧氏距离平均值,并以欧氏距离平均值作为果实的定位误差对2种方法的定位精度进行评估,其计算式为

(11)

图14 定位精度评估试验

Fig.14 Estimation experiment for localizing accuracy

图15 理想采摘点位置测量

Fig.15 Measuring position coordinates of desired picking point

式中 e——果实定位误差(欧氏距离平均值)

![]() 接触测量获得的某个苹果理想采摘点在基坐标系下的坐标

接触测量获得的某个苹果理想采摘点在基坐标系下的坐标

![]() 对应苹果拟合球心在基坐标系下的坐标

对应苹果拟合球心在基坐标系下的坐标

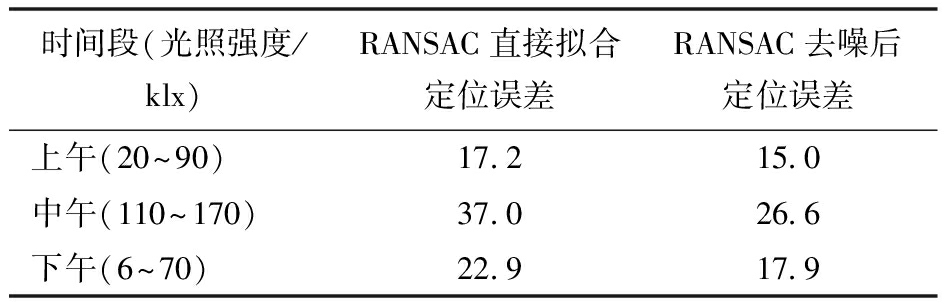

试验结果如表1所示,从表1中可以得出,在自然光照并且果实重叠的情形下,本文方法定位精度能够达到15.0 mm;相对于RANSAC直接拟合,经过RANSAC去噪后再使用最小二乘法拟合定位,定位精度在上午、中午和下午3个时间段内分别提高16.3%、28.1%和21.8%,说明所提方法能够有效解决光照和果实重叠带来的噪声问题。中午时间段的定位精度提高幅度最大,进一步说明所提方法能够降低光照带来的点云噪声影响。

表1 定位精度评估

Tab.1 Accuracy estimation on localization mm

时间段(光照强度/klx)RANSAC直接拟合定位误差RANSAC去噪后定位误差上午(20~90)17.215.0中午(110~170)37.026.6下午(6~70)22.917.9

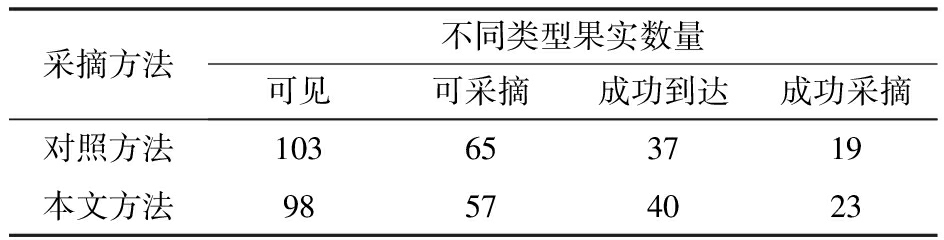

3.3 采摘位姿果园应用对比试验

在未构建果实姿态的情况下,通常以人为设定的固定采摘姿态进行采摘[25-26],而本文通过构建果实姿态在采摘时能够自主调整软爪的采摘姿态,以适应不同生长状态的果实,同时通过RANSAC去噪后再使用最小二乘法拟合球获取更准确采摘位置,以此获得的果实采摘位姿有望提高采摘成功率。为了验证构建的采摘位姿的有效性以及在实际果园中苹果采摘机器人的采摘性能表现,于2023年10月26—27日在江苏省宿迁市斯味特果园开展采摘位姿构建的应用对比试验。

果园试验时,以人为设定的固定水平采摘姿态和直接使用RANSAC拟合得到的采摘位置构成果实采摘位姿[6-9],并以此作为对照方法,然后分别使用本文方法和对照方法进行果园采摘应用对比试验,使用本文方法的采摘过程如图16所示。此外,采摘机器人实施采摘操作之前需要统计机器人视场中可见果实数量;采摘过程中统计在机器人工作范围内的可采摘果实数量、软爪成功到达正确采摘位置数量和果实成功放置到货箱中的果实数量,统计结果如表2所示。其中,软爪成功到达正确采摘位置的数量可以表征定位成功率。需要补充说明的是,由于存在果实成功定位但规划失败导致手爪无法到达正确采摘位置的情形,果实定位成功的数量应该大于软爪成功到达正确采摘位置的数量。从表2可以看出,对于本文方法,98个可见果实中,有57个为满足采摘条件的可采摘果实,软爪成功到达正确采摘位置的数量为40个,定位成功率为70.2%。由于硬件与规划算法性能的限制以及复杂的果园环境,成功采摘数量仅为23个,采摘成功率为40.4%。同理,对照方法定位成功率为56.9%,采摘成功率为29.2%。相较于对照方法,本文方法定位成功率提高23.4%,采摘成功率提高38.4%。

表2 果园试验结果统计

Tab.2 Statistics of test results in orchard个

采摘方法不同类型果实数量可见可采摘成功到达成功采摘对照方法103653719本文方法98574023

图16 试验现场

Fig.16 Field tests

4 结论

(1)针对果实重叠和光照等因素带来的点云噪声难滤除问题,提出了一种RANSAC拟合点云去噪算法,试验表明该算法能够有效滤除点云噪声,提高果实位姿构建的稳定性和准确性。其中,经过RANSAC去噪后再使用最小二乘拟合球进行位置构建,定位精度最高能达到15.0 mm,相较于直接使用RANSAC拟合球的方法,位置构建稳定性提高76.0%,定位精度最大提高28.1%。

(2)结合采摘位置坐标和实例分割算法获得的二值化掩膜图像质心位置坐标,提出了一种新的果实采摘姿态构建方法,该方法构建过程简单,易于实现。相较于以固定姿态采摘,该方法更具灵活性,且能提高定位成功率,进而提高采摘成功率。另外,整体位姿构建时间不超过1 s,满足采摘的效率要求。

(3)通过采摘位姿果园应用对比试验,验证了本文提出的位姿构建方法能够有效提高定位成功率和采摘成功率。其中,定位成功率为70.2%,相较于对照方法,定位成功率提高23.4%,采摘成功率提高38.4%。但由于设备性能的限制和复杂的果园环境,苹果采摘机器人使用构建的采摘位姿采摘成功率仅达到40.4%,有待进一步提高。

[1] 赵雄, 曹功豪, 张鹏飞, 等. 三自由度苹果采摘机械臂动力学分析与轻量化设计[J]. 农业机械学报, 2023, 54(7): 88-98. ZHAO Xiong, CAO Gonghao, ZHANG Pengfei, et al. Dynamic analysis and lightweight design of 3-DOF apple picking manipulator[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(7): 88-98. (in Chinese)

[2] JIA W, ZHANG Y, LIAN J, et al. Apple harvesting robot under information technology: a review[J]. International Journal of Advanced Robotic Systems, 2020, 17(3): 1729881420925310.

[3] MONTOYA-CAVERO L E, D AZ De L T R, G

AZ De L T R, G MEZ-ESPINOSA A, et al. Vision systems for harvesting robots: produce detection and localization[J]. Computers and Electronics in Agriculture, 2022, 192: 106562.

MEZ-ESPINOSA A, et al. Vision systems for harvesting robots: produce detection and localization[J]. Computers and Electronics in Agriculture, 2022, 192: 106562.

[4] TANG Y, CHEN M, WANG C, et al. Recognition and localization methods for vision-based fruit picking robots: a review[J]. Frontiers in Plant Science, 2020, 11:510.

[5] SILWAL A, DAVIDSON J R, KARKEE M, et al. Design, integration, and field evaluation of a robotic apple harvester[J]. Journal of Field Robotics, 2017, 34(6): 1140-1159.

[6] BU L, CHEN C, HU G, et al. Design and evaluation of a robotic apple harvester using optimized picking patterns[J]. Computers and Electronics in Agriculture, 2022, 198: 107092.

[7] HU G, CHEN C, CHEN J, et al. Simplified 4-DOF manipulator for rapid robotic apple harvesting[J]. Computers and Electronics in Agriculture, 2022, 199: 107177.

[8] KANG H, ZHOU H, CHEN C. Visual perception and modeling for autonomous apple harvesting[J]. IEEE Access, 2020, 8: 62151-62163.

[9] 柳长源, 赖楠旭, 毕晓君. 基于深度图像的球形果实识别定位算法[J]. 农业机械学报, 2022, 53(10): 228-235.LIU Changyuan, LAI Nanxu, BI Xiaojun. Spherical fruit recognition and location algorithm based on depth image[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(10): 228-235. (in Chinese)

[10] YOSHIDA T, KAWAHARA T, FUKAO T. Fruit recognition method for a harvesting robot with RGB-D cameras[J]. ROBOMECH Journal, 2022, 9(1): 15.

[11] LI T, FENG Q, QIU Q, et al. Occluded apple fruit detection and localization with a frustum-based point-cloud-processing approach for robotic harvesting[J]. Remote Sensing, 2022, 14(3): 482.

[12] KANG H, ZHOU H, WANG X, et al. Real-time fruit recognition and grasping estimation for robotic apple harvesting[J]. Sensors, 2020, 20(19): 5670.

[13] AU W, ZHOU H, LIU T, et al. The monash apple retrieving system: a review on system intelligence and apple harvesting performance[J]. Computers and Electronics in Agriculture, 2023, 213: 108164.

[14] WANG X, KANG H, ZHOU H, et al. Geometry-aware fruit grasping estimation for robotic harvesting in apple orchards[J]. Computers and Electronics in Agriculture, 2022, 193: 106716.

[15] GONG L, WANG W, WANG T, et al. Robotic harvesting of the occluded fruits with a precise shape and position reconstruction approach[J]. Journal of Field Robotics, 2022, 39(1): 69-84.

[16] LIU M, JIA W, WANG Z, et al. An accurate detection and segmentation model of obscured green fruits[J]. Computers and Electronics in Agriculture, 2022, 197: 106984.

[17] MAGALH ES S A, MOREIRA A P, SANTOS F N D, et al. Active perception fruit harvesting robots—a systematic review[J]. Journal of Intelligent &Robotic Systems, 2022, 105(14): 1-22.

ES S A, MOREIRA A P, SANTOS F N D, et al. Active perception fruit harvesting robots—a systematic review[J]. Journal of Intelligent &Robotic Systems, 2022, 105(14): 1-22.

[18] WU Y, KIRILLOV A, MASSA F, et al. Detectron2[EB/OL]. [2024-04-29]. https:∥github.com/facebookresearch/detectron2.

[19] KOK E, WANG X, CHEN C. Obscured tree branches segmentation and 3D reconstruction using deep learning and geometrical constraints[J]. Computers and Electronics in Agriculture, 2023, 210: 107884.

[20] ZHOU Q Y, PARK J, KOLTUN V. Open3D: a modern library for 3D data processing[J]. arXiv Preprint, arXiv:1801.09847, 2018.

[21] 田蔚瀚, 罗亚哲, 李逸飞, 等. 家庭服务机器人手眼协调系统设计[J]. 机械工程学报, 2022, 58(5): 69-77.TIAN Yuhan, LUO Yazhe, LI Yifei, et al. Design of hand-eye coordination system for home service robot[J]. Journal of Mechanical Engineering, 2022, 58(5): 69-77. (in Chinese)

[22] RUSU R B, COUSINS S. 3D is here: point cloud library (PCL)[C]∥Proceedings of the IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2011.

[23] 李宗春, 路志勇, 郭迎钢, 等. 基于俯仰轴相交和球拟合的天线旋转中心测量方法[J]. 武汉大学学报(信息科学版), 2019, 44(10): 1449-1456.LI Zongchun, LU Zhiyong, GUO Yinggang, et al. Two measuring methods for antenna rotating center based on elevation axes intersection and spherical fitting[J]. Geomatics and Information Science of Wuhan University, 2019, 44(10): 1449-1456. (in Chinese)

[24] LU T, ZHOU S, ZHANG L, et al. Sphere target fitting of point cloud data based on TLS[C]∥International Symposium on Spatial Analysis, Spatial-Temporal Data Modeling, and Data Mining. SPIE, 2009, 7492: 844-850.

[25] 张勤, 庞月生, 李彬. 基于实例分割的番茄串视觉定位与采摘姿态估算方法[J]. 农业机械学报, 2023, 54(10):205-215.ZHANG Qin, PANG Yuesheng, LI Bin. Visual positioning and picking pose estimation of tomato clusters based on instance segmentation[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(10):205-215. (in Chinese)

[26] AU W, CHEN C. Path planning for robotic harvesting[M]∥ZHANG Q. Encyclopedia of smart agriculture technologies. Cham: Springer, 2022: 1-13.

[27] 熊烁, 叶伯生, 蒋明. 机器人工具坐标系标定算法研究[J]. 机械与电子, 2012(6): 60-63.XIONG Shuo, YE Bosheng, JIANG Ming. Study of robot tool coordinate frame calibration[J]. Machinery &Electronics, 2012(6): 60-63. (in Chinese)